ChatGPT부터 AI 그리기 기술까지, 최근 인공 지능 분야의 획기적인 발전은 Transformer 덕분일 수 있습니다.

오늘은 유명한 트랜스포머 페이퍼가 제출된 지 6주년이 되는 날입니다.

논문 링크: https://arxiv.org/abs/1706.03762

6년 전, 사전 인쇄 용지 플랫폼 arXiv에 다소 거창한 이름의 논문이 업로드되었습니다. "xx is All You Need"라는 문구는 AI 분야의 개발자들에 의해 반복적으로 반복되었으며 심지어 논문 제목에서도 트렌드가 되었습니다. Transformer는 더 이상 Transformers를 의미하지 않으며, 이제 AI 분야에서 가장 진보된 기술을 나타냅니다. . 기술.

6년 후 이 논문을 되돌아보면 NVIDIA AI 과학자 Jim Fan이 요약한 것처럼 흥미롭거나 잘 알려지지 않은 측면을 많이 찾을 수 있습니다.

"주의 메커니즘"은 Transformer의 저자가 제안한 것이 아닙니다.

Transformer 모델은 전통적인 CNN 및 RNN 단위를 버리고 전체 네트워크 구조가 주의 메커니즘으로 구성됩니다.

Transformer 논문의 이름은 "Attention is All You Need"이고 우리는 그것 때문에 어텐션 메커니즘을 계속 칭찬하고 있지만 흥미로운 사실에 주목해 주세요. 주의를 발명한 것은 Transformer의 연구자들이 아니었습니다. 그러나 그들은 이 메커니즘을 극단적으로 받아들였습니다.

Attention Mechanism은 2014년 딥 러닝 선구자 Yoshua Bengio가 이끄는 팀에 의해 제안되었습니다:

"Neural Machine Translation by Jointly Learning to Align and Translate", 제목은 비교적 간단합니다.

이 ICLR 2015 논문에서 Bengio 등은 RNN + "컨텍스트 벡터"(즉, 주의)의 조합을 제안했습니다. NLP 분야에서 가장 위대한 이정표 중 하나이지만 Transformer에 비해 훨씬 덜 알려져 있습니다. Bengio 팀의 논문은 지금까지 29,000회 인용되었으며, Transformer는 77,000회 인용되었습니다.

AI의 주의 메커니즘은 자연스럽게 인간의 시각적 주의를 모델로 합니다. 인간의 뇌에는 타고난 능력이 있습니다. 사진을 볼 때 먼저 사진을 빠르게 스캔한 다음 집중해야 할 대상 영역에 초점을 맞춥니다.

부분적인 정보라도 버리지 않으면 필연적으로 생존에 도움이 되지 않는 쓸데없는 일을 많이 하게 됩니다. 마찬가지로, 딥러닝 네트워크에 유사한 메커니즘을 도입하면 모델을 단순화하고 계산 속도를 높일 수 있습니다. 본질적으로 Attention은 많은 양의 정보에서 소량의 중요한 정보를 걸러내고 이 중요한 정보에 집중하고 중요하지 않은 정보는 대부분 무시하는 것입니다.

최근에는 컴퓨터 비전 방향으로 이미지의 수용 필드를 캡처하거나 NLP에서 핵심 토큰이나 기능을 찾는 등 딥러닝의 다양한 분야에서 Attention 메커니즘이 널리 사용되었습니다. 수많은 실험을 통해 Attention 메커니즘을 갖춘 모델이 이미지 분류, 분할, 추적, 향상은 물론 자연어 인식, 이해, 질문 응답, 번역과 같은 작업에서 상당한 성능 향상을 달성했음이 입증되었습니다.

attention 메커니즘을 도입한 Transformer 모델은 범용 시퀀스 컴퓨터로 간주할 수 있습니다. Attention 메커니즘을 사용하면 모델이 입력 시퀀스를 처리할 때 시퀀스의 다양한 위치 상관 관계에 따라 다양한 Attention 가중치를 할당할 수 있습니다. Transformer가 장거리 종속성과 컨텍스트 정보를 캡처하여 시퀀스 처리 효과를 향상시킬 수 있습니다.

하지만 그 당시에는 Transformer도, 원래의 주목 논문도 유니버설 시퀀스 컴퓨터에 대해 언급하지 않았습니다. 대신 저자는 이를 좁고 구체적인 문제인 기계 번역을 해결하기 위한 메커니즘으로 봅니다. 따라서 미래에 우리가 AGI의 기원을 추적하면 "겸손한" Google 번역까지 추적할 수 있을 것입니다.

NeurIPS 2017에서 채택되었지만 Oral조차 받지 못했습니다.

Transformer 이 논문은 현재 큰 영향력을 갖고 있지만, 세계 최고의 AI 학회인 NeurIPS 2017에서는 Oral조차 받지 못했습니다. , 상을 받는 것은 말할 것도 없고요. 해당 컨퍼런스에는 총 3,240개의 논문이 제출되었으며, 그 중 678개가 컨퍼런스 논문으로 선정되었습니다. 이 논문 중 Transformer 논문은 구두 논문 40개, Spotlight 논문 112개, 최우수 논문 3개였습니다. . Thesis, Test of time 상, Transformer는 수상 자격이 없습니다.

NeurIPS 2017 논문상은 놓쳤지만 Transformer의 영향력은 누구에게나 명백합니다.

Jim Fan은 다음과 같이 말했습니다. 영향력 있는 연구가 영향력을 갖기 전에 사람들이 그 중요성을 깨닫는 것이 어려운 것은 심사위원의 잘못이 아닙니다. 그러나 즉시 발견될 만큼 운이 좋은 논문도 있습니다. 예를 들어 He Yuming 등이 제안한 ResNet은 CVPR 2016에서 최우수 논문을 수상했습니다. 이 연구는 충분한 가치가 있으며 최고의 AI 컨퍼런스에서 올바르게 인정받았습니다. 하지만 2017년 현재, 매우 똑똑한 연구자들은 LLM이 가져올 변화를 예측하지 못할 수도 있습니다. 1980년대와 마찬가지로 2012년 이후 딥 러닝이 가져온 쓰나미를 예측할 수 있는 사람은 거의 없습니다.

각각 멋진 삶을 살고 있는 8명의 저자

당시 이 논문의 저자는 8명이었는데, 그들은 Google과 토론토 대학교 출신이었습니다. 5년 후, 논문의 저자 대부분이 사임했습니다. 원래 기관.

2022년 4월 26일, "Adept"라는 회사가 공식적으로 설립되었습니다. Transformer 논문의 저자인 Ashish Vaswani와 Niki Parmar를 포함하여 9명의 공동 창립자가 있습니다. ㅋㅋㅋ 깊이 언어 모델링 학습의 초기 적용. 2016년에 Google Brain에 합류하여 Transformer에 대한 연구를 이끌었고 2021년에 Google을 떠났습니다.

Niki Parmar

퇴사 후 두 사람은 Adept를 공동 창립하고 각각 최고 과학자(Ashish Vaswani)와 최고 기술 책임자(Niki Parmar)를 역임했습니다. Adept의 비전은 다양한 소프트웨어 도구와 API를 사용하도록 훈련된 "인공지능 팀원"이라는 AI를 만드는 것입니다. 2023년 3월, Adept는 미화 3억 5천만 달러 규모의 시리즈 B 파이낸싱을 완료했다고 발표했으며, 회사 가치는 미화 10억 달러를 넘어 유니콘이 되었습니다. 그러나 Adept가 공개적으로 자금을 모금할 때 Niki Parmar와 Ashish Vaswani는 Adept를 떠나 자신의 새로운 AI 회사를 설립했습니다. 그러나 이 새로운 회사는 여전히 기밀이므로 회사에 대한 자세한 정보를 얻을 수 없습니다.

또 다른 논문 저자 Noam Shazeer 는 Google의 가장 중요한 초기 직원 중 한 명입니다. 2000년 말 구글에 입사해 2021년 최종 퇴사했다가 'Character.AI'라는 스타트업의 CEO가 됐다.

Noam Shazeer 외에도 Character.AI의 창립자는 Daniel De Freitas이며 두 사람 모두 Google LaMDA 팀 출신입니다. 이전에는 Google에서 대화 프로그램을 지원하는 언어 모델인 LaMDA를 구축했습니다.

올해 3월, Character.AI는 1억 5천만 달러의 자금 조달 완료를 발표했으며, 가치 평가액은 10억 달러에 달합니다. ChatGPT를 소유한 조직인 OpenAI와 경쟁할 수 있는 잠재력을 가진 몇 안 되는 스타트업 중 하나입니다. , 그리고 단 몇 달 만에 유니콘으로 성장한 회사를 16A만 쓰는 경우도 드물다. 해당 애플리케이션인 Character.AI는 인간과 같은 텍스트 응답을 생성하고 상황에 맞는 대화에 참여할 수 있는 신경 언어 모델 챗봇입니다.

Character.AI는 2023년 5월 23일 Apple App Store와 Google Play Store에 출시되었으며 첫 주에 170만 회 이상 다운로드되었습니다. 2023년 5월에 이 서비스에는 c.ai+라는 월 9.99달러의 유료 구독이 추가되었습니다. 이를 통해 사용자는 우선 채팅 액세스, 더 빠른 응답 시간, 새로운 기능에 대한 조기 액세스 등의 혜택을 누릴 수 있습니다.

Aidan N. Gomez은 2019년에 Google을 떠난 후 FOR.ai에서 연구원으로 근무했으며 현재는 Cohere의 공동 창립자이자 CEO입니다.

Cohere는 2019년에 설립된 생성형 AI 스타트업입니다. 핵심 사업에는 NLP 모델 제공과 기업의 인간-컴퓨터 상호 작용 개선 지원이 포함됩니다. 세 명의 창립자는 Ivan Zhang, Nick Frosst, Aidan Gomez이며, 그중 Gomez와 Frosst는 Google Brain 팀의 전 멤버였습니다. 2021년 11월, Google Cloud는 Cohere와 파트너십을 맺을 것이라고 발표했습니다. Google Cloud는 강력한 인프라를 사용하여 Cohere 플랫폼을 지원하고 Cohere는 Cloud의 TPU를 사용하여 제품을 개발 및 배포합니다.

코히어가 최근 시리즈 C 파이낸싱에서 2억 7천만 달러를 받아 시가총액 22억 달러의 유니콘으로 거듭났다는 점은 주목할 만합니다.

Łukasz Kaiser은 2021년에 Google을 떠나 7년 9개월 동안 Google에서 근무했으며 현재 OpenAI의 연구원입니다. Google에서 연구 과학자로 일하는 동안 그는 기계 번역, 구문 분석, 기타 알고리즘 및 생성 작업을 위한 SOTA 신경 모델 설계에 참여했으며 TensorFlow 시스템과 Tensor2Tensor 라이브러리의 공동 저자였습니다.

Jakob Uszkoreit은 2021년 Google을 떠나 13년 동안 Google에서 근무한 후 Inceptive에 공동 창업자로 합류했습니다. Inceptive는 딥러닝을 활용하여 RNA 약물을 설계하는 데 주력하는 AI 제약회사입니다.

Jakob Uszkoreit는 Google에서 근무하면서 Google Assistant의 언어 이해 팀 구성에 참여했으며 초기에는 Google 번역 작업도 수행했습니다.

Illia Polosukhin 은 2017년 Google을 떠나 현재 NEAR.AI(블록체인 기반 기술 회사)의 공동 창립자이자 CTO입니다.

아직 Google에 남아 있는 유일한 사람은 Llion Jones입니다. 올해로 Google에서 근무한 지 9년째입니다.

이제 "Attention Is All You Need" 논문이 출판된 지 6년이 지났습니다. 일부 원작자는 떠나기로 결정했고, 일부는 무슨 일이 있어도 Google에 머물기로 결정했습니다. 트랜스포머의 영향력은 아직도 계속되고 있다.

위 내용은 트랜스포머 6주년 기념: 당시에는 NeurIPS Oral도 획득하지 못했지만 8명의 저자가 여러 AI 유니콘을 설립했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

모두가 AI 사용에 더 나아지고 있습니다 : Vibe 코딩에 대한 생각Apr 19, 2025 am 11:17 AM

모두가 AI 사용에 더 나아지고 있습니다 : Vibe 코딩에 대한 생각Apr 19, 2025 am 11:17 AM컨퍼런스와 전시회에서 무슨 일이 일어나고 있는지 볼 수 있습니다. 엔지니어에게 자신이하고있는 일을 물어 보거나 CEO와 상담 할 수 있습니다. 당신이 보는 곳마다, 상황은 졸린 속도로 변화하고 있습니다. 엔지니어 및 비 엔지니어 차이점은 무엇입니까?

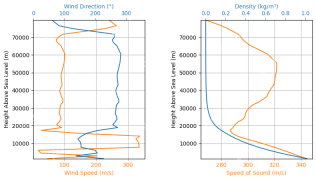

Rocketpy -Analytics Vidhya를 사용한 로켓 런칭 시뮬레이션 및 분석Apr 19, 2025 am 11:12 AM

Rocketpy -Analytics Vidhya를 사용한 로켓 런칭 시뮬레이션 및 분석Apr 19, 2025 am 11:12 AMRocketpy : 포괄적 인 가이드로 로켓 발사 시뮬레이션 이 기사는 강력한 파이썬 라이브러리 인 Rocketpy를 사용하여 고출력 로켓 런칭을 시뮬레이션하는 것을 안내합니다. 로켓 구성 요소 정의에서 Simula 분석에 이르기까지 모든 것을 다룰 것입니다.

5 무료 데이터 분석 과정 - 분석 VidhyaApr 19, 2025 am 11:11 AM

5 무료 데이터 분석 과정 - 분석 VidhyaApr 19, 2025 am 11:11 AM은행을 깨지 않고 데이터 중심의 경력 여행을 시작하십시오! 이 기사는 5 개의 탁월한 무료 데이터 분석 과정을 강조하며, 스킬 셋을 확장하려는 노련한 전문가 모두에게 적합하고 T를 탐구하고 싶어하는 호기심 많은 신입생에게 적합합니다.

Openagi를 사용하여 자율 AI 에이전트를 구축하는 방법은 무엇입니까? - 분석 VidhyaApr 19, 2025 am 11:10 AM

Openagi를 사용하여 자율 AI 에이전트를 구축하는 방법은 무엇입니까? - 분석 VidhyaApr 19, 2025 am 11:10 AMOpenagi로 AI 요원의 힘을 활용하십시오 : 포괄적 인 가이드 지칠 줄 모르는 조수를 상상해보십시오. 항상 작업을 간소화하고 통찰력있는 권장 사항을 제공 할 수 있습니다. 그것이 AI 요원의 약속이며 Openagi

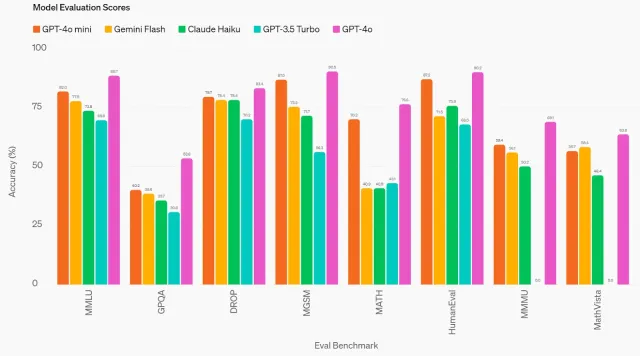

GPT-4O MINI : OpenAi의 최신 모델이 어떻게 쌓이는가?Apr 19, 2025 am 11:09 AM

GPT-4O MINI : OpenAi의 최신 모델이 어떻게 쌓이는가?Apr 19, 2025 am 11:09 AMOpenAi의 최신 제품인 GPT-4O Mini는 저렴하고 접근 가능한 고급 AI를 향한 중요한 단계입니다. 이 작은 언어 모델 (SLM)은 Llama 3 및 Gemma 2와 같은 경쟁자에게 직접 도전하여 낮은 대기 시간, 비용 효율성 및

기술 혁신가에서 건강 관리 파이오니어까지 : Geetha Manjunath 박사 ' S AI StoryApr 19, 2025 am 11:02 AM

기술 혁신가에서 건강 관리 파이오니어까지 : Geetha Manjunath 박사 ' S AI StoryApr 19, 2025 am 11:02 AM"Deading with Data"의이 에피소드에는 Niramai Analytix의 창립자이자 CEO 인 Geetha Manjunath 박사가 있습니다. AI와 의료 분야에서 25 년 이상의 경험을 가진 Manjunath 박사는 인도 과학 연구소에서 박사 학위를 취득하고 MBA FRO

Ollama -Analytics Vidhya와의 로컬 LLM 배치 단순화Apr 19, 2025 am 11:01 AM

Ollama -Analytics Vidhya와의 로컬 LLM 배치 단순화Apr 19, 2025 am 11:01 AMOllama와 함께 현지에서 오픈 소스 LLM의 힘을 활용하십시오 : 포괄적 인 가이드 LLM (Lange Language Models)을 실행하면 비교할 수없는 제어 및 투명성을 제공하지만 환경을 설정하면 어려울 수 있습니다. Ollama는이 과정을 단순화합니다

Monsterapi로 대형 언어 모델을 미세 조정하는 방법Apr 19, 2025 am 10:49 AM

Monsterapi로 대형 언어 모델을 미세 조정하는 방법Apr 19, 2025 am 10:49 AMMonsterapi와 함께 미세 조정 된 LLM의 힘을 활용 : 포괄적 인 가이드 가상 어시스턴트가 귀하의 요구를 완벽하게 이해하고 기대한다고 상상해보십시오. LLMS (Lange Models)의 발전 덕분에 이것은 현실이되고 있습니다. 그러나 a

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

Dreamweaver Mac版

시각적 웹 개발 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

mPDF

mPDF는 UTF-8로 인코딩된 HTML에서 PDF 파일을 생성할 수 있는 PHP 라이브러리입니다. 원저자인 Ian Back은 자신의 웹 사이트에서 "즉시" PDF 파일을 출력하고 다양한 언어를 처리하기 위해 mPDF를 작성했습니다. HTML2FPDF와 같은 원본 스크립트보다 유니코드 글꼴을 사용할 때 속도가 느리고 더 큰 파일을 생성하지만 CSS 스타일 등을 지원하고 많은 개선 사항이 있습니다. RTL(아랍어, 히브리어), CJK(중국어, 일본어, 한국어)를 포함한 거의 모든 언어를 지원합니다. 중첩된 블록 수준 요소(예: P, DIV)를 지원합니다.

안전한 시험 브라우저

안전한 시험 브라우저는 온라인 시험을 안전하게 치르기 위한 보안 브라우저 환경입니다. 이 소프트웨어는 모든 컴퓨터를 안전한 워크스테이션으로 바꿔줍니다. 이는 모든 유틸리티에 대한 액세스를 제어하고 학생들이 승인되지 않은 리소스를 사용하는 것을 방지합니다.

Eclipse용 SAP NetWeaver 서버 어댑터

Eclipse를 SAP NetWeaver 애플리케이션 서버와 통합합니다.