속도는 24배 증가하고, 대규모 실내 장면의 역렌더링은 30분 만에 완료할 수 있다. Rushi의 연구 결과는 CVPR 2023에 선정됐다.

역렌더링 기술에 대한 연구 결과는 2년 연속 최고 컴퓨터 비전 컨퍼런스 CVPR에 선정되었으며, 단일 이미지 처리부터 실내 장면 전체를 커버하는 것까지 루시의 3차원 재구성 분야 시각 알고리즘 기술 기반은 생생하게 보여주었습니다.

3차원 재구성은 컴퓨터 비전(CV) 및 컴퓨터 그래픽(CG) 분야에서 뜨거운 주제 중 하나입니다. CV 기술을 사용하여 카메라 등의 센서로 포착한 실제 사물과 장면의 2차원 이미지를 처리하여 3차원 입체를 얻습니다. -차원 모델. 관련 기술이 계속 발전함에 따라 스마트 홈, AR 관광, 자율주행 및 고정밀 지도, 로봇, 도시 계획, 문화재 재구성, 영화 엔터테인먼트 등 다양한 분야에서 3D 재구성이 점점 더 많이 사용되고 있습니다.

2D 이미지를 기반으로 한 일반적인 3D 얼굴 재구성. 이미지 출처: 10.1049/iet-cvi.2013.0220

전통적인 3차원 재구성은 크게 광도법과 기하학적 방법으로 나눌 수 있으며, 전자는 픽셀의 밝기 변화를 분석하고 후자는 시차를 사용하여 재구성을 완료합니다. 최근에는 머신러닝, 특히 딥러닝 기술이 활용되기 시작하여 특징 탐지, 깊이 추정 등에서 좋은 결과를 얻고 있습니다. 현재 일부 방법에서는 공간 기하학적 모델과 텍스처 맵을 사용하지만 장면의 모양은 실제 세계와 거의 동일하게 보입니다.

그러나 이러한 방법에는 여전히 몇 가지 제한 사항이 있습니다. 장면의 모양 특성만 복원할 수 있으며 장면의 조명, 반사도 및 거칠기와 같은 심층적인 속성을 디지털화할 수 없으며 이러한 심층적인 속성을 쿼리하고 편집할 수 없습니다. 정보. 일어났습니다. 또한 렌더링 엔진에서 사용할 수 있는 PBR 렌더링 자산으로 변환할 수 없으므로 사실적인 렌더링 효과를 생성할 수 없습니다. 이러한 문제를 해결하는 방법은 무엇입니까? 역 렌더링 기술은 점차 사람들의 시야에 들어왔습니다.

역 렌더링 작업은 1978년 구세대 컴퓨터 과학자인 Barrow와 Tenenbaum에 의해 처음 제안되었습니다. 3차원 재구성을 기반으로 조명, 반사도, 거칠기 및 금속성과 같은 장면의 본질적인 속성을 더욱 복원하여 달성합니다. 좀 더 사실적인 렌더링이 가능합니다. 그러나 이미지에서 이러한 속성을 분해하는 것은 매우 불안정하며 서로 다른 속성 구성으로 인해 유사한 모양이 나타나는 경우가 많습니다. 미분 가능 렌더링 및 암시적 신경 표현의 발전으로 일부 방법은 명시적 또는 암시적 사전 변수가 있는 작은 객체 중심 장면에서 좋은 결과를 얻었습니다.

그러나 대규모 실내 장면의 역렌더링은 실제 장면에서 물리적으로 합리적인 자료를 복원하는 것이 어려울 뿐만 아니라 장면 내에서 다중 관점의 일관성을 보장하는 것도 잘 해결되지 않았습니다. 중국에는 핵심 알고리즘의 독립적인 연구 개발에 깊이 관여하고 3D 재구성 분야의 대규모 산업 응용에 중점을 두는 기술 회사가 있습니다. Realsee는 대규모 역 렌더링이라는 어려운 주제를 개척했습니다. 실내 장면을 확장하세요. 효율적인 멀티뷰 역 렌더링 프레임워크. 이 논문은 CVPR 2023 컨퍼런스에 채택되었습니다.

- 프로젝트 주소: http://yodlee.top/TexIR/

- 논문 주소: https://arxiv.org/pdf/2211.10206.pdf

구체적으로 Rushixin은 정확한 공간 기반 이 방법은 조명, 반사도, 거칠기 등과 같은 장면의 본질적인 속성을 역으로 추측하고 3차원 재구성을 기반으로 실제 장면에 가까운 조명 및 재료 성능을 복원하여 재구성을 향상시킬 수 있습니다. 효과, 비용 효율성, 적용 범위 등 차원이 전반적으로 개선되었습니다.

이 글에서는 Rushi의 대규모 실내 장면을 위한 멀티뷰 역렌더링 기술을 자세히 이해하고, 그 장점에 대한 심도 있는 분석을 제공하겠습니다.

대규모 실내 장면의 경우

Rushi의 새로운 역렌더링 기술은 "정확하고 세밀하며 빠른"을 달성합니다.

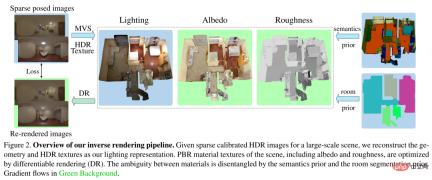

아래 그림 2는 Rushi의 새로운 역렌더링 방법의 전체 프로세스를 보여줍니다. 대규모 실내 장면의 보정된 HDR 이미지 세트가 주어지면 이 방법은 전역적으로 일관된 조명 및 SVBRDF(양방향 반사 분포 함수)를 정확하게 복구하여 이미지 파이프라인 및 다운스트림 애플리케이션에 쉽게 통합하는 것을 목표로 합니다.

이러한 목표를 달성하기 위해 Rushi는 먼저 3D 메쉬와 HDR 텍스처로 구성되어 전체 실내 대형 장면의 모든 위치를 효율적으로 모델링하는 TBL(Texture-based Lighting)이라는 컴팩트한 조명 표현을 제안했습니다. 직접 조명과 무한 바운스 간접 조명을 위한 조명입니다. Rushi는 TBL을 기반으로 미리 계산된 방사조도를 사용한 혼합 조명 표현을 제안하여 재료 최적화에서 효율성을 크게 향상시키고 렌더링 노이즈를 줄였습니다. 마지막으로 Rushi는 복잡한 대규모 실내 장면에서 재료의 물리적 모호성을 잘 처리할 수 있는 세그먼트 기반의 3단계 재료 최적화 전략을 도입했습니다.

텍스처 기반 조명(TBL)

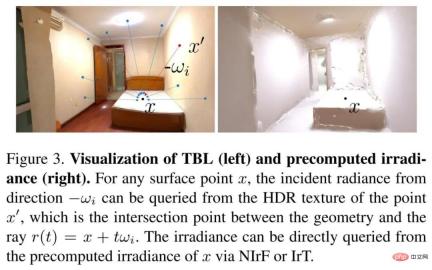

대규모 실내 장면의 조명을 표현할 때 TBL의 장점은 신경 표현의 컴팩트함, IBL 전역 조명 및 파라메트릭 조명의 해석 가능성 및 공간적 일관성에서 나타납니다. . TBL은 전체 장면의 전역 표현으로, 모든 표면 지점에서 방출되는 방사조도를 정의합니다. 표면 지점에서 방출된 방사조도는 일반적으로 HDR 텍스처의 값, 즉 입력 HDR 이미지의 해당 픽셀에서 관찰된 HDR 방사조도와 같습니다.

Rushi는 자체 개발한 고품질 3D 재구성 기술을 사용하여 전체 대형 장면의 메쉬 모델을 재구성합니다. 마지막으로 입력 HDR 이미지를 기반으로 HDR 텍스처가 재구성되고 HDR 텍스처를 통해 모든 위치와 방향에서 전역 조명이 쿼리됩니다. 아래 그림 3(왼쪽)은 TBL의 시각화를 보여줍니다.

혼합 조명 표현

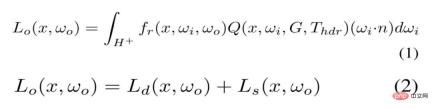

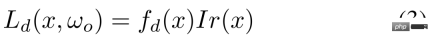

실제로 TBL을 직접 사용하여 재료를 최적화하는 데에는 몬테카를로 샘플 수가 많으면 컴퓨팅 및 메모리 비용이 높아진다는 단점이 있습니다. 대부분의 노이즈는 확산 구성요소에 존재하므로 확산 구성요소에 대한 표면 점의 방사조도가 미리 계산됩니다. 따라서 그림 3(오른쪽)에 표시된 것처럼 비용이 많이 드는 온라인 계산을 대체하여 방사조도를 효율적으로 쿼리할 수 있습니다. TBL 기반 렌더링 수식은 수학식 1에서 수학식 2로 다시 작성된다.

Rushi는 미리 계산된 방사조도를 모델링하기 위해 두 가지 표현을 제안합니다. 하나는 신경 복사장(NIrF)으로, 표면 점을 입력으로 사용하고 복사 조도 p를 출력하는 얕은 다층 퍼셉트론(MLP)입니다. 다른 하나는 IrT(Irradiance Texture)로, 컴퓨터 그래픽에서 일반적으로 사용되는 라이트맵과 유사합니다.

보시다시피, 이 하이브리드 조명 표현에는 확산 구성 요소에 대한 미리 계산된 방사 조도와 반사 구성 요소에 대한 소스 TBL이 포함되어 있어 렌더링 노이즈를 크게 줄이고 재료의 효율적인 최적화를 달성합니다. 식(2)의 확산 성분은 식(3)과 같이 모델링됩니다.

분할 기반의 3단계 재료 추정

신경 재료의 경우 매우 복잡한 재료로 대규모 장면을 모델링하기 어렵고 기존 그래픽 엔진에는 적합하지 않습니다. 형상을 직접적으로 최적화하는 명시적 재질 텍스처를 선택하는 대신 SV 알베도 및 SV 거칠기를 매개변수로 사용하여 Disney BRDF 모델의 단순화된 버전을 사용했습니다. 그러나 관찰의 희소성으로 인해 명시적인 재질 질감을 직접 최적화하면 일관성이 없고 수렴되지 않는 거칠기가 발생합니다.

이와 관련하여 Rushi는 이 문제를 해결하기 위해 의미론적 및 공간 분할 사전을 활용합니다. 여기서 의미론적 이미지는 학습 기반 모델로 예측되고 공간 분할은 점유 그리드로 계산됩니다. 구현 과정에서 Rushi는 3단계 전략을 채택했습니다.

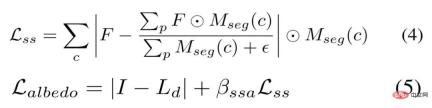

첫 번째 단계에서는 작은 물체 중심의 장면처럼 알베도를 상수로 초기화하는 대신 Lambertian 가정을 기반으로 희소 알베도를 최적화합니다. 확산 알베도는 공식 (3)으로 직접 계산할 수 있지만 하이라이트 영역에서 알베도를 너무 밝게 만들어 다음 단계에서 과도한 거칠기를 초래하게 됩니다. 따라서 아래 식 (4)와 같이 동일한 의미론적 분할에서 유사한 알베도를 자극하기 위해 의미론적 평활화 제약 조건을 사용합니다. 희소 알베도는 방정식 (5)에 의해 최적화됩니다.

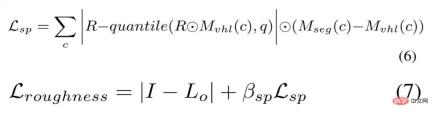

2단계 VHL(가상 하이라이트) 기반 샘플링 및 의미 기반 전파. 다중 뷰 이미지에서는 특히 대규모 장면에서 전체적으로 일관되지 않은 거칠기로 이어지는 희박한 반사 단서만 관찰될 수 있습니다. 그러나 사전 의미 분할을 통해 하이라이트 영역의 합리적인 거칠기가 동일한 의미를 갖는 영역으로 전파될 수 있습니다.

Rushi는 먼저 각 의미 클래스에 대한 VHL 영역을 찾기 위해 거칠기 0.01의 입력 포즈를 기반으로 이미지를 렌더링한 다음 고정된 희소 알베도 및 조명을 기반으로 이러한 VHL의 거칠기를 최적화합니다. 합리적인 거칠기는 방정식 (6)을 통해 동일한 의미 분할로 전파될 수 있으며, 이 거칠기는 방정식 (7)을 통해 최적화될 수 있습니다.

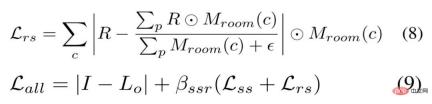

분할 기반 미세 조정의 세 번째 단계. RuShi는 의미론적 분할 및 공간 분할 사전을 기반으로 모든 재료 텍스처를 미세 조정합니다. 특히 Rushi는 방정식 (4)와 유사한 평활화 제약 조건과 거칠기에 대한 공간 평활화 제약 조건을 사용하여 서로 다른 방의 거칠기를 더 부드럽고 매끄럽게 만듭니다. 룸 스무딩 제약 조건은 식 (8)로 정의되며, 알베도에 대한 스무딩 제약 조건을 사용하지 않으면 총 손실은 식 (9)로 정의됩니다.

실험 설정 및 효과 비교

dataset에 대해 Rushi는 합성 데이터 세트와 실제 데이터 세트라는 두 가지 데이터 세트를 사용했습니다. 전자의 경우 Rushi는 경로 추적기를 사용하여 다양한 재료와 조명으로 합성 장면을 만들고 최적화를 위해 24개의 뷰를 렌더링했으며 14개의 새로운 뷰를 렌더링하여 각 뷰에 대한 Ground Truth 재료 이미지를 렌더링했습니다. 후자의 경우 Scannet, Matterport3D 및 Replica와 같이 일반적으로 사용되는 대규모 장면의 실제 데이터 세트에 풀 HDR 이미지가 부족하기 때문에 Rushi는 10개의 풀 HDR 실제 데이터 세트를 수집하고 7개의 브래킷 노출을 병합하여 10~20개를 캡처했습니다. 풀 HDR 파노라마 이미지.

기준 방법 정보. 대규모 장면의 다시점 이미지에서 SVBRDF를 복구하기 위해 현재 역 렌더링 방법에는 단일 이미지 학습 기반의 SOTA 방식 PhyIR, 다시점 객체 중심 SOTA 신경 렌더링 방법 InvRender, NVDIFFREC 및 NeILF가 포함됩니다. 평가 지표와 관련하여 우리는 PSNR, SSIM 및 MSE를 사용하여 정량적 비교를 위해 재료 예측 및 다시 렌더링된 이미지를 평가하고, MAE 및 SSIM을 사용하여 다양한 조명 표현으로 렌더링된 재조명 이미지를 평가합니다.

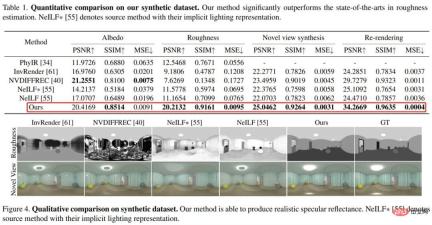

먼저 아래 표 1과 그림 4에 표시된 것처럼 합성 데이터 세트에 대한 평가를 살펴보면, as-view 방법은 거칠기 추정에서 SOTA 방법보다 훨씬 뛰어난 성능을 발휘하며 거칠기는 물리적으로 합리적인 정반사율을 생성할 수 있습니다. 또한 원래의 암시적 표현과 비교하여 시각적 하이브리드 조명 표현을 갖춘 NeILF는 재료와 조명 간의 모호성을 줄입니다.

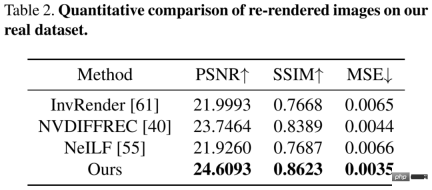

그런 다음 복잡한 재료와 조명이 포함된 까다로운 실제 데이터 세트에 대해 평가했습니다. 아래 표 2의 정량적 비교 결과는 RuShi 방법이 이전 방법보다 우수하다는 것을 보여줍니다. 이러한 방법에는 대략적인 재렌더링 오류가 있지만 시각적 방법만이 전역적으로 일관되고 물리적으로 건전한 자료를 분리합니다.

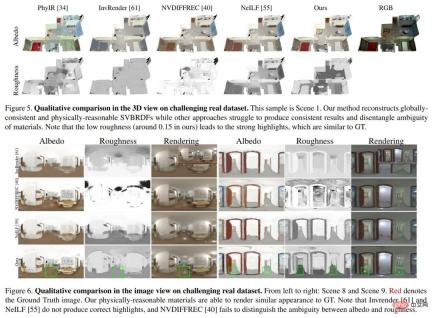

아래 그림 5와 그림 6은 각각 3D 보기와 2D 이미지 보기의 질적 비교를 보여줍니다. PhyIR은 도메인 간격이 커서 일반화 성능이 좋지 않으며 전역 일관성 예측을 달성할 수 없습니다. InvRender, NVDIFFREC 및 NeILF는 올바른 자료를 분리하기 어렵게 만드는 아티팩트로 모호한 예측을 생성했습니다. NVDIFFREC은 RuSight 방법과 유사한 성능을 얻을 수 있지만 반사 성분의 하이라이트가 확산 알베도로 잘못 복원되는 등 알베도와 거칠기 사이의 모호성을 분리할 수 없습니다.

Ablation 실험

TBL, 혼합 조명 표현, 첫 번째 단계의 알베도 초기화, 두 번째 단계의 거칠기 추정과 같은 조명 표현 및 재료 최적화 전략의 효율성을 입증하기 위해 VHL 샘플링 및 절제 실험을 위해 의미 전파 및 세그멘테이션 기반 미세 조정의 세 번째 단계가 수행되었습니다.

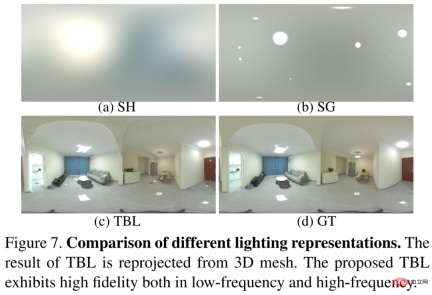

먼저TBL을 이전 방법에서 널리 사용되는 SH 조명 및 SG 조명 방법과 비교하면 그림 7과 같이 TBL은 저주파 및 고주파 모두에서 높은 충실도를 보여줍니다. 주파수 특징.

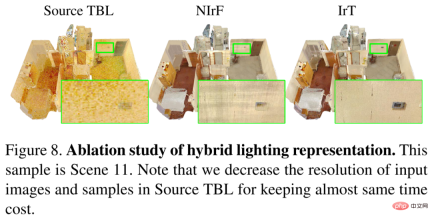

혼합 조명 표현을 원본 TBL과 비교하여 결과를 아래 그림 8에 표시합니다. 혼합된 조명 표현이 없으면 알베도는 소음을 발생시키고 느리게 수렴될 수 있습니다. 미리 계산된 방사 조도를 도입하면 고해상도 입력을 사용하여 미세한 재료를 복구하고 최적화 프로세스 속도를 크게 높일 수 있습니다. 동시에 IrT는 NIrF에 비해 더 미세하고 인공물이 없는 알베도를 생성합니다.

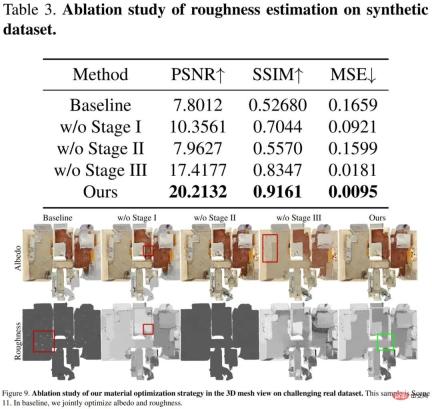

3단계 전략의 유효성이 검증되었으며, 그 결과는 아래 표 3과 그림 9에 나와 있습니다. 기준선 거칠기가 수렴하지 못하고 하이라이트 영역만 업데이트됩니다. 첫 번째 단계에서 알베도 초기화를 수행하지 않으면 하이라이트 영역이 너무 밝아져 거칠기가 잘못됩니다. VHL 기반 샘플링 및 의미 기반 전파의 두 번째 단계는 반사 하이라이트가 관찰되지 않는 영역에서 합리적인 거칠기를 복구하는 데 중요합니다. 분할 기반 미세 조정의 세 번째 단계에서는 미세한 알베도를 생성하여 최종 거칠기를 더 매끄럽게 만들고 서로 다른 재료 간의 거칠기 오류 전파를 방지합니다.

루시의 새로운 역렌더링 기술, 장점은 무엇인가요?

실제로 Rushi는 CVPR 2022 논문 "PhyIR: Physics-based Inverse Rendering for Panoramic Indoor Images"에서 신경망 훈련 방법을 제안하여 단일 이미지의 역 렌더링 작업에서 SOTA 결과를 달성했습니다. 이제 새로운 역 렌더링 프레임워크는 집 전체, 공간 및 장면 등 다양한 관점을 달성할 뿐만 아니라 이전 역 렌더링 방법의 많은 주요 결함을 해결합니다.

우선합성 데이터 훈련을 기반으로 한 이전 방법은 실제 시나리오에서 잘 수행되지 않았습니다. Rushi의 새로운 깊이 역 렌더링 프레임워크는 다단계 재료 최적화를 통해 Rushi 디지털 공간의 세계 최대 3차원 공간 데이터베이스 생활 공간 데이터와 결합하여 "계층적 장면 사전"을 처음으로 도입합니다. 거칠기와 같은 물리적 특성을 분석하여 계층적이고 정확한 예측이 가능합니다.

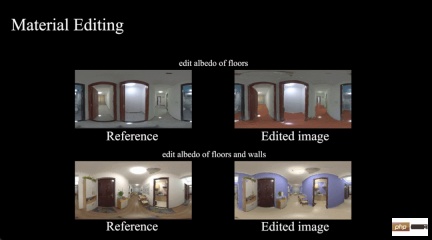

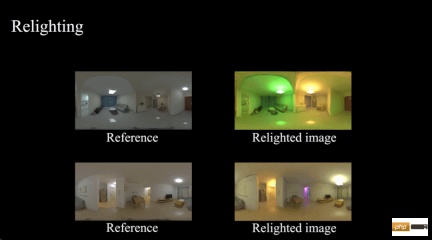

예측 결과최종 출력은 RuShi 장치에서 실제로 캡처한 실내 장면 데이터를 디지털 렌더링 자산으로 원활하게 변환하여 다음과 같은 현재의 모든 주류 렌더링 엔진에 적응하는 물리적으로 합리적이고 전 세계적으로 일관된 다중 유형 재료 맵입니다. Unity 및 Blender를 사용하면 재료 편집, 새로운 뷰 합성, 재조명, 가상 객체 삽입 등과 같은 장면 자산 및 물리 기반 MR 애플리케이션의 자동 생성이 가능합니다. 이 다재다능한 디지털 자산은 향후 더욱 다양한 애플리케이션과 제품을 지원하는 데 도움이 됩니다.

재료 편집

Relighting

두 번째로최적화를 기반으로 한 이전의 미분 가능 렌더링 방법은 계산 비용이 매우 많이 들고 비효율적입니다. 최근에는 역 렌더링 문제를 더 잘 해결하고 훈련 데이터에 대한 의존도를 줄이기 위해 미분 가능한 렌더링 방법이 제안되었습니다. 그래디언트를 렌더링 매개변수에 전파하고 최종적으로 최적화를 통해 물리 기반으로 해결해야 할 매개변수를 얻습니다. 이러한 방법에는 구형 조화(SH) 조명[1]과 3차원 구형 가우스(VSG) 조명이 포함됩니다.

그러나 대규모 실내 장면에는 폐색 및 그림자와 같은 복잡한 광학 효과가 많이 있습니다. 미분 렌더링으로 전역 조명을 모델링하면 계산 비용이 높아집니다. 예를 들어, 이번에 제안한 TBL은 실내 장면의 전역 조명을 효율적이고 정확하게 표현할 수 있으며 약 20MB의 메모리만 필요하지만, Dense Grid 기반 VSG 조명[2]은 약 1GB의 메모리가 필요하고 Sparse Grid 기반 SH 조명 방식 플레녹셀 [3] 약 750MB의 메모리가 필요하며, 데이터 메모리 용량은 수십 배나 줄어들었습니다.

그뿐만 아니라 Rushi의 새로운 방법은30분 안에 전체 실내 장면의 역 렌더링을 완료할 수 있는 반면, 기존 방법 [4]은 약 12시간이 소요될 수 있으며 이는 전체 24배 개선된 것입니다. 컴퓨팅 속도가 크게 향상되면 비용이 절감되고 비용 대비 성능이 크게 향상되어 대규모 실제 응용 프로그램에 한 발 더 다가갈 수 있습니다.

마지막으로 기존 NeRF와 유사한 신경 역 렌더링 방법(예: PS-NeRF [5], NeRFactor [6] 등)은 주로 객체 중심의 소규모 장면을 지향하며 대규모 모델링은 불가능해 보입니다. 실내 장면의 규모를 조정하세요. Rushi의 정확한 디지털 공간 모델과 효율적이고 정확한 혼합 조명 표현을 기반으로 하는 새로운 역 렌더링 프레임워크는 의미론적 분할 및 공간 분할 사전을 도입하여 이 문제를 해결합니다. 이 새로운 깊이 역 렌더링 프레임워크에 대해 Rushi 수석 과학자 Pan Cihui는 "실제 세계의 더 깊은 디지털화를 달성하고 이전 역 렌더링 방법이 실제 장면에서 물리적으로 합리적인 재료와 질감을 복원하는 데 어려움을 겪었던 문제를 해결합니다."라고 말했습니다. 조명 및 다시점 일관성 문제로 인해 3D 재구성 및 MR 적용에 더 큰 상상력이 생겼습니다. "역 렌더링 기술의 장점 파악디지털 공간에서 VR + 산업 통합을 혁신항상 Vision과 같은 3D 재구성 분야에서 많은 기술을 축적해 왔으며, 관련 알고리즘을 다듬고 구현하는 데 많은 에너지를 투자했습니다. 동시에 최첨단 기술의 연구 개발에 큰 지원을 제공하고 업계 최고의 기술을 확보하는 데 큰 중요성을 부여합니다. 이는 새로운 역 렌더링 기술을 포함한 RuShi의 3D 실생활 모델 재구성 및 MR 연구의 중요한 기반이 되어 국제 학계로부터 인정을 받았으며 RuShi의 알고리즘 역량이 이론 연구 및 기술 분야에서 세계 최고의 수준에 도달하는 데 도움이 되었습니다. 응용 프로그램.이러한 알고리즘과 기술적 장점은 현실 세계의 디지털화를 더욱 심화시키고 디지털 공간 구축을 더욱 가속화할 것입니다. 현재 Rushi Digital Space는 자체 개발한 수집 장비를 통해 다양한 국가와 다양한 응용 시나리오에서 2,700만 세트 이상의 컬렉션을 축적했으며 면적은 22억 7,400만 평방미터에 달합니다. Rushi Digital Space는 또한 VR + 산업 통합 개발 방향을 지원하여 상업 소매, 산업 시설, 문화 전시, 공공 업무, 가정 장식, 부동산 거래 및 VR 하우스 뷰잉과 같은 기타 산업에 디지털 애플리케이션 업그레이드를 위한 새로운 개발 기회를 제공할 것입니다. , VR 박물관 등.

Rushi가 만든 AI 마케팅 어시스턴트

VR + 산업 통합을 위해 Rushi의 가장 큰 장점은 지속적으로 진화하는 디지털 재구성 알고리즘과 방대한 실제 데이터의 축적에 있습니다. 장벽과 대규모 데이터 장벽. 이러한 알고리즘과 데이터도 어느 정도 서로 순환하면서 그 장점을 지속적으로 확장할 수 있습니다. 동시에 데이터와 알고리즘의 장벽으로 인해 Rushi는 다양한 산업의 문제점을 해결하고 기술 솔루션을 도입하며 산업 발전의 새로운 모델을 혁신하는 것을 더 쉽게 만들었습니다.

역 렌더링 기술의 성과는 2년 연속 CVPR에 선정되었습니다. 이는 주로 Rushi가 MR 방향에 변화를 만들고 업계에서 일부 구현을 달성하기를 원하기 때문입니다. 앞으로 Rushi는 실제 VR과 순수 가상 시뮬레이션 사이의 격차를 열고 가상과 실제의 진정한 통합을 달성하며 더 많은 산업 애플리케이션을 구축하기를 희망합니다.

위 내용은 속도는 24배 증가하고, 대규모 실내 장면의 역렌더링은 30분 만에 완료할 수 있다. Rushi의 연구 결과는 CVPR 2023에 선정됐다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

모두가 AI 사용에 더 나아지고 있습니다 : Vibe 코딩에 대한 생각Apr 19, 2025 am 11:17 AM

모두가 AI 사용에 더 나아지고 있습니다 : Vibe 코딩에 대한 생각Apr 19, 2025 am 11:17 AM컨퍼런스와 전시회에서 무슨 일이 일어나고 있는지 볼 수 있습니다. 엔지니어에게 자신이하고있는 일을 물어 보거나 CEO와 상담 할 수 있습니다. 당신이 보는 곳마다, 상황은 졸린 속도로 변화하고 있습니다. 엔지니어 및 비 엔지니어 차이점은 무엇입니까?

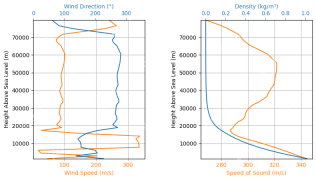

Rocketpy -Analytics Vidhya를 사용한 로켓 런칭 시뮬레이션 및 분석Apr 19, 2025 am 11:12 AM

Rocketpy -Analytics Vidhya를 사용한 로켓 런칭 시뮬레이션 및 분석Apr 19, 2025 am 11:12 AMRocketpy : 포괄적 인 가이드로 로켓 발사 시뮬레이션 이 기사는 강력한 파이썬 라이브러리 인 Rocketpy를 사용하여 고출력 로켓 런칭을 시뮬레이션하는 것을 안내합니다. 로켓 구성 요소 정의에서 Simula 분석에 이르기까지 모든 것을 다룰 것입니다.

5 무료 데이터 분석 과정 - 분석 VidhyaApr 19, 2025 am 11:11 AM

5 무료 데이터 분석 과정 - 분석 VidhyaApr 19, 2025 am 11:11 AM은행을 깨지 않고 데이터 중심의 경력 여행을 시작하십시오! 이 기사는 5 개의 탁월한 무료 데이터 분석 과정을 강조하며, 스킬 셋을 확장하려는 노련한 전문가 모두에게 적합하고 T를 탐구하고 싶어하는 호기심 많은 신입생에게 적합합니다.

Openagi를 사용하여 자율 AI 에이전트를 구축하는 방법은 무엇입니까? - 분석 VidhyaApr 19, 2025 am 11:10 AM

Openagi를 사용하여 자율 AI 에이전트를 구축하는 방법은 무엇입니까? - 분석 VidhyaApr 19, 2025 am 11:10 AMOpenagi로 AI 요원의 힘을 활용하십시오 : 포괄적 인 가이드 지칠 줄 모르는 조수를 상상해보십시오. 항상 작업을 간소화하고 통찰력있는 권장 사항을 제공 할 수 있습니다. 그것이 AI 요원의 약속이며 Openagi

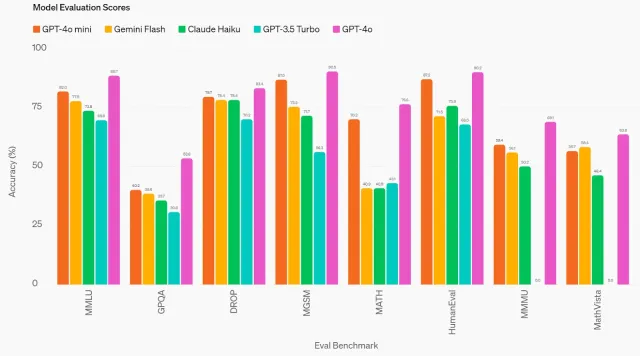

GPT-4O MINI : OpenAi의 최신 모델이 어떻게 쌓이는가?Apr 19, 2025 am 11:09 AM

GPT-4O MINI : OpenAi의 최신 모델이 어떻게 쌓이는가?Apr 19, 2025 am 11:09 AMOpenAi의 최신 제품인 GPT-4O Mini는 저렴하고 접근 가능한 고급 AI를 향한 중요한 단계입니다. 이 작은 언어 모델 (SLM)은 Llama 3 및 Gemma 2와 같은 경쟁자에게 직접 도전하여 낮은 대기 시간, 비용 효율성 및

기술 혁신가에서 건강 관리 파이오니어까지 : Geetha Manjunath 박사 ' S AI StoryApr 19, 2025 am 11:02 AM

기술 혁신가에서 건강 관리 파이오니어까지 : Geetha Manjunath 박사 ' S AI StoryApr 19, 2025 am 11:02 AM"Deading with Data"의이 에피소드에는 Niramai Analytix의 창립자이자 CEO 인 Geetha Manjunath 박사가 있습니다. AI와 의료 분야에서 25 년 이상의 경험을 가진 Manjunath 박사는 인도 과학 연구소에서 박사 학위를 취득하고 MBA FRO

Ollama -Analytics Vidhya와의 로컬 LLM 배치 단순화Apr 19, 2025 am 11:01 AM

Ollama -Analytics Vidhya와의 로컬 LLM 배치 단순화Apr 19, 2025 am 11:01 AMOllama와 함께 현지에서 오픈 소스 LLM의 힘을 활용하십시오 : 포괄적 인 가이드 LLM (Lange Language Models)을 실행하면 비교할 수없는 제어 및 투명성을 제공하지만 환경을 설정하면 어려울 수 있습니다. Ollama는이 과정을 단순화합니다

Monsterapi로 대형 언어 모델을 미세 조정하는 방법Apr 19, 2025 am 10:49 AM

Monsterapi로 대형 언어 모델을 미세 조정하는 방법Apr 19, 2025 am 10:49 AMMonsterapi와 함께 미세 조정 된 LLM의 힘을 활용 : 포괄적 인 가이드 가상 어시스턴트가 귀하의 요구를 완벽하게 이해하고 기대한다고 상상해보십시오. LLMS (Lange Models)의 발전 덕분에 이것은 현실이되고 있습니다. 그러나 a

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

Dreamweaver Mac版

시각적 웹 개발 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

mPDF

mPDF는 UTF-8로 인코딩된 HTML에서 PDF 파일을 생성할 수 있는 PHP 라이브러리입니다. 원저자인 Ian Back은 자신의 웹 사이트에서 "즉시" PDF 파일을 출력하고 다양한 언어를 처리하기 위해 mPDF를 작성했습니다. HTML2FPDF와 같은 원본 스크립트보다 유니코드 글꼴을 사용할 때 속도가 느리고 더 큰 파일을 생성하지만 CSS 스타일 등을 지원하고 많은 개선 사항이 있습니다. RTL(아랍어, 히브리어), CJK(중국어, 일본어, 한국어)를 포함한 거의 모든 언어를 지원합니다. 중첩된 블록 수준 요소(예: P, DIV)를 지원합니다.

안전한 시험 브라우저

안전한 시험 브라우저는 온라인 시험을 안전하게 치르기 위한 보안 브라우저 환경입니다. 이 소프트웨어는 모든 컴퓨터를 안전한 워크스테이션으로 바꿔줍니다. 이는 모든 유틸리티에 대한 액세스를 제어하고 학생들이 승인되지 않은 리소스를 사용하는 것을 방지합니다.

Eclipse용 SAP NetWeaver 서버 어댑터

Eclipse를 SAP NetWeaver 애플리케이션 서버와 통합합니다.