本日、Google は Gemini 1.5 のリリースを発表しました。

Gemini 1.5 は、Google の基礎モデルとインフラストラクチャにおける研究とエンジニアリングの革新に基づいて開発されました。このリリースでは、Gemini 1.5 のトレーニングとサービスの効率を向上させるための新しい Mix of Experts (MoE) アーキテクチャが導入されています。

Google がリリースしたのは、初期テスト用の Gemini 1.5 の最初のバージョン、つまり Gemini 1.5 Pro です。これは、さまざまなタスク向けに拡張および最適化された中規模のマルチモーダル モデルです。 Google の最大のモデルである 1.0 Ultra と比較して、Gemini 1.5 Pro は同様のパフォーマンス レベルを提供し、長いコンテキストをよりよく理解するための画期的な実験的機能を導入しています。

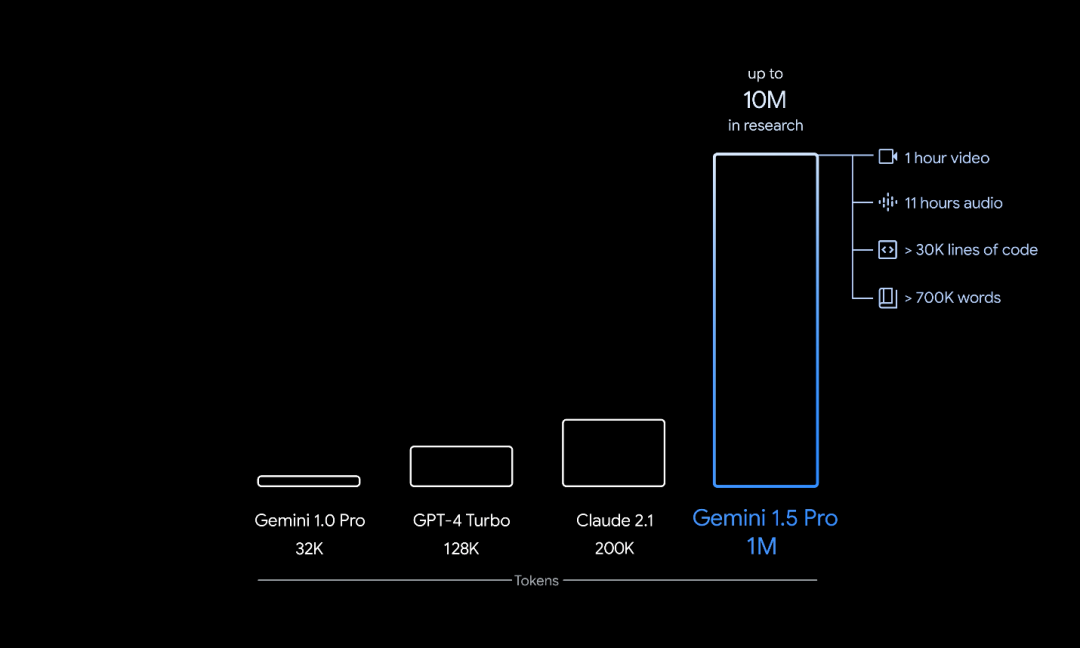

Gemini 1.5 Pro のトークン コンテキスト ウィンドウの数は 128,000 です。ただし、Google は本日より、限られた数の開発者と企業顧客に AI Studio と Vertex AI のプライベート プレビューを提供し、最大 1,000,000 トークンのコンテキスト ウィンドウで試用できるようにします。さらに、Google はレイテンシーの改善、コンピューティング要件の軽減、ユーザー エクスペリエンスの向上を目的としたいくつかの最適化を行っています。

Google CEO の Sundar Pichai 氏と Google DeepMind CEO の Demis Hassabis 氏が新モデルを特別に紹介しました。

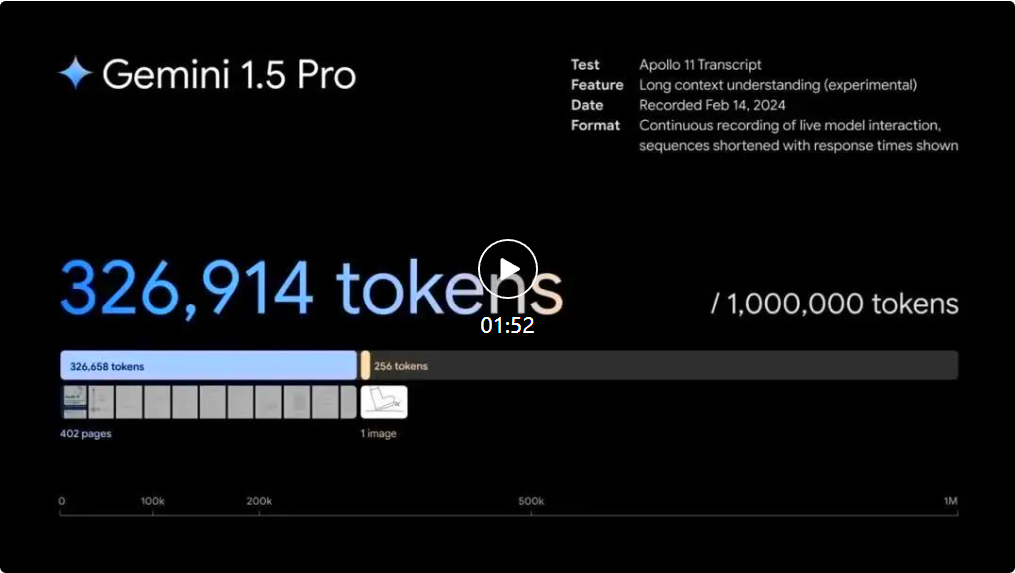

Gemini 1.5 建立在Google對Transformer 和MoE 架構的領先研究之上。傳統 Transformer 充當一個大型神經網絡,而 MoE 模型則分為更小的 “專家” 神經網絡。 根據給定輸入的類型,MoE 模型學會選擇性地僅激活其神經網路中最相關的專家路徑。這種專業化極大地提高了模型的效率。透過稀疏門控 MoE、GShard-Transformer、Switch-Transformer、M4 等研究,Google 一直是深度學習 MoE 技術的早期採用者和先驅。 Google在模型架構方面的最新創新使 Gemini 1.5 能夠更快地學習複雜任務並保持質量,同時更有效率地訓練和服務。這些效率正在幫助Google團隊比以往更快地迭代、培訓和交付更高級的 Gemini 版本,並且正在努力進一步優化。 人工智慧模型的“上下文視窗」 由token 組成,token 是用來處理資訊的建構塊。 token 可以是文字、圖像、影片、音訊或程式碼的整個部分或子部分。模型的上下文視窗越大,它在給定提示中可以接收和處理的資訊就越多,使其輸出更加一致、相關和有用。 透過一系列機器學習創新,Google增加了 1.5 Pro 的上下文視窗容量,遠遠超出了 Gemini 1.0 最初的 32,000 個 token。這個大模型現在可以在生產環境中運行多達 100 萬個 token。 這意味著1.5 Pro 可以一次處理大量訊息,包括1 小時的視訊、11 小時的音訊、超過30,000 行程式碼或超過700,000 個單字的程式碼庫。在Google的研究中,也成功測試了多達 1000 萬個 token。 #1.5 Pro 可以在給定提示內無縫分析、分類和總結大量內容。例如,當給出阿波羅 11 號登月任務的 402 頁記錄時,它可以推理整個文件中的對話、事件和細節。  Gemini 1.5 Pro 可理解、推理和辨識阿波羅 11 號登月任務的 402 頁記錄中的好奇細節。 1.5 Pro 可以針對包括影片在內的不同模式執行高度複雜的理解和推理任務。例如,當給定一部 44 分鐘的巴斯特・基頓無聲電影時,模型可以準確分析各種情節點和事件,甚至推理出電影中容易被忽略的小細節。 Gemini 1.5 Pro 可以理解、推理和識別阿波羅 11 號登月任務的 402 頁記錄中的好奇細節。 1.5 Pro可以針對包括影片在內的不同模式執行高度複雜的理解和推理任務。例如,當給定一部 44 分鐘的巴斯特・基頓無聲電影時,模型可以準確分析各種情節點和事件,甚至推理出電影中容易被忽略的小細節。 Gemini 1.5 Pro 可以理解、推理和識別阿波羅 11 號登月任務的 402 頁記錄中的好奇細節。 1.5 Pro可以針對包括影片在內的不同模式執行高度複雜的理解和推理任務。例如,當給定一部 44 分鐘的巴斯特・基頓無聲電影時,模型可以準確分析各種情節點和事件,甚至推理出電影中容易被忽略的小細節。

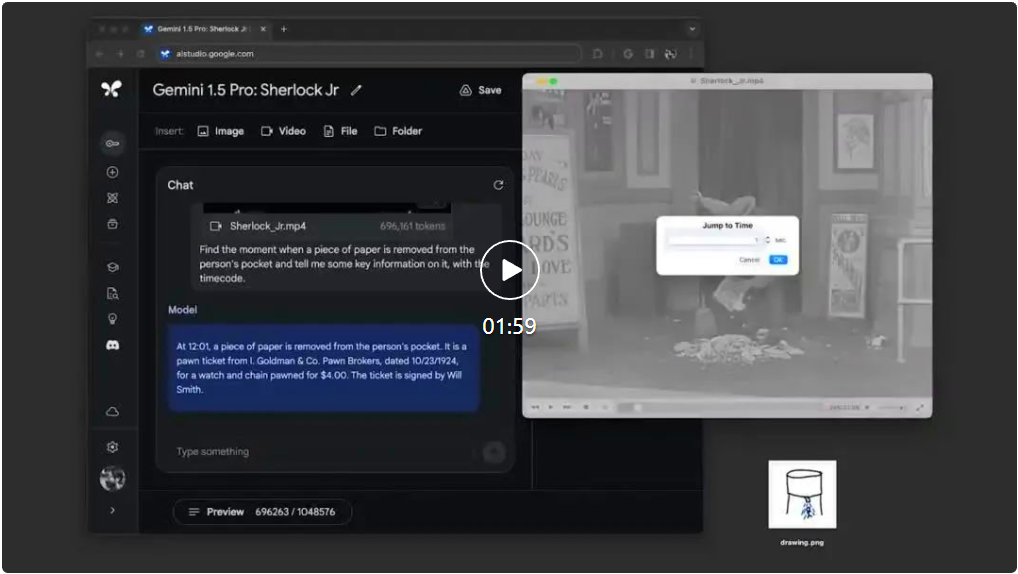

Gemini 1.5 Pro 可理解、推理和辨識阿波羅 11 號登月任務的 402 頁記錄中的好奇細節。 1.5 Pro 可以針對包括影片在內的不同模式執行高度複雜的理解和推理任務。例如,當給定一部 44 分鐘的巴斯特・基頓無聲電影時,模型可以準確分析各種情節點和事件,甚至推理出電影中容易被忽略的小細節。 Gemini 1.5 Pro 可以理解、推理和識別阿波羅 11 號登月任務的 402 頁記錄中的好奇細節。 1.5 Pro可以針對包括影片在內的不同模式執行高度複雜的理解和推理任務。例如,當給定一部 44 分鐘的巴斯特・基頓無聲電影時,模型可以準確分析各種情節點和事件,甚至推理出電影中容易被忽略的小細節。 Gemini 1.5 Pro 可以理解、推理和識別阿波羅 11 號登月任務的 402 頁記錄中的好奇細節。 1.5 Pro可以針對包括影片在內的不同模式執行高度複雜的理解和推理任務。例如,當給定一部 44 分鐘的巴斯特・基頓無聲電影時,模型可以準確分析各種情節點和事件,甚至推理出電影中容易被忽略的小細節。  當給出簡單的線條圖作為現實生活中物體的參考材料時,Gemini 1.5 Pro 可以識別 44 分鐘的巴斯特基頓無聲電影中的場景。1.5 Pro 可以跨較長的程式碼區塊執行更相關的問題解決任務。當給出超過 100,000 行程式碼的提示時,它可以更好地推理範例、建議有用的修改並解釋程式碼不同部分的工作原理。

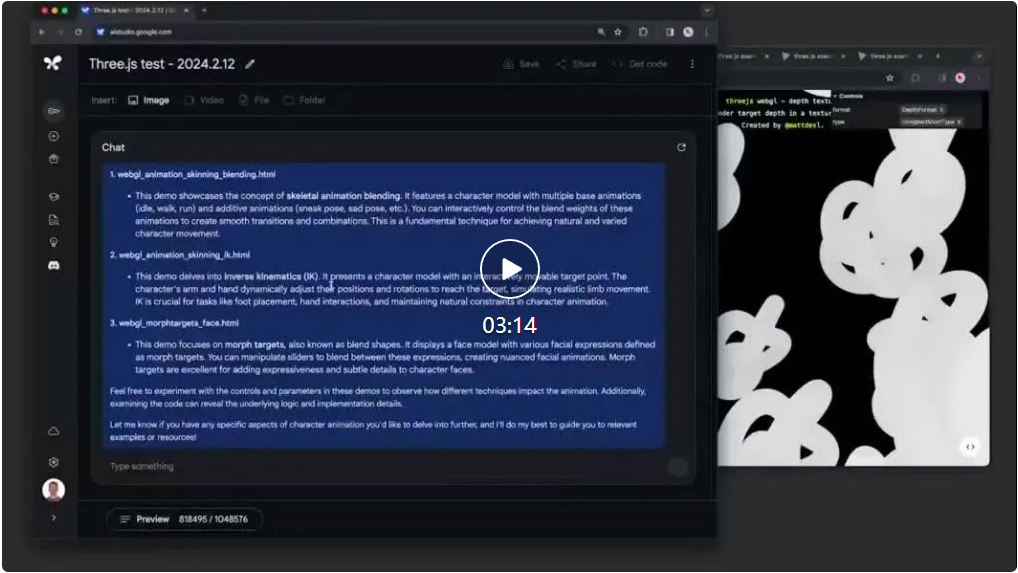

當給出簡單的線條圖作為現實生活中物體的參考材料時,Gemini 1.5 Pro 可以識別 44 分鐘的巴斯特基頓無聲電影中的場景。1.5 Pro 可以跨較長的程式碼區塊執行更相關的問題解決任務。當給出超過 100,000 行程式碼的提示時,它可以更好地推理範例、建議有用的修改並解釋程式碼不同部分的工作原理。  Gemini 1.5 Pro 可以推理100,000 行代碼,提供有用的解決方案、修改和註釋在文字、程式碼、圖像、音訊、視訊評估綜合面板上進行測試時,1.5 Pro 在用於開發大型語言模型(LLM ) 的基準測試中,87% 的效能優於1.0 Pro。在相同的基準測試中與 1.0 Ultra 相比,它的表現大致相似。 即使上下文視窗增加,Gemini 1.5 Pro 仍能維持高水準的效能。 在NIAH 評估中,故意將包含特定事實或陳述的一小段文字放置在很長的文字區塊中,1.5 Pro 99% 的時間都能找到嵌入的文本,在資料區塊中如下只要100 萬個token。 Gemini 1.5 Pro 也展示了令人印象深刻的「上下文學習(in-context learning)」 技能,這意味著它可以從長提示中給出的資訊中學習新技能,而不需要額外的微調。 Google在 MTOB (Translation from One Book )基準測試中測試了這項技能,該基準顯示了該模型從以前從未見過的資訊中學習的能力。當給定卡拉芒語(一種全球使用人數少於 200 人的語言)的語法手冊時,該模型可以學習將英語翻譯成卡拉芒語,其水平與學習相同內容的人相似。 由於 1.5 Pro 的長上下文視窗是大型模型中的首創,因此Google正在不斷開發新的評估和基準來測試其新穎的功能。 有關更多詳細信息,請參閱 Gemini 1.5 Pro 技術報告。 技術報告網址:https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf

Gemini 1.5 Pro 可以推理100,000 行代碼,提供有用的解決方案、修改和註釋在文字、程式碼、圖像、音訊、視訊評估綜合面板上進行測試時,1.5 Pro 在用於開發大型語言模型(LLM ) 的基準測試中,87% 的效能優於1.0 Pro。在相同的基準測試中與 1.0 Ultra 相比,它的表現大致相似。 即使上下文視窗增加,Gemini 1.5 Pro 仍能維持高水準的效能。 在NIAH 評估中,故意將包含特定事實或陳述的一小段文字放置在很長的文字區塊中,1.5 Pro 99% 的時間都能找到嵌入的文本,在資料區塊中如下只要100 萬個token。 Gemini 1.5 Pro 也展示了令人印象深刻的「上下文學習(in-context learning)」 技能,這意味著它可以從長提示中給出的資訊中學習新技能,而不需要額外的微調。 Google在 MTOB (Translation from One Book )基準測試中測試了這項技能,該基準顯示了該模型從以前從未見過的資訊中學習的能力。當給定卡拉芒語(一種全球使用人數少於 200 人的語言)的語法手冊時,該模型可以學習將英語翻譯成卡拉芒語,其水平與學習相同內容的人相似。 由於 1.5 Pro 的長上下文視窗是大型模型中的首創,因此Google正在不斷開發新的評估和基準來測試其新穎的功能。 有關更多詳細信息,請參閱 Gemini 1.5 Pro 技術報告。 技術報告網址:https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf#Google 致力於負責任地將每個新一代Gemini 模型帶給全球數十億人、開發者和企業用戶使用。

從今天開始,Google將透過 AI Studio 和 Vertex AI 向開發者和企業客戶提供 1.5 Pro 預覽版。

未來,當模型進行更廣泛的發佈時,屆時,Google將推出具有標準 128,000 個 token 上下文視窗的 1.5 Pro。很快,隨著Google對模型的改進,Google計劃引入從標準 128,000 個上下文視窗開始並擴展到 100 萬個 token 的定價等級。 ############早期測試人員可以在測試期間免費嘗試 100 萬個 token 上下文窗口,速度的顯著提高也即將到來。 ###############有興趣測試 1.5 Pro 的開發人員現在可以在 AI Studio 註冊,而企業客戶可以聯繫他們的 Vertex AI 客戶團隊。 #####################參考連結:https://blog.google/technology/ai/google-gemini-next-generation-model-february-2024/ #sundar-note##########

以上がGoogle Gemini 1.5 が迅速にリリース: MoE アーキテクチャ、100 万コンテキストの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。