ホームページ >テクノロジー周辺機器 >AI >RoSA: 大規模なモデルパラメータを効率的に微調整するための新しい方法

RoSA: 大規模なモデルパラメータを効率的に微調整するための新しい方法

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2024-01-18 17:27:17828ブラウズ

言語モデルが前例のない規模に拡大するにつれて、下流タスクの包括的な微調整には法外なコストがかかります。この問題を解決するために、研究者はPEFT法に注目し、採用し始めました。 PEFT 手法の主なアイデアは、微調整の範囲を少数のパラメーター セットに制限して、自然言語理解タスクで最先端のパフォーマンスを達成しながら計算コストを削減することです。このようにして、研究者は高いパフォーマンスを維持しながらコンピューティング リソースを節約でき、自然言語処理の分野に新たな研究のホットスポットをもたらします。

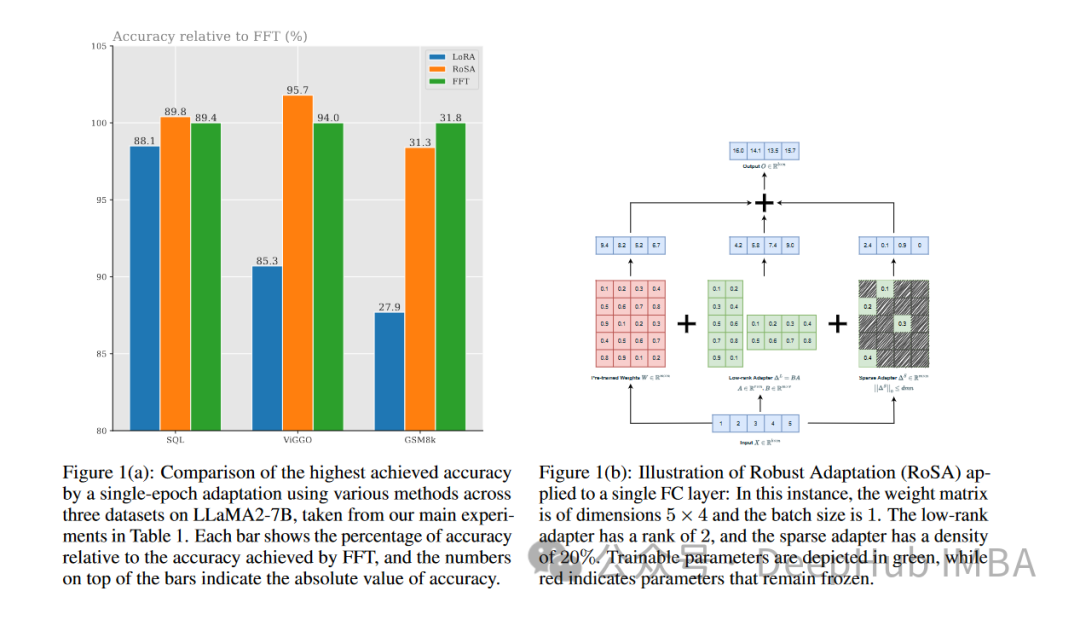

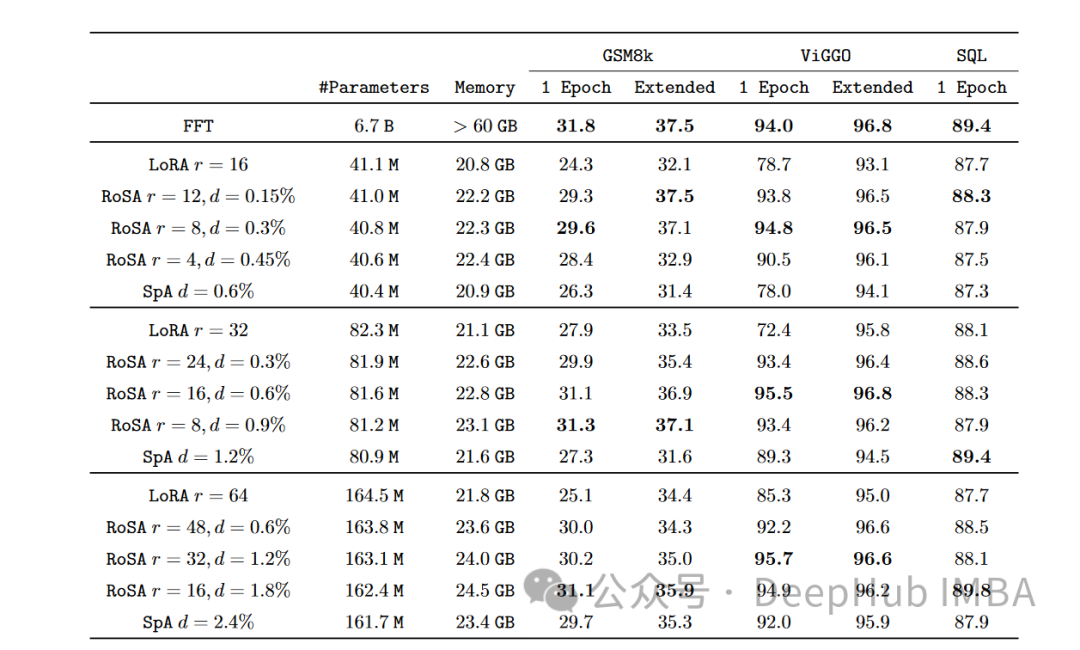

RoSA は新しい PEFT テクノロジーです。一連のベンチマーク テストの実験を通じて、同じパラメーター バジェットを使用した場合、RoSA がパフォーマンスを向上させることがわかりました。以前の低ランク適応 (LoRA) および純粋なスパース微調整方法よりも優れています。

この記事では、RoSA の原則、手法、結果を詳しく掘り下げ、そのパフォーマンスがどのように有意義な進歩を示すかを説明します。大規模な言語モデルを効果的に微調整したい人のために、RoSA は以前のソリューションよりも優れた新しいソリューションを提供します。

パラメータの効率的な微調整の需要

NLP はトランスフォーマーベースの言語に置き換えられましたGPT-4などのモデルを完全に変更。これらのモデルは、大規模なテキスト コーパスで事前トレーニングすることにより、強力な言語表現を学習します。次に、これらの表現を簡単なプロセスを通じて下流の言語タスクに転送します。

モデルのサイズが数十億から数兆のパラメータに増大するにつれて、微調整には膨大な計算負荷が生じます。たとえば、1 兆 7,600 億個のパラメータを持つ GPT-4 のようなモデルの場合、微調整には数百万ドルの費用がかかる可能性があります。このため、実際のアプリケーションでの展開は非常に非現実的になります。

PEFT メソッドは、微調整のパラメータ範囲を制限することで効率と精度を向上させます。最近、効率と精度をトレードオフするさまざまな PEFT テクノロジーが登場しました。

LoRA

#著名な PEFT 手法の 1 つは、低ランク適応 (LoRA) です。 LoRA は、Meta と MIT の研究者によって 2021 年に開始されました。このアプローチは、トランスがヘッド マトリクス内で低ランク構造を示すという観察によって動機付けられました。 LoRA は、この低ランク構造を利用して計算の複雑さを軽減し、モデルの効率と速度を向上させることが提案されています。

LoRA は最初の k 個の特異ベクトルのみを微調整し、他のパラメーターは変更されません。これには、O(n) ではなく、O(k) 個の追加パラメーターのみを調整する必要があります。

この低ランク構造を活用することで、LoRA は下流のタスクへの一般化に必要な意味のある信号をキャプチャし、微調整をこれらの上位特異ベクトルに制限することで、より効果的な最適化と推論を可能にします。

実験の結果、LoRA は 100 分の 1 以上少ないパラメーターを使用しながら、GLUE ベンチマークで完全に微調整されたパフォーマンスに匹敵することがわかりました。ただし、モデルのサイズが拡大し続けると、LoRA を通じて強力なパフォーマンスを得るにはランク k を増やす必要があり、完全な微調整と比較して計算量の節約が減少します。

RoSA が登場する前は、LoRA は PEFT 手法の最先端を代表しており、異なる行列因数分解や少数の微調整の追加などの手法を使用したわずかな改良のみでした。パラメーター。

ロバスト アダプテーション (RoSA)

ロバスト アダプテーション (RoSA) では、パラメータ効率の高い新しい微調整方法が導入されています。 RoSA は、低ランク構造のみに依存するのではなく、堅牢な主成分分析 (ロバスト PCA) からインスピレーションを得ています。

従来の主成分分析では、データ行列 X が行列に分解されます。堅牢な PCA はさらに一歩進んで、X をクリーンな低ランク L と「汚染/破損した」スパース S に分解します。

RoSA はここからインスピレーションを得て、言語モデルの微調整を次のように分解します。

低ランク適応 (L) 行列LoRA に似ており、主要なタスク関連信号を近似するように微調整されています。

非常に少数の、選択的に微調整された大きなパラメーターを含む高度にスパースな微調整 (S) 行列L をエンコードすると残留信号が失われます。

残留スパース成分を明示的にモデル化することで、RoSA は LoRA 単独よりも高い精度を達成できます。

RoSA は、モデルの頭部行列の低ランク分解を実行して L を構築します。これにより、下流のタスクに役立つ基礎となるセマンティック表現がエンコードされます。次に、RoSA は、各レイヤーの上位 m 個の最も重要なパラメーターを選択的に S に微調整しますが、他のすべてのパラメーターは変更されません。このステップでは、低ランクのフィッティングに適さない残差信号をキャプチャします。

微調整パラメータの数 m は、LoRA のみで必要なランク k よりも一桁小さいです。したがって、L の下位ヘッド マトリックスと組み合わせることで、RoSA は非常に高いパラメータ効率を維持します。

RoSA は、他のシンプルだが効果的な最適化も使用します:

残差スパース接続: S 残差は、層の正規化とフィードフォワード サブ層を通過する前に、各トランスフォーマー ブロックの出力に直接追加されます。これにより、L が見逃した信号をシミュレートできます。

独立したスパース マスク: 微調整のために S で選択されたメトリクスは、トランス層ごとに独立して生成されます。

共有低ランク構造: LoRA と同様に、同じ低ランクの基本 U、V 行列が L のすべての層で共有されます。これにより、一貫した部分空間で意味概念が捕捉されます。

これらのアーキテクチャの選択により、最適化と推論のためのパラメーターの効率を維持しながら、完全な微調整に似た柔軟性を RoSA モデリングに提供します。堅牢な低ランク適応と高度にスパースな残差を組み合わせたこの PEFT 手法を利用して、RoSA は精度と効率のトレードオフの新しいテクノロジーを実現します。

実験と結果

研究者らは、テキスト検出、感情分析、自然言語などのタスクをカバーする 12 の NLU データセットの包括的なベンチマークで RoSA を評価しました。言語推論と堅牢性テスト。彼らは、人工知能アシスタント LLM に基づく RoSA を使用し、120 億のパラメーター モデルを使用して実験を実施しました。

すべてのタスクにおいて、同じパラメータを使用した場合、RoSA は LoRA よりも大幅に優れたパフォーマンスを発揮します。両方の方法のパラメータの合計は、モデル全体の約 0.3% です。これは、LoRA の場合は k = 16、RoSA の場合は m = 5120 の場合、どちらの場合も約 450 万の微調整パラメータがあることを意味します。

RoSA は、純粋なスパースの微調整されたベースラインのパフォーマンスと同等かそれを上回っています。

敵対的な例に対する堅牢性を評価する ANLI ベンチマークでは、RoSA のスコアが 55.6 であるのに対し、LoRA のスコアは 52.7 です。これは、汎化と調整の改善を示しています。

感情分析タスク SST-2 と IMDB では、RoSA の精度は 91.2% と 96.9% に達し、LoRA の精度は 90.1% と 95.3% に達します。

難しい語感曖昧さ回避テストである WIC では、RoSA の F1 スコアは 93.5 ですが、LoRA の F1 スコアは 91.7 です。

12 のデータセットすべてにわたって、一致するパラメータ予算の下では、RoSA は一般に LoRA よりも優れたパフォーマンスを示します。

注目すべきことに、RoSA はタスク固有の調整や特殊化を必要とせずにこれらの利点を達成できます。これにより、RoSA はユニバーサル PEFT ソリューションとしての使用に適しています。

要約

言語モデルのサイズが急速に増大し続ける中、言語モデルを微調整するための計算要件を削減することが緊急の課題となっています。解決する必要があります。 LoRA のようなパラメータ効率の高い適応トレーニング技術は、初期の成功を示していますが、低ランク近似に固有の制限に直面しています。

RoSA は、堅牢な低ランク分解と高度にスパースな残差微調整を有機的に組み合わせて、説得力のある新しいソリューションを提供します。選択的なスパース残差を通じて低ランクのフィッティングを回避する信号を考慮することにより、PEFT のパフォーマンスが大幅に向上します。経験的評価では、さまざまな NLU タスク セットで LoRA および制御されていないスパース ベースラインと比較して大幅な改善が示されています。

RoSA は概念的にはシンプルですが高性能であり、パラメータ効率、適応表現、および言語インテリジェンスを拡張するための継続的学習に関する相互研究をさらに進めることができます。

以上がRoSA: 大規模なモデルパラメータを効率的に微調整するための新しい方法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

関連記事

続きを見る- パラメータがわずかに向上し、パフォーマンス指数が爆発します! Google:大規模な言語モデルには「謎のスキル」が隠されている

- GPT-3 の数学問題を解く精度は 92.5% に向上しました。 Microsoft、微調整せずに「科学」言語モデルを作成する MathPrompter を提案

- AI分野にまた1人の「強豪」が加わった、Metaが新たな大規模言語モデルLLaMAをリリース

- サイバーセキュリティを強化する AI チャットボットと大規模な言語モデルを構築する 6 つの方法

- 国内企業として初めて、360 Intelligent Brain が中国情報通信技術院の信頼できる AIGC 大言語モデル機能評価に合格しました