GPT-3 の数学問題を解く精度は 92.5% に向上しました。 Microsoft、微調整せずに「科学」言語モデルを作成する MathPrompter を提案

大規模な言語モデルの最も批判されている欠点は、深刻なナンセンスを除けば、おそらく「数学ができない」ことでしょう。

たとえば、複数ステップの推論を必要とする複雑な数学的問題の場合、言語モデルは通常、正しい答えを与えることができません。 「思考の連鎖」技術のおかげで、途中の段階でエラーが発生することがよくあります。

文系の自然言語理解課題とは異なり、数学の問題は正解が 1 つしかなく、答えの範囲もそれほど広くないため、正確な解を導き出すことが困難です。大規模な言語モデルの場合は、より困難だと言えます。

さらに、数学的な問題に関しては、既存の言語モデルでは通常、答えに対する信頼性が提供されず、ユーザーは生成された答えの信頼性を判断できなくなります。

この問題を解決するために、Microsoft Research は、予測への依存度を高めながら、算術問題における LLM のパフォーマンスを向上させることができる MathPrompter テクノロジを提案しました。

論文リンク: https://arxiv.org/abs/2303.05398

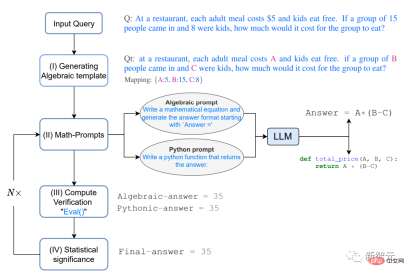

MathPrompter はゼロショット思考を使用しますチェーン ヒンティング テクノロジは、複数の代数式または Python 関数を生成して、同じ数学的問題をさまざまな方法で解決することで、出力結果の信頼性を高めます。

他のヒントベースの CoT メソッドと比較して、MathPrompter は中間ステップの妥当性もチェックします。

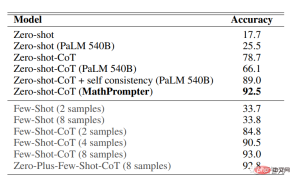

175B パラメーター GPT に基づいて、MathPrompter メソッドを使用して MultiArith データ セットの精度を 78.7% から 92.5% に向上させました。

数学に特化したプロンプト

近年の自然言語処理の発展は、大規模言語モデル (LLM) の規模が拡大し続けていることによるところが大きいです。は、驚くべきゼロショットおよび少数ショット機能を実証し、プロンプト技術の開発にも貢献しました。ユーザーは、プロンプトでいくつかの簡単な例を LLM に入力するだけで、新しいタスクを予測できます。

プロンプトは、単一ステップのタスクでは非常に成功していると言えますが、複数ステップの推論が必要なタスクでは、プロンプト技術のパフォーマンスはまだ不十分です。

人間は複雑な問題を解決するとき、それを分解して段階的に解決しようとします。「思考連鎖」(CoT) 促進テクノロジーは、この直感を LLM に拡張します。推論を必要とするさまざまな NLP タスクにわたってパフォーマンスの向上が達成されました。

この論文では、主に「数学的推論タスクを解決するため」の Zero-shot-CoT メソッドを研究しています。以前の研究では、MultiArith データセットの精度が大幅に向上しました。17.7% から向上しました。

#1. モデルが従う思考の連鎖は結果を改善しますが、思考の連鎖をチェックするわけではありません。続く各ステップの結果;

2. LLM 予測結果には信頼性がありません。

MathPrompterこれらのギャップをある程度解決するために、研究者は「人間が数学の問題を解決する方法」からインスピレーションを得て、複雑な問題をより単純な複数ステップの手順に分解しました。 、複数のメソッドを利用して各ステップでメソッドを検証します。

#LLM は生成モデルであるため、特に数学的推論タスクの場合、生成された答えが正確であることを確認するのは非常に困難になります。

研究者は、生徒が算数の問題を解くプロセスを観察し、生徒が解決策を検証するために行ったいくつかの手順を要約しました:

既知の結果との準拠 ソリューションを既知の結果と比較することで、その精度を評価し、必要な調整を行うことができます。これは、問題が以下のような標準的な問題の場合に特に役立ちます。成熟したソリューション。

マルチ検証は、複数の角度から問題にアプローチし、結果を比較することで、ソリューションの有効性を確認し、ソリューションが合理的かつ正確であることを保証します。 。

クロスチェック、問題を解決するプロセスは、最終的な答えと同じくらい必要です。プロセスの中間ステップが正しいことを検証することで、明確な答えを得ることができます。ソリューションの理解、その背後にある思考プロセス。

#計算検証: 電卓またはコンピューターを使用して算術計算を実行すると、最終的な答えの精度を検証できます

具体的に質問すると、

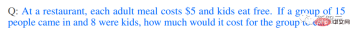

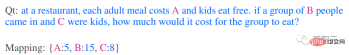

## レストランでの大人の食事の料金は次のとおりです。 5ドル、子供は無料で食べられます。 15 人が来て、そのうち 8 人が子供である場合、このグループの食事の費用はいくらですか?

#1. 代数テンプレートの生成#まず問題を解決します 代数に変換しますこの形式では、キーと値のマップを使用して数値項を変数に置き換えることで、修正された質問 Qt

複数の検証とクロスチェックの上記の思考プロセスによって得られた直感に基づいて、2 つの異なる方法を使用して Qt 分析ソリューションを生成しますは、代数的および Python の両方で、Qt の追加コンテキストを生成するための次のヒントを LLM に提供します。

#プロンプトは、「代数式を導出する」または「Python 関数を作成する」です。

LLM モデルは、プロンプトに応答した後、次の式を出力できます。

上記で生成された分析計画は、LLM の「中間思考プロセス」に関するヒントをユーザーに提供します。ヒントを追加すると、結果の精度が向上します。 . 精度と一貫性が向上し、より正確で効率的なソリューションを生成する MathPrompter の能力が向上します。

#3. 計算の検証

Qt で複数の入力変数を使用するランダム キー - value マップを使用して、前のステップで生成された式を評価します。Python の eval() メソッドを使用してこれらの式を評価します。

次に、出力結果を比較して、答えに一致した意見が見つかるかどうかを確認します。これにより、答えが正しく、信頼できるというより高い信頼度も得られます。

式が出力に一致すると、入力 Q の変数値を使用して最終的な計算が行われます。答え。

4. 統計的有意性

さまざまな式の出力でのコンセンサスを確保するには、ステップ 2 と 3 をほぼ繰り返します。実験を 5 回行い、最も頻繁に観察された回答値を報告します。

明確な合意がない場合は、ステップ 2、3、4 を繰り返します。

実験結果

MathPrompter は MultiArith データ セットで評価されました。その中の数学的質問は、複雑な算術演算を実行する機械学習モデルの能力をテストするために特に使用され、適切に解決するには、さまざまな算術演算と論理的推論を適用する必要があります。

MultiArith データセットの精度結果は、MathPrompter がすべての Zero-shot および Zero -shot- よりも優れたパフォーマンスを示していることを示しています。 CoT ベースライン、精度が 78.7% から 92.5% に向上

175B パラメーター GPT3 DaVinci に基づく MathPrompter モデルのパフォーマンスが 540B パラメーター モデルのパフォーマンスに匹敵することがわかります。 SOTA の Few -shot-CoT メソッドと同等です。

上記の表からわかるように、MathPrompter の設計により、「生成された答えには 1 段階の違いがある場合があります。」という問題は、モデルを複数回実行し、コンセンサス結果を報告することで回避できます。

さらに、推論ステップが長すぎる可能性があるという問題は、通常必要なトークンが少ない Python または代数手法で解決できます。 #また、推論ステップは正しくても、最終的な計算結果が正しくない場合がありますが、MathPrompter では Python の eval() メソッド関数を使用してこの問題を解決します。

ほとんどの場合、MathPrompter は正しい中間解答と最終解答を生成できますが、表の最後の質問のように、代数出力と Python 出力が一致する場合もいくつかあります。はい、しかしエラーがあります。

以上がGPT-3 の数学問題を解く精度は 92.5% に向上しました。 Microsoft、微調整せずに「科学」言語モデルを作成する MathPrompter を提案の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

LLMSでのツール呼び出しApr 14, 2025 am 11:28 AM

LLMSでのツール呼び出しApr 14, 2025 am 11:28 AM大規模な言語モデル(LLM)は人気が急増しており、ツールコール機能は単純なテキスト生成を超えて機能を劇的に拡大しています。 これで、LLMSは動的なUI作成や自律的なaなどの複雑な自動化タスクを処理できます。

ADHDゲーム、ヘルスツール、AIチャットボットがグローバルヘルスを変える方法Apr 14, 2025 am 11:27 AM

ADHDゲーム、ヘルスツール、AIチャットボットがグローバルヘルスを変える方法Apr 14, 2025 am 11:27 AMビデオゲームは不安を緩和したり、ADHDの子供を焦点を合わせたり、サポートしたりできますか? ヘルスケアの課題が世界的に急増しているため、特に若者の間では、イノベーターはありそうもないツールであるビデオゲームに目を向けています。現在、世界最大のエンターテイメントインダスの1つです

AIに関する国連入力:勝者、敗者、および機会Apr 14, 2025 am 11:25 AM

AIに関する国連入力:勝者、敗者、および機会Apr 14, 2025 am 11:25 AM「歴史は、技術の進歩が経済成長を促進する一方で、それ自体が公平な所得分布を確保したり、包括的な人間開発を促進したりしないことを示しています」とUNCTADの事務総長であるRebeca Grynspanは前文で書いています。

生成AIを介した交渉スキルを学ぶApr 14, 2025 am 11:23 AM

生成AIを介した交渉スキルを学ぶApr 14, 2025 am 11:23 AM簡単な、Generative AIを交渉の家庭教師およびスパーリングパートナーとして使用してください。 それについて話しましょう。 革新的なAIブレークスルーのこの分析は、最新のAIに関する私の進行中のフォーブス列のカバレッジの一部であり、特定と説明を含む

テッドは、Openai、Google、Metaが法廷に向かい、自分自身とセルフィーから明らかにしますApr 14, 2025 am 11:22 AM

テッドは、Openai、Google、Metaが法廷に向かい、自分自身とセルフィーから明らかにしますApr 14, 2025 am 11:22 AMバンクーバーで開催されたTED2025会議は、昨日4月11日の第36版を締めくくりました。サム・アルトマン、エリック・シュミット、パーマー・ラッキーを含む60か国以上の80人の講演者が登場しました。テッドのテーマ「人類が再考された」は、仕立てられたものでした

ジョセフ・スティグリッツは、AI独占権の中で迫り来る不平等を警告しているApr 14, 2025 am 11:21 AM

ジョセフ・スティグリッツは、AI独占権の中で迫り来る不平等を警告しているApr 14, 2025 am 11:21 AMジョセフ・スティグリッツは、2001年にノーベル経済賞を受賞した経済学者であり、2001年にノーベル経済賞を受賞しています。スティグリッツは、AIが既存の不平等を悪化させ、いくつかの支配的な企業の手に統合した力を悪化させ、最終的に経済を損なうと仮定しています。

グラフデータベースとは何ですか?Apr 14, 2025 am 11:19 AM

グラフデータベースとは何ですか?Apr 14, 2025 am 11:19 AMグラフデータベース:関係を通じてデータ管理に革命をもたらす データが拡大し、その特性がさまざまなフィールドで進化するにつれて、グラフデータベースは、相互接続されたデータを管理するための変換ソリューションとして浮上しています。伝統とは異なり

LLMルーティング:戦略、テクニック、およびPythonの実装Apr 14, 2025 am 11:14 AM

LLMルーティング:戦略、テクニック、およびPythonの実装Apr 14, 2025 am 11:14 AM大規模な言語モデル(LLM)ルーティング:インテリジェントタスク分布によるパフォーマンスの最適 LLMSの急速に進化する風景は、それぞれが独自の長所と短所を備えた多様なモデルを提供します。 創造的なコンテンツGenに優れている人もいます

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

Dreamweaver Mac版

ビジュアル Web 開発ツール

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。

WebStorm Mac版

便利なJavaScript開発ツール

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。

DVWA

Damn Vulnerable Web App (DVWA) は、非常に脆弱な PHP/MySQL Web アプリケーションです。その主な目的は、セキュリティ専門家が法的環境でスキルとツールをテストするのに役立ち、Web 開発者が Web アプリケーションを保護するプロセスをより深く理解できるようにし、教師/生徒が教室環境で Web アプリケーションを教え/学習できるようにすることです。安全。 DVWA の目標は、シンプルでわかりやすいインターフェイスを通じて、さまざまな難易度で最も一般的な Web 脆弱性のいくつかを実践することです。このソフトウェアは、