ホームページ >テクノロジー周辺機器 >AI >Supermicro が NVIDIA H200 をサポートすることで AI 製品ラインを拡大

Supermicro が NVIDIA H200 をサポートすることで AI 製品ラインを拡大

- WBOY転載

- 2023-11-14 15:25:07805ブラウズ

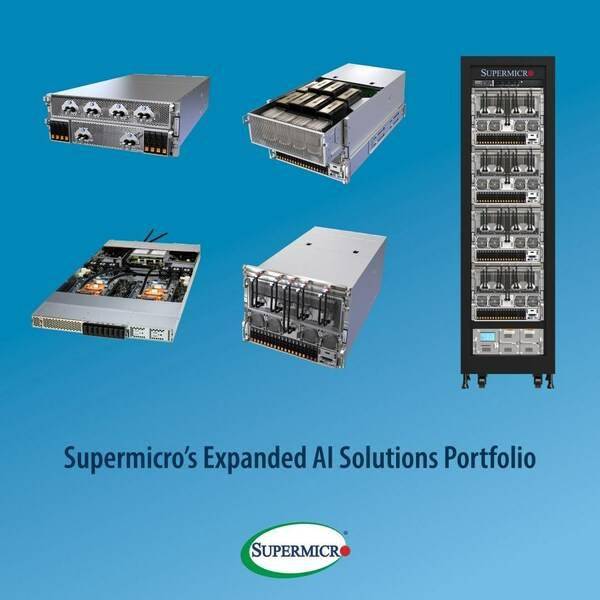

(グローバル TMT 2023 年 11 月 14 日) 人工知能、クラウド テクノロジー、ストレージ、5G/エッジ向けの総合的な IT ソリューションのプロバイダーである Supermicro, Inc. は、H200 Tensor コアを内蔵した新しい NVIDIA HGX H200 のサポートを提供しますGPU 、人工知能製品ラインをさらに拡大します。 Supermicro は 8U および 4U の汎用 GPU システムをカバーしており、HGX H200 8-GPU および 4-GPU をすぐに適用できます。 NVIDIA H100 Tensor コア GPU と比較して、容量がほぼ 2 倍、帯域幅が 1.4 倍高い HBM3e メモリを搭載しています。さらに、Supermicro NVIDIA MGX システムは最も豊富な製品ポートフォリオを備えており、HBM3e メモリを搭載した今後の NVIDIA Grace Hopper スーパー チップと互換性があります。

Supermicro 4U 8GPU H200

最新の液冷テクノロジーを利用して、Supermicro は、NVIDIA HGX H100 8-GPU システムをベースにした液冷 4U サーバーを発売し、業界最高のサーバー密度を達成しました。業界で最もコンパクトな高性能 GPU サーバーとして、データセンターが床面積要件を削減し、エネルギーコストを節約し、最高レベルのシングルラック高性能人工知能トレーニング機能を提供できるようにします。最高密度の GPU システムと高度な液体冷却ソリューションを採用することで、企業は総所有コストを削減できます

以上がSupermicro が NVIDIA H200 をサポートすることで AI 製品ラインを拡大の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。