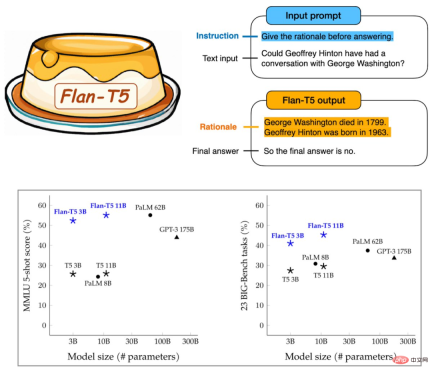

30 億は GPT-3 の 1,750 億を上回りました。Google の新しいモデルは激しい議論を引き起こしましたが、ヒントンの年齢は間違っていました。

人工知能の重要な目標は、強力な一般化機能を備えたモデルを開発することです。自然言語処理 (NLP) の分野では、事前トレーニングされた言語モデルがこの点で大きな進歩を遂げました。このようなモデルは、新しいタスクに適応するために微調整されることがよくあります。

最近、Google の研究者は、命令の微調整に対する拡張機能の影響を含む、さまざまな命令の微調整方法を分析しました。実験によると、命令の微調整はタスクの数とモデルのサイズに応じて実際に適切に拡張でき、最大 5,400 億のパラメーターのモデルで大きなメリットが得られることが示されており、将来の研究ではタスクの数とモデルのサイズがさらに拡大されるはずです。さらに、この研究では、モデルの推論実行能力に対する微調整の影響も分析されており、その結果は非常に魅力的です。

結果として得られた Flan-T5 には、1,800 を超える言語タスク向けに微調整された命令が含まれており、プロンプトと複数ステップの推論機能が大幅に向上しており、1,750 億個のパラメータのうち GPT-3 を超える可能性があります。

#Google は大規模モデルの機能を向上させる方向性を見つけたようです。しかし、この研究は機械学習コミュニティの歓迎を集めただけでなく、Gary Marcus 氏の苦情も引き付けました。 Google のモデル Google の有名な科学者ジェフリー ヒントンの生年月日が間違ったのはなぜですか?彼は明らかに1947年生まれの古株だ。

ちなみに、1963年生まれの有名なAI学者はユルゲン・シュミットフーバーです。

間違っているのは AI モデルではないので、Google の新しい手法が事前トレーニング済みモデルにどのような変化をもたらすかを見てみましょう。

#論文: スケーリング命令 - 微調整された言語モデル

#論文: スケーリング命令 - 微調整された言語モデル

##論文アドレス: https://arxiv.org/abs/2210.11416

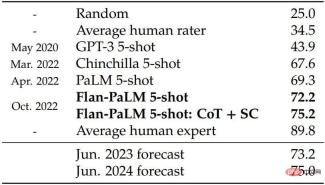

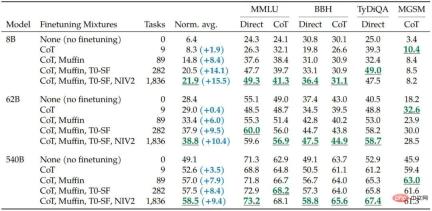

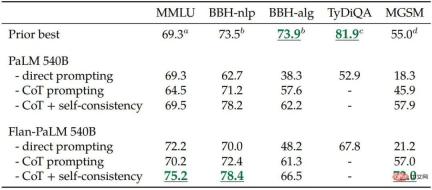

- この調査では 540B パラメータ モデルを使用しますFlan-PaLM をトレーニングすると、微調整タスクの数が 1800 以上に増加し、思考連鎖 (CoT; Wei et al., 2022b) データが含まれます。トレーニングされた Flan-PaLM は PaLM を上回り、複数のベンチマークで新しい SOTA に達しました。推論機能の点では、Flan-PaLM は CoT と自己一貫性 (Wang et al., 2022c) を活用して、大規模なマルチタスク言語理解で 75.2% の精度を達成できます (MMLU; Hendrycks et al., 2020)。レート。

- さらに、Flan-PaLM は、一連の挑戦的なオープンエンド生成問題において PaLM を大幅に上回り、使いやすさが大幅に向上しました。

方法

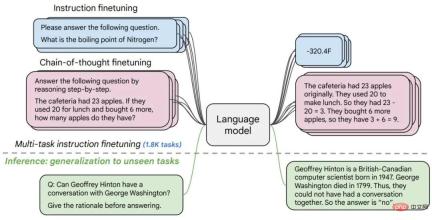

具体的には、この研究は主に、(1) タスクの数の拡大、(2) タスクの拡大など、指導の微調整に影響を与えるいくつかの側面に焦点を当てています。モデルのサイズ、および (3) 思考連鎖データを微調整します。

具体的には、この研究は主に、(1) タスクの数の拡大、(2) タスクの拡大など、指導の微調整に影響を与えるいくつかの側面に焦点を当てています。モデルのサイズ、および (3) 思考連鎖データを微調整します。

研究では、上記の側面による命令の微調整により、さまざまなモデル クラス (PaLM、T5、U-PaLM)、プロンプト設定 (ゼロ ショット、少数ショット、CoT)、および評価ベンチマークが大幅に改善されたことがわかりました。 MMLU、BBH、TyDiQA、MGSM、オープン世代)。たとえば、命令を微調整した Flan-PaLM 540B は、1.8K タスクで PALM 540B を大幅に上回ります (平均 9.4%)。 Flan-PaLM 540B は、5 つの MMLU で 75.2% など、いくつかのベンチマークで最先端のパフォーマンスを達成します。

研究者らは、PaLM 62B などの大型モデルと比較した場合でも強力な数ショット性能を達成する Flan-T5 チェックポイントも公開しました。全体として、命令の微調整は、事前トレーニングされた言語モデルのパフォーマンスと使いやすさを向上させるための一般的なアプローチです。

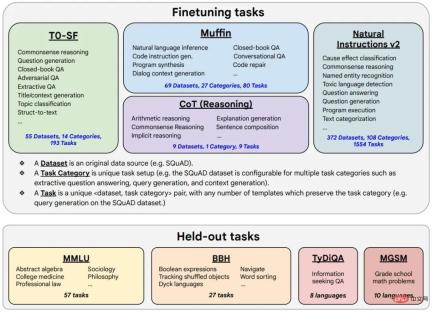

図 1. 研究者は、1,800 を超えるタスクでさまざまな言語モデルを微調整しました。サンプル数 (ゼロまたは少数のサンプル) と思考チェーンの有無により、さまざまな評価シナリオにわたる一般化が可能になります。

# 図 2. 微調整データには 473 のデータセット、146 のタスク カテゴリ、および合計が含まれます1836 のタスク。

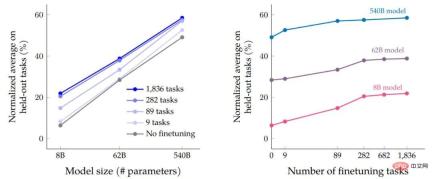

データの微調整とプログラムの微調整プロセスが完了した後、研究者は、タスクの影響に対するモデル サイズのパフォーマンス。まず、3 つのモデル サイズすべてにおいて、マルチタスク命令の微調整を行うと、微調整を行わない場合と比較してパフォーマンスが大幅に向上し、9.4% ~ 15.5% の範囲で向上します。次に、微調整タスクの数を増やすと、パフォーマンスが向上します。

最後に、モデル サイズを 1 桁増やす (8B → 62B または 62B → 540B) と、微調整されたモデルと非微調整されたモデルの両方のパフォーマンスが大幅に向上することがわかります。 -チューンドモデル。

マルチタスク命令の微調整がモデル サイズ (パラメーターの量) と相対的な精度に及ぼす影響と、微調整タスクの数と規模の拡大 影響。

微調整データ内のタスクの数を増やすと、ほとんどの点で Flan-PaLM が改善されます。パフォーマンスのベンチマークを評価します。

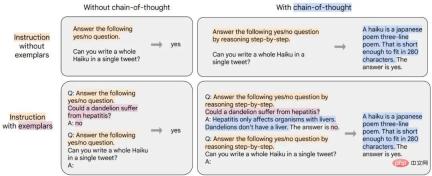

# 研究者らは、思考連鎖 (CoT) の注釈が付けられた 9 つのデータセットを微調整混合に含めることで、推論機能が向上することを実証しました。以下の表は、Flan-PaLM の CoT プロンプト機能が 4 つの評価ベンチマークで PaLM を上回っていることを示しています。

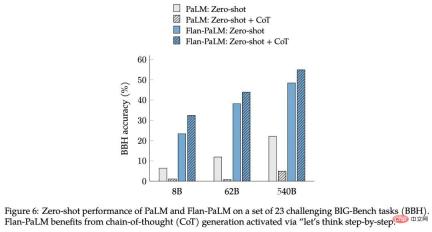

この研究では、CoT データの命令を微調整することのもう 1 つの利点は、ゼロショット推論を達成できることであることがわかりました。 CoT は、わずか数個のサンプルを使用して独自に推論機能を生成しますが、正しく実装するには大規模なエンジニアリング調整が必要になる場合があります。

図 6: 23 個の困難な BIG-Bench タスク (BBH) ゼロのセットでの PaLM と Flan-PaLMショットパフォーマンスオン。 Flan-PaLM では、「ステップごとに考えてみましょう」コマンドによってアクティブ化される思考連鎖 (CoT) の生成が必要です。

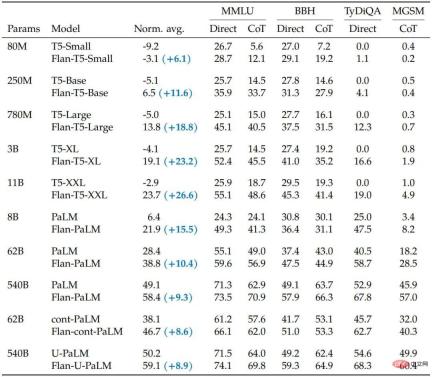

新しい手法の汎用性を実証するために、Google は T5、PaLM、U-PaLM をトレーニングし、8,000 万から 5,400 億パラメータの範囲のモデル サイズをカバーし、すべてのモデルがパフォーマンスを大幅に向上できることを発見しました。

#表 5. 命令微調整 (Flan) は、他の継続的な事前トレーニング方法よりもパフォーマンスを向上させます。

テスト後、命令の微調整により、すべてのモデル タイプの正規化された平均パフォーマンスが大幅に向上し、T5 モデルは、命令の微調整を行わなかったモデルと比較して恩恵を受けました。微調整されたモデルがほとんどです。これらの結果は、一部のベンチマークでは非常に強力です。たとえば、Flan-T5-XL は、わずか 30 億のパラメーターで 47.6% の MMLU スコアを達成し、1,750 億のパラメーターでの GPT-3 の 43.9% スコアを上回りました。

NLP ベンチマークに加えて、言語モデルは自由形式の質問リクエストに対する長い形式の回答を生成できます。この点において、標準的な NLP ベンチマークとその評価に使用される自動化された指標は、人間の好みを測定するには不十分です。研究者らはこれを評価し、190 例からなる評価セットを作成しました。評価セットは、創造性、文脈上の推論、複雑な推論、計画、説明という、それぞれ 20 問からなる 5 つの難しいカテゴリにわたって、ゼロショット方式でモデルに提示される質問で構成されます。

これらの例のうち 60 個 (複雑な推論、計画、説明のカテゴリーから) について、研究では思考連鎖トリガー フレーズ (例: 「段階的に考えてみましょう」) とのリンクを作成しました。 .”)、CoT でゼロショットを有効にして微調整が行われたかどうかの別の評価として。前述の 160 個のゼロショット入力に加えて、この研究には、指導による微調整のない強力な言語モデルが良好に機能することが示されている少数ショット機能をテストするための 30 個の入力も含まれています。

研究者らは、命令の微調整とスケール拡張の両方で大規模な言語モデルのパフォーマンスを継続的に向上させることができ、微調整は推論機能にとって重要であり、モデルの機能を一般化することもできると考えています。命令の微調整と UL2R などの他のモデル適応手法を組み合わせることで、Google はこの作業で最強のモデル Flan-U-PaLM を提案します。

重要なのは、命令の微調整は、モデル スケールの拡張のようなコンピューティング コストを大幅に増加させるものではありません。たとえば、PaLM 540B の場合、命令の微調整には事前トレーニング計算の 0.2% しか必要ありません。ただし、評価ベンチマーク全体の正規化平均を 9.4% 向上させることができます。ディレクティブ ナッジを使用する小規模なモデルは、ナッジを使用しない大きなモデルよりもパフォーマンスが優れている場合があります。

これらの理由から、研究者は、ほぼすべての事前トレーニング済み言語モデルに対して命令を微調整することを推奨しています。

以上が30 億は GPT-3 の 1,750 億を上回りました。Google の新しいモデルは激しい議論を引き起こしましたが、ヒントンの年齢は間違っていました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

革新を調理する:人工知能がフードサービスを変革する方法Apr 12, 2025 pm 12:09 PM

革新を調理する:人工知能がフードサービスを変革する方法Apr 12, 2025 pm 12:09 PM食品の準備を強化するAI まだ初期の使用中ですが、AIシステムは食品の準備にますます使用されています。 AI駆動型のロボットは、ハンバーガーの製造、SAの組み立てなど、食品の準備タスクを自動化するためにキッチンで使用されています

Pythonネームスペースと可変スコープに関する包括的なガイドApr 12, 2025 pm 12:00 PM

Pythonネームスペースと可変スコープに関する包括的なガイドApr 12, 2025 pm 12:00 PM導入 Python関数における変数の名前空間、スコープ、および動作を理解することは、効率的に記述し、ランタイムエラーや例外を回避するために重要です。この記事では、さまざまなASPを掘り下げます

ビジョン言語モデル(VLM)の包括的なガイドApr 12, 2025 am 11:58 AM

ビジョン言語モデル(VLM)の包括的なガイドApr 12, 2025 am 11:58 AM導入 鮮やかな絵画や彫刻に囲まれたアートギャラリーを歩くことを想像してください。さて、各ピースに質問をして意味のある答えを得ることができたらどうでしょうか?あなたは尋ねるかもしれません、「あなたはどんな話を言っていますか?

MediaTekは、Kompanio UltraとDimenity 9400でプレミアムラインナップをブーストしますApr 12, 2025 am 11:52 AM

MediaTekは、Kompanio UltraとDimenity 9400でプレミアムラインナップをブーストしますApr 12, 2025 am 11:52 AM製品のケイデンスを継続して、今月MediaTekは、新しいKompanio UltraやDimenity 9400を含む一連の発表を行いました。これらの製品は、スマートフォン用のチップを含むMediaTekのビジネスのより伝統的な部分を埋めます

今週のAIで:Walmartがファッションのトレンドを設定する前に設定しますApr 12, 2025 am 11:51 AM

今週のAIで:Walmartがファッションのトレンドを設定する前に設定しますApr 12, 2025 am 11:51 AM#1 GoogleはAgent2Agentを起動しました 物語:月曜日の朝です。 AI駆動のリクルーターとして、あなたはより賢く、難しくありません。携帯電話の会社のダッシュボードにログインします。それはあなたに3つの重要な役割が調達され、吟味され、予定されていることを伝えます

生成AIは精神障害に会いますApr 12, 2025 am 11:50 AM

生成AIは精神障害に会いますApr 12, 2025 am 11:50 AM私はあなたがそうであるに違いないと思います。 私たちは皆、精神障害がさまざまな心理学の用語を混ぜ合わせ、しばしば理解できないか完全に無意味であることが多い、さまざまなおしゃべりで構成されていることを知っているようです。 FOを吐き出すために必要なことはすべてです

プロトタイプ:科学者は紙をプラスチックに変えますApr 12, 2025 am 11:49 AM

プロトタイプ:科学者は紙をプラスチックに変えますApr 12, 2025 am 11:49 AM今週公開された新しい研究によると、2022年に製造されたプラスチックの9.5%のみがリサイクル材料から作られていました。一方、プラスチックは埋め立て地や生態系に積み上げられ続けています。 しかし、助けが近づいています。エンジンのチーム

AIアナリストの台頭:これがAI革命で最も重要な仕事になる理由Apr 12, 2025 am 11:41 AM

AIアナリストの台頭:これがAI革命で最も重要な仕事になる理由Apr 12, 2025 am 11:41 AM主要なエンタープライズ分析プラットフォームAlteryxのCEOであるAndy Macmillanとの私の最近の会話は、AI革命におけるこの重要でありながら過小評価されている役割を強調しました。 MacMillanが説明するように、生のビジネスデータとAI-Ready情報のギャップ

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

DVWA

Damn Vulnerable Web App (DVWA) は、非常に脆弱な PHP/MySQL Web アプリケーションです。その主な目的は、セキュリティ専門家が法的環境でスキルとツールをテストするのに役立ち、Web 開発者が Web アプリケーションを保護するプロセスをより深く理解できるようにし、教師/生徒が教室環境で Web アプリケーションを教え/学習できるようにすることです。安全。 DVWA の目標は、シンプルでわかりやすいインターフェイスを通じて、さまざまな難易度で最も一般的な Web 脆弱性のいくつかを実践することです。このソフトウェアは、

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。