導入

鮮やかな絵画や彫刻に囲まれたアートギャラリーを歩くことを想像してください。さて、各ピースに質問をして意味のある答えを得ることができたらどうでしょうか? 「あなたはどんな話を言っているの?」と尋ねるかもしれません。または「なぜアーティストはこの色を選んだのですか?」そこで、ビジョン言語モデル(VLM)が登場します。これらのモデルは、博物館の専門家ガイドと同様に、画像を解釈し、コンテキストを理解し、人間の言語を使用してその情報を伝えることができます。写真でオブジェクトを識別したり、視覚コンテンツに関する質問に答えたり、説明から新しい画像を生成したりするかどうかにかかわらず、VLMSはかつて不可能と思われる方法でビジョンと言語の力を融合します。

このガイドでは、VLMSの魅力的な世界、それらがどのように機能するか、それらの能力、クリップ、パラマ、フィレンツェなどの画期的なモデルを探ります。

この記事は、最近の講演に基づいており、Aritra Roy GosthipatyとRitwik Rahaonaは、2024年のThedatahack SummitにあるVision Language Modelsの包括的なガイドです。

学習目標

- ビジョン言語モデル(VLM)のコア概念と機能を理解します。

- VLMSがオブジェクトの検出や画像セグメンテーションなどのタスクの視覚データと言語データをどのように統合するかを調べます。

- Clip、Palama、Florenceなどの主要なVLMアーキテクチャとそのアプリケーションについて学びます。

- 事前に訓練された、マスクされた、生成モデルを含む、さまざまなVLMファミリに関する洞察を得る。

- 対照的な学習がVLMのパフォーマンスをどのように促進するか、そして微調整がモデルの精度をどのように改善するかを発見します。

目次

- ビジョン言語モデルとは何ですか?

- ビジョン言語モデルの機能

- 注目すべきVLMモデル

- ビジョン言語モデルの家族

- クリップ(コントラスト言語イメージの前oraining)

- siglip(シャム一般化言語イメージ事前化)

- トレーニングビジョン言語モデル(VLM)

- パリゲンマの理解

- よくある質問

ビジョン言語モデルとは何ですか?

ビジョン言語モデル(VLMS)は、ビデオやビデオ、テキストを入力として処理することを目的とした特定のカテゴリの人工知能システムを参照しています。これら2つのモダリティを組み合わせると、VLMはモデルを含むタスクを実行して、たとえば画像とテキストの間の意味をマッピングできます。画像を説明し、画像に基づいて質問に答え、その逆も同様です。

VLMSのコア強度は、コンピュータービジョンとNLPの間のギャップを埋める能力にあります。従来のモデルは通常、これらのドメインの1つのみで優れていました。画像のオブジェクトを認識したり、人間の言語を理解したりします。ただし、VLMは両方のモダリティを組み合わせるように特別に設計されており、言語のレンズを通して画像を解釈することを学習することにより、データのより全体的な理解を提供し、その逆も同様です。

VLMのアーキテクチャには、通常、視覚データとテキストデータの両方の共同表現を学習することが含まれ、モデルがクロスモーダルタスクを実行できるようにします。これらのモデルは、画像のペアと対応するテキストの説明を含む大きなデータセットで事前に訓練されています。トレーニング中、VLMは画像内のオブジェクトとそれらを説明するために使用される単語間の関係を学習します。これにより、モデルは画像からテキストを生成したり、視覚データのコンテキストでテキストプロンプトを理解したりできます。

VLMSが処理できる重要なタスクの例は次のとおりです。

- ビジョン質問応答(VQA) :画像の内容に関する質問に答える。

- 画像キャプション:画像で見られるもののテキストの説明を生成します。

- オブジェクトの検出とセグメンテーション:多くの場合、テキストコンテキストを使用して、さまざまなオブジェクトまたは画像の一部を識別およびラベル付けします。

ビジョン言語モデルの機能

ビジョン言語モデル(VLM)は、視覚情報とテキスト情報の両方を統合することにより、幅広い複雑なタスクに対処するために進化しました。それらは、画像と言語の固有の関係を活用して機能し、いくつかのドメインで画期的な機能を可能にします。

ビジョンと言語

VLMSの礎石は、視覚データとテキストデータの両方で理解して動作する能力です。これらの2つのストリームを同時に処理することにより、VLMは画像のキャプションを生成したり、説明を使用してオブジェクトを認識したり、視覚情報をテキストコンテキストと関連付けるなどのタスクを実行できます。このクロスモーダルの理解により、より豊かで一貫性のある出力が可能になり、実際のアプリケーション全体で非常に用途が広くなります。

オブジェクトの検出

オブジェクトの検出は、VLMの重要な機能です。これにより、モデルは画像内のオブジェクトを認識して分類し、視覚的理解を言語ラベルに基づいています。言語の理解を組み合わせることにより、VLMはオブジェクトを検出するだけでなく、それらのコンテキストを理解して説明することもできます。これには、画像内の「犬」を識別するだけでなく、他のシーン要素と関連付けて、オブジェクトの検出がより動的で有益なものになることも含まれます。

画像セグメンテーション

VLMは、画像セグメンテーションを実行することにより、従来のビジョンモデルを強化します。これは、その内容に基づいて画像を意味のあるセグメントまたは領域に分割します。 VLMSでは、このタスクはテキストの理解によって増強されます。つまり、モデルは特定のオブジェクトをセグメント化し、各セクションのコンテキスト説明を提供できます。これは、モデルが分解して画像のきめの細かい構造を記述できるため、単にオブジェクトを認識するだけではありません。

埋め込み

VLMSのもう1つの非常に重要な原則は、視覚データとテキストデータの間の相互作用のための共有スペースを提供するため、埋め込みの役割です。これは、画像と単語を関連付けることにより、モデルがテキストを与えられた画像の照会などの操作を実行できるためです。これは、VLMが画像の非常に効果的な表現を生成するため、クロスモーダルプロセスでのビジョンと言語の間のギャップを埋めるのに役立つ可能性があるためです。

ビジョン質問応答(VQA)

VLMを使用するすべての形式のうち、VQAを使用してより複雑な形式の1つが与えられます。つまり、VLMには画像と画像に関連する質問が表示されます。 VLMは、画像で取得した画像解釈を採用し、クエリに適切に答える際に自然言語処理の理解を採用しています。たとえば、次の質問がある公園の画像が与えられた場合、「写真にはいくつのベンチを見ることができますか?」このモデルは、カウントの問題を解決し、答えを与えることができます。これは、ビジョンだけでなく、モデルからの推論も示すことができます。

注目すべきVLMモデル

いくつかのビジョン言語モデル(VLM)が登場し、クロスモーダル学習で可能なことの境界を押し広げています。各モデルは、より広範なビジョン言語研究環境に貢献するユニークな機能を提供します。以下は、最も重要なVLMの一部です。

クリップ(コントラスト言語イメージのトレーニング前)

クリップは、VLMスペースの先駆的なモデルの1つです。それは、画像を対応する説明と一致させることを学習することにより、視覚データとテキストデータを接続するための対照的な学習アプローチを利用します。このモデルは、テキストとペアになった画像で構成される大規模なデータセットを処理し、画像とそのテキストの対応物との類似性を最適化することで学習し、一致しないペアを区別します。この対照的なアプローチにより、Clipは、ゼロショット分類、画像キャプション、さらには明示的なタスク固有のトレーニングなしでの視覚的な質問への回答など、幅広いタスクを処理できます。

ここからクリップの詳細を読んでください。

llava(大手言語とビジョンアシスタント)

Llavaは、複雑なマルチモーダルタスクの視覚データと言語データの両方を整列するように設計された洗練されたモデルです。画像処理を大規模な言語モデルと融合させるユニークなアプローチを使用して、画像関連のクエリを解釈および応答する能力を高めます。テキスト表現と視覚的表現の両方を活用することにより、Llavaは視覚的な質問への回答、インタラクティブな画像生成、および画像を含む対話ベースのタスクに優れています。強力な言語モデルとの統合により、詳細な説明を生成し、リアルタイムのビジョン言語相互作用を支援できます。

ここからllavaについてモードを読む。

ラムダ(ダイアログアプリケーションの言語モデル)

ラムダは主に言語の観点から議論されていましたが、ビジョン言語のタスクでも使用できます。ラムダは、ダイアログシステムに非常に優しいものであり、ビジョンモデルと組み合わせると。視覚的な質問に答え、画像制御された対話、その他のモーダルタスクを組み合わせて実行できます。 Lamdaは、自動化された画像やビデオ分析などの視覚データの議論が必要なあらゆるアプリケーションに利益をもたらす人間のようなコンテキストに関連する回答を提供する傾向があるため、改善されています。

ここからラムダの詳細を読んでください。

フィレンツェ

フィレンツェは、ビジョンデータと言語データの両方を組み込んで、幅広いクロスモーダルタスクを実行するもう1つの堅牢なVLMです。特に、大規模なデータセットを扱う際の効率とスケーラビリティで知られています。モデルの設計は、高速トレーニングと展開のために最適化されており、画像認識、オブジェクト検出、マルチモーダルの理解に優れています。フィレンツェは、膨大な量の視覚データとテキストデータを統合できます。これにより、画像検索、キャプション生成、画像ベースの質問応答などのタスクで多用途になります。

ここからフィレンツェの詳細を読んでください。

ビジョン言語モデルの家族

ビジョン言語モデル(VLM)は、マルチモーダルデータの処理方法に基づいて、いくつかのファミリに分類されます。これらには、事前に訓練されたモデル、マスクされたモデル、生成モデル、および対照学習モデルが含まれます。各家族は、さまざまなテクニックを利用してビジョンと言語のモダリティを調整し、さまざまなタスクに適しています。

事前に訓練されたモデルファミリー

事前に訓練されたモデルは、ペアのビジョンデータと言語データの大規模なデータセットに基づいて構築されています。これらのモデルは一般的なタスクでトレーニングされているため、毎回大規模なデータセットを必要とせずに特定のアプリケーション用に微調整できます。

それがどのように機能するか

事前に訓練されたモデルファミリは、画像とテキストの大規模なデータセットを使用しています。このモデルは、画像を認識し、テキストラベルや説明と一致させるように訓練されています。この広範な事前トレーニングの後、このモデルは、画像キャプションや視覚的な質問応答などの特定のタスクに対して微調整できます。事前に訓練されたモデルは、最初は豊富なデータでトレーニングされ、その後小型の特定のドメインで微調整されるため、効果的です。このアプローチにより、さまざまなタスクのパフォーマンスが大幅に向上しました。

マスクされたモデルファミリー

マスクモデルはマスキングテクニックを使用してVLMSをトレーニングします。これらのモデルは、入力画像またはテキストの部分をランダムにマスクし、モデルにマスクされたコンテンツを予測する必要があり、より深いコンテキスト関係を学習することを強制します。

それがどのように機能するか(画像マスキング)

マスクされた画像モデルは、入力画像のランダム領域を隠すことにより動作します。モデルは、欠落しているピクセルの予測を課します。このアプローチにより、VLMは周囲の視覚コンテキストに焦点を合わせて画像を再構築するようになります。その結果、このモデルは、ローカルおよびグローバルな視覚的特徴の両方をより強く理解します。画像マスキングは、モデルが画像内の空間関係の堅牢な理解を開発するのに役立ちます。この改善された理解により、オブジェクトの検出やセグメンテーションなどのタスクのパフォーマンスが向上します。

それがどのように機能するか(テキストマスキング)

マスクされた言語モデリングでは、入力テキストの一部が非表示になります。このモデルは、欠落しているトークンの予測を担当しています。これは、VLMが複雑な言語構造と関係を理解することを促進します。マスクされたテキストモデルは、微妙な言語特徴を把握するために重要です。視覚データとテキストデータの両方を理解することが不可欠な画像キャプションや視覚的な質問への回答などのタスクでのモデルのパフォーマンスを向上させます。

生成ファミリー

生成モデルは、画像からのテキストまたはテキストからの画像を含む新しいデータの生成を扱います。これらのモデルは、インプットモダリティからの新しい出力を合成することを含むテキストから画像、画像からテキスト生成に特に適用されます。

テキストから画像への生成

テキストからイメージのジェネレーターを使用する場合、モデルへの入力はテキストであり、出力は結果の画像です。このタスクは、単語のセマンティックエンコーディングと画像の特徴に関係する概念に大きく依存しています。モデルは、テキストの意味的な意味を分析して、入力として与えられた説明に対応する忠実度モデルを作成します。

画像間生成

画像からテキストの生成では、モデルは入力として画像を取得し、キャプションなどのテキスト出力を生成します。まず、画像の視覚コンテンツを分析します。次に、オブジェクト、シーン、アクションを識別します。次に、これらの要素をテキストに転写します。これらの生成モデルは、自動キャプションの生成、シーンの説明、ビデオシーンからストーリーの作成に役立ちます。

対照学習

クリップを含む対照的なモデルは、マッチングおよび非一致する画像テキストペアのトレーニングを通じてそれらを識別します。これにより、モデルは画像を説明にマッピングするようになり、同時に間違ったマッピングを削除して、言語へのビジョンの良好な対応につながります。

どのように機能しますか?

対照学習は、画像とその正しい説明を同じビジョン言語セマンティックスペースにマッピングします。また、視覚言語の意味的に有毒なサンプル間の矛盾を高めます。このプロセスは、モデルが画像とそれに関連するテキストの両方を理解するのに役立ちます。これは、画像検索、ゼロショット分類、視覚的な質問応答などのクロスモーダルタスクに役立ちます。

クリップ(コントラスト言語イメージの前oraining)

クリップ、または対照的な言語イメージの前orainingは、OpenAIによって開発されたモデルです。ビジョン言語モデル(VLM)フィールドの主要なモデルの1つです。クリップは、画像とテキストの両方を入力として処理します。このモデルは、画像テキストデータセットでトレーニングされています。対照的な学習を使用して、画像をテキストの説明と一致させます。同時に、無関係な画像テキストペアを区別します。

クリップのしくみ

クリップは、デュアルエンコーダーアーキテクチャを使用して動作します。1つは画像用、もう1つはテキスト用です。コアのアイデアは、画像と対応するテキストの説明の両方を同じ高次元ベクトル空間に埋め込み、モデルが異なる画像テキストペアを比較対照できるようにすることです。

クリップの機能の重要なステップ

- 画像エンコーディング:クリップモデルと同様に、このモデルは、VITと呼ばれるビジョントランスを使用して画像をエンコードします。

- テキストエンコーディング:同時に、モデルは、トランスベースのテキストエンコーダーを介して対応するテキストをエンコードします。

- 対照学習:次に、エンコードされた画像とテキストの類似性を比較して、それに応じて結果を与えることができます。画像が説明と同じクラスに属するペアの類似性を最大化し、そうでないペアでそれを最小化します。

- クロスモーダルアラインメント:トレードオフは、視力の一致とゼロショット学習、画像検索、さらには逆の画像合成などの言語と一致するタスクで優れたモデルを生成します。

クリップのアプリケーション

- 画像検索:説明が与えられた場合、クリップはそれに一致する画像を見つけることができます。

- ゼロショット分類:Clipは、特定のカテゴリの追加トレーニングデータなしで画像を分類できます。

- 視覚的な質問応答:Clipは視覚コンテンツに関する質問を理解し、回答を提供できます。

コード例:クリップを使用した画像間

以下は、クリップを使用して画像間タスクを実行するためのコードスニペットの例です。この例は、クリップが画像とテキストの説明のセットをエンコードし、各テキストが画像と一致する確率を計算する方法を示しています。

トーチをインポートします

クリップをインポートします

PILインポート画像から

#GPUが利用可能であるかどうかを確認します。それ以外の場合はCPUを使用します

device = "cuda" if torch.cuda.is_available()else "cpu"

#事前に訓練されたクリップモデルと前処理機能をロードします

モデル、preprocess = clip.load( "vit-b/32"、device = device)

#画像をロードして前処理します

Image = Preprocess(image.open( "lip.png"))。unsqueeze(0).to(device)

#画像と比較するテキストの説明のセットを定義します

text = clip.tokenize(["a diagramg"、 "a dog"、 "a cat"])。(device))

#イメージとテキストの両方をエンコードするために推測を実行する

torch.no_grad()を使用して:

image_features = model.encode_image(画像)

text_features = model.encode_text(text)

#画像機能とテキスト機能の類似性を計算します

logits_per_image、logits_per_text = model(画像、テキスト)

#ソフトマックスを適用して、画像に一致する各ラベルの確率を取得します

probs = logits_per_image.softmax(dim = -1).cpu()。numpy()

#確率を出力します

print( "ラベル確率:"、probs)

siglip(シャム一般化言語イメージ事前化)

シャム一般化言語イメージの事前トレーニングは、Googleが開発した高度なモデルであり、Clipなどのモデルの機能に基づいています。 Siglipは、改善されたアーキテクチャと事前のテクニックを使用して、対照的な学習の強度を活用することにより、画像分類タスクを強化します。ゼロショット画像分類の効率と精度を改善することを目的としています。

Siglipの仕組み

Siglipは、重量を共有し、類似の画像テキストペアを区別するように訓練された2つの並列ネットワークを含むシアムネットワークアーキテクチャを利用します。このアーキテクチャにより、Siglipは画像とテキストの両方の高品質の表現を効率的に学習できます。このモデルは、画像の多様なデータセットと対応するテキストの説明で事前に訓練されており、さまざまな目に見えないタスクに適切に一般化できるようにします。

Siglipの機能の重要なステップ

- シャムネットワーク:このモデルは、画像とテキスト入力を個別に処理するが、同じパラメーターを共有する2つの同一のニューラルネットワークを採用しています。このセットアップにより、画像表現とテキスト表現の効果的な比較と調整が可能になります。

- 対照学習:Clipと同様に、Siglipは対照的な学習を使用して、画像テキストペアの一致した類似性を最大化し、非一致ペアの最小化を行います。

- 多様なデータを事前に作成する:Siglipは、大規模で多様なデータセットで事前に訓練されており、ゼロショットシナリオでうまく機能する能力を高め、タスクで追加の微調整なしでテストされます。

Siglipのアプリケーション

- ゼロショット画像分類:Siglipは、画像をカテゴリに分類することに優れており、その広範な前orainingを活用することで明示的に訓練されていません。

- 視覚的な検索と検索:テキストクエリに基づいて画像を取得したり、記述テキストに基づいて画像を分類するために使用できます。

- コンテンツベースの画像タグ付け:Siglipは、画像の記述タグを自動的に生成でき、コンテンツ管理と組織に役立ちます。

コード例:Siglipによるゼロショット画像分類

以下は、ゼロショット画像分類にSiglipを使用する方法を示すコードスニペットの例です。この例は、トランスライブラリを使用して画像を候補ラベルに分類する方法を示しています。

トランスからインポートパイプラインから

PILインポート画像から

リクエストをインポートします

#事前に訓練されたSiglipモデルをロードします

image_classifier = pipeline(task = "zero-shot-image-classification"、model = "google/siglip-base-patch16-224")

#URLから画像をロードします

url = 'http://images.cocodataset.org/val2017/000000039769.jpg'

image = image.open(requests.get(url、stream = true).raw)

#分類のために候補ラベルを定義します

condidate_labels = ["2匹の猫"、 "平面"、「リモート "]]

#ゼロショット画像分類を実行します

outputs = image_classifier(image、condidate_labels = condastate_labels)

#結果をフォーマットして印刷します

formatted_outputs = [{"score":round(output ["score"]、4)、 "label":output ["label"]} for outputs]

print(formatted_outputs)

ここからSiglipの詳細を読んでください。

トレーニングビジョン言語モデル(VLM)

トレーニングビジョン言語モデル(VLM)には、いくつかの重要な段階が含まれます。

- データ収集:ペアの画像とテキストの大規模なデータセットを収集し、モデルを効果的にトレーニングする多様性と品質を確保します。

- 事前化:変圧器アーキテクチャを使用して、VLMは大量の画像テキストデータで前提とされています。このモデルは、画像やテキストのマスクされた部分を予測するなど、自己監視の学習タスクを使用して、視覚情報とテキスト情報の両方をエンコードすることを学びます。

- 微調整:前処理されたモデルは、より小さなタスク固有のデータセットを使用して特定のタスクで微調整されています。これにより、モデルは画像分類やテキスト生成などの特定のアプリケーションに適応するのに役立ちます。

- 生成トレーニング:生成VLMの場合、トレーニングには、学習した表現に基づいて、画像からテキストやテキストから画像を生成するなど、新しいサンプルを作成することを学習することが含まれます。

- 対照学習:この手法により、ポジティブペアの類似性を最大化し、負のペアに対して最小化することにより、類似のデータと異なるデータを区別するモデルの能力が向上します。

パリゲンマの理解

Paligemmaは、構造化されたマルチステージトレーニングアプローチを通じて画像とテキストの理解を強化するように設計されたビジョン言語モデル(VLM)です。 SiglipとGemmaのコンポーネントを統合して、高度なマルチモーダル機能を実現します。トランスクリプトと提供されたデータに基づく詳細な概要を次に示します。

それがどのように機能するか

- 入力:モデルはテキスト入力と画像入力の両方を取ります。テキスト入力は、線形投影とトークン連結を介して処理され、画像はモデルのビジョンコンポーネントによってエンコードされます。

- Siglip :このコンポーネントは、画像処理にVision Transformer(VIT-SQ400M)アーキテクチャを利用しています。視覚データをテキストデータを使用して共有機能空間にマッピングします。

- Gemma Decoder :Gemma Decoderは、テキストと画像の両方の機能を組み合わせて出力を生成します。このデコーダーは、マルチモーダルデータを統合し、意味のある結果を生成するために重要です。

パリゲンマのトレーニングフェーズ

ここで、以下のパリゲンマのトレーニング段階を調べてみましょう。

-

ユニモーダルトレーニング:

- Siglip(VIT-SQ400M) :強力な視覚表現を構築するために、画像だけでトレーニングします。

- Gemma-2B :テキストだけで列車だけで、堅牢なテキスト埋め込みの生成に焦点を当てています。

-

マルチモーダルトレーニング:

- 224PX、IBの例:このフェーズでは、モデルは入力例(IB)を使用してマルチモーダルの理解を改善し、224pxの解像度で画像テキストペアを処理することを学びます。

-

解決策の増加:

- 4480x&896px :画像とテキストデータの解像度を増やして、より詳細で複雑なマルチモーダルタスクを処理するモデルの機能を改善します。

-

移行:

- 解像度、エポック、学習率:解像度、トレーニングエポックの数、学習率などの重要なパラメーターを調整して、パフォーマンスを最適化し、学習機能を新しいタスクに転送します。

Paligemmaの詳細については、こちらから読んでください。

結論

ビジョン言語モデル(VLMS)に関するこのガイドは、ビジョンと言語技術の組み合わせに革新的な影響を強調しています。オブジェクトの検出や画像セグメンテーション、クリップなどの顕著なモデル、さまざまなトレーニング方法などの重要な機能を調査しました。 VLMは、視覚データとテキストデータをシームレスに統合し、将来より直感的で高度なアプリケーションの段階を設定することにより、AIを進めています。

よくある質問

Q1。ビジョン言語モデル(VLM)とは何ですか?A.ビジョン言語モデル(VLM)は、視覚データとテキストデータを統合して、画像とテキストから情報を理解および生成します。また、画像のキャプションや視覚的な質問への回答などのタスクを有効にします。

Q2。クリップはどのように機能しますか?A. Clipは、対照的な学習アプローチを使用して、画像とテキストの表現を調整します。画像とテキストの説明を効果的に一致させることができます。

Q3。 VLMSの主な機能は何ですか?A. VLMSは、オブジェクトの検出、画像セグメンテーション、埋め込み、ビジョンの質問への回答に優れており、ビジョンと言語処理を組み合わせて複雑なタスクを実行します。

Q4。 VLMSで微調整する目的は何ですか?A.微調整は、事前に訓練されたVLMを特定のタスクまたはデータセットに適応させ、特定のアプリケーションのパフォーマンスと精度を向上させます。

以上がビジョン言語モデル(VLM)の包括的なガイドの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

7強力なAIは、すべてのプロジェクトマネージャーが今習得する必要があるプロンプトをプロンプトしますMay 08, 2025 am 11:39 AM

7強力なAIは、すべてのプロジェクトマネージャーが今習得する必要があるプロンプトをプロンプトしますMay 08, 2025 am 11:39 AMChatGptのようなチャットボットによって例示される生成AIは、プロジェクトマネージャーにワークフローを合理化し、プロジェクトが予定外で予算内に留まることを保証する強力なツールを提供します。 ただし、正しいプロンプトを作成するのに効果的な使用のヒンジ。 正確、詳細

AI自体の有益な支援を介して、とらえどころのないAGIの不明確な意味を定義するMay 08, 2025 am 11:37 AM

AI自体の有益な支援を介して、とらえどころのないAGIの不明確な意味を定義するMay 08, 2025 am 11:37 AM人工一般情報(AGI)を定義するという課題は重要です。 AGIの進捗状況の主張は、しばしば明確なベンチマークを欠いており、定義は事前に決定された研究の方向に合うように調整されています。この記事では、定義への新しいアプローチを探ります

IBMは、2025が生成AIにおけるWatsonx.dataの役割を紹介していると考えていますMay 08, 2025 am 11:32 AM

IBMは、2025が生成AIにおけるWatsonx.dataの役割を紹介していると考えていますMay 08, 2025 am 11:32 AMIBM WATSONX.DATA:エンタープライズAIデータスタックの合理化 IBMは、Watsonx.Dataを、正確でスケーラブルな生成AIソリューションの提供を加速することを目的とした企業向けの重要なプラットフォームとして位置付けています。 これは、Complを簡素化することによって達成されます

ヒューマノイドロボットマシンの台頭が近づいています。May 08, 2025 am 11:29 AM

ヒューマノイドロボットマシンの台頭が近づいています。May 08, 2025 am 11:29 AMAIおよび材料科学のブレークスルーに促進されたロボット工学の急速な進歩は、ヒューマノイドロボットの新しい時代を導く態勢が整っています。 何年もの間、産業自動化が主な焦点でしたが、ロボットの能力は急速に経験しています

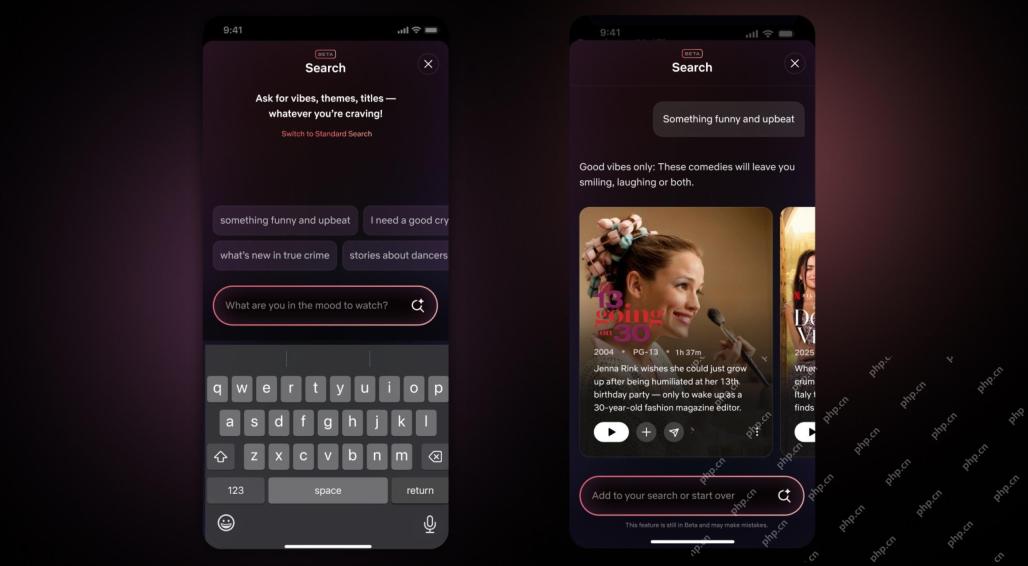

Netflix Revamps Interface - AI検索ツールとTiktokのようなデザインのデビューMay 08, 2025 am 11:25 AM

Netflix Revamps Interface - AI検索ツールとTiktokのようなデザインのデビューMay 08, 2025 am 11:25 AM10年以内のNetflixインターフェイスの最大のアップデート:よりスマートでパーソナライズされた、採用される多様なコンテンツ Netflixは、10年でユーザーインターフェイスの最大の改良を発表しました。新しい外観だけでなく、各ショーに関する情報をさらに追加し、「アンビエント」やより柔軟な構造を理解するための曖昧な概念を理解できるよりスマートなAI検索ツールを紹介し、新興ビデオゲーム、ライブイベント、スポーツイベント、その他の新しいタイプのコンテンツにおいてよりよく示すことができます。 トレンドに対応するために、モバイルの新しい垂直ビデオコンポーネントにより、ファンはトレーラーやクリップをスクロールしたり、完全なショーを見たり、他の人とコンテンツを共有したりすることが容易になります。これは、無限のスクロールと非常に成功した短いビデオWebサイトTIを思い出させます

AGIのずっと前:あなたに挑戦する3つのAIマイルストーンMay 08, 2025 am 11:24 AM

AGIのずっと前:あなたに挑戦する3つのAIマイルストーンMay 08, 2025 am 11:24 AM人工知能における一般的な知能(AGI)の議論の高まりにより、人工知能が人間の知能を上回ると何が起こるかについて多くの人が考えるようになりました。この瞬間が近いか遠いかは、あなたが尋ねる人に依存しますが、私たちが焦点を当てるべき最も重要なマイルストーンであるとは思いません。どの以前のAIマイルストーンがすべての人に影響を与えますか?どんなマイルストーンが達成されましたか?ここに私が起こったと思う3つのことがあります。 人工知能は人間の弱点を上回ります 2022年の映画「社会的ジレンマ」で、人道技術センターのトリスタン・ハリスは、人工知能が人間の弱点を上回っていることを指摘しました。これはどういう意味ですか?これは、人工知能が人間を使用することができたことを意味します

Transunionのプラットフォーム変換とAIの野望に関するVenkat AchantaMay 08, 2025 am 11:23 AM

Transunionのプラットフォーム変換とAIの野望に関するVenkat AchantaMay 08, 2025 am 11:23 AMTransunionのCTOであるRanganath Achantaは、2021年後半にNeustarの買収に続いて会社に入社して以来、重要な技術的変革を主導しました。

AIへの信頼が跳ね上がると、生産性が続きますMay 08, 2025 am 11:11 AM

AIへの信頼が跳ね上がると、生産性が続きますMay 08, 2025 am 11:11 AMBuilding Trustは、ビジネスでのAIの採用を成功させるために最重要です。 これは、ビジネスプロセス内の人間の要素を考えると特に当てはまります。 従業員は、他の人と同様に、AIとその実装に関する懸念を抱いています。 デロイトの研究者はSCです

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

ZendStudio 13.5.1 Mac

強力な PHP 統合開発環境

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。