以前、強化学習、特にオフライン連続制御の分野における、トランスフォーマーと拡散モデルに基づくシーケンス モデリング手法のアプリケーションを紹介しました。このうち、Trajectory Transformer (TT) と Diffusser はモデルベースの計画アルゴリズムであり、非常に高精度な軌道予測と優れた柔軟性を示しますが、意思決定の遅延が比較的大きくなります。特に、TT はシーケンス内の各次元をシンボルとして独立して離散化するため、シーケンス全体が非常に長くなり、状態とアクションの次元が増加するにつれてシーケンス生成の時間消費が急速に増加します。

軌道生成モデルが実用レベルの意思決定速度を達成できるようにするために、Diffusser と並行して効率的な軌道生成と意思決定のプロジェクトを開始しました (重複しますが、後で) 。私たちの最初の考えは、離散的な分布ではなく連続空間内のガウスのトランスフォーマー混合物を使用して軌道分布全体を適合させることでした。実装上の問題は排除されませんが、このアプローチでは比較的安定した生成モデルを取得できませんでした。次に、変分オートエンコーダ (VAE) を試し、いくつかのブレークスルーを達成しました。ただし、VAE の再構成精度はあまり理想的ではないため、下流側の制御パフォーマンスは TT のそれとは大きく異なります。数回の反復の後、最終的に軌道生成の基本モデルとして VQ-VAE を選択し、効率的にサンプリングと計画を実行でき、高次元の制御タスクにおいて他のモデルベースの手法よりもはるかに優れたパフォーマンスを発揮する新しいアルゴリズムを取得しました。私たちは Trajectory Autoencoding Planner (TAP) と呼びました。

- プロジェクトのホームページ: https://sites.google .com /view/latentplan

- 紙のホームページ: https://arxiv.org/abs/2208.10291

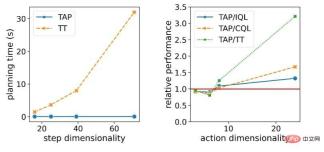

単一 GPU の下で、TAP は 20Hz の意思決定効率でオンライン意思決定を容易に行うことができます。低次元の D4RL タスクでは、意思決定の遅延が発生します。 TT はわずか 1% 程度です。さらに重要なことは、タスクの状態とアクションの次元 D が増加するにつれて、TT の理論的な決定遅延が 3 乗に応じて増加し、ディフューザーは理論的に直線的に増加するということです。 ですが、TAP の意思決定の速度は  の次元には影響されません。エージェントの意思決定パフォーマンスに関しては、アクションの次元が増加するにつれて、TAP のパフォーマンスは他の手法と比較して向上しており、モデルベースの手法 (TT など) と比較した場合の向上は特に顕著です。

の次元には影響されません。エージェントの意思決定パフォーマンスに関しては、アクションの次元が増加するにつれて、TAP のパフォーマンスは他の手法と比較して向上しており、モデルベースの手法 (TT など) と比較した場合の向上は特に顕著です。  意思決定と制御タスクに対する意思決定の遅延の重要性は非常に明白です。MuZero のようなアルゴリズムはシミュレーション環境では良好に機能しますが、現実世界ではリアルタイムで迅速な応答が必要です。 . タスクの場合、過度の意思決定の遅れは、その導入において大きな困難となるでしょう。また、シミュレーション環境を前提とすると、意思決定速度が遅いため、同様のアルゴリズムのテストコストも高くつき、オンライン強化学習での利用コストも相対的に高くなります。

意思決定と制御タスクに対する意思決定の遅延の重要性は非常に明白です。MuZero のようなアルゴリズムはシミュレーション環境では良好に機能しますが、現実世界ではリアルタイムで迅速な応答が必要です。 . タスクの場合、過度の意思決定の遅れは、その導入において大きな困難となるでしょう。また、シミュレーション環境を前提とすると、意思決定速度が遅いため、同様のアルゴリズムのテストコストも高くつき、オンライン強化学習での利用コストも相対的に高くなります。

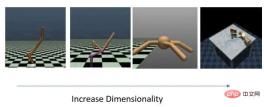

段階的に規模を拡大する 4 つのタスク セット

#タスクの次元の拡大に伴う意思決定の待ち時間と相対的なモデルのパフォーマンスの変化

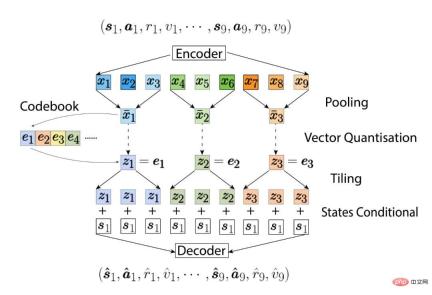

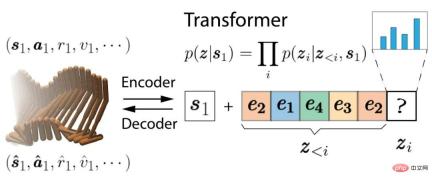

#メソッドの概要#まず、VQ-VAE のオートエンコーダー (autoencoders) 部分をトレーニングします。オリジナルの VQ-VAE とは 2 つの違いがあります。最初の違いは、エンコーダーとデコーダーの両方が CNN ではなく Causal Transformer に基づいていることです。 2 番目の違いは、条件付き確率分布を学習し、モデル化される可能性のある軌跡はすべて現在の状態

から開始する必要があることです。オートエンコーダーは、現在の状態  から始まる軌跡と潜在コードの間の双方向マッピングを学習します。これらの潜在コードは元の軌跡と同様に時系列に配置されており、各潜在コードは実際の

から始まる軌跡と潜在コードの間の双方向マッピングを学習します。これらの潜在コードは元の軌跡と同様に時系列に配置されており、各潜在コードは実際の  ステップ軌跡にマッピングされます。 Causal Transformer を使用するため、時間的順位が低い潜在コード (

ステップ軌跡にマッピングされます。 Causal Transformer を使用するため、時間的順位が低い潜在コード ( など) は、時間的順位が高いシーケンス (

など) は、時間的順位が高いシーケンス ( など) に情報を送信しません。これにより、TAP は最初の N 個の隠れたコーディング部分を通じて長さ NL の軌跡をデコードできるようになり、その後の計画に使用するときに非常に役立ちます。

など) に情報を送信しません。これにより、TAP は最初の N 個の隠れたコーディング部分を通じて長さ NL の軌跡をデコードできるようになり、その後の計画に使用するときに非常に役立ちます。

:

は最高リターンよりもはるかに大きい数値であり、軌道の確率がしきい値

よりも高い場合、その基準はこの軌跡が期待リターンであると判断した場合 (赤で強調表示)、そうでない場合は、この軌跡自体の確率が支配的な要素 (青で強調表示) になります。言い換えれば、TAP は、しきい値を超える軌跡の中で期待リターンが最も高いものを選択します。

よりも高い場合、その基準はこの軌跡が期待リターンであると判断した場合 (赤で強調表示)、そうでない場合は、この軌跡自体の確率が支配的な要素 (青で強調表示) になります。言い換えれば、TAP は、しきい値を超える軌跡の中で期待リターンが最も高いものを選択します。

サンプル数は十分に多いですが、予測シーケンスが短い場合には、直接サンプリングも非常に効果的です。サンプル数と計画に必要な合計時間を制限するという前提の下では、より良いオプティマイザーを使用すると、パフォーマンスが向上します。次の 2 つのアニメーションは、144 ステップ先の将来を予測する場合に、直接サンプリングとビーム検索によって生成された軌道の違いを示しています。これらの軌跡は最終的な目標スコアによってソートされ、最上層の最上部にある軌跡ほどスコアが高く、その後ろに積み重ねられた軌跡ほどスコアが低くなります。さらに、スコアが低い軌道は透明度も低くなります。

この写真では、直接サンプリングによって生成された軌道のダイナミクスの多くが不安定で、物理法則に従っていないことがわかります。特に、背景の明るい軌道はほとんどすべてが浮いています。これらはすべて比較的確率の低い軌道であり、最終計画が選択されるときに削除されます。最前列の軌道はよりダイナミックに見えますが、対応するパフォーマンスは比較的悪く、今にも落ちそうになります。対照的に、ビーム探索では、次の隠れ変数を展開するときに軌道の確率が動的に考慮されるため、確率が非常に低い分岐は早期に終了し、生成される候補軌道は、より優れたパフォーマンスと可能性を備えた軌道に焦点を当てます。線路が周囲にあります。

#直接サンプリング

##ビーム検索実験結果

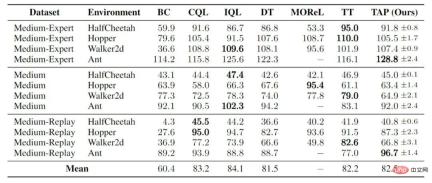

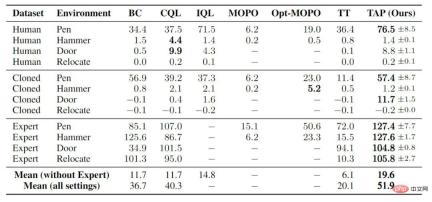

より高度な評価と戦略の改善がなければ、予測精度の利点のみに依存すると、次のような結果が得られます。 -次元タスクでは、TAP は他のオフライン強化学習と同等のパフォーマンスを達成しました:

#ジム移動制御

高次元タスクでは、TAP は他のモデルベースの手法よりもはるかに優れたパフォーマンスを達成し、一般的なモデルフリーの手法をも上回りました。実際には、まだ答えられていない未解決の質問が 2 つあります。 1 つ目は、なぜ以前のモデルベースの手法がこれらの高次元オフライン強化学習タスクでパフォーマンスが悪かったのか、2 つ目は、TAP がこれらのタスクで多くのモデルフリー手法よりも優れたパフォーマンスを発揮できる理由です。私たちの前提の 1 つは、政策が行動政策から大きく逸脱しないことを考慮しながら、高次元の問題に関する政策を最適化することは非常に難しいということです。モデルを学習するとき、モデル自体のエラーによってこの困難さがさらに増大する可能性があります。 TAP は、最適化空間を小さな離散隠れ変数空間に移動し、最適化プロセス全体をより堅牢にします。

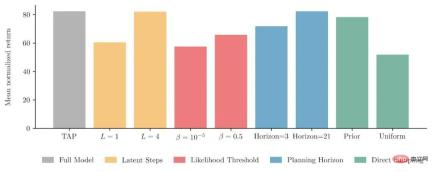

##いくつかのスライス研究# #TAP の多くの設計について、ジムの移動制御のタスクに関する一連のスライス スタディも実行しました。 1 つ目は、各潜在コードが実際に

(黄色のヒストグラム) に対応する軌跡のステップ数です。事実は、潜在変数を複数ステップの状態遷移に対応させるだけでなく、計算上の利点だけでなく、最終モデルでも優れたパフォーマンスを発揮します。検索目的関数

(赤いヒストグラム) で低確率軌道ペナルティを引き起こすしきい値を調整することで、目的関数の両方の部分がモデルの最終パフォーマンスに実際に役立つことも確認しました。 。もう 1 つのポイントは、将来に計画されているステップ数 (計画期間、青色のヒストグラム) はモデルのパフォーマンスにほとんど影響を与えないことです。デプロイ後の探索では、1 つの潜在変数だけを拡張しても、最終的なエージェントのパフォーマンスは低下するだけです。約10%増加

最後に、直接サンプリング下で TAP のパフォーマンスを試しました (緑色のヒストグラム)。ここでサンプリングされたサンプルの数は 2048 ですが、上のアニメーションの数は 256 のみであることに注意してください。また、上のアニメーションでは次の 144 ステップの計画が生成されますが、実際には、基本モデルは 15 ステップの計画を指示しています。結論としては、サンプル数が十分で計画パスが長くなければ、直接サンプリングでもビーム探索と同様のパフォーマンスを達成できるということです。しかし、これは学習された潜在変数の条件付き分布からサンプリングした場合であり、潜在コーディングから直接等しい確率でサンプリングしたとしても、最終的には完全な TAP モデルよりもはるかに悪くなるでしょう。

スライス研究の結果

以上がシングル GPU で 20Hz のオンライン意思決定を実現、シーケンス生成モデルに基づいた最新の効率的な軌道計画手法の解釈の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

10生成AIコーディング拡張機能とコードのコードを探る必要がありますApr 13, 2025 am 01:14 AM

10生成AIコーディング拡張機能とコードのコードを探る必要がありますApr 13, 2025 am 01:14 AMねえ、忍者をコーディング!その日はどのようなコーディング関連のタスクを計画していますか?このブログにさらに飛び込む前に、コーディング関連のすべての問題について考えてほしいです。 終わり? - &#8217を見てみましょう

革新を調理する:人工知能がフードサービスを変革する方法Apr 12, 2025 pm 12:09 PM

革新を調理する:人工知能がフードサービスを変革する方法Apr 12, 2025 pm 12:09 PM食品の準備を強化するAI まだ初期の使用中ですが、AIシステムは食品の準備にますます使用されています。 AI駆動型のロボットは、ハンバーガーの製造、SAの組み立てなど、食品の準備タスクを自動化するためにキッチンで使用されています

Pythonネームスペースと可変スコープに関する包括的なガイドApr 12, 2025 pm 12:00 PM

Pythonネームスペースと可変スコープに関する包括的なガイドApr 12, 2025 pm 12:00 PM導入 Python関数における変数の名前空間、スコープ、および動作を理解することは、効率的に記述し、ランタイムエラーや例外を回避するために重要です。この記事では、さまざまなASPを掘り下げます

ビジョン言語モデル(VLM)の包括的なガイドApr 12, 2025 am 11:58 AM

ビジョン言語モデル(VLM)の包括的なガイドApr 12, 2025 am 11:58 AM導入 鮮やかな絵画や彫刻に囲まれたアートギャラリーを歩くことを想像してください。さて、各ピースに質問をして意味のある答えを得ることができたらどうでしょうか?あなたは尋ねるかもしれません、「あなたはどんな話を言っていますか?

MediaTekは、Kompanio UltraとDimenity 9400でプレミアムラインナップをブーストしますApr 12, 2025 am 11:52 AM

MediaTekは、Kompanio UltraとDimenity 9400でプレミアムラインナップをブーストしますApr 12, 2025 am 11:52 AM製品のケイデンスを継続して、今月MediaTekは、新しいKompanio UltraやDimenity 9400を含む一連の発表を行いました。これらの製品は、スマートフォン用のチップを含むMediaTekのビジネスのより伝統的な部分を埋めます

今週のAIで:Walmartがファッションのトレンドを設定する前に設定しますApr 12, 2025 am 11:51 AM

今週のAIで:Walmartがファッションのトレンドを設定する前に設定しますApr 12, 2025 am 11:51 AM#1 GoogleはAgent2Agentを起動しました 物語:月曜日の朝です。 AI駆動のリクルーターとして、あなたはより賢く、難しくありません。携帯電話の会社のダッシュボードにログインします。それはあなたに3つの重要な役割が調達され、吟味され、予定されていることを伝えます

生成AIは精神障害に会いますApr 12, 2025 am 11:50 AM

生成AIは精神障害に会いますApr 12, 2025 am 11:50 AM私はあなたがそうであるに違いないと思います。 私たちは皆、精神障害がさまざまな心理学の用語を混ぜ合わせ、しばしば理解できないか完全に無意味であることが多い、さまざまなおしゃべりで構成されていることを知っているようです。 FOを吐き出すために必要なことはすべてです

プロトタイプ:科学者は紙をプラスチックに変えますApr 12, 2025 am 11:49 AM

プロトタイプ:科学者は紙をプラスチックに変えますApr 12, 2025 am 11:49 AM今週公開された新しい研究によると、2022年に製造されたプラスチックの9.5%のみがリサイクル材料から作られていました。一方、プラスチックは埋め立て地や生態系に積み上げられ続けています。 しかし、助けが近づいています。エンジンのチーム

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

WebStorm Mac版

便利なJavaScript開発ツール

SublimeText3 中国語版

中国語版、とても使いやすい

Dreamweaver Mac版

ビジュアル Web 開発ツール

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター