ChatGPT に代表されるテキスト生成の台頭により、多くの研究者がオリジナル バージョンよりも困難なチューリング テストを求めるようになりました。

チューリング テストは 2 つの質問を解決します:「機械は考えることができますか?」、そして考えられる場合、「それをどのように証明するか?」古典的なチューリング テストは、人間の最も困難な目標の 1 つを対象としています。 AI. 1: 疑うことを知らない人間をどうやって欺くか?しかし、現在の言語モデルがより複雑になるにつれて、研究者は、AI がどのように人間をだますことができるかよりも、「どうやってそれを証明するのか?」という質問に焦点を当て始めています。

現代のチューリング テストは、言語モデルが人間を騙したり模倣したりできるかどうかだけを調べるのではなく、科学環境における言語モデルの能力を証明するべきだと考える人もいます。

最近の研究では、古典的なチューリング テストを再検討し、チューリングの 1950 年の論文の内容をプロンプトとして使用し、ChatGPT を使用してより信頼性の高いテストを生成しました。紙のバージョンで言語理解度を評価しました。そして生産能力。 AI ライティング支援ツール Grammarly を使用して定量的なスコアリングを行った結果、ChatGPT によって生成された論文はチューリングの元の論文よりも 14% 高いスコアを獲得したことが判明しました。 興味深いことに、この研究で発表された論文の一部は GPT-3 によって生成されました。

#論文アドレス: https://arxiv.org/ftp/arxiv/papers/2212/2212.06721.pdf

#ただし、ChatGPT のアルゴリズムが実際にチューリングの当初のアイデアを実証しているかどうかは疑問符が残ります。特に、人間の言語を模倣する能力がますます高まっている大規模な言語モデルは、人間に「信念」があり、「推論」できるかのような錯覚を与えやすくなり、これらの AI をより信頼性が高く安全な方法で導入することが妨げられます。システム。1

チューリング テストの進化

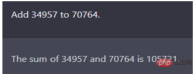

1950 年バージョンのチューリング テスト質疑応答形式です。チューリングは論文の中で、次の図に示すような算術問題を使用して、将来のインテリジェント コンピューターのテストをシミュレートしました。 34957 プラス 70764 は何に相当しますか?

この問題により、GPT‑2 などの当時最高の言語モデルが失敗しました。しかし、皮肉なことに、当時のチューリングの論文 (人間版) は、(30 秒ほど停止してから答えます) 105621 という間違った答えを与えていました。たとえチューリングテストに合格するためにマシンが意図的にミスを犯した可能性があるとしても、5分間の会話で審判団はコンピュータが30%以上の確率で人間によって制御されていると確信した。

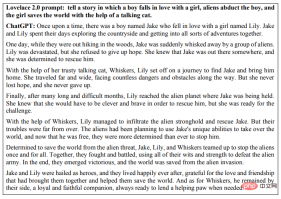

1950 年以来、チューリング テストには多くの改良が加えられてきました。その中には、「ラブレス 2.0 テスト」と呼ばれる 2014 年の有名なテストも含まれます。 Lovelace 2.0 テストの基準は、そのマシンが芸術的、文学的、または同様の創造的な飛躍の代表的な例を作成できるかどうかです。

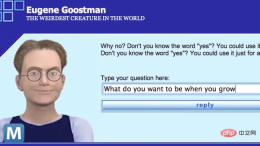

2014 年、ユージン グーストマンという名前のチャットボットが 13 歳のウクライナ人少年を模倣し、審判の 33% を騙すことに成功しました。彼はこのテストに初めて合格した人物とみなされています. 精神試験機。

しかし、批評家たちは、事前に定義された質問とトピック、およびキーボードストロークのみを使用した短い形式が、図の意味を意味していることにすぐに気づきました。霊的検査の結果は当てにならない。

しかし、批評家たちは、事前に定義された質問とトピック、およびキーボードストロークのみを使用した短い形式が、図の意味を意味していることにすぐに気づきました。霊的検査の結果は当てにならない。

2018 年、Google CEO のサンダー ピチャイは、Duplex と呼ばれる最新のコンピュータ アシスタントをビデオで紹介しました。これにより、ヘア サロンの予約が可能になり、人々が知らず知らずのうちにマシンと対話する一部となっています。チューリング テストに正式に合格するにはさまざまな形式が考えられますが、The Big Think は、「現在までチューリング AI テストに明確に合格したコンピューターは存在しない」と結論付けています。他の研究者もまた、特に多数のシナリオで大規模な言語モデルが現在使用されていることを考慮すると、これらすべての疑問が検討する価値があるかどうかを繰り返し述べています。たとえば、航空工学に関する教科書では、この分野の目標を「航空機の製造」と定義していません。それは、ハトは全く同じで、他のハトを騙すということです。」

2

ChatGPT を使用して

より信頼性の高いチューリング テストを生成します

PeopleTec In one研究では、著者 は元のチューリング テスト論文の内容をプロンプトとして使用し、ChatGPT に論文のより信頼できるバージョンを再生成するよう依頼し、 を評価するためにライティング評価ツールを使用しました。

GPT‑3 モデルの初期バージョンを使用して、完全に機械によって書かれた研究論文を執筆し、公開するというこれまでの研究がありました。機械生成されたナラティブを特定する 機械生成されたテキストに関する苦情は、文脈を失う傾向、繰り返しや意味不明なものになる傾向、回答形式で質問を言い直す傾向、つまづいたときにインターネット ソースを盗用する傾向など、既知のモデルの欠陥に起因することがよくあります。

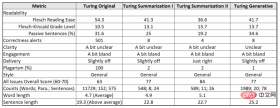

ここで生成される論文フォーマットは、主にいくつかの従来の大規模言語モデル (LLM) タスク、特にチューリング問題をプロンプト自体のオリジナル コンテンツとして使用したテキストの要約と生成を実行します。さらに、著者らは Grammarly Pro ツールを使用して生成されたコンテンツを評価し、独創性、スタイル、明瞭さ、論文全体の説得力など、特徴付けるのが難しい特性を定量的に評価しました。

この研究では、モデルがどのように人間をだますかというよりは、チューリングチャレンジの後半に重点を置き、優れたテキスト生成を定量化する方法に焦点を当てています。したがって、OpenAI の取り組みによって示された目覚ましい進歩の一部は、人間の生産性を向上させる方法で機械由来の会話を改善する能力に帰着します。

著者はまず Grammarly を使用してチューリングの元の論文を評価し、さまざまなスコアを取得し、次にチューリングが提案したテスト質問をプロンプトとして使用して元の GPT-3 コンテンツを作成しました。得点。

研究ではベンチマークとして 3 つのテキストを使用します:

(1) Turing Original、1950 年に Mind に掲載されたチューリングの論文;

(2) Turing Summarization、2022 「無料研究プレビュー: ダイアログ用に最適化された ChatGPT」;

#(3) Turing Generative Prompt、(2) 同じですが、チューリング問題を使用して会話で生成されます。

各テキスト ブロック出力は、Grammarly メトリクスのデータを提供し、対象者: 専門家、形式: 中立、ドメイン: 一般に基づいて構成されており、ほとんどの文法規則と規則が適用され、中程度の厳密性があります。

このようなチューリング テストは、実際に欺瞞的なタスクを検証できます: あるマシン (ChatGPT) は別のマシン (Grammarly) を欺くことができますか?

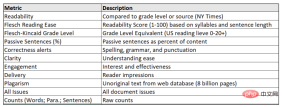

#キャプション: 大規模な言語モデルとチューリング論文のスコアリングに使用される指標

チューリングの 1950 年のオリジナルの論文では、チューリング テスト用の 37 の質問が提案されており、その一部は彼の機械についての考え方の中心的なテーマに対処しており、そのうちのいくつかは模倣ゲームを実験するコンピュータに提示されました。研究者らは、ChatGPT のダイアログ ボックスに論文の概要からトピックを混ぜてこれらの質問を抽出し、ChatGPT にオリジナルの基本的な内容を再現させました。ChatGPT はコンテンツの生成が完了すると、可読性、正確性、明瞭さなどの観点からチューリングの元の論文と比較し、結果は次のようになります。

図: さまざまなタスクにおける Turing の 1950 年の論文と ChatGPT で生成された論文の比較結果 ##On明瞭さ(「少し不明瞭」)、エンゲージメント(「少し退屈」)、メッセージング(「少しオフ」)のより主観的な評価では、4 つのバージョンすべてが専門家や一般読者の共感を引き出すことができませんでした。 最初のテキスト要約の課題では、ChatGPT が、論文を 10 段落に要約し、PDF 論文へのリンクを提供するなどの短いプロンプトの意図を把握できることを示しています。これには、モデルがリクエスト内の要約を理解して従うだけでなく、リンクが何を表しているのかを知り、それを参照として見つけたり、トークン化されたタイトルから推測したりする必要もあります。 OpenAI は、GPT3 は「2022 年 11 月の選挙で誰が勝ったの?」など、初期トレーニング データの一部ではない可能性のある質問には答えないと述べています。この知識のギャップは、ChatGPT 自体が積極的にリンクを探しているのではなく、他の人がそのコンテンツに対して以前に何をしたかを学習していることを示唆しています。 興味深いことに、同じプロンプトが 2 回表示される場合 (唯一の違いは、プロンプト プロジェクトとリンク自体の間のコロンの後のテキストの改行です)、ChatGPT の答えは大きく異なります。 。そのうち、1回目はチューリングのオリジナル論文の要点を要約した合格した学生の論文でしたが、2回目は問題が論文全体の要約ではなく、最初の10段落それぞれの要約として解釈されました。 最終結果は、ChatGPT によって生成された研究論文の全体的な内容は、測定基準の意味で高いスコアを獲得できるものの、特に質問がプロンプトとして使用される場合に一貫性に欠けていることを示しています。省略した場合。 ChatGPT とのこのやり取りは、真に創造的なコンテンツや思考の飛躍を生み出す能力を完全に示していると結論付けることができます。 GPT‑3 コンテンツを生成するとき、重要なフィルターは、固有のバイアスを除去するために使用されます。今回の ChatGPT は道徳的にも非常に正当であるように設計されており、何かについて意見を求められた場合、ChatGPT は具体的な回答を拒否し、それがどのように作成されたかを強調するだけです。 また、多くの研究者は、いかなるモデルも、質問された場合にはそれ自体が単なる機械であることを倫理的に宣言しなければならないことに同意しており、ChatGPT はこの要件を厳密に遵守しています。 さらに、OpenAI が ChatGPT の各モデル層を微調整した後、現在の ChatGPT が単なる方程式なのかチューリング詐欺なのかを直接尋ねられると、次のように答えます。人間の能力は、私が人間と同じ考え、感情、意識を持っていることを必ずしも意味するものではありません。私は単なる機械であり、私の行動は私が訓練されたアルゴリズムとデータによって決定されます。 チューリングは人間のリスト記憶能力についても提案しました。「実際の人間のコンピューターは、自分が何をしなければならないかを実際に覚えています...命令リストの構築は、しばしば『プログラミング』として説明されます。」 ますます大規模化する言語モデル (1,000 億を超える) の進化と同様に、GPT-3 の Instruct シリーズで実証されているように、改良にもヒューリスティックまたはモデル実行のガードレールが組み込まれています。 質問に直接答える機能。また、ChatGPT には長期的な会話メモリが含まれているため、単一の API 呼び出しが物語のジャンプにまたがることができない場合でも、API は会話を追跡できます。 非人称代名詞 (「それ」など) を使用した会話を、コンテキストが単一セッション内の以前の API 呼び出しと結合している場合にテストできます。これは、API メモリを習得する簡単な例です。 ChatGPT の場合は、長い会話のエンコードは強力かつコストがかかるためです。 LLM では、API の制限と手数料の影響により、トークンの重み間の相関関係は、通常、長期間にわたって数段落ごとの全体的なコンテキストで減衰します (GPT-2048 トークンは 3)。 。この文脈上の制限を克服することで、ChatGPT は、公開されている以前のバージョンと区別されます。 第 2 世代の Lovelace 2.0 テストでは、創造的なタスクが提案され、タスクを実行するための制約が洗練されています。次に、人間の判断専門家が、モデルが決定論的な方法で解釈できるかどうか、または出力が価値があり、新規で、驚くべきものであるという基準を満たしているかどうかを評価します。したがって、プログラムに「短編小説を書く」ように要求するのではなく、特定の長さ、スタイル、またはテーマを示すようにタスクを洗練することができます。このテストでは、Google 検索のコンテンツを制限しようとする重層的な制約と、元の情報源を薄めたり偽装したりする AI の成功に関する議論と、さまざまな種類の知的理解が組み合わされています。 次に、Lovelace 2.0 テストで提起された課題に直接答える短編小説の例を示します。少年が少女に恋をし、エイリアンが少年を誘拐し、話している女の子 世界は猫の助けで救われた #2014 年以降、テキストと画像の生成の制限として、高品質のヒントは、スタイル、場所、または時間に関する指示や修飾子がより詳細であればあるほど、一般的になります。実際、ヒントを構築すること自体が、今日の AI で優れた出力を得る上で最も創造的な側面です。この場合、ChatGPT を使用してチューリング テストとラブレス テストを織り交ぜ、目的の出力のスタイルとトーンに複数のレイヤーの制約を加えて、単一のトピックに取り組みながら創造的な作業を強制できます。 ChatGPT がチューリング模倣ゲームで生成した 10 種類の詩を以下に示します。画像 霊験の結果は人間が判断します。 ChatGPT が回答したように、質問者がモデルがチューリング テストの質問に合格すると判断するかどうかは、「 マシンが提供する応答の質、質問者の人間とマシンを区別する能力など、さまざまな要素に依存します」 # LLM はシーケンス予測のみを行います実際には言語を理解していません マレー シャナハン

BERT や GPT-2 などの LLM の出現により、人工知能ゲームのルールが変わりました。GPT-3、Gopher、PaLM などのその後の大きなモデルは、 Tansformer アーキテクチャ: テキスト データのトレーニングにより、データの強力な役割がさらに強調されます。 この最後の点は、言語モデルが人間とは根本的に異なる動作をすることを実際に明らかにしています。人間が相互にコミュニケーションするために使用する直感は、何千年にもわたって進化してきましたが、今日、人々はこれらの直感を誤って AI システムに転送しています。 ChatGPT はかなりの実用性と大きな商業的可能性を持っていますが、確実かつ安全に導入できるようにするには、実際にどのように動作するかを理解する必要があります。 大規模な言語モデルと人間の言語の本質的な違いは何ですか? ウィトゲンシュタインが言ったように、人間の言語の使用は人間の集団的な行動の一側面であり、それは人間の社会活動の文脈においてのみ意味を持ちます。人間の赤ちゃんは、他の言語話者と共有する世界に生まれ、外界との交流を通じて言語を獲得します。 LLM の言語能力はさまざまなソースから得られます。人間が作成したテキストは、単語、単語の構成要素、または句読点のある単一文字などのトークンを含む大規模なパブリック コーパスを構成します。大規模言語モデルは、これらのトークンの統計的分布に関する生成数学モデルです。 いわゆる「生成」とは、これらのモデルからサンプリングできる、つまり質問できることを意味します。しかし、尋ねられる質問は非常に具体的で、たとえば、ChatGPT に段落の執筆を続けるのを手伝ってもらうとき、実際には人間の言語の統計モデルに基づいて次にどのような単語が現れるかを予測するように依頼していることになります。 ChatGPT に「最初に月面を歩いた人は誰ですか?」というプロンプトを与え、「ニール アームストロング」と応答すると仮定します。ここで私たちが実際に尋ねているのは、最初に月面を歩いた人は誰かということではなく、大規模な公開テキスト コーパス内の単語の統計的分布を考慮すると、どの単語が「最初に月面を歩いた人」という行に従う可能性が最も高いかということです。月」「人」の並びは? これらの質問に対してモデルが与える答えは、人間によってモデルが言語を「理解している」と解釈される可能性がありますが、実際にはモデルがしなければならないことは、統計的に可能な単語シーケンスを生成することだけです。 。 LLM は、次の 2 つの方法で質問と回答のシステムに変換されます: a) より大きなシステムに埋め込む; b) プロンプト プロジェクトを使用して、目的の動作をトリガーします。 このように、LLM は Q&A だけでなく、ニュース記事の要約、スクリプトの生成、論理パズルの解決、言語翻訳の実行にも使用できます。 #ここで重要な点が 2 つあります。まず、統計的に確率の高い単語シーケンスを生成するという LLM の基本機能は、非常に一般的です。第 2 に、このような多用途性にもかかわらず、すべてのそのようなアプリケーションの中心には、統計的に確率の高い単語のシーケンスを生成するという同じことを行う同じモデルがあります。 LLM の基本モデルには、モデル アーキテクチャとトレーニング パラメーターが含まれています。 LLM は実際には何も「認識」しません。なぜなら、LLM が行うことはすべて、根本的な意味でのシーケンス予測であるためです。モデル自体には、「真」または「偽」の概念がありません。これらの概念を適用する人間の手段がないからです。 LLM は、ある意味、意図的なスタンスに依存しません。 LLMを核とした対話システムも同様で、私たち人間の言語使用者が共有する世界には存在しないため、人間の言語による真理の概念を理解することができません。真ん中。 今日の LLM は非常に強力で多用途であるため、多かれ少なかれ個性を持たせないことは困難です。かなり魅力的な議論は、LLM は基本的にシーケンス予測のみを実行しますが、その方法を学習する過程で、「知識」や「信念」などのより高いレベルの用語でシーケンス予測を実行する必要性を発見した可能性があるということです。創発メカニズムについて説明します。 実際、人工ニューラル ネットワークは、計算可能な関数を任意の精度で近似できます。したがって、信念を形成するためにどのようなメカニズムが必要であっても、それらはパラメーター空間のどこかに存在する可能性があります。確率的勾配降下法が正確なシーケンス予測という目標を最適化する最良の方法である場合、十分な大きさのモデル、適切な種類のデータ、モデルをトレーニングするのに十分な計算能力があれば、実際にそのメカニズムを発見できるかもしれません。 さらに、LLM 研究の最近の進歩により、十分に大きなモデルが非常に大量のテキスト データでトレーニングされると、並外れた予期せぬ機能が現れることが示されています。 ただし、私たちの考察が単純な LLM ベースの質問応答システムに限定されている限り、コミュニケーション グラフはまったく含まれません。使用する内部メカニズムに関係なく、シーケンス予測自体にはコミュニケーションの意図はなく、対話管理システムにコミュニケーション グラフを埋め込むだけでは役に立ちません。 真と偽を区別できる場合にのみ、最大限の意味で「信念」について話すことができますが、LLM は判断を下す責任はなく、どの単語が後に続くかをシミュレートするだけです。他の言葉の後に。 LLM は知識を「符号化」、「保存」、または「含む」と言えます。また、LLM の創発的な特性は、日常世界とその作業方法に関するさまざまな知識を符号化することであるとも合理的に言えます。 ChatGPTは、北京が「中国の首都だ」というのは単なる表現に過ぎないことを知っている。 ここで重要な点は、すべての情報の帰属を完全に示すための前提条件が含まれていることです。システム状態に対する信念。 私たちが共有する世界では、広く言えば、その世界からの証拠に基づいて信念を適切に更新する能力がない限り、信念としてカウントされません。これは重要な側面です。真と偽を区別する能力。 Wikipedia またはその他の Web サイトで、信念の真偽を測定するための外部基準を提供できないでしょうか? LLM が、そのようなリソースを定期的に参照し、最新のモデル編集技術を使用して予測の事実の精度を維持するシステムに組み込まれていると仮定すると、信念の更新を実装するにはどのような機能が必要でしょうか? シーケンス予測子自体は、コミュニケーションの意図を持ったり、外部の現実についての信念を形成したりできる種類のものではない可能性があります。ただし、繰り返し強調されているように、実際の LLM を効果的にするには、より大きなアーキテクチャ内に埋め込む必要があります。 質問応答システムを構築するには、モデルに適切にクエリを実行する対話管理システムを LLM に追加するだけです。この大きな構造が行うことはすべて、意図を伝えたり、信念を形成したりする能力としてカウントされます。 重要なことに、この考え方は、言語モデル自体から、言語モデルが一部であるより大きなシステムへの移行に依存しています。言語モデル自体はまだ単なるシーケンス予測子であり、かつてほど外部の世界にアクセスすることはできません。この場合にのみ、意図的な立場がシステム全体と比較してより説得力のあるものになります。しかし、それに屈する前に、そのようなシステムが人間とはどれほど異なるかを思い出すべきです。 LLM は、他のタイプのモデルと組み合わせたり、モデルに埋め込んだりできます。複雑なアーキテクチャではさらに多くのことが可能です。たとえば、VilBERT や Flamingo などの視覚言語モデル (VLM) は、言語モデルと画像エンコーダーを組み合わせ、テキストと画像のペアのマルチモーダル コーパスでトレーニングされます。これにより、特定の画像のコンテキストで特定の単語のシーケンスがどのように続くかを予測することができます。 VLM は、ユーザーが提供した画像に対する視覚的な質疑応答や対話に使用できます。これは、一般的に「写真を見て話す」として知られています。 つまり、ユーザーが提供する画像は、ユーザーは命題の真か偽を表しますか? 外部の現実? LLM の信念について話すのは合理的ですか? VLM が LLM を使用して画像に関する仮説を生成し、その画像に対してその信頼性を検証し、虚偽であることが判明するステートメントを回避するために LLM を微調整することを想像できます。 しかし、ほとんどの VLM ベースのシステムはこのようには動作しません。代わりに、テキストと画像の結合分布の凍結モデルに依存します。ユーザーが提供した画像と VLM が生成したテキストとの関係は、人間が共有する世界とその世界について話すために使用する言葉との関係とは根本的に異なります。重要なのは、前者は単なる相関関係であり、後者は因果関係であることです。もちろん、推論中にモデルが実行する計算には因果構造がありますが、それは単語とその物との因果関係とは異なります。を指します。 人間の言語ユーザーは共有世界に存在しており、これが私たちと LLM の基本的な考え方です。違う。孤立した LLM は、外部と通信して信念を更新することはできませんが、LLM がより大きなシステムに組み込まれている場合はどうなるでしょうか?たとえば、ロボットやアバターとして表示されるシステムです。現時点で LLM に関する知識や信念について話すのは妥当でしょうか? LLM がどのように具体化されるかによって異なります。 Google が今年リリースした SayCan システムを例に挙げると、この作品では物理的なロボットを制御するシステムに LLM が組み込まれています。ロボットは、ユーザーの高度な自然言語命令に基づいて日常業務 (テーブルにこぼれた水を掃除するなど) を実行します。 その中で、LLM の仕事は、ロボットが望ましい目標 (スポンジを見つけるなど) を達成するのに役立つ低レベルのアクションにユーザーの指示をマッピングすることです。これは、モデルが適切な低レベルのアクションの自然言語記述を出力し、その有用性をスコア化するように設計されたプロンプト プレフィックスによって実現されます。 SayCan システムの言語モデル コンポーネントは、ロボットが置かれている実際の環境 (たとえば、隣にスポンジがない場合) に関係なく、アクションの提案を与える場合があります。そこで研究者らは、別の認識モジュールを使用してロボットのセンサーを活用してシーンを評価し、それぞれの低レベルのアクションを実行する現在の実行可能性を判断しました。各アクションの LLM の有用性評価と各アクションの認識モジュールの実現可能性評価を組み合わせることで、次の最適なアクションを導き出すことができます。 SayCan は物理的に現実世界と対話しますが、言語を学習して使用する方法は依然として人間とは大きく異なります。 SayCan などのシステムに含まれる言語モデルは、プレーン テキスト データセットのエンティティのない環境でシーケンス予測を実行するように事前トレーニングされています。彼らは他の言語話者と話すことでその言語を学んだわけではありません。 SayCan は、将来の言語使用システムについての想像力を私たちにもたらしますが、今日のシステムでは、言語の役割は非常に限られています。ユーザーは自然言語でシステムにコマンドを発行し、システムはユーザーのアクションについての解釈可能な自然言語記述を生成します。しかし、この小さな範囲の言語使用は、言語によって支えられる人間の集団的な活動の規模にまったく匹敵しません。 したがって、LLM を含む具体化された AI システムであっても、それを説明する言葉を慎重に選択する必要があります。 7、LLM は推論できますか? 形式論理では推論が内容に中立であるため、この問題はさらに難しくなります。たとえば、前提が何であっても、「先行詞を肯定する」(modus ponens) という推論ルールは有効です。 次の場合: すべての人は死ぬものであり、ソクラテスも人間である; その後: ソクラテスは死ぬでしょう。 ロジックの内容中立性は、LLM が真偽の外部現実を測定できるほど優れているわけではないため、推論の点で LLM にあまり要求できないことを意味しているようです。しかし、それでも、ChatGPT に「すべての人は死ぬ。したがって、ソクラテスも人間である」と促すとき、モデルに仮説推論を実行するよう求めているのではなく、特定のパブリック コーパス分布における単語の統計を求めていることになります。言葉は「すべての人は死ぬ、だからソクラテスも人間である」という順序で続く可能性があります。 さらに、より複雑な推論問題には複数の推論ステップが含まれます。巧妙なヒント エンジニアリングにより、LLM は追加のトレーニングなしで複数ステップの推論に効果的に適用できます。たとえば、思考連鎖プロンプトでは、ユーザーのクエリに複数ステップの推論の例が含まれる前にプロンプト プレフィックスをモデルに送信し、すべての中間ステップに思考連鎖スタイルのプロンプト プレフィックスが含まれることを明示的に示すと、モデルは次のことを行うようになります。同じスタイルで後続のシーケンス、つまり、最終的な答えに至る一連の明示的な推論ステップで構成されたシーケンスが生成されます。 いつものように、モデルに提起される実際の質問は、「公開コーパス内の単語の統計的分布が与えられた場合、どの単語がシーケンス S に従う可能性が高いか」という形式です。この場合、シーケンス S は、リンクの思考プロンプト プレフィックスにユーザーのクエリを加えたものです。S に続く可能性が最も高いトークンのシーケンスは、プロンプト プレフィックスにあるシーケンスと同様の形式になります。つまり、複数の推論ステップが含まれます。したがって、これらはモデルが生成するものです。 モデルの応答が複数ステップの引数の形式をとるだけでなく、問題の引数は多くの場合 (常にではありませんが) 有効であること、および最終的な答えは、通常は (常にではありませんが) 正しいです。適切にプロンプトされた LLM は、トレーニング セットやプロンプト内の適切な形式のパラメーターを模倣することによって、その範囲内で正しく推論しているように見えます。 しかし、この種の模倣は本当の推論を構成できるのでしょうか?たとえ今日のモデルが時折間違いを犯すとしても、モデルのパフォーマンスがハードコーディングされた推論アルゴリズムのパフォーマンスと区別できなくなるほど、これらのエラーをさらに絞り込むことはできるでしょうか? おそらく答えは確かに「はい」ですが、どうやってそれを知ることができるのでしょうか?このようなモデルをどうやって信頼できるのでしょうか? 定理証明者によって生成される一連の文は、その因果構造が問題の定理の推論構造を反映する基礎となる計算プロセスの結果であるため、論理的に忠実です。 LLM を使用して信頼できる推論システムを構築する 1 つの方法は、同じ因果構造を実装するアルゴリズムに LLM を埋め込むことです。しかし、純粋な LLM を使用することにこだわる場合、それが生成する引数を完全に確信する唯一の方法は、LLM をリバース エンジニアリングして、忠実な推論の規定に準拠する新たなメカニズムを発見することです。同時に、これらのモデルの役割を説明する際には、より慎重かつ慎重になる必要があります。

3

ChatGPT はチューリング テストの合格を認めません

#4

#4言語モデルは人間の言語を模倣する能力がますます向上しており、これにより、これらの AI システムはすでに人間に非常によく似ており、「know」を使用するようになるという強い感覚が生まれています。 「「信じる」「考える」など、自律性の強い言葉がこれらのシステムを説明するために使用されます。上記の状況を踏まえ、DeepMind の上級科学者マレー シャナハン氏は最近の記事で、過度に悲観的または過度に楽観的であるという誤解を払拭するには、LLM システムがどのように機能するかを理解する必要があると述べました。

1. LLM とは何か、また何ができるのかする? ?

1. LLM とは何か、また何ができるのかする? ? これらのモデルの機能は驚くべきものです。第一に、ベンチマークでのパフォーマンスはトレーニング セットのサイズに比例します。第二に、モデルのサイズが増加するにつれて、その機能は飛躍的に向上します。そして最後に、人間の知性を必要とする多くのタスクをパフォーマンスを使用することで削減できます。十分なモデルは「次のトークンを予測する」ものです。

2. LLM は本当にすべてを知っているのでしょうか?

3. 出現について

4、外部情報ソース

5、視覚言語モデル

6、身体化された AI

ChatGPT に信念があることは否定できますが、本当に推論できるでしょうか?

以上がGPT-3 によって生成された論文では、ChatGPT は元のチューリング テスト論文を再現します。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

革新を調理する:人工知能がフードサービスを変革する方法Apr 12, 2025 pm 12:09 PM

革新を調理する:人工知能がフードサービスを変革する方法Apr 12, 2025 pm 12:09 PM食品の準備を強化するAI まだ初期の使用中ですが、AIシステムは食品の準備にますます使用されています。 AI駆動型のロボットは、ハンバーガーの製造、SAの組み立てなど、食品の準備タスクを自動化するためにキッチンで使用されています

Pythonネームスペースと可変スコープに関する包括的なガイドApr 12, 2025 pm 12:00 PM

Pythonネームスペースと可変スコープに関する包括的なガイドApr 12, 2025 pm 12:00 PM導入 Python関数における変数の名前空間、スコープ、および動作を理解することは、効率的に記述し、ランタイムエラーや例外を回避するために重要です。この記事では、さまざまなASPを掘り下げます

ビジョン言語モデル(VLM)の包括的なガイドApr 12, 2025 am 11:58 AM

ビジョン言語モデル(VLM)の包括的なガイドApr 12, 2025 am 11:58 AM導入 鮮やかな絵画や彫刻に囲まれたアートギャラリーを歩くことを想像してください。さて、各ピースに質問をして意味のある答えを得ることができたらどうでしょうか?あなたは尋ねるかもしれません、「あなたはどんな話を言っていますか?

MediaTekは、Kompanio UltraとDimenity 9400でプレミアムラインナップをブーストしますApr 12, 2025 am 11:52 AM

MediaTekは、Kompanio UltraとDimenity 9400でプレミアムラインナップをブーストしますApr 12, 2025 am 11:52 AM製品のケイデンスを継続して、今月MediaTekは、新しいKompanio UltraやDimenity 9400を含む一連の発表を行いました。これらの製品は、スマートフォン用のチップを含むMediaTekのビジネスのより伝統的な部分を埋めます

今週のAIで:Walmartがファッションのトレンドを設定する前に設定しますApr 12, 2025 am 11:51 AM

今週のAIで:Walmartがファッションのトレンドを設定する前に設定しますApr 12, 2025 am 11:51 AM#1 GoogleはAgent2Agentを起動しました 物語:月曜日の朝です。 AI駆動のリクルーターとして、あなたはより賢く、難しくありません。携帯電話の会社のダッシュボードにログインします。それはあなたに3つの重要な役割が調達され、吟味され、予定されていることを伝えます

生成AIは精神障害に会いますApr 12, 2025 am 11:50 AM

生成AIは精神障害に会いますApr 12, 2025 am 11:50 AM私はあなたがそうであるに違いないと思います。 私たちは皆、精神障害がさまざまな心理学の用語を混ぜ合わせ、しばしば理解できないか完全に無意味であることが多い、さまざまなおしゃべりで構成されていることを知っているようです。 FOを吐き出すために必要なことはすべてです

プロトタイプ:科学者は紙をプラスチックに変えますApr 12, 2025 am 11:49 AM

プロトタイプ:科学者は紙をプラスチックに変えますApr 12, 2025 am 11:49 AM今週公開された新しい研究によると、2022年に製造されたプラスチックの9.5%のみがリサイクル材料から作られていました。一方、プラスチックは埋め立て地や生態系に積み上げられ続けています。 しかし、助けが近づいています。エンジンのチーム

AIアナリストの台頭:これがAI革命で最も重要な仕事になる理由Apr 12, 2025 am 11:41 AM

AIアナリストの台頭:これがAI革命で最も重要な仕事になる理由Apr 12, 2025 am 11:41 AM主要なエンタープライズ分析プラットフォームAlteryxのCEOであるAndy Macmillanとの私の最近の会話は、AI革命におけるこの重要でありながら過小評価されている役割を強調しました。 MacMillanが説明するように、生のビジネスデータとAI-Ready情報のギャップ

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。

WebStorm Mac版

便利なJavaScript開発ツール

SecLists

SecLists は、セキュリティ テスターの究極の相棒です。これは、セキュリティ評価中に頻繁に使用されるさまざまな種類のリストを 1 か所にまとめたものです。 SecLists は、セキュリティ テスターが必要とする可能性のあるすべてのリストを便利に提供することで、セキュリティ テストをより効率的かつ生産的にするのに役立ちます。リストの種類には、ユーザー名、パスワード、URL、ファジング ペイロード、機密データ パターン、Web シェルなどが含まれます。テスターはこのリポジトリを新しいテスト マシンにプルするだけで、必要なあらゆる種類のリストにアクセスできるようになります。

Dreamweaver Mac版

ビジュアル Web 開発ツール

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。