ホームページ >テクノロジー周辺機器 >AI >Nanyang Polytechnic は、完全なシーン グラフから PSG を生成し、ピクセル レベルでオブジェクトの位置を特定し、56 の関係を予測するタスクを提案しました。

Nanyang Polytechnic は、完全なシーン グラフから PSG を生成し、ピクセル レベルでオブジェクトの位置を特定し、56 の関係を予測するタスクを提案しました。

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-12 13:16:211089ブラウズ

もう 2022 年ですが、現在のコンピューター ビジョン タスクのほとんどは依然として画像認識のみに焦点を当てています。たとえば、画像分類タスクでは、モデルが画像内のオブジェクト カテゴリを識別することだけが必要です。ターゲット検出や画像セグメンテーションなどのタスクではさらにオブジェクトの位置を見つける必要がありますが、そのようなタスクはモデルがシーンを包括的かつ深く理解していることを実証するにはまだ十分ではありません。

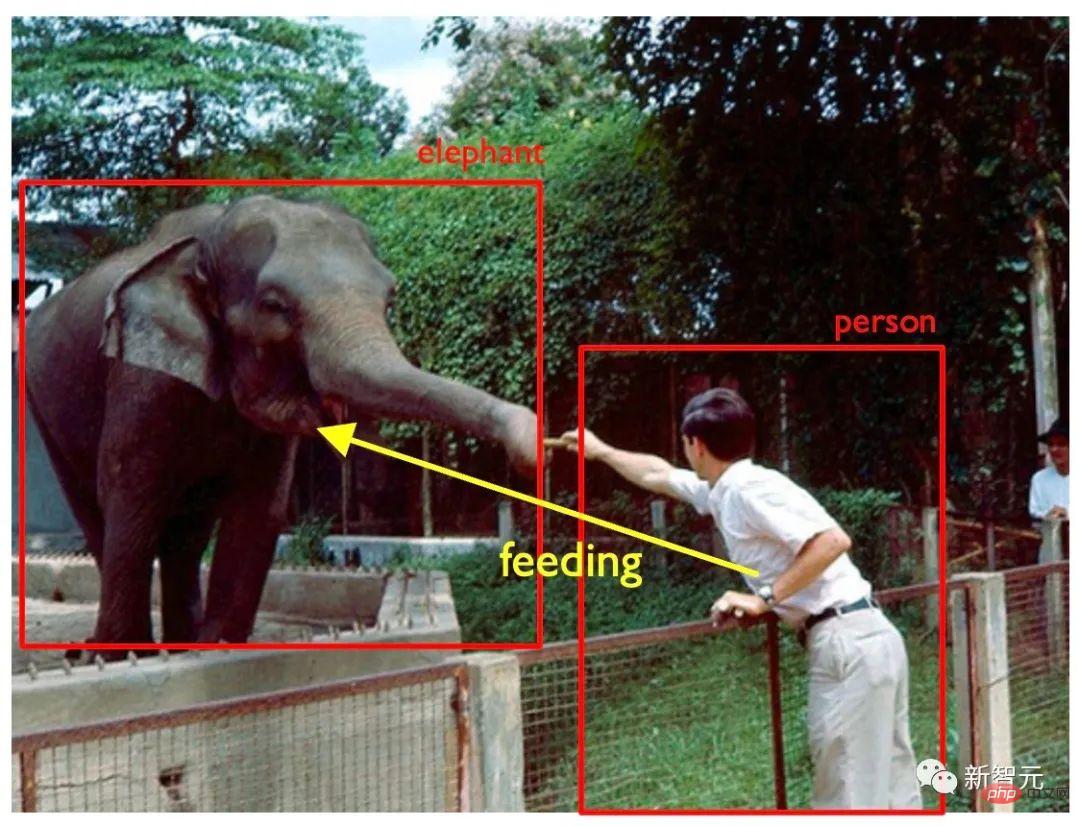

次の図 1 は例です。コンピューター ビジョン モデルが写真内の人、象、フェンス、木などのみを検出する場合、通常、モデルが検出しているとは考えられません。モデルは状況を理解しましたが、「餌を与えない」という警告を発するなど、理解に基づいてより高度な決定を下すこともできません。

図 1: 元の図例

実際には、知恵として都市、自動運転、スマート製造などの現実世界の AI シナリオの多くでは、シーン内のターゲットの位置を特定することに加えて、通常、モデルが画像内のさまざまな被写体間の関係を推論して予測することも期待されます。たとえば、自動運転アプリケーションでは、自動運転車は、道端の歩行者がカートを押しているのか、自転車に乗っているのかを分析する必要があります。状況に応じて、対応するその後の決定が異なる場合があります。

スマートファクトリーのシナリオでは、オペレーターが安全かつ正しく稼働しているかどうかを判断するには、監視側モデルにも被験者間の関係を理解する能力が必要です。既存のメソッドのほとんどは、いくつかのハードコーディングされたルールを手動で設定します。このため、モデルには一般化が欠けており、他の特定の状況に適応することが困難になります。

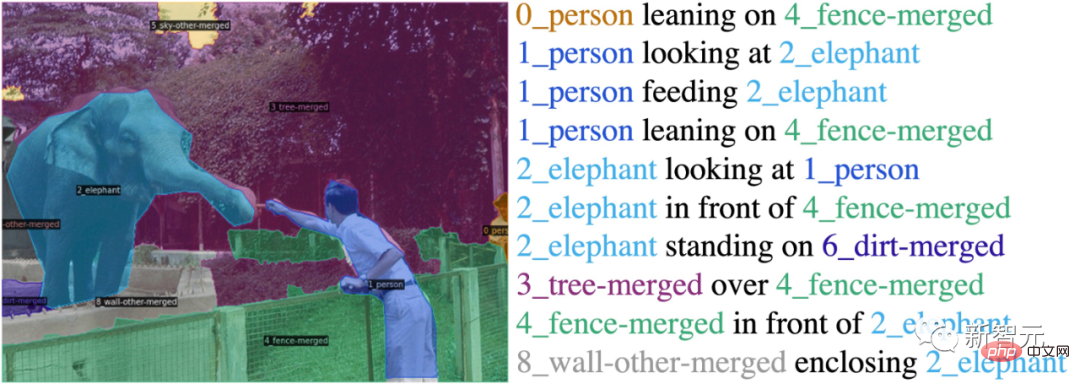

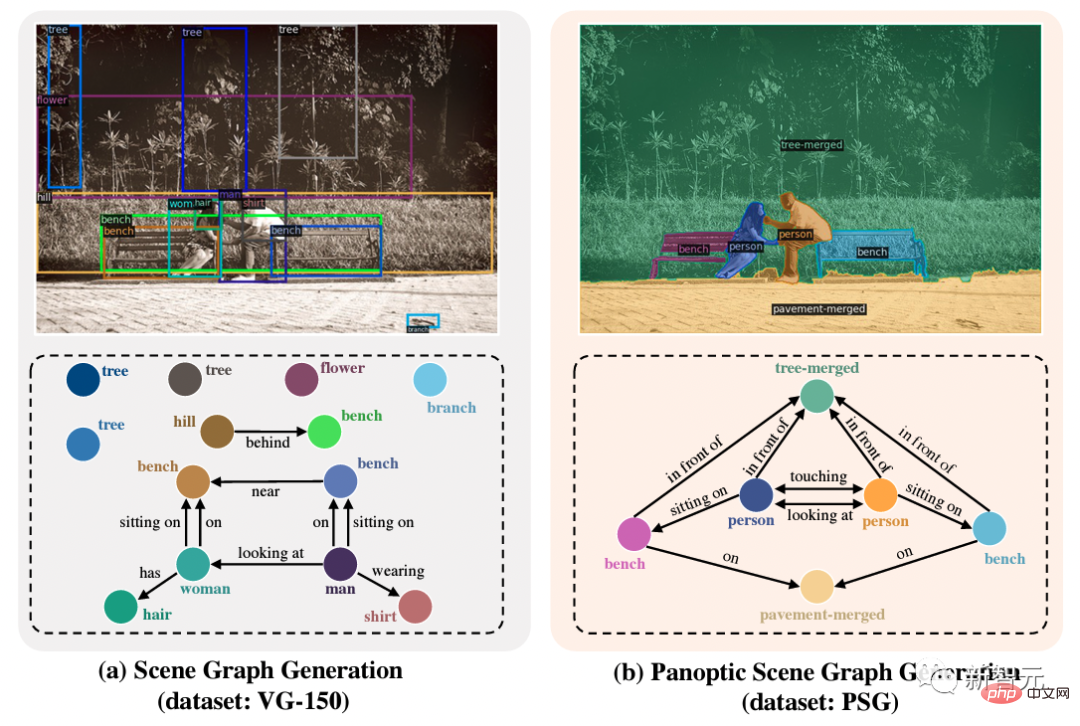

シーン グラフ生成タスク (シーン グラフ生成、または SGG) は、上記の問題を解決するように設計されています。 SGG タスクでは、ターゲット オブジェクトを分類して位置を特定するための要件に加えて、オブジェクト間の関係を予測するためのモデルも必要です (図 2 を参照)。

#図 2: シーン グラフの生成

従来のシーン グラフ生成タスクデータセットには通常、オブジェクトの境界ボックス アノテーションと、境界ボックス間の関係のアノテーションが含まれます。ただし、この設定にはいくつかの固有の欠陥があります:(1) 境界ボックスはオブジェクトを正確に特定できません: 図 2 に示すように、人物にラベルを付ける場合、境界ボックスは必然的に失敗します。

(2) 背景はマークできません: 図 2 に示すように、象の後ろの木は境界ボックスでマークされており、画像全体がほぼ覆われているため、背景間の関係に正確に注釈を付けることができないため、シーン グラフが画像を完全にカバーして包括的なシーンを理解することも不可能になります。

したがって、著者は、細かく注釈が付けられた大規模な PSG データ セットを使用したフル シーン グラフ生成 (PSG) タスクを提案します。

図 3: フル シーン グラフの生成図 3 に示すように、このタスクではパノラマ セグメンテーションを使用して、包括的かつ正確な結果を実現します。オブジェクトと背景を配置することで、シーン グラフ生成タスクの固有の欠点に対処し、この分野を包括的で深いシーンの理解に向けて前進させます。 論文情報

論文リンク: https://arxiv.org/abs/2207.11247プロジェクトページ: https ://psgdataset.org/OpenPSG コードベース: https://github.com/Jingkang50/OpenPSGCompetition リンク: https://www.cvmart.net/race/10349/baseECCV'22 SenseHuman ワークショップ リンク: https://sense- human.github.io/HuggingFace デモリンク: https://huggingface.co/spaces/ECCV2022/PSG 著者が提案した PSG データ セットには、ココの約 50,000 枚の画像が含まれており、セグメント化されたブロック間の関係をマークするココの既存のパノラマ セグメンテーション アノテーションに基づいています。著者は、位置関係(上、前など)、物体間の共通の関係(ぶら下がっているなど)、共通の生物学的動作(歩く、立つなど)、人間と人間の関係など、56種類の関係を丁寧に定義しています。行動(料理など)、交通シーンでの関係(運転、乗車など)、動作シーンでの関係(蹴りなど)、背景間の関係(囲みなど)。著者は、アノテーターに対し、曖昧な表現ではなくより正確な動詞表現を使用し、図内の関係に可能な限り完全に注釈を付けることを要求しています。 PSG モデル効果の表示##タスクの利点

対照的に、右の図で提案されている PSG タスクは、より包括的 (前景と背景の相互作用を含む)、より明確 (適切なオブジェクトの粒度)、およびより正確 (ピクセル レベルの精度) を提供します。シーンの理解の分野を前進させるためのシーン グラフ表現。 2 つの主要なタイプの PSG モデル

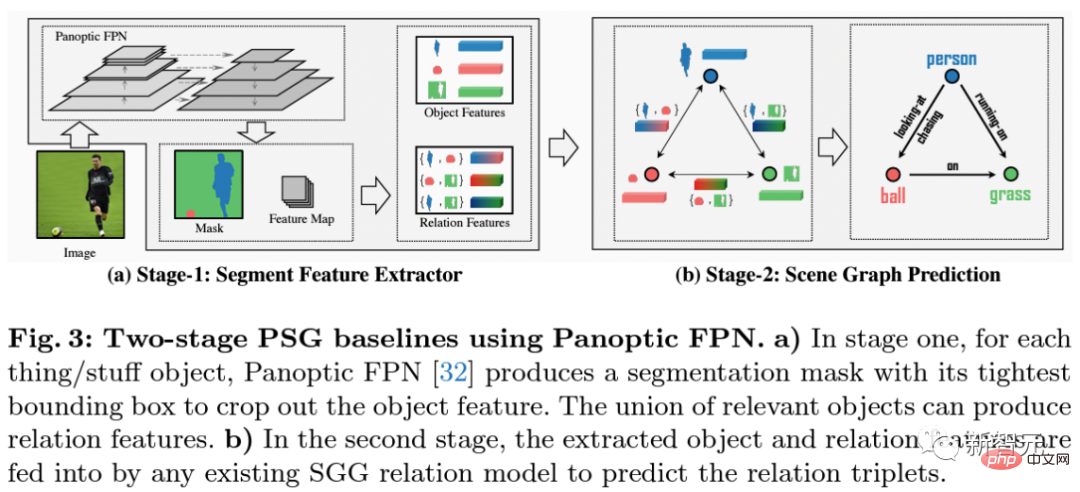

次に、パノラマセグメンテーションによって得られたオブジェクトの特徴と、オブジェクト融合の各ペアの関係の特徴を抽出し、それらを関係予測の次の段階に送ります。このフレームワークは、従来のシーン グラフ生成の古典的な手法である IMP、VCTree、Motifs、および GPSNet を統合して再現しています。

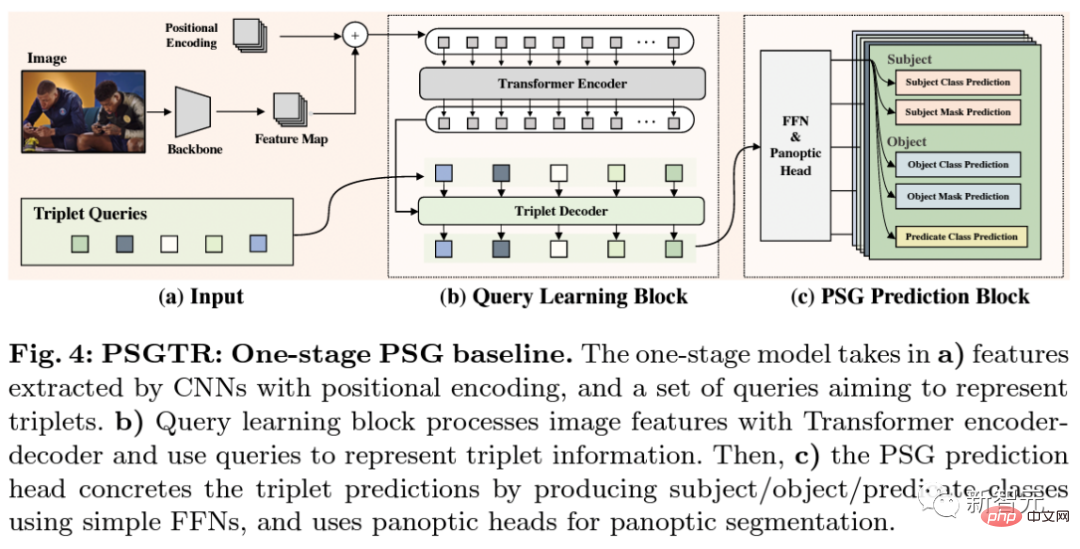

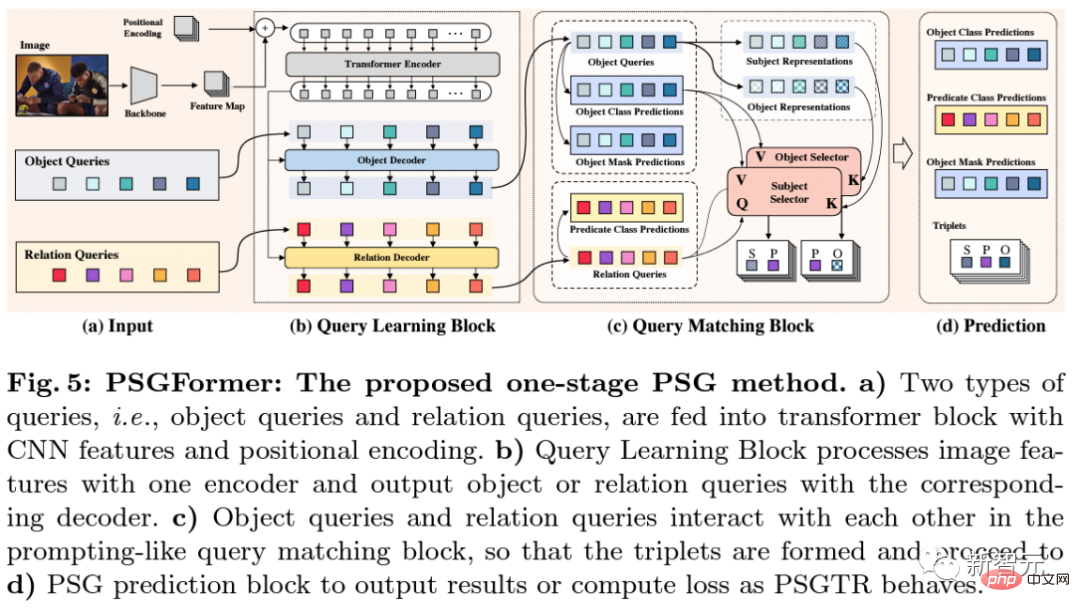

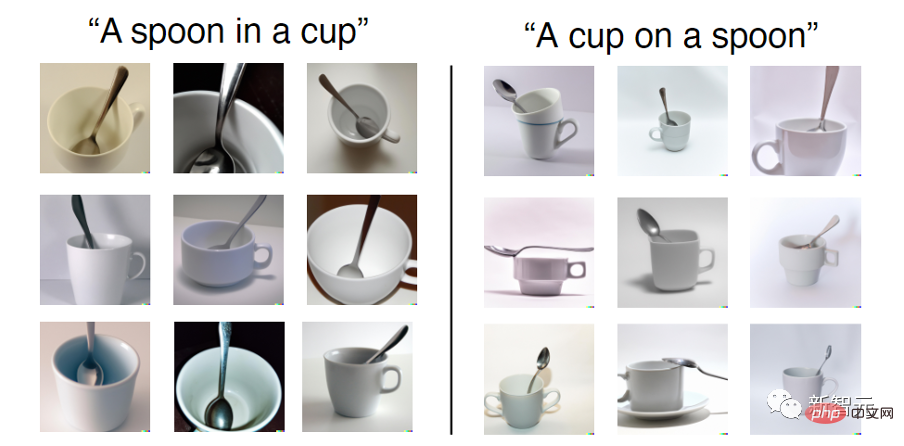

両方のタイプのクエリを学習した後、c) のマッピングを通じて照合して、ペアになったトリプル クエリを取得します。最後に、d) で、オブジェクト クエリと関係クエリに関する予測が予測ヘッドを通じて完了し、c) のマッチング結果に基づいて最終的なトリプル予測結果が得られます。 PSGTR と PSGFormer はどちらも DETR に基づいて拡張および改良されたモデルです。違いは、PSGTR は一連のクエリを使用してトリプルを直接モデル化するのに対し、PSGFormer は 2 つのクエリ セットを使用してオブジェクトと関係モデリングをモデル化することです。各方法には一長一短がありますので、詳しくは論文内の実験結果をご参照ください。 SGG タスクで有効な方法のほとんどは、PSG タスクでも引き続き有効です。ただし、データセットに関する強力な統計的事前分布や、主語、述語、および目的語の述語方向に関する事前分布を利用する一部の方法は、それほど効果的ではない可能性があります。これは、従来の VG データセットに比べて PSG データセットの偏りがそれほど深刻ではなく、述語動詞の定義がより明確で学習しやすいという事実によるものと考えられます。したがって、著者らは、その後の手法が視覚情報の抽出と画像自体の理解に焦点を当てることを望んでいます。統計的事前分布はデータセットのブラッシングに効果的かもしれませんが、必須ではありません。 2 段階モデルと比較して、現在、1 段階モデルの方が優れた結果を達成できます。これは、単一段階モデルの関係に関する監視信号を特徴マップに直接転送できるため、関係信号がより多くのモデル学習に参加し、関係の把握に有益であるためと考えられます。ただし、この記事ではいくつかのベースライン モデルを提案するだけであり、1 段階モデルや 2 段階モデルの最適化を行っていないため、必ずしも 1 段階モデルが 2 段階モデルよりも強いとは言えません。これはまた、出場者が探求を続けることを期待しています。 従来の SGG タスクと比較して、PSG タスクはパノラマ セグメンテーション マップに基づいて関係マッチングを実行し、各関係におけるサブジェクトとオブジェクトの ID の確認を必要とします。オブジェクト ID の分割を完了するためにパノラマ セグメンテーション マップを 2 段階で直接予測するのと比較して、1 段階モデルでは一連の後処理を通じてこのステップを完了する必要があります。既存の単一ステージ モデルがさらに改善およびアップグレードされた場合、単一ステージ モデルでオブジェクト ID の確認をより効果的に完了し、より優れたパノラマ セグメンテーション画像を生成する方法は、引き続き検討する価値のあるトピックです。 最後に、みなさんもぜひ HuggingFace を試してみてください: デモ: https:/ /huggingface .co/spaces/ECCV2022/PSG 最近人気のあるテキスト入力ベースの生成モデル (DALL-E 2 など) ) これは本当に驚くべきことですが、一部の研究によると、これらの生成モデルは、テキスト内で表現されている空間的関係さえ理解せずに、テキスト内の複数のエンティティを単に貼り合わせているだけである可能性があります。以下に示すように、入力は「カップにスプーン」ですが、生成された画像は「スプーンにカップ」のままです。 偶然にも、PSG データ セットにはマスク ベースのシーン グラフ関係がマークされています。作成者は、シーン グラフとパノラマ セグメンテーション マスクをトレーニング ペアとして使用して text2mask モデルを取得し、マスクに基づいてより詳細な画像を生成できます。したがって、PSG データセットは、関係に焦点を当てた画像生成のための潜在的なソリューションも提供する可能性があります。 追伸: この分野で包括的なシーン認識を共同で研究することを奨励することを目的とした「PSG チャレンジ」が本格化しています。何百万もの賞品があなたを待っています!競争リンク: https://www.cvmart.net/race/10349/base

結論の共有

画像生成に関する視点

以上がNanyang Polytechnic は、完全なシーン グラフから PSG を生成し、ピクセル レベルでオブジェクトの位置を特定し、56 の関係を予測するタスクを提案しました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。