Maison >Périphériques technologiques >IA >Tueur de production de masse ! P-Mapnet : En utilisant la carte de basse précision SDMap précédente, les performances de cartographie sont violemment améliorées de près de 20 points !

Tueur de production de masse ! P-Mapnet : En utilisant la carte de basse précision SDMap précédente, les performances de cartographie sont violemment améliorées de près de 20 points !

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2024-03-28 14:36:34846parcourir

Écrit avant

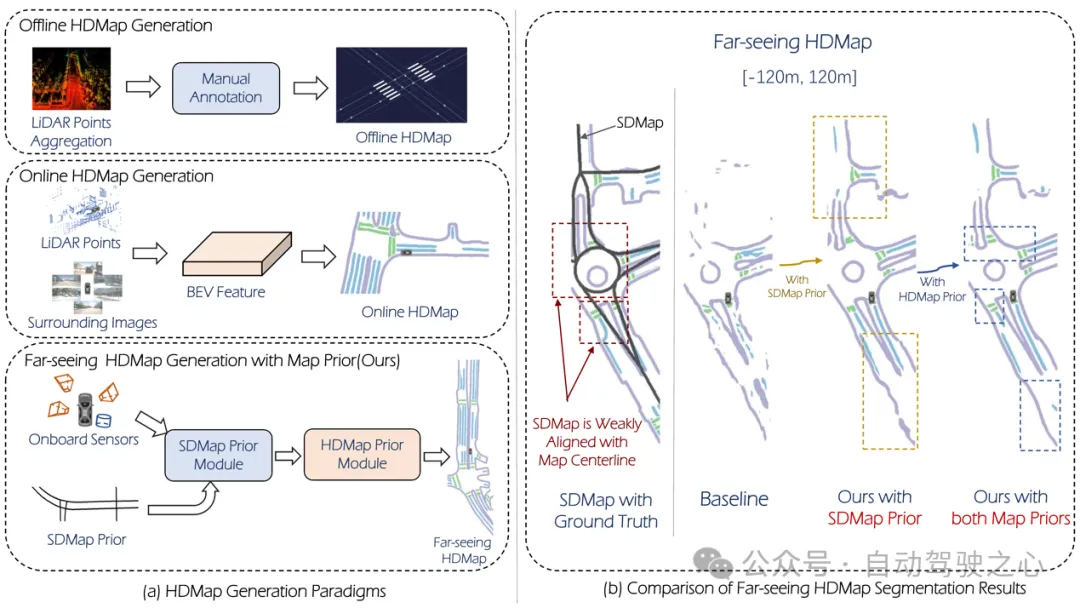

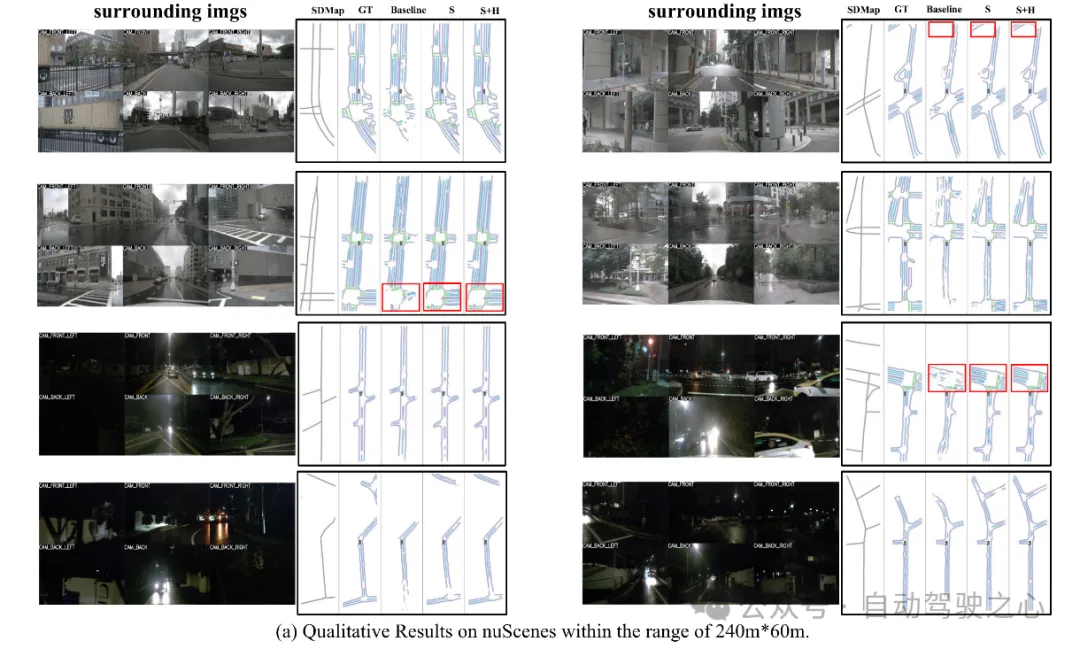

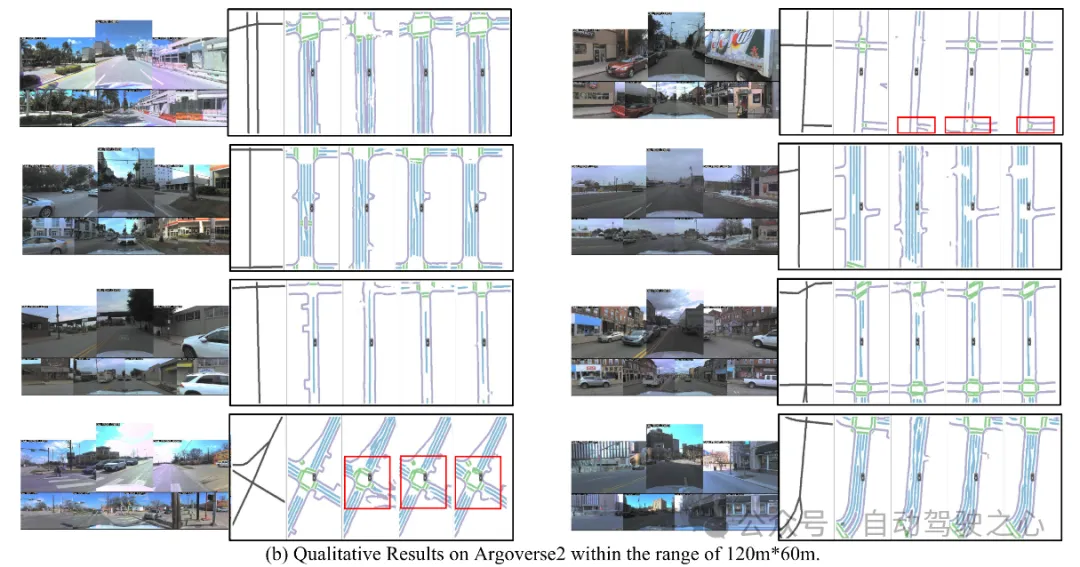

L'un des algorithmes utilisés par le système de conduite autonome actuel pour se débarrasser de sa dépendance aux cartes de haute précision est de profiter du fait que les performances de perception sur de longues distances sont encore médiocres. À cette fin, nous proposons P-MapNet, où le « P » se concentre sur la fusion des cartes a priori pour améliorer les performances du modèle. Plus précisément, nous exploitons les informations préalables dans SDMap et HDMap : d'une part, nous extrayons les données SDMap faiblement alignées d'OpenStreetMap et les encodons en termes indépendants pour prendre en charge l'entrée. Il existe un problème de faible alignement entre l'entrée strictement modifiée et la HD+Map réelle. Notre structure basée sur le mécanisme Cross-attention peut se concentrer de manière adaptative sur le squelette SDMap et apporter des améliorations significatives des performances. Par contre, nous proposons une méthode utilisant ; MAE Pour capturer le module d'affinement de la distribution précédente de HDMap, ce module permet de générer une distribution plus cohérente avec la carte réelle et permet de réduire les effets d'occlusion, d'artefacts, etc. Nous effectuons une validation expérimentale approfondie sur les ensembles de données nuScenes et Argoverse2.

Figure 1

Figure 1

En résumé, nos contributions sont les suivantes :

Notre SDMap avancé peut améliorer les performances de génération de cartes en ligne, y compris la rastérisation (jusqu'à 18,73 mIoU) et la quantification (jusqu'à 8,50 mAP). Deux représentations cartographiques.

(2) Notre HDMap prior peut améliorer l'indice de connaissance de la carte jusqu'à 6,34 %.

(3) P-MapNet peut passer à différents modes d'inférence pour trouver un compromis entre précision et efficacité.

P-MapNet est une solution de génération de cartes HD+ longue distance, qui peut apporter une plus grande amélioration à la plage de détection la plus éloignée. Notre code et notre modèle ont été rendus publics sur https://jike5.github.io/P-MapNet/.

Examen des travaux connexes

(1)Génération de cartes en ligne

La production de cartes HD+ comprend principalement la cartographie SLAM, l'étiquetage automatique, l'étiquetage manuel et d'autres étapes. Cela se traduit par le coût élevé et la fraîcheur limitée de HD+Map. La génération de cartes en ligne est donc cruciale pour les systèmes de conduite autonome. HDMapNet exprime les éléments cartographiques via un maillage et utilise des méthodes de prédiction et de post-traitement par pixel pour obtenir des résultats de prédiction vectorisés. Certaines méthodes récentes, telles que MapTR, PivotNet, Streammapnet, etc., implémentent une prédiction vectorisée de bout en bout basée sur l'architecture Transformer. Cependant, ces méthodes n'utilisent que les entrées de capteurs et leurs performances sont encore limitées dans des environnements complexes tels que l'occlusion. et des conditions météorologiques extrêmes.

(2)Perception cartographique longue distance

Afin de mieux utiliser les résultats générés par les cartes en ligne par les modules en aval, certaines recherches tentent d'élargir davantage la portée de la perception cartographique. SuperFusion[7] permet une prévision longue distance de 90 m en fusionnant le lidar et les caméras et en utilisant la transformation BEV sensible à la profondeur. NeuralMapPrior[8] améliore la qualité des observations en ligne actuelles et élargit la portée de la perception en maintenant et en mettant à jour les priorités de la carte neuronale globale. [6] obtient les caractéristiques du BEV en agrégeant des images satellite et des données de capteurs de véhicules, et les prédit davantage. MV-Map se concentre sur la génération de cartes longue distance hors ligne. Cette méthode optimise les fonctionnalités BEV en agrégeant toutes les fonctionnalités de trame associées et en utilisant des champs de rayonnement neuronal.

Aperçu de P-MapNet

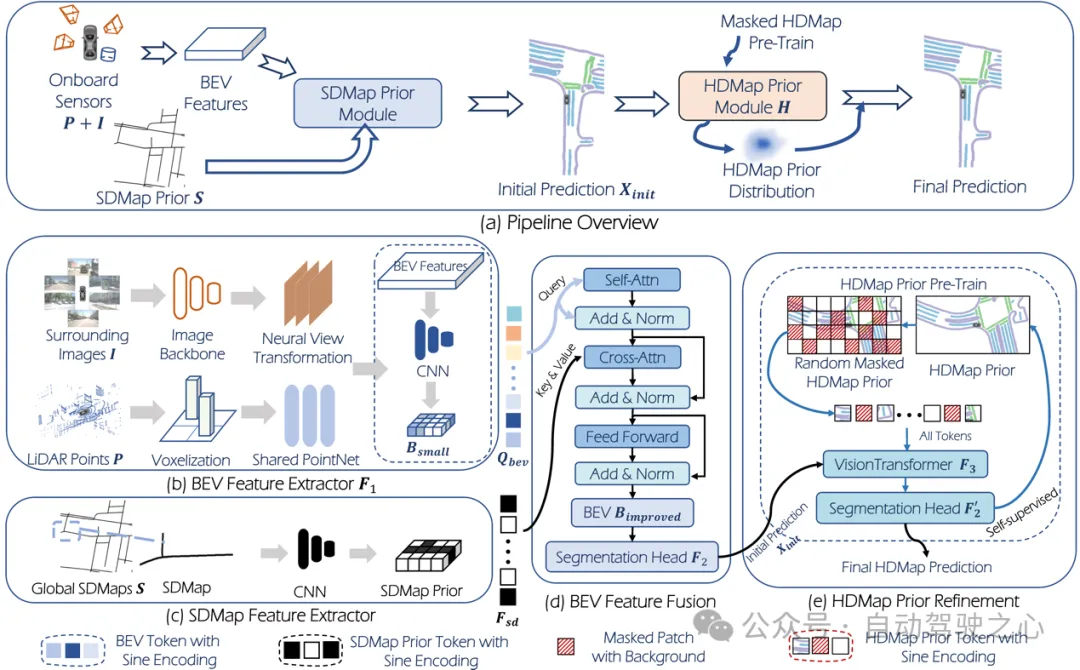

Le cadre global est présenté dans la figure 2.

Figure 2

Figure 2

Entrée : L'entrée du système est un nuage de points : , caméra surround :, où est le nombre de caméras surround. Une tâche de génération HDMap courante (telle que HDMapNet) peut être définie comme :

où représente l'extraction de fonctionnalités, représente la tête de segmentation et est le résultat de la prédiction de HDMap.

Le P-MapNet que nous avons proposé combine les a priori SD Map et HD Map. Cette nouvelle tâche ( setting) peut être exprimée comme suit :

où, représente l'a priori SDMap, représente celui proposé dans le raffinement de cet article. module. Le module apprend la distribution de cartes HD au préalable grâce à une pré-formation. De même, en utilisant uniquement SDMap auparavant, nous obtenons paramètre uniquement :

Sortie : Pour les tâches de génération de carte, il existe généralement deux représentations cartographiques : la rastérisation et la vectorisation. Dans la recherche de cet article, étant donné que les deux modules a priori conçus dans cet article sont plus adaptés à une sortie rastérisée, nous nous concentrons principalement sur la représentation rastérisée.

3.1 Module SDMap Prior

Génération de données SDMap

Cet article effectue des recherches basées sur les ensembles de données nuScenes et Argoverse2, utilise les données OpenStreetMap pour générer des données SD Map pour les zones correspondantes des ensembles de données ci-dessus et effectue des coordonnées Transformation du système via le GPS du véhicule. Pour obtenir la carte SD de la zone correspondante.

Requête BEV

Comme le montre la figure 2, nous effectuons d'abord l'extraction de caractéristiques et la conversion de perspective sur les données d'image et l'extraction de caractéristiques sur le nuage de points pour obtenir les caractéristiques BEV. Ensuite, les fonctionnalités BEV sont sous-échantillonnées via le réseau convolutif pour obtenir les nouvelles fonctionnalités BEV :, et la carte des fonctionnalités est aplatie pour obtenir la requête BEV.

Fusion préalable de la carte SD

Pour les données SD Map, après extraction des caractéristiques via le réseau convolutif, les caractéristiques obtenues Mécanisme d'attention croisée avec requête BEV :

BEV obtenu après le mécanisme d'attention croisée Les caractéristiques sont transmises la tête de segmentation pour obtenir des prédictions initiales des éléments de la carte.

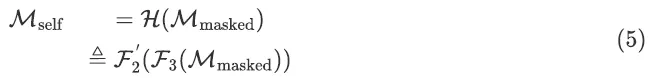

3.2. Le module HDMap Prior

utilise directement la carte HD rastérisée comme entrée du MAE d'origine. Le MAE sera entraîné via MSE Loss, ce qui le rend incapable d'être utilisé comme module de raffinement. Ainsi, dans cet article, nous remplaçons la sortie de MAE par notre tête de segmentation. Afin de garantir la continuité et l'authenticité des éléments cartographiques prédits (plus proches de la distribution de la carte HD réelle), nous utilisons un module MAE pré-entraîné pour le raffinement. La formation de ce module se compose de deux étapes : la première étape consiste à utiliser l'apprentissage auto-supervisé pour entraîner le module MAE à apprendre la distribution de HD Map, et la deuxième étape consiste à affiner tous les modules du réseau en utilisant les poids obtenus. dans la première étape comme poids initiaux.

Dans la première étape de la pré-formation, la véritable carte HD obtenue à partir de l'ensemble de données est masquée de manière aléatoire et utilisée comme entrée réseau , et l'objectif de la formation est de compléter la carte HD :

Dans la seconde étape de réglage fin, Les poids pré-entraînés dans la première étape sont utilisés comme poids initiaux. Le réseau complet est :

Expérience

4.1 Ensembles de données et indicateurs

. Nous l'effectuons sur deux ensembles de données grand public examinés : nuScenes et Argoverse2. Afin de prouver l'efficacité de notre méthode proposée à longue distance, nous l'avons fixée à trois distances de détection différentes :, . Parmi eux, la résolution de BEV Grid dans la plage est de 0,15 m et la résolution dans les deux autres plages est de 0,3 m. Nous utilisons la métrique mIOU pour évaluer les résultats de prédiction rastérisés et mAP pour évaluer les résultats de prédiction vectorisés. Pour évaluer l'authenticité de la carte, nous utilisons également la métrique LPIPS comme métrique de connaissance de la carte.

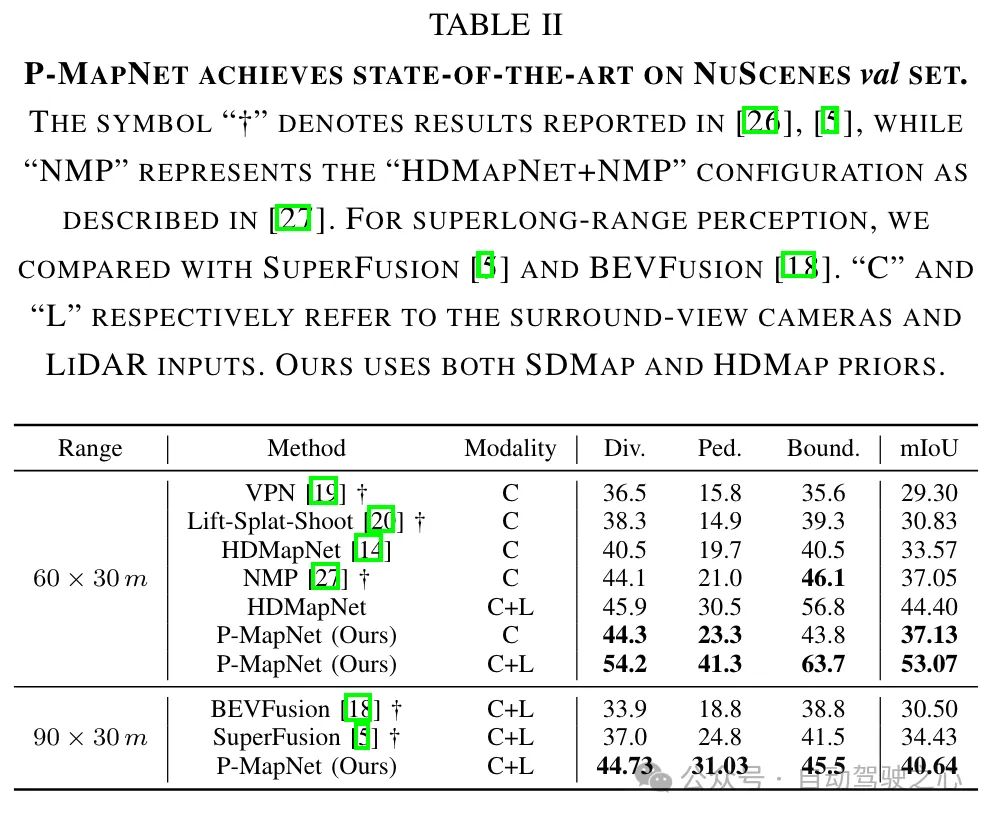

4.2 Résultats

Comparaison avec les résultats SOTA : Nous comparons les résultats de génération de cartes de la méthode proposée et de la méthode SOTA actuelle à courte distance (60m × 30m) et longue distance (90m × 30m). Comme le montre le tableau II, notre méthode présente des performances supérieures par rapport aux méthodes existantes de vision uniquement et multimodales (RVB + LiDAR).

présente une plus grande amélioration que celui dans le paramètre uniquement.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Une analyse approfondie des solutions technologiques de conduite autonome de Tesla

- L'amertume et l'impuissance de l'annotateur autonome : 20 centimes pour dessiner une boîte, un salaire mensuel de 3 000 yuans

- Un article pour comprendre la perception lidar et fusion visuelle de la conduite autonome

- Réaliste, contrôlable et évolutive, la plateforme de simulation d'éclairage de conduite autonome LightSim vient d'être lancée

- ADMap : une nouvelle idée pour des cartes en ligne de haute précision anti-interférences