Maison >Périphériques technologiques >IA >文生图的基石CLIP模型的发展综述

文生图的基石CLIP模型的发展综述

- 王林avant

- 2024-03-22 20:50:221321parcourir

CLIP signifie Contrastive Language-Image Pre-training, qui est une méthode ou un modèle de pré-entraînement basé sur des paires texte-image contrastées. Il s'agit d'un modèle multimodal qui repose sur l'apprentissage contrastif. paires d'images, où une image est associée à sa description textuelle correspondante. Grâce à l'apprentissage contrastif, le modèle vise à comprendre la relation entre les paires de texte et d'images

Open AI a publié DALL-E et CLIP, les deux modèles sont multi. -modèles modaux capables de combiner des images et du texte. DALL-E est un modèle qui génère des images basées sur du texte, tandis que CLIP utilise le texte comme signal de supervision pour former un modèle visuel transférable.

Dans le modèle de diffusion stable, les caractéristiques de texte extraites par l'encodeur de texte CLIP sont intégrées dans l'UNet du modèle de diffusion grâce à une attention croisée. Plus précisément, les fonctionnalités de texte sont utilisées comme clé et valeur d'attention, tandis que les fonctionnalités UNet sont utilisées comme requête. En d’autres termes, CLIP est en fait un pont clé entre le texte et les images, combinant de manière organique les informations textuelles et les informations image. Cette combinaison permet au modèle de mieux comprendre et traiter les informations entre différentes modalités, obtenant ainsi de meilleurs résultats lors du traitement de tâches complexes. De cette manière, le modèle de diffusion stable peut utiliser plus efficacement les capacités de codage de texte de CLIP, améliorant ainsi les performances globales et élargissant les domaines d'application.

CLIP

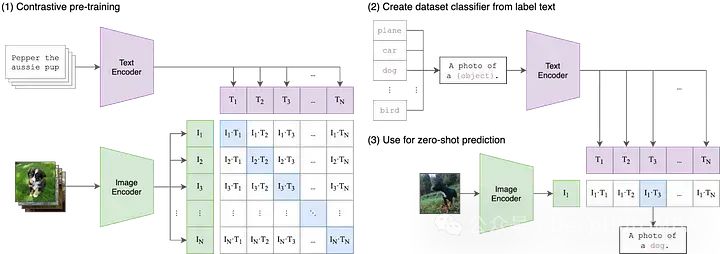

Il s'agit du premier article publié par OpenAI en 2021. Pour comprendre CLIP, nous devons déconstruire l'acronyme en trois composants : (1) Contraste, (2) Langage -Image, ( 3) Pré-formation.

Commençons par Langage-Image.

Dans les modèles d'apprentissage automatique traditionnels, une seule modalité de données d'entrée peut généralement être acceptée, comme du texte, des images, des données tabulaires ou de l'audio. Si vous devez utiliser des données provenant de différentes modalités pour effectuer des prédictions, vous devez entraîner plusieurs modèles différents. Dans CLIP, « Langue-Image » signifie que le modèle peut accepter à la fois des données d'entrée de texte (langue) et d'image. Cette conception permet à CLIP de traiter les informations de différentes modalités de manière plus flexible, améliorant ainsi ses capacités prédictives et sa portée d'application.

CLIP gère la saisie de texte et d'image en utilisant deux encodeurs différents, à savoir l'encodeur de texte et l'encodeur d'image. Ces deux encodeurs mappent les données d'entrée dans un espace latent de dimension inférieure, générant des vecteurs d'intégration correspondants pour chaque entrée. Un détail important est que les encodeurs de texte et d'image intègrent les données dans le même espace, c'est-à-dire que l'espace CLIP d'origine est un espace vectoriel à 512 dimensions. Cette conception permet une comparaison et une correspondance directes entre le texte et les images sans conversion ni traitement supplémentaire. De cette manière, CLIP peut représenter des descriptions de texte et le contenu d'images dans le même espace vectoriel, permettant ainsi des fonctions d'alignement sémantique et de récupération multimodales. La conception de cet espace d'intégration partagé confère à CLIP de meilleures capacités de généralisation et d'adaptabilité, lui permettant de bien fonctionner sur une variété de tâches et d'ensembles de données.

Contrastive

Bien que l'intégration de données de texte et d'image dans le même espace vectoriel puisse être un point de départ utile, le simple fait de cela ne garantit pas que le modèle puisse comparer efficacement la représentation du texte et des images. Par exemple, il est important d’établir une relation raisonnable et interprétable entre l’intégration de « chien » ou « une image de chien » dans un texte et l’intégration d’une image de chien. Il nous faut cependant trouver un moyen de combler le fossé entre ces deux modèles.

Dans l'apprentissage automatique multimodal, il existe différentes techniques pour aligner deux modalités, mais actuellement la méthode la plus populaire est le contraste. Les techniques contrastives prennent des paires d'entrées de deux modalités : disons une image et sa légende et entraînent les deux encodeurs du modèle pour représenter ces paires de données d'entrée aussi fidèlement que possible. Dans le même temps, le modèle est incité à prendre des entrées non appariées (telles que des images de chiens et le texte « photos de voitures ») et à les représenter aussi loin que possible. CLIP n'est pas la première technique d'apprentissage contrastif d'images et de texte, mais sa simplicité et son efficacité en ont fait un pilier des applications multimodales.

Pré-formation

Bien que CLIP lui-même soit utile pour des applications telles que la classification sans tir, la recherche sémantique et l'exploration de données non supervisée, CLIP est également utilisé comme élément de base pour un grand nombre de multi- applications modales, de la diffusion stable et DALL-E à StyleCLIP et OWL-ViT. Pour la plupart de ces applications en aval, le modèle CLIP initial est considéré comme le point de départ de la « pré-formation » et l'ensemble du modèle est affiné pour son nouveau cas d'utilisation.

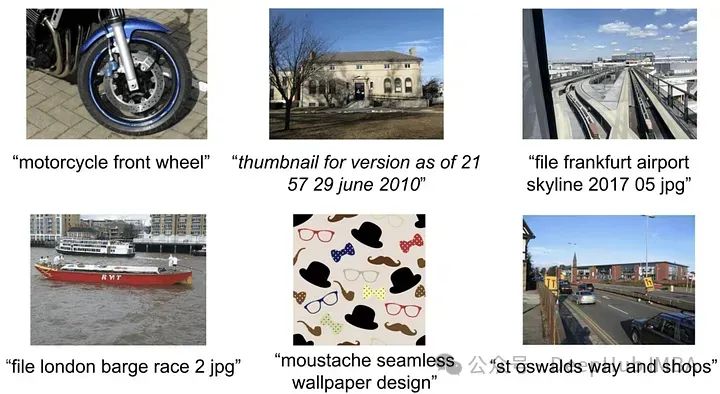

Bien qu'OpenAI n'ait jamais explicitement spécifié ni partagé les données utilisées pour entraîner le modèle CLIP d'origine, l'article CLIP mentionne que le modèle a été formé sur 400 millions de paires image-texte collectées sur Internet.

https://www.php.cn/link/7c1bbdaebec5e20e91db1fe61221228f

ALIGN : améliorer l'apprentissage de la représentation visuelle et visuelle avec une supervision de texte bruyante

Grâce à CLIP, OpenAI utilise 4 milliards des paires image-texte Aucun détail n’étant fourni, il est impossible de savoir exactement comment l’ensemble de données a été construit. Mais pour décrire le nouvel ensemble de données, ils se sont inspirés des légendes conceptuelles de Google - un ensemble de données relativement petit (3,3 millions de paires image-légende) qui utilise des techniques de filtrage et de post-traitement coûteuses, bien que la technologie soit puissante, mais pas particulièrement évolutive) .

Les ensembles de données de haute qualité sont donc devenus la direction de la recherche. Peu de temps après CLIP, ALIGN a résolu ce problème grâce au filtrage à grande échelle. ALIGN ne s'appuie pas sur de petits ensembles de données de sous-titres d'images soigneusement annotés et organisés, mais exploite plutôt 1,8 milliard de paires d'images et de texte alternatif.

Bien que ces descriptions de texte alternatif soient en moyenne beaucoup plus bruyantes que les titres, la taille même de l'ensemble de données compense largement cela. Les auteurs ont utilisé un filtrage de base pour supprimer les doublons, les images contenant plus de 1 000 textes alternatifs pertinents, ainsi que les textes alternatifs non informatifs (soit trop courants, soit contenant des balises rares). Avec ces étapes simples, ALIGN atteint ou dépasse l'état de l'art sur diverses tâches de mise à zéro et de réglage fin.

https://arxiv.org/abs/2102.05918

K-LITE : apprentissage de modèles visuels transférables avec des connaissances externes

Comme ALIGN, K-LITE résout également la pré-formation comparative des des paires image-texte de haute qualité pour un nombre limité de problèmes.

K-LITE se concentre sur l'explication des concepts, c'est-à-dire des définitions ou des descriptions en tant que contexte et des concepts inconnus peuvent aider à développer une compréhension globale. Une explication populaire est que lorsque les gens introduisent pour la première fois des termes techniques et un vocabulaire inhabituel, ils les définissent généralement simplement ou utilisent une analogie avec quelque chose que tout le monde connaît !

Pour mettre en œuvre cette approche, des chercheurs de Microsoft et de l'UC Berkeley ont utilisé WordNet et Wiktionary pour améliorer le texte dans des paires image-texte. Pour certains concepts isolés, tels que les étiquettes de classe dans ImageNet, les concepts eux-mêmes sont améliorés, tandis que pour les titres (par exemple de GCC), les expressions nominales les moins courantes sont améliorées. Grâce à ces connaissances structurées supplémentaires, les modèles pré-entraînés montrent des améliorations substantielles sur les tâches d'apprentissage par transfert.

https://arxiv.org/abs/2204.09222

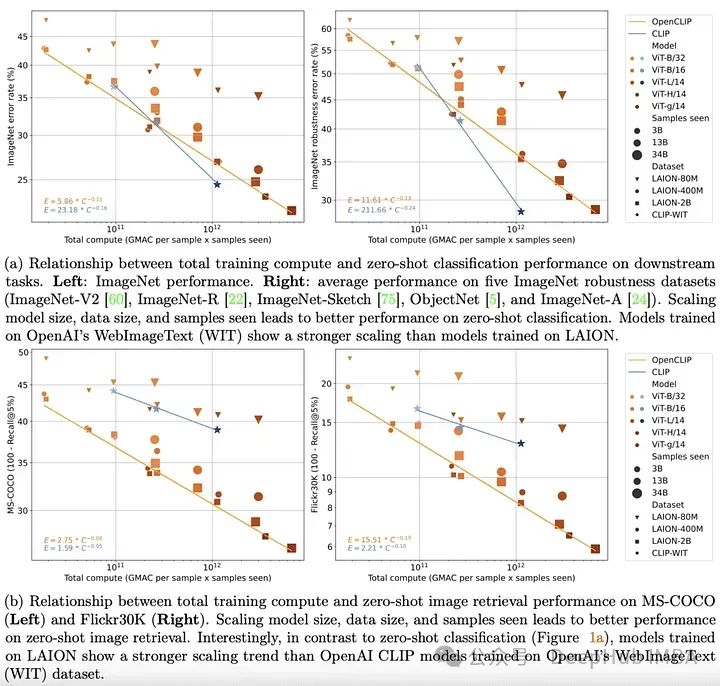

OpenCLIP : lois d'échelle reproductibles pour l'apprentissage contrastif langage-image

D'ici fin 2022, des modèles de transformateur ont été établis dans le texte et domaines visuels. Des travaux empiriques pionniers dans les deux domaines ont également clairement montré que les performances des modèles de transformateur sur des tâches unimodales peuvent être bien décrites par de simples lois d'échelle. Cela signifie qu'à mesure que la quantité de données d'entraînement, le temps d'entraînement ou la taille du modèle augmentent, on peut prédire les performances du modèle avec assez de précision.

OpenCLIP étudie systématiquement les performances des modèles de paires de données d'entraînement dans les tâches de mise à zéro et de réglage fin en étendant la théorie ci-dessus à des scénarios multimodaux en utilisant le plus grand ensemble de données de paires image-texte open source publié à ce jour (5B) Impact . Comme dans le cas unimodal, cette étude révèle que les performances du modèle sur les tâches multimodales évoluent selon une loi de puissance en termes de calcul, de nombre d'échantillons observés et de nombre de paramètres du modèle.

Encore plus intéressante que l'existence de lois de puissance est la relation entre la mise à l'échelle des lois de puissance et les données de pré-entraînement. En conservant l'architecture et la méthode de formation du modèle CLIP d'OpenAI, le modèle OpenCLIP présente des capacités de mise à l'échelle plus fortes sur les tâches de récupération d'images d'échantillons. Pour la classification d'images sans prise de vue sur ImageNet, le modèle d'OpenAI (entraîné sur son ensemble de données propriétaire) a montré des capacités de mise à l'échelle plus fortes. Ces résultats soulignent l’importance des procédures de collecte et de filtrage des données sur les performances en aval.

https://arxiv.org/abs/2212.07143Cependant, peu de temps après la publication d'OpenCLIP, l'ensemble de données LAION a été supprimé d'Internet car il contenait des images illégales.

MetaCLIP : Démystifier les données CLIP

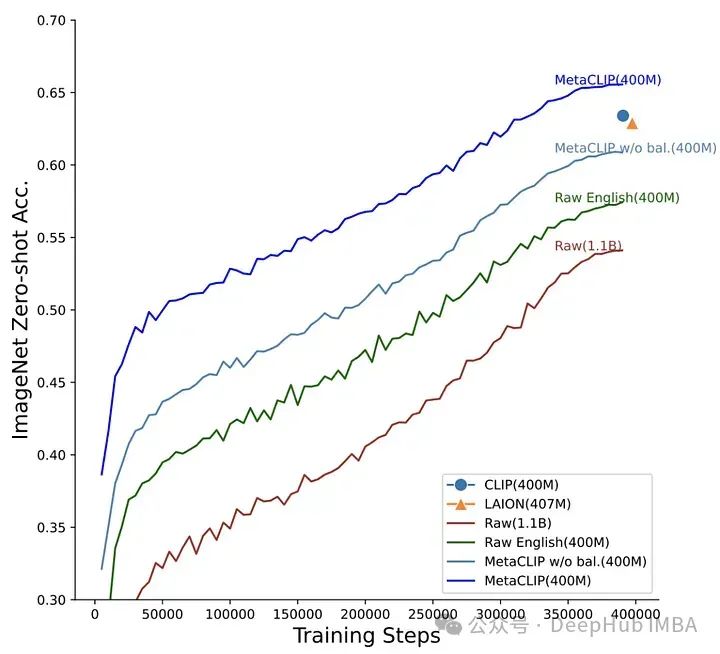

OpenCLIP tente de comprendre comment les performances des tâches en aval changent en fonction de la quantité de données, de l'effort de calcul et du nombre de paramètres du modèle, tandis que MetaCLIP se concentre sur la façon de sélectionner les données. Comme le disent les auteurs : « Nous pensons que le principal facteur de succès de CLIP réside dans ses données, plutôt que dans l'architecture du modèle ou les objectifs de pré-formation.

Pour vérifier cette hypothèse, les auteurs ont corrigé l'architecture du modèle et les étapes de formation. » mené des expériences. L'équipe MetaCLIP a testé diverses stratégies liées à la correspondance des sous-chaînes, au filtrage et à l'équilibrage de la distribution des données, et a constaté que les meilleures performances étaient obtenues lorsque chaque texte apparaissait au maximum 20 000 fois dans l'ensemble de données d'entraînement. Pour tester cette théorie, ils ont testé cette théorie. même Le mot « photo », apparu 54 millions de fois dans le pool de données initial, était également limité à 20 000 paires image-texte dans les données d'entraînement. Grâce à cette stratégie, MetaCLIP a été formé sur 400 millions de paires image-texte de l'ensemble de données Common Crawl, surpassant ainsi le modèle CLIP d'OpenAI sur divers benchmarks.

https://arxiv.org/abs/2309.16671

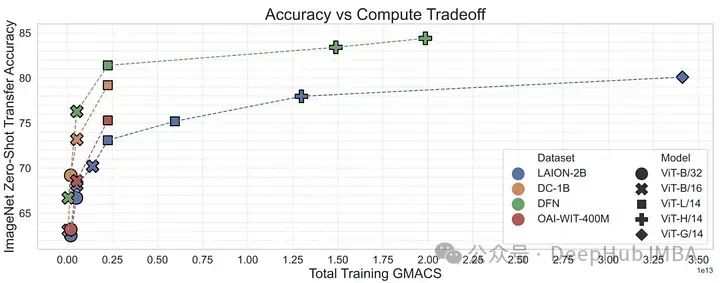

DFN : Data Filtering Networks

Avec la recherche sur MetaCLIP, il peut être démontré que la gestion des données peut être un outil important pour la formation de haut niveau. -des modèles multimodaux performants (tels que CLIP). La stratégie de filtrage de MetaCLIP est très réussie, mais elle repose aussi principalement sur des méthodes heuristiques. Les chercheurs se sont ensuite demandé si un modèle pouvait être formé pour effectuer ce filtrage plus efficacement.

Pour vérifier cela, l'auteur utilise des données de haute qualité du conceptuel 12M pour entraîner le modèle CLIP afin de filtrer les données de haute qualité à partir des données de faible qualité. Ce réseau de filtrage de données (DFN) est utilisé pour créer un ensemble de données plus vaste et de haute qualité en sélectionnant uniquement des données de haute qualité à partir d'un ensemble de données non organisé (dans ce cas, Common Crawl). Les modèles CLIP formés sur des données filtrées ont surpassé les modèles formés uniquement sur des données initiales de haute qualité et les modèles formés sur de grandes quantités de données non filtrées.

https://arxiv.org/abs/2309.17425

Summary

Le modèle CLIP d'OpenAI change considérablement la façon dont nous traitons les données multimodales. Mais CLIP n’est qu’un début. Des données de pré-entraînement aux détails des méthodes d'entraînement et aux fonctions de perte contrastées, la famille CLIP a réalisé des progrès incroyables au cours des dernières années. ALIGN met à l'échelle le texte bruité, K-LITE améliore les connaissances externes, OpenCLIP étudie les lois de mise à l'échelle, MetaCLIP optimise la gestion des données et DFN améliore la qualité des données. Ces modèles approfondissent notre compréhension du rôle de CLIP dans le développement de l’intelligence artificielle multimodale, démontrant les progrès dans la connexion des images et du texte.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Comment connecter myeclipse à Navicat

- Notions de base de Tensorflow (bibliothèque de logiciels open source d'apprentissage automatique)

- Quatre techniques de validation croisée que vous devez apprendre en apprentissage automatique

- Les essentiels du machine learning : comment éviter le surapprentissage ?

- Comment configurer l'apprentissage automatique à l'aide de PyCharm sur les systèmes Linux