Maison >Périphériques technologiques >IA >L'effet de formation d'une puissance de calcul de 40 % est comparable à celui de GPT-4, et les nouvelles réalisations du modèle entrepreneurial commun à grande échelle de DeepMind ont été mesurées.

L'effet de formation d'une puissance de calcul de 40 % est comparable à celui de GPT-4, et les nouvelles réalisations du modèle entrepreneurial commun à grande échelle de DeepMind ont été mesurées.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2024-03-08 15:58:21574parcourir

Dans le concours de grands modèles, un autre cheval noir a émergé -

Inflection-2.5, créé par DeepMind et la startup de grands modèles de Mustafa Suleyman.

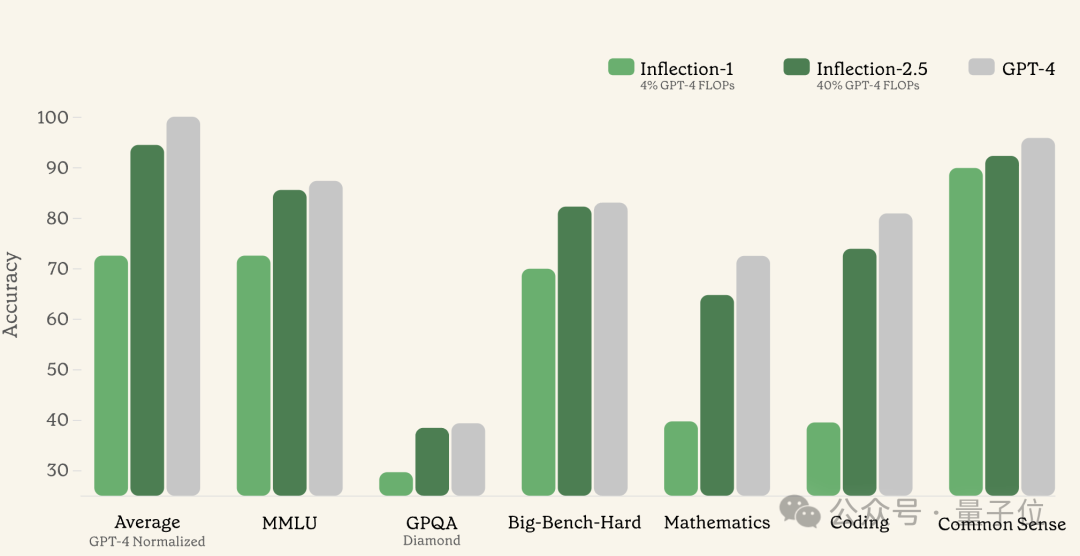

En utilisant seulement 40 % des ressources informatiques pour la formation, les performances dépassent 90 % de GPT-4, et il est particulièrement bon en codage et en mathématiques.

Le premier modèle Inflection ne consommait que 4 % des ressources informatiques pendant la formation, atteignant 72 % des performances de GPT-4.

Sur la base du modèle Inflection, la société a également lancé le robot conversationnel basé sur le Web Pi, qui se concentre sur la « haute intelligence émotionnelle » et la « personnalisation » et prend également en charge le chinois.

Depuis sa création, les utilisateurs actifs quotidiens les plus élevés de Pi ont atteint 1 million, un total de 4 milliards de messages ont été générés et la durée moyenne des conversations a atteint 33 minutes.

Avec cette mise à niveau du modèle de base, Pi a également inauguré sa nouvelle version.

Photos

Photos

Ainsi, que l'Inflexion, ou Pi, soit si forte, les qubits ont effectué des mesures réelles.

Vous pouvez l'utiliser sans vous connecter

Ouvrez la page Pi et vous verrez une interface si minimaliste, et vous pourrez cliquer directement sur Suivant sans vous connecter.

Photos

Photos

Après Next plusieurs fois de suite, entrez la façon dont vous souhaitez que Pi nous appelle.

Photos

Photos

Après cela, sélectionnez la voix et les sujets recommandés, ignorez-les, puis entrez dans l'interface de discussion formelle.

Photos

Photos

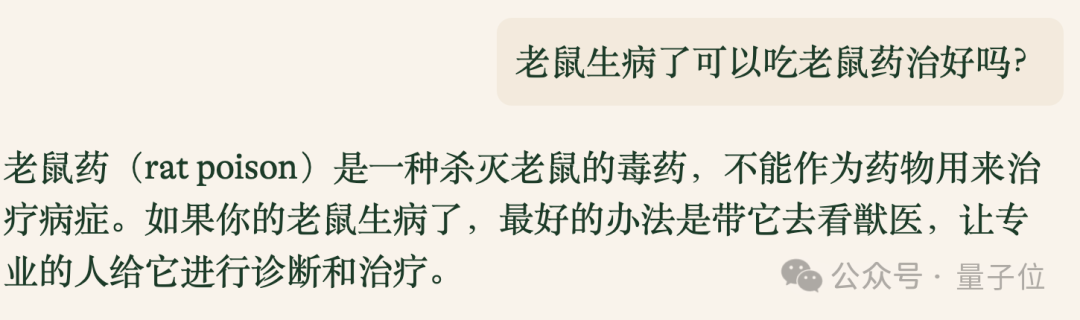

Un test simple a révélé que Pi prend en charge le dialogue chinois. Si tel est le cas, organisez d'abord le benchmark pour les déficients mentaux.

La première question, une souris malade peut-elle être guérie en prenant de la mort-aux-rats ? Pi y a répondu avec succès.

Photos

Photos

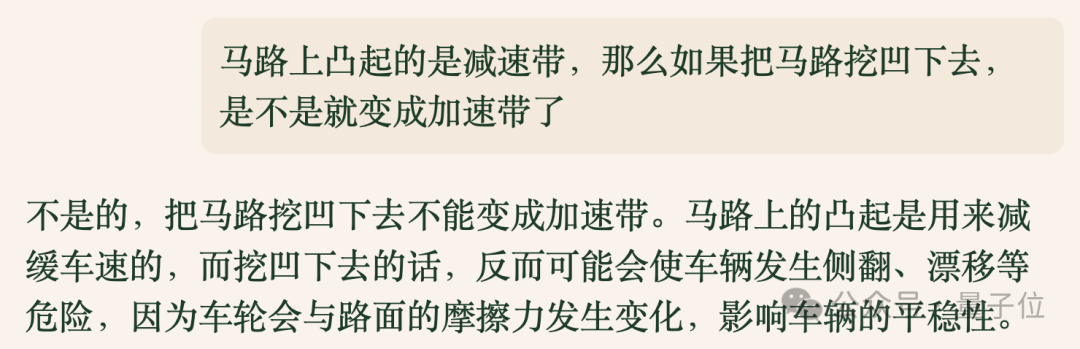

Encore une question « piège », mais je ne suis toujours pas tombée dans le panneau cette fois-ci.

Photos

Photos

Après les deux questions, même s'il n'y a pas eu d'effet dramatique, il semblait que j'avais une certaine compréhension du chinois.

Ensuite, concentrons-nous sur les capacités en mathématiques et en codage pour lesquelles le responsable prétend être « particulièrement bon ».

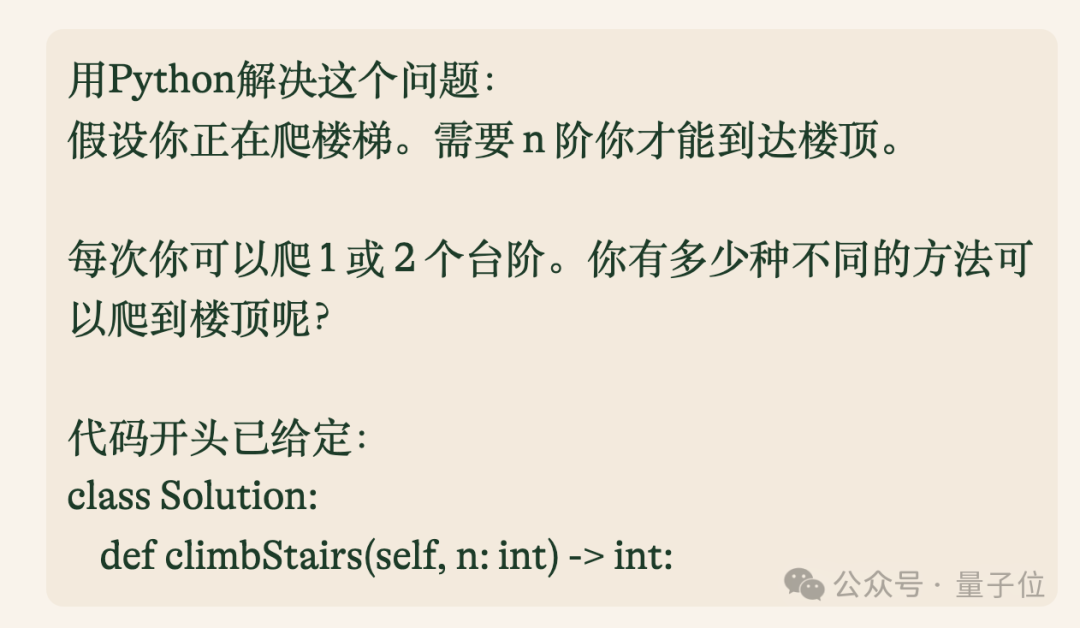

La première est une question de programmation impliquant une programmation dynamique.

Photos

Photos

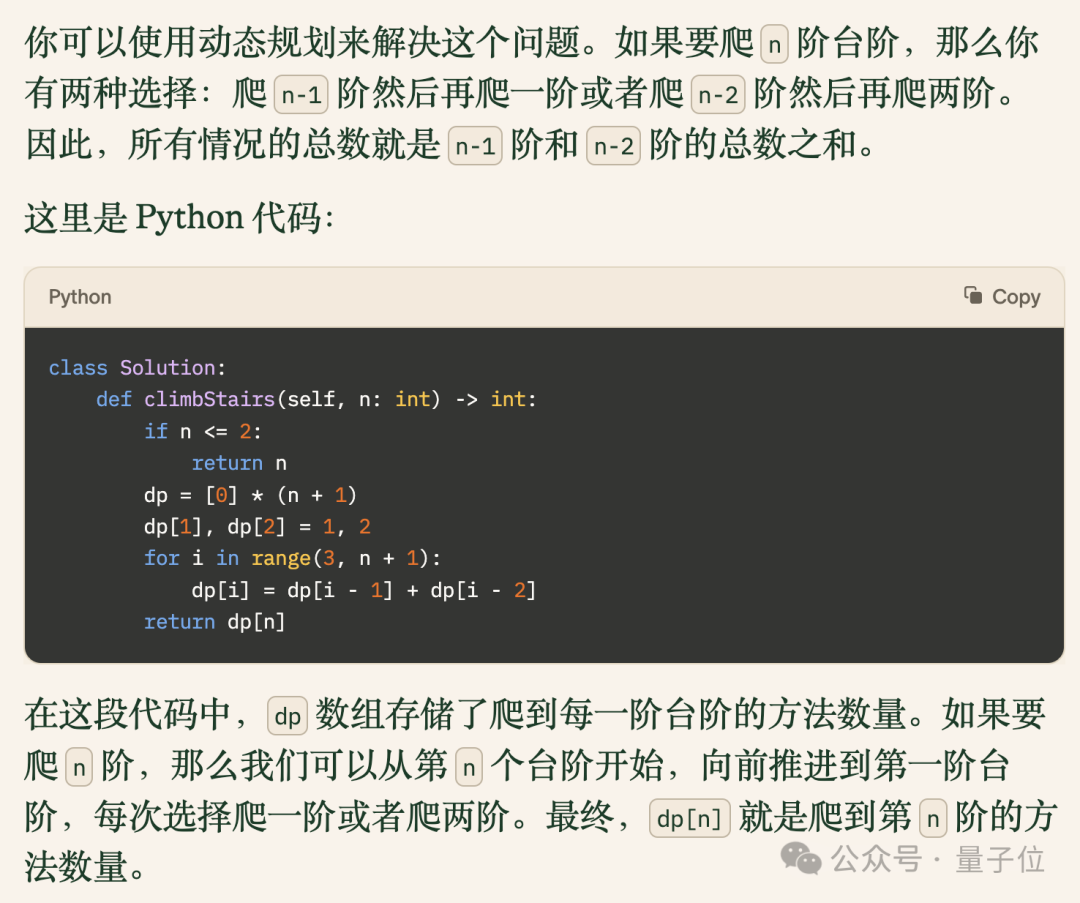

Le code donné par Pi résout ce problème avec succès et est accompagné d'explications claires.

Images

Images

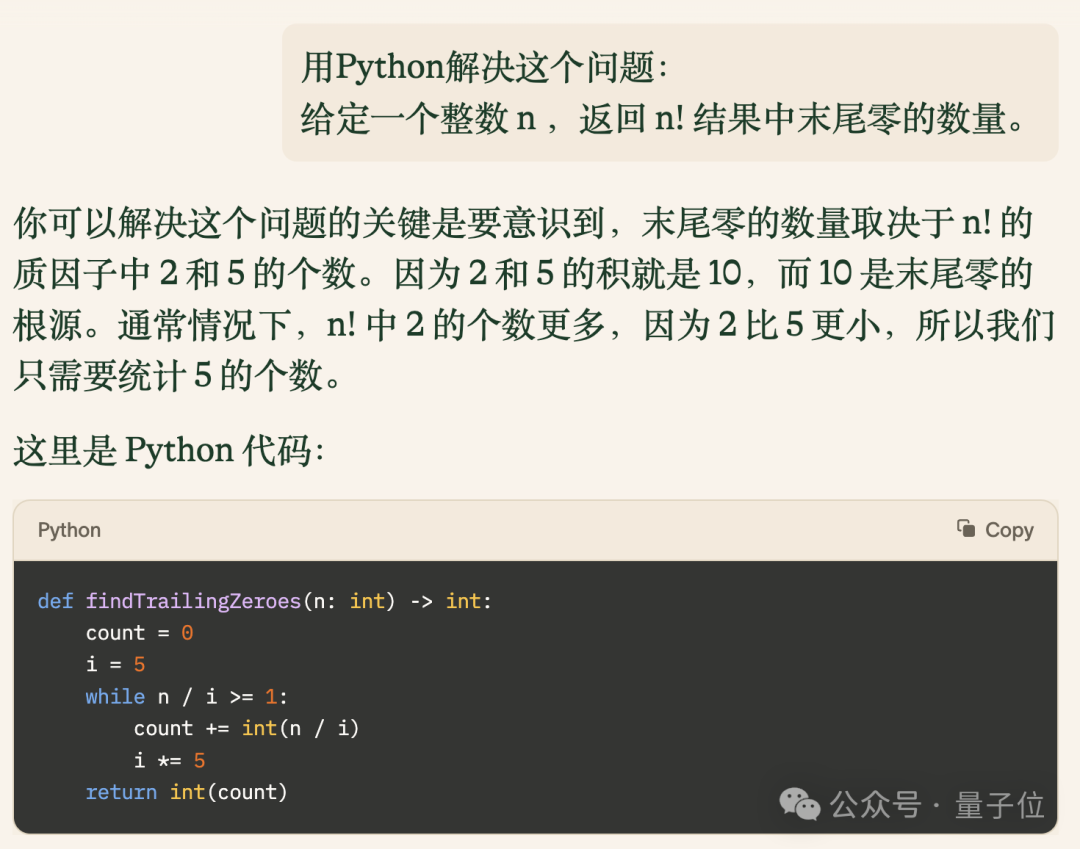

Ensuite, augmentons la difficulté et laissons-la analyser combien de zéros se trouvent à la fin de la factorielle d'un nombre.

Photos

Photos

Le code donné par Pi est non seulement correct, mais aussi concis et efficace, fonctionnant plus vite que 73,8% des utilisateurs sur LeetCode.

Photos

Photos

Enfin, augmentons la difficulté et terminons la partie code du test par une question avec un taux de réussite de 47,5%.

Photos

Photos

Après avoir lu le code, testons les capacités mathématiques de Pi et laissons-le répondre à des questions sur les dérivées :

Trouvez le point extrême de la fonction f(x)=x³+2x²-1

La réponse est tout à fait correcte et très détaillée.

Bien sûr, si vous voulez être bon en mathématiques, la pensée logique est essentielle, donc en plus des questions mathématiques habituelles, nous avons également utilisé une question classique pour tester la pensée logique de Pi, et les résultats n'étaient pas mauvais.

Grâce aux performances de Pi, nous pouvons voir que le modèle Inflection-2.5 derrière lui est en effet remarquable.

À en juger par les données de test officielles publiées par lui-même, les performances d'Inflection-2.5 sont suivies de près par GPT-4 en termes de capacités globales et de sous-éléments individuels.

En prenant les mathématiques et le codage comme exemple, Inflection-2.5 a fait un bond significatif par rapport à la version 1.0 dans des tests tels que MATH et HumanEval.

En plus de ces ensembles de données conventionnels, Inflection a également contesté les questions du test de mathématiques de l'examen d'entrée à l'université hongroise et le test de physique GRE, et les résultats étaient presque à égalité avec GPT-4.

Encore plus délicat, quelqu'un a construit un ensemble de données BIG-Bench en utilisant des problèmes difficiles à comprendre avec de grands modèles, et Inflection-2.5 a défié le sous-ensemble Hard, et la différence entre les résultats et GPT-4 est inférieure à un point. .

Alors, quel type d'entreprise se cache derrière Inflection-2.5 ?

DeepMind Lianchuang Large Model Venture

Cette société s'appelle Inflection AI Elle a été fondée en 2022 par DeepMind Lianchuang Mustafa Suleyman et d'autres. Il y a actuellement plus de 70 personnes.

Également de DeepMind, il y a la chercheuse principale Karen Simonyan, qui est maintenant la scientifique en chef d'Inflection AI.

De plus, le co-fondateur de LinkedIn, Reid Hoffman, a également participé à la création d'Inflection AI.

Depuis sa création, Inflection AI a reçu un financement total de 1,5 milliard de dollars américains de la part de géants tels que NVIDIA, Microsoft et Bill Gates.

Actuellement, Pi basé sur Inflection est toujours gratuit, mais le PDG Suleyman a également déclaré qu'il n'est pas réaliste d'utiliser l'amour pour produire de l'électricité tout le temps et qu'il y aura toujours des frais à long terme.

Les amis qui veulent en faire l'expérience devront peut-être se dépêcher~

Portail : https://pi.ai

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Comment importer la mise en page du modèle CAO

- Choqué ! Après 70 000 heures de formation, le modèle OpenAI a appris à planifier le bois dans « Minecraft »

- Les méta-chercheurs font une nouvelle tentative en matière d'IA : apprendre aux robots à naviguer physiquement sans cartes ni formation

- Comment utiliser PyTorch pour la formation aux réseaux neuronaux

- Les tests internes de Kimi Chat démarrent, Volcano Engine fournit des solutions d'accélération, prend en charge la formation et l'inférence du service de grands modèles Moonshot AI