Maison >Périphériques technologiques >IA >Choqué ! Après 70 000 heures de formation, le modèle OpenAI a appris à planifier le bois dans « Minecraft »

Choqué ! Après 70 000 heures de formation, le modèle OpenAI a appris à planifier le bois dans « Minecraft »

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-09 17:01:041672parcourir

Récemment, OpenAI, qui semble avoir laissé GPT derrière lui, a commencé une nouvelle vie.

Après s'être entraînée avec des vidéos massives non étiquetées et un peu de données étiquetées, l'IA a finalement appris à fabriquer des pioches en diamant dans Minecraft.

L'ensemble du processus prend au moins 20 minutes à un joueur inconditionnel et nécessite un total de 24 000 opérations.

Cette chose semble simple, mais c'est très difficile pour l'IA.

Un enfant de 7 ans peut l'apprendre en seulement 10 minutes

Pour la pioche en bois la plus simple, il n'est pas trop difficile pour les joueurs humains de l'apprendre à partir de zéro.

Un nerd peut enseigner le suivant en moins de 3 minutes avec une seule vidéo.

La vidéo de démonstration dure 2 minutes et 52 secondes

Cependant, réaliser une pioche en diamant est beaucoup plus compliqué.

Mais malgré cela, un enfant de 7 ans peut l'apprendre après avoir simplement regardé une vidéo de démonstration de dix minutes.

La difficulté de cette mission est principalement de savoir comment creuser la mine de diamant.

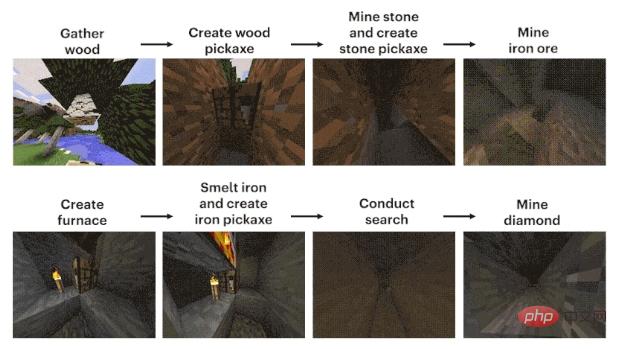

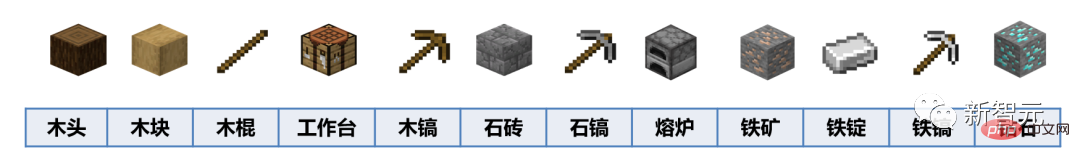

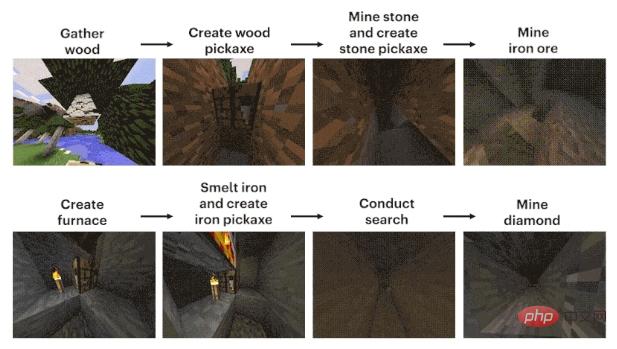

Le processus peut être résumé grossièrement en 12 étapes : d'abord, planifier le bloc de pixels "bois" à mains nues, puis synthétiser les blocs de bois à partir des bûches, utiliser les blocs de bois pour fabriquer des bâtons de bois, utiliser les bâtons de bois pour fabriquez la table d'équipement de l'atelier et utilisez l'établi pour fabriquer des pioches en bois. Utilisez une pioche en bois pour frapper des pierres, ajoutez des pierres aux bâtons de bois pour fabriquer une pioche en pierre, utilisez la pioche en pierre pour construire un four, le four traite le minerai de fer, le le minerai de fer fond en lingots de fer, les lingots de fer fabriquent des pioches en fer et les pioches en fer creusent des diamants.

Maintenant, la pression est du côté de l'IA.

Par coïncidence, CMU, OpenAI, DeepMind, Microsoft Research et d'autres institutions ont lancé un concours connexe, MineRL, depuis 2019.

Les candidats doivent développer un agent d'intelligence artificielle capable de "construire des outils à partir de zéro et de trouver et d'exploiter automatiquement des mines de diamants". Les conditions gagnantes sont également très simples : le plus rapide gagne.

Quel a été le résultat ?

Après le premier concours MineRL, "Un enfant de 7 ans l'a appris après avoir regardé une vidéo de 10 minutes, mais l'IA n'arrivait toujours pas à le comprendre après 8 millions de pas." publié dans la revue Nature.

Bien qu'il y ait beaucoup de données, je ne peux pas les utiliser

En tant que jeu de construction bac à sable, "Minecraft" est particulièrement adapté à l'apprentissage et à la prise de décision de divers modèles d'IA en raison de sa grande ouverture des stratégies des joueurs et environnement virtuel dans le jeu. Un terrain d’essai et une pierre de touche pour les capacités.

Et en tant que jeu « de niveau national », il est facile de trouver des vidéos liées à « Minecraft » en ligne.

Cependant, qu'il s'agisse de créer un tutoriel ou de montrer votre propre travail, dans une certaine mesure, il ne s'agit que du résultat affiché à l'écran.

En d’autres termes, les gens qui regardent la vidéo peuvent seulement savoir ce que le leader a fait et comment il l’a fait, mais ils n’ont aucun moyen de savoir comment il l’a fait.

Pour être plus précis, ce qui est affiché sur l'écran de l'ordinateur n'est que le résultat, et les étapes de l'opération sont le clic constant du propriétaire sur le clavier et le mouvement constant de la souris.

Même ce processus a été modifié, et les gens ne pourront probablement pas l'apprendre après l'avoir regardé, encore moins l'IA.

Pour aggraver les choses, de nombreux joueurs se plaignent que raboter du bois dans le jeu est ennuyeux, un peu comme faire ses devoirs et accomplir des tâches. En conséquence, après une vague de mises à jour, de nombreux outils peuvent être récupérés gratuitement... Désormais, même les données sont difficiles à trouver.

Si OpenAI veut permettre à l'IA d'apprendre à jouer à "Minecraft", elle doit trouver un moyen d'utiliser ces données vidéo massives non étiquetées.

Modèle de pré-formation vidéo - VPT

Ainsi, VPT a vu le jour.

Adresse papier : https://cdn.openai.com/vpt/Paper.pdf

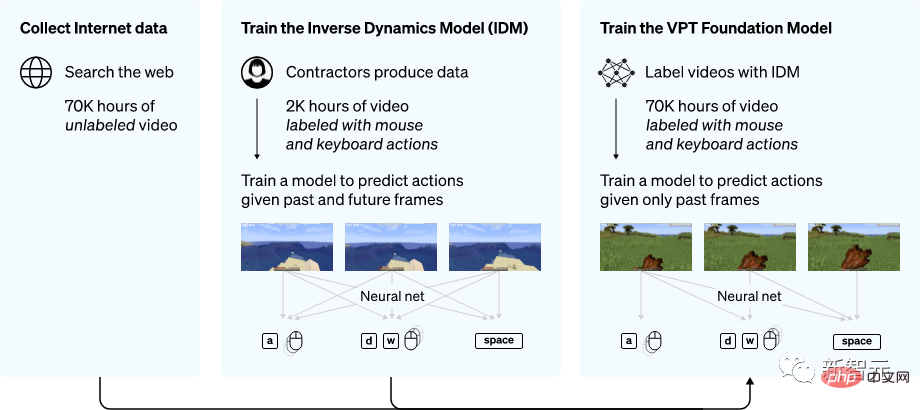

Cette chose est nouvelle, mais ce n'est pas compliqué. C'est une sorte de semi-. supervision Méthode d'apprentissage par imitation.

Tout d'abord, collectez une vague de données pour annoter les données de jeu des sous-traitants, qui comprennent les enregistrements vidéo et les opérations du clavier et de la souris.

Aperçu de la méthode VPT

Ensuite, les chercheurs ont utilisé ces données pour créer un modèle de dynamique inverse (IDM), qui peut déduire la clé de chaque étape dans la vidéo Comment fonctionnent les rats. se déplacer?

De cette façon, l'ensemble de la tâche devient beaucoup plus simple et seulement beaucoup moins de données sont nécessaires pour atteindre l'objectif.

Après avoir terminé l'IDM avec une petite quantité de données externalisées, vous pouvez utiliser IDM pour étiqueter un plus grand ensemble de données non étiquetées.

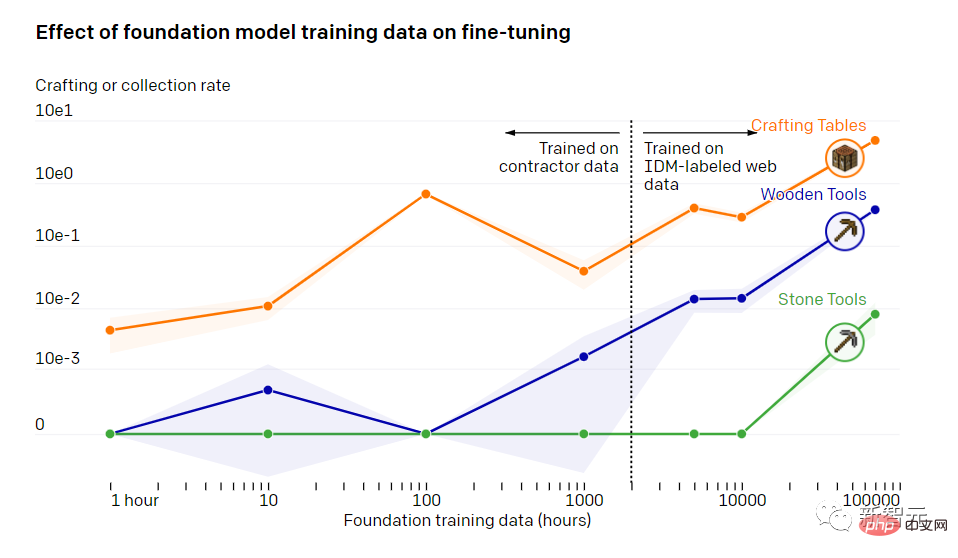

L'impact des données de formation de base du modèle sur le réglage fin

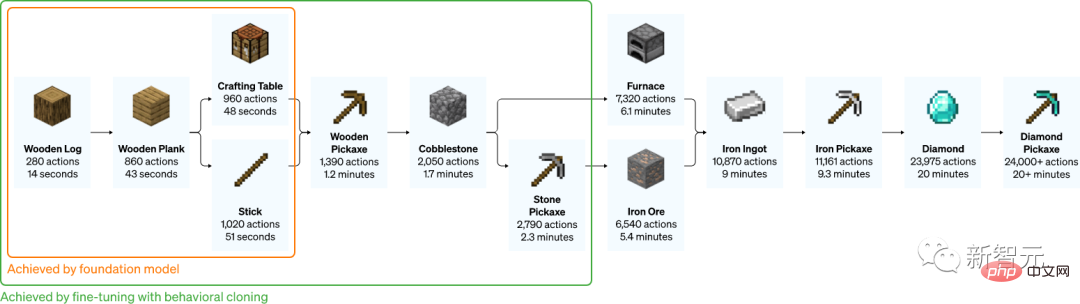

Après 70 000 heures de formation, le modèle de clonage comportemental d'OpenAI peut accomplir diverses tâches que d'autres modèles ne peuvent pas accomplir.

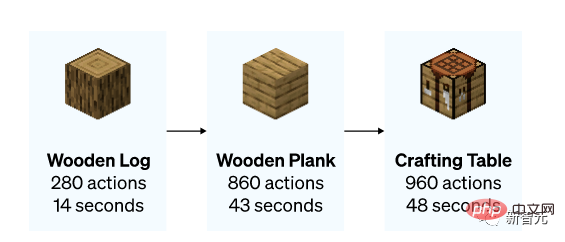

Le modèle a appris à abattre des arbres et à ramasser du bois, à utiliser le bois pour fabriquer des bandes de bois et à utiliser des bandes de bois pour fabriquer des tables. Cet ensemble de choses nécessite qu'un joueur relativement qualifié opère pendant moins de 50 secondes.

En plus de faire une table, le modèle peut aussi nager, chasser et manger.

Il existe même une opération sympa de "courir, sauter et construire", c'est-à-dire que lorsque vous décollez, mettez une brique ou un bloc de bois sous vos pieds, et vous pouvez construire un pilier en sautant. Il s'agit d'un cours obligatoire pour les joueurs inconditionnels.

Création d'un tableau (0 plan)

Chasse (0 plan)

"Courir et sauter" version simple (0 plan)

Pour Pour permettre au modèle d'accomplir certaines tâches plus détaillées, l'ensemble de données est généralement affiné à une taille plus petite et distingue de petites directions.

OpenAI a réalisé une étude qui a montré à quel point un modèle formé avec VPT peut s'adapter aux ensembles de données en aval après un réglage fin.

Les chercheurs ont invité les gens à jouer à "Minecraft" pendant 10 minutes et à construire une maison en utilisant des matériaux de base. Ils espèrent ainsi pouvoir améliorer la capacité du modèle à effectuer certaines tâches de début de partie, telles que la construction d'un établi.

Après avoir affiné l'ensemble de données, les chercheurs ont non seulement constaté que le modèle était plus efficace pour effectuer les tâches initiales, mais ont également constaté que le modèle lui-même comprenait comment fabriquer un établi en bois et un établi en bois. .

Parfois, les chercheurs peuvent également voir le modèle construire tout seul un abri rudimentaire, fouiller le village et piller des coffres.

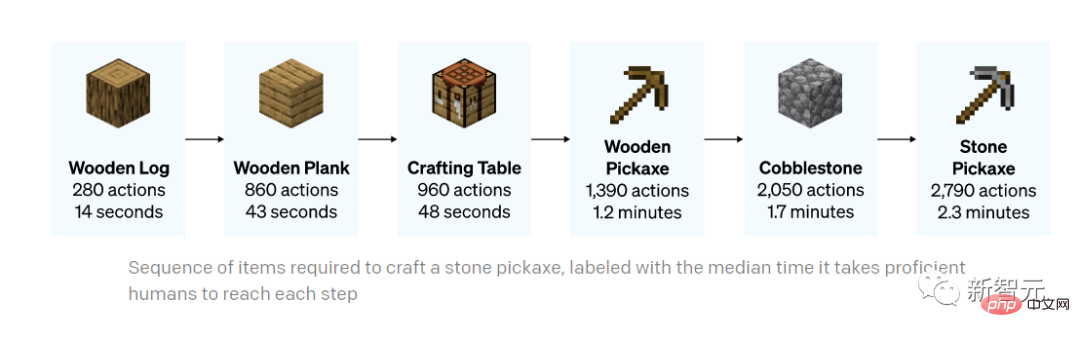

L'ensemble du processus de fabrication d'une pioche en pierre (le temps indiqué ci-dessous est le temps qu'il faut à un joueur expérimenté pour effectuer la même tâche)

Faire une pioche en pierre

Voyons ensuite comment les experts d'OpenAI l'ont peaufiné.

La méthode qu'ils utilisent est l'apprentissage par renforcement (RL).

La plupart des méthodes RL relèvent ces défis en explorant de manière stochastique les priorités, c'est-à-dire que les modèles sont souvent incités à récompenser les actions aléatoires via l'entropie. Le modèle VPT devrait être un meilleur modèle antérieur pour RL, car simuler le comportement humain peut être plus utile que de prendre des actions aléatoires.

Les chercheurs ont mis en place le modèle pour la tâche difficile de collecter des pioches en diamant, une fonctionnalité jamais vue auparavant dans Minecraft, car l'exécution de l'ensemble de la tâche est beaucoup plus difficile lorsque l'on utilise l'interface homme-machine native.

Fabriquer une pioche en diamant nécessite une série longue et complexe de sous-tâches. Pour rendre cette tâche réalisable, les chercheurs ont récompensé l'agent pour chaque élément de la séquence.

Ils ont découvert qu'une politique RL formée à partir d'une initialisation aléatoire (approche RL standard) ne recevait presque aucune récompense, n'apprenait jamais à collecter des journaux et collectait rarement des bâtons.

Contrairement à ce qui se passe, le modèle VPT a été affiné non seulement pour apprendre à fabriquer une pioche en diamant, mais également pour atteindre un succès au niveau humain dans la collecte de tous les objets.

Et c'est la première fois que quelqu'un montre un modèle informatique capable de fabriquer des outils diamantés dans "Minecraft".

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI