Maison >Périphériques technologiques >IA >Les méta-chercheurs font une nouvelle tentative en matière d'IA : apprendre aux robots à naviguer physiquement sans cartes ni formation

Les méta-chercheurs font une nouvelle tentative en matière d'IA : apprendre aux robots à naviguer physiquement sans cartes ni formation

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-09 20:31:121728parcourir

Le département d'intelligence artificielle de Meta Platforms a récemment déclaré qu'il enseignait aux modèles d'IA comment apprendre à marcher dans le monde physique avec le soutien d'une petite quantité de données d'entraînement, et qu'il avait fait des progrès rapides.

Cette recherche peut réduire considérablement le temps nécessaire aux modèles d’IA pour acquérir des capacités de navigation visuelle. Auparavant, pour atteindre de tels objectifs, il fallait utiliser de grands ensembles de données et un « apprentissage par renforcement » répété pour les atteindre.

Les chercheurs de Meta AI ont déclaré que cette exploration de la navigation visuelle de l'IA aura un impact significatif sur le monde virtuel. L’idée de base du projet n’est pas compliquée : aider l’IA à naviguer dans l’espace physique comme le font les humains, simplement par l’observation et l’exploration.

Le département Meta AI a expliqué : « Par exemple, si nous voulons que des lunettes AR nous guident pour trouver les clés, nous devons trouver un moyen d'aider l'IA à comprendre la disposition d'environnements inconnus et en constante évolution. Après tout, il s'agit d'un moyen très détaillé. et une petite exigence qui ne peut pas durer éternellement. S'appuyant sur des cartes prédéfinies de haute précision qui consomment beaucoup de puissance de calcul, les humains peuvent facilement se déplacer dans les coins de la table basse sans aucune collision. Dans ce but, Meta a décidé de concentrer ses efforts. Dans le cas de « l'IA incarnée », le système d'IA est entraîné via le mécanisme interactif de simulation 3D. Dans ce domaine, Meta a déclaré avoir établi un « modèle de navigation point-cible » prometteur, capable de naviguer dans de nouveaux environnements sans aucune carte ni capteur GPS.

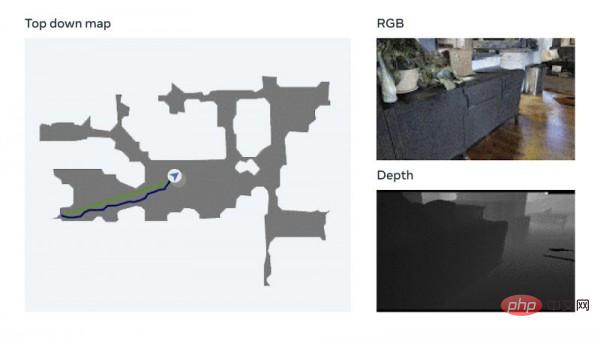

Le modèle utilise une technologie appelée mesure visuelle, qui permet à l'IA de suivre sa position actuelle en fonction d'une entrée visuelle. Meta a déclaré que cette technologie d'augmentation des données peut rapidement former des modèles neuronaux efficaces sans avoir besoin d'annotation manuelle des données. Meta a également mentionné avoir effectué des tests sur sa propre plate-forme de formation à l'IA incorporée Habitat 2.0 (qui utilise la tâche de référence Realistic PointNav pour exécuter des simulations d'espace virtuel), avec un taux de réussite de 94 %.

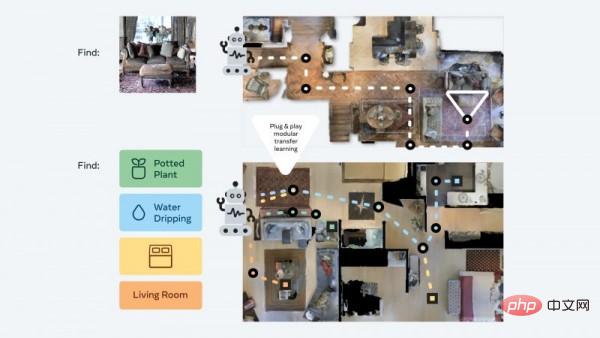

Meta a expliqué : « Bien que notre méthode n'ait pas entièrement résolu tous les scénarios de l'ensemble de données, cette recherche a initialement démontré que la capacité de naviguer dans des environnements du monde réel ne nécessite pas nécessairement une cartographie explicite pour y parvenir. » Afin d'améliorer encore la formation à la navigation par l'IA sans s'appuyer sur des cartes, Meta a créé un ensemble de données de formation appelé Habitat-Web, qui contient plus de 100 000 méthodes différentes de navigation objet-cible démontrées par les humains. Le simulateur Habitat fonctionnant sur un navigateur Web peut se connecter facilement au service Mechanical Turk d'Amazon.com, permettant aux utilisateurs de faire fonctionner des robots virtuels à distance en toute sécurité. Meta a déclaré que les données résultantes seront utilisées comme matériel de formation pour aider les agents d'IA à obtenir des « résultats de pointe ». Scanner la pièce pour comprendre les caractéristiques spatiales globales, vérifier s'il y a des obstacles dans les coins, etc. sont autant de comportements de recherche d'objets efficaces que l'IA peut apprendre des humains.

Meta a expliqué : « Bien que notre méthode n'ait pas entièrement résolu tous les scénarios de l'ensemble de données, cette recherche a initialement démontré que la capacité de naviguer dans des environnements du monde réel ne nécessite pas nécessairement une cartographie explicite pour y parvenir. » Afin d'améliorer encore la formation à la navigation par l'IA sans s'appuyer sur des cartes, Meta a créé un ensemble de données de formation appelé Habitat-Web, qui contient plus de 100 000 méthodes différentes de navigation objet-cible démontrées par les humains. Le simulateur Habitat fonctionnant sur un navigateur Web peut se connecter facilement au service Mechanical Turk d'Amazon.com, permettant aux utilisateurs de faire fonctionner des robots virtuels à distance en toute sécurité. Meta a déclaré que les données résultantes seront utilisées comme matériel de formation pour aider les agents d'IA à obtenir des « résultats de pointe ». Scanner la pièce pour comprendre les caractéristiques spatiales globales, vérifier s'il y a des obstacles dans les coins, etc. sont autant de comportements de recherche d'objets efficaces que l'IA peut apprendre des humains.

De plus, l'équipe Meta AI a également développé une approche modulaire dite « plug and play » qui peut aider les robots à se généraliser dans une variété de tâches de navigation sémantique et de modes cibles grâce à un « cadre d'apprentissage d'expérience sans échantillon » unique. . De cette manière, les agents IA peuvent toujours acquérir des compétences de navigation de base sans avoir besoin de cartes ni de formations gourmandes en ressources, et peuvent effectuer différentes tâches dans un environnement 3D sans ajustements supplémentaires.

Meta explique que ces agents recherchent en permanence des cibles d'images pendant la formation. Ils reçoivent une photo prise à un endroit aléatoire de l’environnement puis utilisent la navigation autonome pour tenter de retrouver l’emplacement. Les chercheurs de Meta ont déclaré : « Notre méthode réduit les données d'entraînement à 1/12,5 et le taux de réussite est 14 % plus élevé que la dernière technologie d'apprentissage par transfert. » Holger Mueller, analyste chez Constellation Research, a déclaré dans une interview que la dernière technologie de Meta. le développement devrait jouer un rôle clé dans ses plans de développement de métaverse. Il estime que si le monde virtuel peut devenir la norme à l’avenir, l’IA doit être capable de comprendre ce nouvel espace, et le coût de cette compréhension ne devrait pas être trop élevé. Mueller a ajouté : « La capacité de l’IA à comprendre le monde physique doit être étendue par des méthodes logicielles. Meta emprunte actuellement cette voie et a progressé dans l’IA incarnée, en développant un système capable de comprendre de manière autonome son environnement sans formation. J'ai hâte de voir les premières applications pratiques de ce logiciel.

Mueller a ajouté : « La capacité de l’IA à comprendre le monde physique doit être étendue par des méthodes logicielles. Meta emprunte actuellement cette voie et a progressé dans l’IA incarnée, en développant un système capable de comprendre de manière autonome son environnement sans formation. J'ai hâte de voir les premières applications pratiques de ce logiciel.

Ces cas d'utilisation réels ne sont peut-être pas loin de nous. Meta a déclaré que la prochaine étape consisterait à faire progresser ces résultats de la navigation aux opérations mobiles et à développer des agents d'IA capables d'effectuer des tâches spécifiques (telles que l'identification d'un portefeuille et son retour à son propriétaire).

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI