Maison >Périphériques technologiques >IA >OccFusion : Un framework de fusion multi-capteurs simple et efficace pour Occ (Performance SOTA)

OccFusion : Un framework de fusion multi-capteurs simple et efficace pour Occ (Performance SOTA)

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2024-03-08 11:50:03857parcourir

Une compréhension globale des scènes 3D est cruciale dans la conduite autonome, et les récents modèles de prédiction sémantique d'occupation 3D ont relevé avec succès le défi consistant à décrire des objets du monde réel avec différentes formes et catégories. Cependant, les méthodes de prévision d’occupation 3D existantes s’appuient fortement sur les images de caméras panoramiques, ce qui les rend sensibles aux changements d’éclairage et de conditions météorologiques. En intégrant les capacités de capteurs supplémentaires tels que le lidar et le radar à vision panoramique, notre cadre améliore la précision et la robustesse de la prévision d'occupation, ce qui se traduit par des performances optimales sur le benchmark nuScenes. De plus, des expériences approfondies sur l'ensemble de données nuScene, y compris des scènes nocturnes et pluvieuses difficiles, confirment les performances supérieures de notre stratégie de fusion de capteurs sur différentes plages de détection.

Lien de l'article : https://arxiv.org/pdf/2403.01644.pdf

Nom de l'article : OccFusion : Un cadre de fusion multi-capteurs simple et efficace pour la prévision d'occupation 3D

Les principales contributions de cet article sont résumées comme suit :

- Un cadre de fusion multi-capteurs est proposé pour intégrer les informations de caméra, lidar et radar afin d'effectuer des tâches de prédiction sémantique d'occupation 3D.

- Dans la tâche de prédiction d'occupation sémantique 3D, notre méthode est comparée à d'autres algorithmes de pointe (SOTA) pour démontrer les avantages de la fusion multi-capteurs.

- Des études d'ablation approfondies ont été menées pour évaluer les gains de performances obtenus par différentes combinaisons de capteurs dans des conditions d'éclairage et météorologiques difficiles telles que la nuit et la pluie.

- Une étude approfondie a été menée pour analyser l'impact des facteurs de portée perceptuelle sur les performances de notre framework dans les tâches de prédiction d'occupation sémantique 3D, en considérant diverses combinaisons de capteurs et des scénarios difficiles !

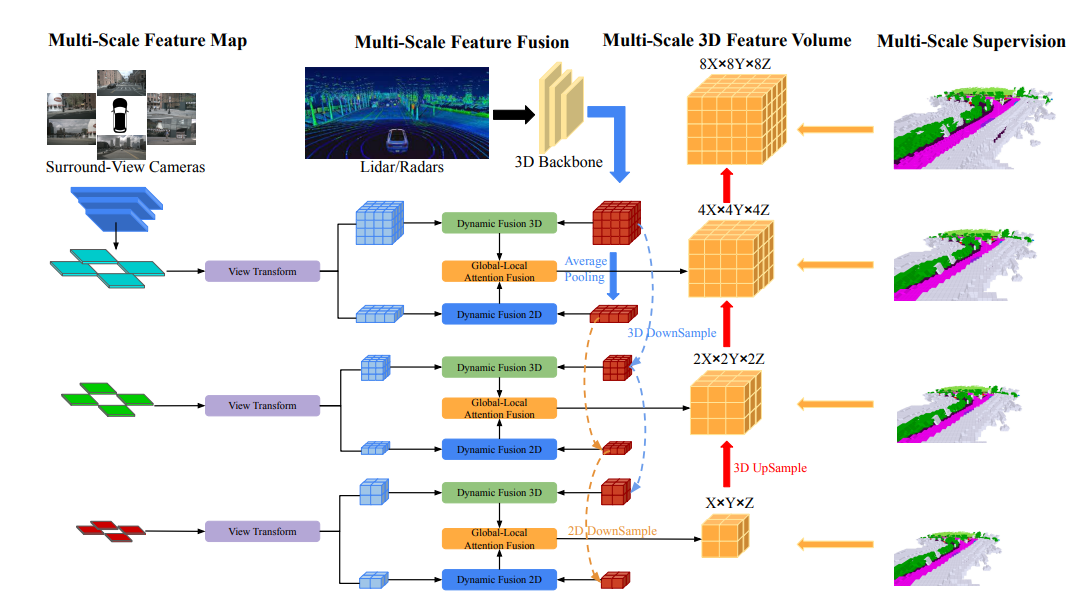

Aperçu de la structure du réseau

L'architecture globale d'OccFusion est la suivante. Tout d’abord, les images en vue panoramique sont entrées dans une structure 2D pour extraire des caractéristiques multi-échelles. Par la suite, la transformation de la vue est effectuée à chaque échelle pour obtenir les caractéristiques BEV globales et le volume de caractéristiques 3D locales à chaque niveau. Les nuages de points 3D générés par le lidar et le radar surround sont également introduits dans le réseau fédérateur 3D pour générer des quantités de caractéristiques 3D locales multi-échelles et des caractéristiques BEV globales. Les modules de fusion dynamique 3D/2D à chaque niveau combinent les capacités des caméras et du lidar/radar. Après cela, les caractéristiques BEV globales fusionnées et le volume de caractéristiques 3D locales à chaque niveau sont introduits dans la fusion d'attention globale-locale pour générer le volume 3D final à chaque échelle. Enfin, le volume 3D à chaque niveau est suréchantillonné et connecté avec un mécanisme de supervision multi-échelle.

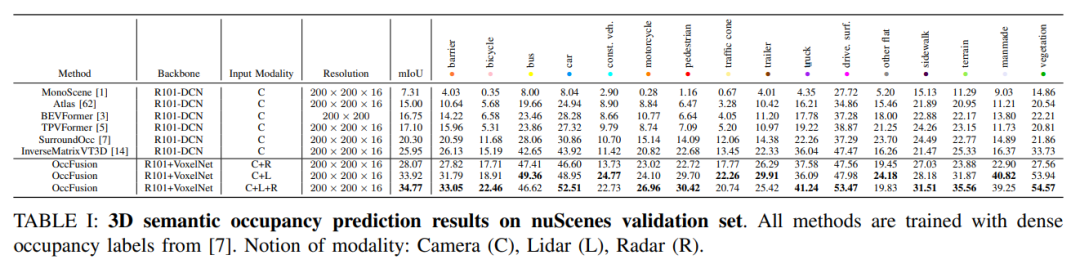

Analyse comparative expérimentale

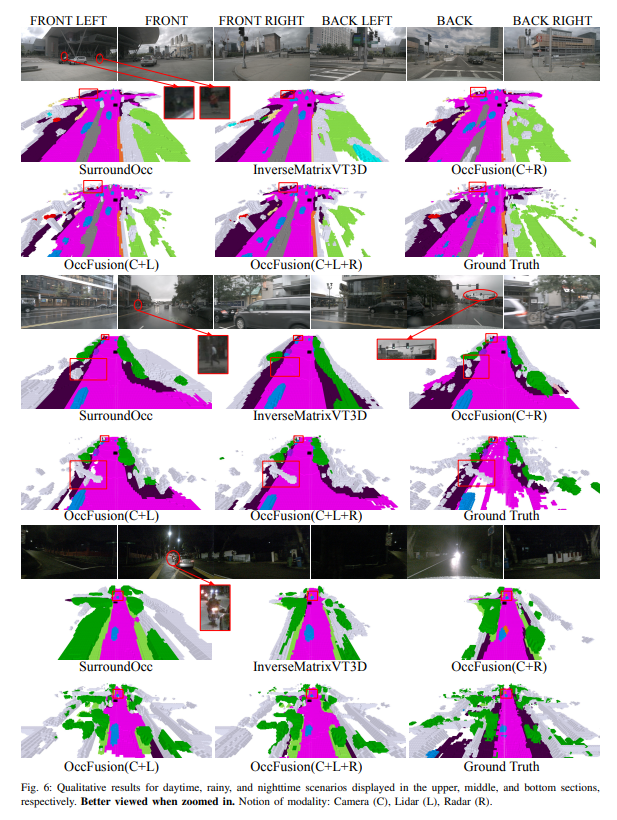

Sur l'ensemble de validation nuScenes, les résultats de diverses méthodes basées sur la formation d'étiquettes d'occupation denses dans la prédiction sémantique d'occupation 3D sont présentés. Ces méthodes impliquent différents concepts modaux dont la caméra (C), le lidar (L) et le radar (R).

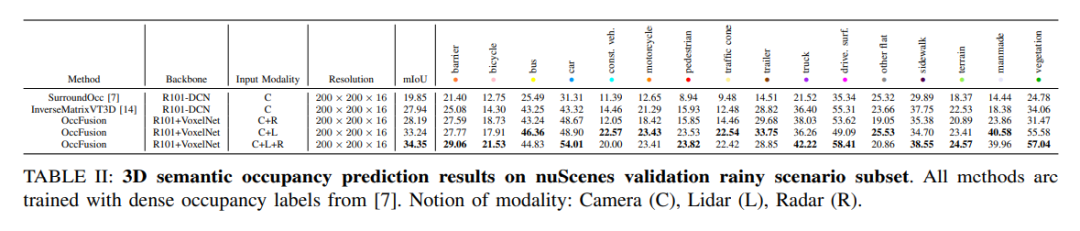

Sur le sous-ensemble de scènes pluvieuses de l'ensemble de données nuScenes, nous prédisons l'occupation sémantique 3D et utilisons des étiquettes d'occupation denses pour la formation. Dans cette expérience, nous avons considéré des données provenant de différentes modalités telles que la caméra (C), le lidar (L), le radar (R), etc. La fusion de ces modes peut nous aider à mieux comprendre et prédire les scènes pluvieuses, constituant ainsi une référence importante pour le développement de systèmes de conduite autonome.

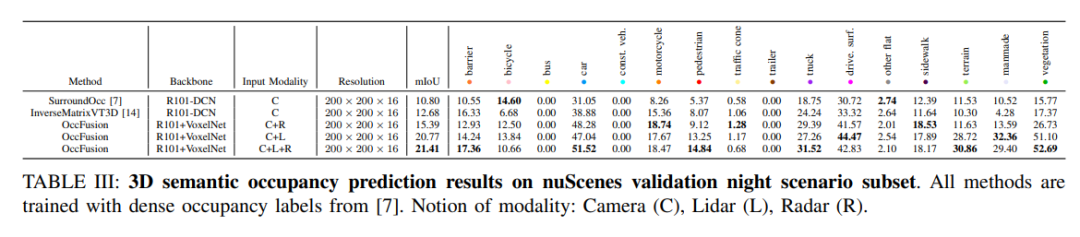

nuScenes valide les résultats de prédiction d'occupation sémantique 3D pour un sous-ensemble de scènes nocturnes. Toutes les méthodes sont formées à l’aide d’étiquettes d’occupation denses. Concepts modaux : caméra (C), lidar (L), radar (R).

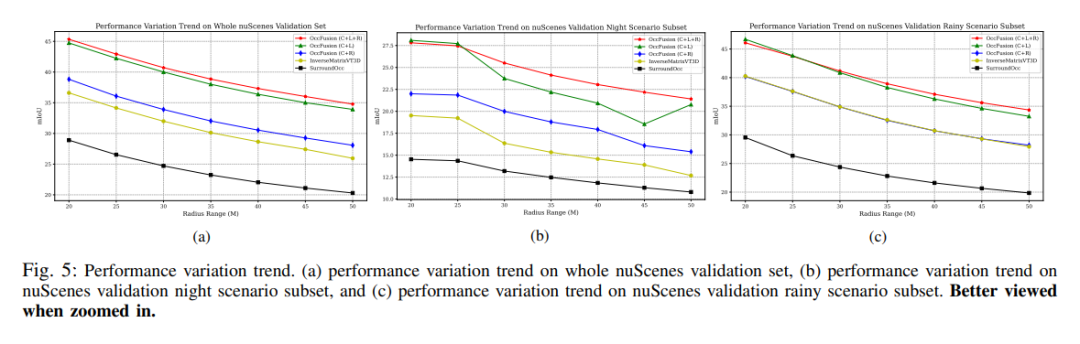

Tendances de changement de performance. (a) Tendance de changement de performances de l'ensemble de la validation nuScenes, (b) sous-ensemble de scènes de nuit de validation nuScenes, et (c) tendance de changement de performances de validation nuScene du sous-ensemble de scènes pluvieuses.

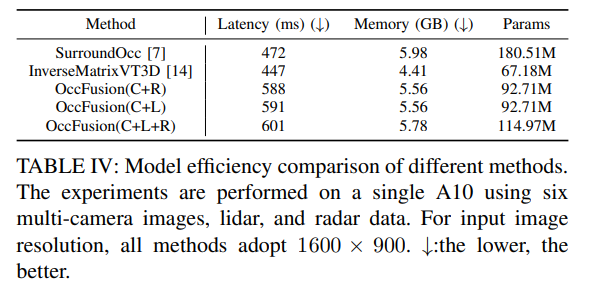

Tableau 4 : Comparaison de l'efficacité du modèle de différentes méthodes. Des expériences ont été menées sur un A10 en utilisant six images multi-caméras, des données lidar et radar. Pour la résolution de l’image d’entrée, 1 600 × 900 est utilisé pour toutes les méthodes. ↓ : Plus c'est bas, mieux c'est.

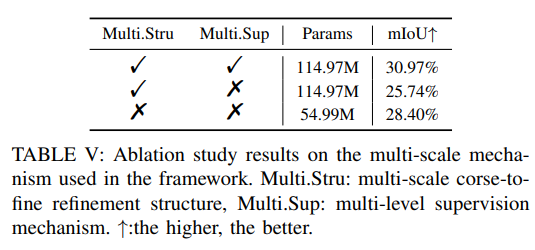

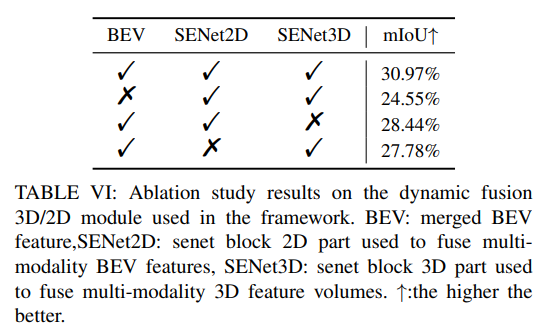

Plus d'expériences d'ablation :

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Exemple de programme WeChat Mini : implémentation du code d'effets spéciaux de carrousel 3D

- Unity3d peut-il être écrit en python ?

- AirPods Pro et AirPods 3 : Comment modifier les commandes du capteur de force

- Réseaux de capteurs sans fil passifs en PHP

- Apprendre la programmation PHP : lecture des données des capteurs via le matériel IoT