Maison >Périphériques technologiques >IA >Près de dix mille personnes ont regardé le dernier discours de Hinton : Algorithme d'entraînement des réseaux neuronaux Forward-Forward, l'article a été rendu public

Près de dix mille personnes ont regardé le dernier discours de Hinton : Algorithme d'entraînement des réseaux neuronaux Forward-Forward, l'article a été rendu public

- 王林avant

- 2023-04-14 10:22:071176parcourir

La conférence NeurIPS 2022 bat son plein. Des experts et des universitaires de tous horizons communiquent et discutent de nombreux domaines subdivisés tels que l'apprentissage profond, la vision par ordinateur, l'apprentissage automatique à grande échelle, la théorie de l'apprentissage, l'optimisation et la théorie clairsemée.

Lors de la réunion, Geoffrey Hinton, lauréat du prix Turing et pionnier de l'apprentissage profond, a été invité à prononcer un discours en reconnaissance de l'article "ImageNet Classification with Deep Convolutional Neural Networks" qu'il a co-écrit avec ses étudiants diplômés Alex Krizhevsky et Ilya. Sutskever a reçu il y a dix ans le Time-testing Award pour son « impact considérable » sur le domaine. Publiés en 2012, ces travaux marquaient la première fois qu'un réseau neuronal convolutif atteignait des performances de niveau humain dans le cadre du concours de reconnaissance d'images ImageNet, et c'était un événement clé qui lançait la troisième vague de l'intelligence artificielle.

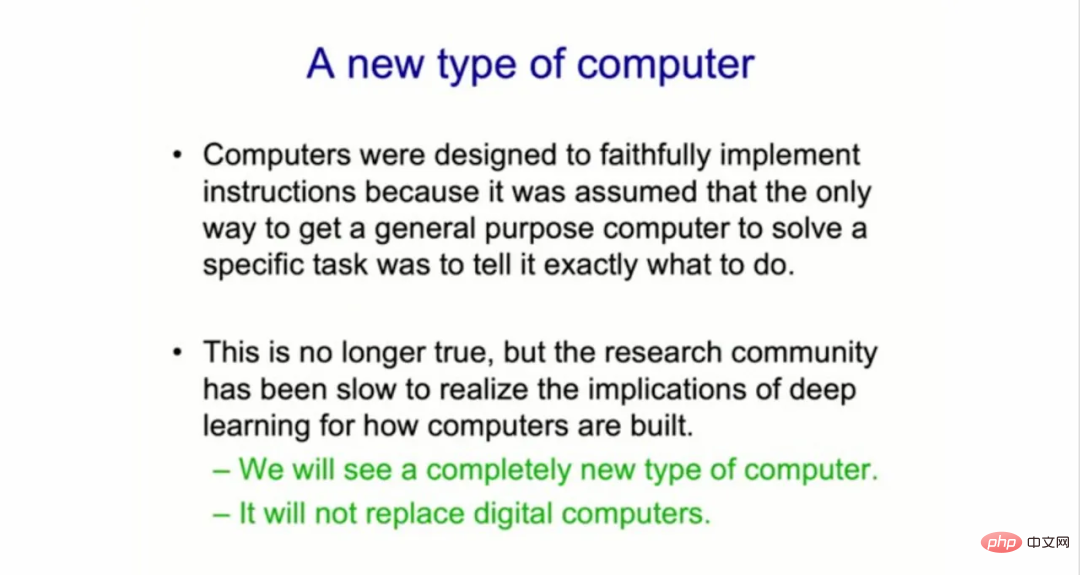

Hinton Le thème de ce discours est "L'algorithme Forward-Forward pour la formation des réseaux de neurones profonds". Dans son discours, Geoffrey Hinton a déclaré : « La communauté de recherche sur l'apprentissage automatique a mis du temps à réaliser l'impact de l'apprentissage profond sur la façon dont les ordinateurs sont construits. » Il pense que les formes d'apprentissage automatique de l'intelligence artificielle déclencheront des changements dans les systèmes informatiques. , c'est une nouvelle combinaison soft et hard qui met l'IA "dans votre grille-pain". Il a poursuivi : "Je pense que nous allons voir un type d'ordinateur complètement différent, et même si cela ne sera pas possible avant quelques années, il y a de bonnes raisons de travailler sur cet ordinateur complètement différent

."

Construire un nouveau type d'ordinateur complètement différent

À ce jour, tous les ordinateurs numériques ont été construits pour être "immortels", où le matériel est conçu pour être extrêmement fiable afin que le même logiciel puisse fonctionner partout. "Nous pouvons exécuter le même programme sur différents matériels physiques, et la connaissance est immortelle."

Hinton a déclaré que cette exigence de conception signifie que les ordinateurs numériques ont manqué "les diverses variables, le caractère aléatoire et l'instabilité du matériel, la simulation et le manque de fiabilité. fonctionnalités" qui peuvent nous être très utiles.

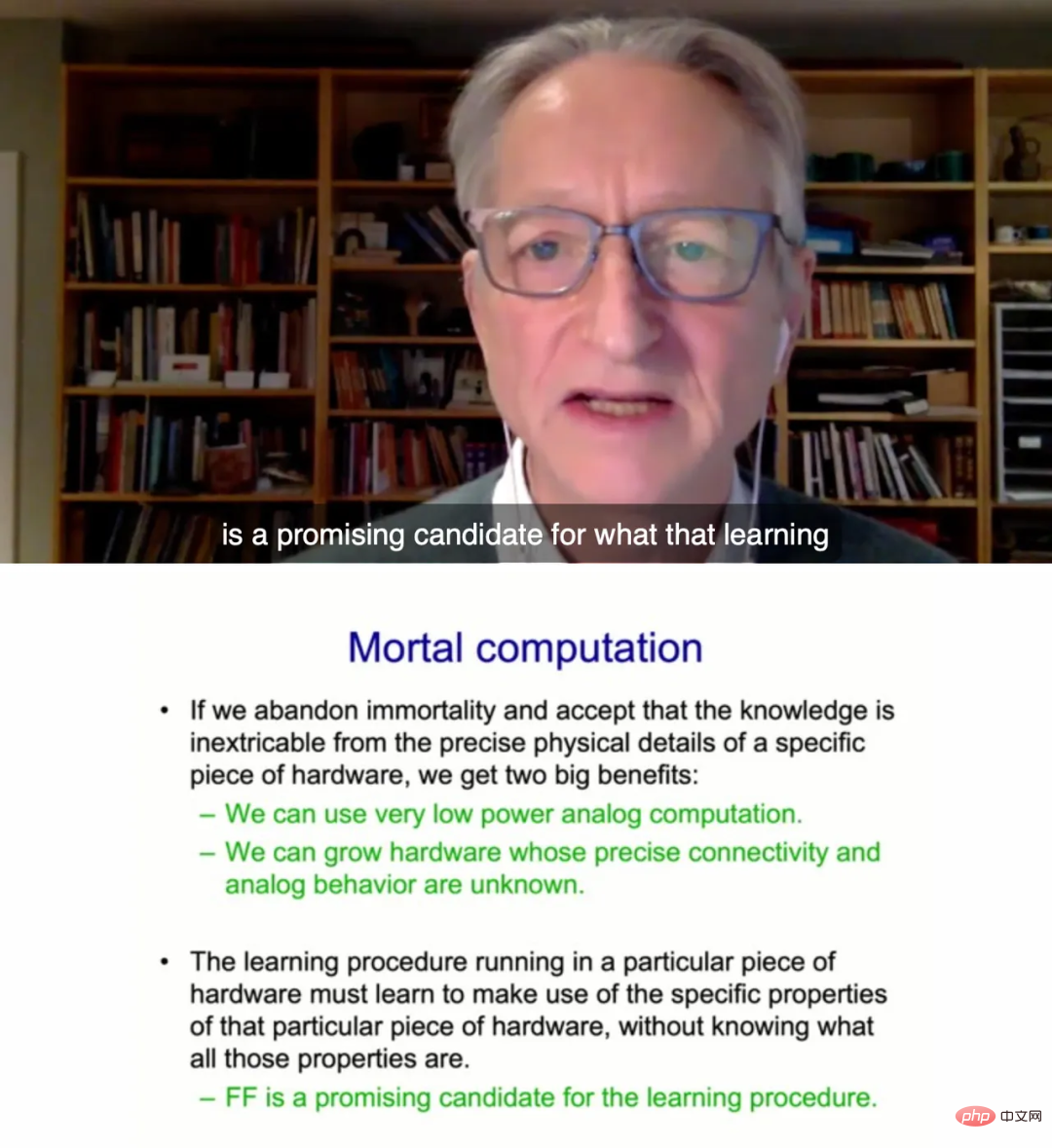

Selon Hinton,

les futurs systèmes informatiques adopteront une approche différente : ils seront « neuromorphiques » et mortels . Cela signifie que chaque ordinateur sera un mariage étroit de logiciels de réseau neuronal et de matériel disjoint, dans le sens où il comportera des composants analogiques plutôt que numériques, qui peuvent contenir un élément d'incertitude et évoluer au fil du temps.

Hinton a expliqué : "L'alternative maintenant est que nous abandonnons la séparation du matériel et des logiciels, mais les informaticiens n'aiment vraiment pas cette approche

Hinton a expliqué : "L'alternative maintenant est que nous abandonnons la séparation du matériel et des logiciels, mais les informaticiens n'aiment vraiment pas cette approche

C'est ce qu'on appelle le calcul mortel." , les connaissances apprises par le système et le matériel sont indissociables. Ces ordinateurs ordinaires peuvent « grandir » à partir d’usines de fabrication de puces coûteuses.

Hinton souligne que si nous faisons cela, nous pouvons utiliser un calcul analogique à très faible consommation et utiliser des poids de memristor pour effectuer des téraflops de traitement parallèle. Il s’agit d’une puce expérimentale vieille de plusieurs décennies basée sur des composants de circuits non linéaires. De plus, nous pouvons faire évoluer le matériel sans comprendre la qualité précise du comportement précis des différents éléments du matériel.

Cependant, Hinton a également déclaré que le nouvel ordinateur ordinaire ne remplacera pas l'ordinateur numérique traditionnel. "Ce n'est pas un ordinateur qui contrôle votre compte bancaire et il ne sait pas non plus exactement combien d'argent vous avez

." Il s'agit d'un ordinateur utilisé pour héberger (c'est-à-dire traiter) d'autres choses, par exemple, il pourrait utiliser un dollar pour "mettre quelque chose comme le GPT-3 dans votre grille-pain" afin qu'il ne prenne que quelques watts de puissance pour correspondre à sa propre conversation sur le grille-pain.

Réseaux FF adaptés au matériel informatique courant

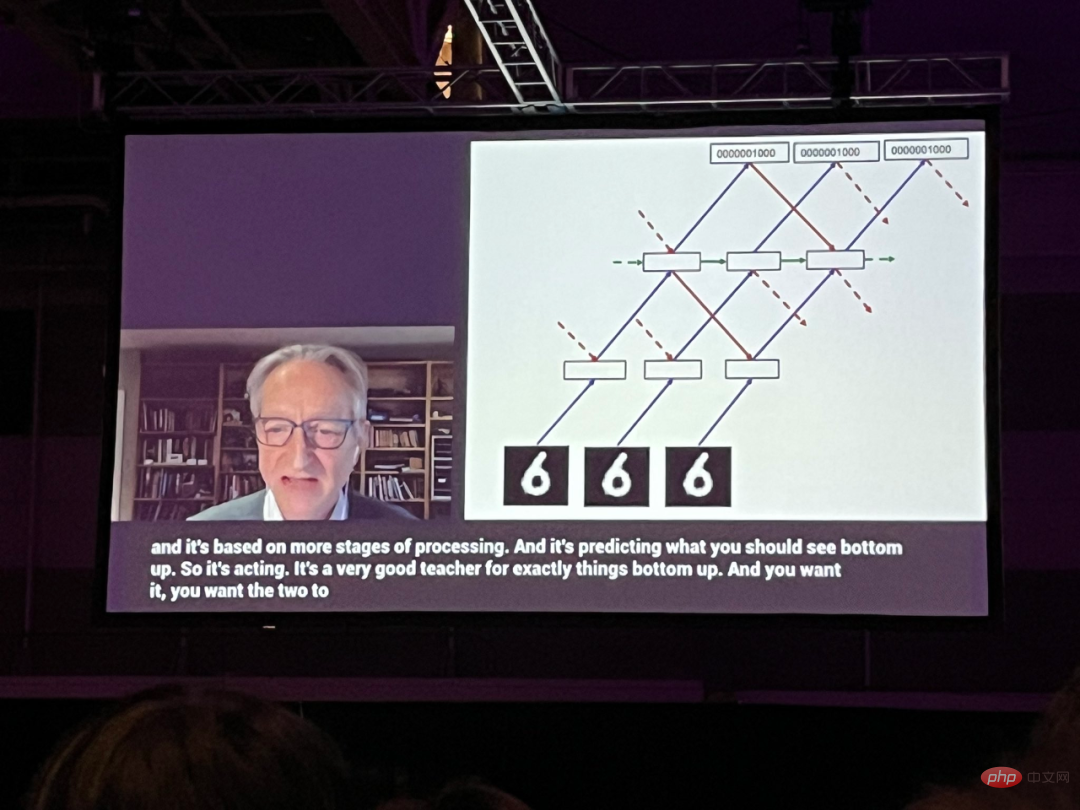

Dans cette présentation, Hinton a passé la majeure partie de la discussion à parler d'une nouvelle approche de réseau neuronal qu'il a appelée réseaux Forward-Forward (FF), qui a remplacé presque la technique de rétropropagation utilisée dans tous réseaux de neurones. Hinton a proposé qu'en supprimant la rétropropagation, les réseaux directs pourraient se rapprocher plus raisonnablement de ce qui se passe dans le cerveau dans la vie réelle.

Ce projet de document est publié sur la page d'accueil de Hinton à l'Université de Toronto :

Lien du document : https://www.cs.toronto.edu/~hinton/FFA13.pdf

Hinton a déclaré que la méthode FF pourrait être plus adaptée au matériel informatique ordinaire. "Pour faire quelque chose comme ça actuellement, nous devons avoir un programme d'apprentissage qui va fonctionner sur du matériel propriétaire, et il doit apprendre à exploiter les propriétés spécifiques de ce matériel propriétaire, sans savoir quelles sont toutes ces propriétés. Mais je pense que le L'algorithme forward est une option avec du potentiel."

Un obstacle à la construction de nouveaux ordinateurs analogiques, a-t-il déclaré, est l'importance accordée à la fiabilité de l'exécution d'un logiciel sur des millions d'appareils. "Chacun de ces téléphones doit commencer comme un babyphone, et il doit apprendre à devenir un téléphone", a déclaré Hinton. "Et c'est très douloureux."

Même les ingénieurs les plus qualifiés seront réticents à abandonner le paradigme d'un ordinateur immortel parfait et identique par peur de l'incertitude.

Hinton a déclaré : « Parmi les personnes qui s'intéressent à l'informatique analogique, il y a encore un très petit nombre de personnes qui sont prêtes à renoncer à l'immortalité. C'est à cause de leur attachement à la cohérence et à la prévisibilité. Mais si vous voulez matériel analogique pour le faire à chaque fois. Même chose, tôt ou tard, vous rencontrez de vrais problèmes avec tout ce désordre. sur certaines petites tâches. L'effet sur la question est assez bon. Le contenu spécifique est le suivant :

Quel est le problème avec la rétropropagation ?

Le succès de l'apprentissage profond au cours de la dernière décennie a établi l'efficacité de la descente de gradient stochastique avec un grand nombre de paramètres et de grandes quantités de données. Le gradient est généralement calculé par rétropropagation, ce qui a conduit à se demander si le cerveau met en œuvre la rétropropagation ou s'il existe d'autres moyens d'obtenir les gradients nécessaires pour ajuster les poids de connexion.

La rétropropagation reste peu plausible en tant que modèle d'apprentissage du cortex cérébral, malgré des efforts considérables pour la mettre en œuvre comme de vrais neurones. Il n'existe actuellement aucune preuve convaincante que le cortex cérébral propage explicitement des dérivés d'erreur ou stocke une activité neuronale pour une utilisation dans une rétro-propagation ultérieure. Les connexions descendantes d'une zone corticale vers des zones situées plus tôt dans le chemin visuel n'étaient pas comme prévu, c'est-à-dire que des connexions ascendantes se produiraient si la rétropropagation était utilisée dans le système visuel. Au lieu de cela, ils forment des boucles dans lesquelles l’activité neuronale traverse environ une demi-douzaine de couches corticales dans deux régions, puis retourne à son point de départ.La rétropropagation dans le temps est particulièrement peu fiable comme moyen d'apprendre des séquences. Afin de traiter un flux d’entrées sensorielles sans interruptions fréquentes, le cerveau doit faire passer les données sensorielles à travers différentes étapes de traitement sensoriel. Il nécessite un programme d’apprentissage capable d’apprendre « à la volée ». Les représentations des étapes ultérieures du pipeline peuvent fournir des informations descendantes qui affectent les représentations des étapes antérieures du pipeline au cours des étapes ultérieures, mais le système de perception doit raisonner et apprendre en temps réel sans s'arrêter pour effectuer une rétropropagation.

Une autre limitation sérieuse de la rétropropagation est qu'elle nécessite une connaissance complète des calculs effectués lors de la passe avant afin de calculer les dérivées correctes. Si nous insérons une boîte noire dans la passe avant, alors la rétropropagation n'est plus possible à moins que nous n'apprenions un modèle différentiable de la boîte noire. Comme nous le verrons, la boîte noire ne change en rien la procédure d’apprentissage de l’algorithme FF, puisqu’il n’est pas nécessaire de rétro-propager à travers elle.

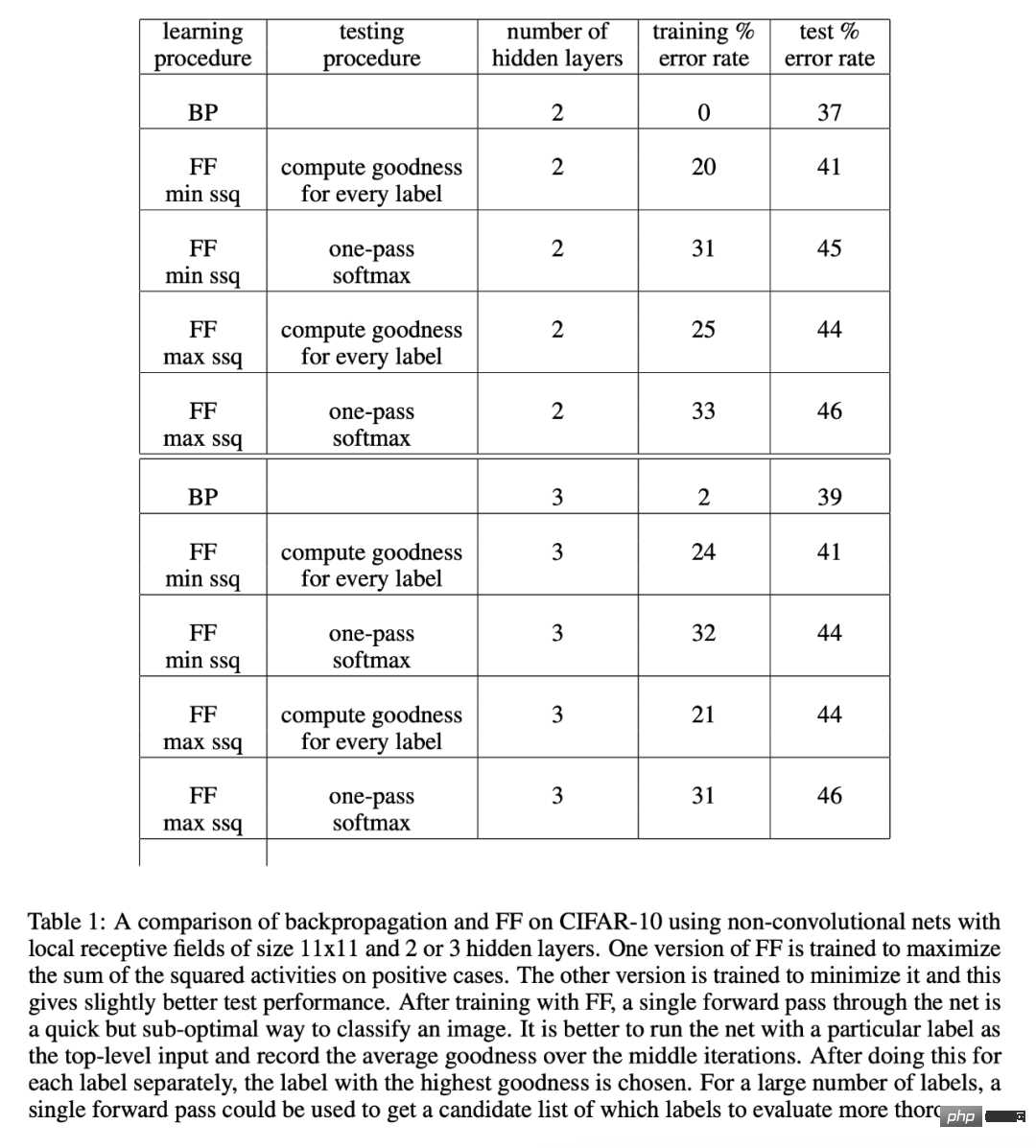

En l'absence d'un modèle de passe avant parfait, on pourrait recourir à l'une des nombreuses formes d'apprentissage par renforcement. L'idée est d'effectuer des perturbations aléatoires sur les poids ou l'activité neuronale et de relier ces perturbations aux changements dans la fonction de paiement. Mais les programmes d’apprentissage par renforcement souffrent d’une grande variabilité : il est difficile de voir l’effet de la perturbation d’une variable lorsque de nombreuses autres variables sont perturbées simultanément. Afin de faire la moyenne du bruit provoqué par toutes les autres perturbations, le taux d'apprentissage doit être inversement proportionnel au nombre de variables perturbées, ce qui signifie que l'apprentissage par renforcement s'adapte mal et ne peut pas être comparé à l'inverse pour les grands réseaux contenant des millions ou des milliards de paramètres. Concours de communication. Le point principal de cet article est que les réseaux de neurones contenant des non-linéarités inconnues n'ont pas besoin de recourir à l'apprentissage par renforcement. L'algorithme FF est comparable en vitesse à la rétropropagation, mais présente l'avantage d'être utilisé lorsque les détails précis du calcul direct ne sont pas connus. Il présente également l’avantage de pouvoir apprendre en pipeline sur des données séquentielles via un réseau neuronal, sans avoir besoin de stocker l’activité neuronale ou d’arrêter de propager des dérivés d’erreur. En général, l'algorithme FF est plus lent que la rétropropagation, et sa généralisation n'est pas idéale sur plusieurs problèmes de jouets étudiés dans cet article, donc dans les applications qui ne sont pas trop contraintes en puissance, il est peu probable qu'il remplace la rétropropagation. Pour les très grands modèles formés sur de très grands ensembles de données, ce type d'exploration continuera à utiliser la rétropropagation. L'algorithme FF peut être meilleur que la rétropropagation sous deux aspects, l'un est en tant que modèle d'apprentissage du cortex cérébral et l'autre est l'utilisation de matériel de simulation à très faible consommation sans recourir à l'apprentissage par renforcement. L'algorithme Forward-Forward est une procédure d'apprentissage multicouche gourmande inspirée des machines de Boltzmann et de l'estimation contrastive du bruit. L'idée est d'utiliser deux passes avant pour remplacer les passes avant et arrière de rétropropagation Ces deux passes avant fonctionnent l'une sur l'autre exactement de la même manière, mais sur des données différentes, les objectifs sont également inverses. . Parmi eux, la passe positive opère sur les données réelles et ajuste les poids pour augmenter la qualité dans chaque couche cachée ; la passe négative opère sur les données négatives et ajuste les poids pour réduire la qualité dans chaque couche cachée. Dans l'article, Hinton a démontré les performances de l'algorithme FF à travers des expériences sur CIFAR-10. CIFAR-10 contient 50 000 images d'entraînement de 32 x 32 pixels avec trois canaux de couleur par pixel. Chaque image possède donc 3072 dimensions. Les arrière-plans de ces images sont complexes et très variables, et ne peuvent pas être correctement modélisés avec des données de formation aussi limitées. De manière générale, lorsqu'un réseau entièrement connecté avec deux ou trois couches cachées est formé avec la méthode de rétropropagation, à moins que la couche cachée ne soit très petite, l'effet de surajustement est très faible, de sorte que presque tous les résultats rapportés concernent des réseaux convolutifs. Étant donné que FF est destiné à être utilisé dans des réseaux où le partage de poids n'est pas réalisable, il a été comparé à un réseau de rétropropagation, qui utilise des champs récepteurs locaux pour limiter le nombre de poids sans trop limiter le nombre d'unités cachées. Le but est simplement de montrer qu'avec un grand nombre d'unités cachées, FF fonctionne de manière comparable à la rétropropagation pour des images contenant des arrière-plans très variables. Le Tableau 1 montre les performances de test des réseaux entraînés avec rétropropagation et FF, qui utilisent tous deux la décroissance du poids pour réduire le surapprentissage. Pour plus de détails sur la recherche, veuillez vous référer à l'article original. Algorithme FF

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI