Maison >Périphériques technologiques >IA >USB : le premier benchmark d'apprentissage de classification semi-supervisé qui unifie les tâches de classification visuelle, linguistique et audio

USB : le premier benchmark d'apprentissage de classification semi-supervisé qui unifie les tâches de classification visuelle, linguistique et audio

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-13 14:46:031329parcourir

Actuellement, le développement de l’apprentissage semi-supervisé bat son plein. Cependant, les critères d'apprentissage semi-supervisés existants se limitent pour la plupart aux tâches de classification en vision par ordinateur, excluant une évaluation cohérente et diversifiée des tâches de classification telles que le traitement du langage naturel et le traitement audio. De plus, la plupart des articles semi-supervisés sont publiés par de grandes institutions, et il est souvent difficile pour les laboratoires universitaires de participer aux progrès du domaine en raison des ressources informatiques limitées.

À cette fin, des chercheurs de Microsoft Research Asia, en collaboration avec des chercheurs de l'Université de Westlake, de l'Institut de technologie de Tokyo, de l'Université Carnegie Mellon, de l'Institut Max Planck et d'autres institutions, ont proposé le Unified SSL Benchmark (USB) : le premier semi- référence d'apprentissage de classification supervisée qui unifie les tâches de classification visuelle, linguistique et audio.

Cet article présente non seulement des domaines d'application plus diversifiés, mais utilise également pour la première fois un modèle visuel de pré-formation pour réduire considérablement le temps de vérification des algorithmes semi-supervisés, rendant ainsi la recherche semi-supervisée plus conviviale pour les chercheurs, en particulier petits groupes de recherche. Les articles pertinents ont été acceptés par NeurIPS 2022, la plus grande conférence universitaire internationale dans le domaine de l'intelligence artificielle.

Lien de l'article : https://arxiv.org/pdf/2208.07204.pdf

Lien du code : https://github.com/microsoft/Semi-supervised-learning

L'apprentissage supervisé crée des modèles adaptés aux données étiquetées. Lorsque l'apprentissage supervisé est utilisé pour former une grande quantité de données étiquetées de haute qualité, le modèle de réseau neuronal produit des résultats compétitifs.

Par exemple, selon les statistiques du site Web Paperswithcode, sur l'ensemble de données d'ImageNet au niveau d'un million, les méthodes traditionnelles d'apprentissage supervisé peuvent atteindre une précision de plus de 88 %. Cependant, l’obtention de grandes quantités de données étiquetées prend souvent du temps et est laborieuse.

Afin d'atténuer la dépendance aux données étiquetées, l'apprentissage semi-supervisé (SSL) s'engage à utiliser une grande quantité de données non étiquetées pour améliorer la généralisation du modèle lorsqu'il n'y a qu'une petite quantité de données étiquetées. L’apprentissage semi-supervisé est également l’un des sujets importants du machine learning. Avant l’apprentissage profond, les chercheurs dans ce domaine proposaient des algorithmes classiques tels que les machines à vecteurs de support semi-supervisées, la régularisation de l’entropie et l’entraînement collaboratif.

Apprentissage profond semi-supervisé

Avec l'essor du deep learning, les algorithmes d'apprentissage profond semi-supervisé ont également fait de grands progrès. Dans le même temps, des entreprises technologiques telles que Microsoft, Google et Meta ont également reconnu l’énorme potentiel de l’apprentissage semi-supervisé dans des scénarios pratiques.

Par exemple, Google utilise la formation d'étudiants bruyants, un algorithme semi-supervisé, pour améliorer ses performances en recherche [1]. Les algorithmes semi-supervisés les plus représentatifs utilisent actuellement la perte d'entropie croisée pour l'entraînement sur des données étiquetées et la régularisation de cohérence sur des données non étiquetées pour encourager les prédictions invariantes des perturbations d'entrée.

Par exemple, l'algorithme FixMatch[2] proposé par Google à NeurIPS 2020 utilise des technologies d'ancrage d'augmentation et de seuil fixe pour améliorer la généralisation du modèle à des données améliorées avec différentes forces et réduire l'influence des pseudo-étiquettes bruyantes. Pendant la formation, FixMatch filtre les données non étiquetées en dessous d'un seuil fourni/prédéfini par l'utilisateur.

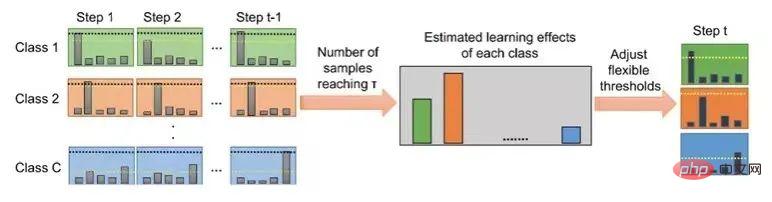

FlexMatch[3], proposé conjointement par Microsoft Research Asia et l'Institut de technologie de Tokyo à NeurIPS 2021, prend en compte les différentes difficultés d'apprentissage entre les différentes catégories, il propose donc une technologie de pseudo-étiquetage des programmes. Les classes devraient adopter des seuils différents.

Plus précisément, pour les catégories faciles à apprendre, le modèle doit définir un seuil élevé pour réduire l'impact des pseudo-étiquettes bruyantes ; pour les catégories difficiles à apprendre, le modèle doit définir un seuil bas pour encourager l'adaptation ; de cette catégorie. L'évaluation des difficultés d'apprentissage de chaque classe dépend du nombre d'échantillons de données non étiquetés entrant dans cette classe et dépassant une valeur fixe.

Dans le même temps, des chercheurs de Microsoft Research Asia ont également collaboré pour proposer une bibliothèque de codes de méthodes semi-supervisée unifiée basée sur Pytorch, TorchSSL[4], qui unifie les méthodes approfondies, les ensembles de données couramment utilisés et les résultats de référence dans ce domaine. soutien.

Figure 1 : Flux de l'algorithme FlexMatch

Figure 1 : Flux de l'algorithme FlexMatch

Problèmes et défis dans la bibliothèque de codes d'apprentissage semi-supervisé actuelle

Bien que le développement de l'apprentissage semi-supervisé bat son plein, les chercheurs ont remarqué que la plupart des codes d'apprentissage semi-supervisés actuels articles dans le sens semi-supervisé En se concentrant uniquement sur les tâches de classification de vision par ordinateur (CV), les chercheurs ne peuvent pas savoir si ces algorithmes efficaces dans les tâches de CV sont toujours efficaces dans différents domaines pour d'autres domaines, tels que le traitement du langage naturel (NLP) et l'audio. traitement (audio).

De plus, la plupart des articles semi-supervisés sont publiés par de grandes institutions, et il est souvent difficile pour les laboratoires académiques de participer à la promotion du développement de ce domaine en raison des limitations des ressources informatiques. De manière générale, les référentiels d'apprentissage semi-supervisé rencontrent actuellement les deux problèmes suivants :

(1) Diversité insuffisante. La plupart des critères d'apprentissage semi-supervisé existants se limitent aux tâches de classification des CV (c'est-à-dire CIFAR-10/100, SVHN, STL-10 et ImageNet), excluant une évaluation cohérente et diversifiée des tâches de classification telles que la PNL, l'audio, etc. , tandis qu'en PNL, le manque de données étiquetées suffisantes dans et audio est également un problème courant.

(2) Cela prend beaucoup de temps et n'est pas convivial pour le monde universitaire. Les références d'apprentissage semi-supervisé existantes telles que TorchSSL prennent souvent du temps et ne sont pas respectueuses de l'environnement, car elles nécessitent souvent de former des modèles de réseaux neuronaux profonds à partir de zéro. Plus précisément, l'évaluation de FixMatch[1] à l'aide de TorchSSL nécessite environ 300 jours GPU. Des coûts de formation aussi élevés rendent la recherche liée au SSL inabordable pour de nombreux laboratoires de recherche (en particulier ceux du milieu universitaire ou des petits groupes de recherche), entravant ainsi le progrès du SSL.

USB : une nouvelle bibliothèque de référence avec des tâches diverses et plus conviviale pour les chercheurs

Afin de résoudre les problèmes ci-dessus, des chercheurs de Microsoft Research Asia se sont associés à l'Université Westlake, à l'Institut de technologie de Tokyo, à l'Université Carnegie Mellon, à Max- Des chercheurs de l'Institut Planck et d'autres institutions ont proposé le Unified SSL Benchmark (USB), qui est le premier benchmark d'apprentissage de classification semi-supervisé qui unifie les tâches de classification visuelle, linguistique et audio.

Par rapport aux précédents benchmarks d'apprentissage semi-supervisé (tels que TorchSSL) qui se concentraient uniquement sur un petit nombre de tâches de vision, ce benchmark introduit non seulement des domaines d'application plus diversifiés, mais utilise également un modèle de vision pré-entraîné (vision pré-entraînée Transformer) pour la première fois afin de réduire considérablement le nombre de tâches visuelles. Le temps de vérification des algorithmes semi-supervisés a été réduit (de 7 000 heures GPU à 900 heures GPU), rendant la recherche semi-supervisée plus conviviale pour les chercheurs, en particulier les petites recherches. groupes.

Les articles pertinents ont été acceptés par NeurIPS 2022, la plus grande conférence universitaire dans le domaine de l'intelligence artificielle internationale. (Cliquez sur "Lire le texte original" pour en savoir plus)

Solution fournie par USB

Alors, comment l'USB peut-il résoudre d'un seul coup les problèmes des benchmarks semi-supervisés actuels ? Les chercheurs ont principalement apporté les améliorations suivantes :

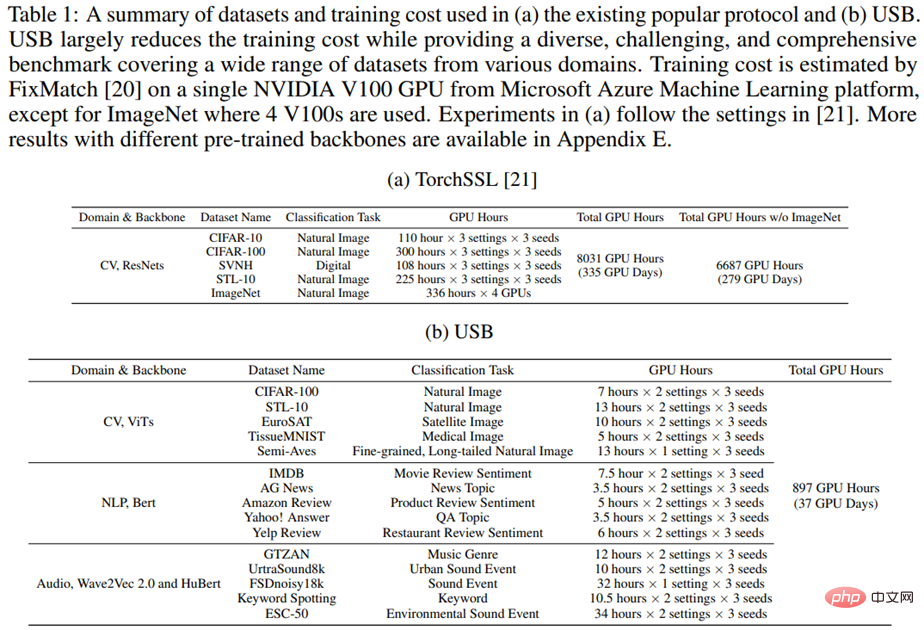

(1) Pour améliorer la diversité des tâches, l'USB a introduit 5 ensembles de données CV, 5 ensembles de données PNL et 5 ensembles de données audio, et a fourni des critères de référence diversifiés et stimulants, permettant une évaluation cohérente sur plusieurs tâches provenant de différents domaines. Le tableau 1 fournit une comparaison détaillée des tâches et du temps de formation entre USB et TorchSSL.

Tableau 1 : Comparaison des tâches et du temps de formation entre les frameworks USB et TorchSSL

(2) Afin d'améliorer l'efficacité de la formation, les chercheurs ont introduit Vision Transformer pré-entraîné dans SSL au lieu de en partant de zéro Formation ResNets. Plus précisément, les chercheurs ont découvert que l'utilisation de modèles pré-entraînés peut réduire considérablement le nombre d'itérations d'entraînement sans affecter les performances (par exemple, réduire le nombre d'itérations d'entraînement pour une tâche CV de 1 million d'étapes à 200 000 étapes).

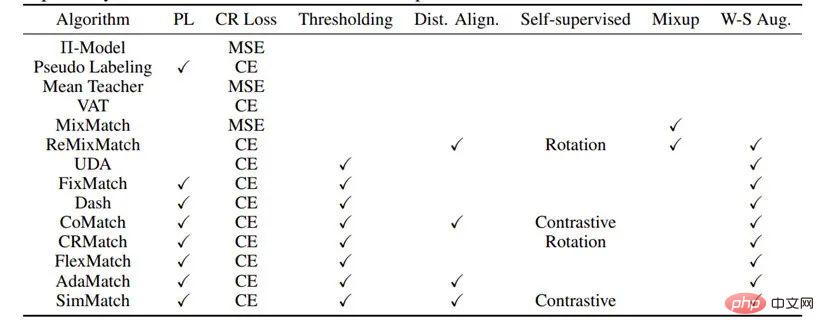

(3) Afin d'être plus conviviaux pour les chercheurs, les chercheurs ont implémenté 14 algorithmes SSL en open source et ont ouvert une bibliothèque de codes modulaires et des fichiers de configuration associés permettant aux chercheurs de reproduire facilement les résultats dans le rapport USB. Pour démarrer rapidement, USB fournit également une documentation détaillée et des didacticiels. De plus, USB fournit également le package pip permettant aux utilisateurs d'appeler directement l'algorithme SSL. Les chercheurs promettent de continuer à ajouter de nouveaux algorithmes (tels que des algorithmes semi-supervisés déséquilibrés, etc.) et des ensembles de données plus complexes à l'USB à l'avenir. Le tableau 2 montre les algorithmes et modules déjà pris en charge en USB.

Tableau 2 : Algorithmes et modules pris en charge en USB

L'apprentissage semi-supervisé a d'importantes recherches futures en exploitant de grandes quantités de données non étiquetées pour former des modèles et une valeur d'application plus précis et plus robustes. Les chercheurs de Microsoft Research Asia sont impatients d'utiliser ces travaux USB pour aider le monde universitaire et l'industrie à progresser davantage dans le domaine de l'apprentissage semi-supervisé.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI