Maison >Périphériques technologiques >IA >Les développeurs éclatent de rire ! La fuite choquante de LLaMa a déclenché une frénésie de remplacement de ChatGPT, et le domaine LLM open source a changé.

Les développeurs éclatent de rire ! La fuite choquante de LLaMa a déclenché une frénésie de remplacement de ChatGPT, et le domaine LLM open source a changé.

- 王林avant

- 2023-04-12 23:40:061209parcourir

Qui aurait pensé qu'une fuite inattendue de LLaMA déclencherait la plus grande étincelle d'innovation dans le domaine du LLM open source.

Une série d'alternatives open source ChatGPT exceptionnelles - "Alpaca Family", est alors apparue de manière éblouissante.

La friction entre l'open source et la distribution basée sur des API est l'une des contradictions les plus pressantes de l'écosystème de l'IA générative.

Dans l'espace texte-image, la sortie de Stable Diffusion démontre clairement que l'open source est un mécanisme de distribution viable pour le modèle sous-jacent.

Cependant, ce n'est pas le cas dans le domaine des grands modèles de langage. Les plus grandes avancées dans ce domaine, comme les modèles tels que GPT-4, Claude et Cohere, ne sont disponibles que via les API.

Les alternatives open source à ces modèles ne démontrent pas le même niveau de performance, notamment dans la capacité à suivre les instructions humaines. Cependant, une fuite inattendue a complètement changé la donne.

Fuite "Epic" de LLaMA

Il y a quelques semaines, Meta AI a lancé le grand modèle de langage LLaMA.

LLaMA a différentes versions, dont les paramètres 7B, 13B, 33B et 65B. Bien qu'il soit plus petit que GPT-3, il peut rivaliser avec les performances de GPT-3 sur de nombreuses tâches.

LLaMA n'était pas open source au début, mais une semaine après sa sortie, le modèle a soudainement fuité sur 4chan, déclenchant des milliers de téléchargements.

Cet incident peut être qualifié de « fuite épique » car il est devenu une source inépuisable d'innovation dans le domaine des grands modèles de langage.

En quelques semaines seulement, l'innovation des agents LLM bâtis sur celle-ci a explosé.

Alpaca, Vicuna, Koala, ChatLLaMA, FreedomGPT, ColossalChat... Revenons sur comment est née cette explosion de la "famille Alpaca".

Alpaca À la mi-mars, le grand modèle Alpaca sorti par Stanford est devenu populaire.

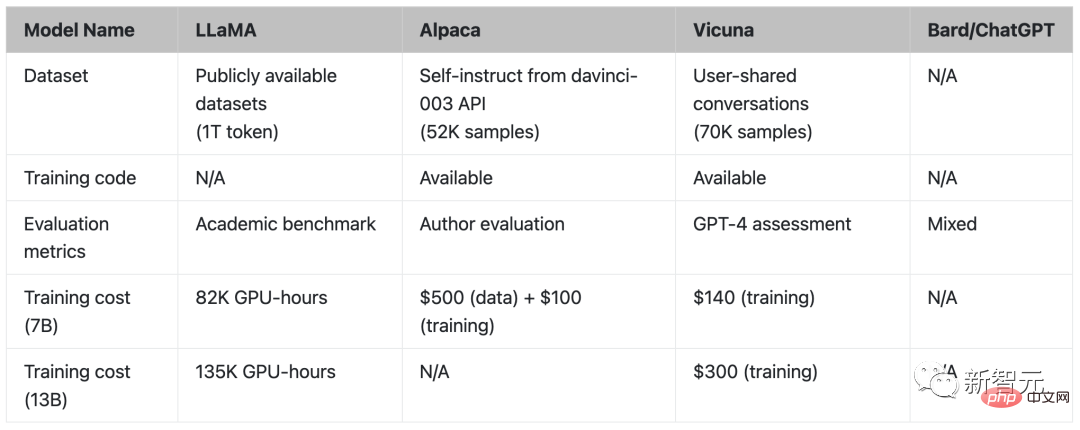

Alpaca est un tout nouveau modèle affiné à partir du LLaMA 7B de Meta. Il n'utilise que 52 000 données et ses performances sont approximativement égales à GPT-3.5.

La clé est que le coût de la formation est extrêmement faible, moins de 600 dollars américains.

Les chercheurs de Stanford ont comparé GPT-3.5 (text-davinci-003) et Alpaca 7B et ont constaté que les performances des deux modèles sont très similaires. Alpaca gagne 90 fois contre 89 contre GPT-3.5.

Pour l'équipe de Stanford, si elle souhaite former un modèle de suivi d'instruction de haute qualité dans les limites du budget, elle doit faire face à deux défis importants : disposer d'un modèle de langage pré-entraîné puissant et d'un enseignement de haute qualité. Suivre les données .

Juste, le modèle LLaMA fourni aux chercheurs universitaires a résolu le premier problème.

Pour le deuxième défi, l'article « Auto-instruction : aligner le modèle de langage avec les instructions auto-générées » a donné une bonne inspiration, c'est-à-dire utiliser des modèles de langage forts existants pour générer automatiquement des données d'instruction.

La plus grande faiblesse du modèle LLaMA est le manque de mise au point pédagogique. L'une des plus grandes innovations d'OpenAI est l'utilisation du réglage des instructions sur GPT-3.

À cet égard, Stanford a utilisé un grand modèle de langage existant pour générer automatiquement des démonstrations des instructions suivantes.

Maintenant, Alpaca est directement considéré comme « Diffusion stable de grands modèles de texte » par les internautes.

Vicuna Fin mars, des chercheurs de l'UC Berkeley, de l'Université Carnegie Mellon, de l'Université de Stanford et de l'UC San Diego ont ouvert Vicuna, une version affinée de LLaMA qui correspond aux performances de GPT-4.

Le paramètre Vicuna de 13 milliards est formé en affinant LLaMA sur les conversations partagées des utilisateurs collectées par ShareGPT. Le coût de la formation est de près de 300 $ US.

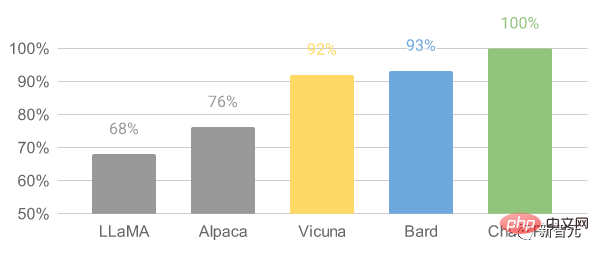

Les résultats montrent que Vicuna-13B atteint des capacités comparables à ChatGPT et Bard dans plus de 90 % des cas.

Pour le processus de formation Vicuna-13B, les détails sont les suivants :

Tout d'abord, les chercheurs ont collecté environ 70 000 conversations sur le site Web de partage de conversations ChatGPT ShareGPT.

Ensuite, les chercheurs ont optimisé le script de formation fourni par Alpaca pour permettre au modèle de mieux gérer plusieurs cycles de conversations et de longues séquences. Ensuite, PyTorch FSDP a été utilisé pour une journée de formation sur 8 GPU A100.

En termes d'évaluation de la qualité du modèle, les chercheurs ont créé 80 questions différentes et évalué les résultats du modèle à l'aide de GPT-4.

Pour comparer différents modèles, les chercheurs ont combiné les résultats de chaque modèle en une seule invite, puis ont laissé GPT-4 évaluer quel modèle donnait la meilleure réponse.

Comparaison de LLaMA, Alpaca, Vicuna et ChatGPT

Koala

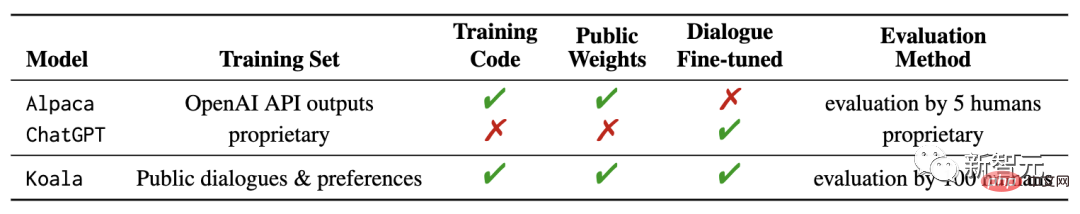

Récemment, l'UC Berkeley AI Research Institute (BAIR) a publié un nouveau modèle "Koala", correspondant à Par rapport à l'utilisation précédente des données GPT d'OpenAI pour le réglage fin des instructions, Koala se distingue par le fait qu'il utilise des données de haute qualité obtenues à partir du réseau pour la formation.

Les résultats de recherche montrent que Koala peut répondre efficacement à une variété de requêtes des utilisateurs, générant des réponses souvent plus populaires qu'Alpaca, et au moins aussi efficaces que ChatGPT dans la moitié des cas.

Les chercheurs espèrent que les résultats de cette expérience pourront approfondir la discussion sur les performances relatives des grands modèles fermés par rapport aux petits modèles publics, d'autant plus que les résultats montrent que pour les petits modèles qui peuvent être exécutés localement, s'ils sont soigneusement collectés Les données de formation peuvent également atteindre les performances de grands modèles.

En fait, les résultats expérimentaux du modèle Alpaca précédemment publiés par l'Université de Stanford et le réglage fin des données LLaMA basées sur le modèle GPT d'OpenAI ont montré que les données correctes peuvent améliorer considérablement les petits modèles open source.

C'est également l'intention initiale des chercheurs de Berkeley de développer et de publier le modèle Koala, dans l'espoir de fournir une autre preuve expérimentale des résultats de cette discussion.

Koala affine les données d'interaction gratuites obtenues sur Internet et accorde une attention particulière à l'inclusion des données interagissant avec des modèles fermés hautes performances tels que ChatGPT.

Les chercheurs n'ont pas cherché à explorer autant de données réseau que possible pour maximiser la quantité de données, mais se sont concentrés sur la collecte d'un petit ensemble de données de haute qualité, comprenant des données distillées ChatGPT, des données open source, etc.

ChatLLaMA

Nebuly a ChatLLaMA open source, un framework qui nous permet de créer des assistants conversationnels en utilisant nos propres données.

ChatLLaMA nous permet de créer des assistants hyper-personnalisés de type ChatGPT en utilisant nos propres données et le moins de calculs possible.

En supposant qu'à l'avenir, nous ne comptons plus sur un seul grand assistant qui « gouverne tout le monde », chacun peut créer sa propre version personnalisée des assistants ChatGPT, qui peuvent répondre à divers besoins humains.

Cependant, créer un tel assistant personnalisé nécessite des efforts sur plusieurs fronts : création d'ensembles de données, formation efficace à l'aide de RLHF et optimisation des inférences.

Le but de cette bibliothèque est de donner aux développeurs une tranquillité d'esprit en éliminant le travail nécessaire pour optimiser et collecter de grandes quantités de données.

ChatLLaMA est conçu pour aider les développeurs à gérer une variété de cas d'utilisation, tous liés à la formation RLHF et à l'inférence optimisée. Voici quelques cas d'utilisation à titre de référence :

- Créez un assistant personnalisé de type ChatGPT pour des tâches verticales spécifiques (juridique, médicale, jeux, recherche universitaire, etc.) ;

- Vous souhaitez travailler avec des données limitées en local ; infrastructure matérielle, Former un assistant efficace de type ChatGPT

- Vous souhaitez créer votre propre version personnalisée d'un assistant de type ChatGPT tout en évitant le contrôle des coûts

- Vous voulez savoir quelle architecture modèle (LLaMA, OPT, GPTJ, etc.) me convient le mieux Exigences en termes de matériel, de budget informatique et de performances

- Vous souhaitez aligner l'Assistant sur mes valeurs personnelles/d'entreprise, ma culture, ma marque et mon manifeste ;

FreedomGPT

Construit avec Electron et React, FreedomGPT est une application de bureau qui permet aux utilisateurs d'exécuter LLaMA sur leur machine locale.

Les caractéristiques de FreedomGPT ressortent clairement de son nom : les questions auxquelles il répond ne sont soumises à aucune censure ni filtrage de sécurité.

Cette application est développée par Age of AI, une société de capital-risque en IA.

FreedomGPT est construit sur Alpaga. FreedomGPT utilise les caractéristiques distinctives d'Alpaca, car Alpaca est relativement plus facile d'accès et de personnalisation que les autres modèles.

ChatGPT suit la politique d'utilisation d'OpenAI et restreint la haine, l'automutilation, les menaces, la violence et le contenu sexuel.

Contrairement à ChatGPT, FreedomGPT répond aux questions sans parti pris ni favoritisme et n'hésitera pas à répondre à des sujets polémiques ou polémiques.

FreedomGPT a même répondu « Comment fabriquer une bombe à la maison », qu'OpenAI a spécifiquement supprimé de GPT-4.

FreedomGPT est unique car il surmonte les restrictions de censure et aborde des sujets controversés sans aucune garantie. Son symbole est la Statue de la Liberté car ce grand modèle de langage unique et audacieux symbolise la liberté.

FreedomGPT peut même s'exécuter localement sur votre ordinateur sans avoir besoin d'une connexion Internet.

De plus, une version open source sera bientôt publiée, permettant aux utilisateurs et aux organisations de la personnaliser entièrement.

ColossalChat

ColossalChat proposé par l'UC Berkeley n'a besoin que de moins de 10 milliards de paramètres pour atteindre des capacités bilingues en chinois et en anglais, et l'effet est équivalent à ChatGPT et GPT-3.5.

De plus, ColossalChat, basé sur le modèle LLaMA, reproduit également le processus complet RLHF, qui est actuellement le projet open source le plus proche du parcours technique original de ChatGPT.

Ensemble de données de formation bilingue chinois-anglais

ColossalChat a publié un ensemble de données bilingues contenant environ 100 000 paires de questions et réponses en chinois et en anglais.

Cet ensemble de données est collecté et nettoyé à partir de scénarios de problèmes réels sur les plateformes de médias sociaux en tant qu'ensemble de données de départ, étendu à l'aide de l'auto-instruction, et le coût d'annotation est d'environ 900 $.

Comparé aux ensembles de données générés par d'autres méthodes d'auto-instruction, cet ensemble de données contient des données de départ plus réalistes et plus diversifiées, couvrant un plus large éventail de sujets.

Cet ensemble de données est adapté à la mise au point et à l'entraînement RLHF. ColossalChat peut obtenir une meilleure interaction conversationnelle en fournissant des données de haute qualité et prend également en charge le chinois.

Pipeline RLHF complet

Il y a trois étapes pour la réplication de l'algorithme de RLHF :

Dans RLHF-Stage1, l'ensemble de données bilingues ci-dessus est utilisé pour l'instruction supervisée afin d'affiner les réglages. le modèle.

Dans RLHF-Stage2, le modèle de récompense est formé en classant manuellement différentes sorties de la même invite pour attribuer les scores correspondants, puis en supervisant la formation du modèle de récompense.

Dans RLHF-Stage3, l'algorithme d'apprentissage par renforcement est utilisé, qui est la partie la plus complexe du processus de formation.

Je pense que d'autres projets seront bientôt publiés.

Personne ne s'attendait à ce que cette fuite inattendue de LLaMA déclenche la plus grande étincelle d'innovation dans le domaine du LLM open source.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI