Maison >Périphériques technologiques >IA >Berkeley a mis en open source le premier ensemble de données haute définition et le premier modèle de prédiction dans les scénarios de stationnement, prenant en charge la reconnaissance de cibles et la prédiction de trajectoire.

Berkeley a mis en open source le premier ensemble de données haute définition et le premier modèle de prédiction dans les scénarios de stationnement, prenant en charge la reconnaissance de cibles et la prédiction de trajectoire.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 23:40:011905parcourir

Alors que la technologie de conduite autonome continue d'évoluer, le comportement du véhicule et la prédiction de trajectoire revêtent une importance extrêmement importante pour une conduite efficace et sûre. Bien que les méthodes traditionnelles de prédiction de trajectoire telles que la déduction de modèles dynamiques et l’analyse d’accessibilité présentent les avantages d’une forme claire et d’une forte interprétabilité, leurs capacités de modélisation de l’interaction entre l’environnement et les objets sont relativement limitées dans des environnements de trafic complexes. Ainsi, ces dernières années, un grand nombre de recherches et d'applications ont été basées sur diverses méthodes d'apprentissage profond (telles que LSTM, CNN, Transformer, GNN, etc.) et divers ensembles de données tels que BDD100K, nuScenes, Stanford Drone, ETH. /UCY, INTERACTION, ApolloScape, etc. ont également émergé, fournissent un support solide pour la formation et l'évaluation de modèles de réseaux neuronaux profonds tels que GroupNet, Trajectron++, MultiPath, etc.

Les modèles et ensembles de données ci-dessus sont concentrés dans des scénarios de conduite routière normale et utilisent pleinement les infrastructures et les fonctionnalités telles que les lignes de voie et les feux de circulation pour faciliter le processus de prévision en raison des limitations des règles de circulation et des schémas de mouvement ; de la plupart des véhicules sont également limités. Plus clair. Cependant, dans le « dernier kilomètre » des scénarios de conduite autonome et de stationnement autonome, nous serons confrontés à de nombreuses nouvelles difficultés :

- Les règles de circulation et les exigences en matière de lignes de voie dans le parking ne sont pas strictes, et les véhicules ne sont pas stricts. Conduire fréquemment à volonté et « prendre des raccourcis »

- Afin d'accomplir la tâche de stationnement, le véhicule doit effectuer des actions de stationnement plus complexes, notamment des marches arrière, un stationnement, une direction fréquentes, etc. Dans le cas des conducteurs inexpérimentés, le stationnement peut devenir un long processus

- Il y a de nombreux obstacles et encombrements dans le parking, et la distance entre les véhicules est courte. Un peu de négligence peut entraîner des collisions et des rayures

-

Stationnement. Les piétons traversent souvent le site à volonté et les véhicules ont besoin de davantage d'actions d'évitement.

Dans un tel scénario, il est difficile d'obtenir l'effet souhaité en appliquant simplement le modèle de prédiction de trajectoire existant, et le modèle de recyclage ne prend pas en charge les données correspondantes. . Les ensembles de données actuels basés sur les scènes de stationnement, tels que CNRPark+EXT et CARPK, sont uniquement conçus pour la détection de places de stationnement gratuites. Les images proviennent du point de vue à la première personne des caméras de surveillance, ont de faibles taux d'échantillonnage et comportent de nombreuses occlusions, ce qui les rend incapables de le faire. être utilisé pour la prédiction de trajectoire.

Lors de la 25e Conférence internationale de l'IEEE sur les systèmes de transport intelligents (IEEE ITSC 2022) qui vient de se terminer en octobre 2022, des chercheurs de l'Université de Californie à Berkeley ont publié la première vidéo haute définition d'une scène de stationnement. ensemble de données de trajectoire, et sur la base de cet ensemble de données, un modèle de prédiction de trajectoire nommé "ParkPredict+" a été proposé en utilisant l'architecture CNN et Transformer.

- Lien papier : https://arxiv.org/abs/2204.10777

- Application d'essai et de téléchargement de l'ensemble de données : https://sites.google.com /berkeley.edu/dlp-dataset (Si vous ne pouvez pas y accéder, vous pouvez essayer la page alternative https://www.php.cn/link/966eaa9527eb956f0dc8788132986707)

- API Python Dataset : https://github. com/ MPC-Berkeley/dlp-dataset

Informations sur l'ensemble de données

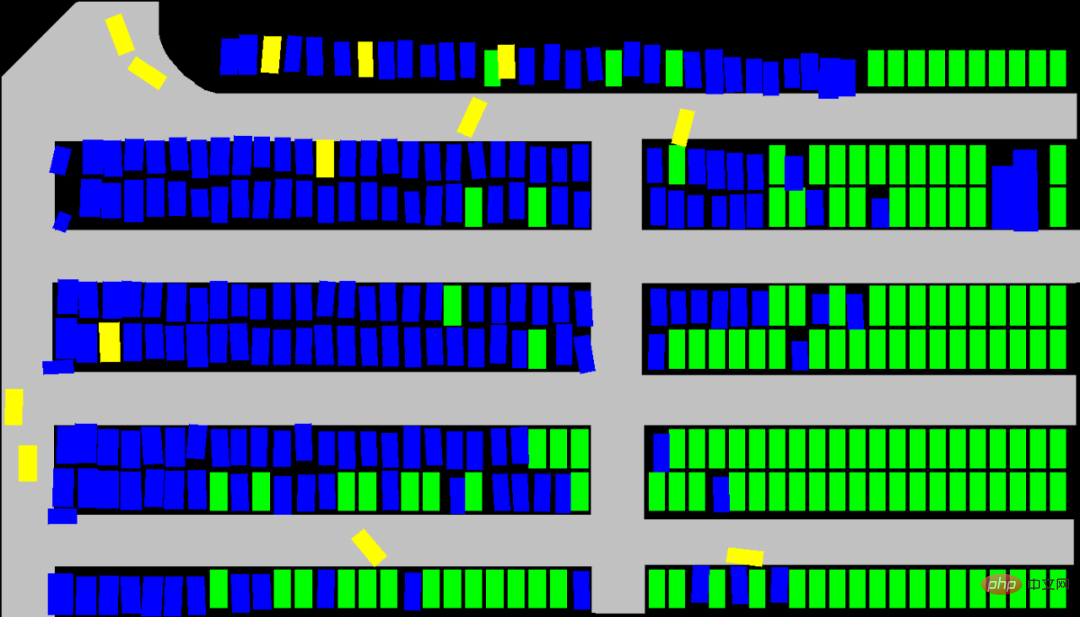

L'ensemble de données a été collecté par un drone, avec une durée totale de 3,5 heures, une résolution vidéo de 4K et un taux d'échantillonnage de 25 Hz. La vue couvre une superficie de parking d'environ 140 mx 80 m, avec un total d'environ 400 places de stationnement. L'ensemble de données est annoté avec précision et un total de 1 216 véhicules à moteur, 3 904 vélos et 3 904 trajectoires de piétons ont été collectés.

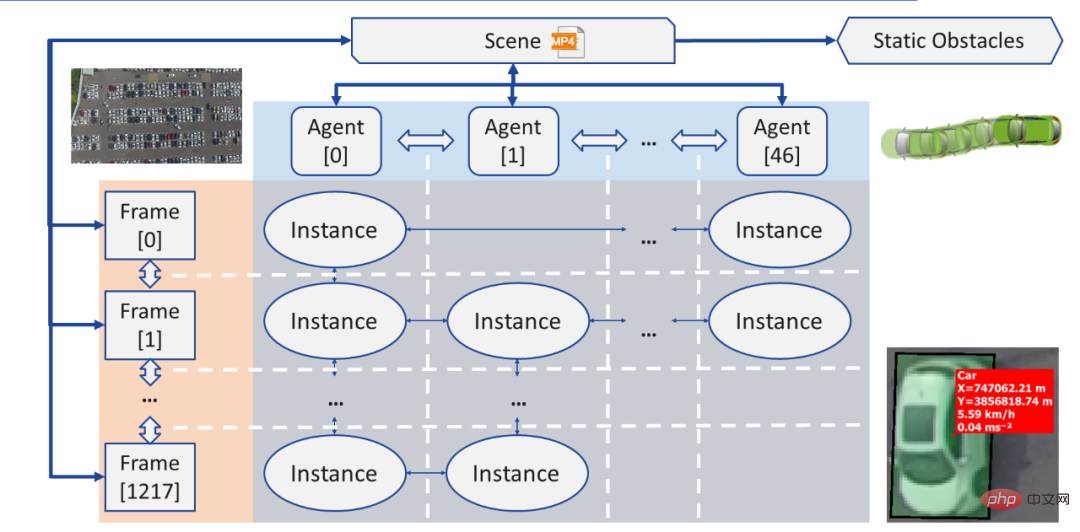

Après retraitement, les données de trajectoire peuvent être lues sous forme de JSON et chargées dans la structure de données du graphe de connexion (Graph) :

- Individu (Agent) : Chaque agent (Agent) est un objet se déplaçant dans la scène actuelle (Scène). Il possède des attributs tels que la forme géométrique et le type. Sa trajectoire de mouvement est stockée sous forme de liste chaînée contenant des instances (Instance). (Liste chaînée)

- Instance : Chaque instance est l'état d'un individu (Agent) dans un cadre (Frame), y compris sa position, son angle de rotation, sa vitesse et son accélération. Chaque instance contient des pointeurs vers l'instance de l'individu dans l'image précédente et l'image suivante

- Frame (Frame) : Chaque image (Frame) est un point d'échantillonnage, qui contient toutes les instances visibles à l'heure actuelle (Instance), et des pointeurs pointant vers l'image précédente et l'image suivante

- Obstacle (Obstacle) : Les obstacles sont des objets qui n'ont pas bougé du tout dans cet enregistrement, y compris la position, le coin et la taille géométrique de chaque objet

- Scène : Chaque scène (Scène) correspond à un fichier vidéo enregistré, qui contient des pointeurs pointant vers les première et dernière images de l'enregistrement, tous les individus (Agents) et tous les obstacles (Obstacles)

L'ensemble de données est disponible en deux formats de téléchargement :

JSON uniquement (recommandé) : les fichiers JSON contiennent le type, la forme, la trajectoire et d'autres informations de tous les individus, et peuvent être téléchargés via le Python open source L'API lit directement , prévisualise et génère des images sémantiques (images sémantiques). Si l’objectif de recherche est uniquement la prédiction de trajectoires et de comportements, le format JSON peut répondre à tous les besoins.

Vidéo originale et annotation : Si la recherche est basée sur des sujets de champ de vision industrielle tels que la détection, la séparation et le suivi de cibles basés sur l'image brute de la caméra (Raw Image), alors vous devrez peut-être télécharger la vidéo originale et l'étiquette. Si cela est nécessaire, la recherche doit être clairement décrite dans la demande d’ensemble de données. De plus, le fichier d'annotation doit être analysé lui-même.

Modèle de prédiction de comportement et de trajectoire : ParkPredict+

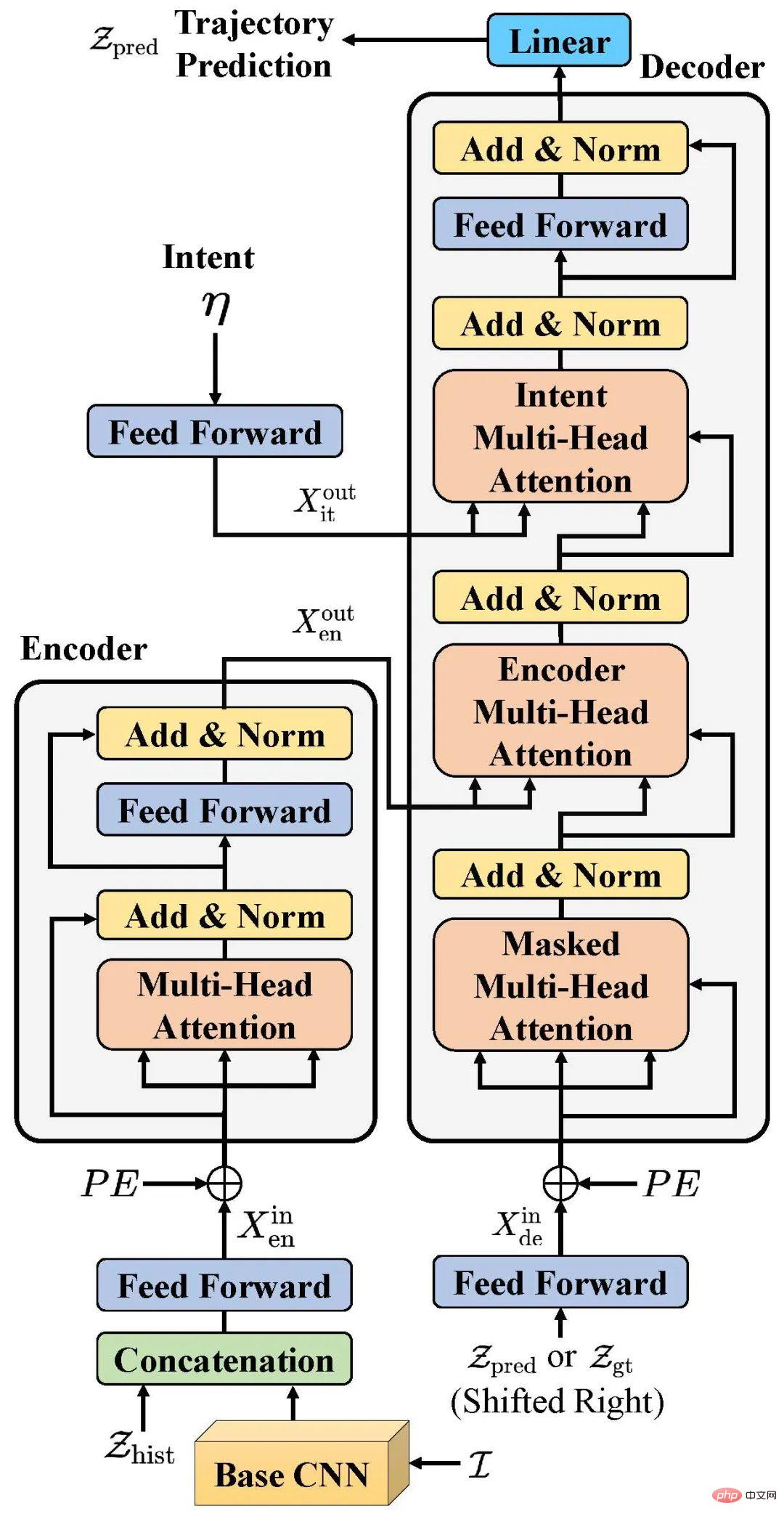

À titre d'exemple d'application, dans l'article "ParkPredict+ : Multimodal Intent and Motion Prediction for Vehicles in Parking Lots with CNN and Transformer" à l'IEEE ITSC 2022, l'équipe de recherche a utilisé ces données ensemble, sur la base de l'architecture CNN et Transformer, la prédiction de l'intention (Intent) et de la trajectoire (Trajectory) du véhicule dans la scène du parking est réalisée.

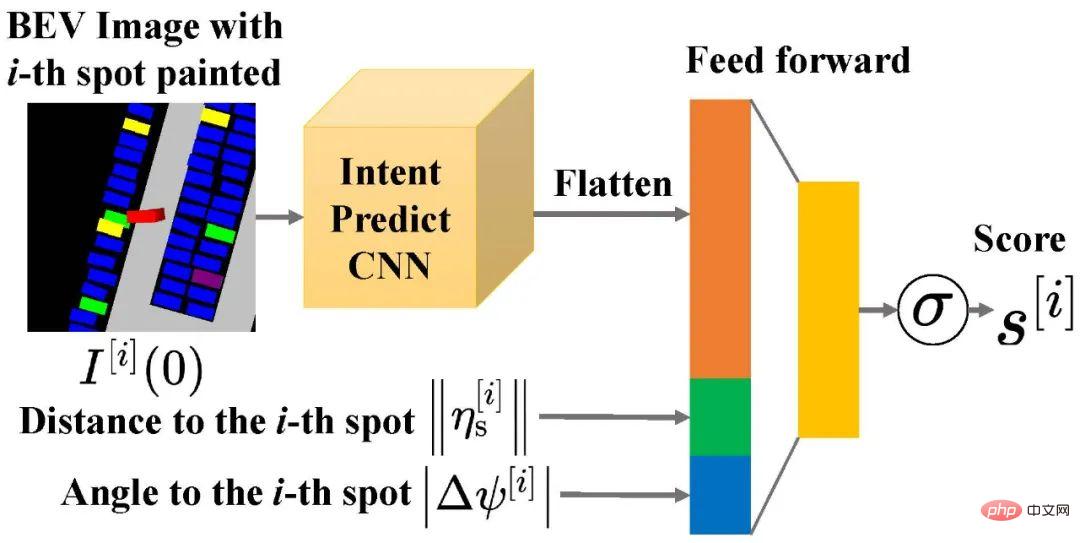

L'équipe a utilisé le modèle CNN pour prédire la probabilité de distribution de l'intention du véhicule (Intent) en créant des images sémantiques. Ce modèle n'a besoin que de construire des informations environnementales locales du véhicule et peut modifier en permanence le nombre d'intentions disponibles en fonction de l'environnement actuel.

L'équipe a réalisé une prédiction multimodale d'intention et de comportement en améliorant le modèle Transformer et en fournissant les résultats de prédiction d'intention, l'historique des mouvements du véhicule et la carte sémantique de l'environnement environnant en entrée.

Résumé

- En tant que premier ensemble de données de haute précision pour les scénarios de stationnement, l'ensemble de données Dragon Lake Parking (DLP) peut permettre la reconnaissance et le suivi de cibles à grande échelle, la détection d'espaces de stationnement gratuits, les comportements et trajectoires des véhicules et des piétons dans ce domaine. Les données de scénario et la prise en charge des API sont fournies pour la prédiction, l'apprentissage par imitation et d'autres recherches

- En utilisant l'architecture CNN et Transformer, le modèle ParkPredict+ montre de bonnes capacités de prédiction de comportement et de trajectoire dans les scénarios de stationnement

- Dragon Lake Parking (DLP) L'ensemble de données est ouvert pour essai et candidature. Vous pouvez en savoir plus en visitant la page d'accueil de l'ensemble de données https://sites.google.com/berkeley.edu/dlp-dataset (si vous ne pouvez pas y accéder, vous pouvez essayer la page alternative https://www.php.cn/link/966eaa9527eb956f0dc8788132986707 )

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI