Maison >Périphériques technologiques >IA >L'ajout d'effets spéciaux ne nécessite qu'une phrase ou une image. La société Stable Diffusion a utilisé AIGC pour jouer de nouveaux tours.

L'ajout d'effets spéciaux ne nécessite qu'une phrase ou une image. La société Stable Diffusion a utilisé AIGC pour jouer de nouveaux tours.

- PHPzavant

- 2023-04-12 23:46:011431parcourir

Je pense que beaucoup de gens ont déjà compris le charme de la technologie de l'IA générative, surtout après avoir vécu l'épidémie d'AIGC en 2022. La technologie de génération de texte en image représentée par Stable Diffusion était autrefois populaire partout dans le monde, et d'innombrables utilisateurs ont afflué pour exprimer leur imagination artistique à l'aide de l'IA...

Comparé à l'édition d'images, le montage vidéo est un problème de tâche plus exigeant, qui nécessite de synthétiser de nouvelles actions, non seulement de modifier l'apparence visuelle, mais également de maintenir une cohérence temporelle.

De nombreuses entreprises explorent cette piste. Il y a quelque temps, Google a publié Dreamix pour appliquer le modèle de diffusion vidéo conditionnelle (VDM) au montage vidéo.

Récemment, Runway, une société qui a participé à la création de Stable Diffusion, a lancé un nouveau modèle d'intelligence artificielle "Gen-1", qui peut convertir des vidéos existantes en nouvelles en appliquant des invites de texte ou tout autre style spécifié par des images de référence. . vidéo.

Lien papier : https://arxiv.org/pdf/2302.03011.pdf

Page d'accueil du projet : https://research.runwayml.com/gen1

En 2021, Runway a collaboré avec des chercheurs de l'Université de Munich pour construire la première version de Stable Diffusion. Ensuite, Stability AI, une startup britannique, est intervenue pour financer les dépenses de calcul nécessaires à l'entraînement du modèle sur davantage de données. En 2022, Stability AI introduit la diffusion stable dans le courant dominant, la transformant d'un projet de recherche en un phénomène mondial.

Runway a déclaré espérer que Gen-1 fera pour la vidéo ce que Stable Diffusion a fait pour les images.

«Nous avons assisté à une explosion des modèles de génération d'images», a déclaré Cristóbal Valenzuela, PDG et co-fondateur de Runway. "Je crois vraiment que 2023 sera l'année de la vidéo."

Plus précisément, Gen-1 prend en charge plusieurs modes d'édition :

1. Transférez le style de n’importe quelle image ou invite sur chaque image de votre vidéo.

2. Transformez votre modèle en un rendu entièrement stylisé et animé.

3. Isolez les sujets dans les vidéos et modifiez-les à l'aide de simples invites textuelles.

4. Rendu. Transformez le rendu sans texture en sortie photoréaliste en appliquant des images d'entrée ou des invites.

5. Personnalisation. Libérez toute la puissance de la génération 1 en personnalisant votre modèle pour des résultats plus fidèles.

Dans une démo publiée sur le site officiel de la société, elle montre comment Gen-1 peut changer les styles vidéo en douceur, jetons un coup d'œil à quelques exemples.

Par exemple, pour transformer « les gens dans la rue » en « marionnettes d'argile », vous n'avez besoin que d'une seule ligne d'invite :

ou pour transformer « des livres empilés sur la table » en « paysage urbain la nuit" :

De « courir sur la neige » à « marcher sur la lune » :

La jeune fille s'est transformée en une ancienne sage en quelques secondes :

Paper Details

Les effets visuels et le montage vidéo sont omniprésents dans le paysage médiatique contemporain. À mesure que les plateformes vidéo gagnent en popularité, le besoin d’outils de montage vidéo plus intuitifs et plus puissants augmente. Cependant, en raison de la nature temporelle des données vidéo, le montage dans ce format reste complexe et prend du temps. Les modèles d’apprentissage automatique de pointe sont très prometteurs pour améliorer le processus d’édition, mais de nombreuses méthodes doivent trouver un équilibre entre cohérence temporelle et détails spatiaux.

Les méthodes génératives de synthèse d'images ont récemment connu une phase de croissance rapide en termes de qualité et de popularité en raison de l'introduction de modèles de diffusion entraînés sur des ensembles de données à grande échelle. Certains modèles conditionnels au texte, tels que DALL-E 2 et Stable Diffusion, permettent aux utilisateurs novices de générer des images détaillées avec juste une invite de texte. Les modèles de diffusion latente fournissent des méthodes efficaces pour générer des images par composition dans un espace perceptuellement compressé.

Dans cet article, nous proposons un modèle de diffusion vidéo contrôlable, sensible à la structure et au contenu, formé sur un ensemble de données à grande échelle de vidéos non censurées et de données texte-image appariées. Nous avons choisi d'utiliser l'estimation de profondeur monoculaire pour représenter la structure et les intégrations prédites par un réseau neuronal pré-entraîné pour représenter le contenu.

Cette méthode fournit plusieurs modes de contrôle puissants au cours de son processus de génération : Premièrement, à l'instar du modèle de synthèse d'image, les chercheurs entraînent le modèle pour que le contenu vidéo déduit, tel que son apparence ou son style, soit cohérent avec celui fourni par l'utilisateur. image ou L'invite de texte correspond (Figure 1). Deuxièmement, inspirés par le processus de diffusion, les chercheurs ont appliqué un processus de masquage des informations à la représentation structurelle afin de pouvoir sélectionner dans quelle mesure le modèle prend en charge une structure donnée. Enfin, nous ajustons le processus d'inférence grâce à une méthode de guidage personnalisée inspirée du guidage sans classification pour contrôler la cohérence temporelle des segments générés.

Globalement, les points forts de cette recherche sont les suivants :

- Le modèle de diffusion latente est étendu au domaine de la génération vidéo en introduisant une couche temporelle dans le modèle d'image pré-entraîné et en s'entraînant conjointement sur les images et videos ;

- propose un modèle sensible à la structure et au contenu pour modifier les vidéos guidées par des exemples d'images ou de texte. Le montage est effectué entièrement en temps d'inférence, ne nécessitant aucune formation ou prétraitement supplémentaire pour chaque vidéo

- Démontre un contrôle complet sur le temps, le contenu et la cohérence structurelle ; Cette étude est la première à montrer qu'un entraînement conjoint sur des données d'images et de vidéos permet de contrôler la cohérence temporelle par le temps d'inférence. Pour une cohérence structurelle, l'entraînement à différents niveaux de détail dans la représentation permet de choisir les paramètres souhaités lors de l'inférence

- Dans une étude utilisateur, notre méthode a été préférée à plusieurs autres méthodes ;

- Le modèle entraîné peut être personnalisé en affinant un petit ensemble d'images pour produire des vidéos spécifiques à un sujet plus précises.

Méthode

À des fins de recherche, il sera utile de penser à une vidéo du point de vue du contenu et de la structure. Par structure, nous entendons ici les caractéristiques qui décrivent sa géométrie et sa dynamique, telles que la forme et la position de ses corps, ainsi que leurs changements temporels. Pour le contenu, il est défini ici comme des caractéristiques qui décrivent l'apparence et la sémantique d'une vidéo, comme la couleur et le style des objets et l'éclairage de la scène. L'objectif du modèle Gen-1 est d'éditer le contenu d'une vidéo tout en préservant sa structure.

Pour atteindre cet objectif, les chercheurs apprennent un modèle génératif p (x|s, c) pour la vidéo x, qui est conditionné par la représentation structurelle (notée s) et la représentation du contenu (notée c). Ils déduisent la représentation de forme s à partir de la vidéo d'entrée et la modifient en fonction de l'invite textuelle c décrivant la modification. Tout d’abord, la mise en œuvre du modèle génératif en tant que modèle de diffusion vidéo latente conditionnelle est décrite, puis le choix des représentations de forme et de contenu est décrit. Enfin, le processus d'optimisation du modèle est discuté.

La structure du modèle est illustrée à la figure 2.

Expérience

Pour évaluer la méthode, les chercheurs ont utilisé des vidéos DAVIS et divers matériaux. Pour créer automatiquement l'invite d'édition, les chercheurs ont d'abord exécuté un modèle de sous-titres pour obtenir une description du contenu vidéo original, puis ont utilisé GPT-3 pour générer l'invite d'édition.

Étude qualitative

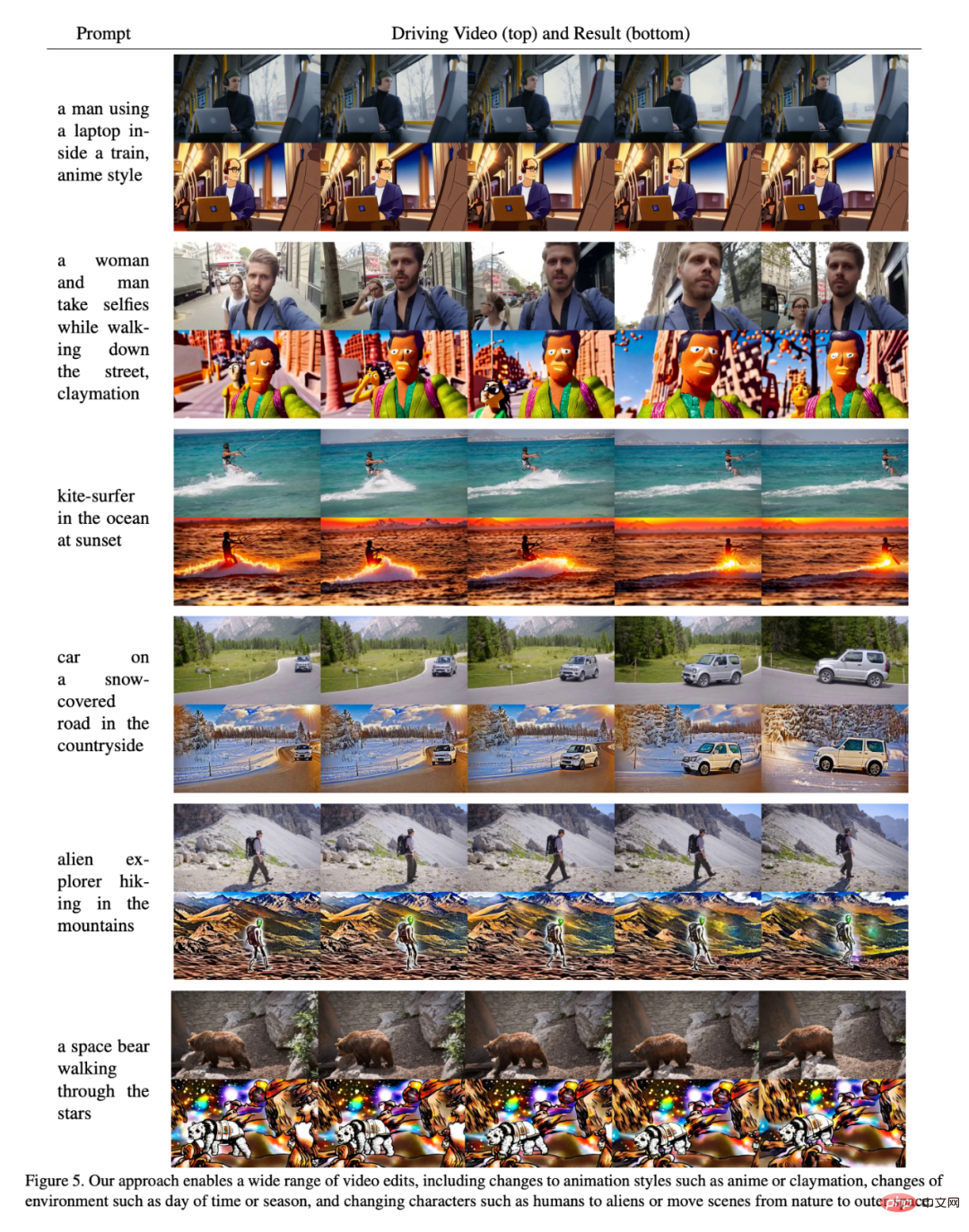

Comme le montre la figure 5, les résultats prouvent que la méthode présentée dans cet article fonctionne bien sur certaines entrées différentes. Les chercheurs ont également mené une étude utilisateur à l'aide d'Amazon Mechanical Turk (AMT) sur un ensemble d'évaluation de 35 invites de montage vidéo représentatives. Pour chaque échantillon, 5 annotateurs ont été invités à comparer la fidélité des invites de montage vidéo entre la méthode de base et notre méthode (« Quelle vidéo représente le mieux les sous-titres édités fournis ? »), puis présentés de manière aléatoire de manière séquentielle, avec un vote majoritaire utilisé pour déterminer le résultat final. résultat.

Les résultats sont présentés dans la figure 7 :

Évaluation quantitative

La figure 6 montre les résultats de chaque modèle en utilisant la cohérence du cadre de cet article et des indicateurs de cohérence rapides. Les performances du modèle présenté dans cet article ont tendance à dépasser le modèle de référence dans les deux aspects (c'est-à-dire qu'elles sont plus élevées dans le coin supérieur droit de la figure). Les chercheurs ont également remarqué qu'il existe un léger compromis pour augmenter le paramètre d'intensité dans le modèle de base : une plus grande mise à l'échelle de l'intensité signifie une cohérence plus élevée des invites au détriment d'une cohérence de trame plus faible. Ils ont également observé qu’une mise à l’échelle structurelle croissante conduit à une cohérence rapide plus élevée, car le contenu n’est plus déterminé par la structure d’entrée.

Personnalisation

Personnalisation

La figure 10 montre un exemple avec différents nombres d'étapes de personnalisation et différents niveaux de dépendance structurelle ts. Les chercheurs ont observé que la personnalisation augmente la fidélité au style et à l'apparence du personnage, de sorte que, malgré l'utilisation de vidéos animées de personnages présentant des caractéristiques différentes, combinées à des valeurs ts plus élevées, des effets d'animation précis peuvent être obtenus.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI