Maison >Périphériques technologiques >IA >Comment améliorer l'efficacité du stockage et de la transmission ? Le réseau de masques à forte intensité de paramètres a un effet significatif

Comment améliorer l'efficacité du stockage et de la transmission ? Le réseau de masques à forte intensité de paramètres a un effet significatif

- 王林avant

- 2023-04-12 17:10:031351parcourir

Afin de gérer des tâches plus complexes, l'échelle des réseaux de neurones a augmenté ces dernières années, et la manière de stocker et de transmettre efficacement les réseaux de neurones est devenue très importante. D'un autre côté, avec la proposition de l'hypothèse des billets de loterie (LTH), les réseaux neuronaux aléatoires et clairsemés ont récemment montré un fort potentiel. Il convient également d'explorer la manière d'utiliser ce potentiel pour améliorer l'efficacité du stockage et de la transmission du réseau.

Des chercheurs de la Northeastern University et du Rochester Institute of Technology ont proposé des réseaux de masquage efficaces aux paramètres (PEMN). Les auteurs explorent d'abord les capacités de représentation des réseaux stochastiques générés par un nombre limité de nombres aléatoires. Les expériences montrent que même si le réseau est généré à partir d’un nombre limité de nombres aléatoires, il possède toujours de bonnes capacités de représentation en choisissant différentes structures de sous-réseaux.

A travers cette expérience exploratoire, l'auteur a naturellement proposé d'utiliser comme prototype un nombre limité de nombres aléatoires, combiné à un ensemble de masques pour exprimer un réseau de neurones. Étant donné qu'un nombre limité de nombres aléatoires et de masques binaires occupent très peu d'espace de stockage, l'auteur l'utilise pour proposer une nouvelle idée de compression de réseau. L'article a été accepté pour NeurIPS 2022. Le code est open source.

- Adresse papier : https://arxiv.org/abs/2210.06699

- Code papier : https://github.com/yueb17/PEMN

1. Recherches connexes

Les chercheurs du MIT ont proposé l'hypothèse du billet de loterie (ICLR'19) : dans un réseau initialisé de manière aléatoire, il existe un sous-réseau de loterie (billet gagnant) qui obtient de bons résultats lorsqu'il est formé seul. L'hypothèse des billets de loterie explore la possibilité d'entraînement de réseaux stochastiques clairsemés. Les chercheurs d'Uber ont proposé Supermask (NeurIPS'19) : dans un réseau initialisé de manière aléatoire, il existe un sous-réseau qui peut être directement utilisé pour l'inférence sans formation. Supermask explore la convivialité des réseaux clairsemés stochastiques. Des chercheurs de l’Université de Washington ont proposé Edge-Popup (CVPR’20) : apprendre le masque du sous-réseau par rétropropagation, ce qui améliore considérablement la convivialité des réseaux clairsemés aléatoires.

2. Motivation/processus de recherche

Les recherches connexes ci-dessus ont exploré le potentiel des réseaux clairsemés aléatoires sous différents angles, tels que la capacité d'entraînement et la convivialité, où la convivialité peut également être comprise comme une capacité de représentation. Dans ce travail, les auteurs s'intéressent à la manière dont un réseau neuronal généré à partir de nombres aléatoires peut représenter sans poids d'entraînement. Suite à l’exploration de ce problème, les auteurs ont proposé des réseaux de masquage efficaces aux paramètres (PEMN). Naturellement, l’auteur utilise PEMN pour proposer une nouvelle idée de compression de réseau et sert d’exemple pour explorer les scénarios d’application potentiels de PEMN.

3. Explorez la capacité de représentation des réseaux de neurones composés de nombres aléatoires

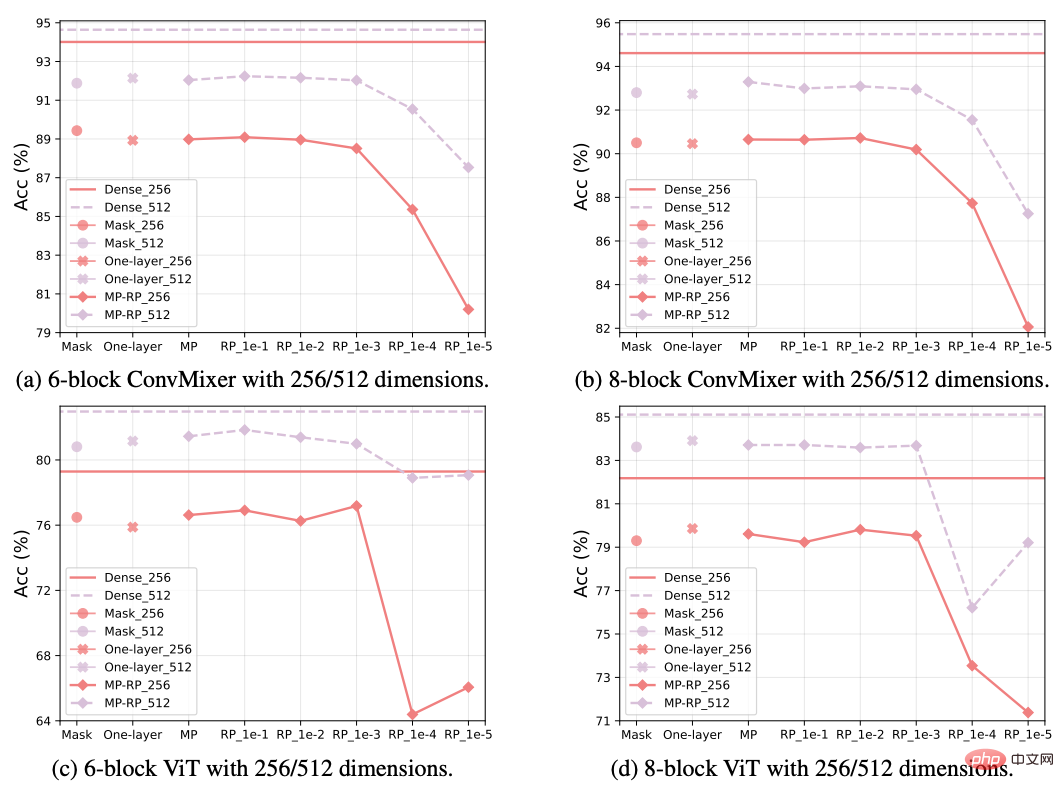

Étant donné un réseau aléatoire, l'auteur choisit l'algorithme Edge-Popup pour sélectionner des sous-réseaux afin d'explorer sa capacité de représentation. La différence est qu'au lieu d'initialiser aléatoirement l'ensemble du réseau, l'auteur propose trois stratégies de génération de réseau à forte intensité de paramètres pour utiliser un prototype afin de construire un réseau aléatoire.

- Une couche : sélectionnez le poids de la structure répétée dans le réseau comme prototype pour remplir d'autres couches de réseau avec la même structure.

- Remplissage de couche maximale (MP) : sélectionnez la couche réseau avec le plus grand nombre de paramètres comme prototype et tronquez les quantités de paramètres correspondantes pour remplir d'autres couches réseau.

- Random vector padding (RP) : sélectionnez un vecteur aléatoire d'une certaine longueur comme prototype et copiez-le pour remplir l'ensemble du réseau.

Trois stratégies de génération de réseaux aléatoires différentes réduisent progressivement le nombre de valeurs uniques dans le réseau. Nous sélectionnons des sous-réseaux en fonction des réseaux aléatoires obtenus par différentes stratégies, explorant ainsi un nombre limité de nombres aléatoires. de réseaux aléatoires générés.

La figure ci-dessus montre les résultats expérimentaux de la classification d'images CIFAR10 à l'aide du réseau ConvMixer et ViT. L'axe Y est la précision et l'axe X est le réseau aléatoire obtenu en utilisant différentes stratégies. Comme le

Selon les résultats expérimentaux, nous avons observé que même si le réseau aléatoire ne dispose que d'un nombre très limité de nombres aléatoires non répétitifs (tels que PR_1e-3), il peut toujours bien maintenir la capacité de représentation du sous-réseau sélectionné. . Jusqu'à présent, l'auteur a exploré la capacité de représentation d'un réseau neuronal composé d'un nombre limité de nombres aléatoires à travers différentes stratégies de génération de réseaux aléatoires et a observé que même si les nombres aléatoires non répétitifs sont très limités, le réseau aléatoire correspondant peut toujours représenter bien les données.

Dans le même temps, sur la base de ces stratégies de génération de réseaux aléatoires et combiné au masque de sous-réseau obtenu, l'auteur a proposé un nouveau type de réseau neuronal appelé Réseaux de masquage efficaces aux paramètres (PEMN).

4. Une nouvelle idée de compression de réseau

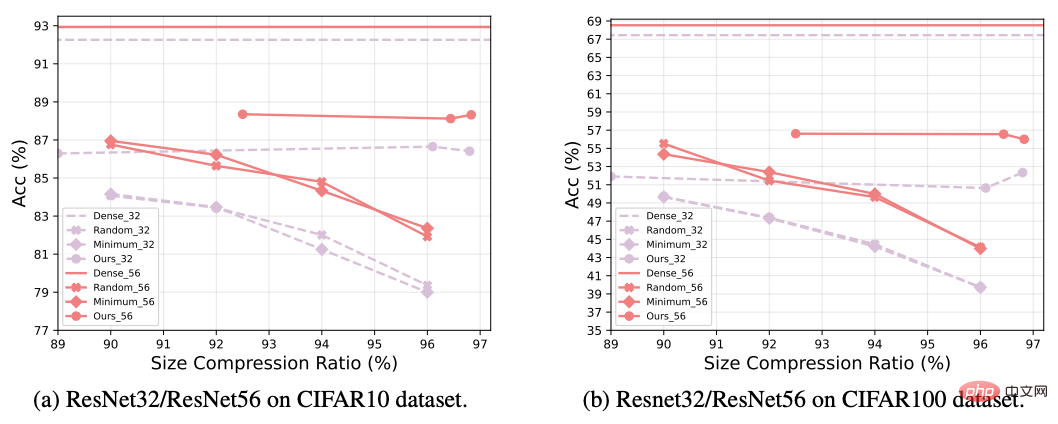

Cet article choisit la compression de réseau neuronal comme exemple pour étendre les applications potentielles du PEMN. Plus précisément, les différentes stratégies de génération de réseaux aléatoires proposées dans cet article peuvent utiliser efficacement des prototypes pour représenter des réseaux aléatoires complets, en particulier la stratégie de remplissage vectoriel aléatoire (RP) la plus fine.

L'auteur utilise le prototype de vecteur aléatoire dans la stratégie RP et un ensemble correspondant de masques de sous-réseau pour représenter un réseau aléatoire. Le prototype doit être enregistré au format virgule flottante, tandis que le masque doit uniquement être enregistré au format binaire. Étant donné que la longueur du prototype dans RP peut être très courte (car un nombre limité de nombres aléatoires non répétitifs ont toujours une forte capacité de représentation), la surcharge liée à la représentation d'un réseau neuronal deviendra très faible, c'est-à-dire le stockage d'un format de nombre à virgule flottante avec une longueur limitée. Un vecteur aléatoire et un ensemble de masques au format binaire. Par rapport aux réseaux clairsemés traditionnels qui stockent les valeurs à virgule flottante des sous-réseaux, cet article propose une nouvelle idée de compression de réseau pour stocker et transmettre efficacement les réseaux de neurones.

Dans la figure ci-dessus, l'auteur utilise PEMN pour compresser le réseau et le compare avec la méthode traditionnelle d'élagage du réseau. L'expérience utilise le réseau ResNet pour effectuer des tâches de classification d'images sur l'ensemble de données du CIFAR. Nous observons que le nouveau schéma de compression fonctionne généralement mieux que l'élagage de réseau traditionnel, notamment à des taux de compression très élevés, le PEMN peut toujours conserver une bonne précision.

5. Conclusion

Inspiré par le potentiel démontré récemment par les réseaux aléatoires, cet article propose différentes stratégies intensives en paramètres pour construire des réseaux de neurones aléatoires, puis explore les méthodes générées lorsqu'il n'y a que des nombres aléatoires non répétitifs limités. Le potentiel de représentation de réseaux neuronaux aléatoires et les réseaux de masquage efficaces aux paramètres (PEMN) sont proposés. L'auteur applique le PEMN aux scénarios de compression réseau pour explorer son potentiel dans des applications pratiques et propose une nouvelle idée pour la compression réseau. Les auteurs proposent des expériences approfondies montrant que même s’il n’y a qu’un nombre très limité de nombres aléatoires non répétitifs dans un réseau aléatoire, celui-ci possède toujours de bonnes capacités de représentation grâce à la sélection de sous-réseaux. De plus, par rapport aux algorithmes d'élagage traditionnels, les expériences montrent que la méthode nouvellement proposée peut obtenir de meilleurs effets de compression de réseau, vérifiant ainsi le potentiel d'application du PEMN dans ce scénario.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI