Périphériques technologiques

Périphériques technologiques IA

IA Un article analysant brièvement la fusion multi-capteurs pour la conduite autonome

Un article analysant brièvement la fusion multi-capteurs pour la conduite autonomeUn article analysant brièvement la fusion multi-capteurs pour la conduite autonome

Qu'est-ce que les voitures connectées intelligentes ont à voir avec la conduite autonome ?

Le cœur de la conduite autonome réside dans la voiture, mais qu'est-ce que le système de connexion réseau intelligent ? Le support de la connexion réseau intelligente est également la voiture, mais le cœur est le réseau qui doit être connecté. L’un est un réseau composé de capteurs et de systèmes de contrôle intelligents à l’intérieur de la voiture, et l’autre est un réseau connecté et partagé par toutes les voitures. La connexion réseau consiste à placer une voiture dans un vaste réseau pour échanger des informations importantes, telles que l'emplacement, l'itinéraire, la vitesse et d'autres informations. L'objectif de développement du système de réseau intelligent est d'améliorer la sécurité et le confort de la voiture grâce à la conception et à l'optimisation des capteurs internes et des systèmes de contrôle de la voiture, rendant la voiture plus humaine. Bien entendu, l'objectif ultime est de parvenir à une conduite sans conducteur. conduite.

Les trois systèmes auxiliaires de base des véhicules autonomes : le système de perception de l'environnement, le système de prise de décision et de planification, et le système de contrôle et d'exécution. Ce sont également les trois problèmes techniques clés que le véhicule intelligent en réseau lui-même doit résoudre.

Quel rôle le système de détection de l'environnement joue-t-il dans le système de connexion réseau intelligent ?

Qu'est-ce que la technologie de détection de l'environnement et que comprend-elle principalement ?

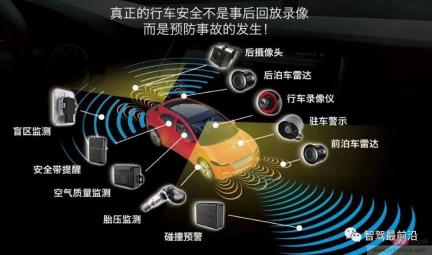

La perception de l'environnement comprend principalement trois aspects : les capteurs, la perception et le positionnement. Les capteurs comprennent des caméras, un radar à ondes millimétriques, un lidar et des ondes ultrasoniques. Différents capteurs sont placés sur le véhicule et jouent un rôle dans la collecte de données, l'identification des couleurs et la mesure des distances.

Si les voitures intelligentes veulent utiliser les données obtenues par les capteurs pour réaliser une conduite intelligente, les données obtenues via les capteurs doivent être traitées par des algorithmes (de perception) et compilées en résultats de données pour réaliser l'échange d'informations sur les véhicules. , les routes, les personnes, etc. Il permet au véhicule d'analyser automatiquement si le véhicule roule dans un état sûr ou dangereux, permet au véhicule de réaliser une conduite intelligente selon les souhaits humains et, en fin de compte, remplace les humains dans la prise de décisions et les objectifs de conduite autonome.

Ensuite, il y a ici un problème technique clé. Différents capteurs jouent des rôles différents. Comment les données numérisées par plusieurs capteurs peuvent-elles former une image d'objet complète ?

Technologie de fusion multi-capteurs

La fonction principale de la caméra est d'identifier la couleur des objets, mais elle sera affectée par le temps pluvieux. Le radar à ondes millimétriques peut compenser les inconvénients de la caméra ; être affecté par les jours de pluie et peut identifier les objets éloignés des obstacles, tels que les piétons, les barrages routiers, etc., mais ne peut pas identifier la forme spécifique des obstacles ; forme spécifique des obstacles ; le radar à ultrasons identifie principalement les obstacles à courte portée sur la carrosserie et est utilisé dans le stationnement des véhicules. Il y en a davantage pendant le processus de conduite. Afin de fusionner les données externes collectées à partir de différents capteurs afin de fournir au contrôleur une base pour prendre des décisions, il est nécessaire de traiter l'algorithme de fusion multi-capteurs pour former une perception panoramique.

Qu'est-ce que la fusion multi-capteurs (traitement d'algorithmes de fusion), et quels sont les principaux algorithmes de fusion ?

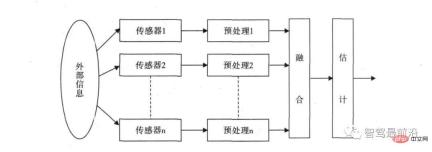

Le principe de base de la fusion multi-capteurs est similaire au processus de traitement complet de l'information par le cerveau humain. Divers capteurs sont utilisés pour compléter et optimiser la combinaison d'informations à plusieurs niveaux et dans plusieurs espaces, produisant finalement un résultat cohérent. interprétation de l’environnement d’observation. Dans ce processus, les données multi-sources doivent être pleinement utilisées pour un contrôle et une utilisation raisonnables, et le but ultime de la fusion d'informations est de dériver des informations plus utiles grâce à des combinaisons d'informations multi-niveaux et multi-aspects basées sur les informations d'observation séparées obtenues par chaque capteur. Cela tire non seulement parti du fonctionnement coopératif de plusieurs capteurs, mais traite également de manière globale les données provenant d'autres sources d'informations pour améliorer l'intelligence de l'ensemble du système de capteurs.

Le concept de fusion de données multicapteurs a été appliqué pour la première fois dans le domaine militaire. Ces dernières années, avec le développement de la conduite autonome, divers radars sont utilisés dans la détection de cibles de véhicules. Étant donné que différents capteurs ont des problèmes d’exactitude des données, comment déterminer les données finales fusionnées ? Par exemple, le lidar indique que la distance au véhicule qui précède est de 5 m, le radar à ondes millimétriques indique que la distance au véhicule qui précède est de 5,5 m et la caméra détermine que la distance au véhicule qui précède est de 4 m. Comment le processeur central doit-il prendre le jugement final ? Un ensemble d’algorithmes de fusion multi-données est alors nécessaire pour résoudre ce problème.

Les méthodes courantes de fusion multi-capteurs sont divisées en deux grandes catégories : l'intelligence aléatoire et l'intelligence artificielle. La catégorie IA comprend principalement le raisonnement en logique floue et les méthodes de réseaux neuronaux artificiels ; les méthodes stochastiques incluent principalement le filtrage bayésien, le filtrage de Kalman et d'autres algorithmes. À l'heure actuelle, la détection de fusion automobile utilise principalement des algorithmes de fusion aléatoire.

L'algorithme de perception de fusion des véhicules autonomes utilise principalement l'algorithme de filtre de Kalman, qui utilise des équations d'état du système linéaire pour estimer de manière optimale l'état du système grâce aux données d'observation d'entrée et de sortie du système. C'est actuellement le meilleur algorithme pour résoudre la plupart des problèmes. méthode efficace.

Plusieurs capteurs doivent être traités par des algorithmes de fusion. Par conséquent, les entreprises auront besoin d'ingénieurs en algorithmes dans la catégorie de détection de fusion pour résoudre le problème de la fusion multi-capteurs. maîtriser plusieurs capteurs. Le principe de fonctionnement et les caractéristiques des données des signaux, et la capacité de maîtriser les algorithmes de fusion pour le développement de logiciels et les algorithmes d'étalonnage des capteurs, ainsi que le traitement des données de nuages de points, les algorithmes de détection d'apprentissage en profondeur, etc.

La troisième partie de la perception de l'environnement - positionnement (slam)

Slam est appelé positionnement et cartographie simultanés. Il suppose que la scène est statique et utilise le mouvement de la caméra pour obtenir la séquence d'images et obtenir les 3. -D scène. La conception structurelle est une tâche importante de la vision par ordinateur. Les données obtenues par la caméra sont traitées par un algorithme, qui est un claquement visuel.

En plus du claquement visuel, les méthodes de positionnement respectueuses de l'environnement incluent également le claquement lidar, le GPS/IMU et des cartes de haute précision. Les données obtenues par ces capteurs doivent être traitées par des algorithmes pour former des résultats qui fournissent une base d'informations de localisation pour les décisions de conduite autonome. Par conséquent, si vous souhaitez travailler dans le domaine de la perception environnementale, vous pouvez non seulement choisir la position de l'algorithme de détection de fusion, mais également choisir le champ de claquement.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment construire votre assistant d'IA personnel avec HuggingFace SmollmApr 18, 2025 am 11:52 AM

Comment construire votre assistant d'IA personnel avec HuggingFace SmollmApr 18, 2025 am 11:52 AMExploiter la puissance de l'IA sur disvise: construire une CLI de chatbot personnelle Dans un passé récent, le concept d'un assistant d'IA personnel semblait être une science-fiction. Imaginez Alex, un passionné de technologie, rêvant d'un compagnon d'IA intelligent et local - celui qui ne dépend pas

L'IA pour la santé mentale est attentivement analysée via une nouvelle initiative passionnante à l'Université de StanfordApr 18, 2025 am 11:49 AM

L'IA pour la santé mentale est attentivement analysée via une nouvelle initiative passionnante à l'Université de StanfordApr 18, 2025 am 11:49 AMLeur lancement inaugural de l'AI4MH a eu lieu le 15 avril 2025, et le Dr Tom Insel, M.D., célèbre psychiatre et neuroscientifique, a été le conférencier de lancement. Le Dr Insel est réputé pour son travail exceptionnel dans la recherche en santé mentale et la techno

La classe de draft de la WNBA 2025 entre dans une ligue qui grandit et luttant sur le harcèlement en ligneApr 18, 2025 am 11:44 AM

La classe de draft de la WNBA 2025 entre dans une ligue qui grandit et luttant sur le harcèlement en ligneApr 18, 2025 am 11:44 AM"Nous voulons nous assurer que la WNBA reste un espace où tout le monde, les joueurs, les fans et les partenaires d'entreprise, se sentent en sécurité, appréciés et autonomes", a déclaré Engelbert, abordé ce qui est devenu l'un des défis les plus dommageables des sports féminins. L'anno

Guide complet des structures de données intégrées Python - Analytics VidhyaApr 18, 2025 am 11:43 AM

Guide complet des structures de données intégrées Python - Analytics VidhyaApr 18, 2025 am 11:43 AMIntroduction Python excelle comme un langage de programmation, en particulier dans la science des données et l'IA générative. La manipulation efficace des données (stockage, gestion et accès) est cruciale lorsqu'il s'agit de grands ensembles de données. Nous avons déjà couvert les nombres et ST

Premières impressions des nouveaux modèles d'Openai par rapport aux alternativesApr 18, 2025 am 11:41 AM

Premières impressions des nouveaux modèles d'Openai par rapport aux alternativesApr 18, 2025 am 11:41 AMAvant de plonger, une mise en garde importante: les performances de l'IA sont non déterministes et très usagées. En termes plus simples, votre kilométrage peut varier. Ne prenez pas cet article (ou aucun autre) article comme le dernier mot - au lieu, testez ces modèles sur votre propre scénario

Portfolio AI | Comment construire un portefeuille pour une carrière en IA?Apr 18, 2025 am 11:40 AM

Portfolio AI | Comment construire un portefeuille pour une carrière en IA?Apr 18, 2025 am 11:40 AMConstruire un portefeuille AI / ML hors concours: un guide pour les débutants et les professionnels La création d'un portefeuille convaincant est cruciale pour sécuriser les rôles dans l'intelligence artificielle (IA) et l'apprentissage automatique (ML). Ce guide fournit des conseils pour construire un portefeuille

Ce que l'IA agentique pourrait signifier pour les opérations de sécuritéApr 18, 2025 am 11:36 AM

Ce que l'IA agentique pourrait signifier pour les opérations de sécuritéApr 18, 2025 am 11:36 AMLe résultat? L'épuisement professionnel, l'inefficacité et un écart d'élargissement entre la détection et l'action. Rien de tout cela ne devrait être un choc pour quiconque travaille en cybersécurité. La promesse d'une IA agentique est devenue un tournant potentiel, cependant. Cette nouvelle classe

Google contre Openai: la lutte contre l'IA pour les étudiantsApr 18, 2025 am 11:31 AM

Google contre Openai: la lutte contre l'IA pour les étudiantsApr 18, 2025 am 11:31 AMImpact immédiat contre partenariat à long terme? Il y a deux semaines, Openai s'est avancé avec une puissante offre à court terme, accordant aux étudiants des États-Unis et canadiens d'accès gratuit à Chatgpt Plus jusqu'à la fin mai 2025. Cet outil comprend GPT - 4O, un A

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

MinGW - GNU minimaliste pour Windows

Ce projet est en cours de migration vers osdn.net/projects/mingw, vous pouvez continuer à nous suivre là-bas. MinGW : un port Windows natif de GNU Compiler Collection (GCC), des bibliothèques d'importation et des fichiers d'en-tête librement distribuables pour la création d'applications Windows natives ; inclut des extensions du runtime MSVC pour prendre en charge la fonctionnalité C99. Tous les logiciels MinGW peuvent fonctionner sur les plates-formes Windows 64 bits.

Dreamweaver CS6

Outils de développement Web visuel

mPDF

mPDF est une bibliothèque PHP qui peut générer des fichiers PDF à partir de HTML encodé en UTF-8. L'auteur original, Ian Back, a écrit mPDF pour générer des fichiers PDF « à la volée » depuis son site Web et gérer différentes langues. Il est plus lent et produit des fichiers plus volumineux lors de l'utilisation de polices Unicode que les scripts originaux comme HTML2FPDF, mais prend en charge les styles CSS, etc. et présente de nombreuses améliorations. Prend en charge presque toutes les langues, y compris RTL (arabe et hébreu) et CJK (chinois, japonais et coréen). Prend en charge les éléments imbriqués au niveau du bloc (tels que P, DIV),

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP