Maison >Périphériques technologiques >IA >Gagnant des alliés et comprenant le cœur des gens, le dernier agent Meta est un maître négociateur

Gagnant des alliés et comprenant le cœur des gens, le dernier agent Meta est un maître négociateur

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-11 23:25:01916parcourir

Le jeu vidéo est depuis longtemps un terrain d'essai pour les progrès de l'IA, depuis la victoire de Deep Blue sur le grand maître d'échecs Garry Kasparov, jusqu'à la maîtrise d'AlphaGo de Go Beyond Humans, en passant par Pluribus battant les meilleurs joueurs de poker. Mais un agent vraiment utile et omnipotent ne peut pas simplement jouer à un jeu de société et déplacer des pièces d’échecs. On ne peut s'empêcher de se demander : pouvons-nous créer un agent plus efficace et plus flexible, capable d'utiliser le langage pour négocier, persuader et travailler avec les gens afin d'atteindre des objectifs stratégiques comme les humains ?

Dans l'histoire du jeu vidéo, il existe un Jeu de table classique Diplomacy Lorsque de nombreuses personnes verront le jeu pour la première fois, elles seront choquées par son plateau de style carte. Considérez-le comme un jeu de guerre complexe. En fait, ce n'est pas le cas. Il s'agit d'un jeu qui nécessite de mobiliser le langage pour gagner des alliés. Cela implique une prise de décision et une négociation entre les joueurs. La clé pour gagner le jeu réside dans l'interaction entre les gens. .

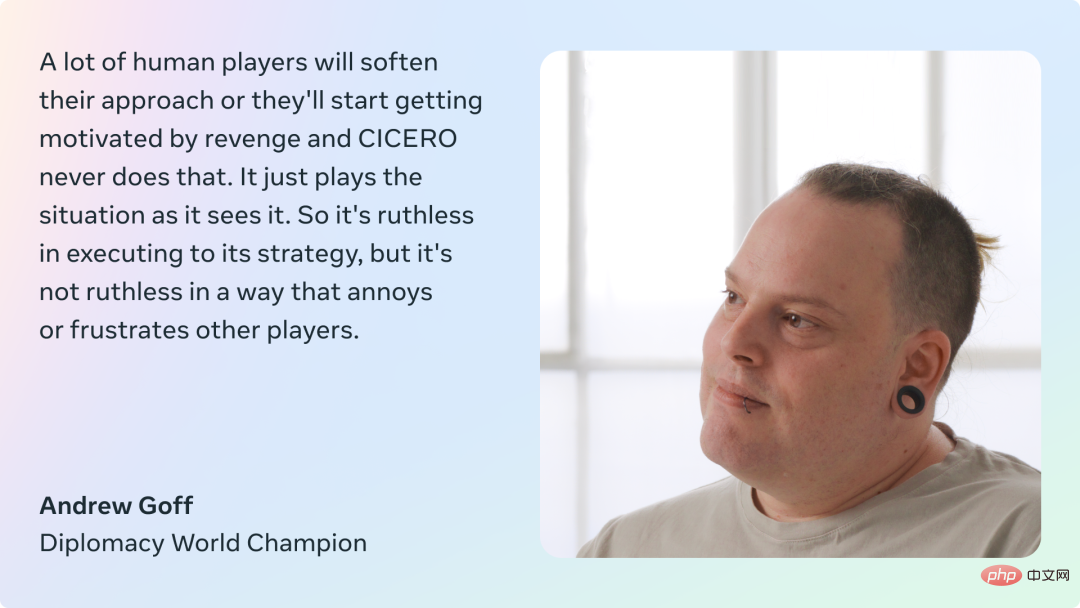

Maintenant, Meta a lancé un défi à ce jeu. L'agent intelligent qu'ils ont construit, CICERO, est devenu la première IA à atteindre le niveau humain en diplomatie. CICERO l'a démontré sur la version en ligne de webDiplomacy.net, où CICERO a obtenu en moyenne un score plus de deux fois supérieur à celui des joueurs humains et s'est classé parmi les 10 % des meilleurs participants ayant joué à plus d'une partie.

- Adresse papier : https://www.science.org/doi/10.1126/science.ade9097

- Adresse de la page d'accueil : https://ai.facebook.com/research/ cicero/diplomacy/

Pendant des décennies, la diplomatie a été considérée comme un défi insurmontable dans le domaine de l'IA, car le jeu exige que les joueurs comprennent les motivations et les perspectives des autres, élaborent des plans complexes, ajustent leurs stratégies, et sur ce point Sur cette base, le langage naturel est utilisé pour conclure des accords avec les autres, persuader les autres de former des partenariats et des alliances, etc. Celles-ci restent difficiles pour les agents, et CICERO reste très efficace dans l'utilisation du langage naturel pour négocier avec les acteurs de la diplomatie.

Contrairement aux échecs et au Go, la diplomatie est un jeu qui concerne les personnes et non les pièces. Si un agent ne peut pas dire si un adversaire bluffe ou sabote réellement, il perdra rapidement la partie. De même, si un agent ne peut pas communiquer comme un humain, faire preuve d'empathie, établir des relations avec les autres et parler du jeu, il ne trouvera pas d'autres joueurs disposés à coopérer avec lui.

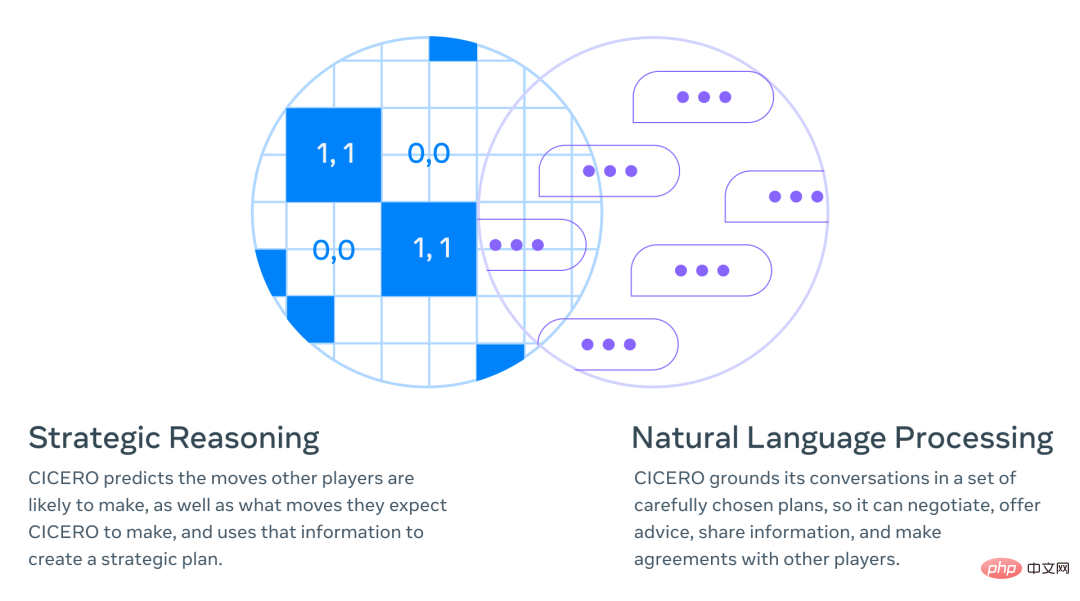

Les recherches de Meta combinent le raisonnement stratégique (par exemple AlphaGo, Pluribus) avec le traitement du langage naturel (par exemple GPT-3, BlenderBot 3, LaMDA, OPT-175B). Par exemple, tard dans le jeu, CICERO en déduit qu'il aura besoin du soutien d'un joueur spécifique, et CICERO élabore alors une stratégie pour gagner les faveurs de cette personne.

Comment construire CICERO

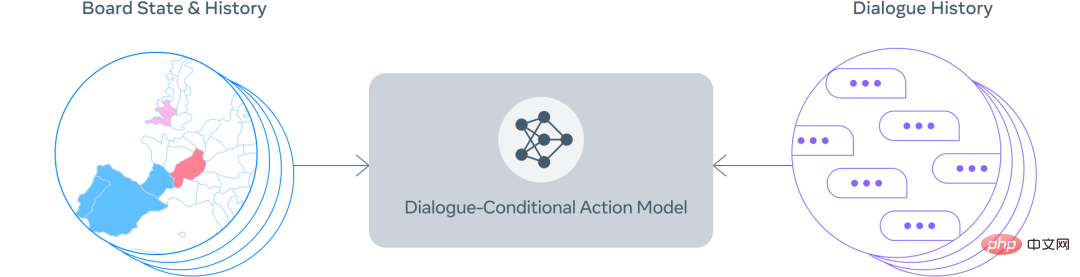

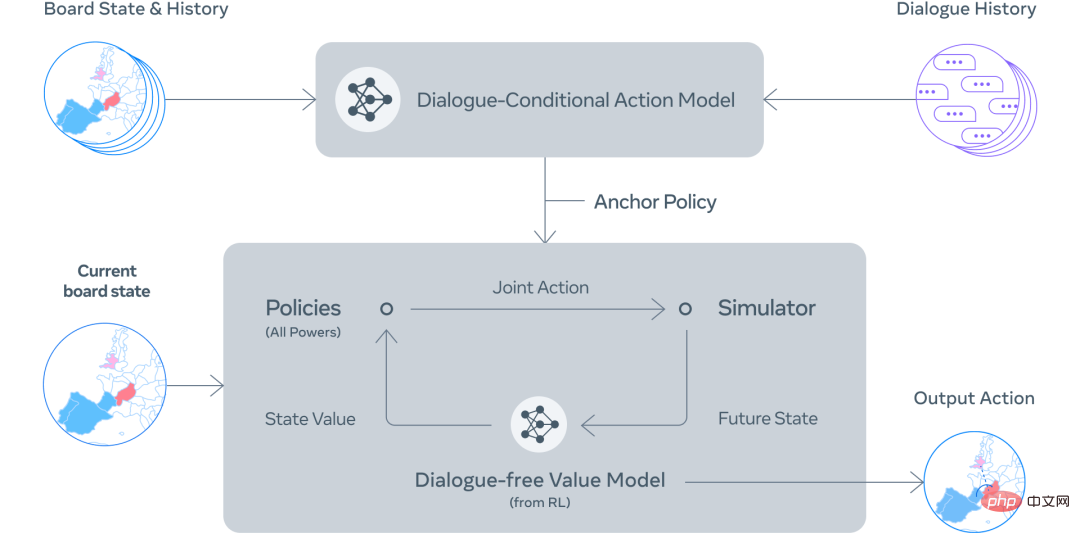

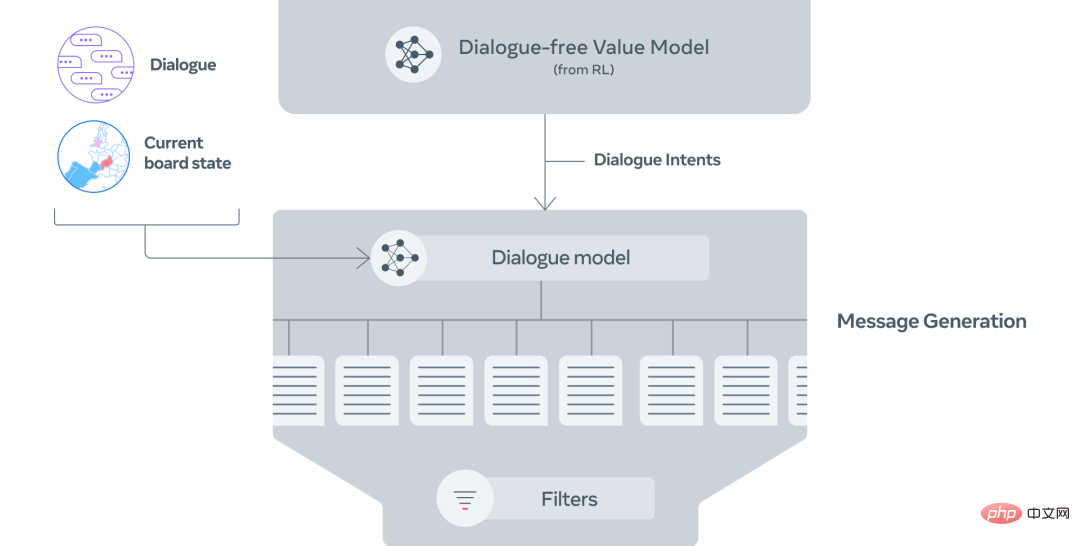

Le cœur de CICERO est un modèle de dialogue contrôlable et un moteur de raisonnement stratégique. À chaque étape du jeu, CICERO examine le plateau de jeu et son historique de conversations et modélise ce que les autres joueurs pourraient faire. Un plan est ensuite élaboré pour contrôler le modèle de langage, communiquer ses plans aux autres joueurs et suggérer des actions raisonnables aux autres joueurs qui se coordonnent bien avec eux.

Dialogue contrôlable

Pour construire un modèle de dialogue contrôlable, Meta est parti d'un modèle de langage de type BART avec 2,7 milliards de paramètres, pré-entraîné sur du texte provenant d'Internet, ainsi que plus de 40 000 jeux humains. ont été peaufinés sur webDiplomacy.net.

Le processus de mise en œuvre est principalement divisé en les étapes suivantes :

Étape 1 : Sur la base de l'état du conseil d'administration et de la conversation en cours, CICERO donne une prédiction préliminaire de ce que chacun fera.

Étape 2 : CICERO améliore de manière itérative la prévision initiale, puis utilise la prévision améliorée pour former une intention pour lui-même et ses partenaires.

Étape 3 : Générez plusieurs messages de candidats en fonction de l'état du conseil d'administration, du dialogue et de l'intention.

Étape 4 : Filtrez les messages des candidats, maximisez la valeur et assurez la cohérence des intentions entre eux.

Les chercheurs ont utilisé certains mécanismes de filtrage pour améliorer encore la qualité du dialogue, tels que l'utilisation de classificateurs entraînés pour faire la distinction entre le texte généré par l'homme et celui généré par un modèle afin de garantir que le dialogue est raisonnable et cohérent avec le texte actuel. état du jeu et précédent Le message est cohérent et stratégiquement solide.

Stratégie et planification de sensibilisation conversationnelle

Dans les jeux impliquant la coopération, les agents doivent apprendre à simuler ce que les humains feraient réellement dans la vie réelle, plutôt que de traiter les humains comme des machines et de laisser l'agent les diriger. fait. Meta espère donc que les plans développés par CICERO seront cohérents avec le dialogue avec d'autres acteurs.

La méthode classique de modélisation humaine est l'apprentissage supervisé, qui utilise des données étiquetées (telles qu'une base de données d'actions de joueurs humains dans des jeux passés) pour former un agent. Cependant, s’appuyer uniquement sur l’apprentissage supervisé pour choisir des actions basées sur des conversations passées aboutit à un agent relativement faible et facile à exploiter. Par exemple, un joueur pourrait dire à l'agent "Je suis content que nous soyons convenus que vous éloigniez vos troupes de Paris!" Puisque des informations similaires n'apparaissent dans les données d'entraînement que lorsqu'un accord est conclu, l'agent peut en fait éloigner ses troupes ! depuis Paris, même si cela constituait clairement une erreur stratégique.

Pour résoudre ce problème, CICERO exécute un algorithme de planification itérative pour équilibrer la cohérence et le caractère raisonnable de la conversation. L'agent prédit d'abord la stratégie de chaque joueur pour le tour en cours en fonction de ses conversations avec les autres joueurs, et prédit également ce que les autres joueurs pensent de la stratégie de l'agent. Il exécutera ensuite un algorithme de planification appelé « piKL » qui améliore de manière itérative ces prédictions en essayant de choisir de nouvelles stratégies avec des valeurs attendues plus élevées compte tenu des stratégies prédites par les autres acteurs, tout en essayant également de rendre les nouvelles prédictions proches des prévisions stratégiques d'origine. . Les chercheurs ont découvert que piKL peut mieux simuler les jeux humains et apporter de meilleures stratégies à l’agent que l’apprentissage purement supervisé.

Générez des conversations naturelles et utiles

En Diplomatie, la façon dont les joueurs se parlent est encore plus importante que la façon dont ils déplacent leurs pièces. CICERO est capable de communiquer de manière claire et convaincante lors de l’élaboration de stratégies avec d’autres acteurs. Par exemple, dans une démo, CICERO a demandé à un joueur de soutenir immédiatement une certaine partie du plateau, tout en faisant pression sur un autre joueur pour qu'il envisage une alliance plus tard dans la partie.

Lors de l'échange, CICERO tente d'exécuter sa stratégie en proposant des actions à trois acteurs différents. Lors de la deuxième conversation, l’agent est capable d’expliquer aux autres joueurs pourquoi ils devraient coopérer et comment cela profitera aux deux parties. Dans ce troisième dialogue, le CICERO sollicite des informations et prépare le terrain pour des actions futures.

Inconvénients

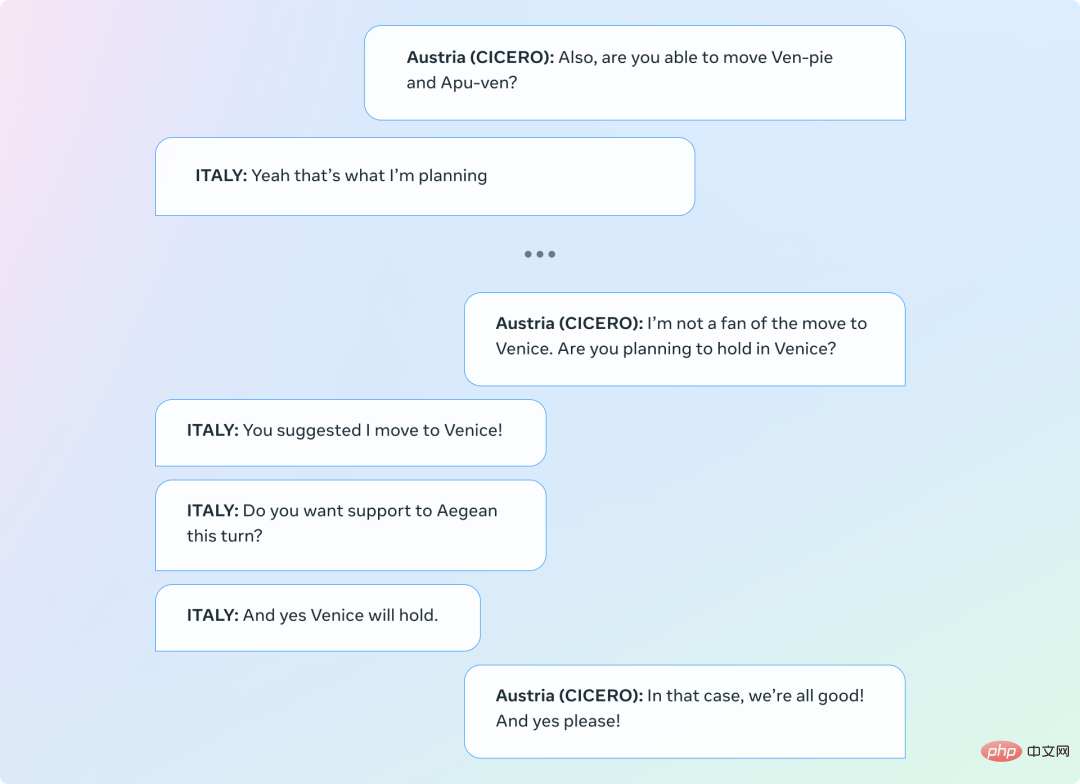

Il faut admettre que CICERO produit aussi parfois des dialogues incohérents, allant ainsi à l'encontre de ses objectifs. Dans l'exemple ci-dessous, CICERO joue l'Autriche, mais l'agent demande à l'Italie de déménager à Venise, contredisant son premier message.

Laissons « Diplomatie » faire progresser le bac à sable de l'interaction homme-IA

Dans un jeu qui implique à la fois coopération et compétition, un système de dialogue axé sur les objectifs a émergé, ce qui est très important pour faire interagir l'IA avec les humains. Cela présente d’importants défis sociaux et techniques en termes d’alignement des intentions et des objectifs. La diplomatie offre un contexte particulièrement intéressant pour étudier ce problème, car jouer à ce jeu nécessite de lutter contre des objectifs contradictoires et de traduire ces objectifs complexes en langage naturel. À titre d'exemple simple, un joueur peut choisir de faire des compromis sur les avantages à court terme pour maintenir une relation avec un allié, car cet allié peut l'aider à se mettre dans une meilleure position au prochain tour.

Bien que Meta ait fait des progrès significatifs dans ce travail, la capacité à combiner de manière robuste des modèles de langage avec des intentions concrètes, ainsi que les défis techniques (et normatifs) liés à la détermination de ces intentions, restent des problèmes importants. En open source le code CICERO, Meta espère que les chercheurs en IA pourront continuer à s'appuyer sur ce travail de manière responsable. L'équipe a déclaré : « En utilisant des modèles de conversation pour la classification zéro-shot, nous avons pris les premières mesures pour détecter et supprimer les informations nuisibles dans ce nouveau domaine. Nous espérons que la « diplomatie » pourra servir de bac à sable sûr pour faire progresser la recherche sur l'interaction homme-IA. . "

Orientations futures

Bien que CICERO ne soit actuellement capable de jouer qu'à des jeux de diplomatie, la technologie derrière cette réalisation est pertinente pour de nombreuses applications du monde réel. Par exemple, les barrières de communication entre les humains et les agents pilotés par l’IA peuvent être atténuées en contrôlant la génération du langage naturel via la planification et le RL.

Par exemple, les assistants IA d’aujourd’hui sont excellents pour répondre à des questions simples comme vous indiquer la météo, mais et s’ils pouvaient entretenir des conversations à long terme dans le but de vous enseigner une nouvelle compétence ?

Imaginez également un jeu vidéo dans lequel les PNJ peuvent planifier et parler comme des humains, comprendre vos motivations et adapter le dialogue en conséquence pour vous aider à mener à bien votre quête de prise d'assaut d'un château.

Ces « rêves » pourraient devenir réalité dans le futur.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI