Maison >Périphériques technologiques >IA >Microsoft dépense 10 milliards de dollars supplémentaires pour OpenAI ! L'IA géante joue aux échecs depuis 4 ans. Qui est le plus grand gagnant ?

Microsoft dépense 10 milliards de dollars supplémentaires pour OpenAI ! L'IA géante joue aux échecs depuis 4 ans. Qui est le plus grand gagnant ?

- PHPzavant

- 2023-04-10 19:11:011218parcourir

Début 2023, Microsoft affiche son statut de « grand gagnant » dans le domaine de l’IA.

Récemment, des étincelles ont constamment volé entre le populaire ChatGPT et Microsoft.

Microsoft a d'abord annoncé qu'il intégrerait ChatGPT dans son propre moteur de recherche Bing, et quelques jours plus tard, il a annoncé qu'il l'intégrerait aux « trois éléments majeurs » de la suite Office : Word, Excel et PPT. . Vous pouvez découvrir ChatGPT en utilisant Office, ce qui a fait le bonheur de nombreuses personnes.

À en juger par la taille de Microsoft dans le domaine des logiciels bureautiques, cette décision pourrait changer la façon dont plus d'un milliard de personnes rédigent des documents, des présentations et des e-mails.

Dès 2019, Microsoft a investi 1 milliard de dollars américains dans OpenAI, le propriétaire de ChatGPT. Cette « interaction » fréquente a également fait réfléchir l'industrie. Ensuite, Microsoft a investi plus de puces et a même acquis OpenAI et ChatGPT ensemble. est devenu une chose naturelle.

Il n’y a eu aucune surprise, aucun revers, et les gens n’ont pas eu à attendre trop longtemps. Microsoft a donné la réponse : investir 10 milliards de dollars supplémentaires.

Microsoft investit 10 milliards de dollars

Selon des personnes proches du dossier, Microsoft a négocié avec OpenAI pour des investissements supplémentaires, qui ont commencé dès octobre de l'année dernière.

Si ce financement est finalisé, y compris de nouveaux investissements, OpenAI sera valorisé à 29 milliards de dollars.

Selon certaines informations, l'injection de capital de Microsoft fera partie d'une transaction complexe. Après l'investissement, Microsoft recevra 75 % des bénéfices d'OpenAI jusqu'à ce que l'investissement soit récupéré.

Auparavant, OpenAI achetait des services auprès du département cloud computing de Microsoft. On ne sait actuellement pas si l'argent sera comptabilisé sur son compte.

Une fois l'investissement récupéré, dans le cadre de la structure de capital d'OpenAI, Microsoft détiendra 49 % des actions, les autres investisseurs recevront 49 % supplémentaires des actions et la société mère à but non lucratif d'OpenAI recevra 2 % des actions. .

Selon certaines informations, il n'est pas clair si la transaction a été finalisée, mais les documents pertinents récemment reçus par les investisseurs potentiels montrent que la transaction devait initialement être finalisée avant la fin de 2022.

Actuellement, Microsoft et OpenAI ont refusé de commenter de manière substantielle. Un porte-parole de Microsoft a déclaré dans un communiqué envoyé par courrier électronique que la société ne « commentait pas les spéculations ».

Le potentiel économique de l’intelligence artificielle est énorme et pourrait être supérieur à toutes les dépenses actuelles en logiciels.

Concevoir un meilleur moteur de recherche, capable de savoir intuitivement ce que recherchent les utilisateurs, constituerait une menace importante pour la valorisation de 1,1 billion de dollars de la société mère de Google, Alphabet. La prochaine étape pourrait consister à concevoir des programmes d’IA pour les médicaments.

Bien sûr, il y a de fortes chances qu’OpenAI disparaisse, comme le font la plupart des entreprises technologiques. Pour autant, l’investissement de Microsoft n’est peut-être pas vain.

Morgan Stanley estime qu'Alphabet a investi environ 100 milliards de dollars en R&D au cours des trois dernières années seulement, pariant fortement sur de tels produits que les dépenses augmenteront à un taux annuel de 13 % au cours des trois prochaines années.

En bloquant une entreprise prometteuse et des chercheurs rares, Microsoft pourrait empêcher Alphabet de gagner et potentiellement l'obliger à augmenter ses dépenses.

La configuration de Microsoft : à l'ère de l'IA, ceux qui acquièrent la technologie en premier gagneront le monde

29 milliards de dollars américains sont une très grande valorisation pour OpenAI Bien qu'OpenAI soit actuellement célèbre, son modèle commercial et son itinéraire actuels le sont. Ce n'est toujours pas clair, et 10 milliards de dollars, c'est un chiffre important pour les actionnaires de Microsoft.

Cependant, certains analystes de Wall Street estiment que même si 10 milliards de dollars américains constituent une somme d'argent décente, en termes de calendrier d'investissement et de stratégie d'investissement, Microsoft n'est pas cette fois considéré comme un « pari à haut risque ».

ChatGPT est populaire partout dans le monde et sa popularité est explosive C'est vrai, mais le risque de joindre les deux bouts est devenu de plus en plus sérieux avec l'augmentation rapide du nombre d'utilisateurs.

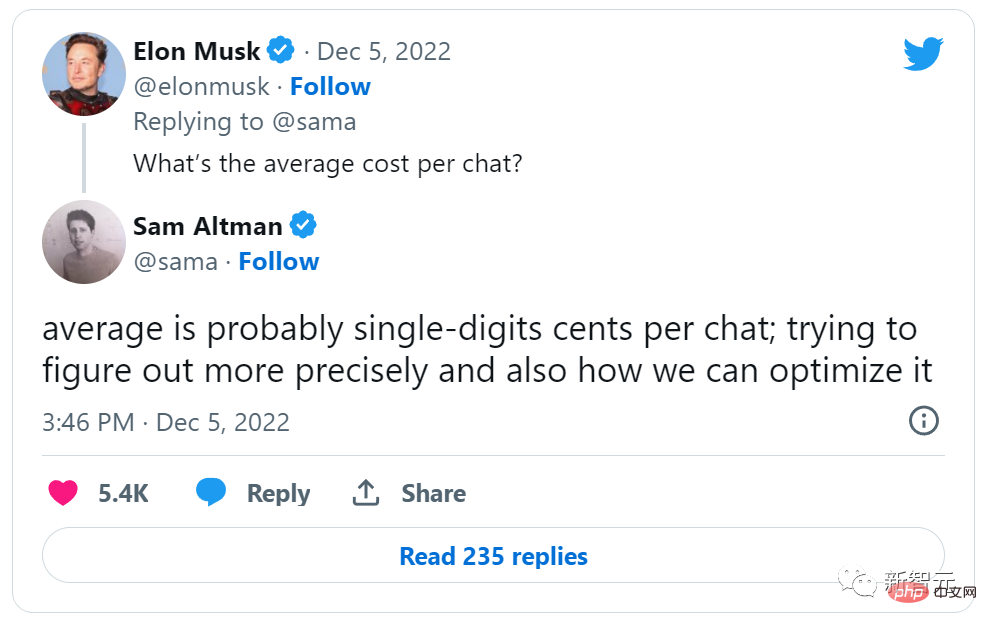

Le PDG d'OpenAI, Sam Altman, a tweeté le mois dernier que chaque fois que quelqu'un posait une question dans ChatGPT, l'entreprise devait payer quelques centimes de puissance de calcul, suscitant des critiques selon lesquelles OpenAI était "trop cher". Une grande partie de cette puissance de calcul provient de la plateforme de cloud computing de Microsoft.

Si OpenAI trouve comment gagner de l'argent avec des produits comme ChatGPT et l'outil de création d'images Dall-E, 75 % des bénéfices reviennent à Microsoft jusqu'à ce qu'il récupère la totalité de son investissement initial.

En plus des bénéfices, il existe également le marché technologique le plus important.

OpenAI et Microsoft entretiennent un partenariat de facto depuis le premier investissement de Microsoft en 2019. Cet investissement est essentiellement la formalisation de ce partenariat, permettant aux deux sociétés d'unir leurs forces pour accélérer conjointement la recherche.

Après cet investissement, Microsoft peut travailler avec OpenAI pour développer une technologie sur sa propre plateforme cloud.

Cela place presque immédiatement Microsoft à l'avant-garde de la technologie grand public probablement la plus importante de la prochaine décennie. Lorsque la plateforme Azure, qui domine déjà les trois tiers du monde dans le domaine du cloud commercial, rencontre OpenAI et ChatGPT, sur le futur marché du cloud, il semble que Microsoft veuille « tout avoir » en 2B et 2C.

Pour Microsoft, d'un point de vue stratégique, cet investissement est un énorme "coup".

En particulier, un concurrent important, Google, a déjà participé au développement de certaines technologies OpenAI. L'intégration de ChatGPT et de Bing cible directement le cœur de métier de Google en matière de recherche. Cet investissement devrait réduire davantage les ambitions de Google en matière de mise en page de l'IA.

De l’avis de Microsoft, OpenAI continuera très probablement à être loin devant les autres sociétés d’algorithmes d’IA utilisant des produits tels que ChatGPT à l’avenir.

Après l'entrée des grands fabricants dans l'industrie, il deviendra de plus en plus difficile pour ces nouvelles sociétés d'IA de creuser de nouveaux « fossés » et de générer des effets de réseau. Sans cela, ce sera très difficile dans le domaine de la technologie grand public. pour gagner de l'argent.

De ce point de vue, l’investissement de Microsoft se concentre sur le positionnement.

De nombreux géants de la technologie s’intéressent également de près à l’avenir de l’intelligence artificielle. Ils savent que les entreprises qui contrôlent les technologies de base bénéficieront d’un grand avantage dans les prochaines années. En investissant dans OpenAI, Microsoft se positionne à l’avant-garde de cette révolution de l’IA.

Alors que le monde continue d'être transformé par l'intelligence artificielle, cette combinaison de Microsoft et d'OpenAI n'est peut-être qu'un début. L’avenir est prometteur et Microsoft et OpenAI espèrent être à l’avant-garde de cette révolution de l’IA.

AI se bat farouchement contre la foule, qui aura le dernier mot ?

Google : Un peu déçu

Microsoft s'envole dans le domaine de l'IA, ce qui fait vomir du sang à Google.

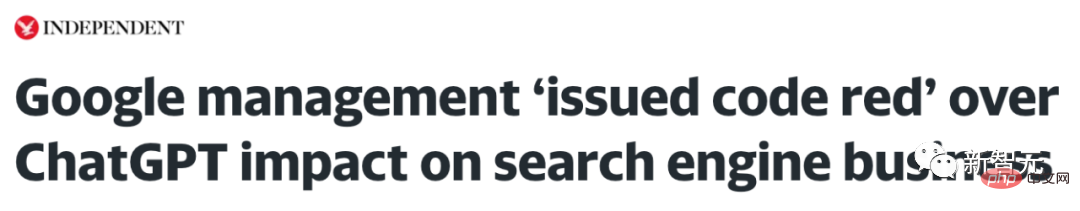

La récente popularité de ChatGPT a attiré l'attention du monde entier, et Google se sent probablement un peu aigre.

Google a également eu l'opportunité d'emprunter cette voie. Google n’est pas désavantagé en matière de chatbots. Dès la conférence I/O de mai 2021, le système d'intelligence artificielle LaMDA de Google avait étonné tout le monde lors de sa présentation.

Mais en raison de considérations telles que le « risque de réputation », Google n'avait pas prévu de commercialiser des chatbots auparavant.

Google est considéré comme le grand frère dans le domaine de l'IA.

Pichai a demandé à certaines équipes de changer de direction et de développer des produits d'IA.

Transformer inventé par Google est la technologie clé pour prendre en charge le dernier modèle d'IA ; selon les rumeurs, le robot de discussion LaMDA de Google a de bien meilleures performances que ChatGPT. De plus, Google affirme également que la capacité de génération d'images de son propre modèle ; Imagen est meilleur que Dall-E, ainsi que les modèles d'autres sociétés.

Cependant, ce qui est légèrement embarrassant, c'est que le chatbot et les modèles d'images de Google n'existent actuellement que dans des « revendications » et qu'il n'existe aucun produit réel sur le marché.

Il n’est pas surprenant que Google le présente ainsi. Dans de nombreux cas, Google ne prévoit pas utiliser l’IA à des fins commerciales.

Google maintient depuis longtemps sa mission consistant à utiliser l'apprentissage automatique pour améliorer les moteurs de recherche et d'autres produits destinés aux consommateurs, et à fournir la technologie Google Cloud en tant que service. Le moteur de recherche a toujours été le cœur de métier de Google.

Il existe un problème inévitable : dans les moteurs de recherche, les utilisateurs sont toujours le décideur final. Bien que le lien soit fourni par Google, c'est l'utilisateur qui décide sur quel lien cliquer.

Google rend ses produits très intelligents. Au lieu de facturer les annonceurs par impression (car cette valeur était difficile à déterminer, surtout il y a 20 ans), il facture par clic. C'est vraiment un produit révolutionnaire.

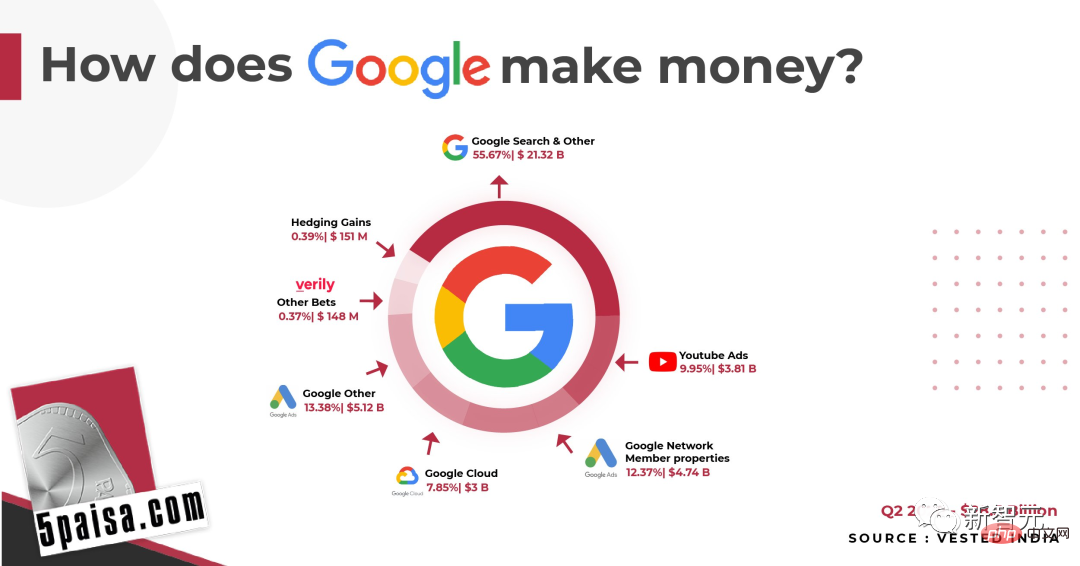

La plupart des revenus de Google proviennent de la publicité en ligne

Maintenant, Google peut gagner 208 milliards de dollars par an grâce aux revenus publicitaires sur les moteurs de recherche, ce qui représente 81 % du chiffre d'affaires total. Par conséquent, il est prudent dans la manière de présenter l’IA, comme les modèles de langage.

Il y a sept ans, l'analyste commercial américain Ben Thompson écrivait un article "Google and Strategic Limitations", évoquant les difficultés rencontrées par l'activité de Google dans le domaine de l'IA -

Une période avant iOS 6 En 2016, Apple introduisait son assistant vocal Siri pour la première fois. Les implications pour Google sont profondes car l'assistant vocal doit être plus proactif qu'une page de résultats de recherche. Il ne suffit pas de fournir des réponses possibles. L'assistant doit donner la bonne réponse.

En 2016, Google a lancé Google Assistant. Cependant, pour des centaines de millions d'utilisateurs iOS, s'ils souhaitent utiliser Google Assistant, ils doivent le télécharger séparément. De plus, le moteur de recherche Google peut gagner de l'argent en permettant aux utilisateurs de cliquer plus de fois. Qu'en est-il de Google Assistant ?

Maintenant, sept années se sont écoulées et, quel que soit le degré d'innovation du principal modèle commercial de Google, il continue à « intégrer davantage d'annonces dans le processus de recherche ». Sur les appareils mobiles, cela fonctionne très bien.

Google Assistant fonctionnant sur Pixel

Google Assistant fonctionnant sur Pixel

Mais maintenant, l'environnement a changé. Les grands modèles de langage tels que ChatGPT apportent une innovation disruptive.

Alors que les produits disruptifs s’améliorent de plus en plus, les produits actuels de Google deviennent de plus en plus volumineux. Peu importe comment vous le regardez, ce n’est pas bon signe.

Récemment, Google a annoncé une mise à niveau de son moteur de recherche, permettant aux utilisateurs de saisir moins de mots-clés et d'obtenir plus de résultats.

Concernant la crise à laquelle Google est confronté, Emad Mostaque, le fondateur de Stability AI, a commenté : "Google est toujours le leader dans le domaine des grands modèles de langage (LLM), et c'est une équipe incontournable dans l'innovation de l'IA générative.

Quelle est la prochaine étape pour Google ? Avec le laboratoire d'IA en main, ses produits d'IA peuvent-ils réussir à trouver une voie de commercialisation ?

Quelle est la prochaine étape pour Google ? Avec le laboratoire d'IA en main, ses produits d'IA peuvent-ils réussir à trouver une voie de commercialisation ?

Meta : L'argent gagné grâce aux médias sociaux est brûlé dans le métaverse

Comment pouvons-nous parler de mêlée dans le domaine de l'IA sans Meta.

Pour Meta, l'IA est une énorme opportunité et, par conséquent, Meta y a investi d'énormes sommes d'argent.

Meta possède d'énormes centres de données qui sont principalement utilisés pour le calcul CPU, ce qui est nécessaire pour alimenter les services de Meta. Les modèles publicitaires qui pilotent Meta, ainsi que les algorithmes qui recommandent du contenu sur le réseau, nécessitent tous un calcul CPU.

En tant que solution à long terme pour le secteur de la publicité, Meta doit construire un modèle probabiliste et comprendre lesquels ont été convertis et lesquels ne l'ont pas été. Ces modèles probabilistes nécessitent beaucoup de GPU, et si vous utilisez l'A100 de Nvidia, le coût atteindra cinq chiffres (USD). Cependant, cela ne coûte pas cher pour Meta.

Évidemment, Meta a besoin de connaître l'effet publicitaire « certain », car des normes de mesure plus claires sont nécessaires en matière d'investissement. Qu'il s'agisse de Facebook ou de Reels, les modèles d'IA sont la clé pour recommander du contenu, et la construction de ces modèles coûtera inévitablement beaucoup d'argent.

Cet investissement sera rentable à long terme. S'il existe un meilleur positionnement et des recommandations pour les utilisateurs, les revenus augmenteront également ; une fois ces centres de données d'IA construits, le coût de maintenance et de mise à niveau devrait être nettement inférieur au coût initial de leur première construction. De plus, un investissement aussi énorme ne peut être permis par des entreprises autres que Google.

Cependant, cela aidera également les produits Meta à devenir de plus en plus intégrés. Meta développe également sa propre puce IA.

Maintenant, les outils publicitaires de Meta sont puissants, l'ensemble du processus de génération et de test A/B des copies et des images peut être effectué par l'IA, et aucune entreprise n'est meilleure que Meta pour fournir ces capacités à grande échelle.

La publicité de Meta vise à attirer l’attention des consommateurs sur des produits et services dont ils ignoraient auparavant. Cela signifie qu'il y aura beaucoup d'erreurs car la grande majorité des annonces ne sont pas converties, mais cela signifie également qu'il y a beaucoup de place pour l'expérimentation et l'itération.

Cela convient très bien à l'IA.

Apple : Le don de l'open source

De nombreuses grandes entreprises investiront dans des logiciels open source. Parce que les entreprises intelligentes tenteront de commercialiser des compléments de produits. Lorsque les prix des compléments d'un produit baissent, la demande pour ce produit augmente, ce qui permet à l'entreprise de facturer plus et de gagner plus d'argent.

L'exemple le plus célèbre de l'investissement d'Apple dans la technologie open source est le noyau Darwin et le moteur de navigateur WebKit utilisés dans son système d'exploitation.

Pendant ce temps, les efforts d’Apple en matière d’IA se sont limités à un petit domaine : la recherche sur les modèles d’apprentissage automatique traditionnels pour les recommandations, la reconnaissance photo et la reconnaissance vocale. Ces études ne semblent pas avoir un impact significatif sur les activités d’Apple.

Cependant, Apple a reçu un cadeau incroyable du monde open source : Stable Diffusion.

Stable Diffusion est remarquable non seulement parce qu'il est open source, mais aussi parce que son modèle est étonnamment petit : lors de sa première sortie, il fonctionnait déjà sur certaines cartes graphiques grand public en quelques semaines, c'est le cas ; optimisé pour fonctionner sur iPhone.

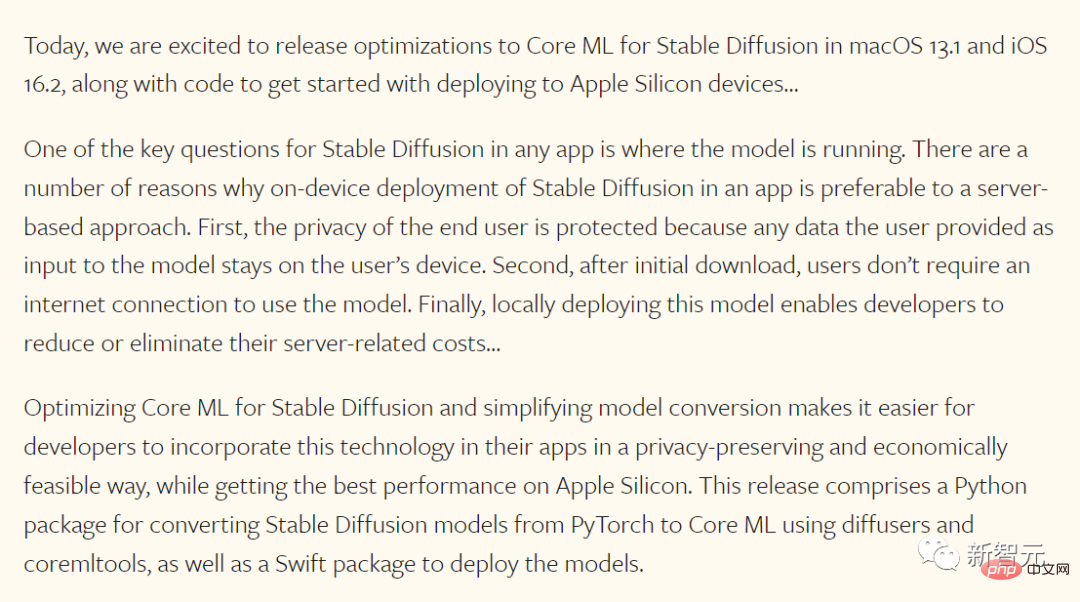

À son honneur, Apple a saisi cette opportunité, et son équipe d'apprentissage automatique a fait l'annonce suivante le mois dernier :

Frappant au tableau, cette annonce se divise en deux parties : Premièrement, Apple optimisé Le modèle Stable Diffusion lui-même (Apple peut le faire car il est open source) ; deuxièmement, Apple a mis à jour le système d'exploitation, qui a été adapté à ses propres puces grâce au modèle intégré d'Apple ;

On peut dire sans se tromper que ce n’est que le début. Bien qu'Apple ait lancé ce qu'on appelle le « moteur neuronal » sur ses propres puces depuis de nombreuses années, le matériel spécifique à l'intelligence artificielle a été adapté aux propres besoins d'Apple ; il semble que les futures puces Apple seront également adaptées à la diffusion stable ;

Dans le même temps, Stable Diffusion lui-même peut être intégré au système d'exploitation d'Apple et fournir une API facilement accessible à tout développeur sans avoir besoin d'une infrastructure backend comme Lensa.

À l'ère de l'Apple Store, Apple semble être un gagnant : les avantages de l'intégration et du silicium peuvent être utilisés pour fournir des applications différenciées, tandis que les petits créateurs d'applications indépendants possèdent l'API et créent de nouveaux canaux de distribution pour les entreprises.

Il semble que les perdants soient les services centralisés de génération d'images (Dall-E ou MidJourney) et les fournisseurs de cloud qui les prennent en charge.

Certes, Stable Diffusion sur les appareils Apple ne conquérira pas l'ensemble du marché - Dall-E et MidJourney sont tous deux meilleurs que Stable Diffusion - mais les capacités locales intégrées auront un impact sur les services centralisés et l'informatique centralisée, la cible ultime. marché.

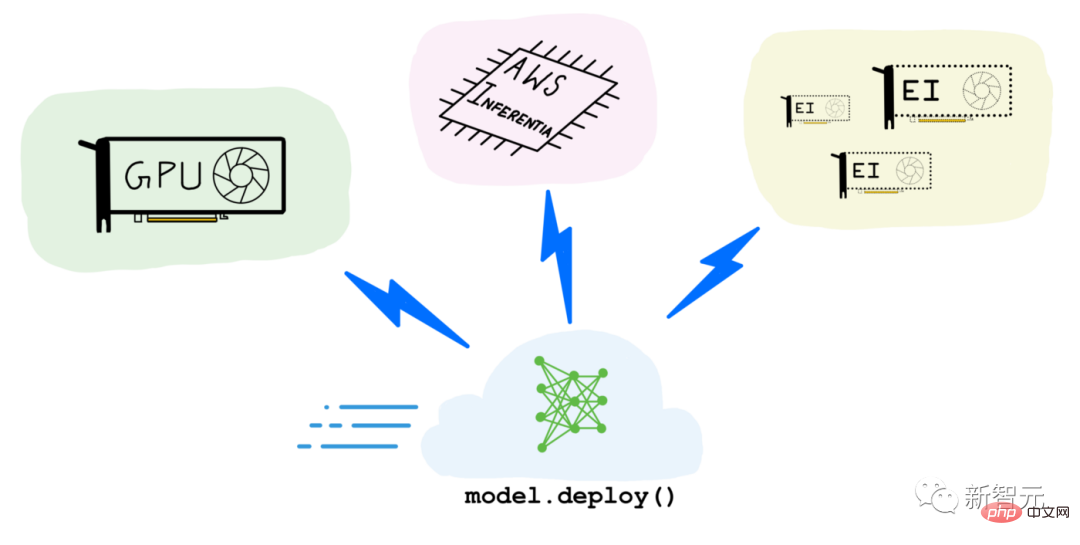

Amazon : j'ai le cloud

Amazon, comme Apple, utilise l'apprentissage automatique dans ses applications, cependant, pour Amazon, les cas d'utilisation de l'IA de génération d'images et de texte chez les consommateurs semblent moins évidents.

Plus important encore pour Amazon, AWS vend l'accès aux GPU dans le cloud. Certains de ces GPU ont été utilisés pour la formation, notamment Stable Diffusion, qui a fonctionné pendant 150 000 heures avec 256 Nvidia A100 et a un prix public de 600 000 $, selon Emad Mostaque, fondateur et PDG de Stability AI. Le prix est déjà incroyablement bas.

Cependant, le cas d'utilisation le plus important est l'inférence, qui consiste à appliquer un modèle pour générer des images ou du texte. Chaque fois qu'un utilisateur génère une image dans MidJourney ou un avatar dans Lensa, l'inférence s'exécute sur les GPU dans le cloud.

Les perspectives d’Amazon dans cet espace dépendront de divers facteurs.

La première et la plus évidente est l’utilité de ces produits dans le monde réel. Amazon est cependant un fabricant de puces à part entière : bien que la plupart de ses efforts se soient jusqu'à présent concentrés sur les processeurs Graviton, il pourrait construire son propre matériel spécialisé pour des modèles comme Stable Diffusion et rivaliser sur les prix.

Malgré cela, AWS parie sur les deux côtés. Les services cloud sont également un partenaire majeur des produits de Nvidia.

Le problème à court terme d'Amazon est de savoir comment mesurer la demande : ne pas avoir suffisamment de GPU entraînera une perte d'argent, cependant, acheter trop de produits inutilisés représentera un coût important pour l'entreprise ; En outre, l’un des défis auxquels est confrontée l’IA est que le raisonnement coûte de l’argent : il y a un coût marginal à utiliser l’IA pour créer des choses.

À l'heure actuelle, les grandes entreprises qui s'efforcent de développer des produits d'IA accrocheurs ne semblent pas encore avoir pris conscience du défi du coût marginal. Même si les services cloud comportent toujours des coûts, la nature discrète des produits d’IA rend plus difficile le financement des itérations nécessaires à l’adéquation produit-marché.

Pour le moment, ChatGPT semble être le produit le plus révolutionnaire à ce jour, non seulement il est gratuit pour les utilisateurs, mais il est propulsé par OpenAI, qui a construit ses propres modèles et a conclu un bon accord avec Microsoft pour la puissance de calcul, ce qui n'est pas le cas. accident.

En conclusion, si AWS vend des GPU à bas prix, cela pourrait stimuler une plus grande utilisation à long terme.

Microsoft, aurez-vous le dernier mot en 2023 ?

En regardant les choses de cette façon, Microsoft semble être dans la meilleure position.

Comme AWS, il dispose d'Azure, un service cloud qui vend des GPU. De plus, c'est également le fournisseur cloud exclusif pour OpenAI ;

Pendant ce temps, Bing est comme Mac à la veille de l'iPhone : il contribue à une part importante des revenus, mais seulement à une fraction dominante. Si ChatGPT est intégré à Bing, Bing risquera peut-être son modèle économique et gagnera d’énormes parts de marché.

Clairement, Microsoft vaut le pari.

De plus, The Information a rapporté que GPT aidera les logiciels bureautiques de Microsoft, et que le logiciel pourrait ajouter de nouvelles fonctionnalités payantes, qui correspondront parfaitement au modèle commercial d'abonnement de Microsoft. Microsoft a déjà un exemple réussi. En imitant GitHub Copilot, il sait créer un assistant au lieu d'un assistant ennuyeux comme Clippy.

GPT entrant dans les logiciels bureautiques, cela risque d'être une étape révolutionnaire. À partir de maintenant, la façon dont 1 milliard de personnes rédigent des documents, des présentations et des e-mails pourrait être changée à jamais.

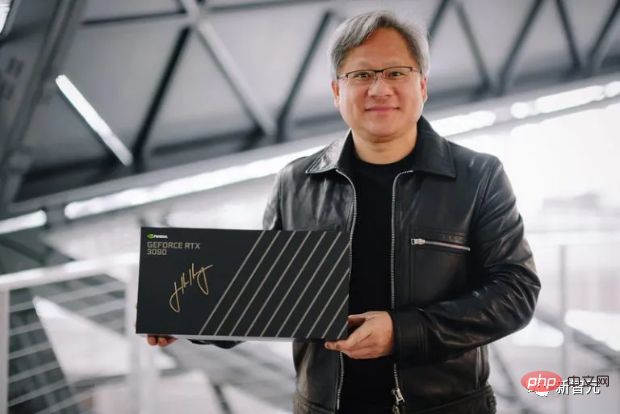

Nvidia et TSMC pourraient être les plus grands gagnants ?

Maintenant, l’IA devient une marchandise, et divers modèles prolifèrent chaque jour.

En fin de compte, les plus grands gagnants sont peut-être NVIDIA et TSMC.

Nvidia a investi dans l'écosystème CUDA, ce qui signifie que Nvidia possède non seulement la meilleure puce d'IA, mais également le meilleur écosystème d'IA, et l'investissement de Nvidia continue de se développer.

Cela a déjà irrité les concurrents, comme les puces TPU de Google.

De plus, au moins dans un avenir prévisible, chaque entreprise devra produire des puces chez TSMC.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI