Périphériques technologiques

Périphériques technologiques IA

IA Comment diviser correctement un ensemble de données ? Résumé de trois méthodes courantes

Comment diviser correctement un ensemble de données ? Résumé de trois méthodes courantesComment diviser correctement un ensemble de données ? Résumé de trois méthodes courantes

La décomposition de l'ensemble de données en un ensemble d'entraînement peut nous aider à comprendre le modèle, ce qui est très important pour la manière dont le modèle se généralise à de nouvelles données invisibles. Un modèle peut ne pas se généraliser correctement à de nouvelles données invisibles s'il est surajusté. Il n’est donc pas possible de faire de bonnes prédictions.

Avoir une stratégie de validation appropriée est la première étape pour réussir à créer de bonnes prédictions et à utiliser la valeur commerciale des modèles d'IA. Cet article a compilé quelques stratégies courantes de fractionnement des données.

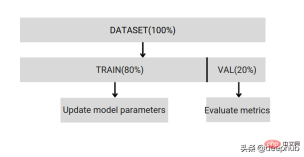

Formation simple et répartition des tests

Divisez l'ensemble de données en parties de formation et de validation, avec 80 % de formation et 20 % de validation. Vous pouvez le faire en utilisant l'échantillonnage aléatoire de Scikit.

Tout d'abord, la graine aléatoire doit être corrigée, sinon la même répartition des données ne peut pas être comparée et les résultats ne peuvent pas être reproduits pendant le débogage. Si l'ensemble de données est petit, rien ne garantit que la répartition de validation puisse être décorrélée de la répartition de formation. Si les données sont déséquilibrées, vous n'obtiendrez pas le même rapport de répartition.

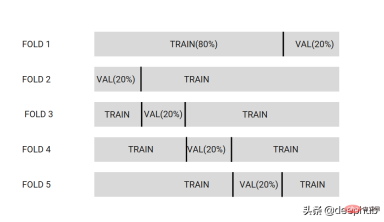

Un simple fractionnement ne peut donc que nous aider à développer et à déboguer. La véritable formation n'est pas assez parfaite, donc les méthodes de fractionnement suivantes peuvent nous aider à mettre fin à ces problèmes. La validation croisée K-fold divise l'ensemble de données en k partitions. Dans l'image ci-dessous, l'ensemble de données est divisé en 5 partitions.

Sélectionnez une partition comme ensemble de données de validation, tandis que les autres partitions sont l'ensemble de données de formation. Cela entraînera le modèle sur chaque ensemble différent de partitions. Au final, K différents modèles seront obtenus, et ces modèles seront utilisés ensemble en utilisant la méthode d'intégration lors du raisonnement et de la prédiction ultérieure.

Au final, K différents modèles seront obtenus, et ces modèles seront utilisés ensemble en utilisant la méthode d'intégration lors du raisonnement et de la prédiction ultérieure.

K est généralement défini sur [3,5,7,10,20]

Si vous souhaitez vérifier les performances du modèle avec un faible biais, utilisez un K [20] plus élevé. Si vous construisez un modèle pour la sélection de variables, utilisez un k faible [3,5] et le modèle aura une variance plus faible.

Avantages :

En faisant la moyenne des prédictions du modèle, vous pouvez améliorer les performances du modèle sur des données invisibles tirées de la même distribution. Il s'agit d'une méthode largement utilisée pour obtenir de bons modèles de production.- Vous pouvez utiliser différentes techniques d'intégration pour créer des prédictions pour chaque donnée de l'ensemble de données, et utiliser ces prédictions pour améliorer le modèle, appelé OOF (out-fold prédiction).

- Question :

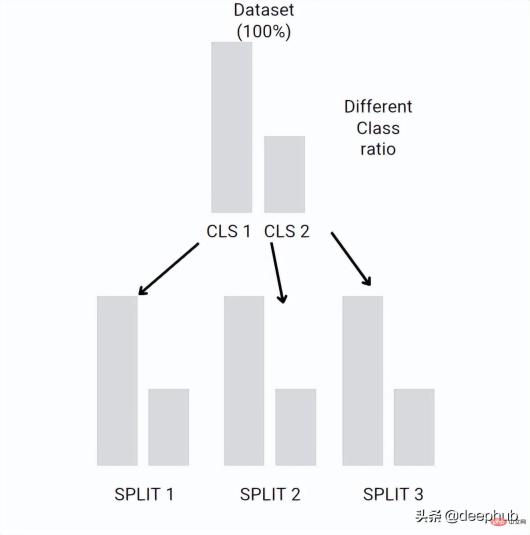

- Stratified-kFold

- peut préserver le rapport entre les différentes classes dans chaque pli. Si l'ensemble de données est déséquilibré, disons que Class1 a 10 exemples et Class2 a 100 exemples. Stratified-kFold crée chaque classification de pli avec le même rapport que l'ensemble de données d'origine

L'idée est similaire à la validation croisée K-fold, mais avec le même rapport pour chaque pli que l'ensemble de données d'origine.

Le ratio initial entre les classes peut être conservé à chaque fractionnement. Si votre ensemble de données est volumineux, la validation croisée du pli K peut également préserver les proportions, mais cela est stochastique, alors que Stratified-kFold est déterministe et peut être utilisé avec de petits ensembles de données. Bootstrap et sous-échantillonnage

Bootstrap et sous-échantillonnage

Bootstrap et sous-échantillonnage sont similaires à la validation croisée K-Fold, mais ils n'ont pas de plis fixes. Il sélectionne aléatoirement certaines données de l'ensemble de données et utilise d'autres données comme validation et les répète n fois

Bootstrap = échantillonnage alterné, que nous avons présenté en détail dans les articles précédents.

Quand l’utiliser ? Bootstrap et Subsamlping ne peuvent être utilisés que si l'erreur standard de l'erreur métrique estimée est importante. Cela peut être dû à des valeurs aberrantes dans l’ensemble de données.

Résumé

Habituellement, dans l'apprentissage automatique, la validation croisée k-fold est utilisée comme point de départ. Si l'ensemble de données est déséquilibré, Stratified-kFold est utilisé. S'il existe de nombreuses valeurs aberrantes, Bootstrap ou d'autres méthodes peuvent être utilisées pour. améliorer le repliement des données.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment construire votre assistant d'IA personnel avec HuggingFace SmollmApr 18, 2025 am 11:52 AM

Comment construire votre assistant d'IA personnel avec HuggingFace SmollmApr 18, 2025 am 11:52 AMExploiter la puissance de l'IA sur disvise: construire une CLI de chatbot personnelle Dans un passé récent, le concept d'un assistant d'IA personnel semblait être une science-fiction. Imaginez Alex, un passionné de technologie, rêvant d'un compagnon d'IA intelligent et local - celui qui ne dépend pas

L'IA pour la santé mentale est attentivement analysée via une nouvelle initiative passionnante à l'Université de StanfordApr 18, 2025 am 11:49 AM

L'IA pour la santé mentale est attentivement analysée via une nouvelle initiative passionnante à l'Université de StanfordApr 18, 2025 am 11:49 AMLeur lancement inaugural de l'AI4MH a eu lieu le 15 avril 2025, et le Dr Tom Insel, M.D., célèbre psychiatre et neuroscientifique, a été le conférencier de lancement. Le Dr Insel est réputé pour son travail exceptionnel dans la recherche en santé mentale et la techno

La classe de draft de la WNBA 2025 entre dans une ligue qui grandit et luttant sur le harcèlement en ligneApr 18, 2025 am 11:44 AM

La classe de draft de la WNBA 2025 entre dans une ligue qui grandit et luttant sur le harcèlement en ligneApr 18, 2025 am 11:44 AM"Nous voulons nous assurer que la WNBA reste un espace où tout le monde, les joueurs, les fans et les partenaires d'entreprise, se sentent en sécurité, appréciés et autonomes", a déclaré Engelbert, abordé ce qui est devenu l'un des défis les plus dommageables des sports féminins. L'anno

Guide complet des structures de données intégrées Python - Analytics VidhyaApr 18, 2025 am 11:43 AM

Guide complet des structures de données intégrées Python - Analytics VidhyaApr 18, 2025 am 11:43 AMIntroduction Python excelle comme un langage de programmation, en particulier dans la science des données et l'IA générative. La manipulation efficace des données (stockage, gestion et accès) est cruciale lorsqu'il s'agit de grands ensembles de données. Nous avons déjà couvert les nombres et ST

Premières impressions des nouveaux modèles d'Openai par rapport aux alternativesApr 18, 2025 am 11:41 AM

Premières impressions des nouveaux modèles d'Openai par rapport aux alternativesApr 18, 2025 am 11:41 AMAvant de plonger, une mise en garde importante: les performances de l'IA sont non déterministes et très usagées. En termes plus simples, votre kilométrage peut varier. Ne prenez pas cet article (ou aucun autre) article comme le dernier mot - au lieu, testez ces modèles sur votre propre scénario

Portfolio AI | Comment construire un portefeuille pour une carrière en IA?Apr 18, 2025 am 11:40 AM

Portfolio AI | Comment construire un portefeuille pour une carrière en IA?Apr 18, 2025 am 11:40 AMConstruire un portefeuille AI / ML hors concours: un guide pour les débutants et les professionnels La création d'un portefeuille convaincant est cruciale pour sécuriser les rôles dans l'intelligence artificielle (IA) et l'apprentissage automatique (ML). Ce guide fournit des conseils pour construire un portefeuille

Ce que l'IA agentique pourrait signifier pour les opérations de sécuritéApr 18, 2025 am 11:36 AM

Ce que l'IA agentique pourrait signifier pour les opérations de sécuritéApr 18, 2025 am 11:36 AMLe résultat? L'épuisement professionnel, l'inefficacité et un écart d'élargissement entre la détection et l'action. Rien de tout cela ne devrait être un choc pour quiconque travaille en cybersécurité. La promesse d'une IA agentique est devenue un tournant potentiel, cependant. Cette nouvelle classe

Google contre Openai: la lutte contre l'IA pour les étudiantsApr 18, 2025 am 11:31 AM

Google contre Openai: la lutte contre l'IA pour les étudiantsApr 18, 2025 am 11:31 AMImpact immédiat contre partenariat à long terme? Il y a deux semaines, Openai s'est avancé avec une puissante offre à court terme, accordant aux étudiants des États-Unis et canadiens d'accès gratuit à Chatgpt Plus jusqu'à la fin mai 2025. Cet outil comprend GPT - 4O, un A

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Version Mac de WebStorm

Outils de développement JavaScript utiles

Télécharger la version Mac de l'éditeur Atom

L'éditeur open source le plus populaire

DVWA

Damn Vulnerable Web App (DVWA) est une application Web PHP/MySQL très vulnérable. Ses principaux objectifs sont d'aider les professionnels de la sécurité à tester leurs compétences et leurs outils dans un environnement juridique, d'aider les développeurs Web à mieux comprendre le processus de sécurisation des applications Web et d'aider les enseignants/étudiants à enseigner/apprendre dans un environnement de classe. Application Web sécurité. L'objectif de DVWA est de mettre en pratique certaines des vulnérabilités Web les plus courantes via une interface simple et directe, avec différents degrés de difficulté. Veuillez noter que ce logiciel

SublimeText3 version anglaise

Recommandé : version Win, prend en charge les invites de code !

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)