Maison >Périphériques technologiques >IA >Yang Dong, directeur technique de la plateforme Unity Greater China : Démarrer le voyage humain numérique dans le métaverse

Yang Dong, directeur technique de la plateforme Unity Greater China : Démarrer le voyage humain numérique dans le métaverse

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-08 18:11:091179parcourir

En tant que pierre angulaire de la création de contenu métaverse, les personnes numériques sont les premiers scénarios matures de subdivision métaverse qui peuvent être mises en œuvre et développées de manière durable. Actuellement, les idoles virtuelles, la livraison de commerce électronique, l'hébergement TV, les présentateurs virtuels, etc. Les applications commerciales ont été reconnues par le public. Dans le monde du Metaverse, l'un des contenus les plus essentiels n'est autre que les humains numériques, car les humains numériques ne sont pas seulement les « incarnations » des humains du monde réel dans le Metaverse, ils sont également l'un des véhicules importants pour nous de effectuer diverses interactions dans celui du Metaverse.

Il est bien connu que la création et le rendu réalistes de personnages humains numériques sont l'un des problèmes les plus difficiles en infographie. Récemment, lors du sous-site « Game and AI Interaction » de la conférence MetaCon Metaverse Technology organisée par 51CTO, Yang Dong, directeur technologique de la plate-forme Unity Greater China, a donné une série de démonstrations dans « Unity Digital Human Technology - Starting a Journey to le Metaverse" "Le partage thématique de la technologie de pipeline de rendu Unity HD est présenté en détail.

1. Introduction à Unity

Unity est actuellement la plate-forme informatique la plus prise en charge au monde et prend désormais en charge près de 30 plates-formes informatiques, dont PC, Mac, Linux, iOS, Android, Switch, PlayStation, Xbox et tous les appareils AR/VR, MMAT et autres. Si vous produisez du contenu interactif en trois dimensions, Unity est actuellement le meilleur choix. Nous savons que le rendu haute définition est utilisé pour restituer du contenu haute définition sur certaines machines équipées de cartes graphiques indépendantes. La technologie humaine numérique dite réaliste s'appuie désormais sur la technologie de rendu haute définition.

Actuellement, l'équipe Unity Chine compte plus de 300 employés à temps plein, près de 7 000 personnes dans le monde, et plus de 70 % sont des ingénieurs. Le siège social est à Shanghai, avec des bureaux à Pékin et Guangzhou, et les employés correspondants y travaillent.

2. Quels sont les aspects puissants du moteur Unity ?

À l'heure actuelle, bien que Unity ne soit pas un moteur Kaiyuan, ses modules sont hautement personnalisables.

L'image montre les plateformes actuellement prises en charge par Unity. Certaines des plateformes les plus courantes peuvent être trouvées sur ces icônes. Il s'agit peut-être de certains des jeux les plus populaires de ces dernières années, et certaines de ces icônes sont relativement familières, comme Honor of Kings, CALL DUTY, League of Legends, Genshin Impact, Fall Bean Man, Shining Nuan Nuan... En fait, plus de 70 % des 1 000 jeux les plus rentables sur les listes Android et iOS nationales et étrangères sont créés par Unity. Plus de la moitié des jeux Switch sont réalisés avec Unity. Vous ne croirez peut-être pas qu'un jeu qui a l'air très complexe avec une qualité graphique élevée et qui était un jeu à succès lancé pour la première fois sur Xbox, a été développé par une seule personne, ce qui démontre pleinement la flexibilité du moteur Unity et la puissance de la chaîne d'outils. .

Unity évolue dans le sens de hautes performances et d'efficacité. Laissez-moi vous expliquer les trois principaux composants du système Dots, le système C#Job, ECS et le compilateur Burst. Le système C#Job permet en fait aux jeux ou applications développés d'utiliser pleinement la puissance de calcul simultanée du processeur intégré, car le modèle de programmation orienté objet actuel est le contenu de production, qui s'exécute sur le thread principal. Le second est le système de composants d'entité (ECS). Grâce au système de composants d'entité, les données peuvent être séparées du système, c'est-à-dire la logique du jeu, qui est plus facile à maintenir et plus conviviale pour l'utilisation de la mémoire. Burst Compiler peut générer un code machine plus performant pour la plate-forme cible.

D'un autre côté, une qualité d'image élevée est également une très bonne fonctionnalité d'Unity. Si vous dites simplement que vous devez utiliser un PC coûteux ou une machine Xbox ou Playstation coûteuse pour restituer de beaux graphismes, en fait la polyvalence du jeu est trop faible. Unity utilise XRP, ce qu'on appelle le pipeline de rendu variable, pour créer deux ensembles de pipelines de rendu prêts à l'emploi pour tout le monde. L'un est le pipeline de rendu universel URP et le second est le HDRP (pipeline de rendu haute définition). . Comme son nom l'indique, le pipeline de rendu universel d'URP est pris en charge par toutes les plateformes. Que vous développiez des jeux VR, des jeux AR ou des jeux mobiles, URP peut être utilisé pour les travaux de rendu. HDRP fait référence aux plates-formes PC Mac Linux, Xbox1 et basestation4 et supérieures, qui prennent également en charge le traçage de rayons en temps réel.

3. Comment le pipeline de rendu HD permet-il d'obtenir un rendu de haute qualité des humains numériques ?

L'homme numérique « Païen » n'est en fait pas le premier homme numérique produit par Unity, mais l'homme numérique « Païen » a sa propre unicité, car cet homme numérique est très réaliste et constitue un ensemble complet de flux de travail. . Pour obtenir un rendu de haute qualité comme "Infidel", un pipeline de rendu haute définition est essentiel.

La personne numérique "The Infidel" a en fait un prototype. Il s'agit d'un acteur de théâtre britannique à Londres, nommé Jack. En scannant ses données, ce sont les données de tout son corps, et l'objectif est de scanner sa tête. Ces données sont utilisées pour créer l'intégralité de l'humain numérique. Les expressions sont très réalistes. Une technologie vidéo volumétrique 4D est utilisée pour créer des animations d'expression. Le défaut est qu'il ne peut pas être piloté en temps réel. Il peut réaliser des animations d'expression de personnages au cinéma et à la télévision sans aucun problème, mais il ne peut pas être piloté en temps réel.

Dans certains cas réussis, vous pouvez jeter un œil au rendu des yeux et du rendu de la peau, examinons-les respectivement.

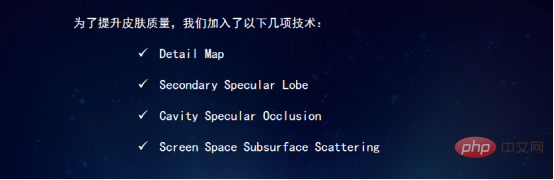

Afin d'améliorer la qualité de la peau, les technologies suivantes ont été ajoutées. Detail Map est une carte détaillée. Le lobe spéculaire secondaire est le point culminant de la deuxième couche, l'occlusion spéculaire de la cavité fait référence à la dépression, qui peut bloquer le point culminant, et la diffusion souterraine de l'espace d'écran fait référence à la diffusion souterraine de l'espace de l'écran.

La première carte détaillée est principalement utilisée pour simuler des textures telles que des détails sur la surface de la peau. Cette texture n'est pas grande, c'est une texture 1K.

La deuxième couche de surbrillance, Lobe spéculaire secondaire, est utilisée pour simuler la couche d'huile à la surface de la peau. Parce que la peau va être grasse et que même la peau a l'air sèche, il est nécessaire de l'utiliser. méthode pour ajouter une deuxième couche de surbrillance.

Le troisième est le point culminant en contrebas, qui consiste à couvrir le point culminant au centre de la zone en contrebas. Après avoir ajouté la deuxième couche de reflets, des reflets apparaissent également dans les zones creuses de la peau, ce qui est évidemment irréaliste. Les reflets doivent être masqués afin qu'aucun reflet n'apparaisse dans les zones creuses.

Le quatrième est la diffusion souterraine dans l'espace de l'écran, qui est utilisée pour créer l'effet de la peau elle-même. Nous savons que la peau elle-même a un effet dit 3S, appelé effet de diffusion souterraine. La peau doit évidemment utiliser la diffusion souterraine, mais traditionnellement, lorsque nous utilisons un logiciel de rendu hors ligne tel que MAYA ou 3Dmax pour simuler cette peau, le rendu de l'effet de la diffusion souterraine prend beaucoup de temps. Dans Unity, il existe en fait deux techniques pour restituer les effets de diffusion souterraine. La première est la technologie Screen Space Subsurface Scattering, qui rend le rendu plus rapide. La seconde est celle du vol léger. De toute évidence, la méthode de vol léger est plus réaliste.

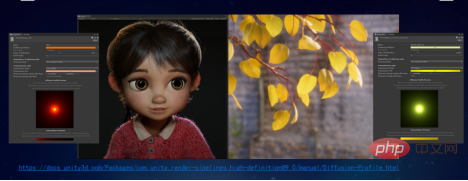

Ce personnage est le personnage de la petite fille dans le court métrage "The Wind-Up Musician". Le personnage de la petite fille utilise également l'effet de diffusion souterraine de l'espace de l'écran. Les feuilles de droite utilisent en fait l’effet de diffusion souterraine.

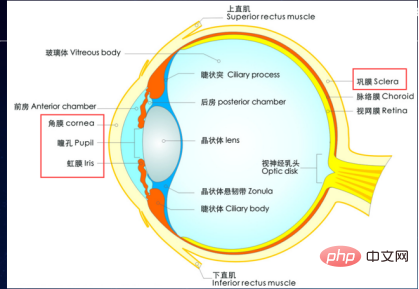

Parlons ensuite du rendu pour les yeux. En fait, l'œil est un objet très complexe. Il est composé de nombreuses parties. En simulant un véritable globe oculaire dans un rendu en temps réel, la simulation de quatre parties : la cornée, la pupille, l'iris et la sclère permet déjà d'obtenir des effets très réalistes.

Comme le montre l'image, notre globe oculaire lui-même est un objet très complexe. Il y a en fait une différence entre la vue de face et la vue de côté, en particulier le phénomène de réfraction en perspective de l'iris s'il est rendu normalement. , cette photo est du très célèbre personnage de Digital Man à la GDC.

Le globe oculaire humain numérique est en fait modélisé selon la forme d'un globe oculaire réel, et il aura des peintres spéciaux pour représenter les différents paramètres du globe oculaire. Y compris sa réflexion, les cartes normales sur la sclère et l'iris, les effets qui peuvent être obtenus en appliquant différentes valeurs normales, et même l'occlusion des paupières, qui peut être contrôlée par un contrôleur séparé, afin que les paupières puissent être contrôlées. Effet .

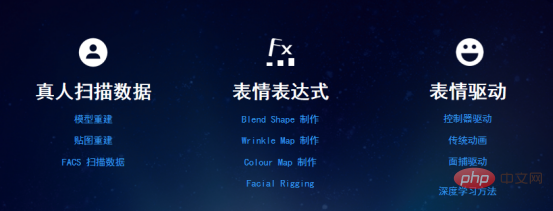

Pour résumer, les expressions sont créées à l'aide d'une forme de mélange, d'une carte des rides, d'une carte de couleurs et d'un gréement du visage à l'aide de données numérisées par une personne réelle, et un contrôleur est utilisé pour piloter l'expression. Bien sûr, nous savons également qu'il existe de nombreuses autres façons de piloter cette expression. En fait, lorsque nous rendons la peau, les yeux ou les cheveux, c'est relativement facile, mais la conduite d'expression est en réalité un point très difficile.

J'entends souvent les développeurs dire pourquoi l'Unity qu'ils utilisent ne peut pas produire les effets que Unity peut produire ? Parce que les effets des démos présentées par Unity ont été créés par un groupe de personnes avec beaucoup d'efforts, et que les technologies qu'ils ont utilisées n'étaient en fait pas encore disponibles dans la version qu'ils ont produite. Après avoir terminé cette démo et avoir ces technologies, elle le sera progressivement. Combiné dans la prochaine version, il formera à terme une version fonctionnelle que tout le monde pourra utiliser.

4. Quel est le processus de création d'un humain numérique ?

Après avoir terminé "Infidel", l'équipe d'Unity Chine a créé son propre humain numérique, en appliquant la technologie "Infidel", la numérisation 4D et d'autres technologies.

Il s'agit d'un véritable projet, et le processus est en fait exactement le même que celui de "Infidel". Y compris le nettoyage des données, la création de la forme de mélange correspondante, la création de Wrinkle Map, la création de Rig, puis le pilotage de l'expression. Le contrôleur dans ASSETStore utilise Animation Clip et BlendShape pour présenter l'animation de l'expression. Bien sûr, il existe en fait d'autres façons de capturer des visages, comme utiliser Market pour suivre, utiliser ARKit pour suivre et utiliser des données d'image pour piloter.

Lors du développement réel, utilisez l'appareil photo pour capturer des expressions afin de tester les expressions de la tête humaine. Il existe une autre façon d'utiliser les données d'image pour conduire. Une très grande différence est qu'elle a des cheveux longs et flottants. Ces cheveux longs et flottants sont une solution développée par l'équipe Unity China. Ils conviennent à l'URP et au HDRP et conviennent à la fois aux pipelines de rendu généraux et aux pipelines de rendu de haute qualité. cheveux. Le rendu des cheveux est très différent de la méthode traditionnelle du plug-in. Il peut être très lisse et ressembler même à l’effet d’une publicité Head & Shoulders. Les expressions sont en fait pilotées en temps réel via AR cade, et bien sûr AR cade est utilisé pour piloter les expressions.

Unity dispose d'un humain numérique appelé Emma. L'expression de cet humain numérique est entièrement pilotée de manière dynamique par la technologie Ziva Dynamics. La technologie de base consiste en fait à simuler ces groupes musculaires sous le modèle ou sous la peau biologique, qui peut soit simuler le groupe musculaire. mouvement des muscles du corps réel des dinosaures, cette technologie peut également être appliquée, par exemple, à la simulation d'expressions faciales très réalistes d'humains numériques. Traditionnellement, un modèle est une coque vide avec une coque à l'extérieur. Mais dans la technologie de Ziva Dynamics, il existe en réalité de véritables muscles anatomiques sur le dos. Lorsque ces muscles sont déplacés de manière réaliste, l'extérieur de ces peaux peut atteindre un niveau différent ou supérieur. niveau de réalisme que la forme traditionnelle de mélange ou la méthode de liaison osseuse.

En mars de cette année, Unity a publié la dernière bande-annonce humaine numérique de "Enemies" à la GDC. L'expression de cet humain numérique est très, très réelle. Il convient de mentionner que ses cheveux sont un ensemble de technologies de rendu de fourrure que Unity publiera bientôt, un ensemble de cheveux appliqué au pipeline de rendu haute définition HDRP.

Bienvenue sur le site officiel de la MetaCon Metaverse Technology Conference pour en savoir plus sur le métaverse et les humains numériques. Adresse : https://metacon.51cto.com/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI