Maison >Périphériques technologiques >IA >Quand l'IA rencontre l'art de la peinture, quel genre d'étincelles vont émerger ?

Quand l'IA rencontre l'art de la peinture, quel genre d'étincelles vont émerger ?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-08 18:21:011502parcourir

Avant-propos

Qu'est-ce que l'IA ? Dans votre esprit, vous pouvez penser à un réseau neuronal composé de neurones empilés les uns sur les autres. Alors, qu’est-ce que l’art de peindre ? S'agit-il du « Sourire de Mona Lisa » de Da Vinci, de « La Nuit étoilée » et des « Tournesols » de Van Gogh ou de « La Fille à la perle » de Johannes Vermeer ? Quand l’IA rencontre l’art de la peinture, quel genre d’étincelles peuvent être créées entre elles ?

Début 2021, l'équipe OpenAI a publié le modèle DALL-E qui peut générer des images basées sur des descriptions textuelles. En raison de ses puissantes capacités de génération d’images multimodales, il a suscité une forte demande parmi les passionnés de technologie du langage naturel et du cercle visuel. En un peu plus d’un an, les technologies de génération d’images multimodales ont commencé à émerger comme des champignons après la pluie. Au cours de cette période, de nombreuses applications utilisant ces technologies pour la création artistique par l’IA sont nées, comme la récente populaire Disco Diffusion. De nos jours, ces applications entrent progressivement dans le champ de vision des créateurs d'art et du grand public, et sont devenues le « stylo magique Ma Liang » dans la bouche de nombreuses personnes.

Cet article part des intérêts techniques, présente la technologie de génération d'images multimodales et le travail classique, et explore enfin comment utiliser la génération d'images multimodales pour créer un art de peinture magique par l'IA.  L'illustration de peinture IA créée par l'auteur à l'aide de Disco Diffusion

L'illustration de peinture IA créée par l'auteur à l'aide de Disco Diffusion

Concept de génération d'images multimodales

La génération d'images multimodales vise à utiliser des informations modales telles que le texte et l'audio comme guide , générez des images réalistes avec des textures naturelles. Contrairement à la technologie traditionnelle de génération monomodale qui génère des images basées sur le bruit, la génération d'images multimodales a toujours été une tâche très difficile. Les problèmes à résoudre comprennent principalement :

(1) Comment combler le « fossé sémantique », Break. faire tomber les barrières inhérentes entre les modalités ?

(2) Comment générer des images logiques, diversifiées et haute résolution ? Au cours des deux dernières années, avec l'application réussie de Transformer dans des domaines tels que le traitement du langage naturel (tel que GPT), la vision par ordinateur (telle que ViT), la pré-formation multimodale (telle que CLIP) et les technologies de génération d'images représentées par le VAE et le GAN, ils ont été progressivement dépassés par l'étoile montante qu'est le modèle de diffusion, le développement de la génération d'images multimodales est hors de contrôle.

Technologie de génération d'images multimodales et travail classique

Classification

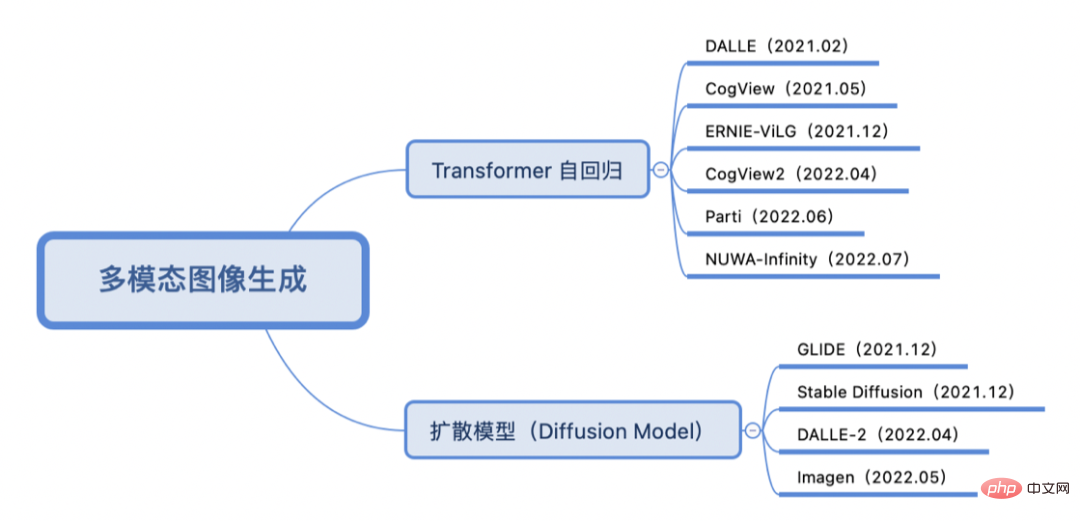

Selon que la méthode de formation est un modèle autorégressif ou de diffusion, le travail clé de génération d'images multimodales au cours des deux dernières années est classé comme suit :

Transformer Autoregressive

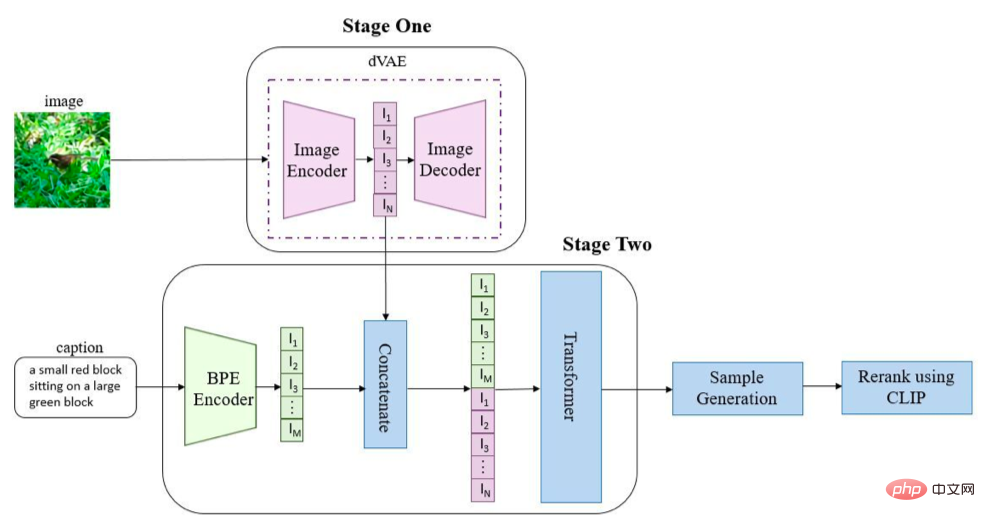

La pratique consistant à utiliser la méthode autorégressive de Transformer convertit souvent le texte et les images en séquences de jetons respectivement, puis utilise l'architecture générative de Transformer pour extraire les données de la séquence de texte (et de la séquence d'images facultative) Prédisez la séquence d'images et enfin utilisez la technologie de génération d'images (VAE, GAN, etc.) pour décoder la séquence d'images afin d'obtenir l'image finale générée. Prenons DALL-E (OpenAI) [1] comme exemple :

Les images et le texte sont convertis en séquences via leurs encodeurs respectifs, assemblés et envoyés à Transformer (GPT3 est utilisé ici) pour une séquence autorégressive génération . Dans l'étape d'inférence, CLIP pré-entraîné est utilisé pour calculer la similarité entre le texte et l'image générée, et la sortie de l'image finale générée est obtenue après tri. Semblable à DALL-E, la série CogView de Tsinghua [2, 3] et ERNIE-ViLG de Baidu [4] utilisent également la conception de l'architecture VQ-VAE + Transformer, tandis que Parti de Google [5] remplace le codec d'image par ViT-VQGAN. NUWA-Infinity [6] de Microsoft utilise des méthodes autorégressives pour obtenir une génération visuelle infinie.

Modèle de diffusion

Le modèle de diffusion est une technologie de génération d'images qui s'est développée rapidement au cours de la dernière année et est saluée comme le terminateur du GAN. Comme le montre la figure, le modèle de diffusion est divisé en deux étapes : (1) Bruitage : ajout progressif de bruit aléatoire à l'image le long du processus de diffusion de la chaîne de Markov (2) Débruitage : apprentissage du processus de diffusion inverse pour restaurer l'image ; Les variantes courantes incluent le modèle de probabilité de diffusion de débruitage (DDPM), etc.

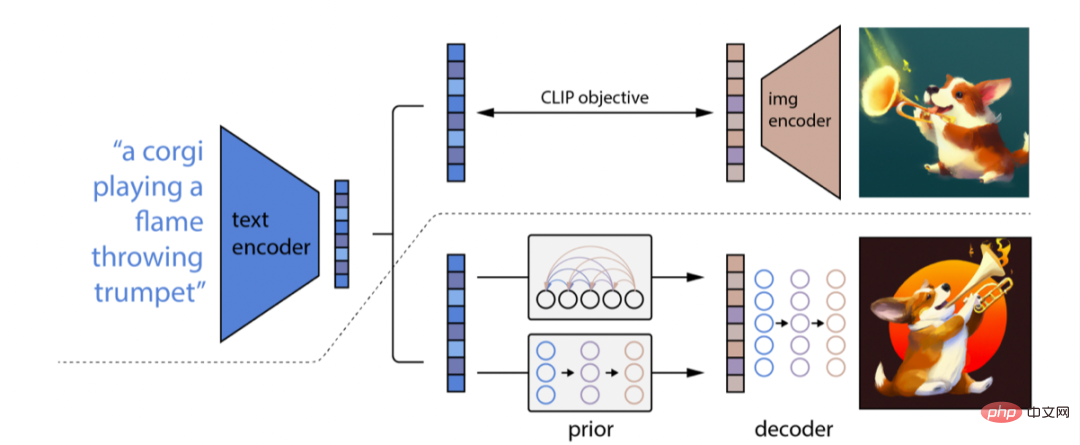

La méthode de génération d'images multimodales utilisant le modèle de diffusion apprend principalement le mappage des caractéristiques du texte aux caractéristiques de l'image via le modèle de diffusion avec guidage conditionnel, et décode les caractéristiques de l'image pour obtenir l'image finale générée. Prenons l'exemple de DALL-E-2 (OpenAI) [7] Bien qu'il s'agisse d'une suite de DALL-E, il emprunte une voie technique complètement différente de DALL-E. Son principe ressemble plus à GLIDE [8] (certaines personnes. appeler GLIDE DALL-E-1.5). L'architecture globale de DALL-E-2 est illustrée dans la figure :

DALL-E-2 utilise CLIP pour encoder le texte et utilise un modèle de diffusion pour apprendre un processus préalable permettant d'obtenir des caractéristiques de texte pour les images A. cartographie des caractéristiques ; enfin, un processus d’inversion de CLIP est appris pour décoder les caractéristiques de l’image dans l’image finale. Par rapport à DALL-E-2, Imagen de Google [9] utilise T5-XXL pré-entraîné pour remplacer CLIP pour l'encodage de texte, puis utilise un modèle de diffusion à super-résolution (architecture U-Net) pour augmenter la taille de l'image, obtenant 1024 ✖️1024 images générées en HD.

Résumé

L'introduction de Transformer autorégressif et de la méthode d'apprentissage comparatif CLIP a établi un pont entre le texte et les images, en même temps, basé sur le modèle de diffusion avec guidage conditionnel, il a jeté les bases d'une génération diversifiée et élevée ; images de résolution. Cependant, l'évaluation de la qualité de la génération d'images est souvent subjective, il est donc difficile de comparer ici la technologie autorégressive ou de modèle de diffusion de Transformer. Et des modèles tels que les séries DALL-E, Imagen et Parti sont formés sur des ensembles de données à grande échelle, et leur utilisation peut entraîner des problèmes éthiques et des préjugés sociaux, de sorte que ces modèles ne sont pas encore open source. Cependant, de nombreux passionnés tentent encore d'utiliser cette technologie, et de nombreuses applications jouables ont été produites au cours de cette période.

AI Art Creation

Le développement de la technologie de génération d'images multimodales offre plus de possibilités pour la création artistique par l'IA. Actuellement, les applications et outils de création d'IA largement utilisés incluent CLIPDraw, VQGAN-CLIP, Disco Diffusion, DALL-E Mini, Midjourney (nécessite une qualification sur invitation), DALL-E-2 (nécessite une qualification bêta interne), Dream By Wombo (App), Meta « Make-A-Scene », fonction Tiktok « AI Green Screen », Stable Diffusion [10], Baidu « Yige », etc. Cet article utilise principalement Disco Diffusion, qui est populaire dans le cercle de la création artistique, pour la création artistique IA.

Introduction à Disco Diffusion

Disco Diffusion [11] est une application de création artistique d'IA maintenue conjointement par de nombreux passionnés de technologie sur Github. Elle a déjà itéré plusieurs versions. Il n'est pas difficile de voir d'après le nom de Disco Diffusion que la technologie qu'elle utilise est principalement un modèle de diffusion guidé par CLIP. Disco Diffusion peut générer des images ou des vidéos artistiques basées sur des descriptions textuelles spécifiées (et des fonds de carte facultatifs). Par exemple, si vous saisissez "Mer de fleurs", le modèle générera aléatoirement une image de bruit et parcourra étape par étape le processus de diffusion de débruitage de Diffusion. Après avoir atteint un certain nombre d'étapes, une belle image pourra être rendue. Grâce aux diverses méthodes de génération du modèle de diffusion, vous obtiendrez des images différentes à chaque fois que vous exécuterez le programme. Cette expérience « d'ouverture de boîte aveugle » est vraiment fascinante.

Disco Diffsion a des problèmes

La création d'IA basée sur le modèle de génération d'images multimodal Disco Diffusion (DD) a actuellement les problèmes suivants :

(1) La qualité des images générées varie : en fonction de la difficulté de la génération tâche, Une estimation approximative est que le taux de rendement des tâches de génération avec un contenu de description difficile est de 20 % à 30 %, et le taux de rendement des tâches de génération avec un contenu de description plus facile est de 60 % à 70 %. 30% et 40%.

(2) Vitesse de génération lente + consommation de mémoire importante : en prenant une itération de 250 étapes pour générer une image 1280*768 à titre d'exemple, cela prend environ 6 minutes et utilise la mémoire vidéo V100 16G.

(3) S'appuyer fortement sur l'expérience d'un expert : la sélection d'un ensemble approprié de descripteurs nécessite de nombreux essais et erreurs sur le contenu du texte et la définition du poids, une compréhension du style du peintre et de la communauté artistique, ainsi que la sélection des modificateurs de texte ; l'inclusion de DD Avoir une compréhension approfondie des concepts tels que les temps de guidage CLIP/saturation/contraste/bruit/temps de coupe/coupes internes et externes/taille du dégradé/symétrie/... et doit avoir certaines compétences artistiques. Le grand nombre de paramètres signifie également qu’une solide expérience d’expert est nécessaire pour obtenir une image générée décente.

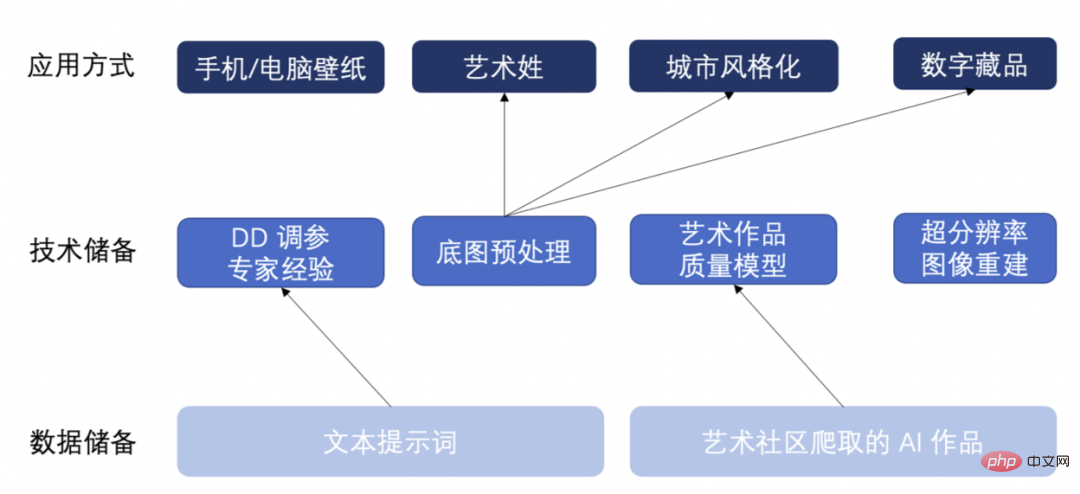

Réserve de compétences

En réponse aux problèmes ci-dessus, nous avons constitué des réserves de données et de technologie, et YY quelques applications futures possibles. Comme le montre l'image ci-dessous :

- En réponse à la première question, nous avons exploré près de 20 000 œuvres d'art générées par l'IA provenant de la communauté de la création artistique et les avons classées en trois catégories en fonction des attributs de base des images générées et de la rationalité du contenu : bonne qualité/qualité moyenne. /mauvaise qualité. Former un modèle d’évaluation de la qualité de l’art. Ce modèle peut évaluer automatiquement la qualité des images générées par l'IA et sélectionner des images à haut rendement, résolvant ainsi le problème de faible efficacité lors de la sélection manuelle d'images de haute qualité.

- Pour le deuxième problème, nous améliorons l'efficacité de la génération de DD en réduisant le nombre d'itérations + en générant des images de petite taille, puis en utilisant l'algorithme de super-résolution ESRGAN pour la reconstruction d'images haute résolution. Cette méthode peut obtenir l'effet d'image généré par une itération normale de DD, et l'efficacité de génération et l'optimisation de la mémoire vidéo sont au moins doublées.

- En réponse à la troisième question, nous avons accumulé un ensemble de logiques de prétraitement de fond de carte, y compris l'ajustement de la température de couleur et de la teinte/l'ajustement des couleurs de premier plan et d'arrière-plan/l'ajout de bruit, etc., qui peuvent appliquer rapidement différentes tâches de génération de fond de carte en même temps ; Au fil du temps, nous avons également accumulé une grande quantité de mots d'invite de texte, un grand nombre d'essais et d'erreurs d'ajustement des paramètres DD ont été effectués, et des images personnalisées, diversifiées et de haute qualité ont été générées en s'appuyant sur l'expérience d'experts.

Grâce à ces données et réserves techniques, nous avons accumulé des méthodes d'application de génération d'images multimodales telles que des fonds d'écran de téléphone portable/ordinateur, des noms/prénoms artistiques, la stylisation de villes emblématiques, des collections numériques, etc. Ci-dessous, nous montrerons des illustrations spécifiques générées par l’IA.

Œuvre d'art IA

Stylisation des bâtiments emblématiques de la ville

En saisissant des descriptions de texte et des fonds de cartes emblématiques de la ville, différents styles de peintures (style anime/style cyberpunk/style pixel art) sont générés :

(1) Un bâtiment avec un anime style, par makoto shinkai et beeple, tendance sur artstation.

(2) Un bâtiment au style cyberpunk, par Gregory Grewdson, tendance sur artstation.

(3) Un bâtiment au style pixel, par Stefan Bogdanovi, tendance sur artstation.

Collection numérique

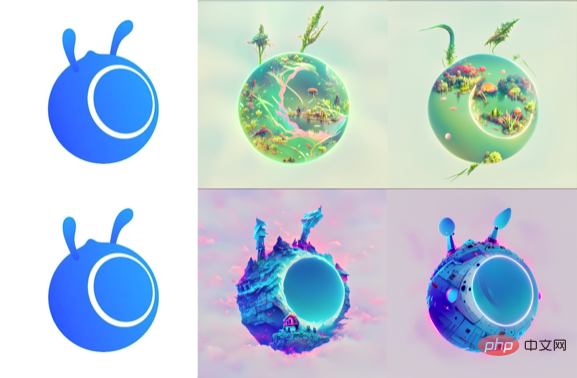

Créez sur le fond de carte en saisissant une description textuelle et un fond de carte.

- Série Ant Logo (Ant Forest/Ant House/Ant Spaceship) :

(1) Un paysage avec végétation et lac, par RAHDS et beeple, Tendance sur artstation.(2) Chalet enchanté au bord d'une falaise paysage fantastique inquiétant, par RAHDS et beeple, tendance sur artstation.

(3) Un vaisseau spatial par RAHDS et beeple, tendance sur artstation.

- Série Ant-Chicken (Chicken Transformers/Chicken Spongebob) :

(1) Transformers with machine armor, par Alex Milne, tendance sur artstation.

(2) Bob l'éponge par RAHDS et beeple, tendance sur artstation.

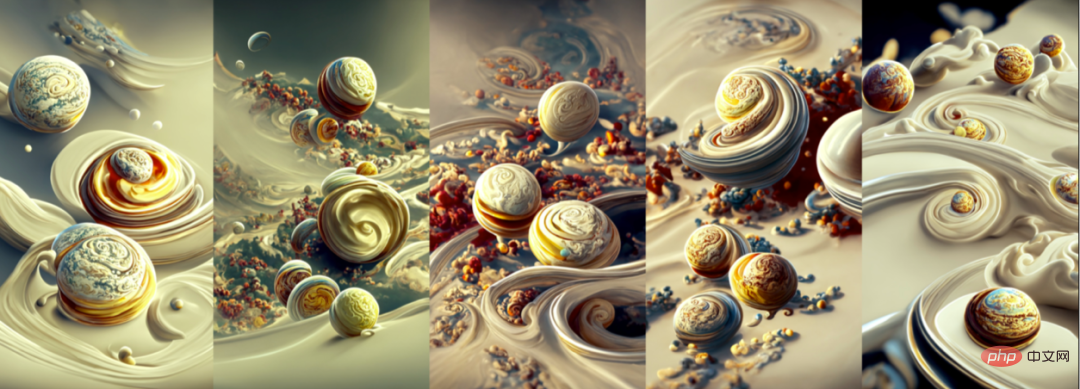

Fond d'écran mobile/ordinateur

- Générer un fond d'écran mobile par saisie de la description du texte :

(1) Le paysage onirique ésotérique de Dan Luvisi, tendance sur Artstation, vaste paysage de matte painting.

(2) Terrasses éparses, hiver, neige, par Makoto Shinka, tendance sur Artstation, fond d'écran 4k.

(3) Une magnifique peinture cloudpunk de l'Atlantide surgissant des abysses annoncée par des baleines steampunk de style rococo Pixar, Artstation, éclairage volumétrique.

(4~8) Une vue panoramique des planètes tournant à travers la crème chantilly par Ernst Haeckel et Pixar tendance sur Artstation, fond d'écran 4k. Shinkai.

(2) Une belle peinture d'une nuit étoilée, éclairant sa lumière sur une mer de tournesols par James Gurney, tendance sur artstation.

- (6) Contra Force, Forteresse rouge, vaisseau spatial, par Ernst Haeckel et Pixar, fond d'écran hd 4k, tendance sur artstation.

(4) Un beau rendu d'un bâtiment magique dans un paysage de rêve par Daniel Merriam, éclairage doux, fond d'écran HD 4k, tendance sur artstation et behance. (1) Usines militaires à grande échelle, machines d'essai de robots, robots semi-finis, véhicules d'ingénierie, gestion de l'automatisation, indicateurs, avenir, science-fiction, effet de lumière , image haute définition.

(2) Une belle peinture de champignons, d'arbres, d'artstation, Artstation, fond d'écran HD 4k.

(4) Une belle peinture du pavillon sur l'eau présente un reflet, par John Howe, Albert Bierstadt, Alena Aenami et Dan Mumford concept art fond d'écran 4k, tendance sur artstation, concept art, cinématique, moteur irréel, tendance sur behance.

(5) Un magnifique paysage d'une jungle luxuriante avec des plantes et des arbres exotiques, par John Howe, Albert Bierstadt, Alena Aenami et Dan Mumford fond d'écran d'art conceptuel 4k, tendance sur artstation, art conceptuel, cinématique, moteur irréel, tendance sur behance.Stable Diffusion [10, 12] 展现了比 Disco Diffusion [11]力,尤其是在«物»的刻画上更加突出。下图是笔者利用 Diffusion Stable并尝试使用多Il s'agit d'un processeur intelligent pour l'IA.行的可能性,以及结合业务为 AI 智能创作赋能,并尝试更多如电影、动漫主题封面,游戏,元宇宙内容创作等更多相关应用。

使用多模态图像生成技术进行Contenu généré par l'IA (AIGC, contenu généré par l'IA) L'AIGC 能够加速落地, 为人类提供更多优质内容。或许,通用人工智能又迈进了一小步?如果你对本文涉及到的技术或者应用感兴趣,欢迎共创交流。

参考文献

[1] Ramesh A, Pavlov M, Goh G et al. Génération de texte en image sans prise de vue[C]//Conférence internationale sur l'apprentissage automatique. PMLR, 2021 : 8821-8831.

[3] Ding M, Zheng W, Hong W et al. CogView2 : génération de texte en image plus rapide et meilleure via des transformateurs hiérarchiques [J]. Préimpression arXiv arXiv :2204.14217, 2022.

[4] Zhang H, Yin W, Fang Y, et al. ERNIE-ViLG : Pré-formation générative unifiée pour la génération bidirectionnelle de langage de vision [J]. Préimpression arXiv arXiv :2112.15283, 2021.[5] Yu J, Xu Y, Koh J Y, et al. Mise à l'échelle des modèles autorégressifs pour la génération de texte en image riche en contenu [J]. Préimpression arXiv arXiv :2206.10789, 2022. [6] Wu C, Liang J, Hu X, et al. NUWA-Infinity : génération autorégressive sur autorégressive pour une synthèse visuelle infinie [J]. Préimpression arXiv arXiv :2207.09814, 2022.

[6] Wu C, Liang J, Hu X, et al. NUWA-Infinity : génération autorégressive sur autorégressive pour une synthèse visuelle infinie [J]. Préimpression arXiv arXiv :2207.09814, 2022.

[7] Ramesh A, Dhariwal P, Nichol A et al. Génération d'images conditionnelles de texte hiérarchique avec latentes de clip [J]. Préimpression arXiv arXiv :2204.06125, 2022.

[8] Nichol A, Dhariwal P, Ramesh A et al. Glide : vers la génération et l'édition d'images photoréalistes avec des modèles de diffusion guidés par le texte[J]. Préimpression arXiv arXiv :2112.10741, 2021.

[9] Saharia C, Chan W, Saxena S, et al. Modèles photoréalistes de diffusion texte-image avec compréhension approfondie du langage [J]. Préimpression arXiv arXiv :2205.11487, 2022.

[10] Rombach R, Blattmann A, Lorenz D et al. Synthèse d'images haute résolution avec modèles de diffusion latente[C]//Actes de la conférence IEEE/CVF sur la vision par ordinateur et la reconnaissance de formes. 2022 : 10684-10695.

[11] Github : https://github.com/alembics/disco-diffusion

[12] Github : https://github.com/CompVis/stable-diffusion

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI