Maison >Problème commun >Sur quoi s'appuie hbase pour stocker les données sous-jacentes

Sur quoi s'appuie hbase pour stocker les données sous-jacentes

- 青灯夜游original

- 2020-11-17 11:28:5415052parcourir

hbase s'appuie sur "HDFS" pour stocker les données sous-jacentes. HBase utilise Hadoop HDFS comme système de stockage de fichiers pour fournir à HBase une prise en charge du stockage sous-jacent de haute fiabilité ; HDFS a une tolérance aux pannes élevée et est conçu pour être déployé sur du matériel à faible coût.

HBase – Hadoop Database est un système de stockage distribué hautement fiable, hautes performances, orienté colonnes et évolutif qui peut être exécuté sur des PC bon marché utilisant la technologie HBase A un cluster de stockage structuré à grande échelle est construit sur le serveur.

hbase s'appuie sur "HDFS" pour stocker les données sous-jacentes.

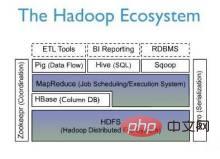

HBase est une implémentation open source de Google Bigtable. Semblable à Google Bigtable, il utilise GFS comme système de stockage de fichiers HBase utilise Hadoop HDFS comme système de stockage de fichiers. Google exécute MapReduce pour traiter Bigtable. HBase utilise également Hadoop MapReduce pour traiter les données massives dans HBase ; Google Bigtable utilise Chubby comme service collaboratif et HBase utilise Zookeeper comme contrepartie.

Hadoop HDFS fournit une prise en charge du stockage sous-jacent de haute fiabilité pour HBase, Hadoop MapReduce fournit à HBase des capacités de calcul hautes performances et Zookeeper fournit des services stables et un basculement pour HBase. .mécanisme.

HDFS

Hadoop Distributed File System (HDFS) fait référence à un système de fichiers distribué (Distributed File System) conçu pour fonctionner sur du matériel à usage général (matériel de base). Système). Il a beaucoup en commun avec les systèmes de fichiers distribués existants. Mais en même temps, la différence entre celui-ci et les autres systèmes de fichiers distribués est également évidente. HDFS est un système hautement tolérant aux pannes, adapté au déploiement sur des machines bon marché. HDFS peut fournir un accès aux données à haut débit et convient parfaitement aux applications sur des ensembles de données à grande échelle. HDFS assouplit certaines contraintes POSIX pour atteindre l'objectif de diffusion en continu des données du système de fichiers. HDFS a été initialement développé comme infrastructure pour le projet de moteur de recherche Apache Nutch. HDFS fait partie du projet Apache Hadoop Core. HDFS présente des caractéristiques de tolérance aux pannes élevées et est conçu pour être déployé sur du matériel à faible coût. Et il offre un débit élevé pour accéder aux données d’application, adapté aux applications comportant de grands ensembles de données. HDFS assouplit les exigences POSIX afin de permettre un accès en streaming aux données du système de fichiers. HDFS adopte un modèle de structure maître/esclave. Un cluster HDFS est composé d'un NameNode et de plusieurs DataNodes. Le NameNode sert de serveur principal, gérant l'espace de noms du système de fichiers et l'accès du client aux fichiers ; le DataNode du cluster gère les données stockées.Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Quelques réflexions et conceptions sur la migration des données de MySQL vers hbase

- Explication détaillée d'exemples d'API Java de la méthode d'accès hbase

- Le temps de récupération de place Java peut également être facilement réduit. Un exemple explique le GC d'Ali-HBase.

- La différence entre Redis et hbase

- Quelles sont les différences entre HBase et Redis ?