Si vous entrez dans le monde du Big Data, vous avez probablement entendu parler d'Apache Spark, un puissant système informatique distribué. PySpark, la bibliothèque Python pour Apache Spark, est l'une des préférées des passionnés de données pour sa combinaison de vitesse, d'évolutivité et de facilité d'utilisation. Mais le configurer sur votre ordinateur local peut sembler un peu intimidant au début.

N'ayez crainte : cet article vous guide tout au long du processus, en abordant les questions courantes et en rendant le voyage aussi simple que possible.

Qu'est-ce que PySpark et pourquoi devriez-vous vous en soucier ?

Avant de procéder à l'installation, comprenons ce qu'est PySpark. PySpark vous permet d'exploiter l'énorme puissance de calcul d'Apache Spark à l'aide de Python. Que vous analysiez des téraoctets de données, construisiez des modèles d'apprentissage automatique ou exécutiez des pipelines ETL (Extract, Transform, Load), PySpark vous permet de travailler avec données plus efficacement que jamais.

Maintenant que vous comprenez PySpark, passons en revue le processus d'installation.

Étape 1 : Assurez-vous que votre système répond aux exigences

PySpark fonctionne sur diverses machines, notamment Windows, macOS et Linux. Voici ce dont vous avez besoin pour l’installer avec succès :

- Java Development Kit (JDK) : PySpark nécessite Java (la version 8 ou 11 est recommandée).

- Python : assurez-vous d'avoir Python 3.6 ou version ultérieure.

- Apache Spark Binary : vous le téléchargerez pendant le processus d'installation.

Pour vérifier l'état de préparation de votre système :

- Ouvrez votre terminal ou votre invite de commande.

- Tapez java -version et python —version pour confirmer les installations de Java et Python.

Si Java ou Python n'est pas installé, suivez ces étapes :

- Pour Java : téléchargez-le depuis le site officiel d'Oracle.

- Pour Python : visitez la page de téléchargement de Python.

Étape 2 : Installer Java

Java est l'épine dorsale d'Apache Spark. Pour l'installer :

1.Télécharger Java : visitez la page de téléchargement du kit de développement Java SE. Choisissez la version appropriée pour votre système d'exploitation.

2.Installer Java : exécutez le programme d'installation et suivez les instructions. Sous Windows, vous devrez définir la variable d'environnement JAVA_HOME. Pour ce faire :

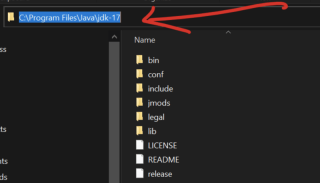

- Copiez la variable path, accédez au disque local sur votre machine, sélectionnez fichiers programme, recherchez le dossier java ouvrez-le, vous verrez jdk-17 (votre propre version n'est peut-être pas 17). Ouvrez-le et vous pourrez voir votre chemin et copier comme ci-dessous

Recherchez Variables d'environnement dans la barre de recherche Windows.

Sous Variables système, cliquez sur Nouveau et définissez le nom de la variable sur JAVA_HOME et la valeur sur votre chemin d'installation Java que vous avez copié ci-dessus (par exemple, C:Programme FichiersJavajdk-17).

3.Vérifier l'installation : ouvrez un terminal ou une invite de commande et tapez java-version.

Étape 3 : Installer Apache Spark

1.Télécharger Spark : Visitez le site Web d'Apache Spark et sélectionnez la version compatible avec vos besoins. Utilisez le package prédéfini pour Hadoop (un couplage courant avec Spark).

2.Extraire les fichiers :

- Sous Windows, utilisez un outil comme WinRAR ou 7-Zip pour extraire le fichier.

- Sur macOS/Linux, utilisez la commande tar -xvf spark-.tgz

3.Définir les variables d'environnement :

- Pour Windows : ajoutez le répertoire bin de Spark à la variable PATH de votre système.

- Pour macOS/Linux : Ajoutez les lignes suivantes à votre fichier .bashrc ou .zshrc :

export SPARK_HOME=/path/to/spark export PATH=$SPARK_HOME/bin:$PATH

4.Vérifier l'installation : ouvrez un terminal et tapez spark-shell. Vous devriez voir le shell interactif de Spark démarrer.

Étape 4 : Installer Hadoop (facultatif mais recommandé)

Bien que Spark ne nécessite pas strictement Hadoop, de nombreux utilisateurs l'installent pour sa prise en charge HDFS (Hadoop Distributed File System). Pour installer Hadoop :

- Téléchargez les binaires Hadoop depuis le site Web d'Apache Hadoop.

- Extrayez les fichiers et configurez la variable d'environnement HADOOP_HOME.

Étape 5 : Installez PySpark via pip

Installer PySpark est un jeu d'enfant avec l'outil pip de Python. Exécutez simplement :

pip install pyspark

Pour vérifier, ouvrez un shell Python et tapez :

pip install pysparkark.__version__)

Si vous voyez un numéro de version, félicitations ! PySpark est installé ?

Étape 6 : Testez votre installation PySpark

C'est ici que le plaisir commence. Assurons-nous que tout fonctionne bien :

Créer un script simple :

Ouvrez un éditeur de texte et collez le code suivant :

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("PySparkTest").getOrCreate()

data = [("Alice", 25), ("Bob", 30), ("Cathy", 29)]

columns = ["Name", "Age"]

df = spark.createDataFrame(data, columns)

df.show()

Enregistrez-le sous test_pyspark.py

Exécuter le script :

Dans votre terminal, accédez au répertoire du script et tapez :

export SPARK_HOME=/path/to/spark export PATH=$SPARK_HOME/bin:$PATH

Vous devriez voir un tableau soigneusement formaté affichant les noms et les âges.

Dépannage des problèmes courants

Même avec les meilleures instructions, le hoquet arrive. Voici quelques problèmes courants et solutions :

Problème : java.lang.NoClassDefFoundError

Solution : Vérifiez à nouveau vos variables JAVA_HOME et PATH.Problème : l'installation de PySpark a réussi, mais le script de test a échoué.

Solution : Assurez-vous que vous utilisez la bonne version de Python. Parfois, les environnements virtuels peuvent provoquer des conflits.Problème : La commande spark-shell ne fonctionne pas.

Solution : Vérifiez que le répertoire Spark est correctement ajouté à votre PATH.

Pourquoi utiliser PySpark localement ?

De nombreux utilisateurs se demandent pourquoi ils devraient s'embêter à installer PySpark sur leur machine locale alors qu'il est principalement utilisé dans des systèmes distribués. Voici pourquoi :

- Apprentissage : expérimentez et apprenez les concepts Spark sans avoir recours à un cluster.

- Prototypage : testez localement de petites tâches de données avant de les déployer dans un environnement plus grand.

- Commodité : déboguez les problèmes et développez des applications en toute simplicité.

Boostez votre productivité PySpark

Pour tirer le meilleur parti de PySpark, tenez compte de ces conseils :

Configurer un environnement virtuel : utilisez des outils comme venv ou conda pour isoler votre installation PySpark.

Intégrer avec les IDE : des outils tels que PyCharm et Jupyter Notebook rendent le développement PySpark plus interactif.

Tirez parti de la documentation PySpark : consultez la documentation d'Apache Spark pour obtenir des conseils approfondis.

Engagez-vous avec la communauté PySpark

Rester bloqué est normal, surtout avec un outil puissant comme PySpark. Contactez la communauté dynamique PySpark pour obtenir de l'aide :

Rejoignez les forums : des sites Web comme Stack Overflow ont des balises Spark dédiées.

Participer à des Meetups : les communautés Spark et Python organisent souvent des événements où vous pouvez apprendre et réseauter.

Suivez les blogs : De nombreux professionnels des données partagent leurs expériences et leurs tutoriels en ligne.

Conclusion

Installer PySpark sur votre machine locale peut sembler intimidant au début, mais suivre ces étapes le rend gérable et gratifiant. Que vous commenciez tout juste votre parcours vers les données ou que vous affiniez vos compétences, PySpark vous fournit les outils nécessaires pour résoudre les problèmes de données du monde réel.

PySpark, l'API Python pour Apache Spark, change la donne en matière d'analyse et de traitement des données. Bien que son potentiel soit immense, sa configuration sur votre ordinateur local peut sembler difficile. Cet article détaille le processus étape par étape, couvrant tout, depuis l'installation de Java et le téléchargement de Spark jusqu'au test de votre configuration avec un simple script.

Avec PySpark installé localement, vous pouvez prototyper des workflows de données, découvrir les fonctionnalités de Spark et tester des projets à petite échelle sans avoir besoin d'un cluster complet.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Python et temps: tirer le meilleur parti de votre temps d'étudeApr 14, 2025 am 12:02 AM

Python et temps: tirer le meilleur parti de votre temps d'étudeApr 14, 2025 am 12:02 AMPour maximiser l'efficacité de l'apprentissage de Python dans un temps limité, vous pouvez utiliser les modules DateTime, Time et Schedule de Python. 1. Le module DateTime est utilisé pour enregistrer et planifier le temps d'apprentissage. 2. Le module de temps aide à définir l'étude et le temps de repos. 3. Le module de planification organise automatiquement des tâches d'apprentissage hebdomadaires.

Python: jeux, GUIS, et plusApr 13, 2025 am 12:14 AM

Python: jeux, GUIS, et plusApr 13, 2025 am 12:14 AMPython excelle dans les jeux et le développement de l'interface graphique. 1) Le développement de jeux utilise Pygame, fournissant des fonctions de dessin, audio et d'autres fonctions, qui conviennent à la création de jeux 2D. 2) Le développement de l'interface graphique peut choisir Tkinter ou Pyqt. Tkinter est simple et facile à utiliser, PYQT a des fonctions riches et convient au développement professionnel.

Python vs C: applications et cas d'utilisation comparésApr 12, 2025 am 12:01 AM

Python vs C: applications et cas d'utilisation comparésApr 12, 2025 am 12:01 AMPython convient à la science des données, au développement Web et aux tâches d'automatisation, tandis que C convient à la programmation système, au développement de jeux et aux systèmes intégrés. Python est connu pour sa simplicité et son écosystème puissant, tandis que C est connu pour ses capacités de contrôle élevées et sous-jacentes.

Le plan Python de 2 heures: une approche réalisteApr 11, 2025 am 12:04 AM

Le plan Python de 2 heures: une approche réalisteApr 11, 2025 am 12:04 AMVous pouvez apprendre les concepts de programmation de base et les compétences de Python dans les 2 heures. 1. Apprenez les variables et les types de données, 2. Flux de contrôle maître (instructions et boucles conditionnelles), 3. Comprenez la définition et l'utilisation des fonctions, 4. Démarrez rapidement avec la programmation Python via des exemples simples et des extraits de code.

Python: Explorer ses applications principalesApr 10, 2025 am 09:41 AM

Python: Explorer ses applications principalesApr 10, 2025 am 09:41 AMPython est largement utilisé dans les domaines du développement Web, de la science des données, de l'apprentissage automatique, de l'automatisation et des scripts. 1) Dans le développement Web, les cadres Django et Flask simplifient le processus de développement. 2) Dans les domaines de la science des données et de l'apprentissage automatique, les bibliothèques Numpy, Pandas, Scikit-Learn et Tensorflow fournissent un fort soutien. 3) En termes d'automatisation et de script, Python convient aux tâches telles que les tests automatisés et la gestion du système.

Combien de python pouvez-vous apprendre en 2 heures?Apr 09, 2025 pm 04:33 PM

Combien de python pouvez-vous apprendre en 2 heures?Apr 09, 2025 pm 04:33 PMVous pouvez apprendre les bases de Python dans les deux heures. 1. Apprenez les variables et les types de données, 2. Structures de contrôle maître telles que si les instructions et les boucles, 3. Comprenez la définition et l'utilisation des fonctions. Ceux-ci vous aideront à commencer à écrire des programmes Python simples.

Comment enseigner les bases de la programmation novice en informatique dans le projet et les méthodes axées sur les problèmes dans les 10 heures?Apr 02, 2025 am 07:18 AM

Comment enseigner les bases de la programmation novice en informatique dans le projet et les méthodes axées sur les problèmes dans les 10 heures?Apr 02, 2025 am 07:18 AMComment enseigner les bases de la programmation novice en informatique dans les 10 heures? Si vous n'avez que 10 heures pour enseigner à l'informatique novice des connaissances en programmation, que choisissez-vous d'enseigner ...

Comment éviter d'être détecté par le navigateur lors de l'utilisation de Fiddler partout pour la lecture de l'homme au milieu?Apr 02, 2025 am 07:15 AM

Comment éviter d'être détecté par le navigateur lors de l'utilisation de Fiddler partout pour la lecture de l'homme au milieu?Apr 02, 2025 am 07:15 AMComment éviter d'être détecté lors de l'utilisation de FiddlereVerywhere pour les lectures d'homme dans le milieu lorsque vous utilisez FiddlereVerywhere ...

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

PhpStorm version Mac

Le dernier (2018.2.1) outil de développement intégré PHP professionnel

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Adaptateur de serveur SAP NetWeaver pour Eclipse

Intégrez Eclipse au serveur d'applications SAP NetWeaver.

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

VSCode Windows 64 bits Télécharger

Un éditeur IDE gratuit et puissant lancé par Microsoft