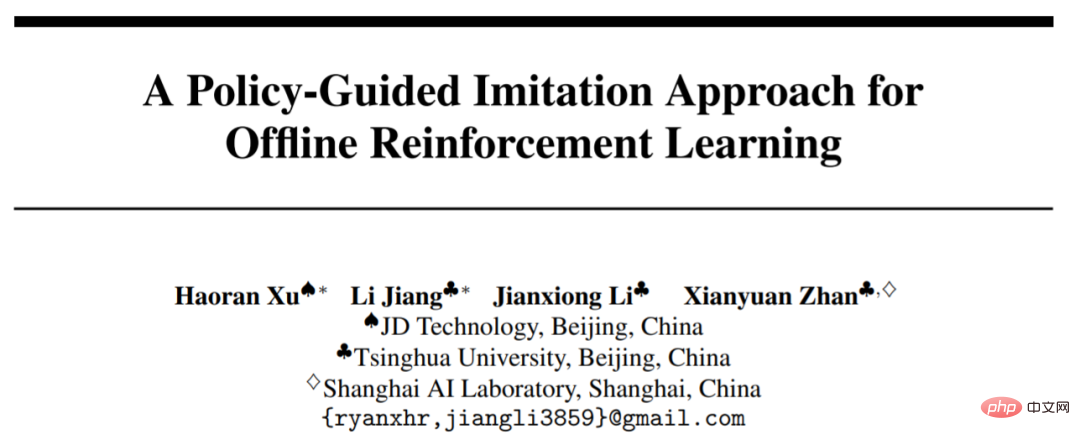

Home >Technology peripherals >AI >A new paradigm for offline reinforcement learning! JD.com & Tsinghua University propose decoupled learning algorithm

A new paradigm for offline reinforcement learning! JD.com & Tsinghua University propose decoupled learning algorithm

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBforward

- 2023-04-11 16:22:031089browse

Offline reinforcement learning algorithm (Offline RL) is one of the most popular sub-directions of reinforcement learning. Offline reinforcement learning does not interact with the environment and aims to learn target policies from previously recorded data. Offline reinforcement learning is particularly attractive compared to online reinforcement learning (Online RL) in areas where data collection is expensive or dangerous, but where there may be a large amount of data (e.g., robotics, industrial control, autonomous driving).

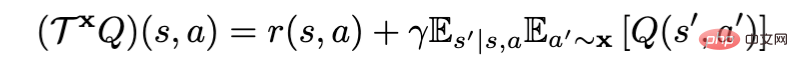

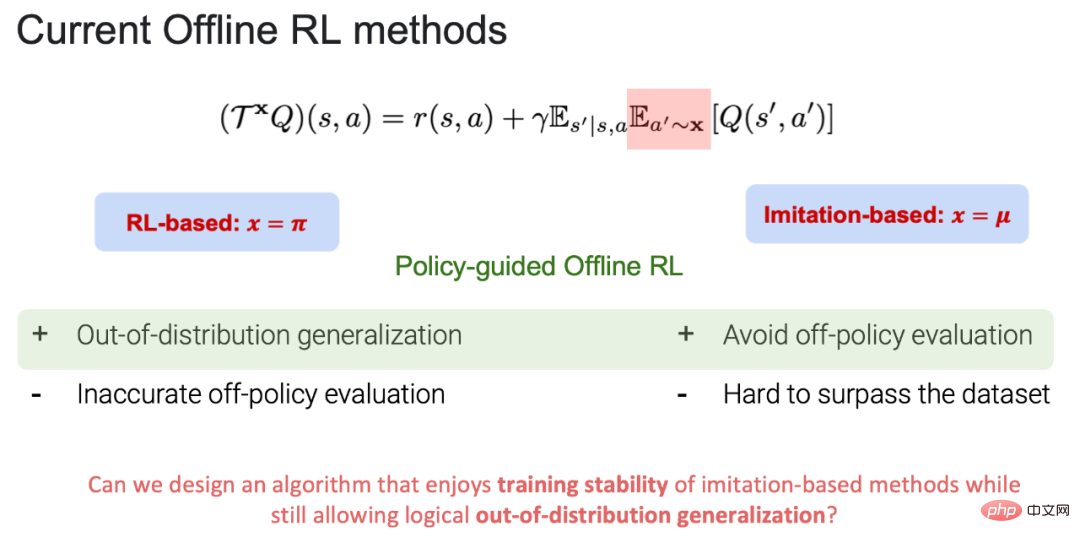

When using the Bellman policy evaluation operator for policy evaluation, the current offline reinforcement learning algorithm can be divided into RL- based (x=π) and Imitation-based (x=μ), where π is the target strategy and μ is the behavioral strategy (Note: target strategy: the strategy for learning and updating; behavioral strategy: the strategy in offline data). Currently, both RL-based and Imitation-based have their own advantages and disadvantages:

1. RL-based advantages: It can generalize outside the data, and finally achieves learning Goal strategies beyond behavioral strategies. Disadvantages: There is a trade-off between accurate value estimation in policy evaluation (more behavioral regularization) and policy improvement (less behavioral regularization). During the policy evaluation process, if an action outside the data distribution is selected, the action value function (action-state value) cannot be accurately estimated, which ultimately leads to the failure of target policy learning.

2.Imitation-based advantage: Because in the process of policy evaluation, all actions are within the data distribution, it can not only bring stability to the training, but also avoid errors outside the data distribution. Strategy evaluation can learn strategies that are close to the best in the behavioral strategy library. Disadvantages: Because all actions are taken within the data distribution, it is difficult to surpass the behavioral strategies existing in the original data.

Based on this, POR can not only avoid trade-offs in the strategy evaluation process, but also have the ability to generalize outside the data. This work has been accepted by NeurIPS 2022 and invited to give an oral presentation. The paper and code have been open source.

- ##Paper: https://arxiv.org/abs/2210.08323

- Code: https://github.com/ryanxhr/POR

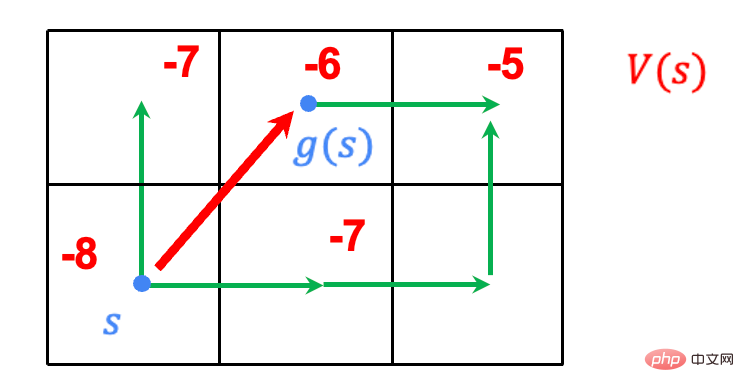

##state-stitching vs. action-stitching

- Task: Walk the grid, with the end point in the upper right corner and the starting point in the lower right corner. Find the shortest path from start point to end point.

- Rules: The agent can choose the eight grids around it in any grid, and will be rewarded 1 when it reaches the end, and the rewards for all other behaviors are 0.

- Data: The green walking path is the existing path data.

How to implement state-stitching?

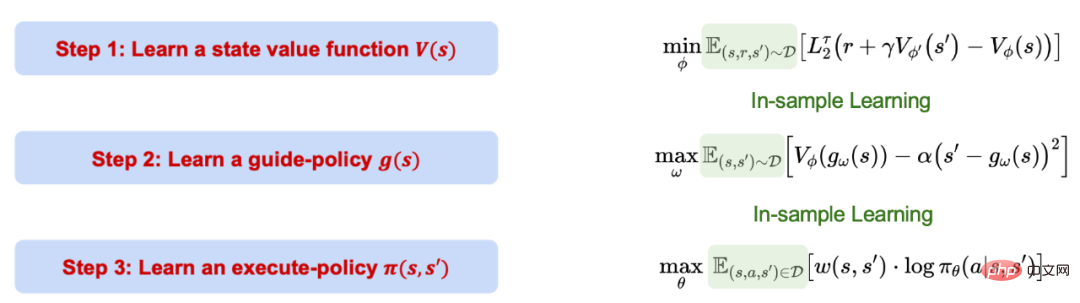

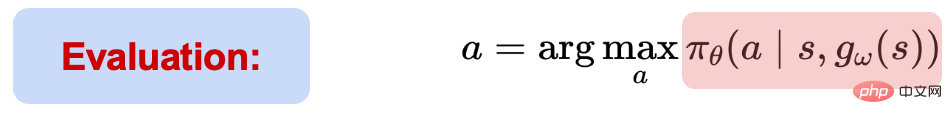

The learning process of Policy-guided Offline RL (POR) is divided into three steps. These three steps are decoupled and mutually exclusive. No impact. It is worth noting that the entire process of POR is based on imitation-based learning, that is, in-sample learning, and does not evaluate the value of actions outside the data distribution.

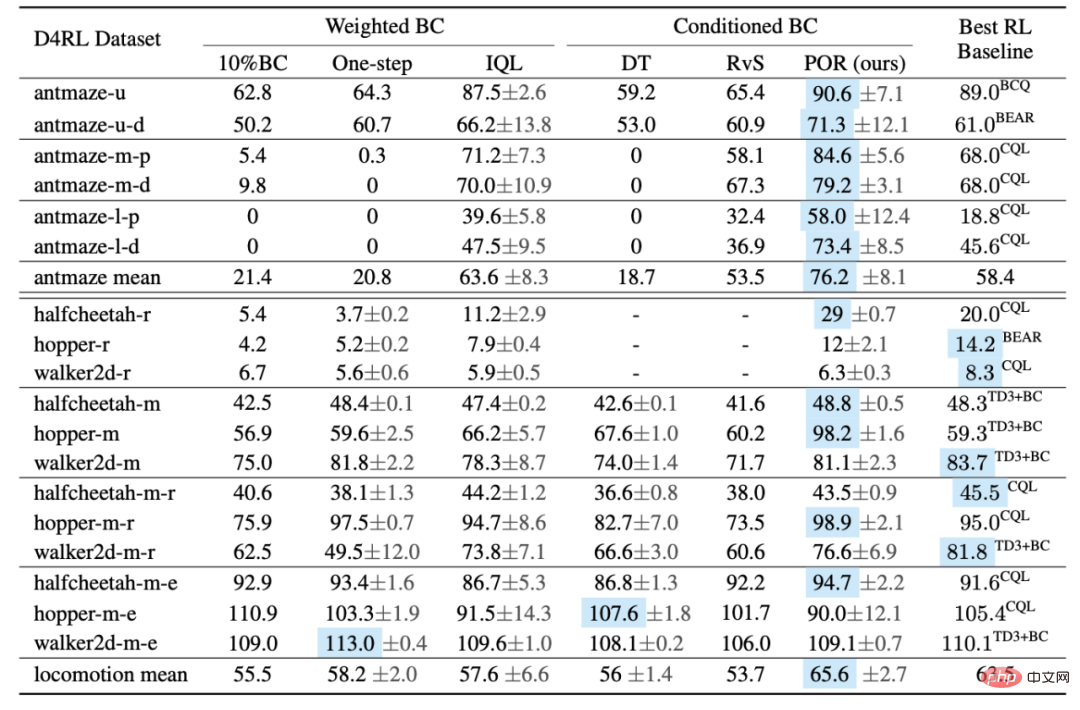

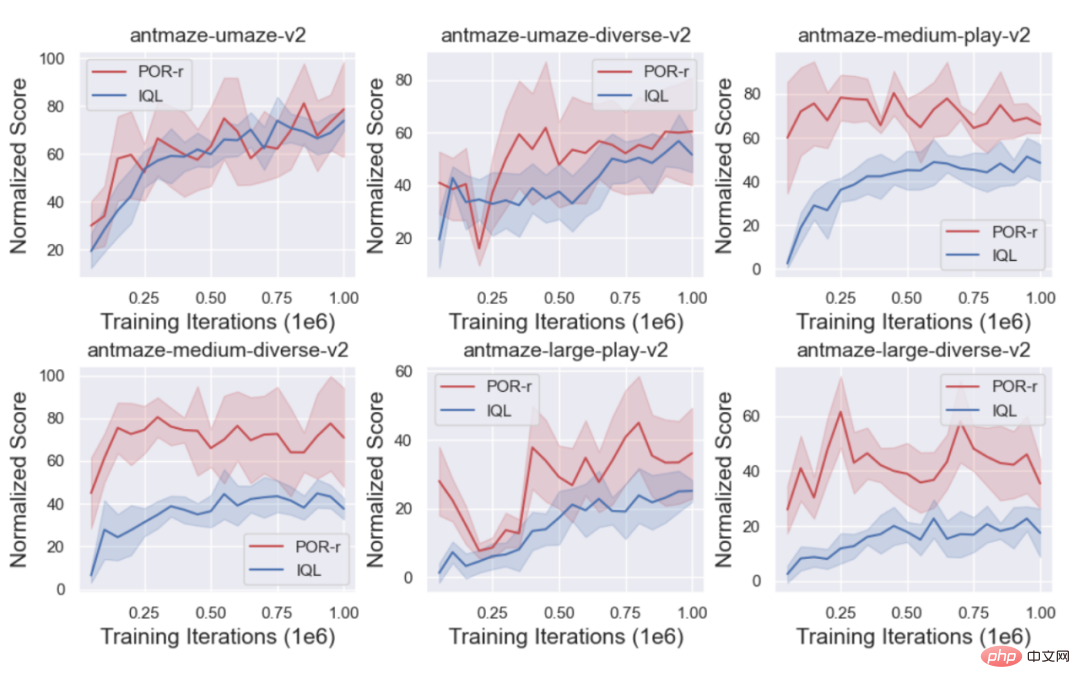

2. Используйте функцию изученного значения, чтобы изучить стратегию управления, которая может генерировать следующую оптимальную позицию (позиции) состояния в выборке с учетом текущего состояния. Последний элемент служит ограничением, гарантирующим, что сгенерированное состояние удовлетворяет условию MDP. #3. Используйте все выборки в данных, чтобы изучить стратегию выполнения, которая может предпринимать шаги с учетом текущего состояния (состояний) и следующего состояния (состояний). Правильное действие - перейти из текущего состояния(й) в следующее состояние(я). #В процессе тестирования, на основе информации(ов) о текущем состоянии, следующий оптимальный статус(ы') сначала выдается через стратегия руководства. Учитывая (s, s'), стратегия выполнения может выбирать и выполнять действия. Хотя весь процесс обучения POR представляет собой обучение на выборке, производительность нейронной сети по обобщению можно использовать для выполнения обучения по обобщению вне данных и, наконец, для достижения сшивания состояний. Автор сравнил производительность POR и других алгоритмов на D4RL Benchmark. Судя по таблице, POR очень хорошо работает с неоптимальными данными и достигает оптимальной производительности алгоритма на более сложных задачах Antmaze. В то же время автор сравнил обучающие кривые POR (сшивка состояний) и IQL (сшивка действий), чтобы показать преимущества государственного сшивания. #Каковы дополнительные преимущества развязки

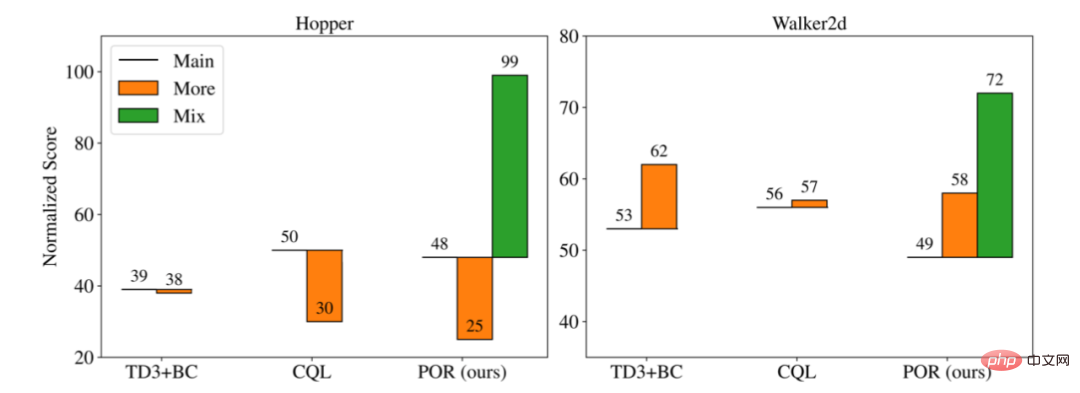

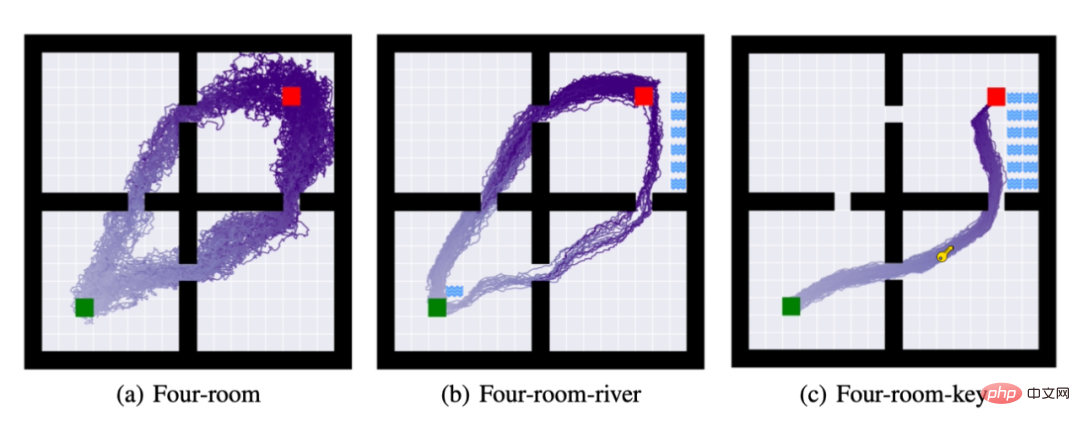

######## 1 1. 1. Повторно изучите стратегию наведения, чтобы добиться повышения производительности алгоритма. ############В реальном мире часто существует большое количество неоптимальных или даже случайных наборов данных (D_o). Если они непосредственно вводятся в изучаемый исходный набор данных (D_e), это может привести к изучению плохой стратегии, но для несвязанных алгоритмов обучения используются разные компоненты и изучаются разные наборы данных для повышения производительности. При изучении функции значения, чем больше наборов данных, тем лучше, потому что функцию значения можно изучить точнее; наоборот, обучение стратегии не хочет вводить (D_o). #############Автор сравнил производительность трёх разных алгоритмов в разных сценариях обучения: #############1.Основное: На исходном наборе данных (D_e) Учитесь, не вводя дополнительные неоптимальные наборы данных. #################### 2. Подробнее: смешайте исходный набор данных (D_e) и новый набор данных (D_o), чтобы изучить его как новый набор данных. #######################################################################################################################################################################################################################################################################]. ##################### Как вы можете видеть на рисунке выше, когда новые неоптимальные данные добавляются и обучаются вместе (Подробнее), это может привести к лучшая производительность, чем исходная. Производительность исходного набора данных (Основной) лучше или хуже, но для разделенной формы обучения для повторного изучения стратегии наведения (D_o D_e) эксперименты автора показывают, что большее количество данных может улучшить избирательность и оптимизация стратегии руководства.Способность к обобщению при сохранении неизменной стратегии поведения, тем самым достигается улучшение стратегии исполнения. #################### 4. При возникновении новой задачи, поскольку стратегия выполнения не имеет отношения к задаче, вам нужно только заново изучить стратегию руководства. ###### С этой целью автор предложил три задачи: (а): четырехкомнатная: требующая от агента перемещения из зеленого квадрата в красный квадрат. (б) Помимо выполнения задания (а), от агента требуется не прикасаться к реке. (c) Помимо выполнения задач (a) и (b), агент должен получить ключ для выполнения задачи. На картинке выше показана траектория развертывания стратегии 50 раз после завершения обучения стратегии.В задачах (б) и задаче (в) Автор следует стратегии выполнения задачи (а) и лишь переучивает стратегию наведения. Как видно из приведенного выше рисунка, метод разделенного обучения может выполнить миграцию задач, используя как можно меньше вычислительных ресурсов.

Эксперимент

The above is the detailed content of A new paradigm for offline reinforcement learning! JD.com & Tsinghua University propose decoupled learning algorithm. For more information, please follow other related articles on the PHP Chinese website!

Related articles

See more- Technology trends to watch in 2023

- How Artificial Intelligence is Bringing New Everyday Work to Data Center Teams

- Can artificial intelligence or automation solve the problem of low energy efficiency in buildings?

- OpenAI co-founder interviewed by Huang Renxun: GPT-4's reasoning capabilities have not yet reached expectations

- Microsoft's Bing surpasses Google in search traffic thanks to OpenAI technology