Heim >Technologie-Peripheriegeräte >KI >Docker schließt die lokale Bereitstellung des großen Open-Source-Modells LLama3 in drei Minuten ab

Docker schließt die lokale Bereitstellung des großen Open-Source-Modells LLama3 in drei Minuten ab

- 王林nach vorne

- 2024-04-26 10:19:211514Durchsuche

Übersicht

LLaMA-3 (Large Language Model Meta AI 3) ist ein groß angelegtes Open-Source-Modell für generative künstliche Intelligenz, das von Meta Company entwickelt wurde. Im Vergleich zur Vorgängergeneration LLaMA-2 gibt es keine wesentlichen Änderungen in der Modellstruktur.

Das LLaMA-3-Modell ist in verschiedene Maßstabsversionen unterteilt, darunter kleine, mittlere und große, um sich an unterschiedliche Anwendungsanforderungen und Rechenressourcen anzupassen. Die Parametergröße kleiner Modelle beträgt 8 B, die Parametergröße mittlerer Modelle beträgt 70 B und die Parametergröße großer Modelle erreicht 400 B. Während des Trainings besteht das Ziel jedoch darin, multimodale und mehrsprachige Funktionalität zu erreichen, und die Ergebnisse werden voraussichtlich mit GPT 4/GPT 4V vergleichbar sein.

Ollama installieren

Ollama ist ein Open-Source-LLM-Diensttool (Large Language Model), mit dem Benutzer große Sprachmodelle auf ihrem lokalen Computer ausführen und bereitstellen können. Ollama ist als Framework konzipiert, das den Prozess der Bereitstellung und Verwaltung großer Sprachmodelle in Docker-Containern vereinfacht und den Prozess schnell und einfach macht. Benutzer können über einfache Befehlszeilenoperationen schnell umfangreiche Open-Source-Sprachmodelle wie Llama 3 lokal ausführen.

Offizielle Website-Adresse: https://ollama.com/download

Bilder

Bilder

Ollama ist ein Tool, das mehrere Plattformen, einschließlich Mac und Linux, unterstützt und Docker-Images bereitstellt, um den Installationsprozess zu vereinfachen. Benutzer können weitere Modelle importieren und anpassen, indem sie eine Modelldatei schreiben, die der Rolle einer Docker-Datei ähnelt. Ollama bietet außerdem eine REST-API zum Ausführen und Verwalten von Modellen sowie ein Befehlszeilen-Toolset für die Modellinteraktion.

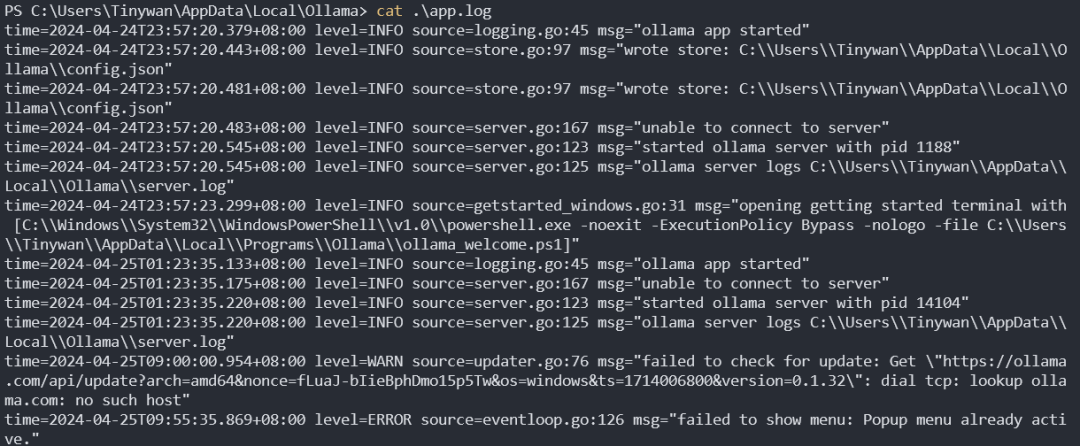

Ollama-Dienst-Startprotokoll

Bilder

Bilder

Modellverwaltung

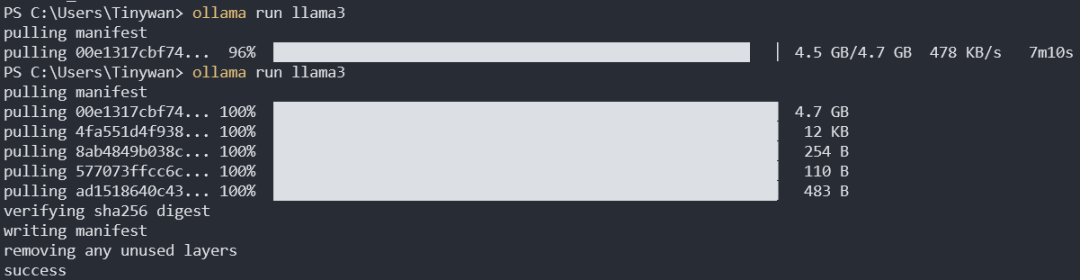

Modell herunterladen

ollama pull llama3:8b

Der Standard-Download ist llama3:8b. Der Doppelpunkt vor dem Doppelpunkt stellt hier den Modellnamen dar, und der Doppelpunkt nach dem Tag stellt das Tag dar. Von hier aus können Sie alle Tags von llama3 anzeigen

Bilder

Bilder

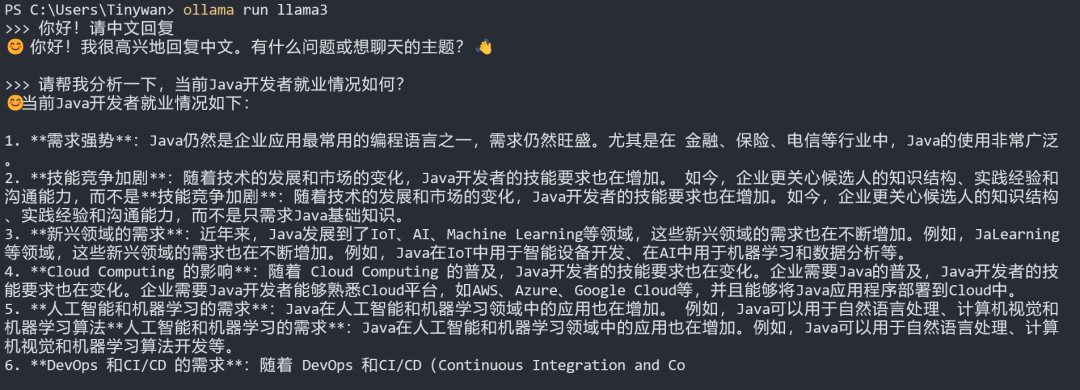

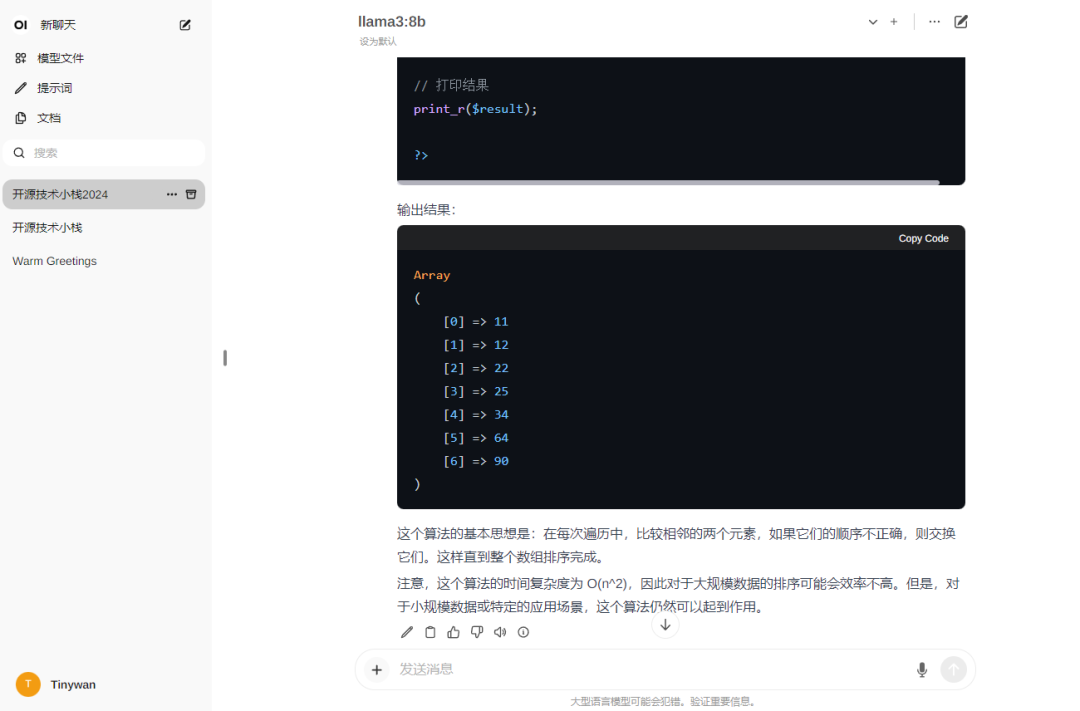

Modelltests

Hinweis: Wenn Sie möchten, dass das Modell angezeigt wird Antwort auf Chinesisch, bitte zuerst eingeben: Hallo! Bitte antworten Sie auf Chinesisch.

Bild

Bild

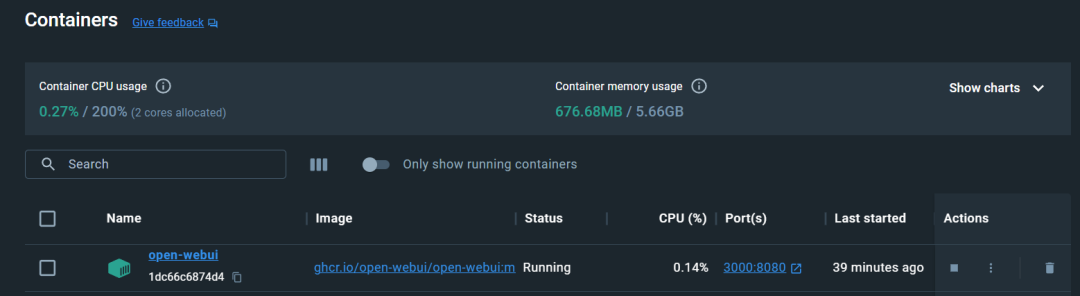

Open-WebUI konfigurieren. Unter CPU ausführen. 3000 für den Zugang

Sie müssen sich für den ersten Besuch registrieren. Hier registriere ich ein Konto, die Registrierung ist abgeschlossen und die Anmeldung ist erfolgreich

Sie müssen sich für den ersten Besuch registrieren. Hier registriere ich ein Konto, die Registrierung ist abgeschlossen und die Anmeldung ist erfolgreich

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Bilder

Bilder

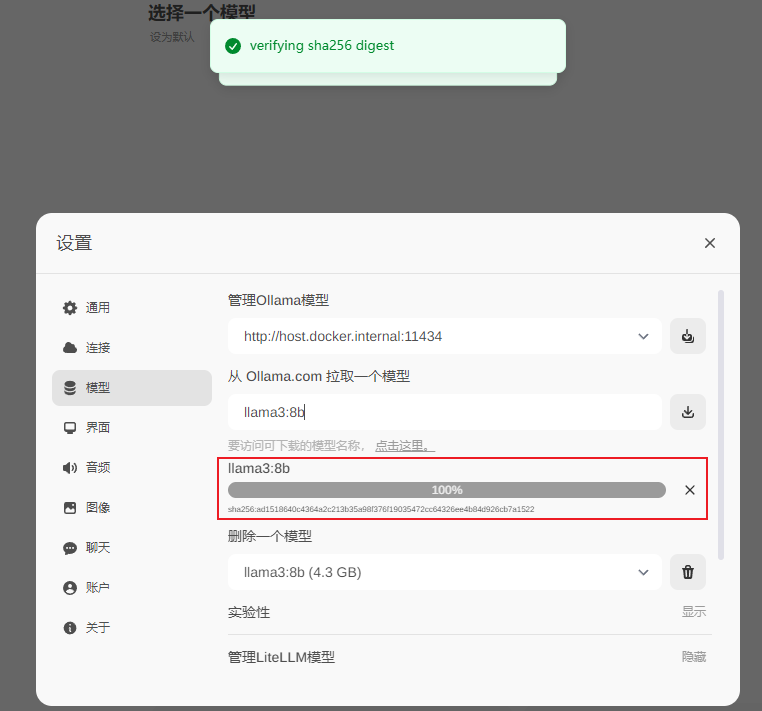

Download abgeschlossen

Bilder

Bilder

Verwenden

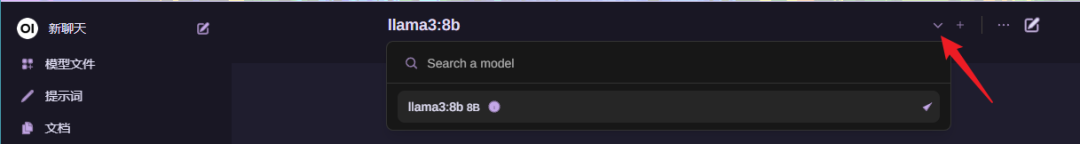

Modell auswählen

Bilder

Bilder

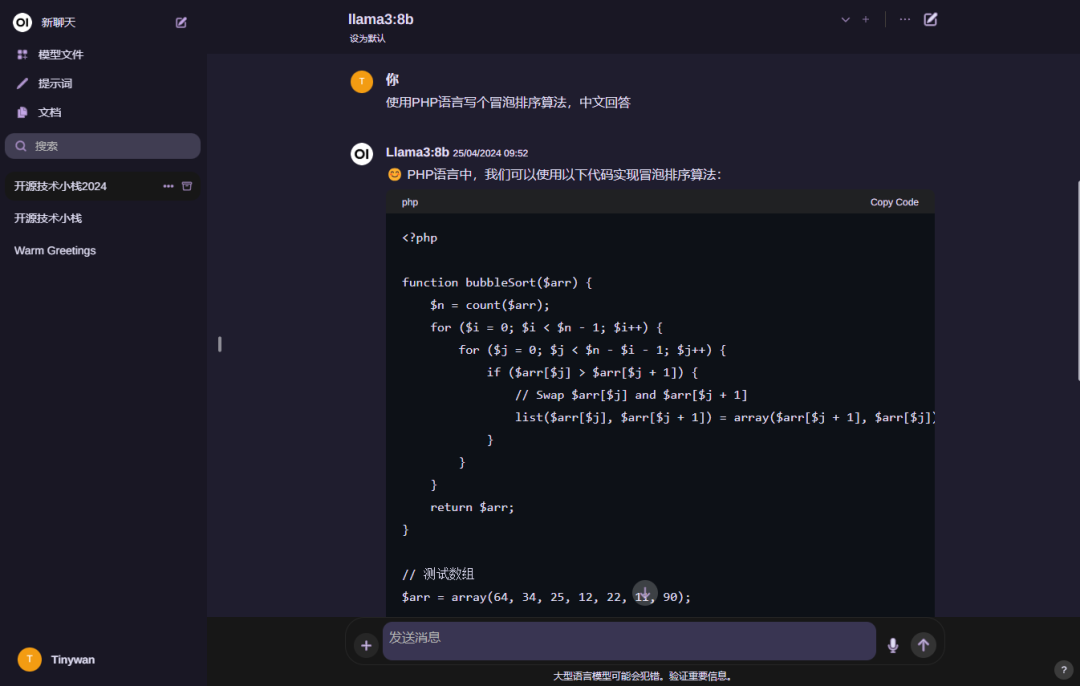

Verwenden. Modell

Bilder

Bilder

Hinweis: Wenn Sie möchten, dass das Modell antwortet auf Chinesisch. Bitte geben Sie zuerst ein: Hallo! Bitte antworten Sie auf Chinesisch

Das obige ist der detaillierte Inhalt vonDocker schließt die lokale Bereitstellung des großen Open-Source-Modells LLama3 in drei Minuten ab. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Was sind die Boxmodelleigenschaften von CSS? Einführung in die Eigenschaften von CSS-Boxmodellen

- So geben Sie Root-Rechte unter Linux ein

- So zeigen Sie Dateien im Docker-Container an

- Was sind in der Datenbanktechnologie die vier wichtigsten Datenmodelle?

- Was ist der Unterschied zwischen Kubernetes und Docker?