Heim >Technologie-Peripheriegeräte >KI >Innerhalb weniger Stunden nach der Veröffentlichung hat Microsoft in Sekundenschnelle ein großes Open-Source-Modell gelöscht, das mit GPT-4 vergleichbar ist! Vergiftungstest vergessen

Innerhalb weniger Stunden nach der Veröffentlichung hat Microsoft in Sekundenschnelle ein großes Open-Source-Modell gelöscht, das mit GPT-4 vergleichbar ist! Vergiftungstest vergessen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-04-23 17:22:111275Durchsuche

Letzte Woche hat Microsoft WizardLM-2 aus der Luft abgeworfen, ein Open-Source-Modell, das als GPT-4-Level bezeichnet werden kann.

Unerwarteterweise wurde es wenige Stunden nach der Veröffentlichung sofort gelöscht.

Einige Internetnutzer stellten plötzlich fest, dass die Modellgewichte und Ankündigungsbeiträge von WizardLM alle gelöscht worden waren und sich nicht mehr in der Microsoft-Sammlung befanden. Abgesehen von der Erwähnung der Website konnten keine Beweise gefunden werden, die dieses offizielle Microsoft-Projekt belegen.

Die GitHub-Projekthomepage ist 404 geworden.

Projektadresse: https://wizardlm.github.io/

Einschließlich des Gewichts des Modells auf HF verschwand alles ...

Das gesamte Netzwerk Das Gesicht ist voller Verwirrung, warum ist WizardLM verschwunden?

Aber Microsoft hat dies getan, weil das Team vergessen hat, das Modell zu „testen“.

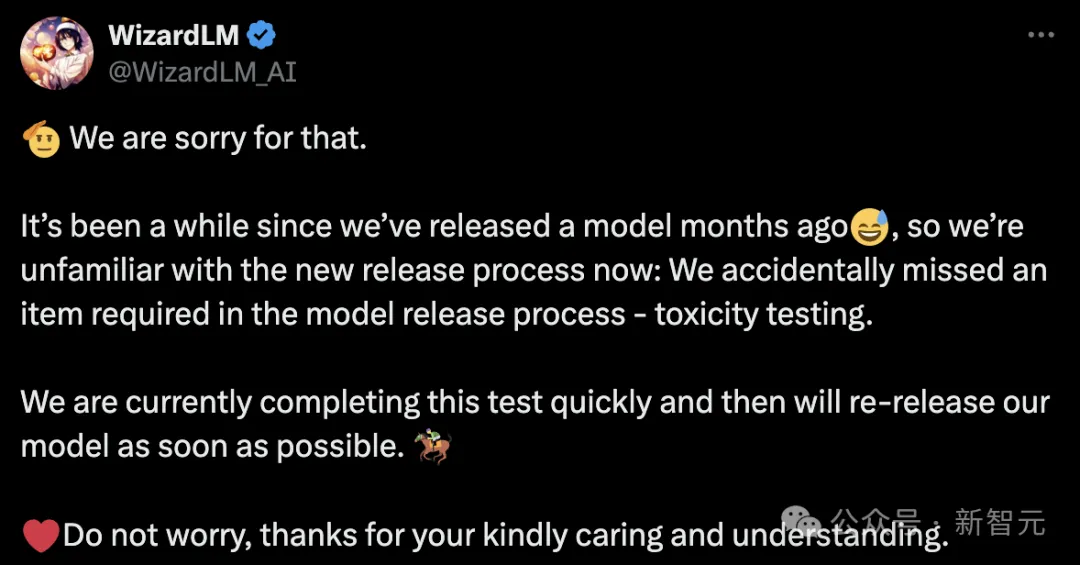

Später erschien das Microsoft-Team, um sich zu entschuldigen und zu erklären, dass es schon eine Weile her sei, seit WizardLM vor ein paar Monaten veröffentlicht wurde, sodass wir mit dem neuen Veröffentlichungsprozess jetzt nicht vertraut seien.

Wir haben versehentlich eines der im Model-Release-Prozess erforderlichen Dinge übersehen: den Vergiftungstest.

Microsoft WizardLM wurde auf die zweite Generation aktualisiert basierend auf LlaMA Nachdem die erste Generation von WizardLM veröffentlicht wurde, erregte sie große Aufmerksamkeit in der Open-Source-Community.

Papieradresse: https://arxiv.org/pdf/2304.12244.pdf

Papieradresse: https://arxiv.org/pdf/2304.12244.pdf

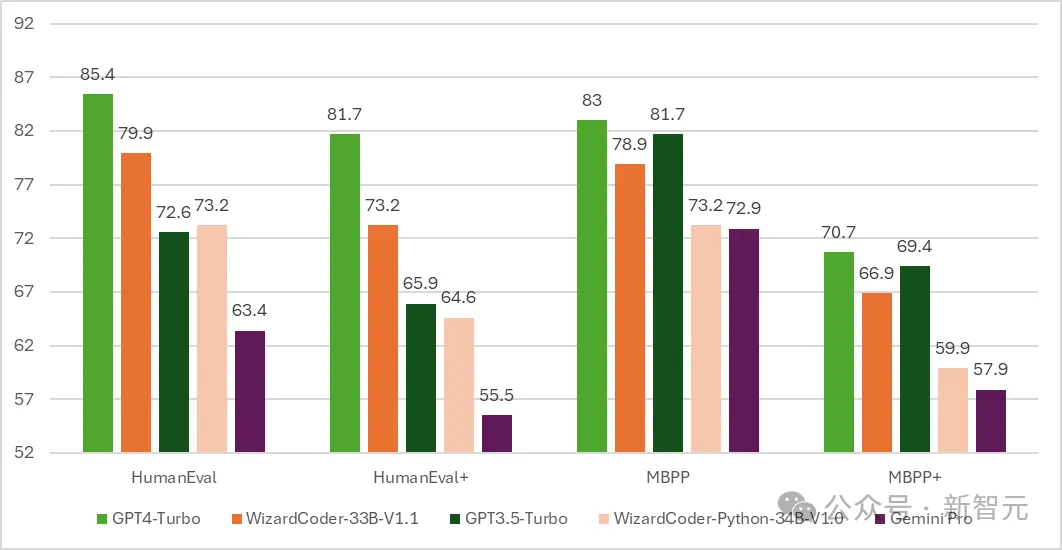

Anschließend wurde die Codeversion von WizardCoder geboren – ein Modell, das auf Code Llama basiert und mithilfe von Evol verfeinert wurde. Anweisen.

Die Testergebnisse zeigen, dass WizardCoders Pass@1 bei HumanEval erstaunliche 73,2 % erreichte und damit den ursprünglichen GPT-4 übertrifft.

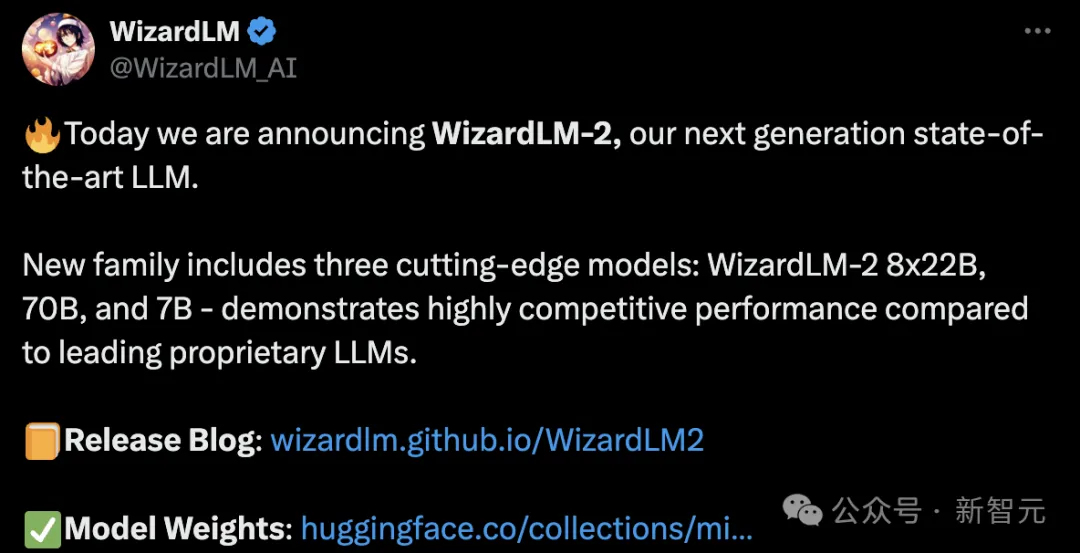

Im Laufe des 15. April kündigten Microsoft-Entwickler offiziell eine neue Generation von WizardLM an, diesmal mit einer Feinabstimmung auf Mixtral 8x22B.

Im Laufe des 15. April kündigten Microsoft-Entwickler offiziell eine neue Generation von WizardLM an, diesmal mit einer Feinabstimmung auf Mixtral 8x22B.

Es enthält drei Parameterversionen, nämlich 8x22B, 70B und 7B.

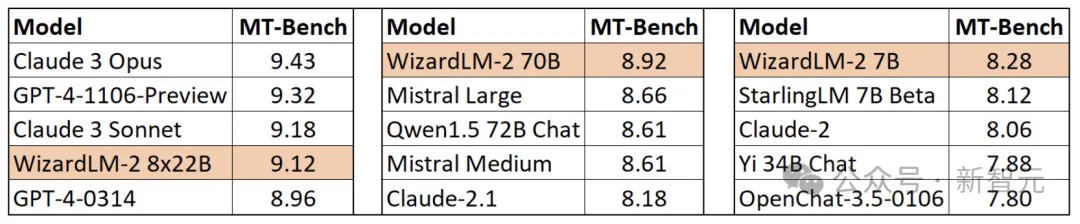

Das Erwähnenswerteste ist, dass das neue Modell im MT-Bench-Benchmark-Test einen Vorsprung erzielen konnte.

Das Erwähnenswerteste ist, dass das neue Modell im MT-Bench-Benchmark-Test einen Vorsprung erzielen konnte.

Insbesondere liegt die Leistung der Version des WizardLM 8x22B-Modells mit dem größten Parameter fast nahe an GPT-4 und Claude 3.

Insbesondere liegt die Leistung der Version des WizardLM 8x22B-Modells mit dem größten Parameter fast nahe an GPT-4 und Claude 3.

Unter derselben Parameterskala steht die 70B-Version an erster Stelle.

Die 7B-Version ist die schnellste und kann mit einer 10-mal größeren Parameterskala sogar eine Leistung erreichen, die dem Spitzenmodell entspricht.

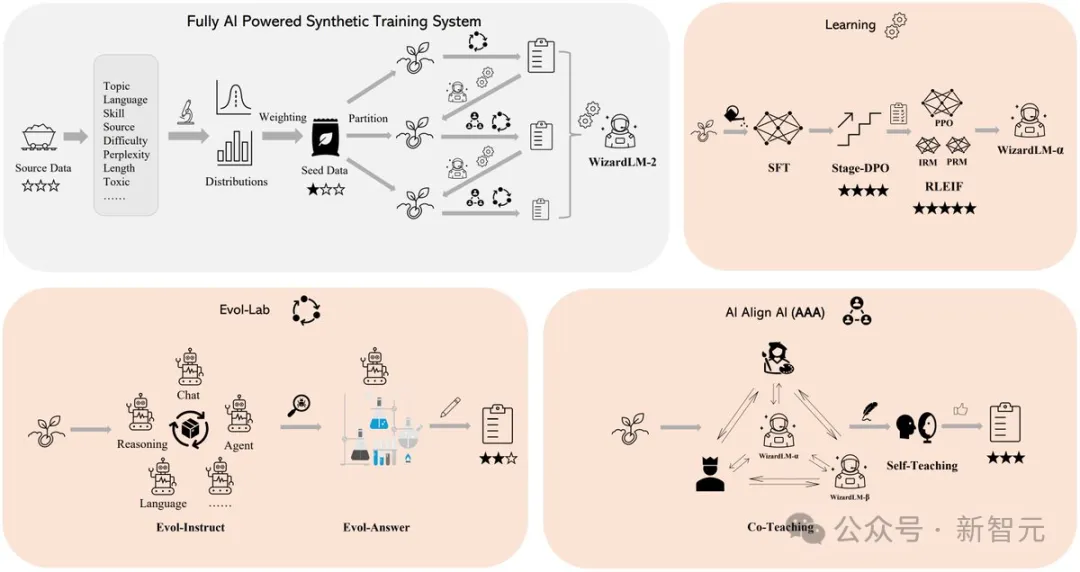

Das Geheimnis hinter der herausragenden Leistung von WizardLM 2 liegt in der revolutionären Trainingsmethodik Evol-Instruct, die von Microsoft entwickelt wurde.

Evol-Instruct nutzt große Sprachmodelle, um den ursprünglichen Befehlssatz iterativ in immer komplexere Varianten umzuschreiben. Diese entwickelten Befehlsdaten werden dann zur Feinabstimmung des Basismodells verwendet, wodurch seine Fähigkeit zur Bewältigung komplexer Aufgaben erheblich verbessert wird.

Das andere ist das Reinforcement Learning Framework RLEIF, das auch im Entwicklungsprozess von WizardLM 2 eine wichtige Rolle spielte.

Im WizardLM 2-Training wird auch die AI Align AI (AAA)-Methode übernommen, die es mehreren führenden großen Modellen ermöglicht, sich gegenseitig anzuleiten und zu verbessern.

Das AAA-Framework besteht aus zwei Hauptkomponenten, nämlich „Co-Teaching“ und „Selbststudium“.

WizardLM und eine Vielzahl lizenzierter Open-Source- und proprietärer fortgeschrittener Modelle führen in dieser Phase gemeinsam Simulationschats, Qualitätsbeurteilungen, Verbesserungsvorschläge und das Schließen von Kompetenzlücken durch.

Durch die Kommunikation untereinander und die Bereitstellung von Feedback können Models von ihren Kollegen lernen und ihre Fähigkeiten verbessern.

Für das Selbststudium kann WizardLM neue evolutionäre Trainingsdaten für überwachtes Lernen und Präferenzdaten für verstärkendes Lernen durch aktives Selbststudium generieren.

Dieser selbstlernende Mechanismus ermöglicht es dem Modell, die Leistung kontinuierlich zu verbessern, indem es aus seinen selbst generierten Daten und Feedback-Informationen lernt.

Darüber hinaus wurde das WizardLM 2-Modell anhand der generierten synthetischen Daten trainiert.

Nach Ansicht von Forschern werden die Trainingsdaten für große Modelle zunehmend erschöpft, und es wird angenommen, dass sorgfältig von KI erstellte Daten und von KI schrittweise überwachte Modelle der einzige Weg zu leistungsfähigerer künstlicher Intelligenz sein werden.

Also haben sie ein vollständig KI-gesteuertes synthetisches Trainingssystem entwickelt, um WizardLM-2 zu verbessern.

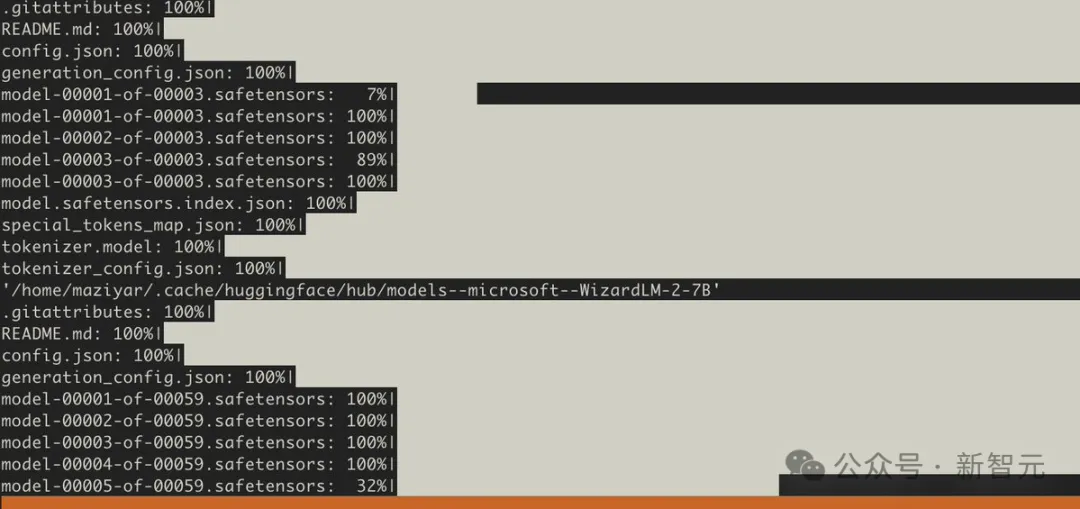

Schnelle Internetnutzer haben die Gewichte bereits heruntergeladen

Vor dem Löschen der Datenbank hatten jedoch viele Leute die Modellgewichte bereits heruntergeladen.

Bevor das Modell entfernt wurde, haben mehrere Benutzer es auch anhand einiger zusätzlicher Benchmarks getestet.

Glücklicherweise waren die Internetnutzer, die es getestet hatten, vom 7B-Modell beeindruckt und sagten, dass es ihre erste Wahl für die Ausführung lokaler Hilfsaufgaben sein würde.

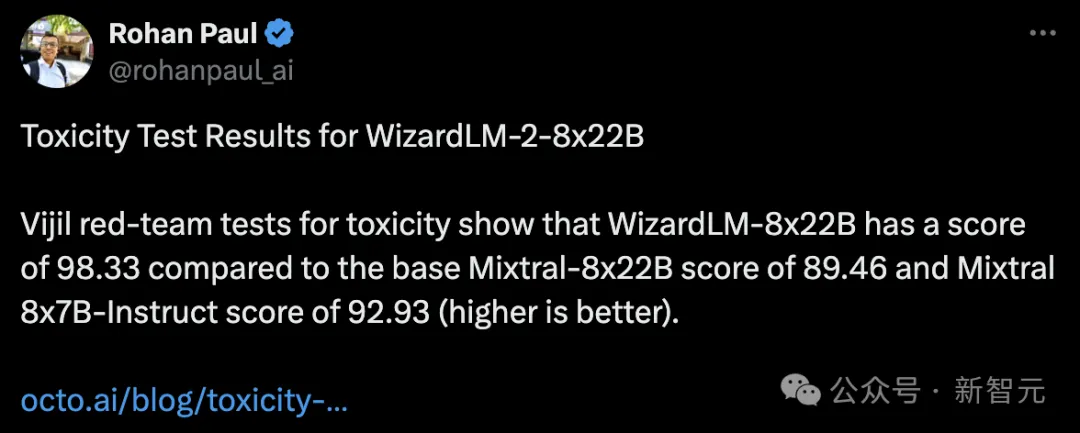

Jemand hat auch einen Gifttest durchgeführt und festgestellt, dass der WizardLM-8x22B 98,33 Punkte erzielte, während der Basis-Mixtral-8x22B 89,46 Punkte erzielte und der Mixtral 8x7B-Indict 92,93 Punkte erzielte.

Je höher die Punktzahl, desto besser, was bedeutet, dass WizardLM-8x22B immer noch sehr stark ist.

Wenn kein Vergiftungstest vorliegt, ist ein Versand des Modells absolut unmöglich.

Jeder weiß, dass große Models anfällig für Halluzinationen sind.

Wenn WizardLM 2 in den Antworten „toxische, voreingenommene und falsche“ Inhalte ausgibt, ist es für große Modelle nicht geeignet.

Insbesondere diese Fehler haben die Aufmerksamkeit des gesamten Netzwerks auf sich gezogen und werden auch bei Microsoft selbst für Kritik sorgen und möglicherweise sogar von den Behörden untersucht werden.

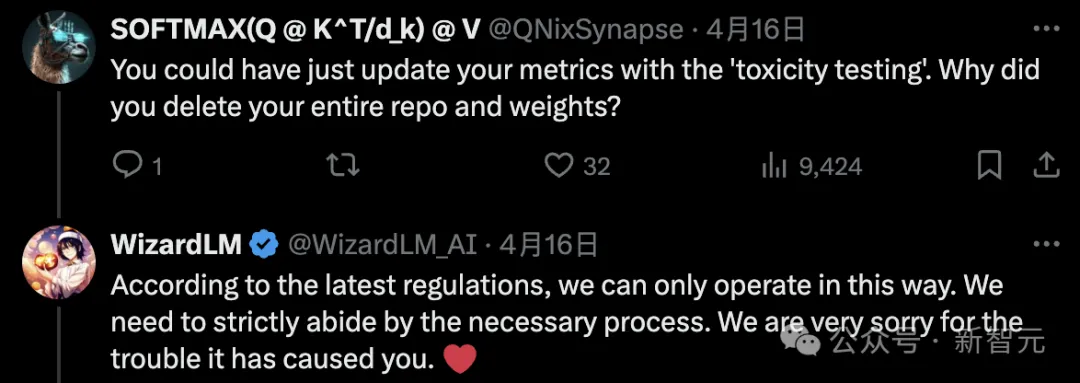

Einige Internetnutzer waren verwirrt und sagten, dass man die Indikatoren durch „Vergiftungstest“ aktualisieren könne. Warum das gesamte Repository und Gewicht löschen?

Der Microsoft-Autor erklärte, dass dies nach den neuesten internen Vorschriften nur möglich sei.

Einige Leute sagten auch, dass wir Modelle ohne „Lobotomie“ wollen.

Entwickler müssen jedoch noch geduldig warten, und das Microsoft-Team verspricht, dass es nach Abschluss des Tests wieder online gehen wird.

Das obige ist der detaillierte Inhalt vonInnerhalb weniger Stunden nach der Veröffentlichung hat Microsoft in Sekundenschnelle ein großes Open-Source-Modell gelöscht, das mit GPT-4 vergleichbar ist! Vergiftungstest vergessen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Eine vollständige Liste häufig verwendeter Git-Befehle [empfohlene Sammlung]

- So verwenden Sie die Vlookup-Funktion von Excel, um mehrere Datenspalten gleichzeitig abzugleichen

- So lösen Sie Zusammenführungskonflikte in Git

- Drei Möglichkeiten, den Git-Add-Befehl abzubrechen

- Die internen Tests von Kimi Chat beginnen, Volcano Engine bietet Beschleunigungslösungen und unterstützt das Training und die Inferenz des Moonshot AI-Großmodelldienstes