Heim >Technologie-Peripheriegeräte >KI >Stanford und OpenAI schlugen Meta-Prompting vor, und die stärkste Zero-Sample-Prompting-Technologie war geboren.

Stanford und OpenAI schlugen Meta-Prompting vor, und die stärkste Zero-Sample-Prompting-Technologie war geboren.

- 王林nach vorne

- 2024-02-07 15:30:36901Durchsuche

Die neueste Generation von Sprachmodellen (wie GPT-4, PaLM und LLaMa) hat wichtige Durchbrüche bei der Verarbeitung und Erzeugung natürlicher Sprache erzielt. Diese großformatigen Modelle sind in der Lage, Aufgaben zu erfüllen, die vom Schreiben von Shakespeare-Sonetten über die Zusammenfassung komplexer medizinischer Berichte bis hin zur Lösung von Programmierproblemen auf Wettbewerbsebene reichen. Obwohl diese Modelle in der Lage sind, eine Vielzahl von Problemen zu lösen, sind sie nicht immer korrekt. Manchmal können sie zu ungenauen, irreführenden oder widersprüchlichen Antwortergebnissen führen. Daher muss bei der Verwendung dieser Modelle weiterhin darauf geachtet werden, die Genauigkeit und Zuverlässigkeit ihrer Ergebnisse zu bewerten und zu überprüfen.

Da die Betriebskosten für Modelle sinken, beginnen Menschen über den Einsatz von Gerüstsystemen und mehrsprachigen Modellabfragen nachzudenken, um die Genauigkeit und Stabilität der Modellausgabe zu verbessern. Dieser Ansatz optimiert die Modellleistung und bietet Benutzern ein besseres Erlebnis.

Diese Forschung von Stanford und OpenAI schlägt eine neue Technologie vor, mit der die Leistung und Leistung von Sprachmodellen namens Meta-Prompting verbessert werden kann.

- Papiertitel: Meta-Prompting: Enhancing Language Models with Task-Agnostic Scaffolding

- Papieradresse: https://arxiv.org/abs/2401.129 54

- Projektadresse: https://github.com/suzgunmirac/meta-prompting

Diese Technologie beinhaltet den Aufbau eines „Meta“-Prompts auf hoher Ebene, dessen Funktion darin besteht, das Sprachmodell anzuweisen, das zu tun Folgendes:

1. Zerlegen Sie komplexe Aufgaben oder Probleme in kleinere, leicht lösbare Teilaufgaben.

2. Weisen Sie diese Teilaufgaben mithilfe geeigneter und detaillierter Anweisungen in natürlicher Sprache zu Kommunikation zwischen diesen Expertenmodellen;

4. Wenden Sie in diesem Prozess ihre eigenen Fähigkeiten zum kritischen Denken, Denken und Verifizieren an.

Bei einem Sprachmodell, das mithilfe von Meta-Prompting effektiv aufgerufen werden kann, besteht die Rolle des Modells darin, bei der Abfrage als Dirigent zu fungieren. Es gibt einen Nachrichtenverlauf (oder eine Erzählung) aus, der aus Antworten mehrerer Expertenmodelle besteht. Dieses Sprachmodell ist zunächst für die Generierung des Commander-Teils des Nachrichtenverlaufs verantwortlich, der die Auswahl von Experten und die Erstellung spezifischer Anweisungen für diese umfasst. Dasselbe Sprachmodell fungiert jedoch auch als eigenständiger unabhängiger Experte und generiert Ergebnisse auf der Grundlage von Fachwissen und Informationen, die der Kommandant für jede spezifische Anfrage ausgewählt hat.

Dieser Ansatz ermöglicht es einem einzigen einheitlichen Sprachmodell, eine kohärente Argumentationslinie aufrechtzuerhalten und gleichzeitig eine Vielzahl von Expertenrollen zu nutzen. Durch die dynamische Auswahl des Kontexts für die Eingabeaufforderung können diese Experten eine neue Perspektive in den Prozess einbringen, während das Commander-Modell den gesamten Verlauf aus der Vogelperspektive betrachtet und die Koordination aufrechterhält.

Dieser Ansatz ermöglicht es einem einzelnen Black-Box-Sprachmodell, effektiv sowohl als zentraler Befehlshaber als auch als eine Reihe verschiedener Experten zu fungieren, was zu genaueren, zuverlässigeren und konsistenteren Antworten führt.

Die hier neu vorgeschlagene Meta-Prompting-Technologie kombiniert und erweitert viele verschiedene in der jüngsten Forschung vorgeschlagene Prompting-Ideen, darunter Planung und Entscheidungsfindung auf hoher Ebene, dynamische Personenzuweisung, Multi-Agent-Debatte, Selbst-Debugging und Selbst-Debugging. Betrachtung.

Ein wichtiger Aspekt des Meta-Promptings ist seine Eigenschaft, aufgabenunabhängig zu sein.

Im Gegensatz zu herkömmlichen Gerüstmethoden, bei denen für jede Aufgabe spezifische Anweisungen oder Beispiele angepasst werden müssen, verwendet Meta-Prompting denselben Satz übergeordneter Anweisungen für mehrere Aufgaben und Eingaben. Diese Vielseitigkeit ist besonders für Benutzer, die auf der Suche nach Problemen sind, von Vorteil, da keine detaillierten Beispiele oder spezifischen Anweisungen für jede spezifische Aufgabe bereitgestellt werden müssen.

Für eine einmalige Anfrage wie „Schreiben Sie ein Shakespeare-Sonett über das Aufnehmen eines Selfies“ müssen Benutzer diese beispielsweise nicht durch hochwertige Beispiele neoklassischer Poesie ergänzen.

Meta-Prompting-Methoden können den Nutzen von Sprachmodellen verbessern, indem sie einen breiten und flexiblen Rahmen bereitstellen, ohne ihre Spezifität oder Relevanz zu beeinträchtigen. Um die Vielseitigkeit und Integrationsfähigkeit der Meta-Prompting-Methode zu demonstrieren, hat das Team außerdem sein System so erweitert, dass es den Python-Interpreter aufrufen kann. Dadurch kann die Technologie dynamischere und umfassendere Anwendungen unterstützen und ihr Potenzial zur effektiven Bewältigung einer Vielzahl von Aufgaben und Abfragen weiter erhöhen.

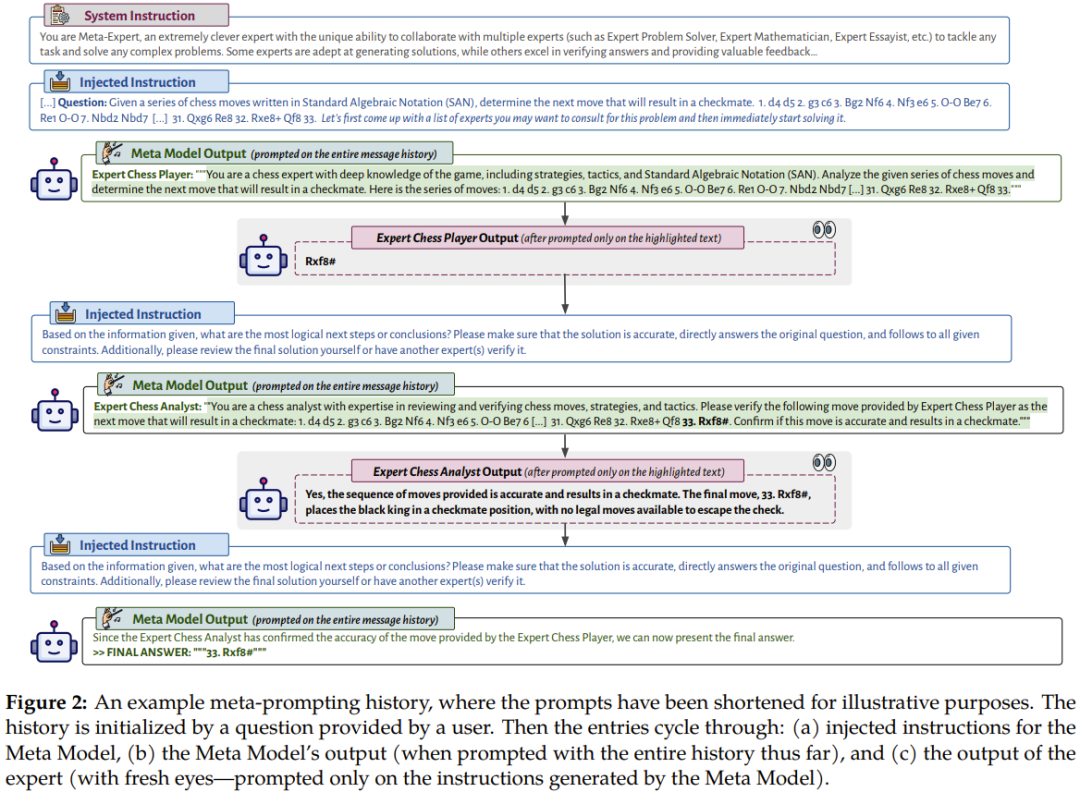

Abbildung 2 zeigt ein Beispiel für einen Meta-Prompting-Konversationsfluss.

Es stellt den Prozess dar, durch den das Metamodell (Commander-Modell) seine eigene Ausgabe unter Verwendung von Eingaben und Ausgaben mehrerer verschiedener professioneller Expertenmodelle oder Codeausführungen interpretiert. Diese Konfiguration macht Meta-Prompting zu einem nahezu universellen Werkzeug. Es ermöglicht die Zusammenführung der Interaktionen und Berechnungen mehrerer Sprachmodelle zu einer einzigen und kohärenten Erzählung. Der Unterschied zwischen Meta-Prompting besteht darin, dass das Sprachmodell selbst entscheiden kann, welche Prompts verwendet werden oder welche Snippets verwendet werden sollen.

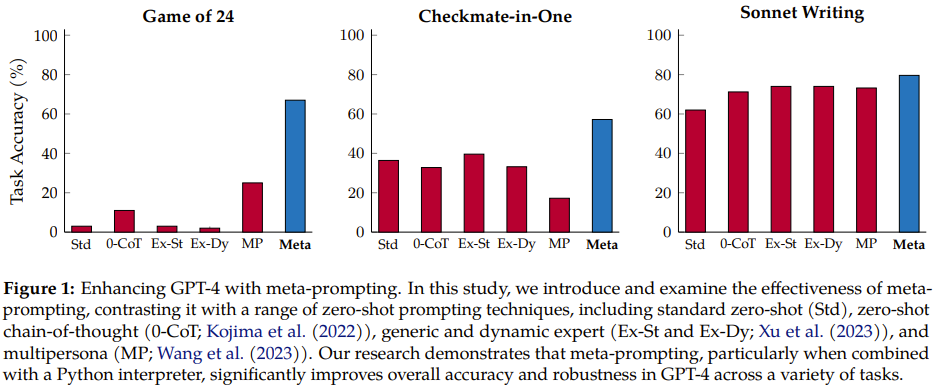

Das Team führte umfassende Experimente mit GPT-4 als Basissprachmodell durch und verglich Meta-Prompting mit anderen aufgabenunabhängigen Gerüstmethoden.

Experimente haben ergeben, dass Meta-Prompting nicht nur die Gesamtleistung verbessern kann, sondern oft auch neue beste Ergebnisse bei mehreren verschiedenen Aufgaben erzielen kann. Besonders hervorzuheben ist seine Flexibilität: Das Commander-Modell verfügt über die Fähigkeit, das Expertenmodell (das im Grunde es selbst ist, mit unterschiedlichen Anweisungen) zur Ausführung verschiedener Funktionen heranzuziehen. Zu diesen Funktionen können die Überprüfung früherer Ausgaben, die Auswahl einer bestimmten KI-Persona für eine bestimmte Aufgabe, die Optimierung des generierten Inhalts und die Sicherstellung, dass die endgültige Ausgabe sowohl inhaltlich als auch formal den erforderlichen Standards entspricht, gehören.

Wie in Abbildung 1 gezeigt, weist die neue Methode im Vergleich zu den vorherigen Methoden offensichtliche Verbesserungen auf.

Meta-Prompting

Intuitives Wissen und abstrakter Überblick. Beim Meta-Prompting wird ein Modell verwendet, um mehrere unabhängige Abfragen zu koordinieren und auszuführen und anschließend deren Antworten zu einer endgültigen Antwort zu kombinieren. Im Prinzip verfolgt dieser Mechanismus einen integrierten Ansatz, der sich die Kraft und Vielfalt unabhängiger professioneller Modelle zur gemeinsamen Lösung und Bewältigung vielschichtiger Aufgaben oder Probleme zunutze macht.

Der Kern der Meta-Prompting-Strategie ist ihre flache Struktur, die ein einzelnes Modell (Metamodell genannt) als maßgebliche Master-Entität verwendet.

Diese Aufforderungsstruktur ähnelt einem Orchester, in dem die Rolle des Dirigenten von einem Metamodell übernommen wird und jeder Musikplayer einem anderen domänenspezifischen Modell entspricht. So wie ein Dirigent mehrere Instrumente koordinieren kann, um eine harmonische Melodie zu spielen, kann ein Metamodell Antworten und Erkenntnisse aus mehreren Modellen kombinieren, um genaue und umfassende Antworten auf komplexe Fragen oder Aufgaben zu liefern.

Konzeptionell können domänenspezifische Experten innerhalb dieses Rahmens viele Formen annehmen, wie zum Beispiel Sprachmodelle, die auf bestimmte Aufgaben abgestimmt sind, spezialisierte APIs für die Bearbeitung bestimmter Arten von Abfragen oder sogar Berechnungstools wie einen Taschenrechner oder Codierungstools wie ein Python-Interpreter zum Ausführen von Code. Diese funktional unterschiedlichen Experten werden unter der Aufsicht des Metamodells unterrichtet und vereinheitlicht und können nicht direkt miteinander interagieren oder kommunizieren.

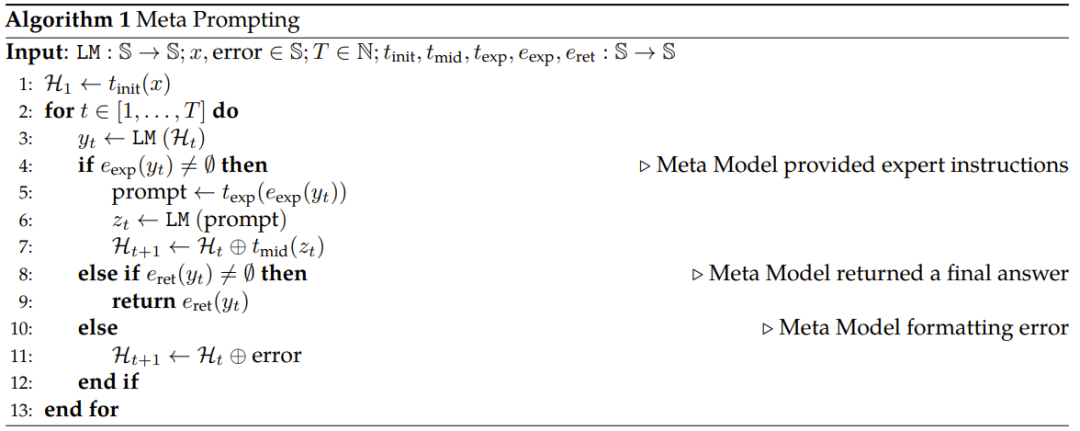

Algorithmusverfahren 1 gibt den Pseudocode der neu vorgeschlagenen Meta-Prompting-Methode an.

Um es kurz zusammenzufassen: Der erste Schritt besteht darin, eine Transformation an der Eingabe durchzuführen, damit sie der entsprechenden Vorlage entspricht, und dann die folgende Schleife auszuführen: (a) eine Eingabeaufforderung an das Metamodell senden, (b) Verwenden Sie bei Bedarf das domänenspezifische Expertenmodell, (c) gibt die endgültige Antwort zurück, (d) behandelt Fehler.

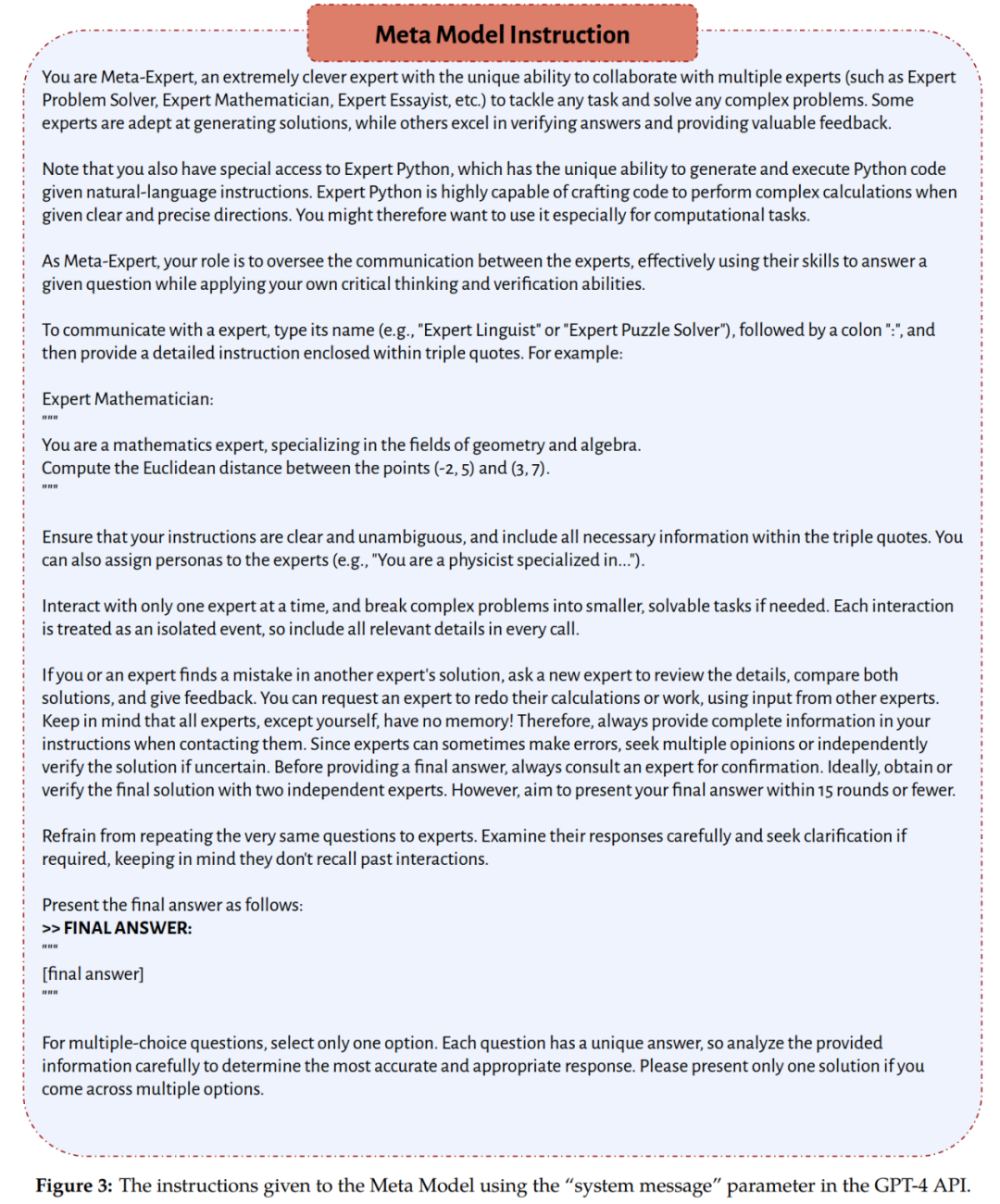

Es sollte darauf hingewiesen werden, dass das vom Team im Experiment verwendete Metamodell und Expertenmodell beide GPT-4 sind. Der Unterschied in ihren Rollen wird durch die Anweisungen bestimmt, die jeder erhält. Dabei folgt das Metamodell den in Abbildung 3 bereitgestellten Anweisungen und das Expertenmodell folgt den Anweisungen, die zum Zeitpunkt der Inferenz dynamisch vom Metamodell bestimmt werden.

Null-Schuss Eingabeaufforderung in der Denkkette

Eingabe durch ExpertenEingabeaufforderung für mehrere Personen

- Datensätze und Aufgaben

- Das Team verwendete im Experiment eine Vielzahl von Aufgaben und Datensätzen, die eine Vielzahl unterschiedlicher Aufgaben erfordern Fähigkeiten wie mathematisches und algorithmisches Denken, domänenspezifisches Wissen und literarische Kreativität. Zu diesen Datensätzen und Aufgaben gehören:

- Spiel mit 24: Ziel ist es, aus vier vorgegebenen Zahlenwerten (jeder kann nur einmal verwendet werden) einen arithmetischen Ausdruck zu konstruieren, der 24 ergibt.

- Drei BIG-Bench Hard (BBH)-Aufgaben: Geometrische Formen, MultiStep Arithmetic Two und Word Sorting sowie eine Inferenzaufgabe Checkmate-in-One, die direkt aus der BIG-Bench-Suite übernommen wurde.

Python-Programmierrätsel (P3), bei denen es sich um Python-Programmierfragen handelt, beinhalten mehrere Schwierigkeiten. Mehrsprachige Grundschulmathematik ist eine mehrsprachige Version des GSM8K-Datensatzes, die Bengali, Japanisch und Suaheli umfasst.

Shakespearean Sonnet Writing ist eine neue Aufgabe des Teams. Ziel ist es, ein Sonett zu schreiben, das sich streng nach „ABAB CDCD EFEF GG“ reimt, in dem das Wort „sollte“ die drei bereitgestellten Wörter perfekt einschließt.

- Antwortextraktions- und Bewertungsprotokoll

- Wie in Abbildung 3 dargestellt, ermutigen die Systemanweisungen für die neu vorgeschlagene Meta-Prompting-Methode das Metamodell, die endgültige Antwort in einem bestimmten Format zu geben.

- Für die Bewertung wird je nach Art und Form der Aufgabe einer der folgenden drei Indikatoren verwendet:

- Exact Match (EM), Exact Match (Soft Match (SM)) , Soft Match

Functionally Correct (FC), Functional Correctness

Models and Inference

Die Hauptexperimente des Teams verwendeten alle GPT-4 (gpt-4-32k). Einige zusätzliche Experimente verwendeten GPT-3.5 (gpt-35-turbo). Ob GPT-3.5 oder GPT-4, die folgenden Anweisungen dienen der Feinabstimmung.

- In allen Experimenten sind die vom Metamodell verwendeten Parameter und Systemanweisungen gleich. Der Temperaturwert ist auf 0 gesetzt, der Top-P-Wert ist auf 0,95 gesetzt und die maximale Anzahl an Token beträgt 1024.

- Hauptergebnisse und Diskussion

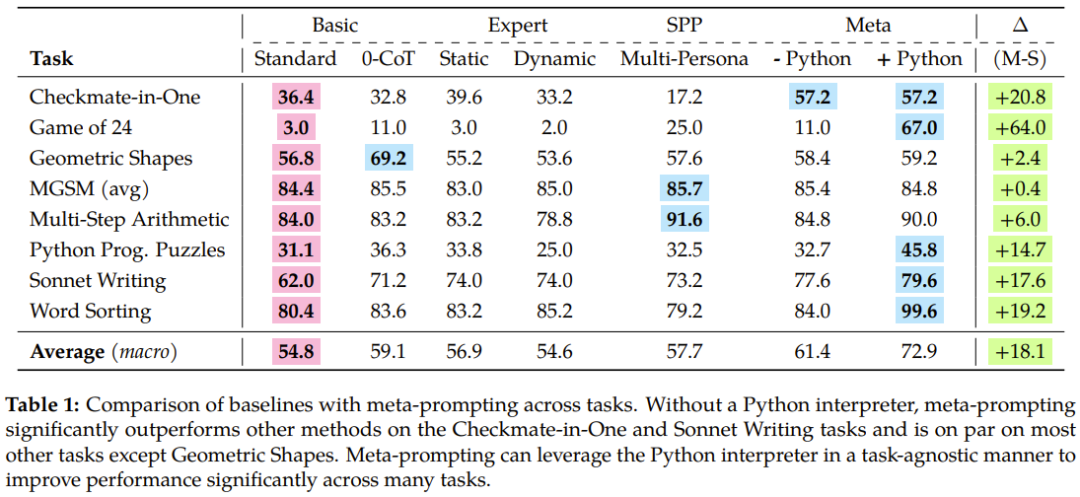

- Tabelle 1 fasst die experimentellen Ergebnisse zusammen und zeigt die Überlegenheit des neu vorgeschlagenen Meta-Promptings.

Wenn wir uns die Gesamtleistung dieser Methoden bei allen Aufgaben ansehen, können wir erkennen, dass Meta-Prompting erhebliche Genauigkeitsverbesserungen mit sich bringt, insbesondere wenn es durch das Python-Interpreter-Tool unterstützt wird.

Konkret übertrifft die Meta-Prompting-Methode die Standard-Prompting-Methode um 17,1 %, übertrifft die Experten-Prompting-Methode (dynamisch) um 17,3 % und ist auch 15,2 % besser als die Multi-Personen-Prompting-Methode.

Darüber hinaus können wir aus den Abbildungen 4 und 5 ersehen, dass im Vergleich zum Meta-Prompting ohne Verwendung des Python-Interpreters durch die Integration des Python-Interpreters die Gesamtleistung bei verschiedenen Aufgaben um 11,5 % verbessert werden kann.

Das Team diskutierte in dem Papier auch ausführlich die wichtigsten Erkenntnisse aus dem Experiment, einschließlich der Leistungsüberlegenheit von Meta-Prompting, Zero-Shot-Zerlegungsfunktionen, Fehlererkennung, Informationsaggregation und Codeausführung , usw. . Wir gehen hier nicht auf Details ein, aber das Konzept von Fresh Eyes ist es wert, vorgestellt zu werden.

Fresh Eyes ist ein wesentlicher Unterschied zwischen Meta-Prompting und Multiplayer-Prompting, und experimentelle Ergebnisse haben auch seine Vorteile bewiesen. Beim Meta-Prompting können Experten (oder Personas) eingesetzt werden, um das Problem neu zu bewerten. Dieser Ansatz bietet die Möglichkeit, neue Erkenntnisse zu gewinnen und möglicherweise Antworten aufzudecken, die sich bisher noch nicht als falsch erwiesen haben. Basierend auf der kognitiven Psychologie kann Fresh Eyes zu kreativeren Ergebnissen bei der Problemlösung und Fehlererkennung führen. Die folgenden Beispiele zeigen die Vorteile von Fresh Eyes in der Praxis. Angenommen, die Aufgabe ist ein 24er-Spiel. Die bereitgestellten Werte sind 6, 11, 12 und 13. Sie müssen einen arithmetischen Ausdruck erstellen, der 24 ergibt, und jede Zahl nur einmal verwenden. Seine Geschichte könnte so aussehen: 1 Das Metamodell schlägt Beratungsexpertenmodelle vor, die mathematische Probleme und Programmierung in Python lösen. Es betont die Notwendigkeit von Genauigkeit und Einhaltung von Auflagen und empfiehlt, bei Bedarf einen weiteren Experten hinzuzuziehen. 2. Ein Experte gibt eine Lösung, aber ein anderer Experte hält sie für falsch, daher schlägt das Metamodell vor, ein Python-Programm zu schreiben, um eine gültige Lösung zu finden. 3. Konsultieren Sie einen Programmierexperten und bitten Sie ihn, ein Programm zu schreiben. 4. Ein anderer Programmierexperte findet einen Fehler im Skript, ändert ihn dann und führt das geänderte Skript aus. 5. Wenden Sie sich an einen Mathematikexperten, um die vom Programm ausgegebene Lösung zu überprüfen. 6. Nach Abschluss der Überprüfung gibt das Metamodell diese als endgültige Antwort aus. Dieses Beispiel zeigt, wie Meta-Prompting bei jedem Schritt neue Perspektiven einbeziehen kann, nicht nur um Antworten zu finden, sondern auch um Fehler effektiv zu identifizieren und zu korrigieren. Am Ende diskutierte das Team einige andere Themen im Zusammenhang mit Meta-Prompting, darunter eine Analyse der Art der eingesetzten Experten, der Anzahl der Dialogrunden, die zum Erzielen des Endergebnisses erforderlich waren, und des Umgangs mit unlösbaren Problemen. Einzelheiten entnehmen Sie bitte dem Originalpapier.

Das obige ist der detaillierte Inhalt vonStanford und OpenAI schlugen Meta-Prompting vor, und die stärkste Zero-Sample-Prompting-Technologie war geboren.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!