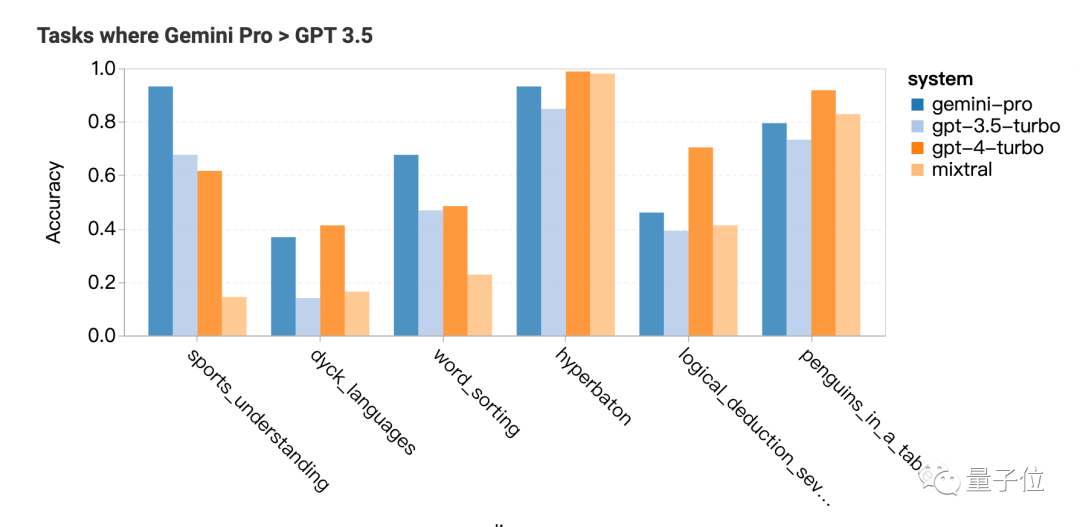

Heim >Technologie-Peripheriegeräte >KI >CMU führte eine detaillierte Vergleichsstudie durch und stellte fest, dass GPT-3.5 Gemini Pro überlegen ist und eine faire, transparente und reproduzierbare Leistung gewährleistet

CMU führte eine detaillierte Vergleichsstudie durch und stellte fest, dass GPT-3.5 Gemini Pro überlegen ist und eine faire, transparente und reproduzierbare Leistung gewährleistet

- PHPznach vorne

- 2023-12-21 08:13:381176Durchsuche

Was ist die Stärke von Google Gemini? Die Carnegie Mellon University hat einen professionellen und objektiven Drittanbietervergleich durchgeführt.

Um Fairness zu gewährleisten, alle Modelle verwenden dieselben Eingabeaufforderungen und Generierungsparameter und liefern reproduzierbaren Code und vollständig transparente Ergebnisse.

wird CoT@32 nicht verwenden, um 5-Shots zu vergleichen, wie Googles offizielle Pressekonferenz.

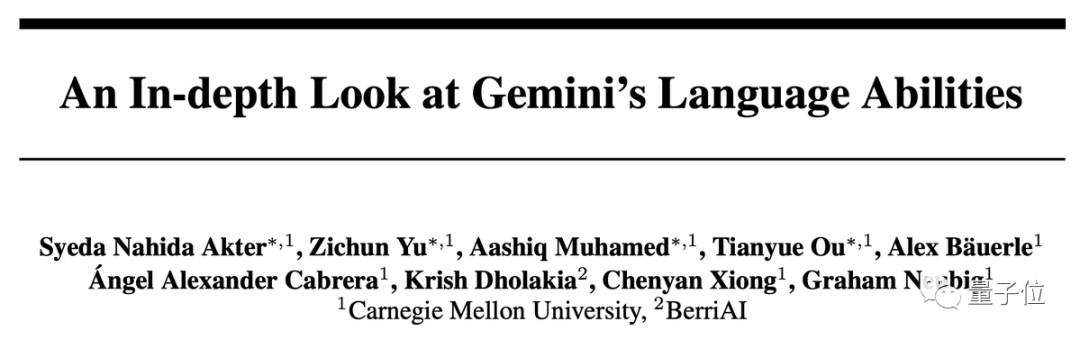

Ergebnisse in einem Satz: Die Gemini Pro-Version liegt nahe an GPT-3.5 Turbo, ist ihm aber etwas unterlegen, und GPT-4 liegt immer noch weit vorne.

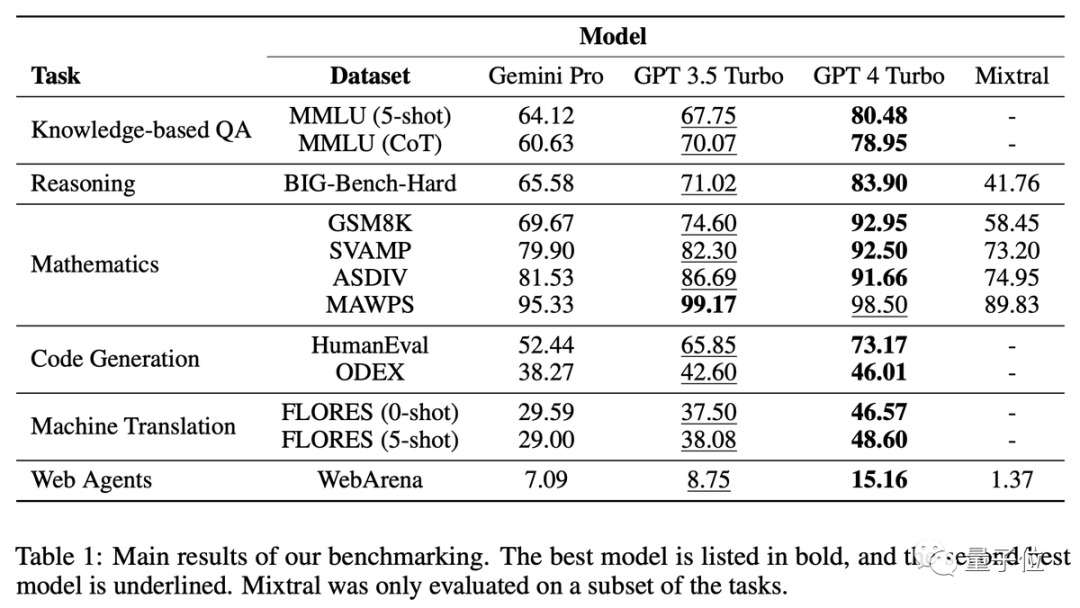

In der eingehenden Analyse haben wir auch einige seltsame Merkmale von Zwillingen gefunden, wie zum Beispiel Ich wähle gerne D für Multiple-Choice-Fragen…

Viele Forscher sagten, dass Zwillinge durchgeführt wurden nur wenige Tage nach der Veröffentlichung sehr detailliert. Dies ist eine sehr bemerkenswerte Leistung

Frage und Antwort: MMLU Inferenz: BIG-Bench Hard

Inferenz: BIG-Bench Hard

Mathe: GSM8k, SVAMP, ASDIV, MAWPS

Code: HumanEval, ODEX

- Übersetzung: FLORES

- Surfen: WebArena

- Trivia: Like D

- Anhand der Ergebnisse ist ersichtlich, dass die Verwendung von Denkkettenaufforderungen bei dieser Art von Aufgabe nicht unbedingt die Wirkung verbessert. Im MMLU-Datensatz handelt es sich bei allen Fragen um Multiple-Choice-Fragen. Nach einer weiteren Analyse der Ergebnisse wurde ein seltsames Phänomen entdeckt: Gemini bevorzugt Option D. Die Verteilung der GPT-Reihe auf die vier Optionen ist viel ausgewogener. Das Team vermutete, dass dies daran liegen könnte, dass Gemini nicht viele Anweisungen für mehrere bereitstellte -Auswahlfragen

- durch Feinabstimmung verursacht.

Darüber hinaus ist die Sicherheitsfilterung von Gemini sehr streng. Bei ethischen Fragen werden nur 85 % der Fragen beantwortet. Wenn es um Fragen im Zusammenhang mit der menschlichen Sexualität geht, kann es nur 28 % der Fragen beantworten

Gemini Pro übertrifft GPT-3.5 in der Sicherheitsforschung und der Mikroökonomie an weiterführenden Schulen, aber der Abstand ist nicht groß, sagte das Team. Ich finde nichts Besonderes

Gemini Pro übertrifft GPT-3.5 in der Sicherheitsforschung und der Mikroökonomie an weiterführenden Schulen, aber der Abstand ist nicht groß, sagte das Team. Ich finde nichts Besonderes

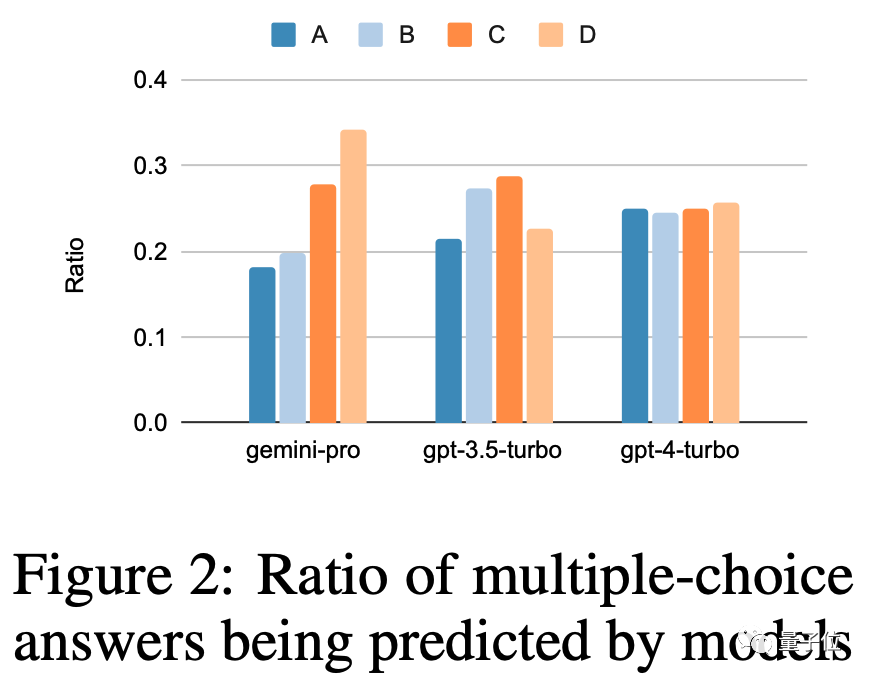

Begründung: Lange Probleme eignen sich nicht gut

Die GPT-Serie schneidet bei längeren und komplexeren Problemen besser ab, im Vergleich schneidet Gemini Pro weniger gut ab. Hervorragend

Zu den Aufgaben, in denen Zwillinge gut sind, gehören das Verstehen der verschiedenen Sportarten der Welt, das Manipulieren von Symbolstapeln, das Sortieren von Wörtern in alphabetischer Reihenfolge und das Analysieren von Tabellen

Mathematik: Komplexe Aufgaben übertroffen

Die Frage selbst war zu lang, was dazu führte, dass die Leistung von Gemini Pro und GPT-3.5 gleichzeitig abfiel und nur GPT-4 ein konstantes Niveau halten konnte

Als die Länge der Denkkette am längsten war, übertraf Gemini GPT- 3.5

Code: Gut bei Matplotlib

Bei Code-Fragen schneidet Gemini bei Fragen mit langen Referenzantworten nicht gut ab

Die GPT-Familie ist in den meisten Typen leistungsfähiger, schneidet bei Matplotlib jedoch völlig schlechter ab

Übersetzung: Einfach antworten Ja, die Qualität ist sehr hoch

Bei der Übersetzungsaufgabe weigerte sich Gemini, 12 Arten von Fragen zu beantworten, aber die Qualität der beantworteten Übersetzungen war alle sehr gut und die Gesamtleistung übertraf sie GPT-4

Gemini weigerte sich zu übersetzen. Die Sprachen umfassen hauptsächlich Latein und Arabisch. soziale Foren, gemeinsame GitLab-Entwicklung, Content-Management-Systeme und Online-Karten. KI muss Informationen in dieser Umgebung finden oder Aufgaben standortübergreifend erledigen.

Gemini schneidet insgesamt nicht so gut ab wie GPT-3.5 Turbo, schneidet aber bei Aufgaben über mehrere Standorte hinweg etwas besser ab.

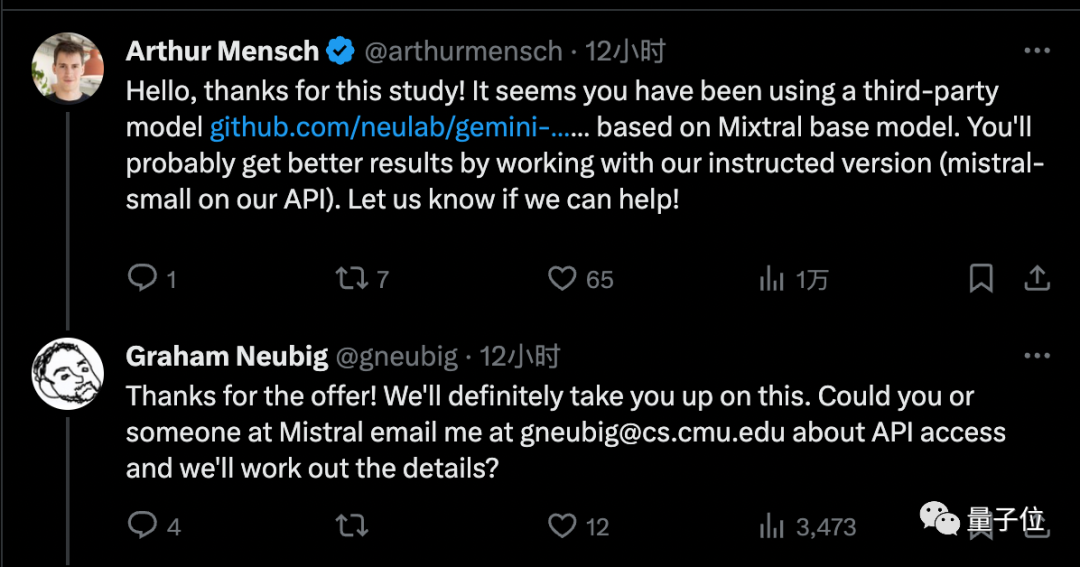

Netizen: Aber es ist kostenlos Eingabeaufforderungswörter für verschiedene Modelle können unterschiedlich sein Erhöhen Sie es um 5 bis 10 Prozentpunkte, was sehr hilfreich für Inferenzaufgaben ist Noam Brown glaubt, dass die Ergebnisse von Mixtral ignoriert werden können, da anstelle der offiziellen Implementierung eine Drittanbieter-API verwendet wird

Der Gründer von Mistral AI hat dem Team Zugriff auf die offizielle Version gewährt, von der er glaubt, dass sie bessere Ergebnisse bringen wird

Obwohl Gemini Pro nicht so gut wie GPT-3.5 ist, besteht sein Vorteil darin, dass es als Nein bezeichnet werden kann mehr als 60 Mal pro Minute Es kann kostenlos genutzt werden

Daher haben viele einzelne Entwickler das Lager gewechselt

Derzeit ist die höchste Version von Gemini, die Ultra-Version, noch nicht veröffentlicht, und das CMU-Team beabsichtigt auch um diese Forschung bis dahin fortzusetzen

Glauben Sie, dass Gemini Ultra GPT-Level 4 erreichen kann?

Dieser Artikel enthält Einzelheiten zum Artikel: https://arxiv.org/abs/2312.11444

Referenzlink:

[1]https://twitter.com/gneubig/status/1737108977954251216.

Das obige ist der detaillierte Inhalt vonCMU führte eine detaillierte Vergleichsstudie durch und stellte fest, dass GPT-3.5 Gemini Pro überlegen ist und eine faire, transparente und reproduzierbare Leistung gewährleistet. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- So debuggen Sie React-Projekte bei Google

- So verwenden Sie Google Maps in Uniapp

- Wählen Sie GPT-3.5 oder optimieren Sie Open-Source-Modelle wie Llama 2? Nach einem umfassenden Vergleich lautet die Antwort

- Auf der Suche nach Szenen für das große Google-Projekt Gemini AI-Projekt Ellman

- Google Gemini schlägt GPT-3.5 gewaltsam und erklärt es für kostenlos! Das leistungsstärkste Tool zur Codegenerierung wird eingeführt, um mehr als 20 Sprachen zu unterstützen