Heim >Technologie-Peripheriegeräte >KI >In Kombination mit der Physik-Engine generiert das GPT-4+-Diffusionsmodell realistische, kohärente und vernünftige Videos

In Kombination mit der Physik-Engine generiert das GPT-4+-Diffusionsmodell realistische, kohärente und vernünftige Videos

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-11-27 14:58:541228Durchsuche

Die Einführung des Diffusionsmodells hat die Entwicklung der Videotechnologie zur Texterzeugung vorangetrieben. Allerdings sind diese Methoden oft rechenintensiv und es ist schwierig, Videos mit reibungsloser Objektbewegung zu erstellen.

Um diese Probleme zu lösen, haben Forscher aus Shenzhen Das Institute of Advanced Technology, die Chinesische Akademie der Wissenschaften, Forscher der Universität der Chinesischen Akademie der Wissenschaften und das VIVO Artificial Intelligence Laboratory haben gemeinsam ein neues Framework namens GPT4Motion vorgeschlagen, mit dem Textvideos ohne Schulung erstellt werden können. GPT4Motion kombiniert die Planungsfähigkeiten großer Sprachmodelle wie GPT, die physikalischen Simulationsfähigkeiten der Blender-Software und die Textgenerierungsfähigkeiten von Diffusionsmodellen mit dem Ziel, die Qualität der Videosynthese erheblich zu verbessern Projektlink: https://gpt4motion.github.io/

- Codelink: https://github.com/jiaxilv /GPT4Motion

- GPT4Motion verwendet GPT-4, um Blender-Skripte basierend auf Benutzereingabeaufforderungen zu generieren. Es nutzt die Physik-Engine von Blender, um grundlegende Szenenkomponenten zu erstellen und sie als kontinuierliche, bildübergreifende Bewegung zu kapseln. Diese Komponenten werden dann in ein Diffusionsmodell eingegeben, um ein Video zu generieren, das der Textaufforderung entspricht

- Experimentelle Ergebnisse zeigen, dass GPT4Motion effizient qualitativ hochwertige Videos generieren und dabei Bewegungskonsistenz und Entitätskonsistenz beibehalten kann. Es ist zu beachten, dass GPT4Motion eine Physik-Engine verwendet, um das generierte Video realistischer zu machen. Dies bietet eine neue Perspektive für Videos zur Textgenerierung

In Bezug auf Flüssigkeitsströmungsmuster kann das von GPT4Motion generierte Video ebenfalls zeigen es gut:

Basketball dreht sich und fällt aus der Luft:

Basketball dreht sich und fällt aus der Luft:

Einführung in die Methode

Darüber hinaus legten die Forscher besonderes Augenmerk auf mehrere typische Bewegungsmodi dieser Materialien, darunter Kollision (direkter Aufprall zwischen Objekten), Windeffekt (durch Luftströmung verursachte Bewegung) und Strömung (kontinuierlich und in eine Richtung bewegt). . Die Simulation dieser physikalischen Szenarien erfordert häufig Kenntnisse der klassischen Mechanik, Strömungsmechanik und anderer Physik. Das aktuelle Verbreitungsmodell, das sich auf textgenerierte Videos konzentriert, ist schwierig, dieses komplexe physikalische Wissen durch Training zu erwerben, und kann daher keine Videos produzieren, die den physikalischen Eigenschaften entsprechen. Der Vorteil von GPT4Motion besteht darin, sicherzustellen, dass das generierte Video nicht nur mit dem übereinstimmt fordert zur Eingabe durch den Benutzer auf und ist auch physikalisch korrekt. Das semantische Verständnis und die Codegenerierungsfunktionen von GPT-4 können Benutzereingaben in Blenders Python-Skripte umwandeln, die die integrierte Physik-Engine von Blender antreiben können, um entsprechende physische Szenen zu simulieren. Darüber hinaus nutzte die Studie auch ControlNet und nutzte die dynamischen Ergebnisse der Blender-Simulation als Eingabe, um das Diffusionsmodell zu steuern, um Video Bild für Bild zu generieren.

Verwendung von GPT-4, um Blender für Simulationsvorgänge zu aktivieren

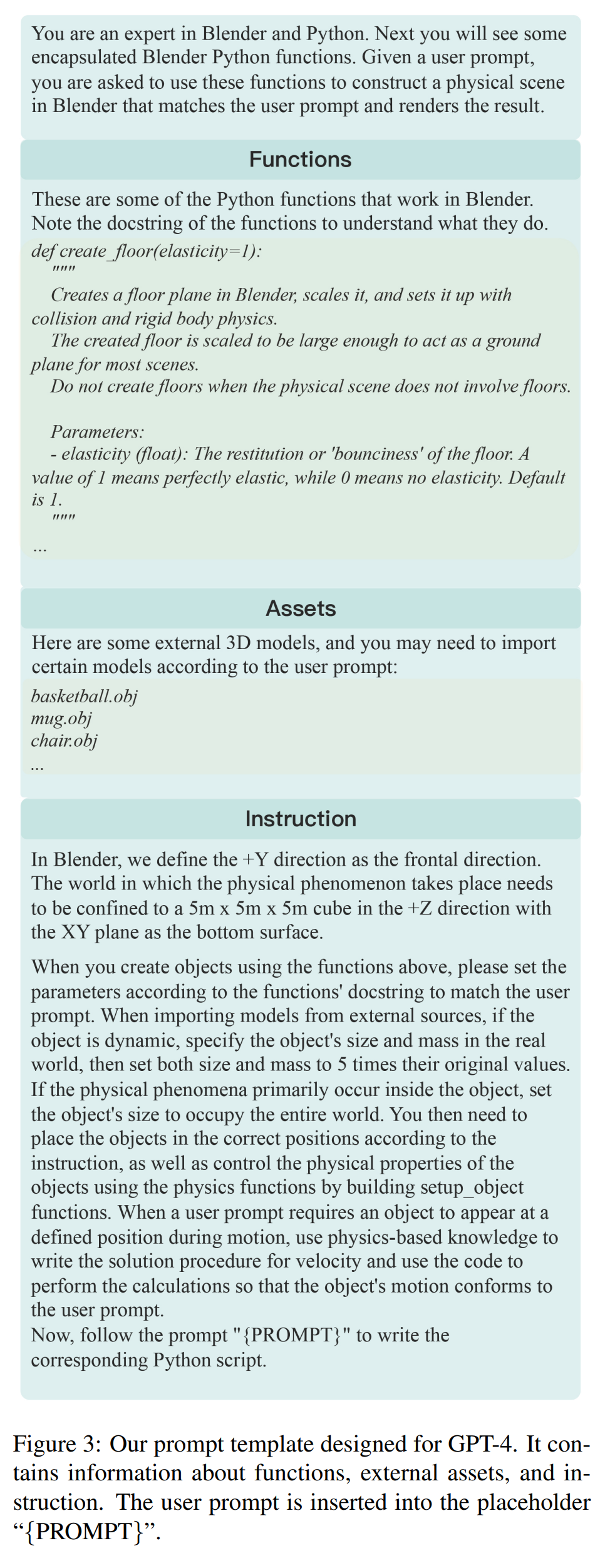

Forscher stellten fest, dass GPT-4 zwar über ein gewisses Verständnis der Python-API von Blender verfügt, es jedoch immer noch an der Fähigkeit mangelt, Blender-Python-Skripte basierend auf Benutzereingaben zu generieren. Einerseits scheint es eine entmutigende Aufgabe zu sein, GPT-4 zu bitten, auch nur ein einfaches 3D-Modell (wie einen Basketball) direkt in Blender zu erstellen. Da die Python-API von Blender andererseits über weniger Ressourcen verfügt und API-Versionen schnell aktualisiert werden, ist es für GPT-4 leicht, bestimmte Funktionen zu missbrauchen oder aufgrund von Versionsunterschieden Fehler zu machen. Um diese Probleme zu lösen, schlägt die Studie die folgende Lösung vor:

- Verwenden Sie ein externes 3D-Modell

- , um Blender-Funktionen zu kapseln

- Konvertieren Sie Benutzereingaben in physikalische Eigenschaften

Abbildung 3 zeigt die Studie Generische Eingabeaufforderungsvorlage für GPT-4. Es umfasst gekapselte Blender-Funktionen, externe Tools und Benutzerbefehle. Die Forscher definierten in der Vorlage die Größenstandards der virtuellen Welt und machten Angaben zur Kameraposition und -perspektive. Diese Informationen helfen GPT-4, den Aufbau des dreidimensionalen Raums besser zu verstehen. Anschließend werden die entsprechenden Anweisungen basierend auf der Eingabeaufforderung des Benutzers generiert und GPT-4 angeleitet, das entsprechende Blender-Python-Skript zu generieren. Schließlich rendert Blender über dieses Skript die Kanten und die Tiefe des Objekts und gibt es als Bildsequenz aus.

Umgeschriebener Inhalt: Erstellen von Videos, die den Gesetzen der Physik folgen

Diese Studie zielt darauf ab, basierend auf den vom Benutzer bereitgestellten Eingabeaufforderungen und den entsprechenden physischen Bewegungsbedingungen, die von bereitgestellt werden, zu generieren Blender, Videos, die mit dem Text übereinstimmen und visuell realistisch sind. Zu diesem Zweck wurde in der Studie das Diffusionsmodell „Physikalische Eigenschaften kontrollieren“ übernommen. Abbildung 4 zeigt das von GPT4Motion unter drei Eingabeaufforderungen generierte Basketball-Bewegungsvideo, das das Fallen und Zusammenstoßen des Basketballs beinhaltet. Auf der linken Seite von Abbildung 4 behält der Basketball eine äußerst realistische Textur bei, während er sich dreht und sein Sprungverhalten nach dem Aufprall auf den Boden genau nachbildet. Der mittlere Teil von Abbildung 4 zeigt, dass diese Methode die Anzahl der Basketbälle genau steuern und effektiv die Kollision und den Rückprall erzeugen kann, die auftreten, wenn mehrere Basketbälle landen. Überraschenderweise berechnet GPT-4, wie auf der rechten Seite von Abbildung 4 dargestellt, die erforderliche Anfangsgeschwindigkeit basierend auf der Fallzeit des Basketballs im generierten Skript, wenn der Benutzer ihn auffordert, den Basketball in Richtung Kamera zu werfen, und erzielt so eine realistische Darstellung Auswirkungen. Dies zeigt, dass GPT4Motion mit den von GPT-4 beherrschten physikalischen Kenntnissen kombiniert werden kann, um den generierten Videoinhalt von im Wind wehenden Stoffen zu steuern. Die Abbildungen 5 und 6 zeigen die Fähigkeit von GPT4Motion, Stoffbewegungen unter dem Einfluss von Wind zu erzeugen. GPT4Motion nutzt vorhandene Physik-Engines für Simulationen und kann Wellen und Wellen bei unterschiedlichen Windstärken erzeugen. Abbildung 5 zeigt das generierte Ergebnis einer wehenden Flagge. Die Flagge zeigt komplexe Muster aus Wellen und Wellen bei unterschiedlichen Windbedingungen. Abbildung 6 zeigt die Bewegung eines unregelmäßigen Stoffobjekts, eines T-Shirts, unter verschiedenen Windstärken. Beeinflusst durch die physikalischen Eigenschaften des Stoffes, wie Elastizität und Gewicht, wackelt und verdreht sich das T-Shirt und entwickelt spürbare Faltenveränderungen.

- Abbildung 7 zeigt drei Videos, in denen Wasser unterschiedlicher Viskosität in Becher gegossen wird. Wenn die Viskosität des Wassers niedrig ist, kollidiert das fließende Wasser mit dem Wasser im Becher und verschmilzt, wodurch ein komplexes Turbulenzphänomen entsteht. Mit zunehmender Viskosität wird der Wasserfluss langsamer und die Flüssigkeiten beginnen aneinander zu kleben

Vergleich mit der Basismethode

In Abbildung 1 wird GPT4Motion visuell mit anderen Basismethoden verglichen. Es ist offensichtlich, dass die Ergebnisse der Baseline-Methode nicht mit den Benutzereingaben übereinstimmen. DirecT2V und Text2Video-Zero weisen Mängel bei der Texturtreue und Bewegungskonsistenz auf, während AnimateDiff und ModelScope die Glätte des Videos verbessern, aber es gibt noch Raum für Verbesserungen bei der Texturkonsistenz und Bewegungskonsistenz. Im Vergleich zu diesen Methoden kann GPT4Motion beim Fallen und Springen des Basketballs nach der Kollision mit dem Boden sanfte Texturänderungen erzeugen, was realistischer aussieht. Wie in Abbildung 8 (erste Reihe) gezeigt, werden AnimateDiff und das von erstellte Video erstellt Text2Video-Zero wies Artefakte/Verzerrungen auf der Flagge auf, während ModelScope und DirecT2V nicht in der Lage waren, den Farbverlauf der im Wind flatternden Flagge reibungslos zu erzeugen. Wie in der Mitte von Abbildung 5 dargestellt, kann das von GPT4Motion generierte Video jedoch die kontinuierliche Veränderung von Falten und Wellen in der Flagge unter dem Einfluss von Schwerkraft und Wind zeigen.

Die Ergebnisse aller Baselines stimmen nicht mit den Benutzereingaben überein, wie in der zweiten Zeile in Abbildung 8 dargestellt. Obwohl die Videos von AnimateDiff und ModelScope Veränderungen im Wasserfluss widerspiegeln, können sie die physikalischen Auswirkungen des in eine Tasse strömenden Wassers nicht erfassen. Andererseits erzeugte das von Text2VideoZero und DirecT2V generierte Video eine ständig zitternde Tasse. Im Vergleich dazu beschreibt das von GPT4Motion erzeugte Video, wie in Abbildung 7 (links) dargestellt, die Bewegung, wenn der Wasserfluss mit dem Becher kollidiert, genau und der Effekt ist realistischer. Interessierte Leser können das Originalpapier lesen, um mehr zu erfahren Viele Forschungsinhalte

Das obige ist der detaillierte Inhalt vonIn Kombination mit der Physik-Engine generiert das GPT-4+-Diffusionsmodell realistische, kohärente und vernünftige Videos. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Welche Datenmodelle werden am häufigsten verwendet?

- Welche drei Arten von Datenbankdatenmodellen gibt es?

- Welche Datenmodelle werden vom Access2010-Datenbankverwaltungssystem unterstützt?

- Wie läuft beim Datenbankdesign die Konvertierung eines ER-Diagramms in ein relationales Datenmodell ab?

- Welche Anwendungen gibt es von Big Data im Leben?