Heim >Technologie-Peripheriegeräte >KI >ICCV'23-Papierpreis „Fighting of Gods'! Meta Divide Everything und ControlNet wurden gemeinsam ausgewählt, und es gab einen weiteren Artikel, der die Jury überraschte

ICCV'23-Papierpreis „Fighting of Gods'! Meta Divide Everything und ControlNet wurden gemeinsam ausgewählt, und es gab einen weiteren Artikel, der die Jury überraschte

- 王林nach vorne

- 2023-10-04 20:37:011728Durchsuche

ICCV 2023, die Top-Computer-Vision-Konferenz in Paris, Frankreich, ist gerade zu Ende gegangen!

Der diesjährige Best Paper Award ist einfach ein „Kampf zwischen Göttern“.

Zu den beiden Arbeiten, die mit dem Best Paper Award ausgezeichnet wurden, gehört beispielsweise die Arbeit, die das Gebiet der vinzentinischen KI untergraben hat – ControlNet.

Seit Open Source hat ControlNet 24.000 Sterne auf GitHub erhalten. Ob für das Diffusionsmodell oder den gesamten Bereich der Computer Vision, die Auszeichnung dieser Arbeit ist wohlverdient

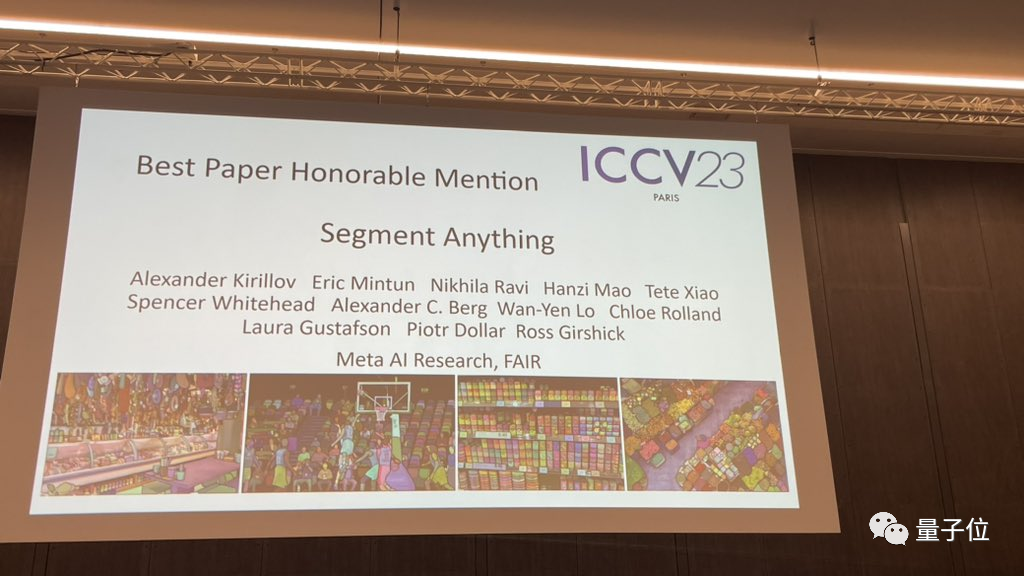

Die lobende Erwähnung für den Best Paper Award ging an eine andere ebenso berühmte Arbeit, Metas „Split Everything“ Modell SAM.

Seit seiner Einführung ist „Segment Everything“ zum „Benchmark“ für verschiedene Bildsegmentierungs-KI-Modelle geworden, darunter viele von hinten aufgekommene FastSAM, LISA und SegGPT, die es alle als Referenzbenchmark für Wirksamkeitstests verwenden.

Die Papiernominierungen sind alle so schwer, wie hart ist die Konkurrenz in diesem ICCV 2023?

ICCV 2023 hat insgesamt 8068 Arbeiten eingereicht, aber nur etwa ein Viertel, also 2160 Arbeiten, wurden angenommen

Fast 10 % der Arbeiten kamen aus China Für ICCV 2023 wurden 49 Arbeiten aus Wissenschaft und Technologie und gemeinsamen Laboratorien von SenseTime ausgewählt, und 14 Arbeiten von Megvii wurden ausgewählt.

Werfen wir einen Blick darauf, welche Arbeiten beim ICCV 2023 ausgezeichnet wurden? Bestes Paper des ICCV Auch bekannt als „Marr-Preis“ (Marr-Preis), „wird alle zwei Jahre ausgewählt“ und gilt als eine der höchsten Auszeichnungen im Bereich Computer Vision.

Diese Auszeichnung ist nach David Marr benannt, einem Pionier auf dem Gebiet der Computer Vision und Begründer der Computational Neuroscience.

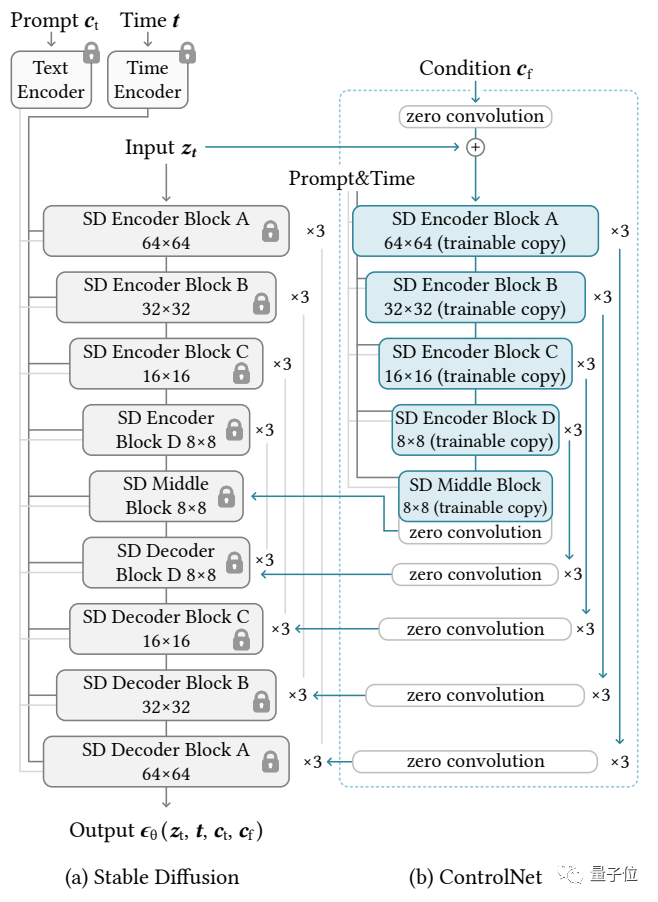

Der erste Gewinner des Best Paper Award ist „Adding Conditional Control for Text-to-Image Diffusion Models“ von Stanford

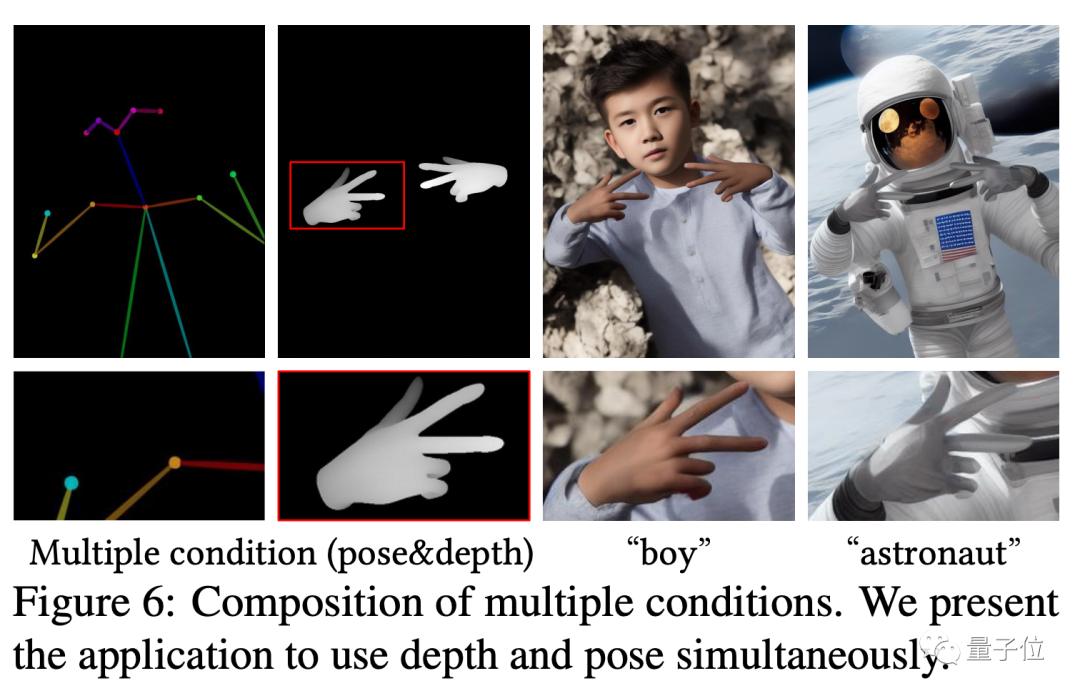

Dieses Papier schlägt ein Modell namens ControlNet vor, das die Details seiner Erzeugung steuern kann, indem es einfach eine zusätzliche Eingabe zum vorab trainierten Diffusionsmodell hinzufügt. Die Eingabe hier kann verschiedener Art sein, einschließlich Skizzen, Kantenbildern, semantischen Segmentierungsbildern, Schlüsselpunktmerkmalen des menschlichen Körpers, geraden Linien zur Hough-Transformationserkennung, Tiefenkarten, menschlichen Knochen usw. Die sogenannte „KI kann Hände zeichnen“. ", der Kern Die Technologie stammt aus diesem Artikel.

Seine Idee und Architektur sind wie folgt: Das Kontrollnetzwerk kopiert zunächst die Gewichte des Diffusionsmodells, um eine „trainierbare Kopie“ zu erhalten.

Das Kontrollnetzwerk kopiert zunächst die Gewichte des Diffusionsmodells, um eine „trainierbare Kopie“ zu erhalten.

Im Gegensatz dazu wurde das ursprüngliche Diffusionsmodell auf Milliarden von vorab trainiert images , daher sind die Parameter „gesperrt“. Und diese „trainierbare Kopie“ muss nur an einem kleinen Datensatz einer bestimmten Aufgabe trainiert werden, um die bedingte Steuerung zu erlernen. Auch wenn die Datenmenge sehr gering ist (nicht mehr als 50.000 Bilder), ist die vom Modell nach dem Training generierte bedingte Kontrolle sehr gut.

Verbunden durch eine 1×1-Faltungsschicht bilden das „gesperrte Modell“ und die „trainierbare Kopie“ eine Struktur namens „0-Faltungsschicht“. Die Gewichte und Vorspannungen dieser 0-Faltungsschicht werden auf 0 initialisiert, sodass während des Trainingsprozesses eine sehr hohe Geschwindigkeit erreicht werden kann, die nahe an der Geschwindigkeit der Feinabstimmung des Diffusionsmodells liegt, und sogar auf persönlichen Geräten trainiert werden kann

Wenn Sie beispielsweise 200.000 Bilddaten verwenden, um eine NVIDIA RTX 3090TI zu trainieren, dauert es nur weniger als eine Woche.

Zhang Lingmin ist der Erstautor des ControlNet-Artikels und derzeit Doktorand an der Stanford University. Neben ControlNet schuf er auch berühmte Werke wie Style2Paints und Fooocus

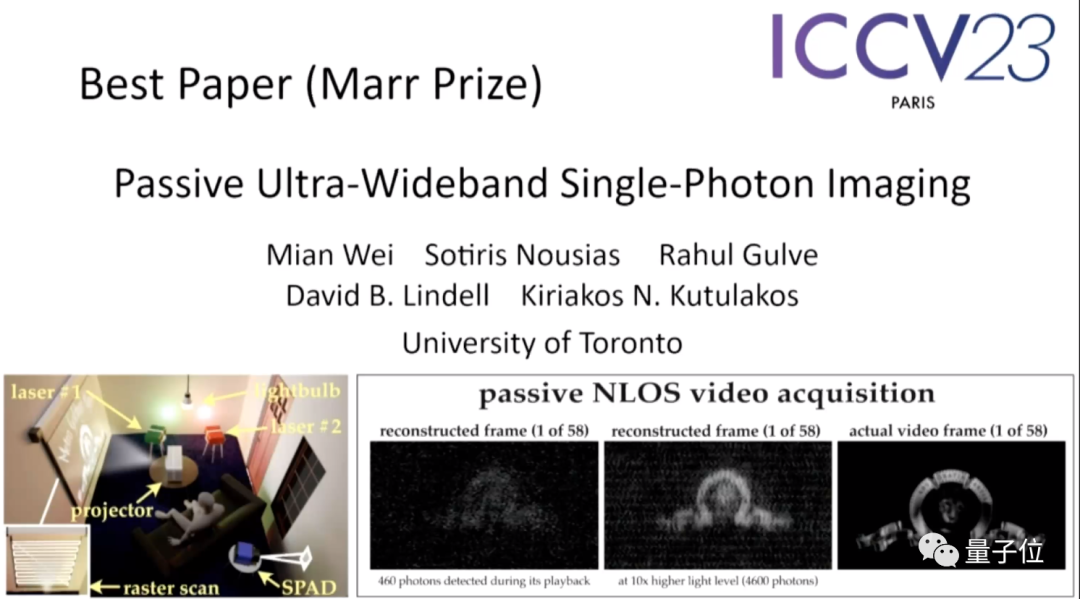

Papieradresse: https://arxiv.org/abs/2302.05543Das zweite Papier „Passive Ultra-Wideband Single-Photon lmaging“ von Universität Toronto.

Diese Arbeit wurde von der Auswahlkommission als „die überraschendste Arbeit zu diesem Thema“ bezeichnet, und zwar so sehr, dass einer der Juroren sagte: „Es war für ihn fast unmöglich, daran zu denken, so etwas auszuprobieren.“

Die Zusammenfassung des Papiers lautet wie folgt:

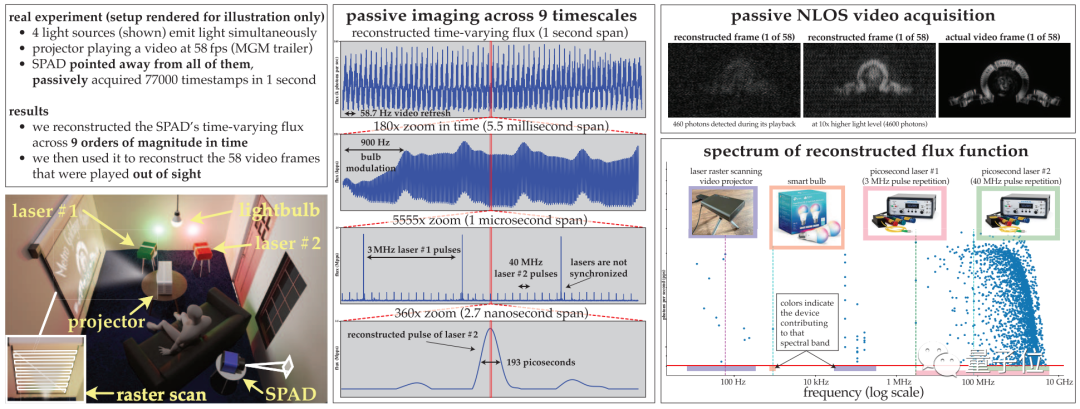

In diesem Papier wird erläutert, wie dynamische Szenen gleichzeitig in extremen Zeitskalen (von Sekunden bis Pikosekunden) abgebildet werden können, während gleichzeitig eine passive Bildgebung erforderlich ist (ohne aktiv große Mengen an Lichtsignalen zu senden) und es wird bei sehr schlechten Lichtverhältnissen durchgeführt und ist nicht auf Zeitsignale der Lichtquelle angewiesen.

Da bestehende Techniken zur Schätzung des optischen Flusses für Einzelphotonenkameras in diesem Bereich versagen, wird in diesem Artikel eine Theorie zur Detektion des optischen Flusses entwickelt, die auf der Idee der stochastischen Berechnung basiert, um von monoton steigenden Photonen-Detektionszeiten auszugehen rekonstruierte Pixel im Poke-Stream.

Basierend auf dieser Theorie führt das Papier vor allem drei Dinge durch:

(1) Zeigt, dass eine passive freilaufende Einzelphotonen-Wellenlängendetektorkamera unter Bedingungen mit geringem optischen Fluss eine erreichbare Frequenzbandbreite von DC bis 31 GHz aufweist Spektrum des Bereichs;

(2) einen neuartigen Fourier-Domänen-Algorithmus zur optischen Flussrekonstruktion zum Scannen von Zeitstempeldaten nach Frequenzen mit statistisch signifikanter Unterstützung ableiten;

(3) sicherstellen, dass das Rauschmodell des Algorithmus auch bei sehr geringen Photonenzahlen oder nicht wirksam ist; vernachlässigbare Totzeiten.

Die Autoren demonstrierten experimentell das Potenzial dieser asynchronen Bildgebungsmethode, einschließlich einiger beispielloser Fähigkeiten:

(1) Bildverarbeitung mit unterschiedlichen Geschwindigkeiten ohne Synchronisation (z. B. Glühbirnen, Projektoren, Multipulslaser) Abbildung der durch Lauflicht beleuchteten Szene Quellen gleichzeitig;

(2) Passive Non-Line-of-Sight-Videosammlung; mit einer Milliardstelsekunde wiedergegeben werden, um zu zeigen, wie sich Licht ausbreitet.

Bitte klicken Sie auf den folgenden Link, um das Papier anzusehen: https://openaccess.thecvf.com/content/ICCV2023/papers/Wei_Passive_Ultra-Wideband_Single-Photon_Imaging_ICCV_2023_paper.pdf

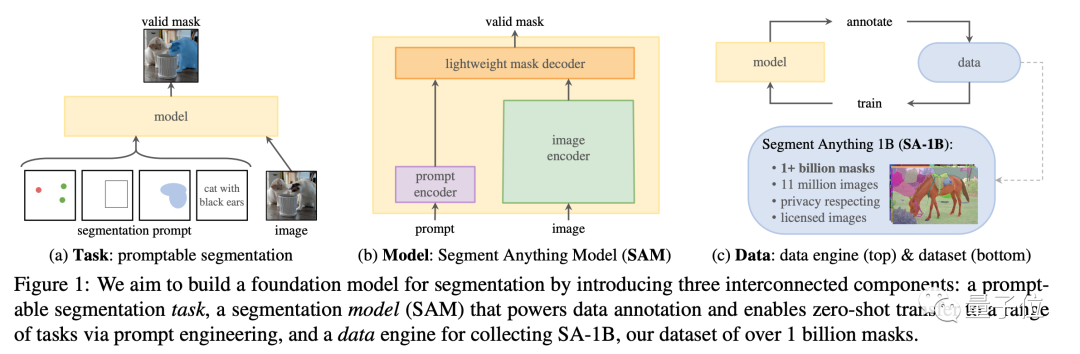

„Dividing Everything“ erhielt eine lobende Erwähnungat Auf dieser Konferenz erhielt Metas „Split Everything“-Modell neben dem mit Spannung erwarteten ControNet auch eine lobende Erwähnung für den Best Paper Award und wurde zu einem mit Spannung erwarteten Thema. Dieses Papier schlug nicht nur eines der größten aktuellen Themen vor Der Segmentierungsdatensatz enthält mehr als 1 Milliarde Masken auf 11 Millionen Bildern, und zu diesem Zweck wurde ein SAM-Modell trainiert, das unsichtbare Bilder schnell segmentieren kann.

Papieradresse: https://arxiv.org/abs/2304.02643

Projekthomepage: https://segment-anything.com/

Projekthomepage: https://segment-anything.com/

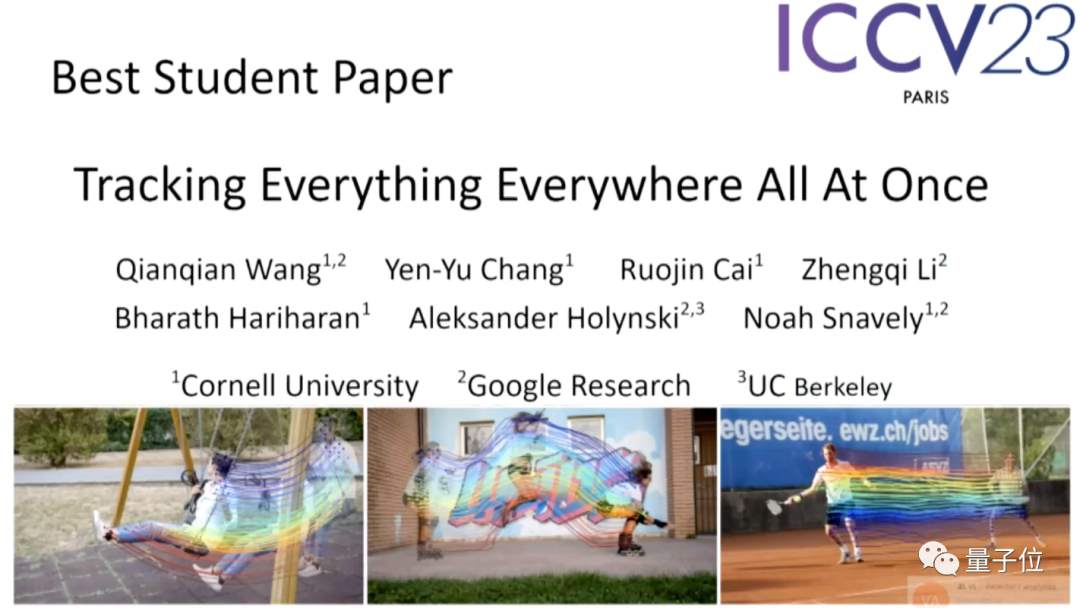

In den studentischen Arbeiten sticht das „Track Everything“-Modell von Google hervor

Genau wie der Titel des Artikels kann dieses Modell gleichzeitig Objekte in Bildern verfolgen an jedem Ort Verfolgung beliebiger (mehrerer) Objekte auf Pixelebene.

Der erste Autor dieses Projekts ist Qianqian Wang, ein chinesischer Doktorand der Cornell University, der derzeit als Postdoktorand an der UCB forscht.

Papieradresse: https://arxiv.org/abs/2306.05422

Projekthomepage: https://omnimotion.github.io/

Projekthomepage: https://omnimotion.github.io/

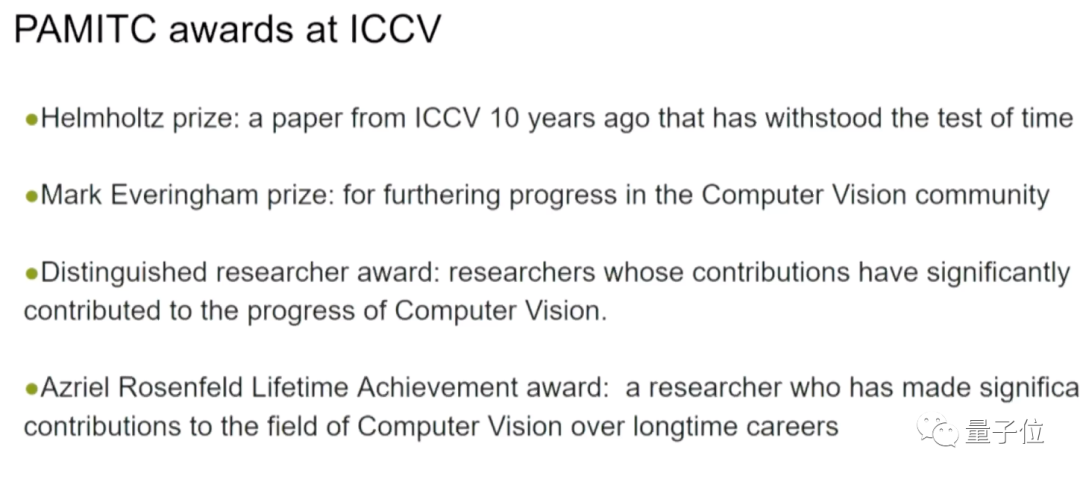

Bei der Eröffnungszeremonie wurden auch besondere Auszeichnungen bekannt gegeben, die von Mitgliedern des PAMITC-Komitees gestiftet wurden, das auch Auszeichnungen für zwei Computer-Vision-Feldkonferenzen, CVPR und WACV, spendete.

Die folgenden vier Auszeichnungen waren enthalten:

- hai Mkhize Award: ICCV-Artikel, der vor zehn Jahren großen Einfluss auf die Computer-Vision-Forschung hatte

- Everingham Award: Fortschritte auf dem Gebiet der Computer-Vision

- Herausragender Forscher: Forscher, die bedeutende Beiträge zur Weiterentwicklung der Computer-Vision geleistet haben

- Rosenfeld Lifetime Achievements Award: Forscher, die im Laufe ihrer langen Karriere bedeutende Beiträge zum Bereich Computer Vision geleistet haben

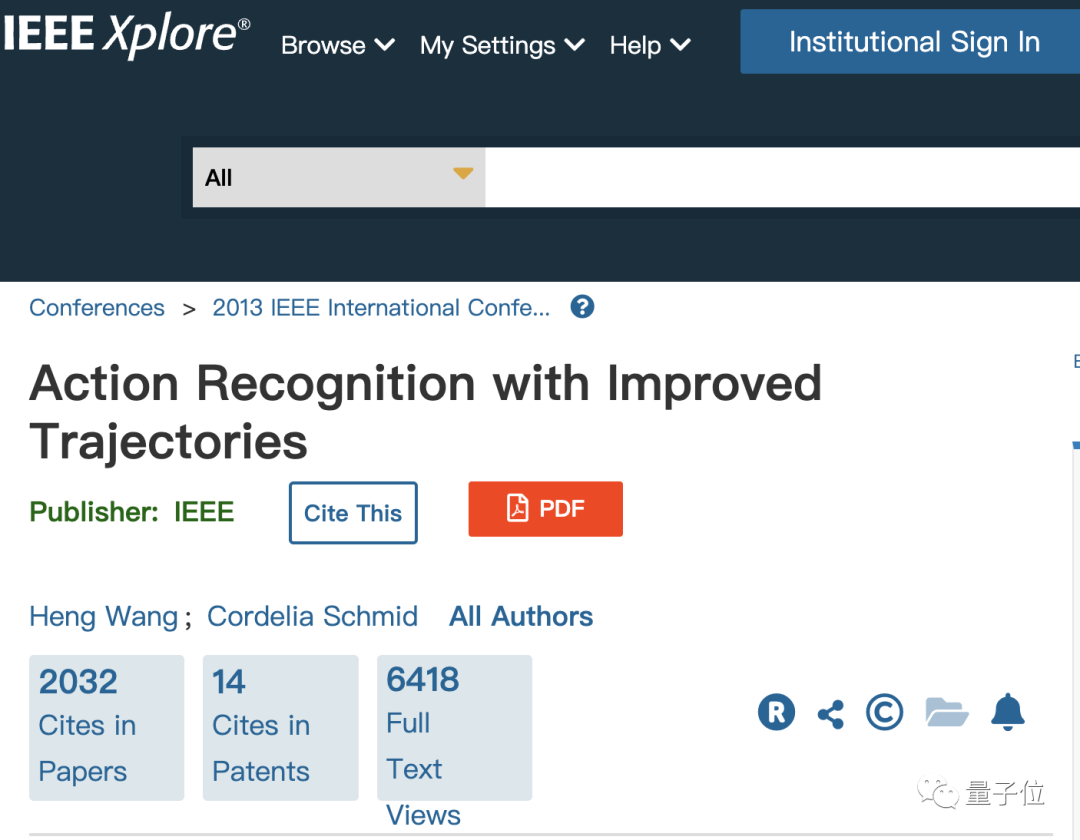

Die Wissenschaftler, die den Helmholtz-Preis gewonnen haben, sind die chinesische Wissenschaftlerin Heng Wang und Cordelia Schmid von Google, die Mitglieder von Meta AI sind

Sie haben gewonnen Auszeichnung für eine 2013 veröffentlichte Arbeit über die Anerkennung von Maßnahmen.

Zu dieser Zeit arbeiteten beide im Lear-Labor des französischen Nationalinstituts für Informatik und Automatisierung (französische Abkürzung: INRIA), und Schmid war zu dieser Zeit der Leiter des Labors.

Bitte klicken Sie auf den folgenden Link, um das Papier anzusehen: https://ieeexplore.ieee.org/document/6751553

Der Everingham-Preis wurde an zwei Teams verliehen

Der Gewinner der ersten Gruppe ist Samer von Google Agarwal, Keir Mierle und ihrem Team

Die beiden Gewinner haben ihren Abschluss an der University of Washington bzw. der University of Toronto gemacht. Ihre Leistung besteht darin, ein Open-Source-C++-Bibliotheks-Ceres-Solver-Projekt zu entwickeln, das weit verbreitet ist im Bereich Computer Vision Homepage-Link: http://ceres-solver.org/

Ein weiteres preisgekröntes Ergebnis ist der COCO-Datensatz, der eine große Anzahl von Bildern und Anmerkungen enthält und über umfangreiche Inhalte und Aufgaben verfügt. und sind wichtige Daten zum Testen von Computer-Vision-Modellen.

Ein weiteres preisgekröntes Ergebnis ist der COCO-Datensatz, der eine große Anzahl von Bildern und Anmerkungen enthält und über umfangreiche Inhalte und Aufgaben verfügt. und sind wichtige Daten zum Testen von Computer-Vision-Modellen.

Dieser Datensatz wurde von Microsoft vorgeschlagen. Der chinesische Wissenschaftler Tsung-Yi Lin hat seinen Doktortitel erworben und arbeitet jetzt als Forscher bei NVIDIA Labs.

Papieradresse: https://arxiv.org/abs/1405.0312

Projekthomepage: https://cocodataset.org/

Projekthomepage: https://cocodataset.org/

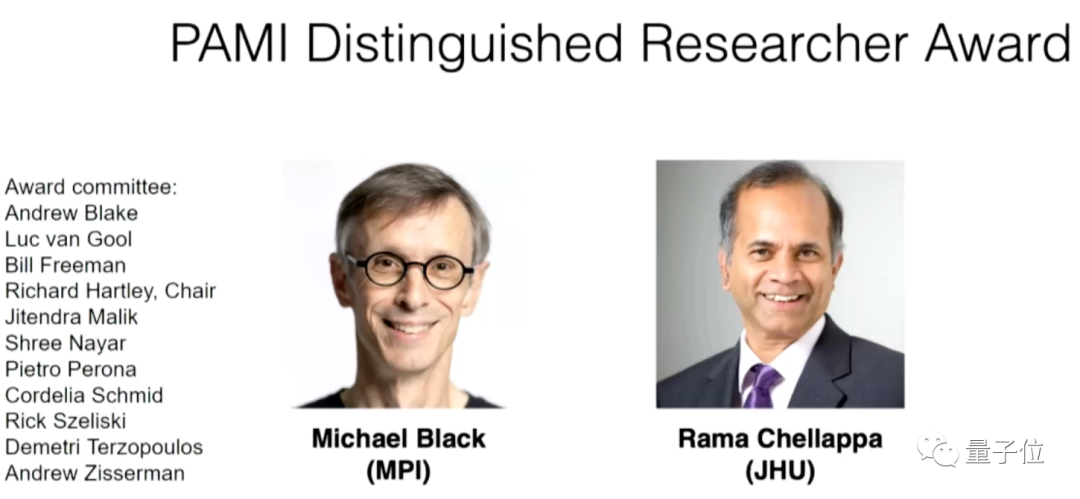

Der Gewinner der Auszeichnung „Outstanding Researcher“ ist der Deutsche Max Die Planck-Professoren Michael Black vom Institut und Rama Chellappa von der Johns Hopkins University.

Das obige ist der detaillierte Inhalt vonICCV'23-Papierpreis „Fighting of Gods'! Meta Divide Everything und ControlNet wurden gemeinsam ausgewählt, und es gab einen weiteren Artikel, der die Jury überraschte. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!