Heim >Technologie-Peripheriegeräte >KI >6. Transformers-Jubiläum: Selbst das NeurIPS Oral gab es damals noch nicht, aber 8 Autoren haben mehrere KI-Einhörner gegründet

6. Transformers-Jubiläum: Selbst das NeurIPS Oral gab es damals noch nicht, aber 8 Autoren haben mehrere KI-Einhörner gegründet

- 王林nach vorne

- 2023-06-14 13:18:011537Durchsuche

Von ChatGPT bis zur KI-Zeichentechnologie – diese jüngste Welle von Durchbrüchen im Bereich der künstlichen Intelligenz ist möglicherweise Transformer zu verdanken.

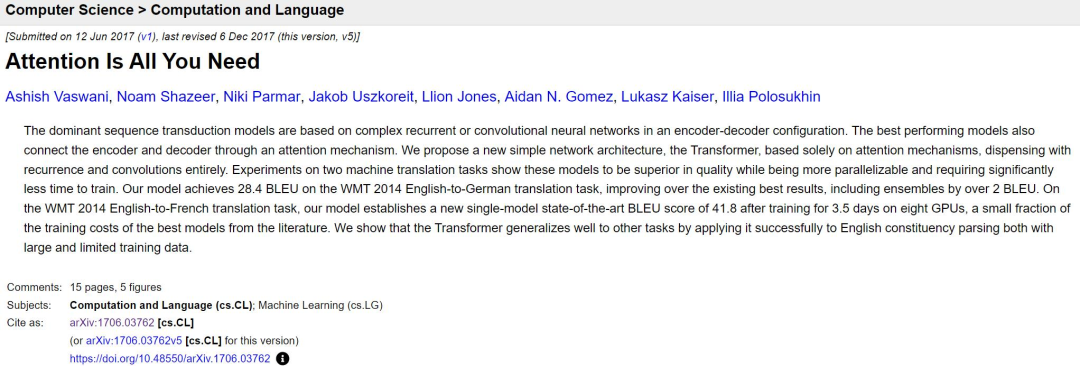

Heute ist der sechste Jahrestag der Einreichung des berühmten Transformer Papers.

Link zum Papier: https://arxiv.org/abs/1706.03762

Vor sechs Jahren wurde ein Papier mit einem etwas hochtrabenden Namen auf die Preprint-Papierplattform arXiv hochgeladen, das Der Satz „xx is All You Need“ wurde von Entwicklern im KI-Bereich immer wieder wiederholt und ist sogar zu einem Trend in Papiertiteln geworden. Transformer bedeutet nicht mehr Transformers, sondern stellt jetzt die fortschrittlichste Technologie im KI-Bereich dar . Technologie.

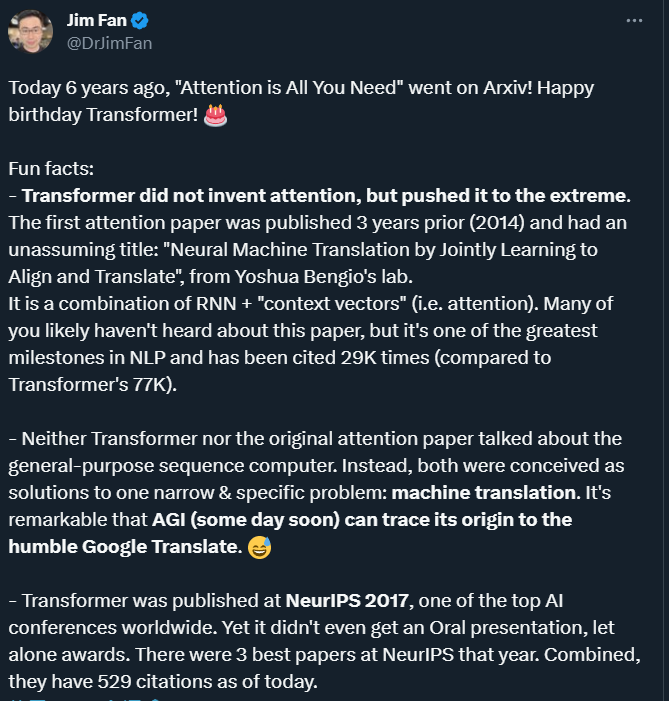

Sechs Jahre später, wenn wir auf dieses Papier zurückblicken, können wir viele interessante oder wenig bekannte Aspekte finden, wie der NVIDIA-KI-Wissenschaftler Jim Fan zusammenfasste.

„Aufmerksamkeitsmechanismus“ ist nicht das, was der Autor von Transformer vorgeschlagen hat

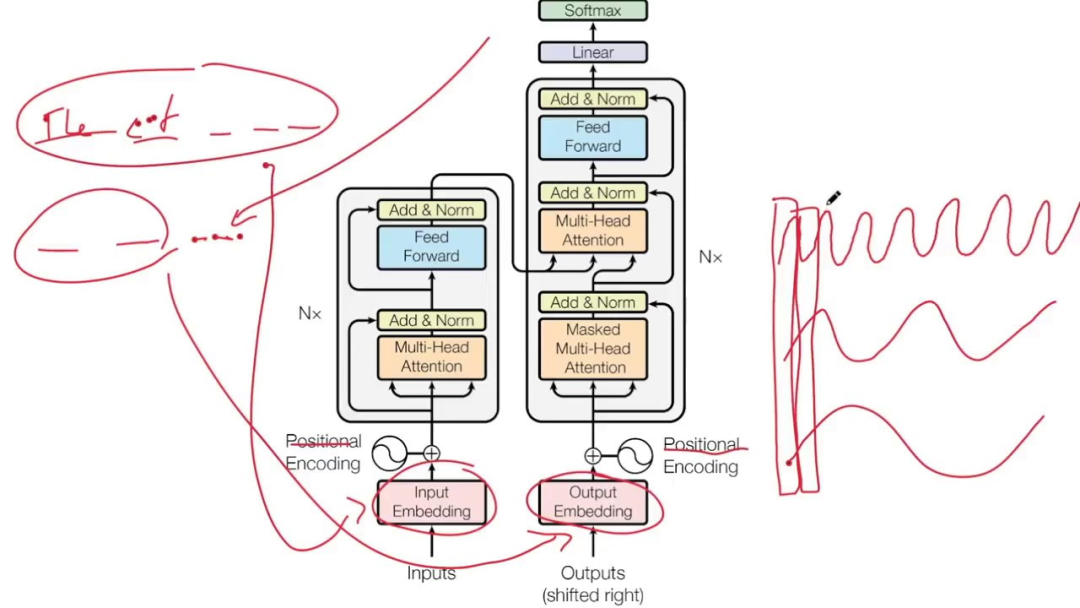

Das Transformer-Modell verzichtet auf die traditionellen CNN- und RNN-Einheiten und die gesamte Netzwerkstruktur besteht vollständig aus dem Aufmerksamkeitsmechanismus.

Obwohl der Name des Transformer-Papiers „Aufmerksamkeit ist alles, was Sie brauchen“ lautet und wir den Aufmerksamkeitsmechanismus deswegen weiterhin loben, achten Sie bitte auf eine interessante Tatsache: Es waren nicht die Forscher von Transformer, die die Aufmerksamkeit erfunden haben. aber Sie haben diesen Mechanismus auf die Spitze getrieben.

Der Aufmerksamkeitsmechanismus wurde 2014 von einem Team unter der Leitung des Deep-Learning-Pioniers Yoshua Bengio vorgeschlagen:

„Neural Machine Translation by Jointly Learning to Align and Translate“, der Titel ist relativ einfach.

In diesem ICLR-Artikel von 2015 schlugen Bengio et al. eine Kombination aus RNN + „Kontextvektor“ (d. h. Aufmerksamkeit) vor. Obwohl es einer der größten Meilensteine auf dem Gebiet des NLP ist, ist es weitaus weniger bekannt als Transformer. Der Artikel des Bengio-Teams wurde bisher 29.000 Mal zitiert, Transformer sogar 77.000 Mal.

Der Aufmerksamkeitsmechanismus von KI ist auf natürliche Weise der visuellen Aufmerksamkeit des Menschen nachempfunden. Das menschliche Gehirn verfügt über eine angeborene Fähigkeit: Wenn wir ein Bild betrachten, scannen wir das Bild zunächst schnell und fokussieren uns dann auf den Zielbereich, auf den wir fokussieren möchten.

Wenn Sie keine Teilinformationen loslassen, werden Sie unweigerlich viel nutzlose Arbeit leisten, was dem Überleben nicht förderlich ist. Ebenso kann die Einführung ähnlicher Mechanismen in Deep-Learning-Netzwerke Modelle vereinfachen und Berechnungen beschleunigen. Im Wesentlichen besteht die Aufmerksamkeit darin, aus einer großen Informationsmenge eine kleine Menge wichtiger Informationen herauszufiltern und sich auf diese wichtigen Informationen zu konzentrieren, während die meisten unwichtigen Informationen ignoriert werden.

In den letzten Jahren wurden Aufmerksamkeitsmechanismen in verschiedenen Bereichen des Deep Learning weit verbreitet eingesetzt, beispielsweise zur Erfassung rezeptiver Felder auf Bildern in Richtung Computer Vision oder zur Lokalisierung wichtiger Token oder Funktionen im NLP. Eine große Anzahl von Experimenten hat gezeigt, dass Modelle mit Aufmerksamkeitsmechanismen erhebliche Leistungsverbesserungen bei Aufgaben wie der Bildklassifizierung, -segmentierung, -verfolgung und -verbesserung sowie der Erkennung natürlicher Sprache, dem Verstehen, der Beantwortung von Fragen und der Übersetzung erzielt haben.

Das Transformer-Modell, das den Aufmerksamkeitsmechanismus einführt, kann als Allzweck-Sequenzcomputer betrachtet werden. Der Aufmerksamkeitsmechanismus ermöglicht es dem Modell, bei der Verarbeitung der Eingabesequenz unterschiedliche Aufmerksamkeitsgewichte zuzuweisen ermöglicht es dem Transformer, Abhängigkeiten und Kontextinformationen über große Entfernungen zu erfassen und so den Effekt der Sequenzverarbeitung zu verbessern.

Aber zu dieser Zeit sprachen weder Transformer noch das ursprüngliche Aufmerksamkeitspapier von universellen Sequenzcomputern. Stattdessen sehen die Autoren darin einen Mechanismus zur Lösung eines engen und spezifischen Problems – der maschinellen Übersetzung. Wenn wir also in Zukunft den Ursprung von AGI zurückverfolgen, können wir ihn möglicherweise auf das „bescheidene“ Google Translate zurückführen.

Obwohl es von NeurIPS 2017 angenommen wurde, erhielt es nicht einmal eine mündliche

Transformer Obwohl dieser Artikel mittlerweile sehr einflussreich ist, erhielt er nicht einmal eine mündliche Stellungnahme auf NeurIPS 2017, der weltweit führenden KI-Konferenz. , geschweige denn einen Preis gewinnen. Die Konferenz erhielt in diesem Jahr insgesamt 3240 Beiträge, von denen 678 als Konferenzbeiträge ausgewählt wurden. Unter diesen Beiträgen waren 40 mündliche Beiträge, 112 Spotlight-Beiträge und 3 die besten „Thesis“, ein „Test of Time“-Preis, Transformer ist für den Preis nicht berechtigt.

Obwohl ich den NeurIPS 2017 Paper Award verpasst habe, ist der Einfluss von Transformer für alle offensichtlich.

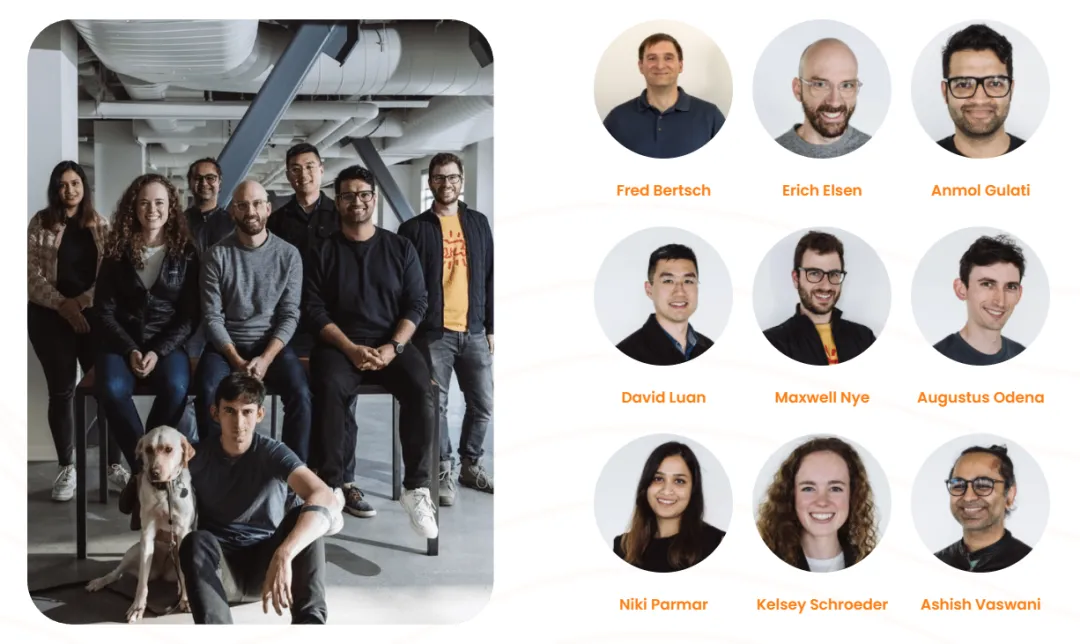

Jim Fan kommentierte: Es ist nicht die Schuld der Jury, dass es für die Menschen schwierig ist, die Bedeutung einer einflussreichen Studie zu erkennen, bevor sie einflussreich wird. Es gibt jedoch auch Artikel, die das Glück haben, sofort entdeckt zu werden. Beispielsweise gewann ResNet, vorgeschlagen von He Yuming und anderen, den besten Artikel des CVPR 2016. Diese Forschung ist wohlverdient und wurde von der führenden KI-Konferenz zu Recht anerkannt. Doch zum jetzigen Zeitpunkt im Jahr 2017 sind sehr kluge Forscher möglicherweise nicht in der Lage, die durch LLM hervorgerufenen Veränderungen vorherzusagen. Genau wie in den 1980er Jahren konnten nur wenige Menschen den Tsunami vorhersehen, der seit 2012 durch Deep Learning verursacht wurde. „Acht Autoren, jeder mit einem wundervollen Leben“ ursprüngliche Institutionen.

Am 26. April 2022 wurde ein Unternehmen namens „Adept“ offiziell gegründet. Es gibt 9 Mitbegründer, darunter Ashish Vaswani und Niki Parmar, zwei Autoren des Transformer-Papiers.? Tiefe Frühe Anwendungen des Lernens in der Sprachmodellierung. Im Jahr 2016 wechselte er zu Google Brain und leitete die Transformer-Forschung, bevor er Google im Jahr 2021 verließ.

Niki Parmar

schloss ihr Masterstudium an der University of Southern California ab und kam 2016 zu Google. Dort entwickelte sie einige erfolgreiche Q&A- und Textähnlichkeitsmodelle für die Google-Suche und -Anzeigen. Sie leitete frühe Arbeiten zur Erweiterung des Transformer-Modells auf Bereiche wie Bilderzeugung, Computer Vision und mehr. Im Jahr 2021 verließ sie auch Google.

Im März 2023 gab Adept den Abschluss einer Serie-B-Finanzierung in Höhe von 350 Millionen US-Dollar bekannt. Die Bewertung des Unternehmens überstieg 1 Milliarde US-Dollar und machte es zu einem Einhorn. Als Adept jedoch öffentlich Gelder sammelte, hatten Niki Parmar und Ashish Vaswani Adept bereits verlassen und gründeten ihr eigenes neues KI-Unternehmen. Dieses neue Unternehmen ist jedoch weiterhin vertraulich und wir können keine detaillierten Informationen über das Unternehmen erhalten. Ein weiterer Papierautor Noam Shazeer ist einer der wichtigsten frühen Mitarbeiter von Google. Ende 2000 kam er zu Google, bis er 2021 endgültig ausschied und dann CEO eines Start-ups namens „Character.AI“ wurde. Der Gründer von Character.AI ist neben Noam Shazeer Daniel De Freitas, beide aus dem LaMDA-Team von Google. Zuvor haben sie LaMDA entwickelt, ein Sprachmodell, das Konversationsprogramme bei Google unterstützt. Im März dieses Jahres gab Character.AI den Abschluss einer Finanzierung in Höhe von 150 Millionen US-Dollar mit einer Bewertung von 1 Milliarde US-Dollar bekannt. Es ist eines der wenigen Startups mit dem Potenzial, mit OpenAI, der Organisation, der ChatGPT gehört, zu konkurrieren , und es ist auch selten, nur 16 zu verwenden. Ein Unternehmen, das sich in nur wenigen Monaten zu einem Einhorn entwickelt hat. Seine Anwendung, Character.AI, ist ein Chatbot mit neuronalem Sprachmodell, der menschenähnliche Textantworten generieren und kontextbezogene Gespräche führen kann. Character.AI wurde am 23. Mai 2023 im Apple App Store und Google Play Store veröffentlicht und in der ersten Woche mehr als 1,7 Millionen Mal heruntergeladen. Im Mai 2023 fügte der Dienst ein kostenpflichtiges Abonnement für 9,99 $ pro Monat namens c.ai+ hinzu, das Benutzern unter anderem bevorzugten Chat-Zugriff, schnellere Reaktionszeiten und frühen Zugriff auf neue Funktionen ermöglicht.

Aidan N. Gomez verließ Google 2019, arbeitete dann als Forscher bei FOR.ai und ist jetzt Mitbegründer und CEO von Cohere.

Cohere ist ein generatives KI-Startup, das 2019 gegründet wurde. Zu seinem Kerngeschäft gehört die Bereitstellung von NLP-Modellen und die Unterstützung von Unternehmen bei der Verbesserung der Mensch-Computer-Interaktion. Die drei Gründer sind Ivan Zhang, Nick Frosst und Aidan Gomez, darunter Gomez und Frosst ehemalige Mitglieder des Google Brain-Teams. Im November 2021 kündigte Google Cloud eine Partnerschaft mit Cohere an, wobei Google Cloud seine robuste Infrastruktur für den Betrieb der Cohere-Plattform nutzt und Cohere die TPUs von Cloud für die Entwicklung und Bereitstellung seiner Produkte nutzt.

Es ist erwähnenswert, dass Cohere gerade eine Serie-C-Finanzierung in Höhe von 270 Millionen US-Dollar erhalten hat und sich damit zu einem Einhorn mit einer Marktkapitalisierung von 2,2 Milliarden US-Dollar entwickelt hat.

Łukasz Kaiser verließ Google im Jahr 2021, arbeitete 7 Jahre und 9 Monate bei Google und ist jetzt Forscher bei OpenAI. Während seiner Tätigkeit als Forschungswissenschaftler bei Google war er am Entwurf neuronaler SOTA-Modelle für maschinelle Übersetzung, Analyse und andere Algorithmen- und Generierungsaufgaben beteiligt. Er war Mitautor des TensorFlow-Systems und der Tensor2Tensor-Bibliothek.

Jakob Uszkoreit verließ Google im Jahr 2021 und arbeitete 13 Jahre bei Google, bevor er als Mitbegründer zu Inceptive kam. Inceptive ist ein KI-Pharmaunternehmen, das sich der Nutzung von Deep Learning zur Entwicklung von RNA-Medikamenten widmet.

Während seiner Arbeit bei Google war Jakob Uszkoreit an der Bildung des Sprachverständnisteams von Google Assistant beteiligt und arbeitete in der Anfangszeit auch an Google Translate.

Illia Polosukhin verließ Google im Jahr 2017 und ist jetzt Mitbegründerin und CTO von NEAR.AI (einem Unternehmen für Blockchain-Technologie).

Der Einzige, der noch bei Google bleibt, ist Llion Jones, dies ist sein 9. Jahr bei Google.

Jetzt sind 6 Jahre vergangen, seit der Artikel „Attention Is All You Need“ veröffentlicht wurde, und einige entschieden sich, bei Google zu bleiben Der Einfluss von Transformer hält immer noch an.

Das obige ist der detaillierte Inhalt von6. Transformers-Jubiläum: Selbst das NeurIPS Oral gab es damals noch nicht, aber 8 Autoren haben mehrere KI-Einhörner gegründet. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr