Heim >Technologie-Peripheriegeräte >KI >Wie weit muss Apple von „Hey Siri' bis zum Metaverse gehen?

Wie weit muss Apple von „Hey Siri' bis zum Metaverse gehen?

- 王林nach vorne

- 2023-06-07 08:01:471613Durchsuche

In der aktuellen Welle von Wissenschaft und Technologie zieht das Konzept des Metaversums mit seiner unendlichen Vorstellungskraft und seinen Möglichkeiten die Aufmerksamkeit der Welt auf sich wie ein schillernder neuer Stern. Das enorme Entwicklungspotenzial hat eine Welle von Unternehmen nach der anderen dazu veranlasst, einen Angriff auf das Metaverse zu starten.

Unter diesen Unternehmen ist Apple das Unternehmen mit den größten Hoffnungen. Am 6. Juni stellte Apple nach siebenjähriger Vorbereitung endlich sein Head-Mounted-Display-Gerät Vision Pro auf der WWDC 2023 offiziell vor.

Wie weit Apple im Bereich der XR-Ausrüstung gehen kann, spiegelt in gewisser Weise wider, wie weit die aktuelle technologische Grenze gehen kann. Nach der aktuellen Situation zu urteilen, sind die Produkte von Apple zwar in vielerlei Hinsicht gut, aber immer noch weit von den Erwartungen der Menschen entfernt. Anhand vieler Designs und Indikatoren können wir die aktuellen technischen Engpässe und einige Kompromisse erkennen, die Apple eingehen muss. Noch wichtiger ist, dass der Endpreis von Vision Pro bis zu 3.499 US-Dollar (ca. 24.860 RMB) beträgt. Dieser Preis bedeutet, dass dieses Produkt ein Nischenspielzeug sein muss und nicht in die Häuser normaler Menschen gelangen kann.

Aktienkurs von Apple

Aktienkurs von Apple

Wie weit sind wir also von der idealen Metaversum-Welt entfernt und welche technischen Probleme und Herausforderungen müssen noch gelöst werden? Um diese Frage zu beantworten, interviewte Dataman den CEO von Cocos, Lin Shun, den Gründer und CEO von DataMesh, Li Jie, den CEO von Youli Technology, Zhang Xuebing, den CTO des Bestsellers von Yuntian, Liang Feng, den stellvertretenden General Manager des AsiaInfo Technology R&D Center, Chen Guo, und den Chief Product Officer von Mo Universe, Lin Yu und viele andere Branchenexperten verstehen die Entwicklungstrends verschiedener Schlüsseltechnologien im Metaverse. Als Nächstes werden wir die neuesten XR-Head-Display-Produkte von Apple kombinieren, um die neuesten Entwicklungstrends und bestehenden Herausforderungen in den vier Schlüsseltechnologiebereichen Near-Eye-Display, Computing-Rendering + 5G-Privatnetzwerk, Wahrnehmungsinteraktion und Inhaltsproduktion eingehend zu untersuchen.

Augennahe Anzeige: Der technische Weg des Anzeigefeldes ist klar und der Lichtwellenleiter hat die „Tür“ noch nicht berührt

Near-Eye-Display ist die erste Tür zur Welt des Metaversums. Den von Apple dieses Mal veröffentlichten Produkten nach zu urteilen, ist sein Vision Pro mit 12 Kameras und einem Micro-OLED-Bildschirm mit 23 Millionen Pixeln für jedes Auge ausgestattet. Die zugewiesenen Pixel übertreffen die eines 4K-Fernsehers, ermöglichen die Anzeige auf einem 100-Zoll-Bildschirm und unterstützen die 3D-Videowiedergabe. Dies gilt als das derzeit höchste Niveau.

Apple Vision Pro Produktbild

Apple Vision Pro Produktbild

Was sind also die Schlüsseltechnologien für das gesamte Near-Eye-Display und wie ist der aktuelle Fortschritt der Branche? Bei der Realisierung des Metaverse ist die Near-Eye-Display-Technologie der Schlüssel zu Hardware-Durchbrüchen. Es besteht im Wesentlichen aus zwei Teilen: einem Anzeigefeld und einem optischen System (insbesondere einem Lichtwellenleiter). Bei beiden technischen Wegen gibt es noch viele technische Schwierigkeiten, die überwunden werden müssen.

1. Das Anzeigefeld bestimmt die Auflösung, Farbsättigung und Bildwiederholfrequenz, und MicroLED setzt große Hoffnungen.

Das Anzeigefeld ist ein wichtiger Bestandteil der augennahen Anzeigetechnologie, die sich direkt auf das visuelle Erlebnis des Benutzers im Metaversum auswirkt. Zu den wichtigsten technischen Indikatoren des Anzeigefelds gehören Auflösung, Farbsättigung und Bildwiederholfrequenz. Die Verbesserung dieser Indikatoren kann den Benutzern ein klareres, reichhaltigeres und flüssigeres visuelles Erlebnis bieten.

Die Auflösung ist einer der Kernindikatoren des Anzeigefelds, der direkt die Fähigkeit bestimmt, Details des Metaversums anzuzeigen. Derzeit steht die Verbesserung der Panel-Auflösung vor einem technischen Engpass. Wie die Auflösung erhöht und gleichzeitig die Panel-Größe und der Stromverbrauch sichergestellt werden können, ist ein wichtiges Problem, das in der Display-Panel-Technologie gelöst werden muss.

Die Farbsättigung ist ein weiterer wichtiger Indikator, der die Farbdarstellungsfähigkeit des Metaverses beeinflusst. Obwohl verschiedene Anzeigetechnologien derzeit gute Ergebnisse bei der Farbdarstellung erzielt haben, besteht im Metaversum noch ein gewisser Abstand zur Erzielung realer Farben.

Die Bildwiederholfrequenz beeinflusst das dynamische visuelle Erlebnis des Benutzers. Eine hohe Bildwiederholfrequenz kann für flüssigere Animationseffekte sorgen. Eine Erhöhung der Bildwiederholfrequenz erhöht jedoch den Druck auf die Rechenleistung und den Stromverbrauch. Eine weitere große technische Herausforderung besteht darin, den Stromverbrauch zu senken und gleichzeitig die Bildwiederholfrequenz zu erhöhen.

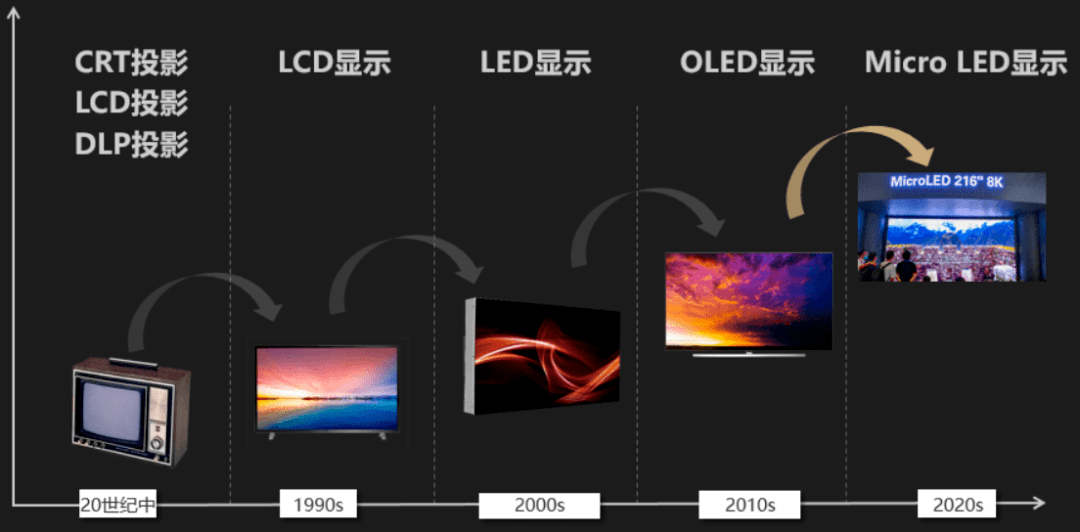

Im Bereich der Anzeigetafeln gehören zu den aktuellen Haupttechnologien Flüssigkristallanzeige (LCD), organische Leuchtdiode (OLED) und Mikro-LED (Micro-LED). Obwohl die LCD-Technologie relativ ausgereift und kostengünstig ist, weist sie im Vergleich zu anderen Technologien hinsichtlich Farbsättigung, Kontrast und Bildwiederholfrequenz Defizite auf, während bei OLED-Displays Lebensdauer- und Kostenprobleme gelöst werden müssen.

Entwicklungsprozess für Anzeigetafeln

Entwicklungsprozess für Anzeigetafeln

In den letzten Jahren hat die MicroLED-Anzeigetechnologie aufgrund ihrer hervorragenden Leistung große Aufmerksamkeit in der Branche erhalten. Es verwendet LEDs im Mikrometerbereich als Pixel, was nicht nur eine höhere Auflösung, einen größeren Farbraum und eine höhere Bildwiederholfrequenz bietet, sondern auch einen geringeren Stromverbrauch und eine längere Lebensdauer hat. Die Herstellung von MicroLED-Panels ist jedoch schwierig und kostspielig, insbesondere wenn die Pixelgröße klein und die Pixeldichte hoch ist. Wie eine Produktion in großem Maßstab mit hoher Effizienz erreicht werden kann, ist immer noch ein zentrales technisches Problem, das gelöst werden muss. Dieses Mal ist Vision Pro mit einem Micro-OLED-Bildschirm ausgestattet, aber für den Preis von fast 25.000 hat dieser Micro-OLED-Bildschirm meiner Meinung nach viel „geleistet“.

2. Der Reifegrad der Lichtwellenleitertechnologie ist geringer als der von Anzeigetafeln, und ihr technischer Weg und Durchbruchszeitpunkt sind ungewiss.

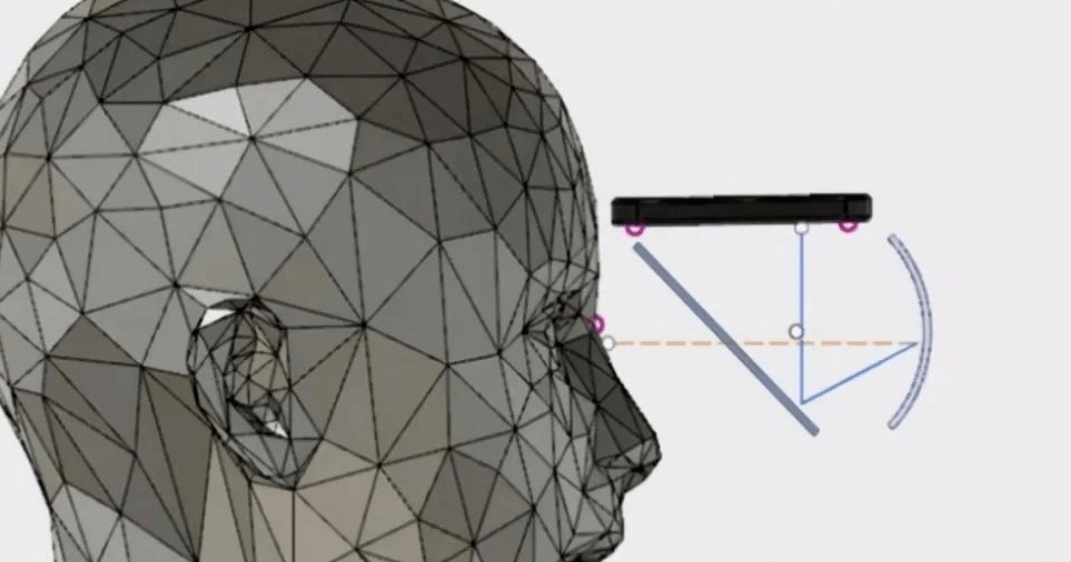

Optische Systeme, insbesondere Lichtwellenleiter, sind für die augennahe Display-Technologie gleichermaßen wichtig. Der Kern der Lichtwellenleitertechnologie besteht darin, Licht zur Netzhaut des Benutzers zu leiten und so virtuelle Bilder im Sichtfeld des Benutzers zu erzeugen. Das Sichtfeld ist ein wichtiger Indikator zur Messung der Qualität von Lichtwellenleitern, der sich auf die Sichtweite des Benutzers im Metaversum auswirkt.

In Augmented-Reality- (AR) und Virtual-Reality-Geräten (VR) sind Anzeigetafeln und Lichtwellenleiter meist eng integriert. Das Anzeigepanel erzeugt Bilder, die dann in Lichtwellenleiter eingespeist werden. Die Aufgabe des Lichtwellenleiters besteht darin, diese Bilder zu den Augen des Benutzers zu leiten und möglicherweise Anpassungen vorzunehmen, um das visuelle Erlebnis zu verbessern, z. B. das Sichtfeld zu erweitern oder den Fokus des Bildes anzupassen. Man kann sich den Vorgang einfach wie ein Kino vorstellen: Die Anzeigetafel ist wie der Projektor, der das Bild erzeugt; und der Lichtwellenleiter ist wie die Projektionsfläche, die das vom Projektor erzeugte Bild empfängt und es dem Publikum präsentiert (in In diesem Fall sind die Augen des Benutzers das Publikum.

Die optische Wellenleitertechnologie kann in verschiedene Typen unterteilt werden, darunter diffraktive optische Wellenleiter, refraktive optische Wellenleiter und holographische optische Wellenleiter. Unter diesen ist der optische Beugungswellenleiter derzeit der am häufigsten verwendete. Es streut einfallendes Licht durch Mikrogitter in mehrere Winkel und leitet diese Strahlen dann mithilfe der Totalreflexion zur Netzhaut des Benutzers. Diese Technologie kann ein breiteres Sichtfeld und eine höhere Bildqualität bieten, es gibt jedoch Probleme hinsichtlich der Lichteffizienz, Streuung und komplexen Herstellungsprozessen.

In Bezug auf die optische Effizienz besteht das Problem bei diffraktiven optischen Wellenleitern darin, dass nur ein Teil des Lichts effektiv genutzt werden kann und der größte Teil des Lichts gestreut wird, was zu einer Energieverschwendung führt. Was die Streuung betrifft, so führt Licht unterschiedlicher Farbe aufgrund des Beugungswinkels des Lichts zu einer Streuung, nachdem es das Gitter passiert hat, was sich auf die Farbgenauigkeit der Abbildung auswirkt. Dies ist zweifellos ein großes Problem für Anwendungen, die ein hohes Maß an Realismus anstreben, wie das Metaverse.

Darüber hinaus spiegelt sich die Komplexität des Herstellungsprozesses in den extrem hohen Anforderungen an die Präzision wider. Mikrogitter für diffraktive optische Wellenleiter müssen auf den Nanometerbereich genau sein, was einen extrem hohen technischen Aufwand und Kostendruck im Produktionsprozess mit sich bringt. Um diese Probleme zu überwinden, verfolgen Forscher neue optische Wellenleitertechnologien, wie etwa refraktive optische Wellenleiter und holographische optische Wellenleiter. Diese Technologien leiten Licht auf unterschiedliche Weise und bieten möglicherweise neue Lösungen zur Überwindung der Probleme diffraktiver Lichtwellenleiter. Holografische optische Wellenleiter verwenden beispielsweise holografische Bilder, um die Wellenfront des Lichts aufzuzeichnen und wiederzugeben, was Vorteile bei der Reduzierung der Streuung und der Verbesserung der optischen Effizienz bieten kann.

Allerdings bringt die neue Lichtwellenleitertechnologie auch ihre eigenen Herausforderungen mit sich. Obwohl refraktive optische Wellenleiter den diffraktiven optischen Wellenleitern hinsichtlich der optischen Effizienz überlegen sind, ist ihr Sichtfeld normalerweise kleiner, während holografische optische Wellenleiter mit dem Problem konfrontiert sind, wie eine groß angelegte, qualitativ hochwertige Herstellung holografischer Bilder erreicht werden kann.

Im Allgemeinen gibt es zwar noch Raum für Verbesserungen bei der Display-Panel-Technologie, ihre technische Roadmap ist jedoch relativ sicher und in den nächsten Jahren sind weitere Verbesserungen zu erwarten. Im Vergleich zur Display-Panel-Technologie ist die optische Wellenleitertechnologie weniger ausgereift und ihr technischer Weg und Durchbruchszeitpunkt ist noch ungewiss. Obwohl die Grundprinzipien optischer Wellenleiter verstanden wurden, ist die Entwicklung und Herstellung effizienter, qualitativ hochwertiger und kostengünstiger optischer Wellenleiter in praktischen Anwendungen immer noch eine technische Herausforderung.

Computational Rendering: Können GPU + Cloud Computing + Edge Computing + 5G den Engpass bei der Rechenleistung überwinden?

Das Metaverse erfordert den Aufbau einer immersiven virtuellen Umgebung, die nahtlos mit der realen Welt verbunden ist, und rechnergestütztes Rendering ist eine der Schlüsseltechnologien, um dieses Ziel zu erreichen. Die Aufgabe des Computational Rendering besteht darin, das dreidimensionale Modell in der virtuellen Welt und seine Materialien, Beleuchtung und andere Attribute in das zweidimensionale Bild umzuwandeln, das der Endbenutzer sieht. Dieser Prozess erfordert viele Berechnungen, einschließlich geometrischer Berechnungen, Raytracing, Beleuchtungsberechnungen, Materialrendering, Nachbearbeitung usw.

Um die Rechenleistung des Geräts zu verbessern, verwendet Apples Vision Pro ein Dual-Chip-Design, einschließlich eines M2-Chips auf Mac-Ebene und eines Echtzeit-Sensorverarbeitungschips R1. Unter ihnen ist der R1-Chip hauptsächlich für die Übertragung und Verarbeitung von Sensorsignalen verantwortlich.

Apple kann spezielle Chips für seine eigenen XR-Geräte entwickeln, aber wie viel Rechenleistung ist im Hinblick auf die gesamte Branche erforderlich, um die gewünschten Ergebnisse zu erzielen? Als nächstes werden wir dieses Thema ausführlicher besprechen.

1. Um die ideale Metaverse-Szene besser realisieren zu können, muss jedes XR-Gerät über mindestens eine NVIDIA A100-GPU verfügen.

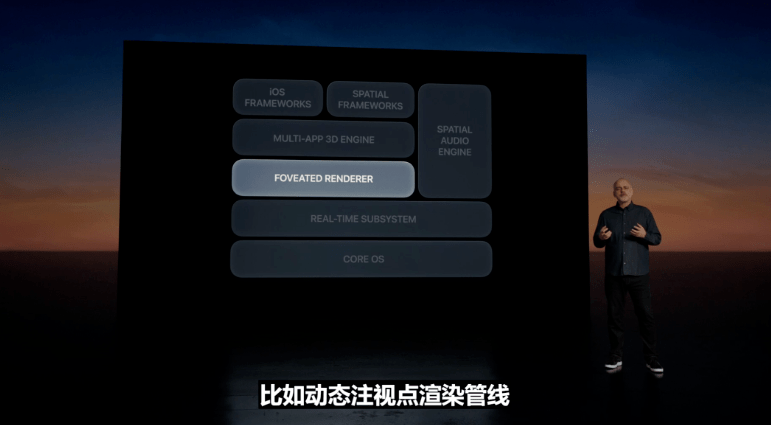

Der Idealzustand besteht darin, ein Echtzeit-Rendering mit hoher Auflösung und hoher Bildrate und vollständigem Raytracing zu erreichen, was eine extrem hohe Rechenleistung erfordert. Die spezifischen Anforderungen an die Rechenleistung hängen von vielen Faktoren ab, wie z. B. der Komplexität des Renderings, der Auflösung, der Bildrate, der Bildqualität usw. Derzeit gibt es einige Technologien, um die Anzahl der Berechnungen zu reduzieren. Die typische Technologie ist die Blickpunkt-Rendering-Technologie. Diese Technologie nutzt die visuellen Eigenschaften des menschlichen Auges, um nur eine hochpräzise Darstellung des Blickpunkts und der umliegenden Bereiche durchzuführen -Präzises Rendering in anderen Bereichen, wodurch die Komplexität der Rendering-Aufgabe effektiv reduziert wird. Das von Apple veröffentlichte Vision Pro nutzt diesmal die dynamische Foveated-Rendering-Technologie, um für jedes Bild, das die Augen des Benutzers betrachten, die maximale Bildqualität präzise zu liefern.

Apple Vision Pro Produkteinführung

Insgesamt übersteigt der Bedarf des Metaverses an rechnergestütztem Rendering die Fähigkeiten der vorhandenen Technologie bei weitem. Insbesondere auf mobilen Geräten ist es aufgrund von Problemen wie Stromverbrauch und Wärmeableitung schwieriger, Rechenleistung bereitzustellen. Die Verarbeitung von 3D-Daten erfordert nicht nur große Rechenressourcen, sondern erfordert auch Echtzeit- oder nahezu Echtzeit-Feedback. Dies stellt extrem hohe Anforderungen an Rechenleistung und Latenz. Die vorhandene Computerausrüstung, einschließlich modernster GPUs und KI-Chips, kann diese Anforderungen noch nicht vollständig erfüllen.

Um die „Lücke“ zwischen dem Angebot an Rechenleistung und der Nachfrage nach Rechenleistung im Metaverse klarer zu erklären, analysieren wir Angebot und Nachfrage an Rechenleistung anhand eines typischen Szenarios.

Angenommen, wir möchten ein vollständiges Raytracing-Rendering mit 4K-Auflösung (d. h. 3840 x 2160 Pixel), 60 Bildern/Sekunde und der Verfolgung von 100 Strahlen pro Pixel erreichen, erfordert die Verarbeitung eines Strahls etwa 500 Floats-Vorgänge (tatsächliche Daten können sein). höher sein).

Dann ist die erforderliche Rechenleistung = 3840 Pixel x 2160 Pixel x 60 Bilder/Sekunde x 100 Strahlen/Pixel x 500 Gleitkommaoperationen/Strahl = 4.976.640.000.000 Gleitkommaoperationen/Sekunde = 25 TFLOPS.

Es ist zu beachten, dass es sich hierbei um eine sehr grobe Schätzung handelt und die tatsächlich erforderliche Rechenleistung höher sein kann, da es beim Raytracing-Rendering neben Raytracing noch viele andere Berechnungsarten gibt, wie z.B. Shading, Texturabtastung, geometrische Transformation usw.

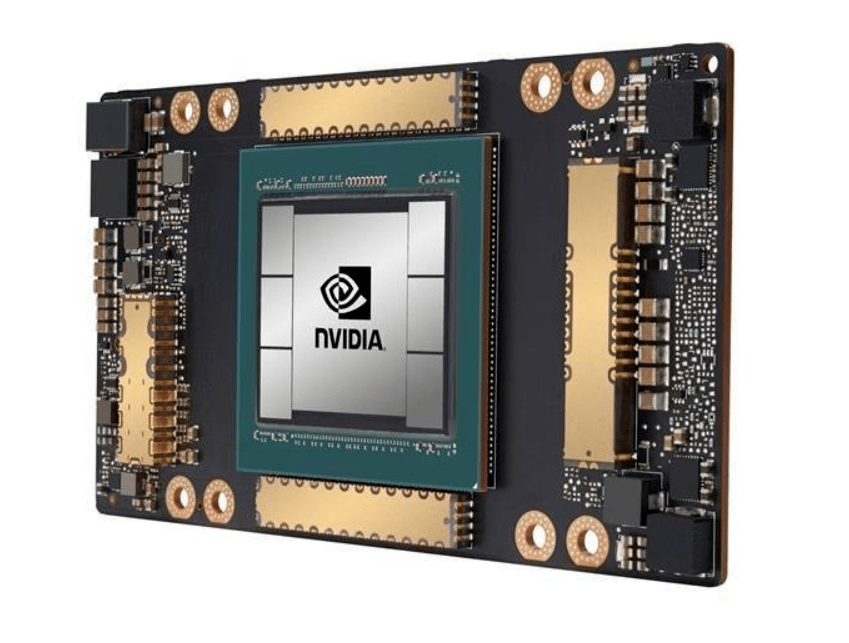

Die Spitzenrechenleistung des High-End-Chips A100 von Nvidia beträgt 19,5 TFLOPS. Der Preis des Nvidia A100 40G auf JD.com übersteigt 60.000 Yuan. Mit anderen Worten: Um einen idealen Metaverse-Szenen-Rendering-Effekt zu erzielen, benötigt ein Gerät mindestens einen A100-Chip. Allein die Kosten für einen Chip betragen mehr als 60.000 Yuan, sodass der Preis für XR-Geräte noch höher sein wird. Abgesehen von anderen technischen Einschränkungen reicht der Preis dieses Geräts aus, um die meisten Verbraucher abzuschrecken.

NVIDIA A100-Chip

NVIDIA A100-Chip

Neben der Verbesserung der allgemeinen GPU-Leistung scheint dedizierte Hardware + spezialisierte Softwareoptimierung für Raytracing eine wichtige Möglichkeit zu sein, die Rechenleistung von Metaverse-Anwendungen zu verbessern. Für Metaverse-Anwendungen ist Raytracing eine wichtige Rechenaufgabe, sodass spezielle Raytracing-Hardware entwickelt werden kann. Ein Beispiel ist die RTX-GPU-Serie von Nvidia, die über dedizierte RT-Kerne zur Beschleunigung von Raytracing-Berechnungen verfügt. Diese Art von Hardware kann einige rechenintensive Vorgänge direkt auf Hardwareebene ausführen, beispielsweise die Berechnung von Schnittpunkten zwischen Licht und Objekten in der Szene, wodurch die Recheneffizienz erheblich verbessert wird. Die Optimierung der Raytracing-Software umfasst bessere Ray-Sortierungsalgorithmen, effizientere Raumteilungsstrukturen usw.

Derzeit ist die Berechnung und Darstellung des Metaversums untrennbar mit der GPU verbunden, und es gibt zwei Hauptquellen für die GPU-Rechenleistung: eine ist die lokale GPU und die andere ist die Cloud-GPU. Lokale GPUs werden hauptsächlich für Szenen verwendet, die Echtzeit-Rendering erfordern, wie z. B. Spiele und AR/VR-Geräte. Die GPU in der Cloud kann für komplexere Rendering-Aufgaben wie Filmspezialeffekte, Architekturvisualisierung usw. verwendet werden. Die Ergebnisse des Cloud-Renderings werden über das Netzwerk an das Gerät des Benutzers übertragen.

Die ideale Computational-Rendering-Lösung sollte ein Hybrid-Rendering-System sein, das lokale und Cloud-Ressourcen integriert. Dieses System sollte in der Lage sein, intelligent zu entscheiden, ob Rendering-Aufgaben lokal oder in der Cloud ausgeführt werden sollen, und wie Aufgaben basierend auf der Art der Aufgabe, den Netzwerkbedingungen, der Geräteleistung und anderen Faktoren zugewiesen werden. Darüber hinaus sollte dieses System auch verschiedene Rendering-Technologien wie Raytracing, Echtzeitbeleuchtung, globale Beleuchtung usw. unterstützen, sodass je nach Bedarf die geeignete Rendering-Technologie ausgewählt werden kann.

Um dieses Ziel zu erreichen, ist es notwendig, eine Hochgeschwindigkeits-Datenübertragung lokal und in der Cloud (oder Edge) zu erreichen. Wie hoch ist also die Internetgeschwindigkeit, um die Anforderungen des Metaverses zu erfüllen?

2. 5G reicht kaum aus, aber der Fortschritt beim 5G-Netzaufbau ist nicht wie erwartet.

Nehmen wir als Beispiel die oben genannten typischen Metaverse-Rechenleistungsanforderungen (4K-Auflösung, 60 Bilder/Sekunde, vollständiges Raytracing-Rendering mit 100 verfolgten Strahlen pro Pixel), um zu sehen, wie viel Netzwerkbandbreite in Cloud (Edge) verwendet wird erforderlich für die +-End-Computing-Rendering-Lösung.

Wenn wir die Farbinformationen jedes Pixels auf 24 Bit vereinfachen (8 Bit Rot, 8 Bit Grün, 8 Bit Blau), um die erforderliche Netzwerkbandbreite zu berechnen:

3840 Pixel * 2160 Pixel * 24 Bits/Pixel * 60 Bilder/Sekunde = 11.943.936.000 Bits = 11,92 Gbit/s.

Die Spitzendatenrate eines 5G-Netzwerks kann theoretisch 20 Gbit/s erreichen, aber das ist die Spitzengeschwindigkeit in einer idealen Laborumgebung. Im tatsächlichen Einsatz können Benutzer in der Regel mit Geschwindigkeiten zwischen 100 Mbit/s und 3 Gbit/s rechnen, was noch einiges von den Netzwerkanforderungen des Metaverse entfernt ist. Selbst das bessere 5G-Netz ist kaum nutzbar.

Es sollte darauf hingewiesen werden, dass selbst in China, das über die meisten 5G-Basisstationen weltweit verfügt, der Aufbau des 5G-Netzes nicht sehr schnell voranschreitet. Berechnungen zufolge sind für den Aufbau eines guten 5G-Netzes mindestens 10 Millionen 5G-Basisstationen erforderlich. Ende Februar 2023 erreichte die Gesamtzahl der 5G-Basisstationen in meinem Land 2,384 Millionen, und es wird mehrere Jahre dauern, bis die 10-Millionen-Marke überschritten wird. Mit anderen Worten: Was den Netzwerkaufbau betrifft, sind wir noch nicht bereit für das Metaverse.

Offensichtlich gibt es derzeit Engpässe hinsichtlich Rechenleistung und Netzwerk. Wie kann dieser Engpass beseitigt werden? Zu diesem Zweck interviewte Dataman mehrere Branchenexperten.

In Bezug auf die Frage „Ist GPU + Cloud Computing + Edge Computing der goldene Schlüssel, um den Engpass bei der Rechenleistung des Metaversums zu beseitigen?“ glaubt Zhang Xuebing, CEO von Unitech, dass die Zusammenarbeit zwischen Cloud, Edge und Geräten nicht gut ist Methode zur Lösung des Rechenleistungsproblems: „Cloud-Rendering reduziert nur die Rendering-Probleme einer kleinen Anzahl von Endgeräten innerhalb eines bestimmten Zeitraums, indem die Rendering-Logik auf der Serverseite konzentriert wird. Der Entwicklungstrend von Endgeräten ist die Konfiguration.“ wird immer höher und die Rechenleistung wird immer stärker. Die Akkumulation von Ressourcen ist aus Kosten- und Parallelitätssicht ineffizient und verschwendet nur die Rechenleistung lokaler Geräte Lösen Sie den Engpass bei der lokalen Rendering-Fähigkeit, um mehrere Parallelitätsprobleme zu lösen, während Cloud-Rendering + Edge Computing + GPU verwendet werden, müssen jedoch viele Probleme wie Server-Parallelität, Lastausgleich, Video-Streaming-Netzwerkbandbreite, Leistungsengpässe beim Cloud-Computing usw. gelöst werden 🎜# Wenn der lokale Geräte-Rendering-Engpass durch den Rendering-Algorithmus behoben wird, gehört das gesamte Cloud-Rendering der Vergangenheit an.“

Zhang Durch das Durchbrechen des High-End-Cloud-Renderings wurden verschiedene Probleme gelöst, die mit der herkömmlichen Cloud-Rendering-Logik nicht gelöst werden können.Liang Feng, Yuntians meistverkaufter CTO, glaubt, dass im 5G-Zeitalter neue Anwendungsszenarien mit Echtzeitinteraktion und schneller Reaktion wie Cloud-Spiele und Metaverse einen exponentiellen Anstieg der Nachfrage nach Rechenleistung verzeichnet haben, insbesondere die beschleunigte Die Integration von KI und Metaverse und die schrittweise Verlagerung der Rechenleistung von To B nach C haben enormen Raum für die Entwicklung der Rechenleistung geschaffen, wenn wir wirklich groß angelegte kommerzielle Anwendungen realisieren und Benutzern eine geringe Latenz bieten wollen Immersive Erfahrung, die aktuelle Rechenleistung muss Li Yuan bei weitem nicht zufriedenstellen. Mit seinen einzigartigen und leistungsstarken parallelen Rechenfunktionen ist die GPU nach und nach zu einer wichtigen Richtung für die Erforschung und Unterstützung der Rechenleistungsbasis neuer Anwendungsszenarien geworden und Edge Computing bietet neue Ideen für die groß angelegte Kommerzialisierung neuer Anwendungen sowie die Integration von Cloud und Netzwerk, um ein Rechenleistungsnetzwerk mit vollständiger Abdeckung zu schaffen.

Chen Guo, stellvertretender Generaldirektor des AsiaInfo Technology R&D Center, vertritt die gleiche Ansicht: „Wenn wir den idealen Zustand des Metaversums erreichen wollen, reichen die vorhandenen Rechenleistungsressourcen bei weitem nicht aus – das ultimative Visual.“ Rendering, Echtzeit-Virtual-Reality-Interaktion und genaues intelligentes Denken stellen extrem hohe Anforderungen an die Rechenressourcen. Die zukünftige „Cloud-Edge“-Multi-Computing-Leistung wird den Rechenleistungsanforderungen des Metaversums besser gerecht Andere verwandte Technologien werden auch den Bedarf an Rechenleistung im Metaverse beseitigen. Der Schlüssel zum Leistungsengpass: Die GPU-Rechenleistung beschleunigt das Rendern von Grafiken, bietet physische Simulationsfunktionen und fördert die XR-Technologie, um das von der Metaverse-Technologie geforderte immersive Erlebnis zu erfüllen Bietet hohe Effizienz, hohe Präzision und kostengünstige Technologie zum Erstellen von Metaverse-Szenen, um die schnelle Modellierung von „Personen, Orten und Gütern“ im Metaverse zu fördern. Die Entwicklung der WebGPU-Technologie ermöglicht hochauflösende, echte interaktive 3D-Anwendungen , was die Grafikleistung des Browsers erheblich verbessern und künftige Leistungsengpässe der Metaverse-Anwendung im Frontend überflüssig machen wird.“

Wahrnehmungsinteraktion: Interne Erfassung ist die natürlichste Art der Interaktion im Metaversum

Wahrnehmungsinteraktion ist eine weitere große Herausforderung beim Aufbau des Metaversums. Um ein wirklich immersives Erlebnis zu schaffen, muss sichergestellt werden, dass Benutzer auf natürliche und intuitive Weise mit dem Metaversum interagieren können, was die Abdeckung mehrerer Sinnesdimensionen wie Sehen, Hören und Fühlen erfordert.

Dem Vision Pro-Produkt von Apple nach zu urteilen, nutzt es die Integration der Hand-Auge-Sprachinteraktion + der vielfältigen Interaktionsmethoden von Eyesight. Erwähnenswert ist, dass Vision Pro nicht mit einem Griff ausgestattet ist, was sich stark von früheren XR-Produkten unterscheidet.

Apple Vision Pro Produktdemonstrationsbild Vision Pro funktioniert über Sprache, Eye-Tracking und Gesten. Benutzer können Anwendungssymbole durchsuchen, indem sie sie ansehen, mit den Händen auswählen, wischen, um zu scrollen, oder Sprachbefehle eingeben, um Text einzugeben .

Vision Pro funktioniert über Sprache, Eye-Tracking und Gesten. Benutzer können Anwendungssymbole durchsuchen, indem sie sie ansehen, mit den Händen auswählen, wischen, um zu scrollen, oder Sprachbefehle eingeben, um Text einzugeben .

Apple Vision Pro Produktdemonstrationsbild

Apple Vision Pro Produktdemonstrationsbild

Es sollte darauf hingewiesen werden, dass Vision Pro immer noch ein „Zukunftsprodukt“ ist und erst Anfang nächsten Jahres offiziell veröffentlicht wird. Welche Funktionen im Demonstrationsvideo implementiert werden können und wie effektiv sie sind, muss daher warten, bis das Produkt offiziell auf den Markt kommt und Benutzer nach dem Erleben eine echte Vorstellung davon haben können.

Bezüglich der Wahrnehmungsinteraktion hat Apple nicht viele technische Details preisgegeben. Als nächstes analysieren wir die wichtigsten technischen Aspekte der Wahrnehmungsinteraktion aus Branchenperspektive. Im Allgemeinen können die Wahrnehmungsinteraktionsmethoden von XR-Geräten in visuelle Interaktion, auditive Interaktion, taktile Interaktion und Gesteninteraktion unterteilt werden.

Visuelle Interaktion basiert hauptsächlich auf Technologien der virtuellen Realität (VR) und der erweiterten Realität (AR). Es gibt bereits ausgereifte VR- und AR-Geräte, die es Nutzern ermöglichen, sich im Metaversum aus der Ego-Perspektive zu bewegen und zu beobachten. Allerdings erfordern diese Geräte häufig das Tragen von Helmen, was den Benutzerkomfort und die langfristige Nutzung beeinträchtigt. Darüber hinaus ist es eine wichtige technische Herausforderung, eine ausreichende visuelle Auflösung und ein ausreichendes Sichtfeld bereitzustellen, damit sich Benutzer so natürlich und real wie in der realen Welt fühlen.

Die auditive Interaktion basiert auf 3D-Audiotechnologie, einschließlich räumlichem Audio und Objektaudio. Diese Technologien erzeugen ein Klangfeld mit Tiefe und Richtung, sodass Benutzer die Quelle und Entfernung von Geräuschen genau bestimmen können. Allerdings ist es mit der aktuellen 3D-Audiotechnologie immer noch schwierig, ein völlig natürliches Hörerlebnis zu bieten, insbesondere bei der Simulation komplexer Klangumgebungen und klangphysikalischer Effekte.

Die taktile Interaktion ist eine der größten Herausforderungen. Obwohl es verschiedene taktile Rückmeldungsgeräte gibt, wie zum Beispiel vibrierende Griffe und haptische Anzüge, können die Rückmeldungsstärke und -genauigkeit dieser Geräte dem realen taktilen Erlebnis nicht gerecht werden. Fortschrittlichere Technologien wie elektrische Stimulation und taktiles Ultraschall-Feedback befinden sich in der Entwicklung, sind aber noch nicht ausgereift.

Im Vergleich zu den oben genannten Methoden gilt die Gesteninteraktion als intuitive und natürliche Art der Interaktion als ideales Mittel zur Interaktion im Metaversum.

Bei der Gesteninteraktion gibt es zwei zentrale Zusammenhänge: Erfassung und Analyse. Unter Erfassung versteht man das Sammeln von Bewegungsinformationen der Hand des Benutzers durch verschiedene Technologien, während die Analyse diese Informationen verarbeitet, um bestimmte Gesten und Bewegungen zu identifizieren.

Die Erfassungstechnologie wird hauptsächlich in externe Erfassung und interne Erfassung unterteilt. Bei der externen Erfassung werden häufig Kameras oder Sensoren eingesetzt, um die Position und Bewegung der Hand aufzuzeichnen, wie dies bei Kinect und Leap Motion von Microsoft der Fall ist. Bei der internen Erfassung kommen tragbare Geräte zum Einsatz, die in der Regel mit einer Reihe von Sensoren wie Beschleunigungsmessern, Gyroskopen, Magnetometern usw. ausgestattet sind, die die Verschiebung, Drehung und Beschleunigung der Hand in drei Raumdimensionen erfassen können.

Man kann sagen, dass die interne Erfassung die idealste Art der Interaktion ist. Interne Erfassung Da der Sensor in direktem Kontakt mit der Hand steht, können Handbewegungsinformationen unabhängig von der Umgebung oder den Lichtverhältnissen des Benutzers stabil und genau erfasst werden. Darüber hinaus sind interne Erfassungsgeräte in der Regel klein und leicht zu tragen, sodass Benutzer jederzeit und überall mit Gesten interagieren können. Die größten technischen Schwierigkeiten bei der internen Erfassung sind die Sensorgenauigkeit und komplexe Gestenerkennungsfunktionen. Die Bewegung der Hand ist sehr komplex, um sie in Echtzeit präzise zu erfassen und in virtuelle Bewegungen umzuwandeln. Es werden hohe Anforderungen an die Genauigkeit und Verarbeitungsgeschwindigkeit des Sensors gestellt. Derzeit ist die interne Erfassung zwar gut geeignet, grundlegende Handbewegungen zu erfassen, komplexere Gesten, wie z. B. winzige Fingerbewegungen, lassen sich jedoch möglicherweise nur schwer genau identifizieren. Wenn das Problem der hochpräzisen Erkennung komplexer Gesten gelöst werden kann, wird die interne Erfassung die idealste Interaktionsmethode im Metaverse sein.

In Bezug auf die Analysetechnologie setzt es hauptsächlich auf Computer Vision und maschinelle Lernalgorithmen. Mithilfe von Computer Vision werden von Aufnahmegeräten aufgenommene Bilder oder Videos verarbeitet, um wichtige Punkte und Konturen der Hand zu extrahieren. Um diese Daten zu analysieren und bestimmte Gesten zu identifizieren, werden maschinelle Lernalgorithmen, insbesondere Deep-Learning-Algorithmen, eingesetzt. In Bezug auf die Parsing-Technologie basieren aktuelle Algorithmen hauptsächlich auf Deep Learning, was für das Training eine große Menge annotierter Daten erfordert. Aufgrund der Komplexität und Vielfalt der Hände ist es jedoch sehr schwierig, diese Daten zu erhalten und zu kennzeichnen.

Neben dem Erfassen und Parsen muss noch ein weiteres Problem gelöst werden: die Interaktion mit virtuellen Objekten, wie Benutzern das Greifen, Bewegen und Manipulieren von Objekten durch Gesten in der virtuellen Umgebung ermöglicht wird und wie Benutzern Folgendes zur Verfügung gestellt werden kann Taktiles Feedback ist ein Problem, das gelöst werden muss. Eine mögliche Methode besteht darin, ein virtuelles Handmodell zu verwenden, um die Gesten des Benutzers in Bewegungen der virtuellen Hand umzuwandeln und dann die virtuelle Hand virtuelle Objekte bedienen zu lassen. Gleichzeitig müssen effektivere taktile Feedback-Technologien wie elektrische Stimulation und Ultraschall untersucht werden, um Benutzern taktiles Feedback zu geben.

Es lässt sich feststellen, dass es im Hinblick auf die Wahrnehmungsinteraktion noch eine Reihe technischer Probleme gibt, die gelöst werden müssen.

Content-Produktion: ChatGPT und AIGC werden zum Schlüssel zum Aufbau intelligenter NPCs

Apple ist ein Meister darin, ein Content-Ökosystem zu schaffen. Auf dieser Vision Pro-Konferenz kündigte Apple auch einige Fortschritte bei der Content-Erstellung an. Complete HeartX erstellt beispielsweise ein interaktives 3D-Herz; JigSpace ermöglicht es Designern, ihre Designentwürfe für den F1-Rennsport visuell zu überprüfen.

Bild zur Produkteinführung von Vision Pro

Bild zur Produkteinführung von Vision Pro

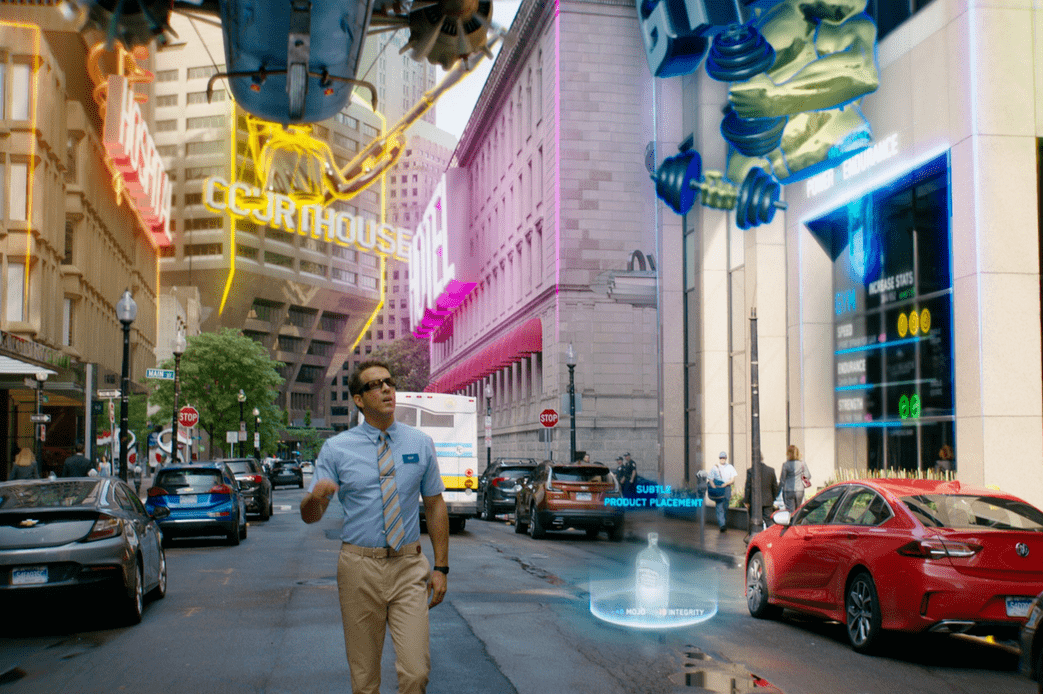

Es sollte darauf hingewiesen werden, dass einige der von Apple demonstrierten Möglichkeiten zur Content-Produktion noch weit von unserem idealen Content-Metaversum entfernt sind. Was wir wollen, ist ein Metaversum wie „Ready Player One“ oder „Runaway Player“, nicht nur schöne 3D-„Ausstellungen“. Um dieses Ziel zu erreichen, müssen wir die tiefe Logik der Metaversum-Inhaltsproduktion erforschen.

Im Metaversum bilden die Umgebung, virtuelle Darstellungen von Menschen und Nicht-Spieler-Charaktere (NPC) den Kerninhalt dieser virtuellen Welt. Diese drei bilden zusammen die Weltanschauung und die Handlung des Metaversums. Die Umgebung stellt den physischen und kulturellen Kontext für die virtuelle Welt bereit und definiert die Regeln und den Betrieb der virtuellen Welt. Es ist die Grundlage der virtuellen Welt und bildet die räumliche Dimension des Metaversums. Der virtuelle Repräsentant oder Spielercharakter einer Person ist die Identität und der Akteur des Benutzers in der virtuellen Welt. Es handelt sich um ein Werkzeug für Benutzer zur Teilnahme und zum Erleben der virtuellen Welt, das die Wünsche und Verhaltensweisen des Benutzers widerspiegelt.

Im Idealfall können NPCs vielfältige Charaktere und Handlungsstränge für die virtuelle Welt bereitstellen und so den Inhalt und das Erlebnis der virtuellen Welt bereichern. Sie sind Aktivitätstreiber in der virtuellen Welt und können Benutzern helfen, besser an der virtuellen Welt teilzunehmen und sie zu verstehen. Die Plastizität und Kreativität von NPCs machen die Handlung des Metaversums endlos möglich. Durch die Interaktion mit NPCs können Benutzer eine Vielzahl von Geschichten und Abenteuern im Metaversum erleben. Virtuelle Vertreter von Menschen im Metaversum können durch Interaktion mit NPCs besondere „Privilegien“ oder Fähigkeiten erlangen. Dieses „Privileg“ kann Benutzern helfen, ihre Ziele in der virtuellen Welt zu erreichen und ihre Identität und ihren Status in der virtuellen Welt zu stärken. Daher ist NPC nicht nur der Story-Treiber des Metaversums, sondern auch ein wichtiger Faktor für Benutzer, um in der virtuellen Welt Erfolg und Zufriedenheit zu erzielen.

Um die oben genannten Ziele zu erreichen, müssen NPCs jedoch über ein hohes Maß an Intelligenz verfügen, was weit außerhalb der Reichweite von NPCs im aktuellen Metaversum liegt. Aktuelle NPCs verlassen sich meist auf voreingestellte Dialoge und Verhaltensweisen, was dazu führen kann, dass sie starr wirken und es ihnen an Realismus und Personalisierung mangelt, wenn sie auf Spieleraktionen reagieren. Gleichzeitig haben NPCs auch Einschränkungen bei der Weiterentwicklung von Handlungssträngen und der Durchführung laufender Interaktionen.

In diesem Zusammenhang sind das Potenzial und die Vorteile des Einsatzes von KI-Technologie, insbesondere AIGC und ChatGPT, zur Optimierung der Metaverse-Inhaltsproduktion und zum Aufbau intelligenter NPCs besonders hervorzuheben.

Cocos-CEO Lin Shun glaubt, dass die Kombination von AIGC und Metaverse die Effizienz und Kreativität der Content-Generierung erheblich verbessern kann. AIGC kann schwere und sich wiederholende Arbeiten bei der Erstellung von Inhalten übernehmen, wodurch Entwickler Zeit und Energie sparen und gleichzeitig vielfältigere und reichhaltigere Spielinhalte bereitstellen. Mit der Technologie von AIGC können Welten und Szenen automatisch generiert werden, was den Inhaltserstellungsprozess des Metaverse beschleunigt, die Welt des Metaverse bunter macht und den Bedürfnissen verschiedener Formen gerecht wird. Zum Beispiel: Automatisches Generieren von Aufgaben und Handlungen, um den Inhalt im Metaversum lebendiger und interessanter zu machen; AIGC kann Entwicklern dabei helfen, verschiedene personalisierte NPC- und Charakterbilder zu erstellen und so die Charaktere im Metaversum vielfältiger und interessanter zu gestalten. Einzigartig; generiert automatisch Soundeffekte und Musik, realistische Soundeffekte und dynamische Musik, wodurch die Metaverse-Szene immersiver und eindringlicher wird.

Lin Shun glaubt auch, dass KI realistischere und intelligentere Interaktionen für NPCs im Metaversum ermöglichen kann. NPCs mit „Seelen“ können eine dynamische Welt im Metaversum bilden und entsprechend reagieren, wodurch die Spielwelt entsteht realistischer und lebendiger und fördert die Entwicklung der Welt. Sie können die Anweisungen und Emotionen der Spieler durch natürliche Sprachverarbeitung und Emotionserkennungstechnologie verstehen und entsprechend reagieren und so ein personalisierteres und reichhaltigeres Spielerlebnis bieten. KI verleiht NPCs eine realistischere „Seele“ oder Persönlichkeit. Durch emotionale Modellierung und kognitive Modelle kann KI NPCs komplexe emotionale Zustände, Persönlichkeitsmerkmale und Verhaltensmuster zeigen lassen und so die emotionale Verbindung und Interaktion zwischen Spielern und NPCs verbessern.

Lin Yu, Chief Product Officer von Mo Universe, äußerte eine ähnliche Ansicht. Er glaubt, dass „AIGC beispielsweise die Produktionseffizienz des Metaversums in den drei Kernelementen „Personen, Objekte und Szenen“ erheblich verbessern wird Im Hinblick auf die digitale Modellierung menschlicher Bilder wird die Designeffizienz verbessert; im Hinblick auf den Aufbau digitaler menschlicher Gehirnintelligenz kann die Intelligenz von 2D- und 3D-Bildern und Videoinhalten erheblich verbessert werden Effizienz von Objekten und Szenen. AIGC kann NPCs ein Gehirn oder eine „Seele“ verleihen und das Intelligenzniveau von NPCs erheblich verbessern, z. B. intelligente Fragen und Antworten zwischen NPCs und Benutzern, nicht nur Textfragen und -antworten, sondern auch Sprachfragen und Antworten sowie Multi-Mode-Fragen und -Antworten wie Bilder und Videos ”

.Schließlich erwähnte der Gründer und CEO von DataMesh, Li Jie, dass es im Bereich der Unternehmensmetaverse immer noch ein „Henne-Ei-Problem“ gibt, das gelöst werden muss – qualitativ hochwertige Inhalte können Benutzer anziehen, aber nicht genug Benutzer können diese hochwertigen Inhalte nicht produzieren und pflegen. Dies ist ein klassisches Netzwerkeffektproblem.

Li Jie glaubt, dass im Rahmen des TEMS-Modells (Training, Experience, Monitoring and Simulation) des Unternehmensmetavers ein möglicher Weg zur Lösung dieses Problems darin besteht, zunächst die beiden Aspekte Simulation (Simulation) und Training (Training) zu nutzen treiben die Inhaltsgenerierung des Metaversums voran. In der Anfangszeit können Unternehmen interne Mitarbeiter schulen und weiterbilden, indem sie spezifische Simulationsszenarien erstellen, die nicht nur die Fähigkeiten der Mitarbeiter verbessern, sondern auch frühe aktive Benutzer und Inhalte für das Metaverse bereitstellen können.

Mit der Zeit, wenn sich die Mitarbeiter allmählich an diese neue Arbeitsweise gewöhnen und sich auf sie verlassen, wird die Benutzerbasis des Unternehmens-Metaversums wachsen, und diese Benutzer werden auch eine große Menge interaktiver Daten im Metaversum generieren. Diese Daten können gesammelt und analysiert werden, um die Erlebnis- und Überwachungs- und Kontrollfunktionen des Metaversums weiter zu optimieren und so einen positiven Kreislauf zu bilden.

Wenn es um die Killeranwendung des Metaverse geht, glaubt Li Jie, dass die Killeranwendung eine Lösung sein könnte, die die vier Aspekte von TEMS perfekt integriert. Beispielsweise kann eine Anwendung, die komplexe Geschäftsprozesse in Echtzeit simulieren, umfangreiche und individuelle Schulungsinhalte bereitstellen, über effiziente Überwachungs- und Steuerungsfunktionen verfügen und ein nahtloses und umfassendes Benutzererlebnis bieten kann, der Killer der Metaverse-Anwendung sein. Solche Anwendungen können nicht nur die Produktionseffizienz des Unternehmens und die Arbeitszufriedenheit der Mitarbeiter erheblich verbessern, sondern auch die kontinuierliche Innovation und Entwicklung des Unternehmens fördern.

Oben haben wir einige technische Kernbereiche und Herausforderungen von XR und dem Metaverse analysiert. Abschließend hoffe ich, dass Unternehmen wie Apple weiterhin technische Engpässe überwinden und den Preis so schnell wie möglich senken können (der Preis von mehr als 20.000 liegt tatsächlich nicht in der Nähe der Menschen), damit das bunte Metaversum wie „Ready Player One“ entsteht. kann so schnell wie möglich eintreffen.

Aber ehrlich gesagt bin ich dieses Mal nicht optimistisch, was das von Apple veröffentlichte XR-Headset angeht. Apple ist ein großartiges Unternehmen und auch seine Produktkompetenz im Bereich der Unterhaltungselektronik ist weltweit einzigartig. Es gibt jedoch immer noch einige erhebliche technische Engpässe in der XR-Ausrüstungs- und Metaverse-Branche. Die Überwindung dieser Engpässe erfordert die Anstrengungen der gesamten Branche und erfordert Zeit. Es ist unwahrscheinlich, dass ein einzelnes Unternehmen sie überwinden kann. Als Apple das iPhone herausbrachte, war es nicht allein die Schuld von Apple, die die Menschheit in das Zeitalter des mobilen Internets führte. Tatsächlich war die Menschheit zu diesem Zeitpunkt bereits mit einem Fuß in das Zeitalter des mobilen Internets eingetreten, aber die Produkte von Apple waren die besten und sie ernteten die größten Früchte. Stellen Sie sich vor, wenn unser Netzwerk immer noch bei 2G oder sogar 1G feststeckt, wird das iPhone dann noch nützlich sein? Apple ist großartig, aber egal wie großartig ein Unternehmen ist, es ist unmöglich, über die Zeit hinauszugehen.

Aus rationaler Sicht gibt es immer noch erhebliche Herausforderungen bei jedem der oben genannten augennahen Displays, rechnergestützten Renderings, wahrnehmungsbezogenen Interaktionen und der Inhaltsproduktion. Auch wenn es so leistungsstark ist wie Apple, hat es unter den bestehenden Branchenbedingungen nur das beste Produkt hervorgebracht, ist aber dennoch weit von unserem Ideal des Metaversums entfernt. Es ist absehbar, dass eine große Anzahl von Benutzern, wenn sie Vision Pro tatsächlich erleben, höchstwahrscheinlich das Gefühl haben wird, dass es im Vergleich zu früheren XR-Produkten einige gute Designs und Durchbrüche aufweist, aber insgesamt bleibt es immer noch weit von den Erwartungen entfernt und weist viele „Rillen“ auf. Berichten zufolge hält der kabelgebundene Akku des Vision Pro beispielsweise nur 2 Stunden.

Text: Yi Liao Yanyu / Data Monkey

Das obige ist der detaillierte Inhalt vonWie weit muss Apple von „Hey Siri' bis zum Metaverse gehen?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr