Heim >Technologie-Peripheriegeräte >KI >Das Team von You Yang erzielte beim AAAI 2023 Outstanding Paper Award neue Ergebnisse, indem es mit einem einzigen V100 das Modell 72-mal schneller trainierte

Das Team von You Yang erzielte beim AAAI 2023 Outstanding Paper Award neue Ergebnisse, indem es mit einem einzigen V100 das Modell 72-mal schneller trainierte

- 王林nach vorne

- 2023-05-10 09:04:101138Durchsuche

Dieser Artikel wird mit Genehmigung von AI New Media Qubit (öffentliche Konto-ID: QbitAI) nachgedruckt. Bitte wenden Sie sich für einen Nachdruck an die Quelle.

Gerade hat UC Berkeley Ph.D. und Jungprofessor You Yang, Präsident der National University of Singapore, die neuesten Nachrichten veröffentlicht –

hat den AAAI 2023Outstanding Paper Award(Distinguished Paper) gewonnen!

Die Forschungsergebnisse erhöhten die Trainingsgeschwindigkeit des Modells auf einmal um das 72-fache.

Selbst Internetnutzer äußerten Emotionen, nachdem sie die Zeitung gelesen hatten:

Von 12 Stunden bis 10 Minuten, zarte Kuh(du Kuh)ah!

Dr. You Yang stellte während seines Studiums einmal den Weltrekord für ImageNet- und BERT-Trainingsgeschwindigkeit auf.

Die von ihm entwickelten Algorithmen werden auch häufig bei Technologiegiganten wie Google, Microsoft, Intel und NVIDIA eingesetzt.

Jetzt ist er nach China zurückgekehrt, um ein Unternehmen zu gründen Luchen TechnologyWelche Art von Algorithmus haben er und sein Team nach anderthalb Jahren entwickelt, um eine solche Ehre auf der Top-KI-Konferenz zu gewinnen?

Trainingszeit von 12 Stunden auf 10 Minuten

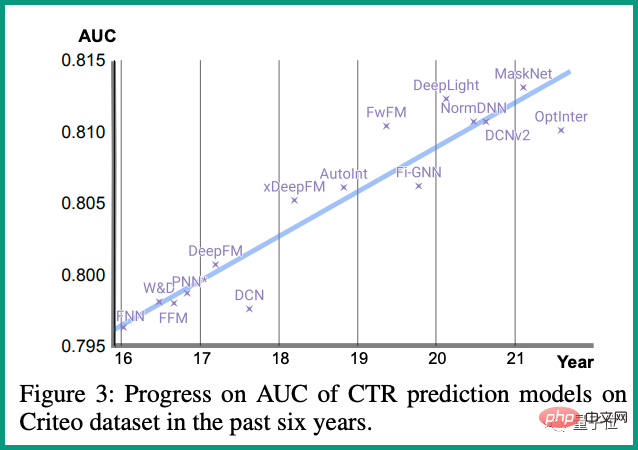

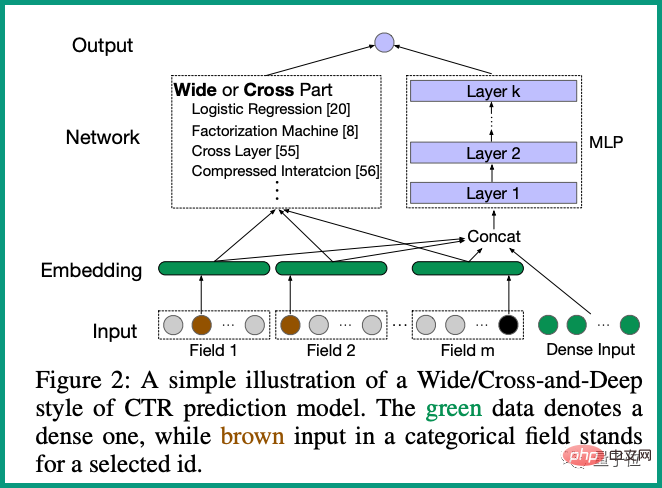

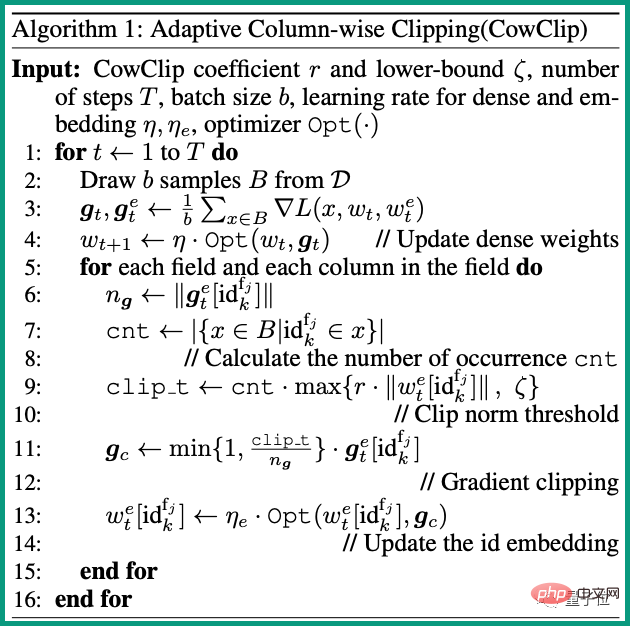

In dieser Studie schlug das Team von You Yang eine Optimierungsstrategie CowClip vor, die das Training von CTR-Vorhersagemodellen in großen Mengen beschleunigen kann.

CTR(Klickrate)Das Vorhersagemodell ist ein häufig verwendeter Algorithmus in personalisierten Empfehlungsszenarien.

Normalerweise muss das Benutzerfeedback (Klicks, Sammlungen, Käufe usw.) gelernt werden , und die täglich online generierte Datenmenge ist beispiellos groß.

Daher ist es entscheidend, das Training von CTR-Vorhersagemodellen zu beschleunigen.

Um die Trainingsgeschwindigkeit zu erhöhen, wird im Allgemeinen ein Batch-Training verwendet. Wenn die Batch-Größe jedoch zu groß ist, wird die Genauigkeit des Modells verringert.

Durch mathematische Analysen hat das Team bewiesen, dass die Lernrate für seltene Funktionen beim Erweitern des Stapels nicht skaliert werden sollte.

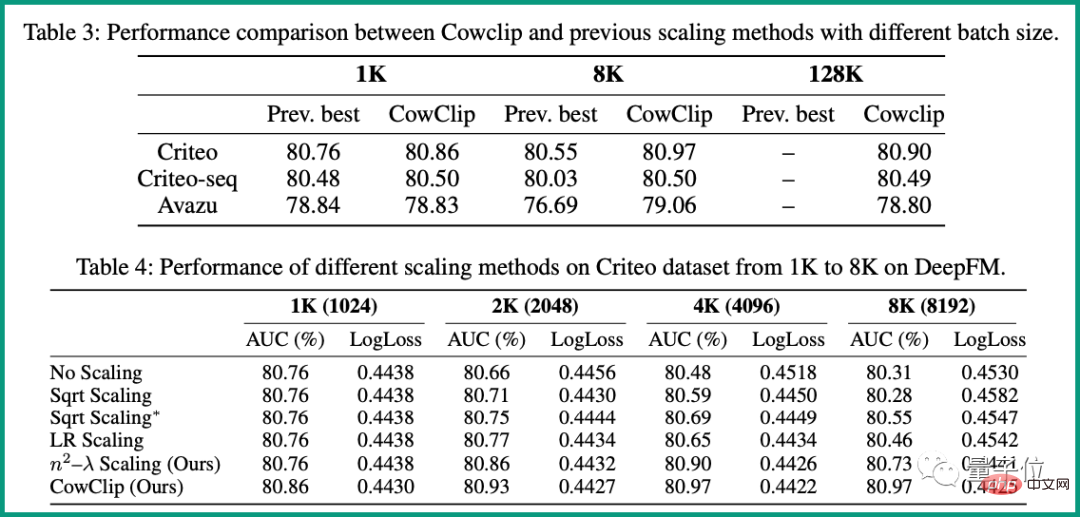

128-fache erweitern, ohne dass es zu Genauigkeitsverlusten kam.

Insbesondere auf DeepFM erreicht CowClip eine Verbesserung der AUC um über 0,1 %, indem es die Batch-Größe von 1K auf 128K erhöht. Und auf einer einzelnen V100-GPU verkürzt sich die Trainingszeit von ursprünglich 12 Stunden auf nur 10 Minuten und die Trainingsgeschwindigkeit erhöht sich um das72-fache.

Zheng Changwei. Er schloss die Computer-Eliteklasse der Universität Nanjing mit einem Bachelor-Abschluss und einem Ph.D. ab.

Seine Forschungsrichtungen umfassen maschinelles Lernen, Computer Vision und Hochleistungsrechnen.Das obige ist der detaillierte Inhalt vonDas Team von You Yang erzielte beim AAAI 2023 Outstanding Paper Award neue Ergebnisse, indem es mit einem einzigen V100 das Modell 72-mal schneller trainierte. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr