Heim >Technologie-Peripheriegeräte >KI >Google behauptet, dass seine TPU der vierten Generation besser sei als die Nvidia-GPU, aber die Branche glaubt, dass die Führungsposition der letzteren schwer zu erschüttern sei

Google behauptet, dass seine TPU der vierten Generation besser sei als die Nvidia-GPU, aber die Branche glaubt, dass die Führungsposition der letzteren schwer zu erschüttern sei

- PHPznach vorne

- 2023-05-09 13:10:121237Durchsuche

Google behauptete kürzlich, dass das Unternehmen Nvidia bei der KI-Superrechenleistung übertreffen kann. Die Branche geht jedoch davon aus, dass diese Nachricht dem Marktführer Nvidia voraussichtlich keine großen Probleme bereiten wird.

Google hat kürzlich einen Forschungsbericht veröffentlicht, der besagt, dass KI-Supercomputer mit seiner TPU eine bessere Leistung und Energieeffizienz aufweisen als entsprechende Maschinen mit Nvidia A100-GPUs.

Google hat 4.000 TPUs der vierten Generation aneinandergereiht, um einen Supercomputer zu bauen, der angeblich 1,7-mal schneller und 1,9-mal effizienter laufen soll als entsprechende Maschinen mit Nvidia A100-GPUs.

Google betreibt in Oklahoma einen Supercomputer mit TPU v4-Antrieb.

Nvidia profitiert vom Boom der generativen KI, da die Benutzernachfrage nach Nvidia A100-GPUs stark ansteigt. A100 wird hauptsächlich zum Training großer Sprach-KI-Modelle wie GPT-4 von OpenAI verwendet.

Die Branche geht davon aus, dass sich das Unternehmen angesichts der bevorstehenden Markteinführung der neuen GPU H100 von Nvidia wahrscheinlich keine Sorgen über diese Leistung von Google machen wird.

Google verwendet TPU v4 intern seit 2020 und hat diese Chips im vergangenen Jahr seinen Google Cloud Platform-Kunden zur Verfügung gestellt. Das größte groß angelegte Sprachmodell des Unternehmens, PaLM, wird mit zwei 4000-TPU-Supercomputern trainiert.

Der Google-Forscher Norm Jouppi und der angesehene Ingenieur David Patterson erklärten in einem Blogbeitrag über das System: „Ausgefallene Komponenten können mit optischen Schaltkreisschaltern leicht umgangen werden. Diese Flexibilität ermöglicht es uns sogar, die Topologie der Computerverbindung zu ändern, um die Leistung zu beschleunigen.“ von Modellen für maschinelles Lernen.“ Mike Orme, verantwortlich für die Entwicklung des Halbleitermarktes bei GlobalData, sagte, dass der Einsatz optischer Schaltkreisschalter der Schlüssel zur Verbesserung der Leistung von Googles Supercomputern sei. Er erklärte: „Während jede TPU nicht so schnell verarbeitet wie die besten NVIDIA-KI-Chips, gleicht die optische Schaltungsvermittlungstechnologie, die Google verwendet, um die Chips zu verbinden und Daten zwischen ihnen weiterzugeben, den Leistungsunterschied aus.“

NVIDIA Die Technologie ist geworden der Goldstandard für das Training von KI-Modellen, und einige große Technologieunternehmen haben Tausende von Nvidia A100-GPUs gekauft, um ihre Konkurrenten im KI-Technologie-Wettbewerb zu übertreffen. Der von OpenAI zum Trainieren von GPT-4 verwendete Supercomputer ist mit 10.000 Nvidia-GPUs ausgestattet, die jeweils bis zu 10.000 US-Dollar kosten.

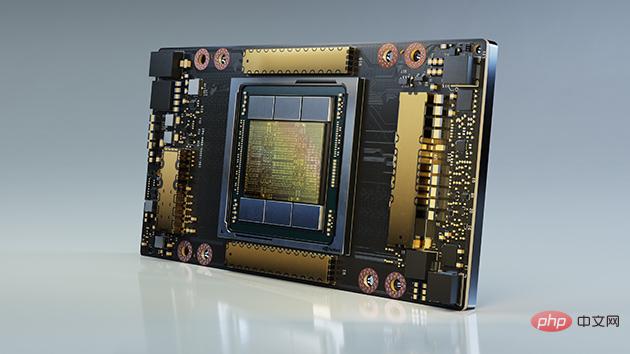

Nvidia A100 GPU

Nvidia A100 GPU

Die neuesten Nachrichten zeigen, dass A100 bald durch Nvidias neuestes Modell H100 ersetzt wird. In einem kürzlich von MLPerf, einer offenen KI-Engineering-Allianz zur Überwachung der Prozessorleistung, veröffentlichten Inferenz-Benchmark-Bericht führte der H100 die Branchenliste in Bezug auf Leistung und Effizienz an.

Nvidia H100 GPU

Nvidia H100 GPU

Dieser Geschwindigkeitsvorteil macht die Vorteile der optischen Schaltungsvermittlungstechnologie von Google zunichte. 90 % des KI-Trainings von Google nutzen TPU, aber trotz seines leistungsstarken Chips erwartet Orme nicht, dass Google es an Dritte weitergibt, da Google nicht den Ehrgeiz hat, mit Nvidia-Chips auf dem Markt für kommerzielle KI-Chips zu konkurrieren, deren TPUs sind den Rechenzentren von Google oder seinen KI-Supercomputern gewidmet. „

Warum nutzen nur wenige Nutzer außerhalb von Google diese Technologie, weil Google Cloud einen kleinen Anteil am öffentlichen Cloud-Markt hat? Laut Umfragedaten der Synergy Research Group liegt der Marktanteil von Google Cloud bei 11 % AWS und Microsoft Azure bei 34 % bzw. 21 %

Gleichzeitig hat Google auch eine Vereinbarung mit NVIDIA getroffen, um Google Cloud-Kunden H100-GPU-Rechenleistung zur Verfügung zu stellen, was zeigt, dass NVIDIA auch in Zukunft die Marktführerschaft behaupten wird Google kann darauf nicht verzichten.

Das obige ist der detaillierte Inhalt vonGoogle behauptet, dass seine TPU der vierten Generation besser sei als die Nvidia-GPU, aber die Branche glaubt, dass die Führungsposition der letzteren schwer zu erschüttern sei. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr