Heim >Technologie-Peripheriegeräte >KI >Bilderkennung: Faltungs-Neuronales Netzwerk

Bilderkennung: Faltungs-Neuronales Netzwerk

- 王林nach vorne

- 2023-04-29 13:31:061819Durchsuche

Dieser Artikel ist ein Nachdruck aus dem öffentlichen WeChat-Konto „Leben im Informationszeitalter“. Der Autor lebt im Informationszeitalter. Um diesen Artikel erneut zu drucken, wenden Sie sich bitte an das öffentliche Konto „Living in the Information Age“.

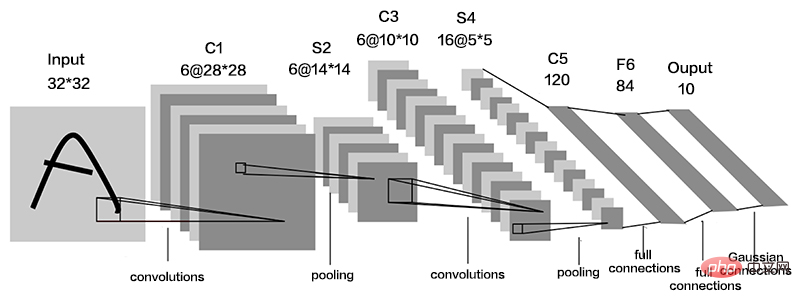

Convolutional Neural Network (CNN) ist ein spezielles Deep-Feed-Forward-Netzwerk, das im Allgemeinen eine Dateneingabeschicht, eine Faltungsschicht, eine Aktivierungsschicht, eine Downsampling-Schicht und eine vollständig verbundene Schicht umfasst.

Die Faltungsschicht ist eine wichtige Einheit im Faltungs-Neuronalen Netzwerk. Sie besteht aus einer Reihe von Faltungskernen, die die Daten filtern der Faltungskern. Linearer Überlagerungsprozess der wertgewichteten Summation. Das Bild I wird als Eingabe verwendet und der zweidimensionale Faltungskern K wird für die Faltung verwendet. Der Faltungsprozess kann wie folgt ausgedrückt werden:

wobei I(i,j) das Bild in ist (i,j) Der Positionswert S(i,j) ist die nach der Faltungsoperation erhaltene Merkmalskarte.

Die Aktivierungsfaltungsoperation ist linear, kann nur eine lineare Zuordnung durchführen und verfügt über begrenzte Ausdrucksfähigkeiten. Um nichtlineare Abbildungsprobleme zu lösen, ist es daher erforderlich, eine nichtlineare Aktivierungsfunktion einzuführen. Um verschiedene nichtlineare Probleme zu lösen, werden auch unterschiedliche Aktivierungsfunktionen eingeführt. Die am häufigsten verwendeten sind Sigmoid, Tanh, Relu usw.

Der Ausdruck der Sigmoidfunktion lautet:

Der Ausdruck der Tanh-Funktion lautet:

Relu-Funktion lautet:

Die Downsampling-Schicht wird auch als Pooling-Schicht bezeichnet. Sie wird normalerweise nach mehreren Faltungsschichten platziert, um die Größe des Feature-Bildes zu reduzieren. Die Pooling-Funktion nutzt die gesamten statistischen Eigenschaften benachbarter Ausgänge an einer bestimmten Position, um den Ausgang des Netzwerks an dieser Position zu ersetzen. Im Allgemeinen hat die Pooling-Schicht drei Funktionen: Erstens reduziert sie die Feature-Dimension. Der Pooling-Vorgang entspricht einem anderen Feature-Extraktionsprozess, der redundante Informationen entfernen und das Datenverarbeitungsvolumen der nächsten Schicht reduzieren kann. Die zweite besteht darin, eine Überanpassung zu verhindern, und die Pooling-Operation erhält abstraktere Informationen und verbessert die Generalisierung. Die dritte besteht darin, die Merkmalsinvarianz aufrechtzuerhalten, und die Pooling-Operation behält die wichtigsten Merkmale bei.

Die vollständig verbundene Schicht wird normalerweise am Ende des Faltungs-Neuronalen Netzwerks platziert, und alle Neuronen zwischen den Schichten sind mit Gewichten verbunden. Der Zweck besteht darin, alle im Netzwerk gelernten Merkmale dem Etikettenraum der Stichprobe zuzuordnen, um Kategorieurteile zu treffen. Die Softmax-Funktion wird normalerweise in der letzten Schicht des neuronalen Netzwerks als Ausgabe des Klassifikators verwendet. Jeder von der Softmax-Funktion ausgegebene Wert liegt zwischen (0, 1).

Es gibt einige klassische und effiziente CNN-Modelle wie VGGNet, ResNet, AlexNet usw., die im Bereich der Bilderkennung weit verbreitet sind.

Das obige ist der detaillierte Inhalt vonBilderkennung: Faltungs-Neuronales Netzwerk. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr