Heim >Technologie-Peripheriegeräte >KI >Stanford, Meta AI Research: Auf dem Weg zu AGI ist die Datenbereinigung wichtiger als wir denken

Stanford, Meta AI Research: Auf dem Weg zu AGI ist die Datenbereinigung wichtiger als wir denken

- PHPznach vorne

- 2023-04-17 19:04:031256Durchsuche

In vielen Bereichen des maschinellen Lernens, einschließlich Sehen, Sprache und Sprache, besagt das neuronale Skalierungsgesetz, dass Testfehler im Allgemeinen mit den Trainingsdaten, der Modellgröße oder der Anzahl der Berechnungen abnehmen. Diese proportionale Verbesserung hat dazu geführt, dass Deep Learning erhebliche Leistungssteigerungen erzielen konnte. Allerdings sind diese allein durch Skalierung erzielten Verbesserungen mit erheblichen Rechen- und Energiekosten verbunden.

Diese proportionale Skalierung ist nicht nachhaltig. Um beispielsweise den Fehler von 3 % auf 2 % zu senken, sind exponentiell mehr Daten, Berechnungen oder Energie erforderlich. Einige frühere Untersuchungen haben gezeigt, dass die Reduzierung des Kreuzentropieverlusts von 3,4 auf 2,8 bei der Sprachmodellierung mit großen Transformern zehnmal mehr Trainingsdaten erfordert. Darüber hinaus führten bei großen visuellen Transformern zusätzliche 2 Milliarden vorab trainierte Datenpunkte (ausgehend von 1 Milliarde) nur zu einem Genauigkeitsgewinn von einigen Prozentpunkten auf ImageNet.

All diese Ergebnisse geben Aufschluss über die Natur der Daten beim Deep Learning und zeigen gleichzeitig, dass das Sammeln großer Datensätze ineffizient sein kann. Die Diskussion hier ist, ob wir es besser machen können. Können wir beispielsweise mit einer guten Strategie zur Auswahl von Trainingsbeispielen eine exponentielle Skalierung erreichen?

In einem kürzlich erschienenen Artikel fanden Forscher heraus, dass das Hinzufügen nur einiger sorgfältig ausgewählter Trainingsstichproben den Fehler von 3 % auf 2 % reduzieren kann, ohne dass zehnmal mehr Zufallsstichproben gesammelt werden müssen. Kurz gesagt: „Verkauf ist nicht alles, was Sie brauchen“.

Papierlink: https://arxiv.org/pdf/2206.14486.pdf

Im Allgemeinen sind die Beiträge dieser Forschung:

1. Mithilfe der statistischen Mechanik wurde eine neue Datenbereinigungsmethode entwickelt In der Zweiganalysetheorie werden in der Lehrer-Schüler-Perzeptron-Lernumgebung Proben entsprechend ihrer Lehrergrenzen beschnitten, und die großen (kleinen) Ränder entsprechen jeweils einfachen (schwierigen) Proben. Die Theorie stimmt quantitativ mit numerischen Experimenten überein und offenbart zwei überraschende Vorhersagen:

a Die optimale Bereinigungsstrategie ändert sich mit der Menge der Anfangsdaten; wenn die Anfangsdaten reichlich vorhanden (knapp) sind, sollten nur schwierige (einfache) Stichproben beibehalten werden.

b. Wenn ein zunehmender Pareto-optimaler Bereinigungswert als Funktion der anfänglichen Datensatzgröße gewählt wird, ist eine exponentielle Skalierung für die beschnittene Datensatzgröße möglich.

2. Untersuchungen zeigen, dass diese beiden Vorhersagen in der Praxis in allgemeineren Situationen zutreffen. Sie validieren die Eigenschaften der exponentiellen Fehlerskalierung in Bezug auf die Größe des beschnittenen Datensatzes für ResNets, die von Grund auf auf SVHN, CIFAR-10 und ImageNet trainiert wurden, und für einen auf CIFAR-10 fein abgestimmten visuellen Transformer.

3. Führte eine groß angelegte Benchmark-Studie zu 10 verschiedenen Datenbereinigungsmetriken auf ImageNet durch und stellte fest, dass die meisten Metriken mit Ausnahme der rechenintensivsten eine schlechte Leistung erbrachten.

4. Mithilfe von selbstüberwachtem Lernen wird eine neue kostengünstige unbeaufsichtigte Bereinigungsmetrik entwickelt, die im Gegensatz zu früheren Metriken keine Etiketten erfordert. Wir zeigen, dass diese unbeaufsichtigte Maßnahme mit den besten überwachten Beschneidungsmaßnahmen vergleichbar ist, die Etiketten und mehr Berechnungen erfordern. Dieses Ergebnis zeigt die Möglichkeit, ein vorab trainiertes Basismodell zum Bereinigen neuer Datensätze zu verwenden.

Ist die Waage alles, was Sie brauchen?

Die Perzeptron-Datenbereinigungstheorie des Forschers schlägt drei überraschende Vorhersagen vor, die in einer allgemeineren Umgebung getestet werden können, beispielsweise in anhand von Benchmarks trainierten tiefen neuronalen Netzen:

(1) Relativ zur zufälligen Datenbereinigung, wenn der anfängliche Datensatz relativ ist Wenn der anfängliche Datensatz jedoch relativ klein ist, ist dies schädlich Der feste Anteil der Stichproben f sollte eine Potenzgesetz-Skalierung mit einem Exponenten erzeugen, der der zufälligen Beschneidung entspricht Am Datensatz wird eine aggressive Bereinigung durchgeführt, um eine Pareto-optimale untere Hüllkurve zu verfolgen, wodurch die Potenzgesetz-Skalierungsfunktionsbeziehung zwischen Testfehler und Größe des beschnittenen Datensatzes unterbrochen wird.

Die Forscher verwendeten unterschiedliche Anzahlen von anfänglichen Datensatzgrößen und Datenfraktionen, die unter Datenbereinigung gespeichert wurden (Theorie in Abbildung 3A vs. das Deep-Learning-Experiment in Abbildung 3BCD), und das Training auf SVHN, CIFAR-10 und ImageNet ResNets verifizierte dies oben drei Vorhersagen. In jeder Versuchsumgebung lässt sich erkennen, dass eine größere anfängliche Datensatzgröße und eine aggressivere Bereinigung eine bessere Leistung erbringen als die Potenzgesetz-Skalierung. Darüber hinaus kann ein größerer Anfangsdatensatz möglicherweise eine bessere Skalierung erzielen (Abbildung 3A).Darüber hinaus fanden Forscher heraus, dass die Datenbereinigung die Leistung des Transferlernens verbessern kann. Sie analysierten zunächst das auf ImageNet21K vorab trainierte ViT und führten dann eine Feinabstimmung auf verschiedene beschnittene Teilmengen von CIFAR-10 durch. Interessanterweise ermöglichte das vorab trainierte Modell eine aggressivere Datenbereinigung; nur 10 % der CIFAR-10-Feinabstimmung erreichten oder übertrafen die Leistung aller CIFAR-10-Feinabstimmungen (Abbildung 4A). Darüber hinaus zeigt Abbildung 4A ein Beispiel für die Brechung der Potenzgesetzsskalierung in einer fein abgestimmten Umgebung.

Wir haben die Wirksamkeit der Bereinigung der vorab trainierten Daten untersucht, indem wir ResNet50 auf verschiedenen bereinigten Teilmengen von ImageNet1K (dargestellt in Abbildung 3D) vorab trainiert haben und sie dann auf CIFAR-10 optimiert haben. Wie in Abbildung 4B dargestellt, kann ein Vortraining auf mindestens 50 % von ImageNet die CIFAR-10-Leistung erreichen oder übertreffen, die durch Vortraining auf allen ImageNet erreicht wird.

Daher kann die Bereinigung der Pre-Training-Daten von Upstream-Aufgaben dennoch eine hohe Leistung bei verschiedenen Downstream-Aufgaben aufrechterhalten. Insgesamt zeigen diese Ergebnisse, dass eine Reduzierung des Transferlernens während der Vortrainings- und Feinabstimmungsphase vielversprechend ist.

Benchmarking überwachter Bereinigungsmetriken auf ImageNet

Die Forscher stellten fest, dass die meisten Datenbereinigungsexperimente an kleinen Datensätzen (d. h. Varianten von MNIST und CIFAR) durchgeführt wurden. Daher werden die wenigen für ImageNet vorgeschlagenen Bereinigungsmetriken selten mit Basislinien verglichen, die auf kleineren Datensätzen basieren.

Daher ist unklar, wie sich die meisten Beschneidungsmethoden auf ImageNet skalieren lassen und welche Methode die beste ist. Um den theoretischen Einfluss der Qualität der Pruning-Metriken auf die Leistung zu untersuchen, haben wir beschlossen, diese Wissenslücke zu schließen, indem wir eine systematische Bewertung von 8 verschiedenen überwachten Pruning-Metriken auf ImageNet durchführen.

Sie beobachteten erhebliche Leistungsunterschiede zwischen den Metriken: Abbildung 5BC zeigt die Testleistung, wenn ein Teil der härtesten Proben unter jeder Metrik im Trainingssatz beibehalten wurde. Viele Metriken sind bei kleineren Datensätzen erfolgreich, aber wenn man eine deutlich kleinere Trainingsteilmenge wählt (z. B. 80 % von Imagenet), erzielen nur wenige noch eine vergleichbare Leistung, wenn sie auf dem gesamten Datensatz trainiert werden.

Dennoch übertreffen die meisten Maßnahmen immer noch das zufällige Beschneiden (Abbildung 5C). Forscher fanden heraus, dass alle Bereinigungsmetriken das Klassenungleichgewicht verstärken, was zu Leistungseinbußen führt. Um dieses Problem anzugehen, verwendeten die Autoren in allen ImageNet-Experimenten eine einfache Klassenausgleichsrate von 50 %.

Selbstüberwachte Datenbereinigung über Prototyp-Metriken

Wie in Abbildung 5 dargestellt, lassen sich viele Datenbereinigungsmetriken nicht gut auf ImageNet skalieren, und einige von ihnen sind tatsächlich rechenintensiv. Darüber hinaus erfordern alle diese Metriken Anmerkungen, was ihre Datenbereinigungsmöglichkeiten für das Training umfangreicher Basismodelle auf riesigen, unbeschrifteten Datensätzen einschränkt. Daher benötigen wir eindeutig einfache, skalierbare und selbstüberwachte Bereinigungsmetriken.

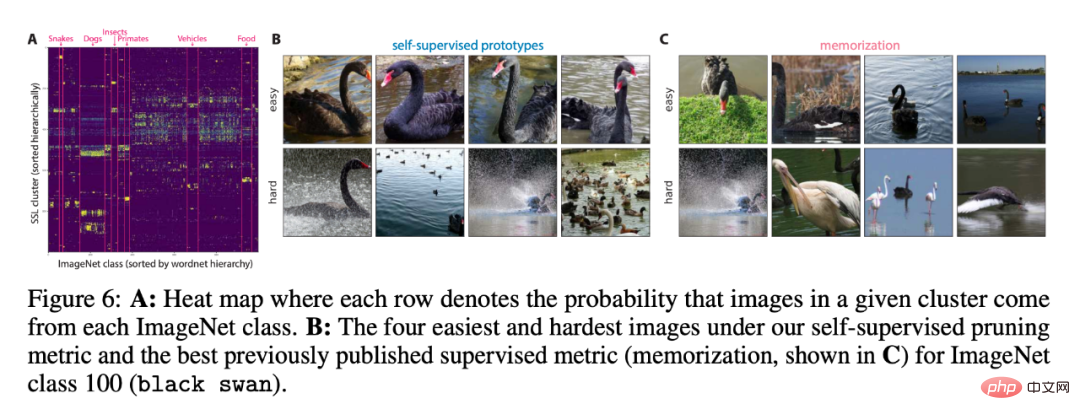

Um zu bewerten, ob die von der Metrik entdeckten Cluster mit ImageNet-Klassen konsistent sind, haben wir ihre Überlappung in Abbildung 6A verglichen. Die Leistung von selbstüberwachten und überwachten Maßnahmen ist ähnlich, wenn mehr als 70 % der Daten beibehalten werden, was zeigt, dass selbstüberwachtes Beschneiden vielversprechend ist.

Weitere Forschungsdetails finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonStanford, Meta AI Research: Auf dem Weg zu AGI ist die Datenbereinigung wichtiger als wir denken. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr