Heim >Technologie-Peripheriegeräte >KI >Empfohlenes Papier: Segmentierung und Klassifizierung von Brusttumoren in Ultraschallbildern basierend auf Deep Adversarial Learning

Empfohlenes Papier: Segmentierung und Klassifizierung von Brusttumoren in Ultraschallbildern basierend auf Deep Adversarial Learning

- 王林nach vorne

- 2023-04-15 08:19:03961Durchsuche

Bedingtes GAN (cGAN) + Atrous Convolution (AC) + Kanalaufmerksamkeit mit gewichteten Blöcken (CAW).

Dieses Papier schlägt eine Methode zur Segmentierung und Klassifizierung von Brusttumoren für Ultraschallbilder (cGAN+AC+CAW) vor, die auf Deep Adversarial Learning basiert. Obwohl das Papier bereits 2019 vorgeschlagen wurde, war die von ihm vorgeschlagene Methode zur Verwendung von GAN für die Segmentierung damals Aber Es handelt sich um eine sehr neuartige Idee, die im Grunde alle damals integrierbaren Technologien umfasste und sehr gute Ergebnisse erzielte. Darüber hinaus wurden in dem Papier auch typische Gegenmaßnahmen für SSIM-Verluste und L1-Normen vorgeschlagen Verlust als Verlustfunktion.

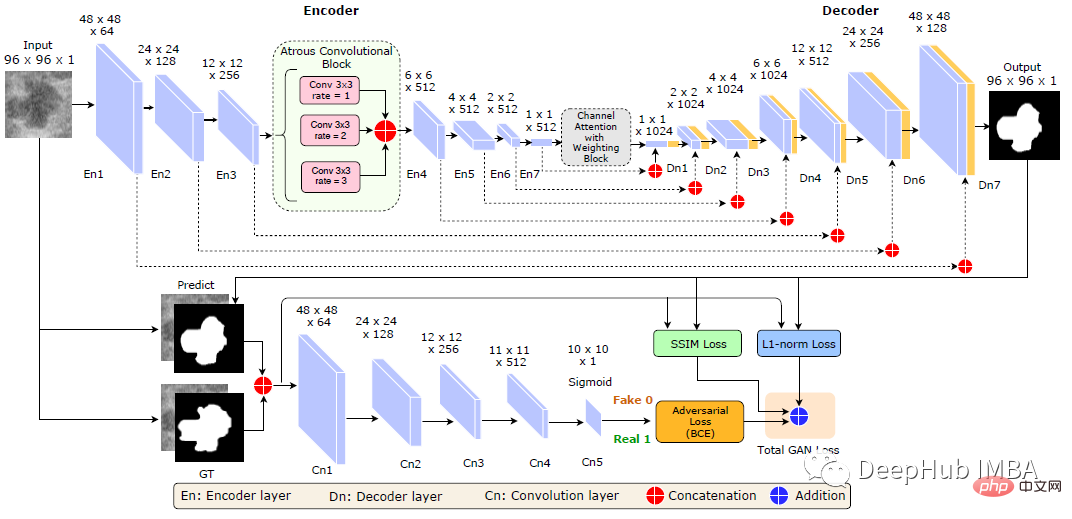

Verwendung von cGAN+AC+CAW für die semantische Segmentierung

Generator G

Das Generatornetzwerk besteht aus einem Encoderteil: bestehend aus sieben Faltungsschichten (En1 bis En7) und einem Decoder: sieben bestehend aus Entfaltungsschichten (Dn1 bis Dn7).

Fügen Sie einen atrous Faltungsblock zwischen En3 und En4 ein. Dilatationsverhältnisse 1, 6 und 9, Kerngröße 3×3, Schritt 2.

Es gibt auch eine Kanalaufmerksamkeitsschicht mit Kanalgewichtungsblock (CAW) zwischen En7 und Dn1.

CAW-Block ist eine Sammlung von Kanalaufmerksamkeitsmodulen (DAN) und Kanalgewichtungsblöcken (SENet), die die Darstellungsfähigkeit der Funktionen der höchsten Ebene des Generatornetzwerks erhöhen.

Diskriminator D

Es ist eine Folge von Faltungsschichten.

Die Eingabe in den Diskriminator ist die Verkettung des Bildes und einer binären Maske, die die Tumorregion markiert.

Die Ausgabe des Diskriminators ist eine 10×10-Matrix mit Werten im Bereich von 0,0 (vollständig gefälscht) bis 1,0 (echt).

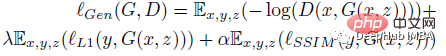

Verlustfunktion

Die Verlustfunktion von Generator G besteht aus drei Begriffen: gegnerischer Verlust (binärer Kreuzentropieverlust), l1-Norm zur Erleichterung des Lernprozesses und SSIM-Verlust zur Verbesserung der Grenzform der Segmentierungsmaske:

wobei z eine Zufallsvariable ist. Die Verlustfunktion des Diskriminators D lautet:

Verwendung von Random Forest für die Klassifizierungsaufgabe

Jedes Bild wird in das trainierte generative Netzwerk eingegeben, um die Tumorgrenze zu erhalten, und dann werden 13 statistische Merkmale aus dieser Grenze berechnet : fraktale Dimension, Lakunarität, konvexe Hülle, Konvexität, Zirkularität, Fläche, Umfang, Schwerpunkt, Neben- und Hauptachsenlänge, Glätte, Hu-Momente (6) und Zentralmomente (Ordnung 3 und darunter)

Unter Verwendung umfassender Merkmalsauswahl), Algorithmus um den optimalen Funktionsumfang auszuwählen. Der EFS-Algorithmus zeigt, dass fraktale Dimension, Lakunarität, konvexe Hülle und Schwerpunkt die vier optimalen Merkmale sind.

Diese ausgewählten Merkmale werden in einen Random-Forest-Klassifikator eingespeist, der dann darauf trainiert wird, zwischen gutartigen und bösartigen Tumoren zu unterscheiden.

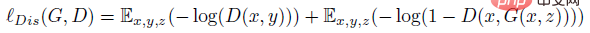

Ergebnisvergleich

Segmentierung

Der Datensatz enthält 150 bösartige Tumoren und 100 gutartige Tumoren, die im Bild enthalten sind. Für das Training des Modells wurde der Datensatz zufällig in Trainingssatz (70 %), Validierungssatz (10 %) und Testsatz (20 %) aufgeteilt.

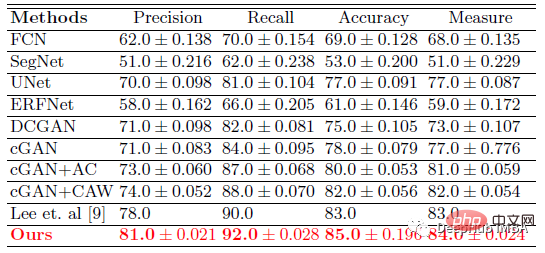

Dieses Modell (cGAN+AC+CAW) übertrifft andere Modelle in allen Indikatoren. Die Dice- und IoU-Werte liegen bei 93,76 % bzw. 88,82 %.

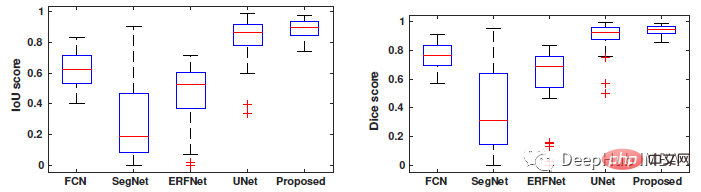

Boxplot-Vergleich von IoU und Dice des Papiermodells mit Segmentierungsköpfen wie FCN, SegNet, ERFNet und U-Net.

Der Wertebereich dieses Modells für den Dice-Koeffizienten beträgt 88 % ~ 94 %, und der Wertebereich für IoU beträgt 80 % ~ 89 %, während die Werte anderer Tiefensegmentierungsmethoden FCN, SegNet, ERFNet und U-Net sind Der Wertebereich ist breiter.

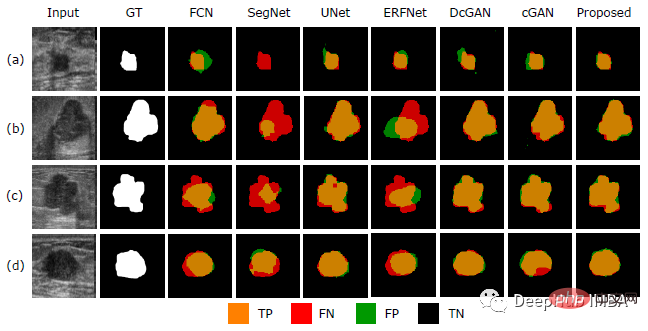

Segmentierungsergebnisse Wie in der Abbildung oben gezeigt, lieferten SegNet und ERFNet die schlechtesten Ergebnisse, mit einer großen Anzahl falsch negativer Bereiche (rot) und einigen falsch positiven Bereichen (grün).

Während U-Net, DCGAN und cGAN eine gute Segmentierung bieten, bietet das in der Arbeit vorgeschlagene Modell eine genauere Segmentierung der Brusttumorgrenzen.

Klassifizierung

Die vorgeschlagene Methode zur Klassifizierung von Brusttumoren ist besser als [9], mit einer Gesamtgenauigkeit von 85 %.

Das obige ist der detaillierte Inhalt vonEmpfohlenes Papier: Segmentierung und Klassifizierung von Brusttumoren in Ultraschallbildern basierend auf Deep Adversarial Learning. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr