Heim >Technologie-Peripheriegeräte >KI >Warum ist Selbstüberwachung effektiv? Die 243-seitige Princeton-Doktorarbeit „Understanding Self-supervised Representation Learning' erläutert umfassend die drei Arten von Methoden: kontrastives Lernen, Sprachmodellierung und Selbstvorhersage.

Warum ist Selbstüberwachung effektiv? Die 243-seitige Princeton-Doktorarbeit „Understanding Self-supervised Representation Learning' erläutert umfassend die drei Arten von Methoden: kontrastives Lernen, Sprachmodellierung und Selbstvorhersage.

- PHPznach vorne

- 2023-04-15 08:13:021092Durchsuche

Pre-Training hat sich als alternatives und wirksames Paradigma zur Überwindung dieser Mängel herausgestellt, bei dem Modelle zunächst mithilfe leicht verfügbarer Daten trainiert und dann zur Lösung nachgelagerter interessanter Aufgaben verwendet werden, und zwar mit viel weniger gekennzeichneten Daten als beim überwachten Lernen.

Die Verwendung unbeschrifteter Daten für das Pre-Training, also das selbstüberwachte Lernen, ist besonders revolutionär und hat sich in verschiedenen Bereichen als erfolgreich erwiesen: Text, Vision, Sprache usw.

Dies wirft eine interessante und herausfordernde Frage auf: Warum sollte ein Vortraining an unbeschrifteten Daten scheinbar nicht zusammenhängende nachgelagerte Aufgaben unterstützen? .edu/handle/88435/dsp01t435gh21h

Dieses Papier präsentiert einige Arbeiten, schlägt einen theoretischen Rahmen vor und etabliert ihn, um zu untersuchen, warum selbstüberwachtes Lernen für nachgelagerte Aufgaben von Vorteil ist.

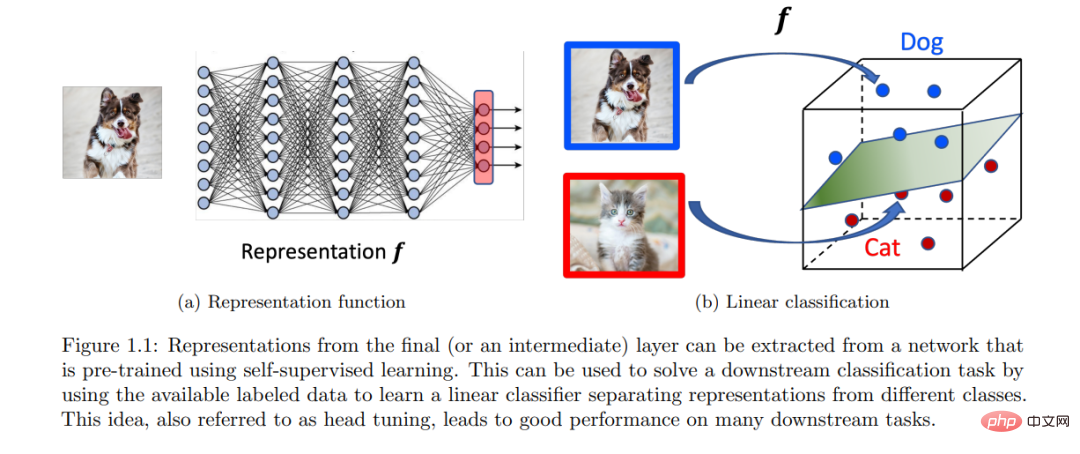

Dieses Framework eignet sich für kontrastives Lernen, autoregressive Sprachmodellierung und auf Selbstvorhersage basierende Methoden. Die Kernidee dieses Frameworks besteht darin, dass das Vortraining dabei hilft, eine niedrigdimensionale Darstellung der Daten zu erlernen, was anschließend dazu beiträgt, die nachgelagerten Aufgaben von Interesse mit linearen Klassifikatoren zu lösen, die weniger beschriftete Daten erfordern.

Ein häufiges Thema ist die Formalisierung der idealen Eigenschaften unbeschrifteter Datenverteilungen für die Erstellung selbstüberwachter Lernaufgaben. Bei entsprechender Formalisierung kann gezeigt werden, dass durch eine ungefähre Minimierung des korrekten Ziels vor dem Training Downstream-Signale extrahiert werden können, die implizit in unbeschrifteten Datenverteilungen codiert sind. Abschließend zeigen wir, dass dieses Signal mithilfe eines linearen Klassifikators aus der erlernten Darstellung dekodiert werden kann und so eine Formalisierung für den Transfer von „Fähigkeiten und Wissen“ über Aufgaben hinweg bereitstellt.

EINFÜHRUNG

Der Bereich maschinelles Lernen und künstliche Intelligenz hat im letzten Jahrzehnt enorme Fortschritte bei der Entwicklung von Agenten und datengesteuerten Problemlösungen gemacht. Mit ersten Erfolgen bei anspruchsvollen Benchmarks für überwachtes Lernen wie ImageNet [Deng et al., 2009] führten Innovationen im Deep Learning anschließend zu Modellen mit übermenschlicher Leistung bei vielen solcher Benchmarks in verschiedenen Bereichen. Das Training solcher aufgabenspezifischen Modelle ist sicherlich beeindruckend und hat einen enormen praktischen Wert. Es besteht jedoch eine wichtige Einschränkung darin, dass große beschriftete oder kommentierte Datensätze erforderlich sind, was oft teuer ist. Darüber hinaus erhofft man sich aus Intelligenzperspektive allgemeinere Modelle, die wie Menschen [Ahn und Brewer, 1993] aus früheren Erfahrungen lernen, diese zu Fähigkeiten oder Konzepten zusammenfassen und diese Fähigkeiten oder Konzepte zur Lösung neuer Aufgaben nutzen können wenig oder keine Demonstration. Schließlich lernen Babys viel durch Beobachtung und Interaktion ohne explizite Aufsicht. Diese Einschränkungen inspirierten zu einem alternativen Paradigma für das Vortraining.

Der Schwerpunkt dieses Artikels liegt auf dem Vortraining unter Verwendung der oft großen Mengen unbeschrifteter verfügbarer Daten. Die Idee, unbeschriftete Daten zu verwenden, ist seit langem ein interessanter Punkt beim maschinellen Lernen, insbesondere beim unbeaufsichtigten und halbüberwachten Lernen.

Der Schwerpunkt dieses Artikels liegt auf dem Vortraining unter Verwendung der oft großen Mengen unbeschrifteter verfügbarer Daten. Die Idee, unbeschriftete Daten zu verwenden, ist seit langem ein interessanter Punkt beim maschinellen Lernen, insbesondere beim unbeaufsichtigten und halbüberwachten Lernen.

Während selbstüberwachtes Lernen empirisch erfolgreich war und weiterhin vielversprechend ist, mangelt es über eine grobe Intuition hinaus immer noch an einem guten theoretischen Verständnis seiner Funktionsweise. Diese beeindruckenden Erfolge werfen interessante Fragen auf, da a priori unklar ist, warum ein Modell, das für eine Aufgabe trainiert wurde, bei einer anderen, scheinbar nicht zusammenhängenden Aufgabe helfen sollte, d. h. warum das Training für Aufgabe a bei Aufgabe b helfen sollte. Während ein vollständiges theoretisches Verständnis von SSL (und Deep Learning im Allgemeinen) schwierig und schwer zu erreichen ist, kann das Verständnis dieses Phänomens auf jeder Abstraktionsebene bei der Entwicklung prinzipiellerer Algorithmen helfen. Die Forschungsmotivation dieses Artikels lautet:

Warum hilft das Training zu selbstüberwachten Lernaufgaben (unter Verwendung großer Mengen unbeschrifteter Daten) bei der Lösung datenknapper nachgelagerter Aufgaben? Wie kann der Transfer von „Wissen und Fähigkeiten“ formalisiert werden?

Obwohl es eine große Literatur zum überwachten Lernen gibt, unterscheidet sich die Generalisierung von SSL-Aufgabe → Downstream-Aufgabe grundlegend von der Generalisierung von Trainingssatz → Testsatz beim überwachten Lernen. Für überwachtes Lernen für nachgelagerte Klassifizierungsaufgaben kann beispielsweise ein Modell, das auf einem Trainingssatz von Eingabe-Label-Paaren trainiert wurde, die aus einer unbekannten Verteilung stammen, direkt für die Auswertung eines unbekannten Testsatzes verwendet werden, der aus derselben Verteilung stammt. Diese Grundverteilung stellt die Verbindung vom Trainingssatz zum Testsatz her. Der konzeptionelle Zusammenhang zwischen SSL-Aufgabe und Downstream-Aufgabe ist jedoch weniger klar, da die in der SSL-Aufgabe verwendeten unbeschrifteten Daten kein klares Signal über Downstream-Labels haben. Dies bedeutet, dass ein Modell, das für eine SSL-Aufgabe vorab trainiert wurde (z. B. Vorhersage eines Teils der Eingabe aus dem Rest), nicht direkt für nachgelagerte Aufgaben verwendet werden kann (z. B. Vorhersage einer Klassenbezeichnung anhand der Eingabe). Daher erfordert der Transfer von „Wissen und Fähigkeiten“ einen zusätzlichen Trainingsschritt unter Verwendung einiger gekennzeichneter Daten, idealerweise weniger als das, was für überwachtes Lernen von Grund auf erforderlich ist. Jedes theoretische Verständnis der Verallgemeinerung von SSL-Aufgaben → Downstream-Aufgaben muss sich mit den folgenden Fragen befassen: „Welche eigentliche Rolle spielen unbeschriftete Daten?“ und „Wie werden vorab trainierte Modelle für Downstream-Aufgaben verwendet?“ Dieses Papier zielt auf die Downstream-Aufgaben der Klassifizierung ab Treffen Sie Verteilungsannahmen für unbeschriftete Daten und nutzen Sie die Idee des Repräsentationslernens, um diese Probleme zu untersuchen:

(a) (Verteilungsannahme) Die Verteilung unbeschrifteter Daten enthält implizit Informationen über die nachgelagerte Klassifizierungsaufgabe von Interesse.

(b) (Darstellungslernen) Ein Modell, das vorab auf eine entsprechende SSL-Aufgabe trainiert wurde, kann dieses Signal durch erlernte Darstellungen kodieren, die dann zur Lösung nachgelagerter Klassifizierungsaufgaben mit linearen Klassifikatoren verwendet werden können.

Punkt (a) zeigt, dass bestimmte Struktureigenschaften, die nicht gekennzeichnet sind, uns implizit Hinweise auf nachfolgende nachgelagerte Aufgaben geben, und selbstüberwachtes Lernen kann dabei helfen, dieses Signal aus den Daten herauszuarbeiten. Punkt (b) schlägt eine einfache und empirisch effektive Möglichkeit vor, vorab trainierte Modelle zu verwenden und dabei die erlernten Darstellungen des Modells zu nutzen. Dieser Artikel identifiziert und quantifiziert die Verteilungseigenschaften unbeschrifteter Daten mathematisch und zeigt, dass gute Darstellungen für verschiedene SSL-Methoden wie kontrastives Lernen, Sprachmodellierung und Selbstvorhersage erlernt werden können. Im nächsten Abschnitt befassen wir uns mit der Idee des Repräsentationslernens und erklären formal, warum selbstüberwachtes Lernen nachgelagerte Aufgaben unterstützt.

Das obige ist der detaillierte Inhalt vonWarum ist Selbstüberwachung effektiv? Die 243-seitige Princeton-Doktorarbeit „Understanding Self-supervised Representation Learning' erläutert umfassend die drei Arten von Methoden: kontrastives Lernen, Sprachmodellierung und Selbstvorhersage.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr