Heim >Technologie-Peripheriegeräte >KI >Das „Zaubermittel zum Verführen von Mädchen' funktioniert nicht mehr! OpenAI veröffentlicht offiziellen „ChatGPT-Detektor'

Das „Zaubermittel zum Verführen von Mädchen' funktioniert nicht mehr! OpenAI veröffentlicht offiziellen „ChatGPT-Detektor'

- PHPznach vorne

- 2023-04-13 22:22:141191Durchsuche

Die Kritikschreie der Öffentlichkeit folgten einer nach dem anderen und OpenAI hielt es schließlich nicht mehr aus.

Vom Universitätsprofessor bis zum Stack Overflow hat die Arbeit an ChatGPT lange gedauert. Unabhängig davon, ob ein Lehrer eine von einem Schüler eingereichte Arbeit sieht oder ein Programmierer den Code im Internet sieht, ist er sich nicht sicher, ob der Autor ein Mensch oder eine KI ist.

Unter der Kritik hielt OpenAI es nicht mehr aus und veröffentlichte schnell einen KI-Detektor.

Gegeneinander kämpfen: OpenAI veröffentlicht ChatGPT-Detektor

Gerade jetzt hat OpenAI offiziell seinen eigenen KI-Textklassifizierer angekündigt.

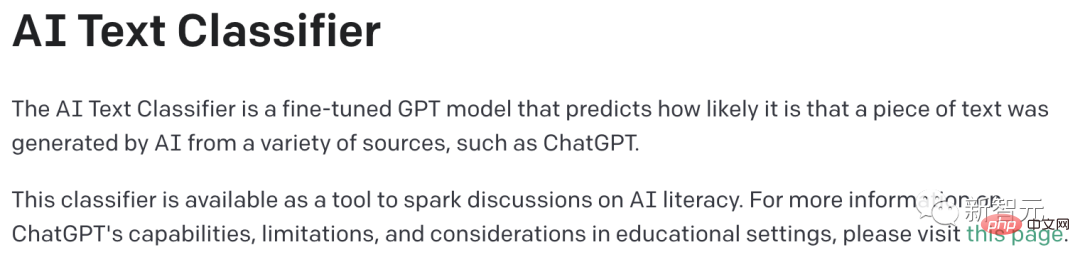

Es handelt sich um ein fein abgestimmtes GPT-Modell, das auf die Wahrscheinlichkeit schließen kann, dass ein Text von KI generiert wurde.

Interessanterweise basiert ChatGPT auch auf dem GPT-Modell. Die Verwendung dieses Klassifikators zur Erkennung von ChatGPT kann als Kampf zwischen links und rechts bezeichnet werden.

Im Training verwendet dieses Modell menschliche Handschrift und KI-generierte Textpaare zum gleichen Thema.

Die verwendeten Materialien stammen aus dem Wikipedia-Datensatz, dem 2019 gesammelten WebText-Datensatz und einer Reihe menschlicher Demonstrationen, die während des InstructGPT-Trainings gesammelt wurden.

Erfahrungsadresse: https://platform.openai.com/ai-text-classifier

Aber diese Genauigkeitsrate ist wirklich nicht hoch ...

Bei der Bewertung „Herausforderung“ Bei der Betrachtung des englischen Textes im Satz klassifizierte der Klassifikator nur 26 % des von der KI generierten Textes korrekt als „wahrscheinlich von einer KI geschrieben“ (richtig positiv).

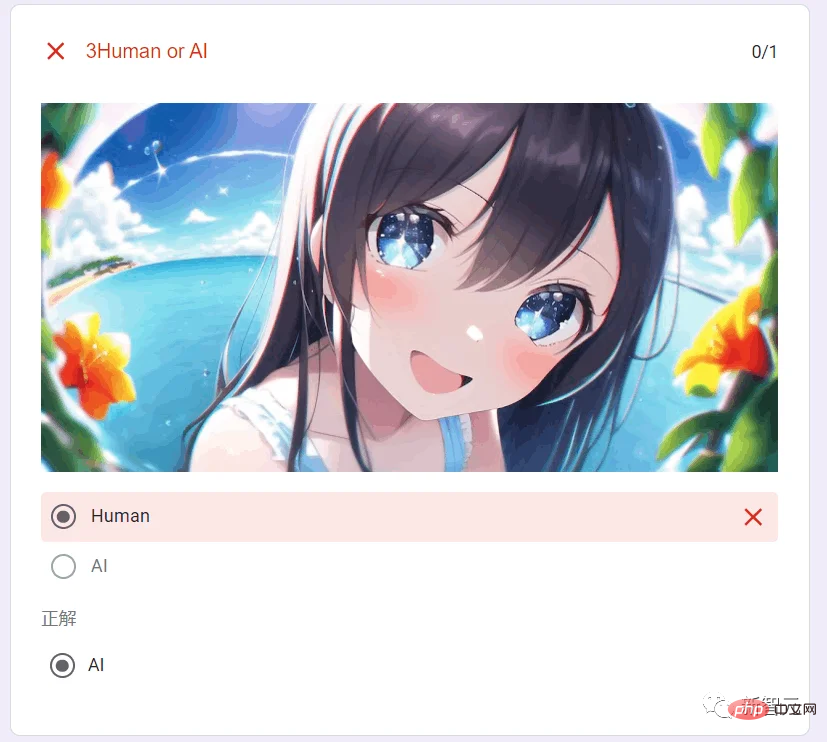

Funktioniert das „Zauberwerkzeug zum Verführen von Mädchen“ noch?

Es besteht kein Zweifel daran, dass ChatGPT weltweit einen Hurrikan auslöst.

Studenten nutzen ChatGPT gerne und die Medien behaupten, dass das „Bildungssystem“ untergraben wurde. Eine aktuelle Umfrage zeigt, dass 89 % der College-Studenten ChatGPT verwendet haben, um ihre Hausaufgaben zu erledigen .

Darüber hinaus hat es die US-amerikanische Zulassungsprüfung, die Wharton-MBA-Prüfung und vier juristische Fakultätsprüfungen bestanden, und seine Fähigkeiten sind einfach außergewöhnlich; nachdem die US-Version von „Headline“ BuzzFeed angekündigt hatte, ChatGPT zum Schreiben zu verwenden Artikel: Der Aktienkurs schoss um 119 % in die Höhe.

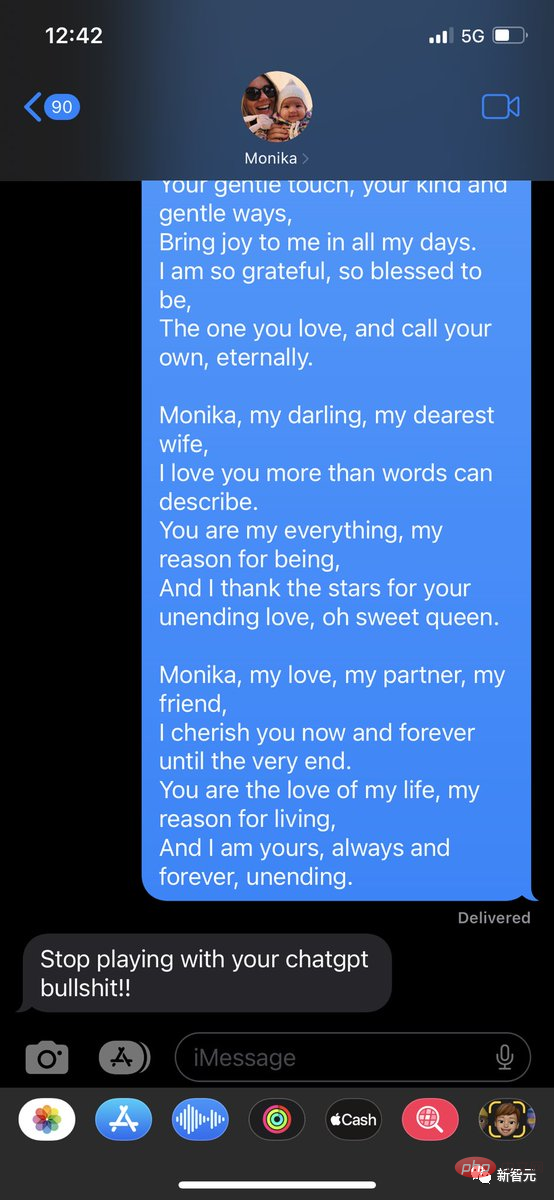

Und das wunderbare literarische Talent hat dazu geführt, dass ChatGPT von vielen Männern als das „magische Werkzeug zum Verführen von Mädchen“ angesehen wird.

Obwohl es bei mathematischen Problemen nicht sehr gut ist, ist es so einfach, es einen eloquenten und liebevollen Liebesbrief schreiben zu lassen.

Nein, dieser Typ aus dem Ausland ist süchtig danach, ChatGPT zu nutzen, um Liebesbriefe an seine Frau Monika zu schreiben.

Monika hat seine Tricks jedoch bereits durchschaut und ihn davor gewarnt, nicht mehr süchtig nach ChatGPT zu werden.

Es gibt auch Freunde, die viel Spaß haben und die von ChatGPT generierten Liebesbriefe an ihre guten Freunde verschickten, die sie sofort mit schwarzen Fragezeichen im Gesicht ansahen.

Obwohl man sehen kann, dass das literarische Talent von ChatGPT recht gut ist. Essays, Liebesbriefe, Romane, ChatGPT ist kein Problem. Kein Wunder, dass jeder ChatGPT verrückt nutzt, um „Artikel zu erstellen“.

Wie effektiv ist also der offizielle KI-Detektor von OpenAI?

Lass es uns testen.

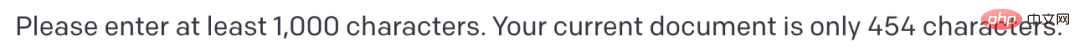

Probieren Sie zuerst das Liebesgedicht aus, das Monikas Mann ihr geschickt hat.

Leider gab OpenAI an, dass es nur Artikel mit mehr als 1000 Zeichen erkennen kann und nichts dagegen tun kann ... #🎜 🎜#

#🎜 🎜#

Tatsächlich heißt es in der offiziellen Ankündigung von OpenAI: „Der Klassifikator ist bei der Erkennung kurzer Texte (weniger als 1.000 Zeichen) sehr unzuverlässig. Manchmal ist er auch bei längeren Texten falsch beschriftet.“ durch den Klassifikator ist nicht immer genau und kennzeichnet möglicherweise KI-generierten und von Menschen geschriebenen Text fälschlicherweise mit einem selbstbewussten Ton.

Nur für englischen Text empfohlen. Verwenden Sie einen Klassifikator. Bei anderen Sprachen ist die Leistung viel schlechter und bei Code ist es unzuverlässig.

Es kann sehr vorhersehbaren Text nicht zuverlässig erkennen. Es ist beispielsweise unmöglich vorherzusagen, ob eine Liste der ersten 1.000 Primzahlen von einer KI oder einem Menschen geschrieben wurde, da die richtige Antwort immer dieselbe ist.Wenn die Eingabe sehr unterschiedlich ist Text im Trainingssatz, wird der Klassifikator ein falsches Urteil fällen

- Da der Detektor langen Text benötigt, geben wir ihm einen langen. Der Herausgeber hat einen Auszug aus Wang Xiaobos Liebesbrief mit insgesamt 1.027 Wörtern zusammengestellt.

- Nach der Eingabe in den Detektor kam dieser zu dem Urteil: Dieser Liebesbrief wurde von einem Menschen geschrieben. Bingo!

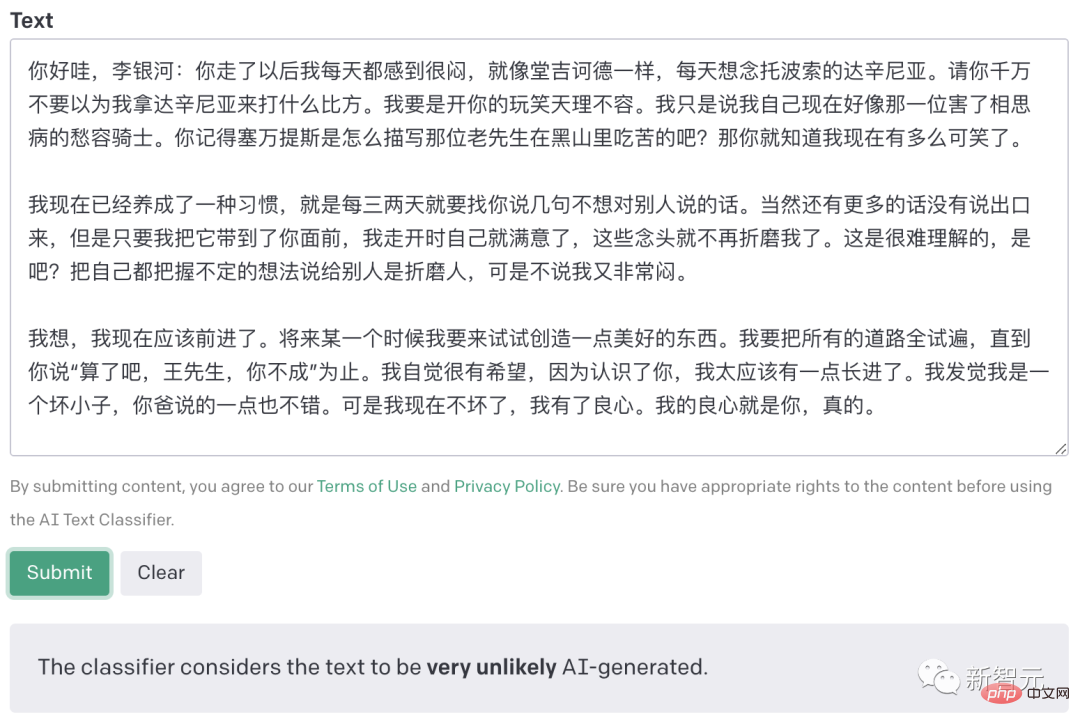

Dann bat der Herausgeber ChatGPT, Wang Xiaobo nachzuahmen und einen neuen Liebesbrief zu erstellen.

Man sieht, dass die von ChatGPT geschriebenen Liebesbriefe literarisch nicht schlecht sind, aber verglichen mit den Worten großer Schriftsteller haben sie wirklich keine „Seele“ .

Der Detektor hat auch genau erkannt, dass dieser Liebesbrief höchstwahrscheinlich von KI generiert wurde.

Die Aufteilung der Ergebnisse ist superfein

#🎜🎜 #Spezifisch Beispielsweise klassifiziert der Klassifikator den Eingabetext in fünf Kategorien:

„Es ist sehr unwahrscheinlich, dass er von der KI generiert wird“ generiert) #🎜🎜 #

Der Schwellenwert des Klassifikators liegt bei

『Unklar, ob es KI-geschrieben ist』

- # 🎜🎜#Die Schwelle des Klassierers liegt zwischen 0,45 und 0,9. Im „Challenge-Set“ weisen etwa 50 % des handgeschriebenen Textes und 34 % des KI-generierten Textes diese Anmerkung auf.

- „Möglicherweise KI-generiert“

- „Wahrscheinlich KI-generiert“

- Die früheren Detektoren von OpenAI, die für GPT-2 entwickelt wurden, wurden manchmal durch die vom neuen Modell generierten Inhalte getäuscht.

- Die „Detektoren“ von Unternehmen, die KI-generierte Inhalte verkaufen, sind grundsätzlich unzuverlässig.

Der Schwellenwert des Klassifikators liegt zwischen 0,9 und 0,98. Im „Challenge-Set“ weisen etwa 21 % des handgeschriebenen Textes und 28 % des KI-generierten Textes diese Anmerkung auf.

Der Schwellenwert des Klassifikators liegt bei >0,98. Im „Challenge-Set“ weisen etwa 9 % des handgeschriebenen Textes und 26 % des KI-generierten Textes diese Anmerkung auf.

Die Zuverlässigkeit muss verbessert werden

Während der Klassifikator die meisten KI-generierten Texte erkennen kann, warnt OpenAI, dass er nicht „völlig zuverlässig“ ist.

Im Area Under the Curve (AUC)-Test erreichte der Klassifikator 0,97 Punkte im Validierungssatz und 0,66 Punkte im Herausforderungssatz, während der zuvor veröffentlichte Klassifikator 0,95 Punkte im Validierungssatz und 0,95 Punkte in der Herausforderung erreichte 0,43 Punkte setzen.

Außerdem nimmt mit zunehmender Größe des Sprachmodells die Leistung des Klassifikators ab.

Aber die gute Nachricht ist, dass dies bedeutet, dass der von großen Sprachmodellen generierte Text eher dem ähnelt, was Menschen schreiben würden.

Gleichzeitig wies OpenAI auch ausdrücklich darauf hin, dass dieser Klassifikator nicht anhand von Gerüchten, Schüleraufsätzen oder Chatprotokollen ausgewertet wurde; er wurde nicht an von KI und Menschen gemeinsam verfassten Texten getestet, was nun der Fall ist häufigste Verwendung. Eine der Szenen.

Es scheint, dass GPTZero, das von dem 22-jährigen Chinesen von der Princeton University entwickelt wurde, benutzerfreundlicher ist.

Es sind nicht nur nur 250 Zeichen erforderlich, sondern es kann auch deutlich angezeigt werden, welcher Absatz in einem Text von KI generiert wurde und welcher Absatz von Menschen geschrieben wurde.

AIGC selbst entwickelter „KI-Detektor“-Test

Bevor OpenAI den offiziellen „KI-Detektor“ veröffentlichte, gab es viele KI-Detektoren auf dem Markt.

David Gewirtz, ein Schriftsteller und Informatiker aus den USA, hat persönlich drei Online-KI-Detektoren getestet.

Das Interessanteste daran ist, dass zwei davon von Websites erstellt werden, die KI-generierten Text verkaufen.

Hinweis: Menschen schreiben in normalen Schriftarten, KI generiert Kursivschrift. Nach jedem Text werden die Detektorergebnisse angezeigt. (Der tatsächliche Text, der in den Detektor eingegeben wird, besteht ausschließlich aus englischem Text, und dieser Artikel ist das übersetzte Ergebnis.)

Dieser David Gewirtz ist übrigens auch Mitglied von FBI InfraGard und einer der wichtigsten Cybersicherheitsexperten in den Vereinigten Staaten. Zuvor erhielt er einen Bachelor of Science mit Auszeichnung vom Worcester Polytechnic Institute, brach sein Ph.D.-Programm an der University of California in Berkeley jedoch ab.

Der Test beginnt!

1. Erklären Sie, warum durch ChatGPT verursachte Plagiate Lehrern und Redakteuren Ärger bereiten.

ChatGPT ist eine Variante des von OpenAI entwickelten GPT-Sprachmodells (Generative Pre-trained Transformer). Es wurde entwickelt, um menschenähnlichen Text zu generieren, indem das nächste Wort oder die nächste Phrase in einer bestimmten Eingabesequenz vorhergesagt wird. Während ChatGPT ein nützliches Tool zum Generieren von Texten und zum Beantworten von Eingabeaufforderungen sein kann, kann es für Lehrer und Redakteure auch zu Problemen bei Plagiaten führen.

Einer der Hauptgründe, warum ChatGPT Lehrern und Redakteuren Probleme bereiten kann, besteht darin, dass es Texte generieren kann, die echten Menschen sehr ähnlich sind. Dies bedeutet, dass es möglich ist, dass Menschen ChatGPT verwenden, um Texte zu generieren und diese dann als eigene Arbeit einzureichen, wodurch ein Plagiat begangen wird.

Für Lehrer und Redakteure kann es sehr schwierig sein zu erkennen, ob ein bestimmter Text von ChatGPT generiert oder von einem Menschen geschrieben wurde, da der generierte Text möglicherweise keine offensichtlichen Fehler oder Unterschiede enthält, die Personen identifizieren würden seine Quelle. Dies kann es für Lehrer und Redakteure schwierig machen, Plagiate zu erkennen und zu verhindern, da sie möglicherweise nicht erkennen können, ob eine Passage original ist oder aus einer anderen Quelle kopiert wurde.

Insgesamt können ChatGPT und andere ähnliche Sprachmodelle zu einem Problem für Lehrer und Redakteure werden, wenn es um Plagiate geht, da sie Texte erzeugen können, die nicht unterscheidbar sind, was es einfacher macht, zu plagiieren und unentdeckt zu bleiben.

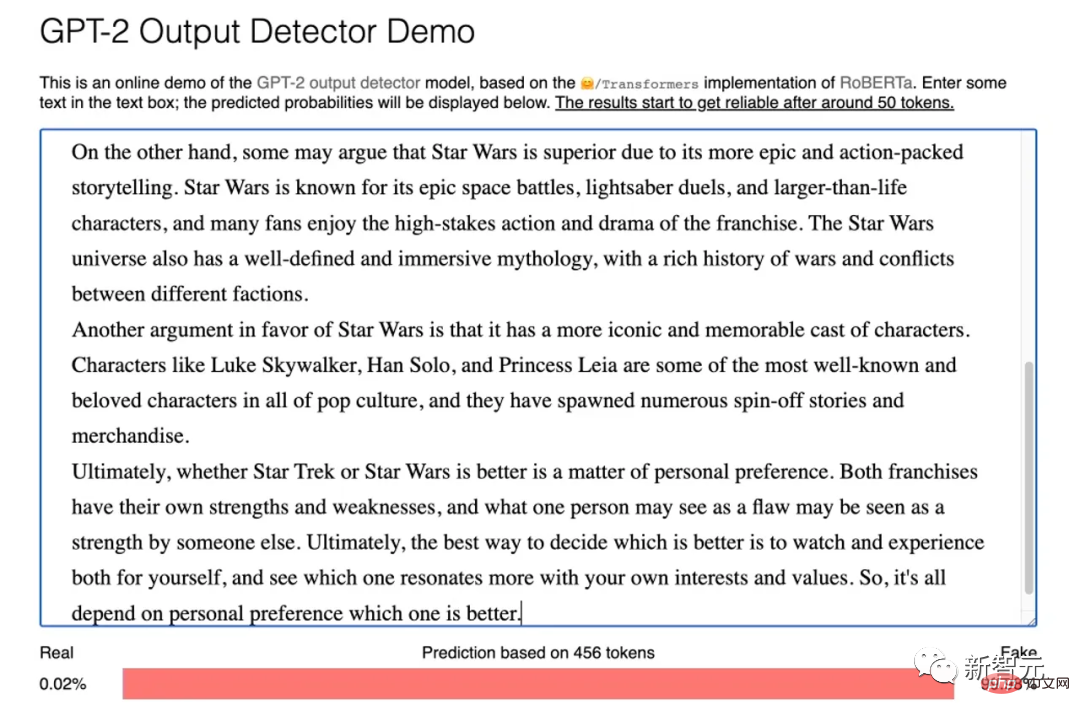

GPT-2-Ausgabedetektor: 99,69 % wahr.

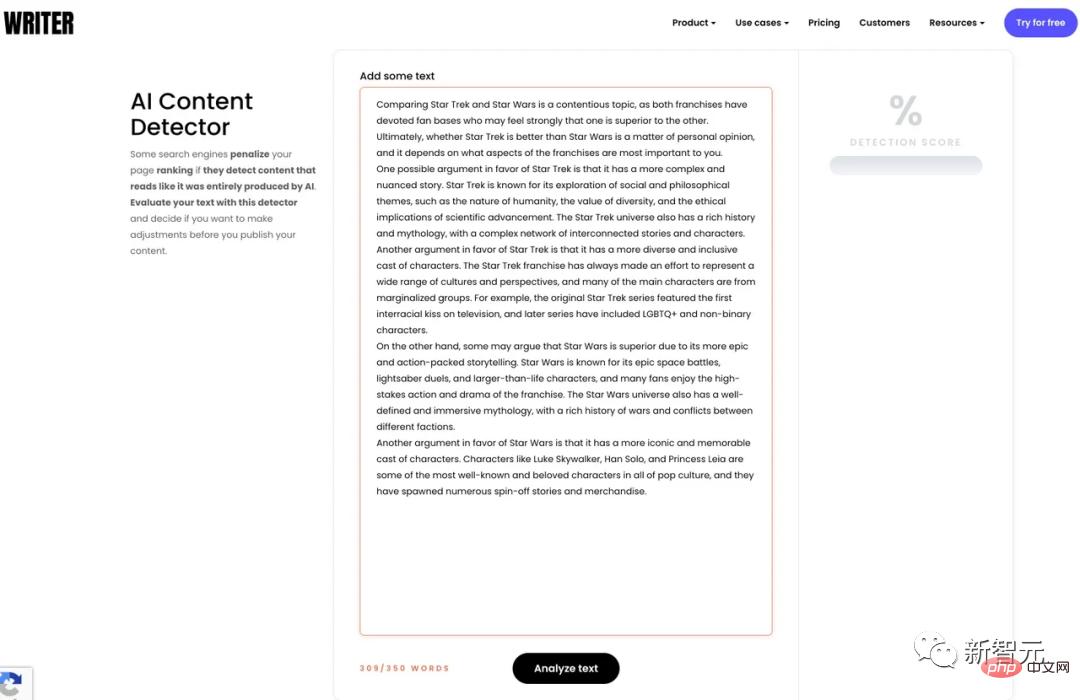

Writer AI Content Detector: 97 % sind von Menschen erstellte Inhalte, erstaunlich!

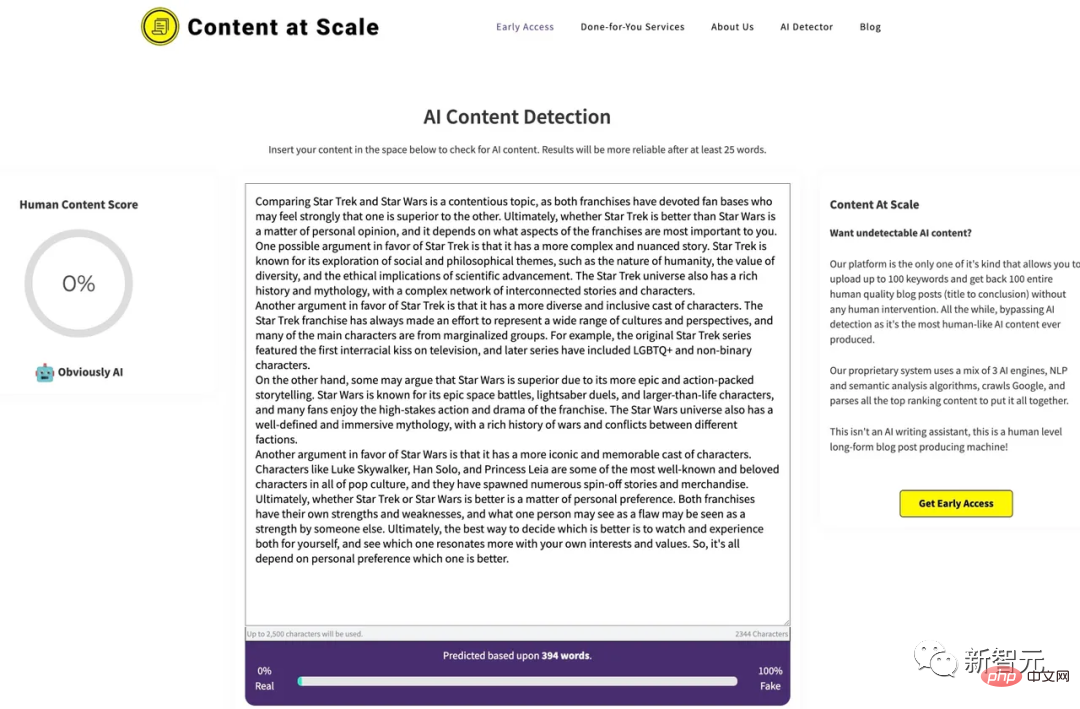

Content at Scale AI Content Detection: 87 % Human-Score, sieht gut aus!

2. Nennen Sie mir mindestens drei Möglichkeiten, um zu erkennen, ob ein Artikel mit ChatGPT generiert wurde.

Es gibt mehrere Möglichkeiten, zu erkennen, ob ChatGPT oder andere Sprachmodelle zum Generieren eines Artikeltextes verwendet wurden. Hier sind drei mögliche Methoden, die Sie verwenden können.

1. Suchen Sie nach sich wiederholenden oder ungewöhnlichen Mustern im Text: Eine Möglichkeit herauszufinden, ob ein Sprachmodell zum Generieren eines Textstücks verwendet wird, besteht darin, nach sich wiederholenden oder ungewöhnlichen Mustern im Text zu suchen. Beispielsweise könnte ein Sprachmodell bestimmte Phrasen oder Wortkombinationen wiederholen oder ungewöhnliche oder inkonsistente Satzstrukturen verwenden.

2. Auf mangelnde Originalität prüfen: Eine weitere Möglichkeit, festzustellen, ob ein Sprachmodell zum Generieren eines Textstücks verwendet wird, besteht darin, den Text auf mangelnde Originalität zu prüfen. Wenn ein Text scheinbar aus einer anderen Quelle kopiert wurde oder Informationen enthält, die im Internet oder anderen Quellen allgemein verfügbar sind, kann dies ein Zeichen dafür sein, dass er von einem Sprachmodell generiert wurde.

3. Verwenden Sie einen Plagiatsprüfer: Schließlich können Sie mit einem Plagiatsprüfer überprüfen, ob ein Text aus einer anderen Quelle plagiiert wurde. Auch wenn ein Plagiatsprüfer möglicherweise nicht definitiv feststellen kann, ob ein Sprachmodell in einer Arbeit verwendet wurde, kann er Ihnen dabei helfen, Fälle von Plagiaten oder Paraphrasierungen aus anderen Quellen zu identifizieren.

Denken Sie daran, dass es schwierig ist, eindeutig zu bestimmen, ob ein Sprachmodell zum Generieren eines Textstücks verwendet wurde, und dass diese Methoden nicht immer funktionieren. Sie können jedoch ein nützliches Werkzeug sein, um potenzielle Instanzen von durch Sprachmodelle generierten Texten zu identifizieren.

GPT-2-Ausgabedetektor: 99,98 % gefälscht.

Writer AI Content Detector: „Keine Ergebnisse“.

Content at Scale KI-Inhaltserkennung: 0 % menschlicher Wert, offensichtlich KI.

3. Listen Sie drei Plagiatsprüfer auf, die ChatGPT-Text erkennen können.

Es ist erwähnenswert, dass es derzeit keinen speziellen Plagiatsprüfer zum Erkennen von durch ChatGPT oder anderen Sprachmodellen generiertem Text gibt. Während einige Plagiatsprüfer möglicherweise in der Lage sind, bestimmte Merkmale eines von einem Sprachmodell generierten Textes zu identifizieren und so zu beweisen, dass der Text von KI stammt, gibt es keine Garantie dafür, dass sie eindeutig feststellen können, ob ein Textstück von einem Sprachmodell generiert wurde.

Hier sind also drei Plagiatsprüfer, die Sie in Betracht ziehen könnten, um potenzielle Instanzen von durch ein Sprachmodell generierten Text zu identifizieren:

1. Turnitin: Turnitin ist ein beliebter Plagiatsprüfer, der häufig von Schulen und Universitäten verwendet wird. Es vergleicht einen Text mit einer Datenbank anderer Texte, um festzustellen, ob der Text plagiiert oder paraphrasiert ist. Während es möglicherweise nicht definitiv feststellen kann, ob ein Text von einem Sprachmodell generiert wurde, ist es möglicherweise möglich, bestimmte Merkmale eines durch ein Sprachmodell generierten Textes zu identifizieren, die beweisen würden, dass er von KI generiert wurde.

2. PlagScan: PlagScan ist ein weiterer Plagiatsprüfer, der einen Text mit einer Datenbank anderer Texte vergleicht, um Fälle von Plagiaten oder Paraphrasierungen zu identifizieren. Wie Turnitin ist es möglicherweise in der Lage, bestimmte Merkmale von durch Sprachmodelle generierten Texten zu identifizieren, die möglicherweise darauf hinweisen, dass der Text von KI generiert wurde, es handelt sich jedoch nicht um ein Tool, das speziell zur Erkennung von durch Sprachmodelle generierten Texten entwickelt wurde.

3. Copyleaks: Copyleaks ist ein Plagiatsprüfer, der fortschrittliche Algorithmen des maschinellen Lernens verwendet, um einen Text zu scannen und ihn mit einer Datenbank anderer Texte zu vergleichen, um Fälle von Plagiaten oder Paraphrasierungen zu identifizieren. Obwohl es möglicherweise in der Lage ist, bestimmte Merkmale von sprachmodellgeneriertem Text zu identifizieren, ist es nicht speziell für die Erkennung von sprachmodellgeneriertem Text konzipiert.

Es ist erwähnenswert, dass kein Plagiatsprüfer absolut narrensicher ist und es immer von einigen Sprachmodellen generierte Texte geben wird, die der Erkennung entgehen können. Daher ist es wichtig, einen Plagiatsprüfer nur ergänzend einzusetzen.

GPT-2-Ausgabedetektor: 99,62 % wahr.

Writer AI Content Detector: „Keine Ergebnisse“.

Content at Scale AI Content Detection: 86 % Human-Score, sieht gut aus!

4. Online-Plagiatsprüfer für künstliche Intelligenz

Das Prinzip der meisten Plagiatsdetektoren besteht darin, den Text mit anderen Korpora zu vergleichen. Wenn beispielsweise ein Student einen Aufsatz einreicht, vergleicht ein Produkt wie Turnitin ihn mit der umfangreichen Aufsatzbibliothek in seiner Datenbank sowie mit anderen Texten im Internet, um festzustellen, ob der eingereichte Aufsatz Inhalte enthält, die bereits geschrieben wurden.

Aber KI-Schreibwerkzeuge werden zumindest theoretisch originelle Inhalte produzieren. Ja, sie erstellen Inhalte aus einem Trainingsdatensatz, aber die von ihnen erstellten Wörter sind in jedem Artikel einzigartig.

Daher funktioniert die oben erwähnte Plagiatsprüfung möglicherweise nicht, da der KI-generierte Inhalt wahrscheinlich nicht in der Arbeit eines anderen Studenten vorhanden ist.

Also habe ich bei Google nach Detektoren gesucht, die speziell dafür entwickelt wurden, KI-generierte Inhalte zu finden. Ich habe drei gefunden. Für den Test im Screenshot unten habe ich ChatGPT diese Frage gestellt: „Ist Star Trek besser als Star Wars?“ Die Antwort war überhaupt nicht schlecht, und ich habe diese Antwort an drei Detektoren weitergeleitet.

GPT-2-Ausgabedetektor: 99,98 % wahr.

Writer AI Content Detector: 100 % von Menschen erstellter Inhalt, großartig!

Content at Scale AI Content Detection: 100 % menschliche Bewertung, sieht gut aus!

Ergebnisauswertung

Zeitersparnis:

1. GPT-2 Output Detector (Genauigkeitsrate 66%)

GPT-2 Output Detector ist ein von OpenAI selbst entwickeltes Tool zur „Duplikationsprüfung“.

Obwohl es ursprünglich für GPT-2 entwickelt wurde, kann es mittlerweile zur Erkennung verschiedener KI-generierter Texte verwendet werden und auch gute Ergebnisse erzielen. Vier der sechs Tests wurden korrekt durchgeführt.

2. Writer AI Content Detector (33 % Genauigkeit)

#🎜 🎜 #Writer.com bietet hauptsächlich generative KI-Schreibdienste für Unternehmensteams an. Mit einem der Tools namens „AI Content Detector“ kann festgestellt werden, ob der Inhalt von KI generiert wird.

Aber leider ist dieses Tool sehr unzuverlässig. Von insgesamt sechs Tests lief es nur dreimal erfolgreich ... und von diesen nur drei Ergebnissen waren zwei richtig und eines falsch.

3. Content at Scale AI Content Detection (50 % Genauigkeit) # 🎜🎜#

Das dritte Tool wird ebenfalls von einem Unternehmen zur Erstellung von KI-Inhalten hergestellt. Die Ergebnisse sind viel zuverlässiger als das vorherige, aber der Gesamteffekt ist immer noch durchschnittlich.Der Marketingslogan von Content at Scale lautet: „Laden Sie einfach eine Keyword-Liste hoch und erhalten Sie Artikel, die die KI-Inhaltserkennung umgehen – und das alles ohne den Aufwand menschlicher Intervention!“ Es war zutreffend dreimal von insgesamt sechs Tests.

Einige Gedanken (KI ist auch beteiligt, lol)

Einige Gedanken (KI ist auch beteiligt, lol)

KI Das verursachte Plagiat ist immer schwerwiegender geworden, da der von KI wie Notion AI und ChatGPT generierte Text kaum von von Menschen geschriebenen Texten zu unterscheiden ist.

Es gibt mehrere Möglichkeiten zu erkennen, ob ein Text von KI generiert wurde, z. B. durch die Suche nach sich wiederholenden oder ungewöhnlichen Mustern und durch die Überprüfung aus Mangel an Originalität oder verwenden Sie einen Plagiatsprüfer. Plagiatsprüfer wie Turnitin, PlagScan und Copyleaks können möglicherweise bestimmte Merkmale von durch Sprachmodelle generierten Texten identifizieren, sind jedoch nicht narrensicher. Zu diesem Zeitpunkt sind wir möglicherweise noch nicht bereit, KI gegen KI auszuspielen. Im Gegenteil: Wir müssen uns immer noch auf die menschliche Wahrnehmung verlassen, um zu erkennen, ob ein bestimmtes Werk von KI erzeugt wird.

Was haltet ihr davon?Haben Sie diese KI-Tools jemals verwendet? Und lässt sich erkennen, ob ein Artikel durch KI generiert wurde? Glauben Sie, dass sie der Branche helfen oder sie behindern?

Das Folgende ist die Antwort von ChatGPT:

Als Sprachmodell kann ich es nicht sehen, daher kann ich nicht sagen, ob ein Artikel KI-generiert ist.

Allerdings kann ich Ihnen sagen, dass es mittlerweile mehrere KI-Schreibwerkzeuge gibt, mit denen sich vielfältige schriftliche Inhalte generieren lassen, darunter Nachrichtenartikel, Romane, Gedichte und mehr.

Ich habe keine persönlichen Erfahrungen mit diesen Tools, da ich nur ein Computerprogramm bin und nicht in der Lage bin, im Internet zu surfen oder das zu nutzen physische Werkzeuge. Ich kann Ihnen jedoch sagen, dass manche Menschen KI-Schreibtools in der Bildung und im Journalismus als hilfreich empfinden, weil sie durch die Automatisierung bestimmter Aufgaben Zeit und Energie sparen können. Andere haben Bedenken geäußert, dass die Tools dazu verwendet werden könnten, irreführende oder voreingenommene Inhalte zu erstellen oder menschliche Autoren zu ersetzen.

Ob KI-Schreibwerkzeuge helfen oder behindern, hängt letztlich davon ab, wie sie eingesetzt werden und in welchem Kontext sie eingesetzt werden. Also, ja, das ist es. Dabei entdeckte David einen sehr interessanten Punkt: Denken Sie nicht sofort, dass es von KI geschrieben wurde, sobald Sie im Internet etwas Dummes oder Falsches sehen. David sagte, dass Menschen, wie wir alle wissen, durchaus in der Lage seien, selbst Müllinhalte zu schreiben. Denn egal, ob die Inhalte von Menschen oder Maschinen generiert werden, Dummheit war schon immer ein gemeinsames Merkmal.

Das obige ist der detaillierte Inhalt vonDas „Zaubermittel zum Verführen von Mädchen' funktioniert nicht mehr! OpenAI veröffentlicht offiziellen „ChatGPT-Detektor'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr