Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI Von Papieren bis hin zu Code, von Spitzenforschung bis hin zu industrieller Umsetzung: Verstehen Sie die BEV-Wahrnehmung umfassend

Von Papieren bis hin zu Code, von Spitzenforschung bis hin zu industrieller Umsetzung: Verstehen Sie die BEV-Wahrnehmung umfassend

BEV Was genau ist Wahrnehmung? Auf welche Aspekte der Wahrnehmung von BEV achten sowohl die akademischen als auch die industriellen Kreise des autonomen Fahrens? Dieser Artikel verrät Ihnen die Antwort.

Im Bereich des autonomen Fahrens ist es ein Trend, dem Wahrnehmungsmodell eine leistungsstarke Darstellung aus der Vogelperspektive (BEV) erlernen zu lassen, und hat in diesem Jahr für Aufmerksamkeit gesorgt der Branche und der breiten akademischen Aufmerksamkeit. Im Vergleich zu den meisten früheren Modellen im Bereich des autonomen Fahrens, die auf der Ausführung von Aufgaben wie Erkennung, Segmentierung und Verfolgung in der Vorderansicht oder perspektivischen Ansicht basieren, ermöglicht die Darstellung aus der Vogelperspektive (BEV) dem Modell, verdeckte Fahrzeuge besser zu identifizieren und Hat Erleichtert die Entwicklung und Bereitstellung nachfolgender Module (z. B. Planung, Steuerung).

Es ist ersichtlich, dass die BEV-Wahrnehmungsforschung einen enormen potenziellen Einfluss auf den Bereich des autonomen Fahrens hat und langfristige Aufmerksamkeit und Investitionen von Wissenschaft und Industrie verdient ist BEV-Wahrnehmung? Was ist das? Auf welche Inhalte der BEV-Wahrnehmung achten akademische und industrielle Führungskräfte im Bereich autonomes Fahren? Dieser Artikel verrät Ihnen die Antwort durch BEVPerception Survey.

BEVPerception Survey ist Shanghai Artificial Intelligence Laboratory Autonomous Driving OpenDriveLab-Team und # 🎜 🎜#SenseTime Research InstituteDie praktische Tool-Präsentationsmethode des Gemeinschaftspapiers „Delving into the Devils of Bird's-eye-view Perception: A Review, Evaluation and Recipe“, #🎜 🎜 #Es ist in zwei Hauptabschnitte unterteilt: die neueste Literaturrecherche auf Basis von BEVPercption und die Open-Source-BEV-Perception-Toolbox auf Basis von PyTorch.

- Papieradresse: https:/ /arxiv.org/abs/2209.05324

- Projektadresse: https://github.com/OpenPerceptionX/BEVPerception-Survey-Recipe Zusammenfassende Interpretation, technische Interpretation

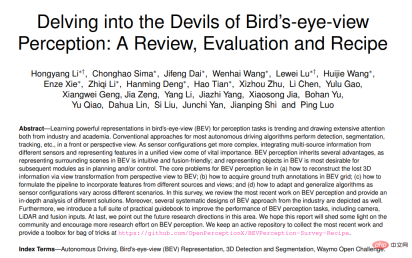

BEV-Kamera, BEV-Lidar und BEV-Fusion . BEV-Kamera stellt einen reinen oder visionszentrierten Algorithmus für die 3D-Objekterkennung oder -segmentierung von mehreren umgebenden Kameras dar. BEV-Lidar beschreibt die Erkennungs- oder Segmentierungsaufgabe von Punktwolkeneingaben. BEV-Fusion beschreibt die Erkennungs- oder Segmentierungsaufgabe von Eingabefusionsmechanismen mehrerer Sensoren wie Kameras, Lidar, globale Navigationssysteme, Odometrie, HD-Karten, CAN-Bus usw.

BEV Perception Toolbox ist für BEV-basierte Kameras. Bietet eine Plattform für die 3D-Objekterkennung und eine experimentelle Plattform für den Waymo-Datensatz, die manuelle Tutorials und Experimente mit kleinen Datensätzen ermöglicht.

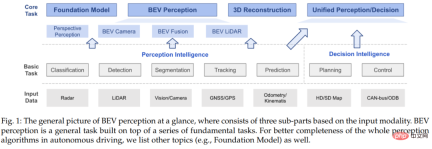

Insbesondere BEV-Kamera stellt einen Algorithmus zur 3D-Objekterkennung oder -Segmentierung von mehreren umgebenden Kameras dar; BEV-Lidar stellt die Verwendung von Punktwolken als Eingabe zur Vervollständigung von Erkennungs- oder Segmentierungsaufgaben dar. Es nutzt die Ausgabe mehrerer Sensoren als Eingabe, wie z. B. Kameras, LiDAR, GNSS, Kilometerzähler, HD-Karte, CAN-Bus usw. #? 🎜 #Die Wahrnehmung der BEV-Kamera umfasst drei Teile: 2D-Feature-Extraktor, Ansichtstransformation und 3D-Decoder. Die folgende Abbildung zeigt das BEV-Kamerawahrnehmungsflussdiagramm. Bei der Ansichtstransformation gibt es zwei Möglichkeiten, 3D-Informationen zu kodieren: Die eine besteht darin, Tiefeninformationen aus 2D-Merkmalen vorherzusagen, und die andere darin, 2D-Merkmale aus dem 3D-Raum abzutasten.

Abbildung 2: BEV-Kamera-Wahrnehmungsflussdiagramm

Für den 2D-Feature-Extraktor gibt es viel Erfahrung in der 2D-Wahrnehmungsaufgabe, die in die 3D-Wahrnehmungsaufgabe übernommen werden kann, wie z Form des Hauptinterventionstrainings.

Das Ansichtskonvertierungsmodul ist ein ganz anderer Aspekt als das 2D-Wahrnehmungssystem. Wie in der Abbildung oben gezeigt, gibt es im Allgemeinen zwei Möglichkeiten, eine Ansichtstransformation durchzuführen: Eine ist die Transformation vom 3D-Raum in den 2D-Raum, die andere ist die Transformation vom 2D-Raum in den 3D-Raum. Diese beiden Transformationsmethoden verwenden entweder den 3D-Raum Vorkenntnisse der Physik im System oder Nutzung zusätzlicher 3D-Informationen zur Überwachung. Es ist erwähnenswert, dass nicht alle 3D-Wahrnehmungsmethoden über Ansichtstransformationsmodule verfügen. Beispielsweise erkennen einige Methoden Objekte im 3D-Raum direkt anhand von Features im 2D-Raum.

3D-Decoder empfängt Funktionen im 2D/3D-Raum und gibt 3D-Wahrnehmungsergebnisse aus. Die meisten 3D-Decoder basieren auf LiDAR-basierten Wahrnehmungsmodellen. Diese Methoden führen die Erkennung im BEV-Raum durch, es gibt jedoch immer noch einige 3D-Decoder, die Funktionen im 2D-Raum ausnutzen und die Lokalisierung von 3D-Objekten direkt regressieren.

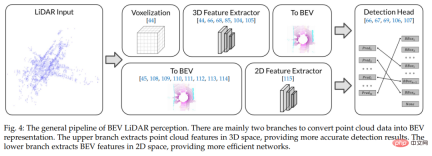

BEV LiDAR

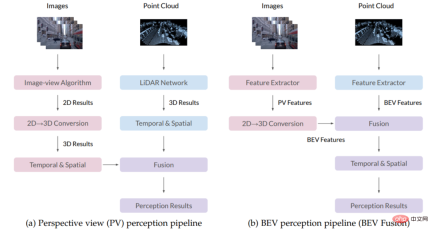

BEV Der allgemeine Prozess der LiDAR-Wahrnehmung umfasst hauptsächlich zwei Zweige, um Punktwolkendaten in eine BEV-Darstellung umzuwandeln. Die folgende Abbildung zeigt das BEV-Lidar-Erkennungsflussdiagramm. Der obere Zweig extrahiert Punktwolkenmerkmale im 3D-Raum, um genauere Erkennungsergebnisse zu liefern. Der untere Zweig extrahiert BEV-Merkmale im 2D-Raum und sorgt so für ein effizienteres Netzwerk. Zusätzlich zu punktbasierten Methoden, die auf rohen Punktwolken arbeiten, voxelbasierte Methoden, die Punkte in diskrete Gitter voxelisieren und durch die Diskretisierung kontinuierlicher 3D-Koordinaten eine effizientere Darstellung ermöglichen. Basierend auf der diskreten Voxeldarstellung können 3D-Faltung oder 3D-Sparse-Faltung zum Extrahieren von Punktwolkenmerkmalen verwendet werden. Abbildung 3: Flussdiagramm der BEV-Lidar-Erkennung Wissenschaft und Industrie . Die folgende Abbildung zeigt einen Vergleich der Flussdiagramme der PV- und BEV-Erkennung. Der Hauptunterschied zwischen den beiden ist das 2D-zu-3D-Konvertierungs- und Fusionsmodul. Im PV-fähigen Flussdiagramm werden die Ergebnisse verschiedener Algorithmen zunächst in den 3D-Raum umgewandelt und dann mithilfe einiger Vorkenntnisse oder manuell erstellter Regeln zusammengeführt. Im BEV-Wahrnehmungsflussdiagramm wird die PV-Feature-Map in die BEV-Perspektive konvertiert und dann im BEV-Raum zusammengeführt, um das Endergebnis zu erhalten, wodurch die Beibehaltung der ursprünglichen Feature-Informationen maximiert und übermäßiges manuelles Design vermieden wird.

Abbildung 4: Flussdiagramm für PV-Erfassung (links) und BEV-Erfassung (rechts)

Für BEV-Erfassungsmodelle geeignete DatensätzeEs gibt viele Datensätze für BEV-Erfassungsaufgaben. Normalerweise besteht ein Datensatz aus verschiedenen Szenen, und jede Szene hat in verschiedenen Datensätzen eine unterschiedliche Länge. Die folgende Tabelle fasst die in der akademischen Gemeinschaft häufig verwendeten Datensätze zusammen. Wir können sehen, dass der Waymo-Datensatz vielfältigere Szenen und umfangreichere 3D-Erkennungsfeldanmerkungen aufweist als andere Datensätze.

Tabelle 1: Übersicht über BEV-Sensordatensätze

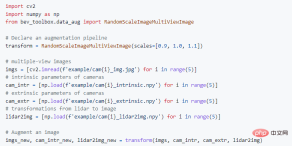

Allerdings gibt es derzeit keine von Waymo entwickelte Software für die BEV-Sensoraufgabe, die in der akademischen Gemeinschaft veröffentlicht wurde. Aus diesem Grund haben wir uns für eine Entwicklung basierend auf dem Waymo-Datensatz entschieden, in der Hoffnung, die Entwicklung von BEV-Wahrnehmungsaufgaben auf dem Waymo-Datensatz zu fördern. BEVFormer ist eine häufig verwendete BEV-Wahrnehmungsmethode. Sie verwendet einen raumzeitlichen Transformator, um die vom Backbone-Netzwerk aus Multi-View-Eingaben extrahierten Merkmale in BEV-Merkmale umzuwandeln und dann die BEV-Merkmale in die Erkennung einzugeben Gehen Sie, um die endgültigen Testergebnisse zu erhalten. BEVFormer verfügt über zwei Funktionen. Er verfügt über eine präzise Konvertierung von 2D-Bildfunktionen in 3D-Funktionen und kann die extrahierten BEV-Funktionen auf verschiedene Erkennungsköpfe anwenden. Wir haben die Ansichtskonvertierungsqualität und die endgültige Erkennungsleistung von BEVFormer durch eine Reihe von Methoden weiter verbessert. Nachdem wir mit BEVFormer++ den ersten PlatzCVPR 2022 Waymo Challenge gewonnen haben, haben wir Toolbox - BEV Perception Toolbox gestartet, indem wir einen vollständigen Satz benutzerfreundlicher Waymo Open Dataset-Datenverarbeitungstools bereitgestellt haben. Dies integriert eine Reihe von Methoden, die die Modellleistung erheblich verbessern können (einschließlich, aber nicht beschränkt auf Datenverbesserung, Erkennungsköpfe, Verlustfunktionen, Modellintegration usw.) und ist mit in diesem Bereich weit verbreiteten Open-Source-Frameworks wie mmdetection3d kompatibel und Detectron2. Im Vergleich zum grundlegenden Waymo-Datensatz optimiert und verbessert die BEV-Perception-Toolbox die Nutzungsfähigkeiten für die Verwendung durch verschiedene Arten von Entwicklern. Die folgende Abbildung zeigt ein Beispiel für die Verwendung der BEV-Awareness-Toolbox basierend auf dem Waymo-Datensatz. Abbildung 5: Toolbox-Nutzungsbeispiel basierend auf dem Waymo-Datensatz und eine ausführlichere ausführliche Diskussion. Eine umfassende Analyse der Literatur zur BEV-Erkennung deckt Kernthemen wie Tiefenschätzung, Ansichtstransformation, Sensorfusion, Domänenanpassung usw. ab und bietet eine detailliertere Erläuterung der Anwendung der BEV-Erkennung in industriellen Systemen. Neben theoretischen Beiträgen bietet BEVPerception Survey auch eine sehr praktische Toolbox zur Verbesserung der kamerabasierten 3D-Vogelperspektive (BEV)-Objekterkennungsleistung, einschließlich einer Reihe von Strategien zur Verbesserung von Trainingsdaten und einem effizienten Encoder-Design Verlustfunktion Design, Testdatenverbesserung und Modellintegrationsstrategien usw. sowie die Implementierung dieser Techniken im Waymo-Datensatz. Wir hoffen, mehr Forschern dabei zu helfen, „Use and Take“ zu erkennen und den Forschern in der Branche des autonomen Fahrens mehr Komfort zu bieten. Toolbox – BEV-Wahrnehmungs-Toolbox

Wir hoffen, dass BEVPerception Survey Benutzern nicht nur dabei hilft, leistungsstarke BEV-Wahrnehmungsmodelle einfach zu nutzen, sondern auch ein guter Ausgangspunkt für Anfänger für den Einstieg in BEV-Wahrnehmungsmodelle wird. Wir sind bestrebt, die Grenzen der Forschung und Entwicklung im Bereich des autonomen Fahrens zu durchbrechen und freuen uns darauf, unsere Ansichten und Diskussionen mit der akademischen Gemeinschaft zu teilen, um das Anwendungspotenzial der Forschung im Bereich des autonomen Fahrens in der realen Welt kontinuierlich zu erkunden.

Das obige ist der detaillierte Inhalt vonVon Papieren bis hin zu Code, von Spitzenforschung bis hin zu industrieller Umsetzung: Verstehen Sie die BEV-Wahrnehmung umfassend. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Lesen des AI-Index 2025: Ist AI Ihr Freund, Feind oder Co-Pilot?Apr 11, 2025 pm 12:13 PM

Lesen des AI-Index 2025: Ist AI Ihr Freund, Feind oder Co-Pilot?Apr 11, 2025 pm 12:13 PMDer Bericht des Stanford University Institute for Human-orientierte künstliche Intelligenz bietet einen guten Überblick über die laufende Revolution der künstlichen Intelligenz. Interpretieren wir es in vier einfachen Konzepten: Erkenntnis (verstehen, was geschieht), Wertschätzung (Sehenswürdigkeiten), Akzeptanz (Gesichtsherausforderungen) und Verantwortung (finden Sie unsere Verantwortlichkeiten). Kognition: Künstliche Intelligenz ist überall und entwickelt sich schnell Wir müssen uns sehr bewusst sein, wie schnell künstliche Intelligenz entwickelt und ausbreitet. Künstliche Intelligenzsysteme verbessern sich ständig und erzielen hervorragende Ergebnisse bei mathematischen und komplexen Denktests, und erst vor einem Jahr haben sie in diesen Tests kläglich gescheitert. Stellen Sie sich vor, KI zu lösen komplexe Codierungsprobleme oder wissenschaftliche Probleme auf Graduiertenebene-seit 2023-

Erste Schritte mit Meta Lama 3.2 - Analytics VidhyaApr 11, 2025 pm 12:04 PM

Erste Schritte mit Meta Lama 3.2 - Analytics VidhyaApr 11, 2025 pm 12:04 PMMetas Lama 3.2: Ein Sprung nach vorne in der multimodalen und mobilen KI Meta hat kürzlich Lama 3.2 vorgestellt, ein bedeutender Fortschritt in der KI mit leistungsstarken Sichtfunktionen und leichten Textmodellen, die für mobile Geräte optimiert sind. Aufbau auf dem Erfolg o

AV -Bytes: META ' S Lama 3.2, Googles Gemini 1.5 und mehrApr 11, 2025 pm 12:01 PM

AV -Bytes: META ' S Lama 3.2, Googles Gemini 1.5 und mehrApr 11, 2025 pm 12:01 PMDie KI -Landschaft dieser Woche: Ein Wirbelsturm von Fortschritten, ethischen Überlegungen und regulatorischen Debatten. Hauptakteure wie OpenAI, Google, Meta und Microsoft haben einen Strom von Updates veröffentlicht, von bahnbrechenden neuen Modellen bis hin zu entscheidenden Verschiebungen in LE

Die menschlichen Kosten für das Gespräch mit Maschinen: Kann sich ein Chatbot wirklich darum kümmern?Apr 11, 2025 pm 12:00 PM

Die menschlichen Kosten für das Gespräch mit Maschinen: Kann sich ein Chatbot wirklich darum kümmern?Apr 11, 2025 pm 12:00 PMDie beruhigende Illusion der Verbindung: Blühen wir in unseren Beziehungen zur KI wirklich auf? Diese Frage stellte den optimistischen Ton des "Fortschritts -Menschen mit AI) des MIT Media Lab in Frage. Während die Veranstaltung moderne EDG präsentierte

Verständnis der Scipy Library in PythonApr 11, 2025 am 11:57 AM

Verständnis der Scipy Library in PythonApr 11, 2025 am 11:57 AMEinführung Stellen Sie sich vor, Sie sind ein Wissenschaftler oder Ingenieur, der sich mit komplexen Problemen befasst - Differentialgleichungen, Optimierungsherausforderungen oder Fourier -Analysen. Pythons Benutzerfreundlichkeit und Grafikfunktionen sind ansprechend, aber diese Aufgaben erfordern leistungsstarke Tools

3 Methoden zum Ausführen von LLAMA 3.2 - Analytics VidhyaApr 11, 2025 am 11:56 AM

3 Methoden zum Ausführen von LLAMA 3.2 - Analytics VidhyaApr 11, 2025 am 11:56 AMMETAs Lama 3.2: Ein multimodales KI -Kraftpaket Das neueste multimodale Modell von META, Lama 3.2, stellt einen erheblichen Fortschritt in der KI dar, das ein verbessertes Sprachverständnis, eine verbesserte Genauigkeit und die überlegenen Funktionen der Textgenerierung bietet. Seine Fähigkeit t

Automatisierung von Datenqualitätsprüfungen mit DagsterApr 11, 2025 am 11:44 AM

Automatisierung von Datenqualitätsprüfungen mit DagsterApr 11, 2025 am 11:44 AMDatenqualitätssicherung: Automatisieren von Schecks mit Dagster und großen Erwartungen Die Aufrechterhaltung einer hohen Datenqualität ist für datengesteuerte Unternehmen von entscheidender Bedeutung. Wenn Datenvolumina und Quellen zunehmen, wird die manuelle Qualitätskontrolle ineffizient und anfällig für Fehler.

Haben Mainframes eine Rolle in der KI -Ära?Apr 11, 2025 am 11:42 AM

Haben Mainframes eine Rolle in der KI -Ära?Apr 11, 2025 am 11:42 AMMainframes: Die unbesungenen Helden der KI -Revolution Während die Server bei allgemeinen Anwendungen und mehreren Kunden übernommen werden, werden Mainframes für hochvolumige, missionskritische Aufgaben erstellt. Diese leistungsstarken Systeme sind häufig in Heavil gefunden

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

ZendStudio 13.5.1 Mac

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Herunterladen der Mac-Version des Atom-Editors

Der beliebteste Open-Source-Editor

Dreamweaver CS6

Visuelle Webentwicklungstools

MinGW – Minimalistisches GNU für Windows

Dieses Projekt wird derzeit auf osdn.net/projects/mingw migriert. Sie können uns dort weiterhin folgen. MinGW: Eine native Windows-Portierung der GNU Compiler Collection (GCC), frei verteilbare Importbibliotheken und Header-Dateien zum Erstellen nativer Windows-Anwendungen, einschließlich Erweiterungen der MSVC-Laufzeit zur Unterstützung der C99-Funktionalität. Die gesamte MinGW-Software kann auf 64-Bit-Windows-Plattformen ausgeführt werden.

MantisBT

Mantis ist ein einfach zu implementierendes webbasiertes Tool zur Fehlerverfolgung, das die Fehlerverfolgung von Produkten unterstützen soll. Es erfordert PHP, MySQL und einen Webserver. Schauen Sie sich unsere Demo- und Hosting-Services an.