Heim >Technologie-Peripheriegeräte >KI >Gary Marcus rief Hinton und Musk öffentlich zu: „Deep Learning stößt an eine Wand, ich wette 100.000 Dollar.'

Gary Marcus rief Hinton und Musk öffentlich zu: „Deep Learning stößt an eine Wand, ich wette 100.000 Dollar.'

- PHPznach vorne

- 2023-04-13 19:40:011888Durchsuche

„Wenn jemand sagt, dass (Deep Learning) an eine Wand stößt, dann muss er nur eine Liste der Dinge erstellen, die Deep Learning nicht kann. In 5 Jahren werden wir in der Lage sein, zu beweisen, dass Deep Learning es schafft

6 Am 1. März war der zurückgezogen lebende Geoffrey Hinton zu Gast im Podcast des UC Berkeley-Professors Pieter Abbeel. Die beiden führten ein 90-minütiges Gespräch, das von maskierten Auto-Encodern über AlexNet bis hin zu Spiking-Neuronalen Netzen reichte.

In der Show stellte Hinton deutlich die Ansicht in Frage, dass „Deep Learning an eine Wand gestoßen ist“.

Die Aussage „Deep Learning hat eine Wand erreicht“ stammt aus einem Artikel im März des bekannten KI-Wissenschaftlers Gary Marcus. Genauer gesagt glaubt er, dass das „reine End-to-End-Deep-Learning“ fast am Ende ist und der gesamte KI-Bereich einen neuen Ausweg finden muss.

Wo ist der Ausweg? Laut Gary Marcus hat die Symbolverarbeitung eine große Zukunft. Allerdings wurde diese Ansicht von der Community noch nie ernst genommen: „Jede Investition in Symbolverarbeitungsmethoden ist ein großer Fehler.“

Hintons öffentliche „Widerlegung“ im Podcast erregte offensichtlich die Aufmerksamkeit von Gary Marcus.

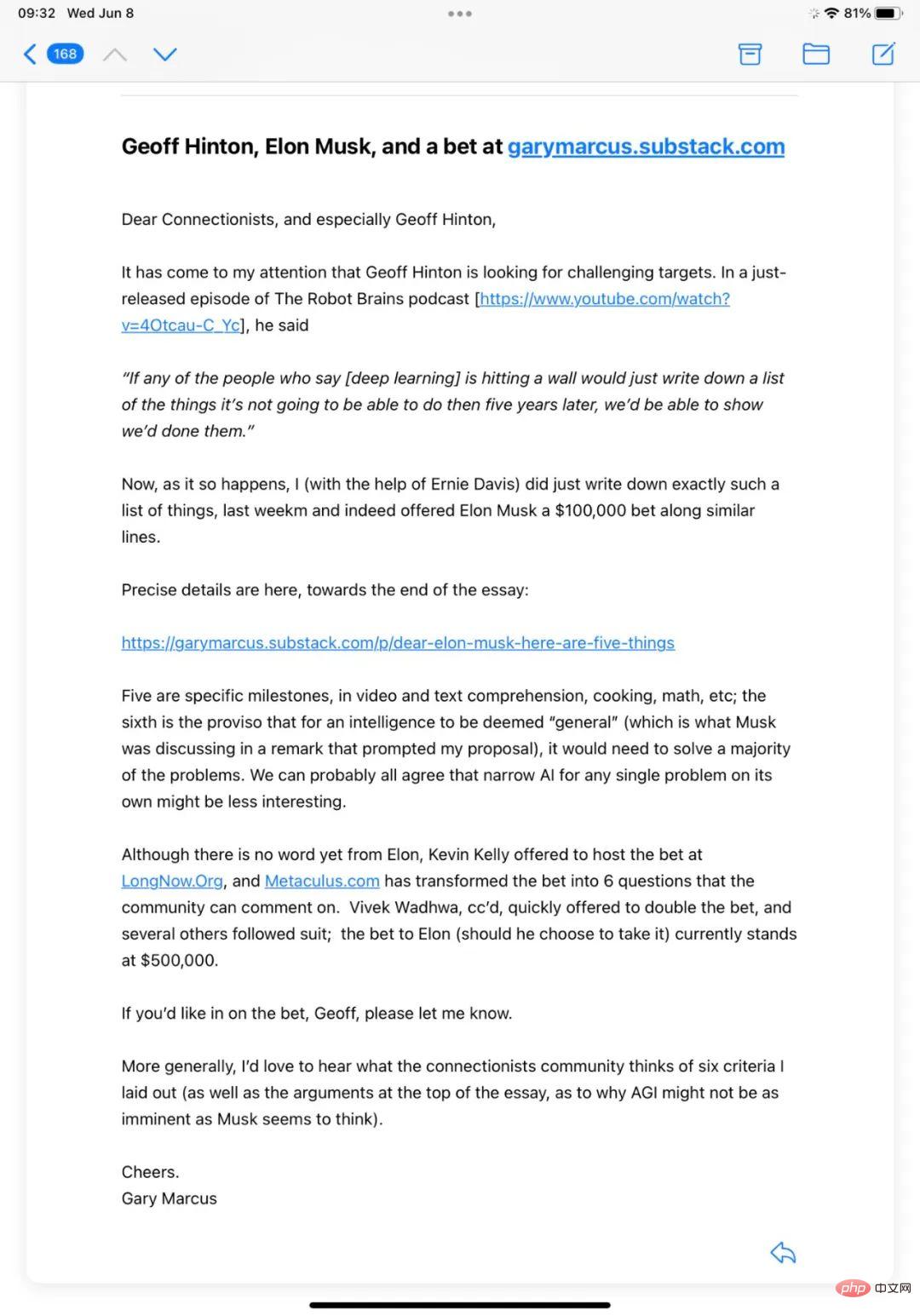

Erst vor einem Dutzend Stunden schickte Gary Marcus einen offenen Brief an Geoffrey Hinton auf Twitter:

In dem Brief stand Folgendes: „Mir ist aufgefallen, dass Geoffrey Hinton nach anspruchsvollen Jobs sucht. Ziel. Ich habe tatsächlich so einen geschrieben.“ Liste mit Hilfe von Ernie Davis, und ich habe letzte Woche eine 100.000-Dollar-Wette an Musk abgegeben. „

Was ist hier mit Musk los? Der Grund beginnt mit einem Tweet Ende Mai.

Eine 100.000-Dollar-Wette mit Musk

Seit langem verstehen die Menschen unter AGI die Art von KI, die in Filmen wie „A Space Odyssey“ (HAL) und „Iron Man“ (JARVIS) beschrieben wird. Im Gegensatz zur aktuellen KI, die für eine bestimmte Aufgabe trainiert wird, kann AGI, eher wie das menschliche Gehirn, lernen, wie man eine Aufgabe erledigt.

Die meisten Experten glauben, dass es Jahrzehnte dauern wird, AGI zu erreichen, während einige sogar glauben, dass dieses Ziel niemals erreicht werden wird. In einer Umfrage unter Experten auf diesem Gebiet wurde geschätzt, dass die Chance, bis 2099 AGI zu erreichen, bei 50 % liegt.

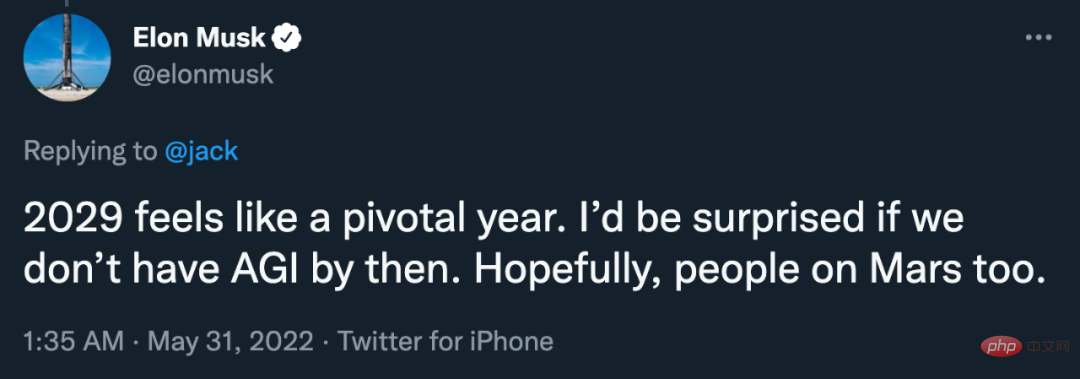

Im Gegensatz dazu zeigt sich Musk optimistischer und äußerte sich sogar öffentlich auf Twitter: „2029 ist ein kritisches Jahr. Wenn wir bis dahin AGI nicht erreicht haben, werde ich überrascht sein. Ich hoffe, dass die Menschen auf dem Mars es auch sein werden. So.“

Gary Marcus, der anderer Meinung war, fragte schnell: „Wie viel sind Sie bereit zu wetten?“ ein Spiel bei Long Bets und der Betrag beträgt 100.000 $.

Nach Ansicht von Gary Marcus sind Musks relevante Ansichten nicht verlässlich: „Sie sagten beispielsweise im Jahr 2015, dass es zwei Jahre dauern würde, bis es vollständig autonome Autos gibt. Seitdem haben Sie fast jedes Jahr dasselbe gesagt.“

Im Jahr 2029 wird KI nicht in der Lage sein, Filme zu verstehen und die Geschichte genau zu erzählen. Was passiert mit Ihnen (wer sind die Charaktere, was sind ihre Konflikte und Motivationen usw.);

Im Jahr 2029 kann KI keine Romane lesen und Fragen zu Handlung, Charakteren, Konflikten, Motivationen usw. nicht zuverlässig beantworten 2029 kann KI in keiner Küche ein kompetenter Koch sein;

Im Jahr 2029 kann KI nicht zuverlässig mehr als 10.000 Zeilen fehlerfreien Codes erstellen (Code aus vorhandenen Bibliotheken einkleben), und zwar durch Spezifikation in natürlicher Sprache oder durch Interaktion mit nicht fachkundigen Benutzern nicht zählen);

- Im Jahr 2029 wird die KI nicht willkürlich Beweise aus in natürlicher Sprache verfasster mathematischer Literatur entnehmen und in eine symbolische Form umwandeln können, die für die symbolische Verifizierung geeignet ist.

- „Hier ist mein Vorschlag: Wenn Sie (oder jemand anderes) es schaffen, im Jahr 2029 mindestens drei zu schaffen, gewinnen Sie. Deal? Wie wäre es mit hunderttausend Dollar?“

bei mehr Leuten Im weiteren Verlauf ist der Einsatzbetrag auf 500.000 US-Dollar gestiegen. Bisher hat Musk jedoch nicht reagiert.

Gary Marcus: AGI ist nicht so „nahe bei uns“, wie Sie denken

Am 6. Juni veröffentlichte Gary Marcus einen Artikel im Scientific American, in dem er seinen Standpunkt bekräftigte: AGI ist nicht in unserer Nähe.

Für den Durchschnittsmenschen scheint es, als würden im Bereich der künstlichen Intelligenz große Fortschritte gemacht. Unter Medienberichten: DALL-E 2 von OpenAI scheint in der Lage zu sein, jeden Text in ein Bild umzuwandeln, GPT-3 ist allwissend und das im Mai veröffentlichte Gato-System von DeepMind meistert jede Aufgabe gut … Ein leitender DeepMind-Manager prahlte sogar mit dem Start die Suche nach künstlicher allgemeiner Intelligenz (AGI), KI mit menschenähnlichem Intelligenzniveau ...

Lassen Sie sich nicht täuschen. Maschinen könnten eines Tages so intelligent sein wie Menschen, vielleicht sogar noch intelligenter, aber das ist heute noch lange nicht der Fall. Es gibt noch viel zu tun, um Maschinen zu schaffen, die die reale Welt wirklich verstehen und darüber nachdenken können. Was wir jetzt wirklich brauchen, ist weniger Gehabe und mehr Grundlagenforschung.

Natürlich macht die KI in einigen Bereichen tatsächlich Fortschritte – synthetische Bilder sehen immer realistischer aus, die Spracherkennung kann in lauten Umgebungen funktionieren –, aber von einer universellen KI auf menschlicher Ebene sind wir noch weit entfernt. Es ist noch ein weiter Weg Beispielsweise ist künstliche Intelligenz noch nicht in der Lage, die wahre Bedeutung von Artikeln und Videos zu verstehen und auch nicht mit unerwarteten Hindernissen und Unterbrechungen umzugehen. Wir stehen immer noch vor der Herausforderung, vor der KI seit Jahren steht: KI zuverlässig zu machen.

Nehmen Sie Gato als Beispiel: Wenn Sie einem Bild eines Werfers, der einen Baseball wirft, einen Titel hinzufügen möchten, gibt das System drei verschiedene Antworten zurück: „Ein Baseballspieler wirft auf einem Baseballfeld“, „Ein Mann wirft einen Ball zu.“ „Ein Baseballspieler auf einem Baseballfeld“, „Ein Werfer wirft einen Baseball“ und „Ein Baseballspieler schlägt und ein Fänger in einem Baseballspiel.“ Die erste Antwort ist richtig, während die anderen beiden scheinbar zusätzliche Spieler enthalten, die im Bild nicht sichtbar sind. Dies deutet darauf hin, dass das Gato-System nicht weiß, was sich tatsächlich im Bild befindet, sondern vielmehr, was für ungefähr ähnliche Bilder typisch ist. Jeder Baseballfan kann erkennen, dass dies der Werfer ist, der gerade den Ball geworfen hat – wir würden zwar erwarten, dass ein Fänger und ein Schlagmann in der Nähe sind, aber sie fehlen auf dem Bild auffällig.

In ähnlicher Weise wird DALL-E 2 diese beiden Positionsbeziehungen verwechseln: „roter Würfel auf blauem Würfel“ und „blauer Würfel auf rotem Würfel“. Ebenso konnte das von Google im Mai veröffentlichte Imagen-Modell nicht zwischen „Astronaut auf einem Pferd“ und „Astronaut auf einem Pferd“ unterscheiden.

Man findet es vielleicht immer noch etwas komisch, wenn ein System wie DALL-E schief geht, aber es gibt einige KI-Systeme, die sehr ernste Probleme verursachen können, wenn sie schief gehen. Beispielsweise fuhr kürzlich ein selbstfahrender Tesla direkt auf einen Arbeiter zu, der mitten auf der Straße ein Stoppschild hielt, und erforderte das Eingreifen eines menschlichen Fahrers, um das Fahrzeug abzubremsen. Das selbstfahrende System konnte Menschen und Stoppschilder selbstständig erkennen, verlangsamte jedoch nicht die Geschwindigkeit, wenn es auf ungewöhnliche Kombinationen dieser beiden traf.

Leider sind KI-Systeme also immer noch unzuverlässig und haben Schwierigkeiten, sich schnell an neue Umgebungen anzupassen.

Gato schneidet bei allen von DeepMind gemeldeten Aufgaben gut ab, aber selten so gut wie andere moderne Systeme. GPT-3 schreibt oft fließende Prosa, hat aber immer noch Schwierigkeiten, die Grundrechenarten zu beherrschen, und hat zu wenig Verständnis für die Realität. Es ist leicht, unglaubliche Sätze zu formulieren wie „Einige Experten glauben, dass das Essen von Socken dem Gehirn helfen kann, seinen Zustand zu ändern.“ " .

Das Problem dahinter ist, dass die größten Forschungsteams im Bereich der Künstlichen Intelligenz nicht mehr akademische Institutionen, sondern große Technologieunternehmen sind. Im Gegensatz zu Universitäten haben Unternehmen keinen Anreiz, fair zu konkurrieren. Ihr neues Papier wurde ohne wissenschaftliche Begutachtung durch die Presse veröffentlicht, was zu Medienberichterstattung und Umgehung der Begutachtung durch Fachkollegen führte. Die Informationen, die wir erhalten, sind nur die Informationen, die das Unternehmen selbst von uns verlangt.

In der Softwarebranche gibt es ein spezielles Wort, das diese Geschäftsstrategie darstellt: „Demoware“, was bedeutet, dass das Design der Software für die Anzeige geeignet ist, aber nicht unbedingt für die reale Welt geeignet ist.

Und auf diese Weise vermarktete KI-Produkte können entweder nicht reibungslos veröffentlicht werden, oder sie sind in der Realität ein Chaos.

Deep Learning verbessert die Fähigkeit der Maschine, Datenmuster zu erkennen, weist jedoch drei große Mängel auf: Die erlernten Muster sind eher oberflächlich als konzeptionell; die erzielten Ergebnisse sind schwer zu interpretieren; Der Harvard-Informatiker Les Valiant betonte: „Die zentrale Herausforderung der Zukunft besteht darin, die Form des KI-Lernens und -Denkens zu vereinheitlichen.“

Derzeit streben Unternehmen danach, Maßstäbe zu setzen, anstatt neue Ideen zu entwickeln . Nehmen Sie kleine Verbesserungen vor, anstatt über grundlegendere Probleme nachzudenken.

Wir brauchen mehr Leute, die grundlegende Fragen stellen, wie zum Beispiel „Wie baut man ein System auf, das gleichzeitig lernen und argumentieren kann“, anstatt großartige Produktpräsentationen anzustreben?

Diese Debatte über AGI ist noch lange nicht zu Ende, und andere Forscher haben sich angeschlossen. Der Forscher Scott Alexander wies in seinem Blog darauf hin, dass Gary Marcus eine Legende ist und dass das, was er in den letzten Jahren geschrieben hat, mehr oder weniger völlig korrekt ist, aber dennoch seinen Wert hat.

Gary Marcus hatte beispielsweise zuvor einige Probleme von GPT-2 kritisiert. Acht Monate später, als GPT-3 geboren wurde, wurden diese Probleme gelöst. Aber Gary Marcus zeigte keine Gnade gegenüber GPT-3 und schrieb sogar einen Artikel: „Der Sprachgenerator von OpenAI weiß nicht, wovon er spricht.“

Im Wesentlichen ist ein Standpunkt vorerst richtig: „Gary Marcus Es ist.“ ein Gimmick, um sich über große Sprachmodelle lustig zu machen, aber dann werden diese Modelle immer besser, und wenn sich dieser Trend fortsetzt, wird AGI bald implementiert sein.“

Das obige ist der detaillierte Inhalt vonGary Marcus rief Hinton und Musk öffentlich zu: „Deep Learning stößt an eine Wand, ich wette 100.000 Dollar.'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr