Heim >Technologie-Peripheriegeräte >KI >Neue Ideen für die KI-Malerei: Neues inländisches Open-Source-Modell mit 5 Milliarden Parametern, das einen Sprung in der synthetischen Steuerbarkeit und Qualität erzielt

Neue Ideen für die KI-Malerei: Neues inländisches Open-Source-Modell mit 5 Milliarden Parametern, das einen Sprung in der synthetischen Steuerbarkeit und Qualität erzielt

- PHPznach vorne

- 2023-04-13 10:37:021425Durchsuche

- Papieradresse: https://arxiv.org/pdf/2302.09778v2.pdf

- Projektadresse: https://github.com/damo-vilab/composer

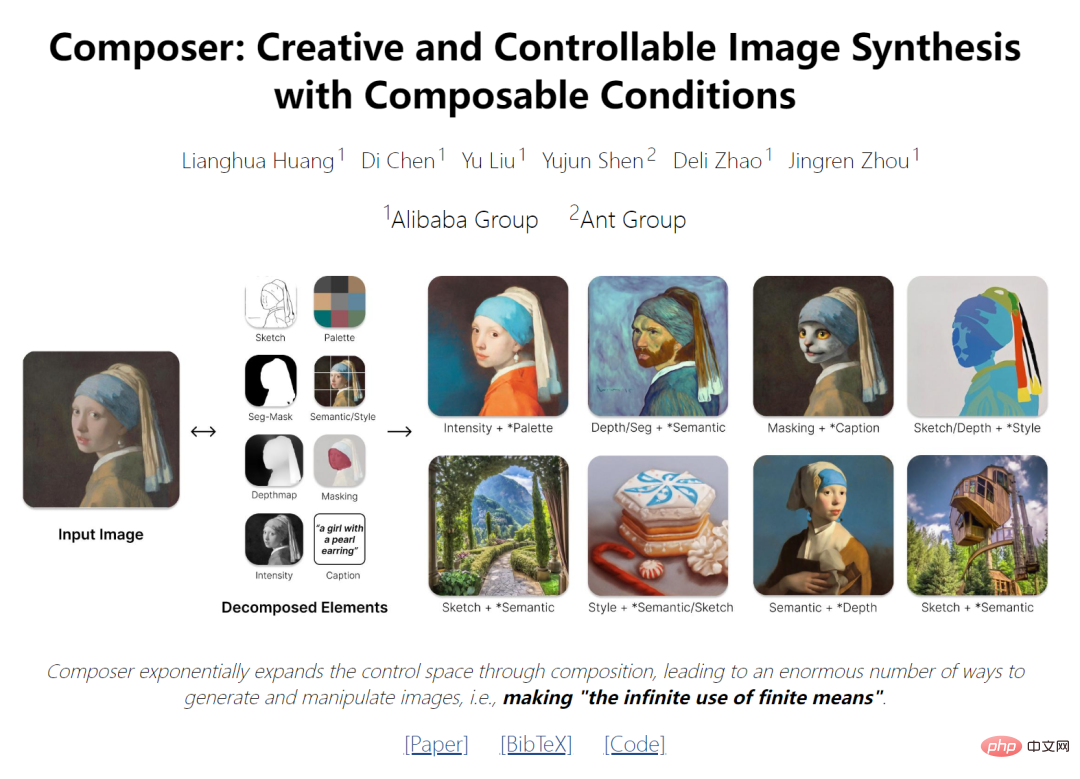

In den letzten Jahren konnten groß angelegte generative Modelle, die auf Big Data erlernt wurden, Bilder hervorragend synthetisieren, waren jedoch nur begrenzt steuerbar. Der Schlüssel zur kontrollierbaren Bilderzeugung liegt nicht nur in den Bedingungen, sondern vor allem in der Kompositionalität. Letzteres kann den Kontrollraum exponentiell erweitern, indem es eine große Anzahl möglicher Kombinationen einführt (z. B. 100 Bilder mit jeweils 8 Darstellungen, was ungefähr 100^8 Kombinationen ergibt). Ähnliche Konzepte wurden in den Bereichen Sprach- und Szenenverständnis untersucht, wo Kompositionalität als kombinatorische Verallgemeinerung bekannt ist, die Fähigkeit, eine potenziell unendliche Anzahl neuer Kombinationen aus einem begrenzten Satz bekannter Komponenten zu identifizieren oder zu generieren.

Die neuesten Forschungsergebnisse liefern ein Paradigma der neuen Generation, das das Ausgabebild (z. B. räumliches Layout und Farbpalette) flexibel steuern und gleichzeitig die Synthesequalität und die Modellkreativität beibehalten kann.

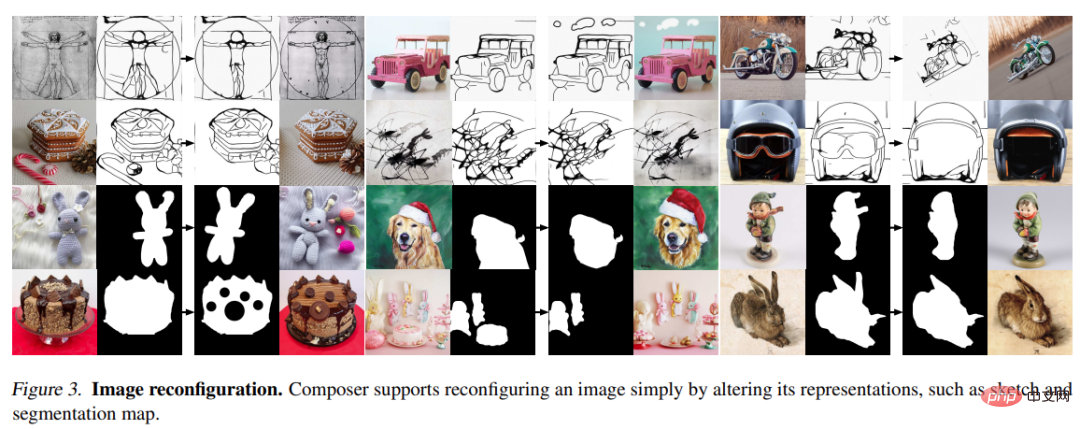

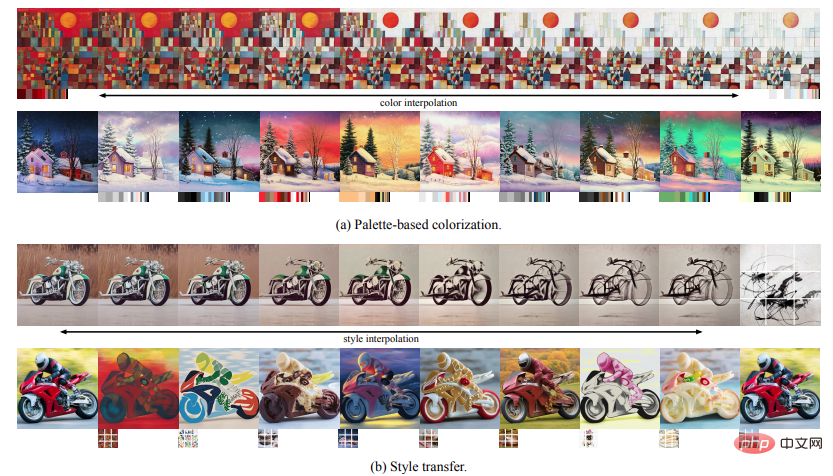

Diese Forschung nimmt die Kompositionalität als Kernidee an. Sie zerlegt das Bild zunächst in repräsentative Faktoren und trainiert dann ein auf diesen Faktoren basierendes Diffusionsmodell, um die Eingabe neu zu organisieren. Während der Inferenzphase dienen umfangreiche Zwischendarstellungen als zusammensetzbare Elemente und bieten einen riesigen Gestaltungsspielraum für die Erstellung anpassbarer Inhalte (d. h. exponentiell proportional zur Anzahl der Zerlegungsfaktoren). Es ist erwähnenswert, dass die Methode namens Composer verschiedene Ebenen von Bedingungen unterstützt, z. B. Textbeschreibungen als globale Informationen, Tiefenkarten und Skizzen als lokale Orientierungshilfe, Farbhistogramme als Details auf niedriger Ebene usw.

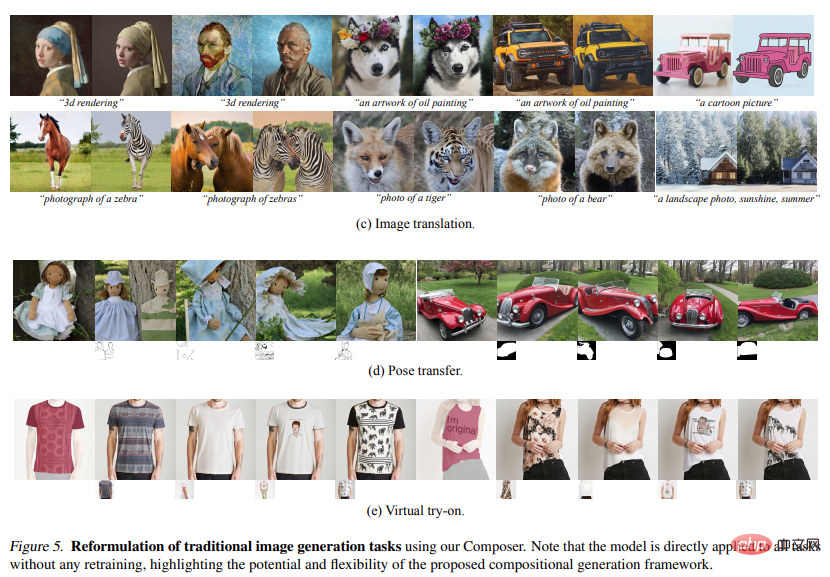

Diese Studie verbessert nicht nur die Steuerbarkeit, sondern bestätigt auch, dass Composer als allgemeiner Rahmen dienen kann, der ein breites Spektrum klassischer Generierungsaufgaben ohne Umschulungsbedarf ermöglicht.

Methode

Das in diesem Artikel vorgestellte Framework umfasst eine Zerlegungsphase (das Bild wird in einen Satz unabhängiger Komponenten unterteilt) und eine Synthesephase (die Komponenten werden mithilfe eines bedingten Diffusionsmodells neu kombiniert). Hier stellen wir zunächst kurz das mit Composer implementierte Diffusionsmodell und die Führungsrichtung vor und beschreiben dann detailliert die Implementierung der Bildzerlegung und -synthese.

2.1. Diffusionsmodell

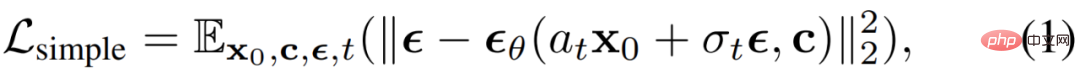

Das Diffusionsmodell ist ein generatives Modell, das durch einen iterativen Entrauschungsprozess Daten aus Gaußschem Rauschen generiert. Als Entrauschungsziel wird normalerweise ein einfacher mittlerer quadratischer Fehler verwendet:

wobei x_0 die Trainingsdaten mit der optionalen Bedingung c sind,  additives Gaußsches Rauschen ist, a_t, σ_t von t sind Skalarfunktion,

additives Gaußsches Rauschen ist, a_t, σ_t von t sind Skalarfunktion,  ist ein Diffusionsmodell mit lernbaren Parametern θ. Klassifikatorfreies Bootstrapping wurde in neueren Arbeiten am häufigsten für die bedingte Datenabtastung von Diffusionsmodellen verwendet, bei denen das vorhergesagte Rauschen angepasst wird durch:

ist ein Diffusionsmodell mit lernbaren Parametern θ. Klassifikatorfreies Bootstrapping wurde in neueren Arbeiten am häufigsten für die bedingte Datenabtastung von Diffusionsmodellen verwendet, bei denen das vorhergesagte Rauschen angepasst wird durch:

Formel In  ist ω das Führungsgewicht. DDIM und DPM-Solver werden häufig verwendet, um den Sampling-Prozess von Diffusionsmodellen zu beschleunigen. DDIM kann auch verwendet werden, um ein Sample x_0 in sein reines Rauschpotential x_T umzuwandeln, was verschiedene Bildbearbeitungsvorgänge ermöglicht.

ist ω das Führungsgewicht. DDIM und DPM-Solver werden häufig verwendet, um den Sampling-Prozess von Diffusionsmodellen zu beschleunigen. DDIM kann auch verwendet werden, um ein Sample x_0 in sein reines Rauschpotential x_T umzuwandeln, was verschiedene Bildbearbeitungsvorgänge ermöglicht.

Führungsrichtung: Composer ist ein Diffusionsmodell, das mehrere Bedingungen akzeptieren und verschiedene Richtungen ohne Klassifikatorführung erreichen kann:

c_1 und c_2 sind zwei Sätze von Bedingungen. Unterschiedliche Auswahlmöglichkeiten von c_1 und c_2 stellen eine unterschiedliche Betonung der Bedingung dar. Bedingungen innerhalb von

(c_2 c_1) werden als ω hervorgehoben, Bedingungen innerhalb von (c_1 c_2) werden als (1−ω) unterdrückt und Bedingungen innerhalb von c1∩c2 haben eine Richtgewichtung von 1,0. Bidirektionale Anleitung: Indem wir die Bedingung c_1 verwenden, um das Bild x_0 in das zugrunde liegende x_T umzukehren, und dann eine andere Bedingung c_2 verwenden, um eine Stichprobe aus x_T zu erstellen, können wir Composer verwenden, um das Bild auf entwirrte Weise zu manipulieren, wobei die Manipulationsrichtung dazwischen liegt c_2 und c_1 durch Unterschiede definiert.

Decomposition

untersucht die Zerlegung von Bildern in entkoppelte Darstellungen, die verschiedene Aspekte des Bildes erfassen, und beschreibt die acht in dieser Aufgabe verwendeten Darstellungen, die während des Trainingsprozesses in Echtzeit extrahiert werden.

Bildunterschrift : Die Forschung verwendet Titel- oder Beschreibungsinformationen in Bild-Text-Trainingsdaten (z. B. LAION-5B (Schuhmann et al., 2022)) direkt als Bildunterschriften. Vorab trainierte Bilder können auch zur Veranschaulichung des Modells genutzt werden, wenn keine Anmerkungen verfügbar sind. Wir charakterisieren diese Titel mithilfe von Satz- und Wörterinbettungen, die aus dem vorab trainierten CLIP ViT-L /14@336px-Modell (Radford et al., 2021) extrahiert wurden.

Semantik und Stil : Studie mit Bildeinbettungen, die vom vorab trainierten CLIP ViT-L/14@336px-Modell extrahiert wurden, um die Semantik und den Stil von Bildern zu charakterisieren, ähnlich wie bei unCLIP.

Farbe: Studieren Sie die Farbstatistik von Bildern mithilfe geglätteter CIELab-Histogramme. Quantisieren Sie den CIELab-Farbraum mit einem Glättungssigma von 10 in 11 Farbtonwerte, 5 Sättigungs- und 5 Lichtwerte. Erfahrungsgemäß funktioniert diese Einstellung besser.

Skizze: Lernen Sie die Anwendung von Kantenerkennungsmodellen und die anschließende Verwendung von Skizzenreduktionsalgorithmen, um Skizzen von Bildern zu extrahieren. Sketch erfasst lokale Details eines Bildes mit weniger Semantik.

Instanzen: Studie mit vorab trainiertem YOLOv5-Modell, um Instanzsegmentierung auf Bilder anzuwenden, um deren Instanzmasken zu extrahieren. Instanzsegmentierungsmasken spiegeln die Kategorie- und Forminformationen visueller Objekte wider.

Tiefenkarte: Studieren Sie die Verwendung eines vorab trainierten monokularen Tiefenschätzungsmodells, um die Tiefenkarte des Bildes zu extrahieren und das Layout des Bildes grob zu erfassen.

Intensität: Die Studie führt das ursprüngliche Graustufenbild als Darstellung ein und zwingt das Modell, zu lernen, mit dem entwirrten Freiheitsgrad der Farbe umzugehen. Um Zufälligkeit einzuführen, nehmen wir gleichmäßig Stichproben aus einem Satz vordefinierter RGB-Kanalgewichte, um Graustufenbilder zu erstellen.

Maskierung: Studieren Sie die Einführung der Bildmaskierung, um es Composer zu ermöglichen, die Bilderzeugung oder -vorgänge auf bearbeitbare Bereiche zu beschränken. Es wird eine 4-Kanal-Darstellung verwendet, wobei die ersten 3 Kanäle dem maskierten RGB-Bild und der letzte Kanal der Binärmaske entsprechen.

Es ist zu beachten, dass in diesem Artikel zwar Experimente mit den oben genannten acht Bedingungen durchgeführt wurden, Benutzer die Bedingungen jedoch mit Composer frei anpassen können.

Komposition

Studien mit Diffusionsmodellen, um Bilder aus einer Reihe von Darstellungen neu zu kombinieren. Konkret nutzt die Studie die GLIDE-Architektur und modifiziert deren Tuning-Modul. Die Studie untersucht zwei verschiedene Mechanismen zur Anpassung von Modellen basierend auf Darstellungen:

Globale Konditionierung: Für globale Darstellungen, einschließlich CLIP-Satzeinbettungen, Bildeinbettungen und Farbpaletten, projizieren wir sie und fügen sie zu Zeitschritteinbettungen hinzu. Darüber hinaus projizieren wir Bildeinbettungen und Farbpaletten in acht zusätzliche Token und verketten sie mit CLIP-Worteinbettungen, die dann in GLIDE als Kontext für Queraufmerksamkeit verwendet werden, ähnlich wie bei unCLIP. Da Bedingungen entweder additiv sind oder bei gegenseitiger Aufmerksamkeit selektiv maskiert werden können, können Bedingungen direkt während des Trainings und der Inferenz gelöscht oder neue globale Bedingungen eingeführt werden.

Lokalisierungskonditionierung: Für lokalisierte Darstellungen, einschließlich Skizzen, Segmentierungsmasken, Tiefenkarten, Intensitätsbilder und Maskenbilder, verwenden wir gestapelte Faltungsschichten, um sie auf einen Durchschnitt mit derselben räumlichen Größe wie das dimensional eingebettete Rauschpotential x_t zu projizieren . Anschließend wird die Summe dieser Einbettungen berechnet und das Ergebnis zu x_t verkettet, das dann in UNet eingespeist wird. Da Einbettungen additiv sind, ist es einfach, fehlende Bedingungen anzupassen oder neue lokalisierte Bedingungen zu integrieren.

Gemeinsame Trainingsstrategie: Es ist wichtig, eine gemeinsame Trainingsstrategie zu entwerfen, die es dem Modell ermöglicht, Bilder aus verschiedenen Kombinationen von Bedingungen zu dekodieren. Die Studie experimentierte mit mehreren Konfigurationen und identifizierte eine einfache, aber effektive Konfiguration, die eine unabhängige Austrittswahrscheinlichkeit von 0,5 für jede Bedingung, eine Wahrscheinlichkeit von 0,1 für das Entfernen aller Bedingungen und eine Wahrscheinlichkeit von 0,1 für das Beibehalten aller Bedingungen verwendet. Für Intensitätsbilder wird eine spezielle Dropout-Wahrscheinlichkeit von 0,7 verwendet, da sie den Großteil der Informationen über das Bild enthalten und andere Bedingungen während des Trainings abschwächen können.

Das grundlegende Diffusionsmodell erzeugt ein Bild mit einer Auflösung von 64 × 64. Um hochauflösende Bilder zu erzeugen, haben wir zwei bedingungslose Diffusionsmodelle für das Upsampling bzw. Upsampling von Bildern von 64 × 64 auf 256 × 256 und von 256 × 256 auf 1024 × 1024 trainiert. Die Architektur des Upsampling-Modells wurde gegenüber unCLIP modifiziert, wobei die Verwendung von mehr Kanälen in Schichten mit niedriger Auflösung untersucht und Selbstaufmerksamkeitsblöcke eingeführt werden, um die Kapazität zu erweitern. Außerdem wird ein optionales Vorgängermodell eingeführt, das Bildeinbettungen aus Untertiteln generiert. Empirisch gesehen können frühere Modelle die Vielfalt erzeugter Bilder unter bestimmten Kombinationen von Bedingungen verbessern.

Experimentieren

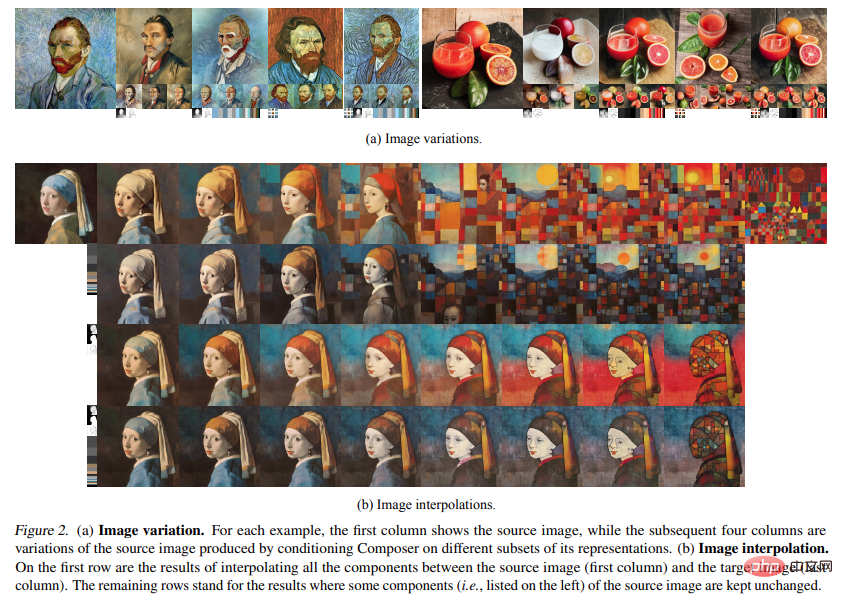

Variation: Mit Composer können Sie ein neues Bild erstellen, das einem bestimmten Bild ähnelt, sich jedoch in mancher Hinsicht etwas unterscheidet, indem Sie eine bestimmte Teilmenge seiner Darstellung konditionieren. Durch die sorgfältige Auswahl von Kombinationen verschiedener Darstellungen kann der Umfang der Bildänderungen flexibel gesteuert werden (Abb. 2a). Nach Einbeziehung weiterer Bedingungen generiert die in der Studie vorgestellte Methode eine Variante von unCLIP, die nur Bedingungen für die Bildeinbettung erfüllt: Mit Composer ist es möglich, neue Bilder zu erstellen, die einem bestimmten Bild ähneln, jedoch durch Konditionierung auf eine bestimmte Teilmenge davon Repräsentation ist in mancher Hinsicht anders. Durch die sorgfältige Auswahl von Kombinationen verschiedener Darstellungen kann der Umfang der Bildänderungen flexibel gesteuert werden (Abb. 2a). Nach Einbeziehung weiterer Bedingungen erreicht die vorgeschlagene Methode eine höhere Rekonstruktionsgenauigkeit als unCLIP, das nur von Bildeinbettungen abhängig ist.

.

.

Das obige ist der detaillierte Inhalt vonNeue Ideen für die KI-Malerei: Neues inländisches Open-Source-Modell mit 5 Milliarden Parametern, das einen Sprung in der synthetischen Steuerbarkeit und Qualität erzielt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr